Si l'intelligence artificielle est un concept attrayant, sa

mise en oeuvre est loin d'être anodine. Qu'il s'agisse des coûts

liés à son développement ou son utilisation, ils sont

multiples et peuvent représenter un grand nombre d'externalités

négatives. En outre, l'essor de cette technologie essentiellement

portée par des startups s'ancre dans un contexte

politico-économique peu en accord avec la sobriété

prônée par bon nombre de scientifiques. Il est donc

nécessaire de s'interroger sur la compatibilité de ces

éléments, afin de s'assurer de l'intérêt (ou non)

d'encourager ces solutions dans un contexte d'urgence écologique

indéniable.

2.1. L'intelligence artificielle comme source de

pollution

On oublie bien souvent que le numérique, domaine dans

lequel s'inclut l'IA, n'est pas virtuel, mais bien palpable. Au-delà du

concept que représente un algorithme, il est indispensable de

détenir le matériel pour l'exécuter. Sans cette mise en

oeuvre pratique sur un quelconque ordinateur, l'intelligence artificielle en

tant que telle n'est d'aucune utilité.

C'est notamment dans ce passage de l'imaginaire au

réel que le coût écologique se fait: en 2019, la pollution

numérique représentait 4% des émissions carbonées

mondiales, soit le double du transport aérien. Par ailleurs, notre

utilisation croissante de ces technologies a généré avec

2018 une augmentation annuelle de 8%18, faisant ainsi du secteur un

pollueur majeur.

Il est donc indispensable de cerner ces enjeux en

intégrant aux externalités de l'IA ces coûts

environnementaux négatifs, qui viennent se présenter comme des

freins majeurs, parfois alarmistes dans son déploiement et sa mise en

place.

2.1.1. La consommation énergétique, un

poids environnemental majeur

La consommation énergétique est bien souvent

vue comme le premier facteur négatif lié à l'utilisation

de l'intelligence artificielle. En effet, qui dit utilisation de l'IA dit

également ordinateurs et serveurs pour la faire fonctionner. Or, ces

dispositifs sont extrêmement énergivores, principalement en

électricité, et sont pourtant indispensables pour n'importe quel

algorithme. Qu'il s'agisse de leur production ou de leur utilisation, ces

appareils puisent dans des ressources planétaires de plus en plus

précieuses.

18 THE SHIFT PROJECT. Déployer la

sobriété numérique. Rapport intermédiaire

dirigé par Hugues FERREBOEUF. Janvier 2020.

22/62

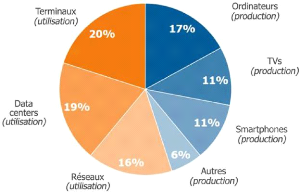

Figure 4 : Distribution de la consommation

énergétique du numérique par poste pour la production (en

orange) et

l'utilisation (en bleu) du numérique en 2017 [Source : The

Shift Project, 2020]

L'IA rend le défi encore plus important puisque, pour

garantir des résultats corrects, les modèles informatiques

doivent s'entraîner sur des jeux de données immenses, devant

être stockés, déplacés et transformés, afin

de garantir une progression du programme au fil de ses exécutions. Rien

qu'aux États-Unis, premier hébergeur mondial de données,

le chiffre s'élève à plus de 2700 centres de

données19 et à cela s'ajoutent les centaines d'autres

disséminés dans le reste du monde, dont plus de 250 en France.

Pourtant, leurs besoins énergétiques sont multiples :

l Alimentation en électricité pour les maintenir

allumés;

l Alimentation en électricité

supplémentaire pour chaque accès ou déplacement de

données;

l Régulation des températures des salles via

d'importants systèmes de climatisation.

Ce problème, déjà connu depuis plusieurs

années maintenant, est loin d'être résolu puisque les

données s'accumulent, en étant rarement supprimées. En

effet les entreprises souhaitent conserver leur historique et ne jamais

l'effacer, même lorsqu'il n'est pas utilisé. Le principe du

«au cas où» règne en maître : même si un

algorithme n'utilise que des images en HD pour son fonctionnement, on

conservera la version 4K en se disant qu'il sera peut-être pratique de

l'avoir à l'avenir.

L'amélioration constante des algorithmes

d'intelligence artificielle et la recherche de performance supérieure ne

font qu'aggraver le problème : les programmes vont tourner pendant des

heures, faire appel à de plus en plus de données, et solliciter

de plus en plus d'espace disponible dans les serveurs afin de calculer plus

rapidement. En ce sens, une amélioration des performances de l'IA est

négativement corrélée à son impact

écologique.

Toute la difficulté réside cependant dans le

fait de quantifier ce coût énergétique afin de le

comprendre et de le maîtriser. C'est notamment cet objectif qui a

guidé une équipe de

19 GAUDIAUT Tristan. Le pays qui héberge

le plus de data centers. Statista. 07/10/2022.

23/62

chercheurs de l'Université du Massachusetts a

étudié le coût énergétique de l'IA

Transformer créé par Google en 2017. Cette

dernière a pour objectif d'améliorer le traitement du langage

naturel20 appliqué aux problématiques de traduction en

s'appuyant sur le fonctionnement d'attention : l'algorithme identifie en

priorité les mots-clés afin de traduire selon le contexte. Il

s'agit donc a priori d'un modèle nécessitant de nombreuses

données afin d'apprendre itérativement pour améliorer son

passage d'une langue à l'autre.

Les équipes du Massachusetts ont étudié

l'intégralité de l'énergie nécessaire à la

mise au point de ce modèle. Ils ont donc analysé l'ensemble des

phases d'apprentissage du modèle afin d'obtenir des indicateurs

quantitatifs. Cela comprend notamment:

l L'ajustement des hyperparamètres définissant

les caractéristiques globales de la structure de l'algorithme;

l La recherche des pondérations optimales21

de chaque paramètre de l'algorithme pour arriver à la meilleure

traduction possible.

Au changement de chaque hyperparamètre, un

réapprentissage complet du modèle doit être effectué

: c'est donc après de nombreux essais qu'un modèle optimal est

défini. Intuitivement, on comprend que ce mode de fonctionnement est

extrêmement coûteux en énergie, et que la phase

d'apprentissage peut consommer bien plus que l'utilisation du modèle

final. En effet, la définition des paramètres est rapidement

fastidieuse et cela a bien été confirmé par

l'équipe du Massachusetts : l'ensemble des phases d'essai a

consommé 3200 fois plus que l'apprentissage seul du modèle final

optimisé22.

Le problème identifié ici n'est donc pas

l'intelligence artificielle en tant que telle et les modèles qui la

constituent, mais bien la démarche qui permet d'arriver à ces

algorithmes performants. Tout l'enjeu est donc de limiter les consommations

énergétiques engendrées par les phases d'essai et

d'apprentissage. Celles-ci sont constituées d'itérations

successives, parfois à tâtons, dans le but de déterminer la

combinaison optimale de paramètres permettant l'obtention du meilleur

résultat possible.

C'est en cela que l'intelligence artificielle soulève

un paradoxe quant à son inspiration humaine : alors que le cerveau a

besoin de très peu d'énergie pour apprendre une importante

quantité d'informations, l'IA, quant à elle, est

extrêmement consommatrice et n'obtient pas d'aussi bons résultats.

En effet, il reste aujourd'hui bien souvent incontestable qu'un

franco-britannique fournira une bien meilleure traduction que bon nombre

d'algorithmes en ligne, malgré leur apprentissage sur une immense

quantité de données.

C'est pour cette raison que le super-traducteur open

source Bloom développé par le CNRS en 46 langues a

été étudié. Anne-Laure LIGOZAT et ses

collègues ont ainsi estimé que sa

20 Le traitement du langage naturel est la

capacité d'un algorithme à comprendre une phrase, comme peuvent

le faire les agents conversationnels tels que ChatGPT.

21 Un modèle algorithmique s'appuie sur des

expressions mathématiques où tous les coefficients doivent

être pondérés par des valeurs les plus précises

possibles dans le but d'obtenir un résultat (ici, une traduction). Il

s'agit de la phase d'ajustement de la formule en s'appuyant sur des

données dont on connaît le résultat final (des phrases

déjà traduites).

22 STRUBELL, Emma, GANESH, Ananya, et MCCALLUM,

Andrew. Energy and policy considerations for modern deep learning research. In

: Proceedings of the AAAI conference on artificial intelligence. 2020. p.

13693-13696.

24/62

phase d'apprentissage de 118 jours avait émis 24,7

tonnes eqCO223, soit l'équivalent d'environ 14 allers-retours

Paris-New York en avion. Dans ce calcul, les phases d'essai-erreur lors de la

création du modèle et les phases d'utilisation à

postériori ne sont pas prises en compte. On comprend donc que la

performance des modèles s'obtient bien souvent au détriment de la

planète.

De fait, comme l'énonce le rapport du Shift Project de

janvier 202024 : «introduire une technologie numérique -

même dans le but de diminuer une consommation énergétique,

de réduire les émissions de carbone ou d'oeuvrer aux transitions

d'une quelconque manière - doit faire l'objet d'une

réflexion». En effet, même si l'intérêt de l'IA

n'est bientôt plus à démontrer, elle reste soumise aux

contraintes énergétiques mondiales, même lorsqu'elle est

impulsée par des géants tels que Google ou Microsoft. En outre,

sa pollution ne se limite pas à l'entraînement et à

l'utilisation de modèles, mais inclut également la construction

du matériel nécessaire à son développement. Des

ordinateurs aux serveurs en passant par les câbles électriques,

tous représentent un poids non négligeable et une grande

quantité de ressources.

2.1.2. L'IA : une technologie virtuelle avec des besoins

matériels

Au-delà des considérations

énergétiques, la fabrication de l'ensemble du matériel

nécessaire à l'utilisation de l'IA nécessite un recours

à de nombreux matériaux, dont certains très rares (cobalt,

lithium, mercure, etc.), et à des procédés de fabrication

complexes. On pense bien entendu en premier lieu à la production des

ordinateurs, des téléphones ou des serveurs et leurs

infrastructures, mais ils ne représentent en réalité

qu'une partie des besoins. En effet, la diversité de capteurs

nécessaires pour la collecte des données est un puit immense de

consommation de matière première, imposant une exigence sans

précédent dans leur fabrication, dans le but de collecter des

informations toujours plus précises et retranscrivant la

réalité avec un maximum de détails. Qu'il s'agisse de

thermomètres, de compteurs, de lasers, ou de chronomètres, le

niveau d'exigence désormais attendu les contraint à être

issus de procédés de fabrications nouveaux.

C'est par exemple le cas des lasers, qui ont

bénéficié d'avancées scientifiques majeures en

moins d'un siècle, et pour lesquels les techniques se sont largement

complexifiées. Initialement, ils étaient simplement issus de gaz

sous pression et excités par impulsions électriques qui

génèrent ainsi une lumière unidirectionnelle. Cependant,

progressivement, de nouvelles méthodes sont apparues, comportant chacune

leur spécificité permettant des performances optimales selon les

cas d'application. On distingue par exemple des socles techniques tels que:

l Les semi-conducteurs, comme la diode25, et qui

constituent les lasers à usage domestique ou peu exigeants en

précision ;

23 LUCCIONI, Alexandra Sasha, VIGUIER, Sylvain, et

LIGOZAT, Anne-Laure. Estimating the carbon footprint of bloom, a 176b parameter

language model. Journal of Machine Learning Research, 2023, vol. 24,

no 253, p. 1-15.

24 THE SHIFT PROJECT. Déployer la

sobriété numérique. Rapport intermédiaire

dirigé par Hugues FERREBOEUF. Janvier 2020.

25 La diode est un composant électronique ne

permettant au courant électrique de ne passer que dans un sens.

l

Les supports solides, comme le mélange de saphir et de

titane, qui permet d'atteindre de grandes puissances ;

l Les colorants, souvent toxiques, mais permettant de choisir

la longueur d'onde26 ;

l La fibre générant une amplification

optique27 importante.

Face à la multiplicité d'options pour chaque

type de capteur et appareils de mesure, il est évident que les besoins

en matières premières, dont l'approvisionnement est parfois

limité, sont de plus en plus divers, nécessitant d'extraire des

ressources jusqu'ici peu exploitées. La rareté de bon nombre

d'entre elles impose des transports réguliers à travers le monde

pour relier les différents lieux clés de la fabrication et de

livraison, ce qui ne fait augmenter le besoin en ressources et le coût

environnemental de chacun des composants sur lesquels s'appuie l'IA.

Au-delà de la nature des composants

nécessaires, leur nombre et leur variété sont frappantes.

Par exemple, la startup française Skyvisor est spécialisée

dans l'inspection automatisée préventive des structures comme des

éoliennes ou des panneaux solaires. Pour effectuer leur analyse et

soumettre des préconisations de maintenance, des drônes

équipés de caméras de grande précision sont

déployés afin de récolter les données (des images)

sur lesquelles travailler. Il faut donc un grand nombre de matériel :

l Un ordinateur pour afficher les résultats;

l L'accès à un serveur dans un data center qui

collecte toutes les données et effectue les calculs;

l Des drônes équipés de caméras

variées (caméra haute résolution, caméra

thermique...);

l Un dispositif permettant l'accès à internet

;

l Des câbles (électrique, fibre optique...).

On comprend ainsi qu'un outil, par son interconnexion,

nécessite de nombreux composants pour son fonctionnement. Par ailleurs,

au coeur de ces fabrications résident quasi-systématiquement les

mêmes matériaux. L'Université de Yale a d'ailleurs

mené une étude en 201528 pour déterminer la

part de chaque matériau dans la fabrication d'un circuit

imprimé29. Ce constat a été placé sur un

tableau période des éléments, regroupant l'ensemble des

matériaux présents sur Terre, de façon à identifier

l'importance de chacun d'entre eux.

Or, cette même étude a également fait

état des risques de tension d'approvisionnement de matériaux dans

les années à venir. Il a ainsi été constaté

que beaucoup d'éléments étaient communs aux deux tableaux,

ce qui interroge sur notre capacité future à continuer à

concevoir de nouveaux matériels informatiques.

26 La longueur d'onde représente la

distance entre le début et la fin d'une ondulation (entre deux

crêtes ou deux creux) générée par la lumière,

elle va déterminer la puissance du laser.

27 L'amplification optique a pour but d'augmenter la

puissance ou l'intensité.

28 GRAEDEL, Thomas E., HARPER, Ermelina M.,

NASSAR, Nedal T., et al. Criticality of metals and metalloids.

Proceedings of the National Academy of Sciences, 2015, vol. 112, no

14, p. 4257-4262.

29 Un circuit imprimé est une plaque sur

laquelle des composants électroniques sont montés et

connectés par des pistes conductrices, permettant le fonctionnement de

divers dispositifs électroniques dont notamment les ordinateurs et les

smartphones.

26/62

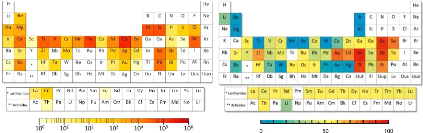

Figure 5 : Tableau périodique des éléments

indiquant la concentration des matériaux pour la fabrication d'un

circuit imprimé (à gauche) et les matériaux en tension

dans les années à venir (à droite) [Source : GRAEDEL,

2015]

Au-delà des pollutions engendrées par

l'extraction, le transport et la transformation de ces matériaux, cela

interroge également sur les méthodes d'exploitation de ces

ressources naturelles. En effet, la construction de mines va détruire

des écosystèmes, les métaux et minerais utilisés

sont en quantité finie sur Terre, et les conditions d'exploitation ne

sont pas toujours respectueuses des droits humains.

En outre, aujourd'hui le recyclage de ce type de

matériaux est peu pris en charge. Eric VIDALENC évoque ce sujet

dans son essai30 : 'plus on est high-tech, moins on est

recyclable», «sur les 60 métaux que l'on trouve dans un

smartphone, seuls 17 sont recyclés».

Ce besoin en ressources naturelles interroge donc sur la

pertinence de l'utilisation de l'intelligence artificielle pour

l'environnement. Pour que cela ait un réel intérêt, il

faudrait que les gains soient largement supérieurs aux coûts

écologiques de fabrication. C'est une analyse complète du cycle

de vie qui doit être effectuée afin de s'assurer que la mise en

oeuvre de la technologie représente un bénéfice. En effet,

dans un monde où l'empreinte carbone moyenne d'un habitant est de 5

tonnes (et plus de 9 tonnes pour un français) alors que l'objectif est

à 2 tonnes eqCO2 en 2050, il est indéniable que la

création de n'importe quel produit doit être questionnée.

Cela nous amène donc à nous interroger même de la

pertinence du modèle économique des startups dans une ère

prônant la sobriété.

2.2. Startups et innovation technologique : le

«toujours plus» à l'aune de la

sobriété

Lorsque l'on définit une startup, il est

récurrent de parler de forte croissance économique de cette jeune

entreprise. Or, la croissance est souvent perçue comme un synonyme de

création et de massification. Ces concepts semblent donc aux antipodes

de la sobriété, pourtant définie comme le fondement

nécessaire à la transition écologique. L'équilibre

n'est donc a priori pas évident ; le trouver est alors un réel

défi pour les startups se disant 'à impact».

30 VIDALENC, Éric. Pour une

écologie numérique. Les petits matins, 2023.

27/62

2.2.1. La business model des startups, profit ou

impact?

Les startups présentent la particularité de

baser leur modèle sur le fait d'apporter une innovation, dont les

performances du produit sont supérieures à celles existant sur le

marché. Cette innovation doit alors permettre une forte croissance afin

de développer et pérenniser cette jeune entreprise. Aussi, les

startups s'ancrent parfaitement dans la société capitaliste

actuelle dont l'objectif central est d'augmenter la rentabilité.

Face à ce constat, le concept même de startup

interroge sur la compatibilité avec celui d'écologie. En effet,

il a été démontré de nombreuses fois, notamment par

le GIEC, que la transition vers un monde durable ne se fera que par

l'acquisition de pratiques plus sobres. Cela implique donc de réduire

les consommations pour limiter l'exploitation des ressources naturelles.

La sobriété et la croissance ne semblent donc

pas aller de pair, ce qui questionne la possibilité que des startups, et

plus généralement n'importe quelle entreprise, puissent

réellement s'engager dans une démarche environnementale. En

effet, la société actuelle pousse à la réussite

individuelle alors que la transition écologique nécessite un

travail collaboratif et de cohésion. C'est d'ailleurs la philosophie

d'un des scénarios de l'ADEME proposé dans le cadre du programme

«Transition(s) 2050» : les structures doivent penser à

travailler ensemble et à s'entraider mutuellement, en faisant passer au

second plan leur intérêt propre (scénario 2).

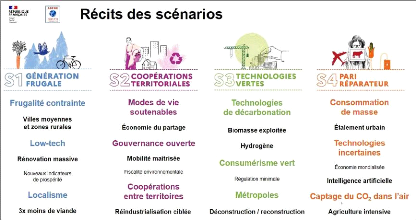

Figure 6 : Présentation des scénarios de l'ADEME

dans le cadre du programme «Transition(s) 2050»

[Source : ADEME,

2021]

En outre, l'intelligence artificielle interroge

également ce concept de sobriété. En effet, dans son

immense majorité, elle est utilisée pour analyser des millions de

données, ce qu'il serait impossible de faire sans cette technologie.

Quelles qu'en soient les applications, l'idée est d'intégrer

toujours plus de paramètres pour gagner en précision. L'ADEME

intègre d'ailleurs

28/62

l'intelligence artificielle comme un des

éléments clés de son scénario n°4, qui est

d'ailleurs décrit comme il suit : «Les modes de vie du

début du XXIème siècle sont sauvegardés.

Mais le foisonnement de biens consomme beaucoup d'énergie et de

matières avec des impacts potentiellement forts sur

l'environnement»31. En effet, les ressources

nécessaires pour cette approche sont importantes, et le scénario

part du principe que nous trouverons des solutions technologiques dans le

futur.

Ainsi, il est nécessaire d'interroger la pertinence du

développement important de startups notamment dans le domaine avec de

l'intelligence artificielle. La volonté de développement de la

structure semble s'opposer au concept de sobriété ou de

frugalité scientifiquement prôné.

Toutefois, ces organisations semblent avoir leur place dans

le cadre de substitution à la société actuelle. En effet,

malgré les ressources nécessaires, les conséquences de

nombreuses innovations semblent bénéfiques pour l'environnement.

De plus en plus de startups décident de s'auto-évaluer, en

cherchant à prendre en compte l'ensemble des coûts

environnementaux de leur procédé, y compris l'accès et le

stockage des données. Ainsi, ces nouveaux services, se voulant plus

vertueux, doivent, pour avoir un impact positif, prendre la place des

modèles actuels, et ne pas s'ajouter, afin d'éviter une

surconsommation (cf. section 2.3.1 sur l'effet rebond).

C'est dans cette optique qu'a travaillé Stratosfair :

pour limiter les impacts des data centers, la startup se charge d'en

construire de nouveaux avec des objectifs soutenables. Ainsi, chaque structure

respecte plusieurs critères:

l Les serveurs sont situés dans un conteneur

réemployé, posé sur des plots afin d'éviter de

bétonner une grande surface;

l Le local est alimenté par des panneaux solaires

installés au-dessus de la structure;

l Les lieux d'implantation sont proches des villes afin de

permettre un «circuit court» dans le transit de données;

l Les capacités de stockage sont restreintes, pour

éviter de surdimensionner et d'avoir des ressources

non-exploitées.

Ainsi, la startup, bien qu'appuyée sur un

modèle du «toujours plus» pour multiplier les sources de

stockage de données, a tenté de développer son

activité de manière raisonnée. Les ressources sont

allouées en dimensionnant préalablement les besoins, et en

interagissant avec les parties prenantes locales ; l'énergie est

produite de manière durable. Cependant, cet équilibre, difficile

à trouver, a tout de même mené à la faillite de

Stratosfair, ce qui illustre bien la complexité de compatibilité

entre sobriété et rentabilité.

Ainsi, chaque solution est pesée, en tentant

d'évaluer son intérêt pour l'environnement, mais

également son coût. Si a priori le modèle des startups

n'est pas forcément bénéfique dans un contexte de

transition écologique, il n'est pas pour autant antagoniste. Ce qui

est

31 ADEME. Transition(s) 2050. Choisir maintenant,

agir pour le climat. Horinzons. Novembre 2021.

29/62

fondamental, c'est d'avoir conscience des coûts et de

tenter par tous les moyens de les minimiser de sorte à ce que les

externalités positives soient plus importantes.

Dans le domaine de l'intelligence artificielle, et dans tous

les domaines liés aux données, se pose toutefois la question de

la transparence des modèles. Faut-il dire ce qui est fait avec ces

informations, au risque de dévoiler son expertise et de perdre en

compétitivité ? Ces questions à la fois éthiques et

écologiques du spectre de l'open sourcing sont donc

étroitement liées à celle du fonctionnement du

modèle d'affaires des entreprises.

2.2.2. Diffusion des données et des algorithmes :

la transparence est-elle

compatible avec la rentabilité ?

La question de la transparence se pose forcément lors

de développements ayant pour but de créer des modèles

nécessitant de manipuler des données. Celle-ci se situe à

deux niveaux : avoir connaissance des types de données utilisées,

mais également, savoir comment elles sont maniées. Cette

problématique, a priori éthique, interroge donc grandement sur

cette volonté d'accroissement des intelligences artificielles. En effet,

dans le contexte actuel du deep learning, le coeur de la

réussite se situe dans la masse de données : plus un algorithme a

de données, meilleur sera son apprentissage, et donc, meilleurs seront

ses résultats.

Ce sujet a vu son premier cadrage majeur apparaître

avec le RGPD (Règlement Général sur la Protection des

Données)32 en 2018, dont la CNIL (Commission Nationale de

l'Informatique et des Libertés) assure le respect. Toutefois, cette

approche se limite à savoir quelles sont les données

utilisées, mais ne s'interroge pas sur la manière dont cela est

fait. C'est donc dans ce but -à que les récents travaux de

l'Union Européenne ont permis d'aboutir à l'AI

Act33.

Ce nouveau cadre normatif a pour but de s'assurer que les

données ne sont pas manipulées par des modèles d'IA pour

induire en erreur. Son principe est de classer les différents

modèles d'intelligence artificielle selon le risque qu'ils

représentent pour l'utilisateur. En fonction du risque associé,

les exigences réglementaires sont plus ou moins importantes, allant de

l'affichage d'un message d'information (pour certains générateurs

de deepfake, les chatbots...), à l'interdiction de

l'outil (notamment pour le scoring social).

L'IA Act se positionnerait ainsi comme le premier

cadre normatif au monde pour régir l'intelligence artificielle. Son but

se décline notamment en quatre parties :

l La transparence et l'explicabilité, en imposant de

disposer d'une documentation claire sur les modèles ;

l Le respect des droits fondamentaux;

l La responsabilisation des développeurs et

utilisateurs, en assurant qu'un responsable puisse être

désigné en cas de dommages;

l La supervision et la gouvernance, par la création

d'organismes de surveillance.

32 RGPD :

https://eur-lex.europa.eu/legal-content/FR/TXT/?uri=CELEX%3A32016R0679

33 AI Act :

https://eur-lex.europa.eu/legal-content/FR/TXT/PDF/?uri=CELEX:52021PC0206

30/62

On comprend ainsi que pour assurer la confiance des

utilisateurs, il est indispensable de signaler comment les données sont

exploitées et par qui. Cette réflexion est d'autant plus valable

dans des cas d'application en écologie : pouvoir expliquer comment

fonctionne le modèle et ce qu'il permet d'obtenir garantie à

l'utilisateur qu'il s'agit bien d'un outil vertueux et non de greenwashing.

La transparence est donc la première étape de la

coopération entre les acteurs : connaître les intentions de son

interlocuteur permet de s'assurer d'avoir des objectifs communs. C'est

également un moyen de vérifier que les visions des protagonistes

sont identiques, et d'identifier ainsi des biais que pourrait avoir un

modèle. Cette question éthique interroge donc plus largement sur

la capacité de mutualisation des ressources et de partage des

expertises.

Connaître le fonctionnement de l'autre peut être

décisif dans le choix d'un partenariat. Virgile BAUDROT donne l'exemple

de l'importance de la maîtrise de la localisation du stockage des

données (cf. annexe 2). En effet, une entreprise qui souhaite

s'engager profondément dans l'écologie va

généralement vouloir privilégier des serveurs

géographiquement proches. Il peut être également pertinent

de regarder qui gère le data center, et l'on pourra alors avoir

une opinion différente selon s'il s'agit d'un géant du

numérique, comme Amazon ou Microsoft, ou d'une startup locale comme

Stratosfair. Cette question de la gestion du serveur est cruciale, tant pour

l'aspect éthique qu'écologique. En effet, certaines entreprises

s'engagent à une gestion sobre des data centers, qu'il s'agisse

de leur alimentation en énergie, de leur empreinte au sol...

Enfin, la question de la transparence interroge sur le fait

de développer ou non des outils déjà existants. Le nombre

d'algorithmes déjà créés est immense et l'open

sourcing peut être une solution de sobriété. Avoir

accès aux codes de certains modèles permet d'avoir une solution

«clé en main», sur laquelle le travail d'optimisation a

déjà été réalisé, sans devoir

reproduire des travaux opérés précédemment par

quelqu'un d'autre et qui demanderont à nouveau des ressources

environnementales.

Il s'agit donc là de s'interroger sur la transparence

des modèles, mais également sur leur réplicabilité.

Si un modèle a été pensé de manière à

être le plus général possible, il pourra s'adapter à

de nouveaux cas d'usage ce qui évitera des développements

supplémentaires.

Toutefois, les startups travaillant en open source

se retrouvent bien souvent confrontées à la question de la

rentabilité du business model. Si une entreprise dévoile

son expertise sans garde-fous, se pose alors la question de sa capacité

à générer un chiffre d'affaires. On distingue alors bien

souvent deux schémas, comme l'évoquait Juliette FROPIER en

entretien (cf. annexe 6) :

l Les modèles entièrement en open source,

souvent financés dans un but d'intérêt

général, régulièrement par des acteurs publics,

avec l'objectif que tout le monde puisse ensuite l'utiliser, et en ne visant

ainsi pas forcément la rentabilité de cette opération;

l Les modèles partiellement en open source,

où une partie est disponible à tous, tandis qu'une autre

(souvent plus complexe) reste la propriété de l'entreprise et il

est donc nécessaire de payer pour pouvoir l'utiliser (comme le

modèle BERT de Google).

31/62

La transparence est donc un indispensable pour l'intelligence

artificielle mais n'est pas présente à un même degré

selon les entreprises et les projets. Certaines startups, comme c'est le cas de

Qonfluens, font le choix de travailler en open source en estimant que

leur valeur se situe dans leur capacité à développer de

nouveaux modèles. D'autres entreprises, majoritaires, gardent le code

secret tout en en dévoilant les grands principes pour assurer leur

rentabilité et leur compétitivité.

Toutefois, cela interroge sur les objectifs affichés

par bon nombre de startups en matière de transition écologique.

On comprend aisément que dévoiler l'intégralité de

son travail altère indéniablement le modèle d'affaires.

Pour tempérer cela, il est donc indispensable de pouvoir annoncer et

quantifier le caractère vertueux de l'outil. Sans cela, il est

impossible de s'assurer de sa plus-value écologique.

2.3. Coûts et bénéfices, de quoi

parle-t-on?

Si une solution technologique se dit vertueuse, il est

indispensable de disposer d'indicateurs pour quantifier, et ainsi,

vérifier, l'apport de sa mise oeuvre. La difficulté reste

cependant d'évaluer cet écart entre coûts et

bénéfices écologiques. L'impact d'une solution Green

IT serait alors moindre par rapport au cas IT for

Green34, mais selon quels indicateurs?

2.3.1. Les indicateurs pour mesurer la réussite

: choisir, comprendre et calculer

Pour privilégier une technologie à une autre,

il est indispensable d'avoir des indicateurs permettant de comparer les

performances et les impacts des deux solutions. La question se pose donc assez

naturellement pour l'intelligence artificielle. Le calcul des performances

s'appuie sur les approches classiques, déjà appliquées

depuis longtemps dans le secteur plus global du numérique. On

répondra alors aux questions telles que «Combien d'images mon

algorithme peut-il analyser par minute?» ou encore «Quel est mon taux

d'erreur ?».

L'interrogation principale se situe donc dans la mesure des

impacts. Selon l'outil considéré, ils peuvent être

variés, multidimensionnels, quantitatifs ou qualitatifs. En effet, il

n'existe pas de bonnes réponses pour mesurer l'éthique ou le

coût environnemental. Chaque modèle doit être

évalué au regard de son objectif d'utilisation. Si un algorithme

a pour but de réduire les consommations électriques liées

à la climatisation, il sera alors indispensable de s'assurer que la

régulation thermique du serveur utilisé ne génère

pas une consommation énergétique plus importante que la baisse

permise par le modèle.

On parle alors d'IA rouge ou verte :

l L'IA rouge (red AI) recherche à tout prix

l'amélioration de la précision, en s'appuyant sur la puissance de

calcul des machines et en complexifiant les modèles;

34 L'expression «IT for Green»

désigne le fait d'utiliser une technologie dans un cadre

écologique, alors qu'elle n'a pas forcément été

créée pour cela et qu'il ne s'agit que d'un cadre d'application

spécifique. Cette notion s'oppose au Green IT qui est une

technologie pensée de manière écologique pour

répondre de manière sobre à un besoin.

l

32/62

L'IA verte (green AI) recherche l'efficacité,

en tentant de se rapprocher des performances de l'IA rouge tout en

réduisant au maximum ses coûts et son impact (environnemental et

social), qui sont des critères d'évaluation à part

entière.

Il est donc indispensable d'établir un

équilibre entre les coûts et les bénéfices de chaque

intelligence artificielle pour se demander si ses besoins sont bien

inférieurs à ce qu'elle va pouvoir générer comme

bénéfice. L'évaluation peut être à la fois

chiffrée, mais également qualitative, dépendant ainsi du

contexte d'utilisation. Il est également utile de se demander si le

recours à cette technologie est réellement nécessaire :

est-il pertinent d'utiliser ChatGPT pour rechercher la date de naissance de

Simone Veil alors qu'une simple requête sur internet permettrait

d'obtenir cette réponse et serait bien moins énergivore ?

Aujourd'hui, l'intelligence artificielle est

considérée comme une nouveauté par la

société civile. Cela génère donc un engouement

autour de cette technologie, qu'une grande partie de la population veut

découvrir et apprendre à maîtriser. Nous sommes donc dans

une phase ascendante d'utilisation de ces outils avec une médiatisation

accrue : les utilisateurs ont une envie systématique d'y avoir recours,

sans vraiment s'interroger sur l'impact et l'intérêt de cette

démarche.

A l'heure actuelle, la part de la population prenant en

compte les enjeux écologiques est minoritaire. Même si cette

dimension est croissante auprès des plus jeunes

générations, il n'en reste pas moins qu'elle n'est pour l'instant

pas prioritaire. Indéniablement, l'intelligence artificielle va devoir

s'adapter et changer pour se conformer à ces convictions

écologiques grandissantes.

S'il semble peu probable que l'intelligence artificielle

disparaisse de notre monde pour des raisons écologiques, il va en

revanche être nécessaire de «mieux faire» l'IA.

Au-delà de la question de la mesure de l'impact, il va falloir que la

démarche cherche intrinsèquement à le diminuer. Un

modèle très bien documenté, décrivant chaque test

ayant été fait, les résultats obtenus et les conclusions

tirées permet non seulement d'accroître les connaissances dans le

domaine mais également de ne pas reproduire des erreurs

déjà effectuées. Etroitement lié à la

question de la transparence, on comprend donc que l'accès aux

informations peut non seulement être source de progrès mais

également d'économie de ressources environnementales. Ainsi, un

développeur pourra directement partir d'un modèle

déjà optimisé pour l'adapter à son cas

d'application sans avoir besoin de le reconstruire entièrement.

Ce qui reste aujourd'hui peu étudié est tout de

même l'impact environnemental global des modèles d'IA. Il convient

donc de se demander si la bonne manière d'aborder ce type d'étude

ne serait pas de se rapprocher d'une ACV (Analyse du Cycle de Vie). Il n'y a

aujourd'hui pas de méthode établie pour mesurer le coût

écologique d'une solution. Selon les cas, toutes les étapes du

cycle de vie ne seront pas prises en compte ou alors, elles le seront de

manière différente. Certaines entreprises vont vouloir être

les plus exhaustives possible, tandis que

d'autres ne vont se concentrer que sur leur

développement pour avoir des résultats les plus vendeurs.

Globalement, il semble indispensable de prendre en compte

l'ensemble des étapes nécessaires au bon fonctionnement final de

l'intelligence artificielle. Même si toutes les structures ne font pas

cette démarche, c'est cette évaluation globale qui paraît

la plus pertinente. On y retrouve donc quatre éléments principaux

devant être évalués:

l Le matériel utilisé pour faire fonctionner

l'IA (serveur, ordinateur, capteurs, câbles, antennes...);

l La phase d'entraînement du modèle pour

déterminer les hyperparamètres optimaux, offrant les meilleures

performances possibles;

l La phase d'entraînement sur le jeu de données

final, avec les hyperparamètres optimaux fixés;

l La phase d'utilisation du modèle.

A l'heure actuelle, un faible nombre d'évaluations

cherchent à être systémiques. Jusqu'à peu, l'outil

d'évaluation green algorithm35 est celui qui faisait

foi. Pourtant, ce dernier ne prend pas en compte le matériel

nécessaire au fonctionnement des modèles, qui est pourtant un

poste de dépense de ressources très important. Même si de

nouveaux outils apparaissent, tentant d'être plus complets que green

algorithm, aucun ne fait aujourd'hui consensus.

Il n'existe d'ailleurs pour l'instant pas de label permettant

d'attester du caractère éco-responsable d'une intelligence

artificielle. Même si de plus en plus de modèles sont

développés avec ce but, il n'a pas encore été

défini de critères objectifs pour établir le

caractère vertueux ou non d'un modèle.

Plusieurs labels complémentaires existent dans des

domaines adjacents. C'est par exemple le cas du label «ADEL-AI Act»

s'intéressant au cadre éthique du modèle, en regardant ses

objectifs, sa transparence et sa sécurité. Dans le domaine

écologique, l'Institut du Numérique Responsable (INR) a

également créé son label : le Label du Numérique

Responsable. Ce dernier évalue l'impact environnemental des

technologies, mais il n'est pas adapté à l'intelligence

artificielle ; il s'intéresse à l'ensemble des solutions

numériques pouvant exister avec des critères beaucoup plus vastes

qui ne sont pas forcément compatibles avec les modèles d'IA. Il

s'intéressera par exemple à la sobriété d'un site

internet, pour s'assurer que la consultation de celui-ci ne

génère pas une trop forte consommation de ressources.

La question de l'évaluation de l'impact de

l'intelligence artificielle n'est donc aujourd'hui pas réglée.

Même si des pistes commencent à faire consensus (comme les phases

à prendre en compte dans l'analyse), aucun référentiel

n'est actuellement établi pour calculer le coût environnemental de

ce type d'algorithme. Ce qu'il en ressort toutefois, c'est qu'il est

indispensable que l'apport généré par l'algorithme soit

bien supérieur à son coût d'utilisation et de

création. Aujourd'hui, comme l'évoque Juliette FROPIER en annexe

6, le Ministère de la Transition Ecologique n'encourage aucune

initiative qui n'est pas en capacité de prouver que les

33/62

35 https://www.green-algorithms.org/

34/62

bénéfices de son recours sont bien

supérieurs à ses coûts. C'est bien cela qui doit être

prioritairement regardé.

Les outils de quantification doivent être choisis au

regard de l'objectif d'utilisation et ne peuvent donc pas être

universels. Il est ainsi nécessaire de s'interroger

systématiquement sur la pertinence du recours à une technologie

pour un cas d'application donné.

Par ailleurs, il est indispensable de regarder les impacts

indirects de ces technologies, pour tenter d'avoir une vision la plus

exhaustive possible. Une large partie de ces effets annexes se retrouvent dans

l'effet rebond qui peut générer une surconsommation liée

à l'arrivée d'une technologie. Leur prise en compte est donc

indispensable pour s'assurer de la pertinence d'une solution.

2.3.2. L'effet rebond, facteur de réduction du

progrès

L'effet rebond est bien souvent négligé lors de

prise de décision et est pourtant capable de détruire les

bienfaits d'une action. En effet, son principe est simple : lorsqu'une mesure

permet de diminuer sa consommation d'une ressource, cette dernière sera

utilisée ailleurs et ne sera pas économisée.

L'effet rebond était initialement appelé le

paradoxe de JEVONS (de l'économiste du XIXème

siècle du même nom). William Stanley JEVONS a observé que

le progrès dans l'efficacité énergétique des

machines à vapeur n'a pas réduit l'utilisation de cette ressource

à l'échelle macroéconomique, puisque les gens ont

continué à utiliser le charbon économisé dans

d'autres secteurs. Ce phénomène intimement lié à

l'économie a été constaté dans de nombreux domaines

et aujourd'hui essentiellement classifié en deux catégories :

l L'effet rebond direct : la machine à vapeur consomme

moins de charbon, donc elle pourra être utilisée plus souvent ou

plus longtemps;

l L'effet rebond indirect : la machine à vapeur

consomme moins de charbon, donc le charbon restant pourra être

utilisé pour d'autres applications.

Ce phénomène incite donc à s'interroger

sur les objectifs des démarches d'innovation : les économies de

ressources sont-elles faites dans un but de sobriété ou

d'accroissement de la consommation ? En effet, dans un monde où les

ressources naturelles sont limitées pour maintenir un niveau de

développement et de croissance constant, il est indispensable

d'apprendre à faire avec moins.

Pour autant, cette approche interroge sur la

sobriété. Alors que ce concept devient essentiel dans un monde

où la transition écologique est indispensable, il est donc

nécessaire de réduire les consommations et non de les

transformer.

Il a ainsi été estimé en 2017 par

FREIRE-GONZALES36 qu'en Union Européenne, l'effet rebond

représentait entre 70 et 80%. Ceci signifie que dans le cas d'une

innovation permettant de diminuer, par exemple, la consommation

électrique de 100 kWh, entre 70 et 80 kWh seront

36 FREIRE-GONZÁLEZ, Jaume. A new way to

estimate the direct and indirect rebound effect and other rebound indicators.

Energy, 2017, vol. 128, p. 394-402.

35/62

réutilisés ; l'économie ne sera donc que

de 20 à 30 kWh. Intimement liées à nos modes de

consommation, ces pratiques dépendent énormément des pays

puisqu'il a estimé que, pour le Canada, l'effet rebond est autour de 40

%37.

L'existence de ce phénomène interroge donc sur

la pertinence de l'innovation, qu'elle soit en intelligence artificielle ou

dans d'autres domaines, dans un objectif de réduction de l'utilisation

des ressources. En effet, par définition, l'innovation cherche à

améliorer les performances, ce qui signifie que la nouvelle technologie

apportée sur le marché permettra donc d'obtenir un

résultat similaire en réduisant son impact écologique. Or,

si 70 % des économies réalisées sont en

réalité réutilisées, il ne s'agit pas

d'économie mais de réallocation.

L'effet rebond met donc en perspective la quantité

d'efforts à faire et d'innovation à produire afin d'effectivement

diminuer drastiquement l'impact écologique de nos modes de vie. Dans le

cas de l'Union Européenne, si seulement 30 % des économies

réalisées sont effectivement des gains de ressources, alors la

marche vers la sobriété devient plus grande.

C'est notamment un des sujets qui a été

abordé lors de l'entretien présenté en annexe 1 avec

Christophe PHAM. Son entreprise dans le numérique durable, Infogreen

Factory, permet par exemple de construire des sites internet avec un impact

écologique largement diminué. Ainsi, le site d'Infogreen Factory

économise 92 % des émissions de gaz à effet de serre lors

de sa consultation par rapport à un site classique. Or si, comme la

consommation est réduite, une entreprise va par exemple pouvoir

décider de créer un plus grand nombre de pages, et l'impact

positif devient réduit. Dans ce cadre, Christophe PHAM s'interroge

même sur la responsabilité de son entreprise dans ce

phénomène puisqu'elle incite indirectement à continuer

à la consommation et non à faire preuve de

sobriété. Il ne s'agit donc ni d'un changement de

mentalité, ni d'un changement de pratique.

Toutefois, l'effet rebond n'est pas toujours le reflet de

comportements négatifs : si les technologies permettent désormais

de se chauffer à moindre coût grâce à une

consommation énergétique mieux anticipée, l'effet rebond

macroéconomique peut simplement être lié à

l'utilisation du chauffage par des foyers qui n'en avaient pas les moyens

auparavant. Dans ce cas, l'effet rebond contribue au bien-être, puisque

les économies de ressources effectuées permettent de

répondre à un besoin élémentaire de la

population.

37 GILLINGHAM, Kenneth, RAPSON, David, et WAGNER,

Gernot. The rebound effect and energy efficiency policy. Review of

environmental economics and policy, 2016.