|

Rendu le 09/06/2020

Ecole Supérieure de Réalisation

Audiovisuelle

ISTS option Audiovisuel

MÉMOIRE de fin d'études

Quels Sont les Enjeux de l'Audio Orienté Objet

?

Axel Morvan

Promotion 2020

Sous la direction de Mr Bergame Periaux

Remerciements:

Je tiens à remercier Monsieur Bergame Periaux qui m'a

transmis sa passion pour le son multicanal et guidé vers cette

thématique enrichissante et passionnante. Je le remercie

également de m'avoir aider à mener à bien ce

mémoire.

Je remercie mon entourage ainsi que tous ceux ayant

participés au questionnaire avec beaucoup d'enthousiasmes.

Je remercie mon équipe, Lucas Benoist et Yann Douhou, ils

ont contribué à la re-création sonore du court

métrage Paperman, qui a servi pour les expérimentations.

1

Enfin, je remercie mes parents pour leur soutien.

2

Table des Matières

Introduction 4

1. L'Orienté Objet, Qu'est-ce que c'est ?

5

1.1 Le Contexte 5

1.2 Le Concept 11

1.3 ADM (Audio Definition Model norme ITU-R BS.2076-2) 13

1.3.1 Audio «Orienté canal» (Channel Based)

14

1.3.2 Audio «Orienté Scène» (Scene Based)

14

1.3.3 Audio «Orienté Objet» (Object Based)

15

1.4 Fonctionnalités de l'ADM 16

1.4.1 Les Fonctions d'adaptations de l'ADM 16

1.4.2 Application de l'ADM 17

1.4.3 La Question de la Réverbération 18

1.5 Les Différentes familles de l'Audio Objet 19

2. Quelles sont les applications du format Objet ?

20

2.1 La Sonorisation 20

2.1.1 WFS 21

2.2 Le Cinéma 25

2.2.1 Le Dolby Atmos 25

2.2.2 MDA DTS:X 28

2.2.3 WFS 30

2.3 Le Broadcast et les Supports grand public 31

2.3.1 MPEG-H 31

2.3.2 Dolby Atmos 37

2.3.3: DTS:X 38

2.3.4: WFS 40

2.4 La Réalité Virtuelle (VR) 40

2.4.1 MPEG-H 40

2.4.2 Dolby Atmos 41

2.5 La Musique 41

2.5.1 MPEG-H avec Sony 360 Reality Audio 41

2.5.2 Dolby Atmos Music 43

2.6 Etude Statistique 43

2.6.1 Les Événements Live (concert, spectacles,...)

44

2.6.2 Le Cinéma 45

2.6.3 Le Broadcast et les supports grand public 47

2.6.4 Synthèse 49

3

3. Comment réaliser un projet audiovisuel au

format Orienté Objet ? 50

3.1 Contexte d'étude 50

3.2 Comment rendre un projet au format ADM 51

3.2.1 ADMix de l'IRCAM 51

3.2.2 MHAPI de Fraunhofer 56

3.2.3 Dolby Atmos 60

3.2.4 Pyramix de Merging Technologies 63

3.3 Comment fonctionne la compatibilité ADM des

différents outils? 64

3.3.1 Compatibilité avec l'outil de l'IRCAM 64

3.3.2 Compatibilité avec l'outil de Fraunhofer 64

3.3.3 Compatibilité avec l'outil de Dolby 66

3.4 Synthèse 67

Conclusion 68

Bibliographie 71

Annexes 74

A _ La norme ADM 75

1 Compléments de la norme ADM 75

2 La réverbération avec l'OBA 77

B_ Compléments sur le Dolby Atmos 78

C_ Étude Statistique 79

1 Sondage «La Nouvelle Génération Audio»

79

2 Sondage ORPHEUS 86

D_ Réalisation d'un projet audiovisuel au format Objet

87

Mémoire disponible sur le site:

axelmorvan85.wixsite.com/memoire

ou

depuis le Portfolio: axelmorvan.wordpress.com/

4

Introduction

Les contenus audiovisuels foisonnent, les moyens de diffusions

se diversifient et pourtant, il est difficile aujourd'hui d'adapter ces

contenus selon les besoins sonores des auditeurs.

Bien que le contenu soit distribué pour de multiples

utilisations, le projet reste peu malléable en fonction du contexte

d'écoute. En réalité, seul le studio où a

été réalisé le contenu restitue fidèlement

les intentions artistiques, ce qui est problématique pour les

créateurs tout comme le public.

La production cinématographique est en quête

d'immersion, avec l'apparition de formats utilisant de plus en plus d'enceintes

et de canaux. Seulement, les salles de cinéma ont elles aussi chacune

leur configuration et installation. La localisation sonore se devant

d'être cohérente à l'image, peut alors s'avérer

complexe pour rendre le projet optimal en tout lieu.

Malgré cette quête d'immersion,

l'événementiel continue de diffuser une image sonore

stéréo plate, voire monophonique pour des concerts ou spectacles,

dans le seul but que le son soit audible par le plus grand nombre.

Puis, avec notamment l`apparition du Dolby Atmos en 2012

survint le terme «objet audio» ou «audio orienté

objet» dans la production sonore, termes assimilés à la dite

«nouvelle génération audio» repensant la conception

sonore d'aujourd'hui. Mais qu'est ce que la nouvelle génération

audio? Quels sont les enjeux de l'Audio Orienté Objet

?

5

1. L'Orienté Objet, Qu'est-ce que c'est ?

1.1 Le Contexte

Afin de bien comprendre ces enjeux, il nous a semblé

important de retracer quelques étapes importantes du son, jusqu'à

nos utilisations et besoins actuels, avant d'appréhender le concept de

l'Audio Orienté Objet.

En 1932, suite à l'invention de la

stéréophonie par l'ingénieur Alan Blumlein un an

auparavant, le brevet de Gance-Derbie sur la projection sonore à

haut-parleur

1

multiple est déposé . La musique au

cinéma est alors interprétée en direct, tandis que les

dialogues et effets sont sur deux pistes optiques. L'enceinte

dédiée avait comme avantage une bonne intelligibilité des

dialogues, en plus d'une cohérence à l'image. Mais un technicien

doit opérer manuellement la bascule afin d'avoir les dialogues à

l'arrière de l'écran et les effets en surround.

«La tâche incombant à l'opérateur

étant fastidieuse, les techniciens s'accordèrent sur le fait

qu'il était tout à fait acceptable d'avoir conjointement, les

dialogues et la musique d'orchestre, diffusés en un seul et même

point derrière l'écran. Cette anecdote du début du

cinéma parlant, entraine par son échec les prémisses du

mixage

2

orienté canal , alors qu'il constitue sans le

savoir les fondements du mixage orienté objet.»

3

Puis le film Disney «Fantasia» en 1940, marqua à

son tour l'histoire du cinéma sonore, car ce fut le premier film

commercialisé en son stéréo (et multicanal).

Mécontent de la qualité sonore de l'époque, Walt Disney

voulait créer un film plongeant le spectateur dans la scène

sonore, comme étant à la place d'un chef d'orchestre, avec des

sons se déplaçant à travers la scène.

Mots clés: Gance-Derbie, Stéréophonie,

Blumlein, Disney, Fantasia,

Sources:

1 «Histoire du son au cinéma» La

semaine du son 2011, conférence SAE Institute Paris

Alanblumlein.com

2: Méthode reposant sur le principe qu'une piste

sonore correspond à une enceinte disposée dans la salle.

3: Extrait de «L'Approche Orienté Objet»

mémoire de Florent Denizot, école Louis Lumière,

2016, p.16.

6

Les ingénieurs de Disney et de Bell Labs ont

souhaité enregistrer l'orchestre de Philadelphie avec trente-trois

microphones, et neuf enregistreurs. Avec ces nombreuses pistes, le mixage fut

vite un problème pour rendre le tout réaliste et la diffusion fut

impossible avec la contrainte du nombre de piste sur la bande. Les neuf pistes

ont finalement été combinées en quatre; trois pour la

voix, la musique, les effets spéciaux; et une quatrième pour le

contrôle du volume des trois premières. Le son avait donc sa

propre bande, séparé de l'image.

La diffusion a également été

étudiée, basée sur trois enceintes à

l'arrière de l'écran et deux sur les côtés, qui

rediffusaient les signaux des enceintes droite et gauche. Les ingénieurs

ont découvert que le fait d'éloigner des enceintes entre elles

permettait le déplacement du son, sans que celui ci ne disparaisse entre

les enceintes. Cet effet de déplacement dans la scène sonore ne

pouvait pas se limiter à un contrôle de volume. Le

potentiomètre panoramique a donc été créé,

permettant le mouvement fluide du son d'une enceinte à une autre.

Le concept a donc été créé pour le

film, et Fantasia reposait réciproquement sur l'aspect technique de

diffusion, chaque salle devait donc être équipée, afin

qu'il soit bien restitué. Les différentes installations en salle

se sont révélées coûteuses et ont

considérablement augmenté les coûts de production. La

distribution sous le procédé Fantasound s'est alors

réduite, et a entraîné l'échec commercial,

malgré un concept innovant.

Après la découverte du son magnétique et

de la projection Cinerama, le CinémaScope voit le jour en 1952,

créé par la FOX, et connaîtra plusieurs normalisations de

la SMPTE (Society of Motion Picture and Television Engineers). L'image

s'agrandit grâce à l'anamorphose créé avec

l'hypergonar (optique devant le projecteur) afin de concurrencer la

télévision, le son se doit de rester cohérent.

Mots Clés: Fantasound, stéréo, Bell Labs,

Disney, SMPTE,

Sources:

Screenprism.com article

«What was Fantasound and why was it created for fantasia»

«A Retrospective of the Groundbreaking sound system of

Disney»a Kristina M Griffin Thesis

«Histoire du son au cinéma» La semaine

du son 2011, conférence SAE Institute Paris

7

Quatre pistes magnétiques sont alors

insérées (sur la même bande magnétique 35mm

dédiée à l'image) avec trois canaux (gauche, centre,

droite), et un canal d'ambiance. Le 70mm utilisera par la suite six canaux,

cinq pour l'écran un pour l'ambiance.

Après le Dolby A très utilisé pour la

réduction du bruit au cinéma dès 1966, la

société confirme sa place en 1977 avec le Dolby

Stéréo, permettant à l'aide d'un matriçage,

d'obtenir quatre canaux avec seulement deux pistes optiques sur la bande. Les

contraintes liées à la bande sont ainsi réduites, ce

procédé remplaça les précédents, le

magnétique étant plus simple, et moins coûteux.

La disposition des enceintes reste la même au fil du

temps depuis le CinémaScope, normalisé en 1987 par la SMPTE sous

la proposition de l'ingénieur Tomlinson Holman. Trois à cinq

enceintes sont disposées à l'arrière de l'écran,

quelques unes sur les côtés de la salle, et une dernière

pour les basses fréquences (système 5.1 ou 7.1). Les enceintes L

et R sont à 30° par rapport à l'enceinte centrale, et

à 110° pour les enceintes surround Ls et Rs selon la norme ITU-R BS

775-1.

C'est également en 1987 que le Dolby Pro Logic,

utilisant la technologie Dolby surround, est introduite sur le marché

grand public. De part le home cinéma, la télévision

continue de faire concurrence. Les supports se développent avec la VHS,

le DVD, puis le Blu-Ray, et les technologies Cinéma des grandes

entreprises Dolby et DTS sont de plus en plus disponibles (jeux vidéo,

films, télé) ce qui élargit les utilisations du son

multicanal et accroît la qualité. L'image évolue

également dans les années 2000, avec l'arrivée de la HD

qui bouleverse l'audiovisuel, la vente de télé écran plat

augmente, Internet est démocratisé et les smartphones affluent.

Le mode de consommation des contenus audiovisuel change.

Mots clés: SMPTE, Dolby Stéréo, Dolby Pro

Logic, Numérique, télévision

Sources:

«A Retrospective of the Groundbreaking sound system of

Disney»a Kristina M Griffin Thesis «Histoire du son au

cinéma» La semaine du son 2011, conférence SAE

Institute Paris

«Le son multicanal, de la production à la

diffusion du son 5.1, 3D et binaural» de Bergame Periaux, Jean-luc

Ohl et Patrick Thévenot, Paris, Dunod: INA 2015, 1.1.2

8

Parallèlement, le cinéma remodèle sa

chaîne de production progressivement et s'adapte au numérique. Le

film, le son, les sous-titres, les données, sont encapsulés dans

un conteneur appelé DCP (Digital Cinéma Package). Le DCP

sécurisé est ensuite transmis aux exploitants de salles par

internet, ou physiquement (disque dur). Après avoir chargé le

film dans le projecteur numérique, l'opérateur intègre la

KDM, une clé sous forme de fichier codé permettant la diffusion

du film en un temps défini (appelé aussi Key Delivery Message).

Après maturation, cette technologie permet une meilleure qualitée

visuelle et sonore, plus stable et durable. Les problèmes liés

à la pellicule comme la casse, les erreurs de montage des bobines, ou

encore les limites d'inscriptions d'informations liées à la

taille de la bande sont révolues. La projection numérique n'est

toutefois pas dispensée de problèmes techniques comme la

reconnaissance des clés. La gestion des KDM peut aussi devenir un

véritable casse tête, avec les différentes versions d'un

film nécessitant chacune une sécurité.

Suite au 5.1 standard, plusieurs propositions de normes ont vu

le jour comme le 10.2 par Thomlinson Hollman dans les années 90

(Fondateur de THX), dans les années 2000 le 22.2 de Hamasaki (ex

ingénieur de NHK) ou encore l'Auro 3D en 2006. Le format 7.1 sorti en

2010 par Dolby, est le premier résultat des recherches de la

société sur un renouveau du format multicanal, voulant une

progression sonore en lien avec les progrès visuels 3D et ainsi,

relancer la vente des places de cinéma. Cette petite avancée

marquée par la diffusion du film «Toy Story 3» de Pixar,

symbolise surtout l'envie de révolutionner la spatialisation

cinématographique. Mais Dolby atteint les limites du DCP avec un nombre

de seize canaux maximum utilisables, autres versions comprises (langues,...),

contrairement aux autres formats multicanaux utilisant des décodeurs et

moteurs de rendu. La société Immsound proposera en 2012 une

nouvelle approche, celle de l'audio Orienté Objet que nous

étudierons, et qui donnera naissance par la suite au Dolby Atmos.

Mots clés: DCP, KDM, NHK 22.2, 10.2, THX, Auro 3D, Dolby

7.1, Immsound, Dolby Atmos

9

La pluralisation des normes, et des types de diffusion, sont

au détriment du mixeur. Ces multiples supports suscitent plusieurs

déclinaisons du format original, qu'opère le technicien, afin de

correspondre aux mieux aux conditions dans lesquelles sera le spectateur. Le

mixeur fait tout son possible afin de préserver les intentions sonores

du film, tout en prenant en compte les contraintes (stockage DVD, norme de

diffusion TV,...) qui obligent une certaine baisse de qualité du

contenu. Pour la sortie d'un film, plusieurs exports doivent être ainsi

effectués lors du mastering, selon le type de diffusion et du support.

Avec le format original 5.1 PCM .WAV non compressé s'ajoute 4 :

- une version Dolby SR-D (Format numérique optique avec

une compression AC-3, utilisé pour le stockage)

- une version Blu-Ray (5.1 ou 7.1 avec les deux codages

standards Dolby True HD et DTS Master HD)

- une version DVD (5.1 compressée aux formats Dolby

Digital AC-3 ou DTS)

- une version diffusion TV (similaire au DVD avec un passage

à 25 images par seconde)

- Et enfin, une version Stéréo pour le DVD,

Blu-Ray, TV (par exemple, le Dolby Digital 2.0, le PCM Stéréo ou

le MPEG-2).

Le downmix 5.1 vers stéréo est délicat,

les conditions différentes du salon mènent à

réfléchir sur l'adaptation de différents

éléments techniques mais aussi artistiques d'un contenu.

L'acoustique bruyante et réverbérante implique une diminution de

la dynamique audio, or elle est un élément essentiel à la

mise en scène du film. Les effets doivent être

contrôlés, et leur diffusion vérifiée car à

contrario d'utiliser le canal LFE seulement pour les FX en salle de projection,

le home cinéma dédie le canal de basses à tout le bas du

spectre (en dessous de 150Hz environ) afin de restituer les fréquences

ne pouvant pas être diffusées par les petites enceintes.

Mots clés: Normes, Diffusion, Downmix, DVD, Blu-Ray, TV,

Home Cinéma

Sources:

4 «La chaîne du son au cinéma et à

la télévision, de la prise de son à la

post-production» de Lucien Balibar, Paris, Dunod: INA 2019, 6.4

p.287

10

Enfin, la réduction de l'espace sonore et la

concentration des composantes du film (musique, ambiance, reverb, effet,...)

compliquent le mix, les dialogues peuvent alors moins trouver leur place et

affecter la compréhension des voix.

Ces points doivent recevoir une attention particulière,

complexifient le mastering, et peuvent aussi conduire à une diminution

de l'expérience à la maison. L'engouement des salles de

cinéma est donc encore bien là, malgré la

sévère concurrence de l'expérience

cinématographique à la maison (VOD, SVOD,

Télévision,...). Elles se différencient nettement avec les

conditions techniques optimales et une expérience authentique impossible

à reproduire à l'identique chez soi (ambiance de la salle,

chronologie des médias, acoustique, taille de l'écran,

qualité sonore,...).

La production audiovisuelle mondiale n'a jamais

été aussi diversifiée et importante quantitativement

qu'aujourd'hui.

Nous sommes en pleine guerre des plateformes de vidéo

à la demande avec Amazon Prime, Disney+, AppleTV+, Hulu, HBO max, ou

encore My Canal, qui concurrence le géant Netflix. A contrario d'obliger

bon nombre de spectateurs à faire un choix sur leurs abonnements pour

une question de prix; le nombre et la qualité des contenus augmentent,

ainsi que le budget (plusieurs centaines de millions de dollars pour des

séries) afin de séduire et fidéliser les clients des

plateformes. Le leader à ce jour Netflix, dénombre environs 167

millions d'abonnés.

Le binaural désormais bien connu du monde de l'audio,

est de plus en plus utilisé (podcasts, parcours sonores). Cette

technique d'écoute plus naturelle joue avec les

5

fonctions de transfert de la tête (HRTF ) qui permettent

la localisation du son. Elle donne plus de plans sonores (3D) que la simple

stéréo (2D), et cela à la portée de tous,

simplement avec un casque audio. Le succès des ventes de ce dernier

ainsi que la forte utilisation de téléphone, tablette, et

ordinateur, augmentent donc le nombre potentiel d'auditeurs.

Mots clés: Plateformes, Box Office, Cinéma,

Diversité de Contenu

5 Head-Related Transfer Function transformation de l'onde sonore

par la tête et les oreilles, permettant la localisation d'un son

(Données différentes pour chaque individu).

11

Avec un début timide, la Réalité

Virtuelle (VR) se démocratise, et voit son champs d'action s'agrandir

(Culture, Formation, Sciences, Cinéma,...) en plus du jeu vidéo.

Afin d'avoir un univers immersif cohérent, la partie sonore se devait

elle aussi immersive et interactive. La technique binaurale est alors la mieux

adaptée pour ce nouveau contenu, pouvant s'adapter aux mouvements de

tête de l'utilisateurs, captés à l'aide d'un Head

Tracker.

Jusqu'à présent, chaque contenu est

créé pour une diffusion particulière (cinéma,

podcast, télé...) et se voit attribuer un format principal. Cela

implique de réadapter le contenu pour chaque situation voulue, aussi

nombreuses soient-elles. En définitive, cela prend du temps, et augmente

le nombre de version pour un seul contenu, donc plus de stockage de

données.

1.2 Le Concept

L'Audio Orienté Objet (OBA pour Object Based Audio, ou

encore NGA Next Generation Audio), a l'ambition d'adapter un contenu

audiovisuel, en fonction du spectateur et du contexte de diffusion. Cela est

rendu possible en repensant la spatialisation. Au lieu, de dispatcher les

sources sur différentes enceintes (principe multicanal classique), de

spatialiser avec un potentiomètre de panoramique classique Äi

(différence d'intensité) comme illustré sur la figure 1.1

et 1.2, le son est ici assigné à des metadatas, des

données de position (azimut, élévation, distance) et de

gain. Ces données sont stockées dans un fichier XML, qui seront

lues en même temps que le fichier sonore.

Mots clés: Channel based, compatibilité, NGA,

OBA, Scène Based, chaîne audio classique

12

Avec ces données de spatialisation bien plus

précises, il peut intégrer également des informations

techniques sur le format, le nom et type de son, ou encore les langues audio

disponibles etc. Ces fichiers XML et audio, sont encapsulés dans un

fichier BWF (Broadcast Wave Format). Le projet est alors universel et peut

s'adapter aux formats cinéma (Dolby, DTS, NHK 22.2, Auro 3D) et à

n'importe quelle situation ou se trouve le spectateur. Le temps consacré

à d'adaptation du contenu est alors révolu. En plus de tout

simplifier en un seul format, l'Orienté Objet permet d'obtenir un son

interactif, personnalisé et plus d'accès à une immersion

sonore. L'utilisateur pourra non seulement avoir accès simplement

à différents formats audio en fonction de ses besoins (5.1 pour

un home cinéma, binaural pour le casque, simple

stéréo,...) mais aussi choisir ce qu'il veut entendre,

étant donné que ce sont plusieurs matières sonores

individuelles, qui sont lues en même temps. Il sera alors possible

d'augmenter la voix d'un présentateur de sport ou ne garder que

l'ambiance d'un stade. N'écouter que l'instrumental d'une musique pour

un cover,...(figure 1.4)

«Le NGA est plus efficace en termes de débit

binaire que les technologies précédentes, de sorte que ces

nouvelles fonctionnalités ne se font pas au prix de débits

binaires plus élevés. 6 »

Mots clés: OBA/NGA, BWF, XML, Universel,

Simplification, Spatialisation Personnalisation, concept Sources:

Orpheus-audio.eu;

lab.irt.de, 6:

tech.ebu.ch/nga

13

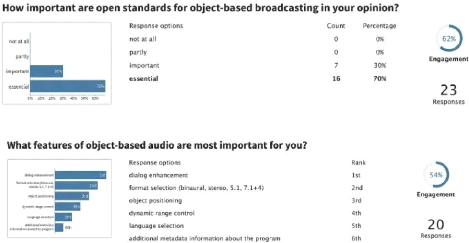

20 professionnels de l'audio ont participé à un

petit sondage réalisé lors d'un séminaire à

Genève le 17 et 18 Mai 2017, présentant les avancées

d'ORPHEUS sur l'audio basé sur objet, sur la question «Quelle

fonctionnalité est la plus importante selon vous?» (sondage en

annexe ). En première position arrive la compréhension des

dialogues, en deuxième la sélection des formats (7.1, 5.1,

binaural, stereo,...), en troisième la localisation. Vint ensuite le

contrôle de la plage dynamique, la sélection des langues, et les

metadata du programme.

En vu du contexte d'aujourd'hui, avec la forte croissance du

podcast, de la vidéo à la demande, en recherche de nouvelles

expériences audiovisuelles, accessibles simplement, l'Orienté

Objet semble tomber à pic. Les applications et améliorations sont

nombreuses.

1.3 ADM (Audio Definition Model norme ITU-R

BS.2076-2)

L'Audio Definition Model (ITU-R BS.2076-2) est une norme de

metadata pour l'audio Objet, élaboré et standardisé en

juin 2017 par l'Union Européenne de Radio Télévision (UER

EBU), avec le soutien de la BBC, France TV, Radio France et Fraunhofer. Ce

standard européen ouvert et gratuit, est le plus avancé sur les

metadatas de l'audio nouvel génération (NGA), (Document de la

norme disponible en annexe A).

Affiliant des données XML à l'audio, l'ADM

différencie les éléments du paysage sonore afin de

définir un fichier audio comme étant «Channel Based»,

«Scene Based», «Object Based» Audio.

Mots clés: OBA/NGA, BWF, XML, Universel,

Simplification, Spatialisation Personnalisation,ADM, libre

14

Sources:

Orpheus-audio.eu

1.3.1 Audio «Orienté canal» (Channel

Based)

La première solution pour spatialiser de l'audio est de

l'assigner à une enceinte, située à un point

précis. Le nombre de canaux audio correspondent alors au nombre

d'enceintes du système d'écoute prévu

(stéréo, 5.1, 7.1,...). Cette méthode fonctionne à

condition de respecter les normes de diffusion prévues pour le contenu.

Si les enceintes sont positionnées différemment de la norme de

mixage, les informations de spatialisation seront altérées, moins

réalistes donc moins immersives. Le média devra en temps normal

être ré-adapté pour être compatible sur un autre

système de diffusion (downmix 5.1 vers stereo par exemple). En assignant

de l'audio comme étant «channel based», il sera

considéré comme objet fixe, et se verra appliqué ses

données de positions, pour pouvoir être compatible sans

modification supplémentaire.

Pour une captation d'ambiance en quadriphonie, on la

définira en post-production comme étant «channel

based». Chaque canal individuel aura alors son code et ses informations

précises. Le canal gauche L aura la donnée d'azimut -30°,

droite R +30°, arrière gauche LS -110°, et arrière

droite LR +110°. 7

1.3.2 Audio «Orienté Scène»

(Scene Based)

L'audio Orienté Scène est une autre approche de

l'ambiance spatialisée. Elle fait directement référence

à l'Ambisonique, qui est une méthode de captation 3D à un

point précis de la scène sonore. Elle s'appuie sur la

superposition de plusieurs microphones, et des harmoniques

sphériques.

L'ordre correspond au nombre de capteurs utilisés par

le système, plus l'ordre est élevé, plus la restitution

spatiale est précise. Le FOA (first Order Ambisonic, ordre 1) a trois

directivités et utilisera quatres pistes. Le plus utilisé est

l'ordre 3 (TOA), pour sa bonne restitution spatiale et spectrale (restitution

des signaux HOA sur des Haut-Parleurs en annexe figure A2).

Mots clés: Channel based, compatibilité, Scene

based, Ambisonique, ordres, captation, encodage, 3D, 7 Ces

coordonnées sphériques pourront être retranscrites en

coordonnées cartésiennes si besoin pour d'autres lecteurs.

15

En plus de contenir beaucoup plus de pistes (au-delà de

seize) les ordres supérieurs au TOA peuvent contenir des défauts

spectraux et de corrélation de phases, car ils utilisent plus de

microphones. Différentes marques proposent des micros ambisonic comme

SoundField (racheté par RODE), ou Sennheiser avec l'AMBEO.

Une fois la captation réalisée (format A), il

faut dématricer le signal (format B), une manipulation des cosinus,

sinus, mixage est effectué afin d'obtenir les données X,Y, Z,

etc. L' Ambisonique est également très utilisée comme

encodeur et décodeur, pour du binaural de synthèse par exemple,

nécessitant une spatialisation 3D précise.

1.3.3 Audio «Orienté Objet» (Object

Based)

Un objet désigne un son seul, ayant une position sous

forme d'azimut et d'élévation, connaissant une variante

temporelle, qui se déplace dans la scène sonore. Ils peuvent

être plusieurs à constituer une scène. Étant un

format indépendant du système d'écoute, l'ambisonique peut

être exporté en object based. Chaque objet possède son

canal de mixage et ses métadonnées. En plus des données de

position, des paramètres sur la taille de l'objet donnant un son plus ou

moins directif sont possible. Le moteur de rendu recevra alors l'info d'envoyer

le son à l'enceinte la plus proche ou à un ensemble d'enceintes.

Le paramètre «Object Divergence» allant de 0 à 1 permet

la création d'objet fantôme, à 45° (si l'on utilise

les coordonnées sphérique) à gauche et à droite de

l'objet d'origine. C'est le même principe que le potentiomètre

«center%» dans le pan 5.1 de Pro Tools.

Chaque audio décrit comporte un identifiant, un code

avec des informations sur son format, la localisation du fichier, la langue

associée, ou encore la durée du programme, pouvant proposer le

même contenu avec plusieurs longueurs selon le temps dont dispose

l'auditeur. (Les métadonnées sur la diégèse du son

pour du contenu VR ne sont pas spécifiées par l'ADM).

Mots clés: Object Based, ADM,

Métadonnées, VR

Sources:

AES Convention Paper «Méthode d'enregistrement en

Audio Orienté Objet» le 7 Juin 2016, Paris. Audio Definition

Model Recommandation ITU-R BS.2076-2 (10/2019)

16

L'audio Object Interaction définit les limites de

l'interaction accordé à l'auditeur. Si le programme à

l'indicateur 1, il accorde une certaine liberté de modification sur le

gain ou la localisation des sons.

Si l'interaction sur le gain est autorisée, le sous

élément «Audio Object Interaction» donne une intervalle

limite ou une liberté totale. L'auditeur pourra si il le souhaite,

n'entendre que l'ambiance du match par exemple.

Si l'interaction sur la position est autorisée, le sous

élément «Audio Object Interaction» donne une intervalle

limite sur l'azimut, l'élévation et la distance (données

Sphériques ou Cartésiennes).

1.4 Fonctionnalités de l'ADM

1.4.1 Les Fonctions d'adaptations de l'ADM

Une fois l'audio référencé, plusieurs

paramètres entrent également en compte. La «Zone

d'exclusion» définit les différentes limites de l'espace 3D

(avec des données cartésiennes X,Y,Z) afin de masquer

dynamiquement les points de sources à ne pas utiliser pendant la

lecture. Les données nommées «Audio Programme Reference

Screen», elles, indiquent les références de l'écran

utilisé par le créateur de contenu. Ces coordonnées

(Polaire ou cartésiennes) peuvent influer sur la spatialisation, et

permettent l'adaptabilité spatiale du projet. Si par exemple le contenu

contient l'indicateur «ScreenRef Flag», informant que l'audio

Orienté Scène (Scene Based) est lié à la taille de

l'écran, le moteur de rendu adaptera la scène au système

de la salle recevant le contenu.

Pour ce qui est de l'adaptation d'un contenu en Binaural, la

fonction «Head Locked» (illustrée en Annexe 3 Figure A9)

définie si un objet doit bouger en fonction des mouvements de tête

(ambiance par exemple), ou ne pas en prendre compte (voix off par exemple). Le

contenu pourra être binauralisé par le moteur de rendu, donnant

à l'auditeur le choix du ratio champs direct/champs

réverbéré de l'acoustique virtualisé, et pourquoi

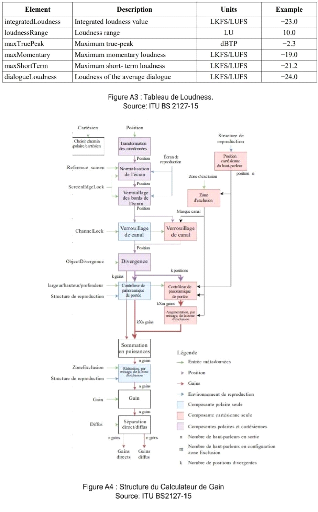

pas des HRTF. La mesure du Loudness est effectuée avec la norme

recommandée ITU-R BS.1770 fonctionnant pour les formats mono,

stéréo, et multicanaux.(cf Annexe figures A3 et A4)

Mots clés: Interaction, Audio Programme Reference

Screen, ITU-R BS.1770, Matrice, Binaural

17

La norme EBU R128 est quant à elle utilisée pour

le «Loudness Rec Type, afin d'indiquer quelle pratique a été

suivie dans la correction du Loudness»; et enfin le «Loudness

Correction Type» comment l'audio a été corrélé

(temps réel ou hors ligne).

Une matrice divisée en trois segments

interconnectés (partie encodage, décodage et direct) effectuera

les downmix/upmix, en se servant de la base de données et des

identifiants de chaque piste. Des valeurs de gain et de déphasage

peuvent être constantes ou variables pour permettre au moteur de rendu

d'ajuster ces valeurs, possiblement avec une autre source de

métadonnées. Des sous-éléments sont

également disponibles pour choisir la définition de la

conversion. Une fois que le contenu est au format ADM, tout l'audio est

encapsulé dans un fichier BWF (Broadcast Wave Format), un simple fichier

WAV contenant nos metadata XML.

1.4.2 Application de l'ADM

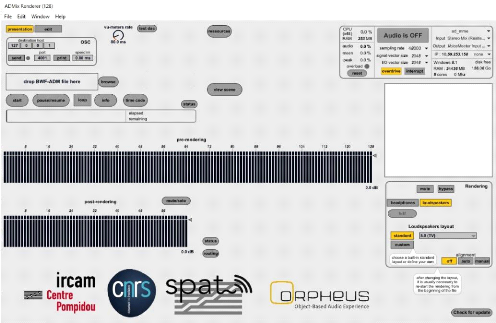

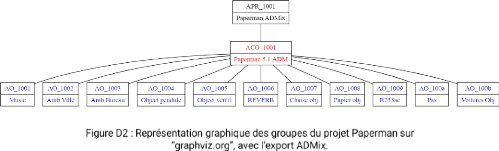

Orpheus est un projet faisant parti du programme «Horizon

2020» de la commission européenne, apportant 80 Milliards d'euros

de financement dans la recherche et l'innovation en 7 ans. Le projet a

été lancé le 1er Décembre 2015 et s'est

achevé le 31 Mai 2018, il a été le premier à

créer une chaîne multimédia de A à Z avec de l'audio

Orienté Objet (annexe figure B2). Dix partenaires participeront à

son élaboration dont Fraunhofer institute, la BBC, l'IRT, Magix (DAW

Sequoia), Elephant Candy (pour la création d'une application ios), et

aussi les français Trinnov, B-com, et l'IRCAM,...

l'Institut de Recherche et Coordination Acoustique/Musique,

à créé le logiciel ADMix permettant de rendre un projet au

format objet sous la norme ADM, mais aussi de le lire et d'extraire les

données XML. D'autres DAW sont compatibles ADM tels que Pyramix ou

Nuendo. La norme ADM vise à unifier les autres formats utilisant aussi

le principe objet (Dolby, DTS, Fraunhofer,...), en misant sur la

liberté, la transparence et la gratuité. Correspond t-elle

à toutes les applications utilisées? Comment ces

différents outils et formats objets communiquent-ils entre eux? C'est ce

que nous essayerons de voir dans le chapitre 3 de ce mémoire.

Mots clés: EBU R128,

Sources: Audio Definition Model Recommandation ITU-R BS.2076-2

(10/2019)

18

1.4.3 La Question de la Réverbération

Le plus délicat dans la recherche de l'OBA, c'est la

réverbération, qui n'est pas évoquée par la norme

ADM. Ce phénomène acoustique généré par de

multiples réflexions d'ondes sonore propre à un lieu, donnant une

couleur et une nouvelle dimension au son direct, est indispensable pour le

réalisme d'un contenu. Elle pourrait également offrir à

l'auditeur une customisation de pièces, pour une immersion d'un contenu

dans une salle de spectacle par exemple. Seulement, cet effet est complexe

à référencer en objet, tout en gardant la qualité.

Il est effectivement impensable d'utiliser un objet pour chaque

réflexion acoustique.

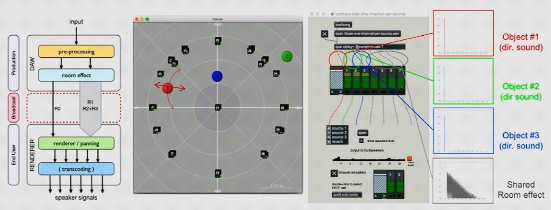

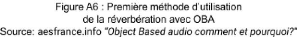

Certains membres de l'équipe ORPHEUS, Markus Noisternig

et Olivier Warusfel de l'IRCAM, ont alors proposé une réflexion

sur les techniques de réverbérations pour l'audio objet. Il

existe deux approches afin d'intégrer la reverb à l'ADM.

La première est de convertir les paramètres de

la reverb en metadata, ce qui impliquerait l'intégration d'un programme

de reverb dans le moteur de rendu.

La deuxième est l'approche «basé

signal», étudiée par ORPHEUS et S3A Audio, qui utilise le

principe Orienté Scène ou Canal. Dans cette approche, plusieurs

méthodes sont possible (illustrées en Annexe A1):

- Séparer complètement le son direct du son

réverbéré

- Avoir deux pistes pour le son direct et la première

réflexion, puis les autres réflexions (plusieurs pistes)

- Avoir trois pistes pour le son direct, la première et

deuxième réflexion, puis les autres réflexions (plusieurs

pistes)

Le moteur de rendu interprètera donc les metadata des

différents canaux avec des informations de gain et de spatialisation. A

défaut de demander plus de pistes contenant les premières

réflexions, cette technique donne d'avantages de contrôle sur la

localisation des sources.

Mots clés: Orpheus, Scene based, Taille de

l'écran, Adaptabilité, , Reverb,

Sources:

Orpheus-audio.eu

Audio Definition Model Recommandation ITU-R BS.2076-2

(10/2019)

AES «Réverbération Techniques for object

based audio» séminaire Orpheus à Genève, Mai

2017

visible sur le site AES France «OBA comment et

pourquoi»

19

Les difficultés sont aussi du point de vue de la

différenciation entre le son direct et les première

réflexions, ou encore l'intégration de la reverb pour les

programmes à multi-languages. L'approfondissement et l'étude

d'une extension se profilent donc pour le format ADM, afin de répondre

à toutes ces questions.

1.5 Les Différentes familles de l'Audio

Objet

Comme dit précédemment, l'audio objet est un son

accompagné de métadonnées qui le décrit (position,

gain,...), ils seront lus en même temps lors de la restitution. L'ADM est

d'ailleurs une proposition de norme décrivant ces

métadonnées, présent de la production à la

diffusion. Plusieurs solutions utilisent ce principe: le Dolby Atmos, le MDA de

DTS, le MPEG-H de Fraunhofer, et enfin la technique WFS, nous les

étudierons dans le chapitre 2.

Le 10.2 (de Tomlinson Holman, créateur de THX) l'auro

3D et le 22.2 de NHK sont quant à eux des normes de diffusion, surtout

présents dans les salles de cinéma. Ils font

référence à une diffusion multicanal, ou chaque son est

assimilé à une ou plusieurs enceintes, et non à des

métadonnées. Cela n'empêchera pas pour autant l'utilisation

de ces systèmes de diffusion avec un contenu objet, capable de

s'adapter.

Le binaural est aussi une méthode très

intéressante, surtout sur le point de la diffusion pour l'audio objet.

Cette technique utilise les données HRTF afin de rendre l'écoute

d'un contenu plus naturelle, avec une localisation à trois dimensions,

comme dans la vie de tous les jours. Le son 3D serait alors à

portée de tous, nécessitant simplement un casque. Le moteur de

rendu délivrant le contenu quelconque pourra restituer, après

sélection de l'auditeur, le son 3D avec les informations de la matrice

et les paramètres de binauralisation de l'audio instauré. Le

binaural peut également servir à simuler l'écoute en

auditorium ou d'une salle de cinéma pour le mixage d'un film. Cette

pratique faisait partie du projet de recherche BILI (BInaural LIstening),

lancé en Janvier 2013, en partenariat avec l'IRCAM, France

Télévision, Radio France et Trinnov entre autre.

Mots clés:ADM, métadonnées, Dolby ATMOS,

DTS MDA, MPEG-H Fraunhofer, WFS Sources:

Bili-project.org

20

2. Quelles sont les applications du format Objet ?

Après avoir présenté le principe de

l'audio objet, cette deuxième partie vise à découvrir les

applications de l'OBA, ainsi que les formats utilisés dans

différents domaines (Sonorisation, Cinéma, Broadcast, VR,

Musique).

2.1 La Sonorisation

Le but de la sonorisation a longtemps été de

diffuser le son aussi bien que possible, afin que les spectateurs puissent

entendre ce qu'il se passe sur scène. Ceci n'était pas le cas

lors de la tournée américaine des Beatles en 1964, puisque seul

les ampli de guitares servaient d'enceintes de façades, et

n'étaient guère efficaces face aux cris hystériques de la

foule. Ce n'était pas non plus le cas en 1969 lors du mythique festival

de Woodstock, qui diffusait 12 000 W de son pour 500 000 personnes, puissance

aujourd'hui utilisée pour une salle de 500 personnes. Les progrès

étaient alors dirigés sur la puissance, la consommation, le

volume/poids, la réponse en fréquence, la longue portée

avec le line source, ou encore l'audio numérique.

Dans un événement aujourd'hui, on retrouve

souvent deux points de sources principales sur chaque côté de la

scène, (parfois trois avec une source centrale, voire quatres points sur

certains grands festivals) afin de couvrir toute la zone où se trouve le

public. L'écoute y est souvent monophonique, à moins de se

trouver dans le «Sweet Spot», petite zone ou l'on peut percevoir de

la stéréophonie. Cette zone est située dans l'axe central

de la scène, car le son provenant des deux sources arrivent à nos

oreilles, avec la même intensité, sans décalage temporel,

ni détimbrage causé par la directivité de l'enceinte. Mais

dans la majorité des cas, le spectateur écoute le son provenant

d'une seule enceinte, en plus ne correspondant pas à l'image sonore

réelle de la scène, car la localisation sonore est contradictoire

avec ce qu'il voit, comme l'illustre la figure 2.1.

Mots clés: Sonorisation, WFS, IRCAM, Sonic Emotion,

Euphonia, Huygens, Sources:

Orpheus-audio.eu

Avec une localisation imprécise, le mix est bien plus

compliqué à construire, à rendre tous les instruments

cohérents dans un espace spatial et spectral plus restreint.

2.1.1 WFS

La WFS (Wave Field Synthesis) est issue des recherches

notamment de l'IRCAM, de l'université de Delft au Pays Bas, et des

sociétés comme Sonic Emotion ou encore Euphonia. La

synthèse du front d'onde (WFS) est une technique de restitution

multipliant le nombre de point de diffusion sur le même plan horizontal.

L'ensemble des enceintes est excité en même temps(figure 2.2),

générant un front d'onde (type plane) selon le principe

d'Huygens, s'inspirant des ondes à la surface de l'eau 8 .

21

Mots clés: WFS, 360°, 3D, Objet, Sonic Emotion,

L-Acoustics,

Sources:

Orpheus-audio.eu ;

Sonicemotion.com;

L-Acoustics;

Euphonia.fr

8 «Le son multicanal, de la production à la

diffusion du son 5.1, 3D et binaural» de Bergame Periaux, Jean-luc

Ohl et Patrick Thévenot, Paris, Dunod: INA 2015, p.104.

22

Des microphones placés en ligne, ayant le même

espacement que les diffuseurs ponctuels (amplifiés individuellement),

donnent une représentation conforme de la scène. Le

procédé étend le Sweet Spot stéréo ainsi que

le champs sonore à presque l'ensemble du public, offrant une

écoute beaucoup plus naturelle et réaliste qu'un système

de sonorisation classique (cf zone verte représenté sur la figure

2.4). Le spectateur peut alors se déplacer ou se positionner à

n'importe quel endroit, tout en gardant une localisation cohérente de

chaque source. Par conséquent, une localisation améliorée

permet une meilleure précision spectrale des sources, un mix plus clair

et plus de liberté créative.

Les angles de diffusion des ondes planes sont

contrôlés avec des delay. De multiples configurations d'enceintes

sont possibles, comme élargir le champ sonore avec des sources

supplémentaires aux extrémités («extension»),

mais aussi diffuser du son en 360° ou en 3D afin d'immerger le public dans

le son (cf figure 2.4). En plus d'une diffusion innovante, on retrouve le

principe objet avec les données de position (Pan, Width, Distance,

Elevation) pour chaque source réelle ou virtuelle, décuplant les

possibilités artistiques. Le mix d'un format (stéréo, 5.1,

7.1,...) peut aussi être facilement adapté au système

utilisé. Mais de nouveaux besoins surgissent, car

l'événementiel peut contenir plusieurs contraintes comme

l'acoustique du lieu, les positions d'enceintes imparfaites, le show

control,...

Mots clés: WFS, 360°, 3D, Objet, Sonic Emotion,

L-Acoustics,

Sources:

Orpheus-audio.eu ;

Sonic Emotion; L-Acoustics ;

Euphonia.fr

23

Un processeur spécial WFS comme le Wave1 de Sonic

Emotion, vient alors s'insérer dans la chaîne du son, entre la

table de mixage (ou DAW) et l'amplification. Il reçoit par le biais

d'une transmission audionumérique, chaque canal individuel de la console

correspondant à un objet. Parallèlement, les metadatas de

positions de chaque piste sont transférées au Wave1. Le tout est

calculé par le processeur, puis le signal audio traité est

envoyé aux enceintes. Le Wave1 est contrôlable en temps

réel, afin d'indiquer les informations concernant les objets sur le

logiciel WavePerformer, à l'aide de plugins, d'interfaces et de

trackers. Avec ce dernier, la localisation du son diffusé pourra suivre

automatiquement la position de la source d'origine.

L-Acoustics:

Le géant Français de la sonorisation

L-Acoustics, est récemment entré dans le marché de la WFS

avec son système L-ISA. Son processeur peut intégrer 96

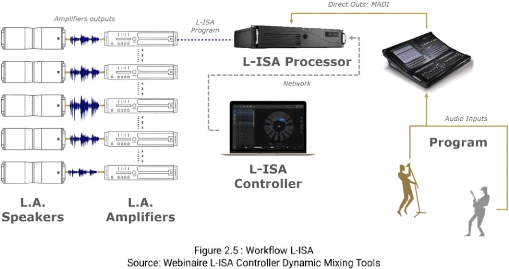

entrées audio (correspondant aux objets) et 64 sorties hauts parleurs

avec le protocole MADI. Une sortie AES/EBU est disponible pour transmettre un

downmix stéréo de secours généré

automatiquement, et un cable RJ-45 permet la liaison remote en DHCP entre le

L-ISA Processor et le software L-ISA Controller (Cf figure 2.5).

Le logiciel supervise les objets et groupes d'objets, les

presets de scène, ainsi que les contrôles externes possible avec

le plugin LA (compatible Protools, Nuendo, Reaper, Ableton Live), les tables de

mixages (plugin compatible Yamaha, Avid, et Digico), des trackers, ou encore

des interfaces OSC. Le logiciel intègre également des outils de

traitements pour corriger le son suivant l'acoustique du lieu.

Mots clés: WFS, 360°, 3D, Objet, Sonic Emotion,

L-Acoustics,

Sources:

Orpheus-audio.eu ;

Sonic

Emotion.com;

L-Acoustics.com ;

Euphonia.fr ;

24

Le système de L-Acoustics est déjà bien

présent dans le monde, pour des concerts symphoniques («Harry

Potter et le prisonnier d'Azkaban» en Australie, concerts d'Ennio

Morricone), des tournées (Christine and the Queen, Gambino enfantin),

des festivals (Tomorrowland, The Lab Panorama) ou le Parc à Thème

Français le «Puy du Fou» aux Epesses.

Ce dernier fut la première implémentation du

système dans le monde, cela pour le spectacle «Le Dernier

Panache», demandant une configuration sonore particulière.

Doté d'une tribune tournante qui s'axe sur plusieurs décors, le

son de diffusion devait suivre la rotation de la tribune. Ceci fut possible

avec l'utilisation d'objets audio et des capteurs, permettant de diffuser au

bon moment sur les bonnes enceintes (placées en couronne) le son du

spectacle, tout en prenant en compte les mouvements (plus ou moins lent) de la

tribune.

Mots clés: WFS, 360°, 3D, Objet,

L-Acoustics,L-ISA, Sources:

l-isa-immersive.com

et les webinaires sur le L-ISA

25

La technique de diffusion WFS est innovante, et résout

bon nombre de problèmes existants, sans complexifier l'utilisation, mais

elle doit encore se démocratiser.

Les prestataires doivent se procurer le matériel

nécessaire, afin de proposer ce service aux organisateurs.

L'emplacement, l'installation et le câblage des enceintes doivent aussi

être repensés et organisés avec les techniciens de

scène pour les événements occasionnels. Les salles doivent

s'équiper et apporter un service adapté aux besoins des groupes

qu'ils accueillent. Enfin les techniciens et créateurs doivent assimiler

les outils, afin d'utiliser cette technique au service des

événements. Tout cela prend du temps, mais finira, certainement

et on l'espère, par convaincre les professionnels du spectacle, et les

spectateurs.

2.2 Le Cinéma

2.2.1 Le Dolby Atmos

Le Dolby Atmos est sans doute le procédé

orienté objet le plus connu, car véritable atout marketing pour

les salles de cinéma, allant jusqu'à faire une

démonstration du système avant le lancement d'un film. Il est

associé à la technologie Dolby Vision (pour l'image) pour les

salles Dolby Cinema, souvent proposé sans majoration de tarif,

comparé aux places en salles standard. Parmis 5000 salles

équipées (ou en cours d'installation) dans plus de 90 pays dans

le monde, la France peut être considérée comme très

bien équipée, comptant à ce jour plus de 130 salles dans

l'hexagone (Pathé/Gaumont, CGR, Cinévilles,...). Le film Pixar

«Rebelle», fait le premier pas vers la technologie Atmos, ils sont

aujourd'hui plus de 1500 («Gravity» d'Alfonso Cuarón,

«Mad Max: Fury Road» de George Miller, «Ready Player One»

de Steven Spielberg, mais aussi des séries avec la saison 2 de

«Game of Thrones» de Weiss & Benioff, qui est 1ère

série Atmos (après remixage), et «Sherlock» de Steven

Moffat & Mark Gatiss, première à intégrer le format

nativement).

Mots clés: Atmos, Dolby Cinéma, 7.1 , Immsound,

Rétrocompatible, beds, object

Sources:

C

inemaspathegaumont.com

Blogcobrason.com

Dolby.com et Dolby Atmos White Paper

26

L'envie d'un renouveau multicanal (création du Dolby

surround 7.1), et le rachat en 2012 de la firme Imm Sound (créer en

2010) avec ses recherches conduiront à la naissance du Dolby Atmos la

même année. Les travaux de la société espagnole

étaient dirigés sur la gestion de l'audio, des metadatas et du

DCP, jusqu'à la diffusion en trois couronnes (23.1 ou 14.1). Sur la

couche supérieure, trois enceintes frontales et cinq au plafond; sur la

couche intermédiaire trois enceintes LCR, six canaux pour dix enceintes

latérales et deux canaux pour six enceintes à l'arrière.

Pour la dernière couche inférieure, trois enceintes frontales

avec deux sub pour le canal LFE 9 .

Dolby se sert donc de cette base de recherche et instaure son

format de diffusion, en prenant en compte les aménagements de chaque

salle. Le nombre de haut-parleur peut ainsi varier selon la configuration

existante. Derrière l'écran, on retrouve trois enceintes LCR, et

une enceinte supplémentaire de chaque côté du canal centre

(Lc et Rc), conseillées pour des écrans de plus de 12

mètres, pour une localisation sonore plus cohérente et fluide (cf

carrés verts sur la figure 2.6). Tous ces hauts parleurs sont

dirigés vers un point de référence. Le caisson de basse

lui, est positionné de façon asymétrique par rapport au

centre de la salle afin d'éviter les ondes stationnaires.

L' Atmos est totalement rétrocompatible avec le 7.1 /

5.1, notamment en conservant la position des canaux existants, et en optimisant

l'intégration de nouveaux. 64 Enceintes au total peuvent être

gérer par le processeur. Les nouvelles se situent au plafond et sur les

côtés entre les enceintes de façades (écran) et

surround, la couverture sonore dans la salle est alors élargie (cf

carrés bleus sur la figure 2.6). Une nouvelle dimension, celle de la

hauteur et l'élévation est possible avec précision. Au

lieu de reproduire un son sur plusieurs enceintes, ici le son peut être

lu uniquement sur un haut parleur, augmentant considérablement la

localisation, la cohérence à l'image et la liberté

créatrice.

Mots clés: Atmos, Dolby Cinéma, 7.1 , Immsound,

Rétrocompatible, beds, object

Sources:

Dolby.com et Dolby Atmos White Paper

9 «Le son multicanal, de la production à la

diffusion du son 5.1, 3D et binaural» de Bergame Periaux, Jean-luc

Ohl et Patrick Thévenot, Paris, Dunod: INA 2015, p.40.

Contrairement à l'ADM, l'Atmos distingue seulement deux

types de sons dans un contenu, le «bed» et les «objets»

pour une meilleure compatibilité dans les salles. Le «bed»

(souvent en 7.1), est le «décor» du paysage sonore, et

contient les sons ayant une localisation fixe assignée à un canal

(ambiances, musique, similaire à l'orienté canal ou au multicanal

traditionnel), contrairement aux «objets» pouvant être en

mouvement. Ils peuvent aussi être statiques et représenter une

position précise dans l'environnement. Le procédé peut

utiliser jusqu'à 128 canaux. Le processeur se chargera

d'interpréter les objets / bed, et de transmettre le signal vers les

enceintes, (cela bien plus fidèlement que le principe multicanal) en

faisant une concordance avec les coordonnées de la salle.

27

Mots clés: Atmos, Dolby Cinéma, 7.1 , Immsound,

Rétrocompatible, beds, object

28

Les fichiers audio et métadonnées Dolby Atmos

sont livrés avec les fichiers traditionnels 5.1 et 7.1 dans un seul et

unique DCP pour toutes les salles équipées ou non,

éliminant les besoins de plusieurs fichiers selon les versions.

Dans la salle Atmos, les fichiers appropriés seront

décodés par le processeur (ou RMU Server), et pourront à

tout moment basculer au format inférieur si nécessaire, et cela

sans interruption durant la projection. Un outil de monitoring («Dolby

Atmos Monitor Tool») est fourni, ainsi que l'outils «Dolby Atmos

Designer Tool» permettant la calibration de la salle.

2.2.2 MDA DTS:X

2012 est décidément une année

charnière pour le son orienté objet. DTS, le concurrent direct de

Dolby, fait l'acquisition de SRS Labs, entreprise de processing audio contenant

cent cinquante brevets. Parmis eux, le MDA (Multi Dimensional Audio), un format

audio PCM non-compressé Orienté Objet, (.mda incluant les

métadonnées propres au format) compatible DCP, destiné aux

professionnels. La firme mise alors sur la gratuité de licence pour les

productions, et la liberté du format, avec certaines

spécifications libres de droits et pris en charge par un SDK (Software

Development Kit) facilitant son évolution. Il a également

été standardisé par l'ESTI, SMPTE et l'ITU.

Mots clés: Atmos, Dolby Cinéma, 7.1 , Immsound,

Rétrocompatible, beds, object Sources:

Dolby.com et Dolby Atmos White Paper ;

MDA White Paper;

dts.com

29

En 2015, le MDA devient DTS: X pour l'exploitation dans les

salles de cinéma et les produits grand public.

Coté production, à ce jour, plus de cent films

ont été mixés en DTS:X comme «Midway»,

«Ford v Ferrari», ou «Sonic Hedgehog». Après une

implémentation de 14000 salles DTS dans le monde en 1998 (contre 15000

salles Dolby Digital), le déploiement DTS:X semble plus timide, environs

1000 installations, majoritairement en Amérique du Nord (AMC Theatre,

Cinépolis, Cinémex, Epic Cinémas, UEC...). Un

récent accord avec CJ 4DPLEX prévoit une intégration dans

les salles ScreenX dotées d'un écran 270°.

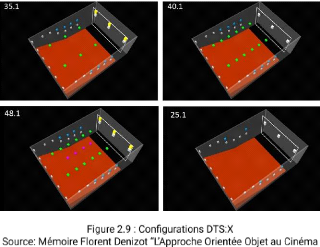

Le principe reste similaire au concurrent, quatres

configurations type (basées sur le 7.1) sont proposées selon la

taille des salles, tout en prenant en compte les conditions de celles-ci, sans

y percevoir un nombre idéal d'enceintes (figure 2.9). Le format est

compatible avec les configurations Dolby Atmos, 22.2, Auro 3D,...

Bien que l'on retrouve les mêmes arguments que Dolby,

soit une meilleure restitution, une fidélité créatrice

dans toutes situations, le DTS:X MDA reste moins fermé que son rival,

avec une installation ne nécessitant aucun matériel

propriétaire, rendant l'adaptation d'une salle plus efficace.

Mots clés: MDA, DTS, SRS Labs, PCM non

compressé,

Sources:dts.com et MDA White Paper

«L'Approche Orienté Objet» mémoire de

Florent Denizot, école Louis Lumière, 2016. p.40

30

Concernant la création, DTS met à disposition

une suite d'outils sous forme de plug-ins AAX Protools ou logiciels stand alone

fonctionnant sur macOS. Parmis ces outils, le MDA Creator permettant de placer

un nombre illimité d'objets dans l'espace, un encodeur, et un lecteur.

Un auditorium certifié ATMOS est totalement compatible pour fonctionner

avec le MDA. Ces auditoriums Dolby Atmos en France sont aussi

équipés et certifiés DTS:X 10 .

2.2.3 WFS

La WFS nous l'avons vu, est surtout connu de

l'événementiel, mais des salles de cinéma utilisent aussi

pour certaines d'entre elles ce système, s'éloignant ainsi de la

course aux formats. Reposant sur la multiplication des diffuseurs et sur

l'audio objet, la salle de cinéma pourrait alors contenir avec cette

technique un nombre suffisant d'enceintes, donnant une grande précision

spatiale, et ainsi, être capable de recevoir tous types de formats. La

salle et le processeur s'adapteraient, sans altérer le contenu.

Avec ces avantages sur le papier, la WFS aurait pu influencer

l'installation des salles de cinéma, et pourtant le Dolby Atmos semble

dominer le marché du cinéma Orienté Objet. Les

inconvénients semblent principalement être au niveau du coût

de l'installation et la de la complexité d'adaptation, dus à un

nombre important d'enceintes. Dolby offre le nécessaire sur toute la

chaîne de production cinématographique (du mix à la

diffusion, normé, avec des outils hardware et software), avec un large

panel de films produits dans ce format. Le choix d'équiper une salle en

Atmos semble alors être préférable, et à moindre

risque du point de vue technique pour les exploitants de salles.

Mots clés: WFS, adaptabilité, Dolby, DTS:X,

MDA

Sources:

Dolby.com;

Sonicemotion.com

«Utilisation de la technologie WFS dans la

création sonore cinématographique: Possibilités et

limites»

mémoire de Rémi Carreau et Thibault Macquart,

école ENS Louis-Lumière, 2015.

10:

Associationdesmixers.fr

selon Gérard Loupias, directeur de développement DTS:X Europe

31

2.3 Le Broadcast et les Supports grand public 2.3.1

MPEG-H

Le MPEG-H est un format audio objet ouvert,

élaboré par Fraunhofer pouvant être lu sur n'importe quel

enceinte ou casque. Il a été testé et utilisé dans

le monde entier par TV Globo (télé Brésilienne), NHK

(télé Japonaise), CCTV (Télé Chinoise),

l'Eurovision (2018 et 2019), pour la coupe du monde de foot 2018 ou encore

France TV pour Roland Garros; et est d'ores et déjà actif pour la

télé 4K Sud Coréenne.

Le MPEG-H a été conçu pour pouvoir

être transmis par un simple câble SDI sans perte de qualité,

ce qui le limite pour l'instant à 16 canaux audio dont un canal

dédié aux metadata, ici appelé «Control Track»

(aussi en flux PCM), évitant la perte des métadonnées. Le

nombre d'objets est alors limité, donc la liberté d'adaptation et

de personnalisation est plus réduite.

Conformer le contenu pour les salles de cinéma

nécessite un grand nombre d'objets (donc de piste), cela semble alors

compliqué pour le MPEG-H. Mais ce format est très

intéressant pour la télé, la VR, la musique en streaming,

les podcasts, la diffusion live ou tout autre contenu à consommer

à la maison. Les promesses de la NGA offrant une meilleure

expérience avec un son immersif (adaptabilité selon le type

diffusion disponible) ainsi que l'interactivité sont maintenus, tout en

préservant un aspect essentiel pour l'utilisateur, la simplicité.

L'interface et les options sont épurés, puis des solutions

existent afin de proposer une expérience évolué avec une

installation réduite. Le son 3D interactif est alors plus que jamais

accessible.

Mots clés: Fraunhofer, AAC, Objets, 15 Pistes,

Simplicité, MHAPI, Sources:

Orpheus-audio.eu

aesfrance.info «Object Based audio comment et

pourquoi?» Webinar MPEG-H Fraunhofer du 23 Avril au 12 Mai

32

L' AAC, également l'une des innovations de Fraunhofer,

est réutilisée (entreprise que l'on connaît bien avec le

projet Orpheus). Le débit s'apparente à 128 kbps pour un mix 5.1

et 64 kbps pour du stéréo (données techniques à

différencier de la qualité subjective). Comme montré

ci-dessous, l'étape d'authoring vient s'ajouter à la chaîne

de production avec le format MPEG-H.

L' Authoring:

L'authoring est l'étape permettant de conformer le

contenu en objet, de définir l'interactivité, les presets,

mesurer le loudness, effectuer l'export,...

Le format repose sur la méthode «bed+object»

(comme le dolby atmos) qui sépare la scène sonore en deux types

de son. Les «bed» représentent la base du contenu audio, c'est

à dire les ambiances, les musiques, qui sont affiliées à

une position précise et fixe (multicanal, 5.1, 7.1, 22.2, quad,...).

Puis les objets représentent le reste de la scène sonore, donc

les effets spéciaux, les voix par exemple, dont la position est variable

(ou peut être changé par l'utilisateur).

Mots clés: Fraunhofer, AAC, Objets, 15 Pistes,

Simplicité, MHAPI,

Sources:

Webinar Fraunhofer «Hands on post-production for MPEG-H

audio» le 27 Avril 2020

33

Ensuite les «Switch Group» servent à proposer

un choix unique et non multiple à l'auditeur, en groupant un certain

nombre d'objets ou scènes. Par exemple, le switch group sera

nécessaire pour le choix des langues du contenu, pour ne pas choisir le

français en même temps que l'anglais (figure 2.11).

A partir de la différenciation des sons, il est

possible de définir des presets, que l'utilisateur pourra

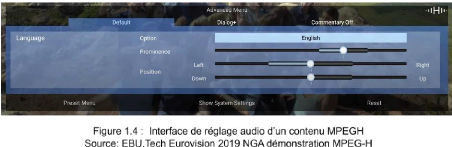

sélectionner rapidement et simplement, selon ses besoins (figure 1.4).

Trois presets sont recommandés (mais d'autres sont possibles avec des

paramètres aux choix de l'ingénieur son, du

réalisateur,...).

Le premier est nommé «Default», comme son nom

l'indique, ce sont les paramètres audio du contenu d'origine

proposés par le mixeur son.

Le second est nommé «Dialogue+». Si ce preset

est sélectionné, la voix, les dialogues, sont automatiquement

augmentés de 6 dB.

Le troisième se nomme «Commentary OFF», il

est donc dépourvu de voix, et seulement constitué des effets, de

la musique, de l'ambiance,... (figure 2.11)

Mots clés: Fraunhofer, AAC, Objets, 15 Pistes,

Simplicité, MHAPI,

Sources:

Webinar Fraunhofer «Hands on post-production for MPEG-H

audio» le 27 Avril 2020

34

Notons que sur chaque preset, l'utilisateur peut changer par

lui même le volume, l'azimut et l'élévation du son dans les

limites qui lui sont accordées. Ces nouvelles valeurs seront

sauvegardées pour une prochaine utilisation. Ainsi, les principales

fonctions du NGA importantes aux yeux des utilisateurs (la compréhension

des

10

dialogues, le choix du format et la localisation) sont

respectées, tout en restant simple et accessible pour tout

utilisateur.

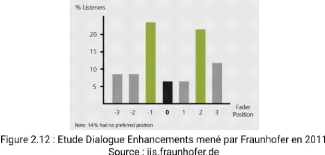

«Dialogue Enhancements», une ancienne étude

de 2011 menée par Fraunhofer sur les réglages audio choisis par

les utilisateurs est très intéressante. L'ancêtre du

MPEG-H, le MPEG4 AAC était utilisé lors d'un match de tennis de

Wimbledon. Un curseur de mixage allant de la valeur «3» à

«-3» est proposé aux auditeurs. La valeur

«zéro» correspond mixage par défaut de

l'ingénieur son, les valeurs positives privilégient les

commentaires, tandis que les valeurs négatives les atténuent et

donnent une priorité à l'ambiance du stade. Deux types de

réglages se distinguent dans les résultats, 25% ont

préféré le réglage «-1» (moins de

commentaires), et environ 22% le réglage «2». Le mixage par

défaut à été choisi à hauteur de 7%, et 14%

n'ont pas de préférence. Cette petite expérience montre

à quelle point le mixage est subjectif, différent pour chacun, et

est un vrai casse tête pour l'ingénieur du son. Le MPEG-H est

alors une belle proposition afin de résoudre ce problème.

Mots clés: Fraunhofer, AAC, Objets, 15 Pistes,

Simplicité, MHAPI,

10 Comme nous l'avons vu précédemment par

exemple avec le sondage d'ORPHEUS sur le concept du NGA

Sources:

Webinar Fraunhofer «Hands on post-production for MPEGH

audio» le 27 Avril 2020

https://tech.ebu.ch/docs/techreview/trev_2012-Q2_Dialogue-Enhancement_Fuchs.pdf

35

Post-Production

Si il s'agit de diffuser un contenu enregistré (film,

documentaire,...), un simple plugin de Fraunhofer nommé MHAPI est

nécessaire à la conversion en format objet. Nous l'analyserons en

partie 3 de ce mémoire.

Événements en Live:

Si il s'agit d'une diffusion Live (événement

sportif, concert,...), les contraintes sont différentes et cela

nécessite une configuration plus complexe afin d'obtenir les

11

mêmes résultats et fonctions, qu'avec un PAD

utilisant le MPEG-H (interactivité, preset,...).

L'ensemble des micros d'ambiance et de la matière

sonore (commentaire, musique,...) est reçu dans un car régie,

afin de mixer et faire l'authoring du contenu (même principe de ce que

nous venons de voir). Deux outils Hardware et Software sont majoritairement

utilisés pour l'authoring, chacun ayant une interface différente

mais effectuant la même tâche: le Jünger MMA (Multichannel

Monitoring and Authoring) et le Linear Acoustic AMS (Authoring and Monitoring

System). L'interface utilisateur, les presets ainsi que l'interactivité,

sont entièrement modifiables en temps réel. La synchronisation

entre le son (avec les métadonnées) et la vidéo se font

verticalement, par frame (50 fps), et peut être assurés

jusqu'à -30dB.

Lecteur MPEG-H:

A ce jour, Fraunhofer fait des recherches sur un lecteur, car

seul le hardware comme certaines télévisions ou barres de son

(comme la «AMBEO» de Sennheiser» est capable de décoder,

lire et profiter des avantages d'un contenu MPEG-H.

Mots clés: Fraunhofer, AAC, Objets, 15 Pistes,

Simplicité, MHAPI,

Sources:

Webinar Fraunhofer «Hands on post-production for MPEG-H

audio» le 27 Avril 2020 11 Contenu «Près à

diffuser».

36

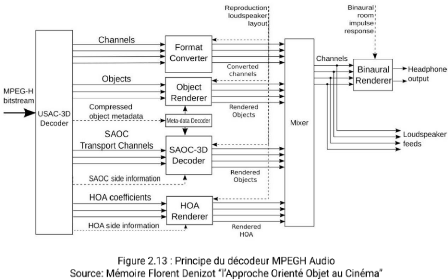

Le décodeur MPEG-H (USAC pour Unified Speech and Audio

Coding) prélève les éléments (figure 2.13), on

retrouve ainsi les objets, fichiers ambisonique et basés canal. Les

signaux «Channel Based» son transmis au mixer virtuel, convertit au

bon format si besoin est. Les objets sont traités en fonction des

metadatas et le système de spatialisation SAOC (Spatial Audio Object

Coding). Les fichiers Ambisonique sont eux aussi, traités par un moteur

de rendu. Ainsi, l'ensemble du contenu audio est adapté aux

configurations de l'auditeur, avec de l'interactivité et de la

personnalisation. Un moteur de rendu situé après le mixer permet

la binauralisation avec une réponse impulsionnelle pour ajouter ou non

de l'acoustique de pièce pour plus de réalisme. Pas d'information

sur l'insertion de fichier .sofa ou l'intégration de plusieurs HRTF,

donnant la possibilité la meilleure expérience 3D au casque selon

les personnes (un bon compromis si il n'y a pas de créateur d'HRTF comme

propose Sony en partie 2.5.1).

Mots clés: Décodeur, Mixer, Moteur de rendu,

Binaural, HRTF

aesfrance.info

«L'Approche Orienté Objet»

mémoire de Florent Denizot, école Louis Lumière,

2016

37

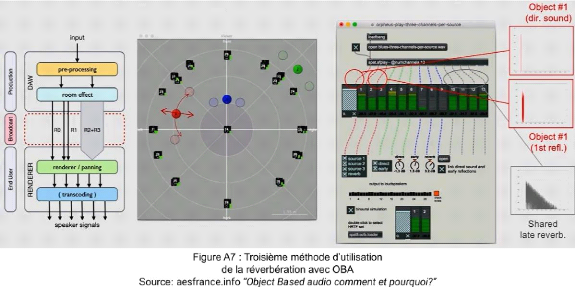

2.3.2 Dolby Atmos

On peut retrouver le procédé Dolby Atmos

également dans le salon. Côtés supports, plusieurs films

ont commencé à être distribués en Atmos sur Blu-Ray.

Les jeux vidéos sur consoles sont également compatibles (Forza,

Assassin's Creed, Battlefield, Final Fantasy,...) proposant ainsi un

réel potentiel sonore, en explorant les limites créatrices que

l'audio ne peut pas forcément se permettre avec les codes de la fiction.

Cela apporte un réel plus pour le joueur, pouvant se repérer et

anticiper son jeux. Le marché en hausse des plateformes VOD/SVOD propose

aussi l'Atmos (Netflix, Apple TV+, Amazon Prime, Vudu ou encore Youtube). Il

faudra encore attendre afin de pouvoir regarder un film ou une série

Atmos proposé par une chaîne de télévision, bien que

la firme soit prête à diffuser des évènements Live

avec le même codec AC-4 (annexe figure B1 pour en savoir plus sur la

configuration Live). Au-delà de ses capacités de diffusion, on

retrouve les possibilités de personnalisation que propose le MPEG-H tels

que les presets (ici intitulé «présentation») avec le

choix des langues, le volume des dialogues rehaussé ou modifiable, les

commentaires sportifs «muté», etc.

Restitution:

Plusieurs solutions s'offrent au spectateur pour pouvoir

profiter de ce format à la maison. Il est possible d'avoir une

télévision Atmos qui lui permettra de regarder du contenu

(Blu-Ray, SVOD,...) et de le restituer sur un home-cinéma Atmos par

exemple. Il est aussi possible de passer par son Home-Cinema compatible,

câblé à sa télévision (avec

possibilité d'Upmixer un contenu). Afin de restituer les sons

aériens, des systèmes jouent sur les réflexions du

plafond, évitant d'encastrer des enceintes, donc une installation

complexe chez le particulier, (bien que abordable et plus fidèle). Il

s'agit d'enceintes à poser, d'autres inclusent sur le côté

supérieur de la baffle servant aussi à restituer le canal

Gauche/droite.

Mots clés: Atmos, Jeux vidéo, Blu-Ray,

VOD/SVOD, Home cinéma, Barre de son, Interactivité Sources:

Dolby.com ; aesfrance.info

«Object Based Audio, Comment et Pourquoi?»

38

Puis des barres de son Atmos, plug&play, moins intrusives

mais plus coûteuses sont sur le marché. Des programmes sont

disponibles sur certains appareils afin de mesurer l'acoustique de la

pièce, et offrir la meilleure expérience possible.

Le binaural se révèle alors être

l'alternative aux prix élevés ou aux installations complexes,

seulement avec un casque. Néanmoins, la société permet

cette option d'écoute exclusivement avec les casques sans fil Dolby

Headphones. Ces casques

12

dotés d'un Head Tracking sont connectés avec

l'application Dolby Dimension, permettant d'écouter le contenu provenant

du smartphone, de la télé ou tout autre appareil. Contrairement

à Sony, Dolby ne croit pas pour l'instant à la personnalisation

auditive (Création et virtualisation des HRTF) et propose une seule HRTF

censée convenir pour tous. L'application permet avec le «Default

Lifemix» de modifier le niveau d'extériorisation et l'acoustique,

compensant le manque de personnalisation.

2.3.3: DTS:X

Étant plus présent que Dolby sur le

marché du Blu-Ray, DTS poursuit son gage qualité avec DTS:X pour

l'expérience à la maison.

Ce format rétro-compatible est disponible sur des

Blu-Ray («Spiderman», «Jumanji»,

«Terminator»,...), et les plateformes de streaming Américaine

Européenne et Asiatique (Rakuten TV, Fandango Now, Tsutaya TV,...).

Mots clés: Atmos, Jeux vidéo, Blu-Ray,

VOD/SVOD, Home cinéma, Barre de son, Interactivité Sources:

Dolby.com aesfrance.info «Object

Based Audio, Comment et Pourquoi?»

12: Capteur de mouvement de tête permettant influant sur le

contenu sonore un rendu plus réaliste (par exemple, un son provenant

d'une direction de changera pas de localisation même avec les mouvements

de tête) cf Annexe Figure B2

39

L'interactivité est aussi présente avec un

contrôle du niveau des dialogues ou autres composantes (Musique,

Foreground Effect, Background Effect) avec une interface simple et

épurée, schématisée avec un curseur. Le responsable

de l'authoring peut autoriser ou non certaines fonctions, mais la restriction

semble moins évoluée que le format MPEG-H. Cela mène soit

à une grande liberté de l'auditeur, au risque de

détériorer les intentions créatives, soit à

l'interdiction de la personnalisation du contenu.

Le format est aussi utilisé pour IMAX enhanced. L'IMAX

faisant partie du même groupe que DTS (XPERI), ils ont associé

leurs technologies au service du home-cinéma haute qualité, avec

une amélioration visuelle (couleurs, taille de l'image,...) et sonore

(adaptabilité, immersion).

Puis la firme est présente sur le marché du jeux

vidéo, notamment sur présente sur la XBOX One, et en partenariat

avec GDC (Game Developers Conference) l'un des événements

professionnels les plus important dans ce domaine.

Restitution:

Beaucoup de home-cinema et téléviseurs sont

équipés DTS:X (Sony, Trinnov, Pioneer, Denon, Yamaha,

Lexicon,...), pouvant prendre en charge jusqu'à 11.2 canaux et

trente-deux emplacements d'enceintes différentes. Un Upmix est possible

afin d'exploiter les enceintes supérieures sur du contenu n'utilisant

à l'origine que le plan horizontal. Le choix de la barre de son jouant

sur les réflexions acoustique du salon est également viable,

elles aussi nombreuses à être compatibles. Le binaural est

accessible par l'intermédiaire du DTS HeadphoneX intégré

sur les smartphones, tablettes et ordinateurs, pour une expérience

sonore 3D sur les Jeux Vidéo, Films ou encore Musiques.

Mots clés: DTS:X, Jeux vidéo, Blu-Ray,

streaming, Home cinéma, Interactivité Sources:

dts.com aesfrance.info «Object

Based Audio, Comment et Pourquoi?»

40

Le marché de l'automobile est en pleine extension, les

acteurs de l'audiovisuel prévoyant de nous distraire sur le temps du

trajet, temps qui finira par s'avérer libre avec les voitures autonomes.

DTS fait parti de ces acteurs qui prend ce marché à part

entière très au sérieux, avec l'utilisation du HeadphoneX

pour le visionnage de films, et du son «Neural».

2.3.4: WFS

On retrouve aussi le principe WFS dans la fabrication des

barres de son grand public, en associant plusieurs enceintes sur un espace

restreint. L'onde n'est plus plane mais cardioïde, afin d'assurer une

certaine homogénéité du son dans la pièce, la

perception spatiale est alors plus aboutie. Cette technique facilite

l'accès du multicanal au grand public car moins encombrante, bien que la

qualité du son dépend beaucoup de l'acoustique de la

pièce.

2.4 La Réalité Virtuelle (VR)

2.4.1 MPEG-H

Fraunhofer a pour avantage de créer non seulement les

solutions Software mais aussi des solutions Hardware intégrées

pour la VR, ce qui en fait un des acteurs principaux. Le partenariat avec B-COM

a permis de présenter en 2017 le premier court-métrage en VR. Le

MPEG-H est le codec privilégié pour les contenus à

Réalité Virtuelle pour son efficacité de codage, et son

flux binaire contenant l'ensemble des metadatas et diverses signaux audio

(object, ambisonics FOA/HOA, Beds,...). L'interface est simple, et pratique

pour l'utilisateur souhaitant une perception du contenu adapté à

ses besoins. Les possibilités interactives sont les mêmes que pour

le broadcast, cela dans un environnement 360. Des outils d'authoring, de

spatialisation et d'encodage sont proposés par la firme sous forme de

Plugin AAX / VST3 et un plugin Unity. Un rendu binaural y est

intégré avec plusieurs fonctionnalités de Head

Tracking.

Mots clés: Fraunhofer, AAC, Objets, 15 Pistes,

Simplicité, MHAPI, Sources: aesfrance.info «Object Based

audio comment et pourquoi?»

iis.fraunhofer.de;

b-com.com

41

2.4.2 Dolby Atmos

Dolby propose aussi des solutions pour la VR avec

intégration de vidéo MP4 (vue

360 ou 2D) sur Windows/Mac, et compatible avec Oculus Rift

pour le monitoring. Le Player VR Dolby peut être connecté en IP au

Dolby Atmos Renderer sur ProTools, en gardant la synchronisation entre le son

et la vidéo 360. L'export ambisonique semble être de l'ambiX

(format B) d'ordre 1. Dolby Atmos VR Player Home disponible sur android, permet

de lire le contenu avec le Samsung Gear VR ou Google Cardboard V2.

2.5 La Musique

2.5.1 MPEG-H avec Sony 360 Reality Audio

En fin d'année 2019, Sony a lancé son gros projet

musical, le «360 Reality Audio», en

partenariat avec Google, Amazon Music, Deezer, Tidal ou encore

Nugs.net, proposant du contenu audio 3D

personnalisable. Après plusieurs recherches et échecs des

entreprises ayant misées sur l'individualisation de l'écoute,

Sony permet maintenant à l'utilisateur une expérience binaural

optimisée. Avec l'application «Headphone Connect», l'auditeur

peut scanner ses oreilles afin de créer ses propres données HRTF

pour une expérience immersive maximisée, devançant

largement DTS Headphones X. Il s'agit donc bien de restitution en trois

dimensions (X, Y, Z), et non sur deux plans comme peut le supposer le nom

marketing «360».

Mots Clés: MPEG-H, 3D, Scan, Musique Binaural Sources:

Deezer.com; Sony.fr,

Developer.dolby.com

42

Sony collabore avec les grands labels de musique (Warner,

Universal, Sony Music), et met à disposition son propre outil de

production, traitant indépendamment chaque composante de la musique afin

de la spatialiser. De simples projets multipistes d'anciens ou nouveaux titres

sont éligibles au mastering 360 Reality audio. Pour cela, le codec

MPEG-H est utilisé et peut diffuser du Dolby Atmos.

Contrairement au Dolby Headphones, l'utilisateur n'est pas

obligé d'acquérir un casque compatible, (bien que Sony conseille

ses casques adaptés) tout est donc très simple et accessible. Un

catalogue de 1000 titres est d'ores et déjà disponible sur les

plateformes et applications Deezer ou Tidal avec l'abonnement HiFi (Flac

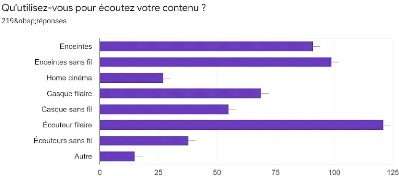

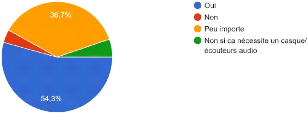

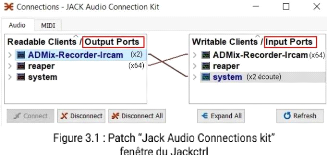

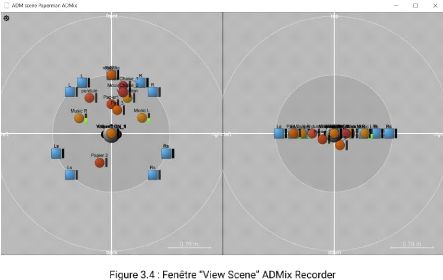

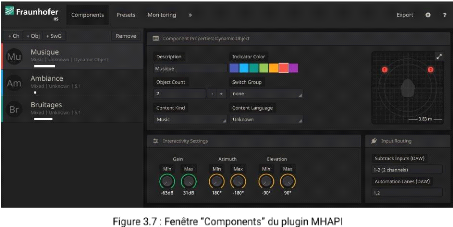

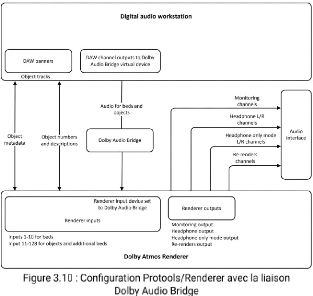

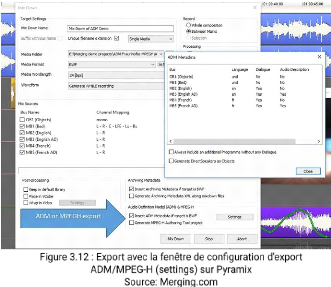

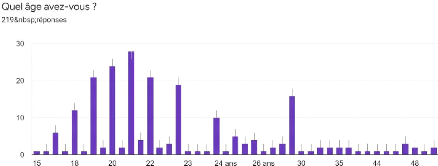

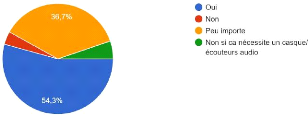

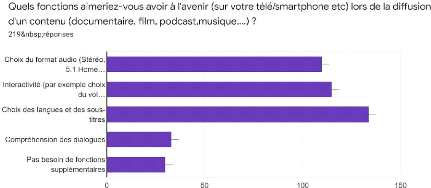

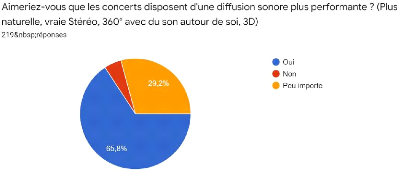

1411kbps). Nugs propose également la rediffusion de concerts, le