|

|

Mémoire de recherche de Master 2 Droit Des Affaires

2019-2020

Déposé le 2 juin 2020

|

|

Intelligence Artificielle

et mise en oeuvre des principes de

Privacy by design et Privacy by

default

Julie Richard Morin

Sous la direction de (PhD) Isabelle Bufflier

Remerciements

La réalisation de ce mémoire a été

possible grâce au concours de plusieurs personnes à qui je

voudrais témoigner ma gratitude.

Je souhaite d'abord remercier la directrice de ce

mémoire, Madame Isabelle Bufflier pour son accompagnement tout au long

de sa rédaction et pour m'avoir poussée à dépasser

mes limites.

Je tiens également à remercier Maître

Adrien Basdevant, qui m'a partagé la passion du métier lors de

mon stage effectué chez Basdevant Avocats.

Un grand merci aussi à Monsieur François Xavier

Cao pour m'avoir accompagnée dans ma démarche et pour m'avoir

confortée dans l'idée que le droit et la technologie sont

consubstantiels.

Je désire en outre saluer les professeurs de

l'Université du Littoral Côte d'Opale et de Skema Business School

ainsi que les intervenants qui ont su nourrir ma réflexion tout au long

de ce master, créant ainsi des ponts entre les connaissances et

participant à ma formation.

J'adresse enfin un remerciement tout particulier à ma

famille et mes amis, dont mes grands-parents héroïques, qui ont su

braver le confinement et le fossé technico-juridique et réussir

une relecture efficace de ce mémoire.

« La sécurité, c'est faire face aux

menaces de demain contre les plateformes d'aujourd'hui. C'est

déjàÌ assez difficile. Le respect de la vie

privée, c'est faire face aux menaces de demain contre les plateformes de

demain1 »

La Maison-Blanche

Bureau exécutif du Président B. Obama

Conseil d'experts en science et technologie du

Président

1 Texte original: « security deals with tomorrow's

threats against today's platforms. That is hard enough. But privacy deals with

tomorrow's threats against tomorrow's platforms, since those

«platforms» comprise not just hardware and software, but also new

kinds of data and new algorithms »

Executive office of the president, president's council of

advisors on science and technology «report to the president big data

and privacy: a technological perspective», mai 2014, p. 34

RGPD Règlement Général de

Protection des Données

Glossaire

CNIL Commission Nationale de l'Informatique et

des

Libertés. Autorité Administrative

Indépendante chargée de former, accompagner, contrôler et

sanctionner.

Donnée à caractère personnel

Toute information se rapportant à une personne

physique identifiée ou identifiable.

Personne concernée Personne pouvant

être identifiée directement ou

indirectement par une donnée à caractère

personnel.

Responsable du traitement Personne physique ou

morale, autorité publique,

service ou autre organisme qui, seul ou conjointement avec

d'autres, détermine les finalités et les moyens du traitement

Sigles

EDPB European Data Protection Board

Comité Européen de Protection des

Données

EDPS European Data Protection Supervisor

Contrôleur Européen de la Protection des

Données

G29 Groupe de travail de l'article 29

Le G29 devient l'EDPB le 25 mai 2018

IPEN Internet Privacy Engineering Network

Réseau d'ingénierie de la vie privée sur

Internet

IA Intelligence Artificielle

PET Privacy Enhancing Technologies

Technologies renforçant la protection de la vie

privée

Sommaire

IA et mise en oeuvre des principes de Privacy by design et

Privacy by default

INTRODUCTION 1

PREMIERE PARTIE : UNE NECESSAIRE ADAPTATION PRINCIPES DE

PROTECTION DES

DONNEES A CARACTERE PERSONNEL A L'INTELLIGENCE

ARTIFICIELLE 22

Titre 1 : L'application des principes de protection des

données à caractère personnel à l'intelligence

artificielle 23

Chapitre 1 : Les principes directeurs du RGPD, des

principes limités 23

Chapitre 2 : La nécessité de

créer des principes spécifiques à l'IA 29

Titre 2 : Les moyens d'autorégulation

adaptés à l'intelligence artificielle 34

Chapitre 1 : Vers une nouvelle notion du risque

34

Chapitre 2 : Des outils de conformités

adaptés au respect de la vie privée 41

SECONDE PARTIE : CONSTRUIRE UNE INTELLIGENCE

ARTIFICIELLE CONFORME AUX

PRINCIPES DE PRIVACY BY DESIGN ET DE

PRIVACY BY DEFAULT 47

Titre 1 : Le régime de lege lata

48

Chapitre 1 : Le régime de gouvernance

autorégulé de la donnée 48

Chapitre 2 : Les points d'attention selon le cycle

de vie de la donnée 57

Titre 2 : Le régime de lege

feranda 70

Chapitre 1 : De la gouvernance de la donnée

à la gouvernance de l'intelligence artificielle 70

Chapitre 2 : Replacer l'utilisateur au coeur de

l'intelligence artificielle 80

CONCLUSION 85

- 1 -

Introduction

Analyser la mise en oeuvre des principes de privacy by

design et du privacy by default dans le cadre d'un traitement d'un logiciel

d'intelligence artificielle requiert au préalable quelques propos

préliminaires. L'essor de l'IA est permis par l'augmentation massives

des données, dit big data (1). Par ailleurs, le terme d'intelligence

artificielle est galvaudé, si bien qu'il convient de s'accorder sur sa

définition (2) et sur le fonctionnement de cette technologie (3). Il

conviendra ensuite de mesurer les enjeux soulevés par son usage (4) afin

de comprendre les spécificités de la réglementation en

matière de données à caractère personnel et plus

particulièrement du privacy by design et du privacy by default (5) et

son application à l'intelligence artificielle (6).

1. L'avènement du big data

Les données font partie inhérente de la vie de

l'Homme. Utilisées avant même l'invention de l'écriture

pour compter, puis pendant l'antiquité pour effectuer des recensements,

l'usage des données évolua au fil des transformations de nos

sociétés. Elles devinrent ensuite un instrument de mesure de

risques par des indicateurs statistiques ; par une approche descriptive

d'abord, puis par une approche prescriptive ensuite, si bien que les

données prennent de plus en plus de place dans notre vie2. La

donnée est communément définie comme « une

description élémentaire d'une réalité. C'est par

exemple une observation ou une mesure. La donnée est dépourvue de

tout raisonnement, supposition, constatation, probabilité. État

indiscutable ou indiscutée, elle sert de base à une recherche,

à un examen quelconque3 ». Au fil des

siècles, la définition des données n'a pas changé,

mais son usage ainsi que son nombre modifient en profondeur notre mode de

vie.

Le volume de données augmente de 33,8 % par an, ce qui

représentera 163 Zigaoctets en 20254. Cette croissance

fulgurante de la quantité de données, appelée

également « données massives » ou «

big data » est définie comme « la conjonction

entre, d'une part, d'immenses volumes de données devenus difficilement

traitables à l'heure du numérique et, d'autre part,

2 A. Basdevant, JP Mignard, « l'empire des

données », Don Quichotte, 2018, p. 28 et s.

3 S. Abiteboul, « Sciences des données.

De la logique du premier ordre à la Toile », leçon

inaugurale à la chaire Informatique et sciences numériques du

Collège de France, 8 mars 2012

4 Cabinet IDC, « La gouvernance des

données, un enjeu majeur à l'ère de la transformation

numérique », novembre 2019

- 2 -

INTRODUCTION

les nouvelles techniques permettant de traiter ces

données, voire d'en tirer par le repérage de corrélations

des informations inattendues5. ». Le big data a

pu connaitre un essor fulgurant par la synergie de quatre facteurs

énumérés dans le rapport Villani6. Il s'agit de

la baisse colossale du coût de traitement de l'information, de

l'avènement du web 2.0 et des contenus générés par

les utilisateurs, de la croissance exponentielle des données

générées par les humains et les machines et des

progrès spectaculaires en algorithmie. Le big data fait par

ailleurs l'objet d'un investissement massif. Si le total estimé en

valeur des investissements mondiaux dans les domaines du big data et

de l'analytique s'élève à 189 milliards de dollars en

2019, le cabinet IDC estime que cet investissement total

s'élèvera à 274 milliards de dollars en 20227.

Ce phénomène participe à l'essor du marché

d'internet, basé sur la publicité en ligne. Désormais, les

« data brokers8 », courtiers en données

personnelles, revendent des données personnelles en temps réel

afin de proposer par exemple un contenu publicitaire

ciblé9.

Le big data permet ainsi la création de

nouveaux usages liés au développement de nouvelles technologies.

Le big data offre notamment la possibilité de traiter une plus

grande masse de données, souvent non structurées, afin de mener

une opération non plus déductive mais inductive10. Il

permet de faire émerger des modèles, appelés «

patterns ». L'intelligence artificielle ne peut fonctionner sans

ces données, qui permettent au logiciel de fonctionner et qu'elle permet

en retour de traiter. Cette technologie est ainsi intimement liée au

big data par un rapport d'interdépendance : «

L'algorithme sans données est aveugle. Les données sans

algorithme sont muettes11 ».

2. Un logiciel de traitement intelligent ?

L'idée d'un être artificiel est présente

dès l'antiquité à travers les mythes de Pygmalion et

d'Héphaïstos12. Néanmoins, la doctrine s'accorde

à dater l'apparition du terme d'intelligence artificielle en 1956 lors

de la conférence de Dartmouth. Les plus grands chercheurs du domaine

réunis sur le campus du Dartmouth College tels que K. McCarthy, M.

Minsky, C. Shannon, A. Newell, A. Samuel, H. Simon et N. Rochester s'accordent

à définir cette nouvelle technologie

5 CNIL, « Comment permettre à l'Homme

de garder la main ? Les enjeux éthiques des algorithmes et de

l'intelligence artificielle », 2017, p. 75

6 C. Villani, « Donner un sens à

l'intelligence artificielle », mars 2018, p.149

7 Propos rapportés dans le « Guide du

big data », 2019, p. 38

8 B. Poilvé, « Les enchères en

temps réel (RTB), un système complexe », LINC, CNIL, 14

janvier 2020

9 Rapport à l'Assemblée nationale

n°3119 « Numérique et libertés, un nouvel âge

démocratique », présenté par C. Paul et C.

Féral-Schuhl 2015, p. 108

10 A. Basdevant, J.P. Mignard, op. cit., p.

64

11 CNIL, sondage réalisé sur un

échantillon de 1001 personnes par l'IFOP, « Comment permettre

à l'homme de garder la main ? Les enjeux éthiques des algorithmes

et de l'intelligence artificielle », 2017 p.15

12 J. Diaz, «Petite histoire de l'intelligence

artificielle, Partie 1 », Actu IA, 12 avril 2017

- 3 -

INTRODUCTION

par le terme d'« intelligence artificielle

». Si cette date fait consensus, on notera néanmoins que

dès 1950, A. Turing s'intéresse13 à la

possibilité pour des machines de penser par elles-mêmes.

Plus récemment, des succès spectaculaires ont

mis en exergue les prouesses de l'intelligence artificielle. En 2016, Alpha Go,

intelligence artificielle créée par Google bat le champion du

monde du jeu de Go, Lee Sedol14. Cette victoire est notable car le

jeu de Go est basé davantage sur l'intuition des joueurs que sur un

raisonnement logique et ne repose donc pas sur une analyse statistique des

chances de succès.

Si l'intelligence artificielle fait l'objet de nombreuses

publications, sa définition peut rester vague pour les

non-initiés. Selon un sondage mené par l'IFOP pour la CNIL, 83%

des français ont déjà entendu parler des algorithmes mais

53% ne savent pas précisément de quoi il s'agit15.

L'intelligence artificielle est définie dans le Journal

Officiel de la République Française comme le « Champ

interdisciplinaire théorique et pratique qui a pour objet la

compréhension de mécanismes de la cognition et de la

réflexion, et leur imitation par un dispositif matériel et

logiciel, à des fins d'assistance ou de substitution à des

activités humaines » 16. La CNIL, dans son

rapport17 sur l'intelligence artificielle reprend la

définition de M. Minsky18, qui la définit comme des

théories et des techniques « consistant à faire faire

à des machines ce que l'homme ferait moyennant une certaine intelligence

». Ces deux définitions se fondent sur le

référentiel de l'intelligence humaine et ciblent une

catégorie spécifique d'algorithmes, capables d'effectuer des

instructions avec un certain degré d'autonomie par rapport à

l'homme.

On distingue traditionnellement deux types d'intelligence

artificielle. D'une part, l'IA qualifiée de « forte

», ou IA « généraliste », qui serait

capable de répondre globalement à n'importe quel problème,

et son fonctionnement serait donc comparable à celui de l'intelligence

humaine. D'autre part, l'IA « faible »,

spécialisée, qui pourrait imiter une tâche

déterminée19. Cette distinction provient de la

signification du terme « d'intelligence » qui selon C.

Castests-Renard20, renvoie à la capacité de la machine

à imiter les fonctions cognitives de l'esprit de l'humain ou de

l'animal. Dès lors, deux approches peuvent être

distinguées. D'une part, l'approche cognitive vise à imiter le

comportement humain dans la manière de penser ou dans

13 A. M. Turing, «Computing machinery and

intelligence», Mind, 59, 1950, p. 433-460

14 CNIL, les enjeux éthiques des

algorithmes et de l'intelligence artificielle, op. cit., p. 16

15 CNIL, sondage, op. cit., p.15

16 Vocabulaire de l'intelligence artificielle

(liste de termes, expressions et définitions adoptés), JORF

n°0285, 9 décembre 2018

17 CNIL, les enjeux éthiques des

algorithmes et de l'intelligence artificielle, op. cit., p. 16

18 1927-2016, père fondateur de l'intelligence

artificielle

19 Conseil de l'Europe, « Glossaire de

l'intelligence artificielle »

20 C. Castests-Renard, « Comment construire

une intelligence artificielle responsable et inclusive ? » Recueil

Dalloz 2020, p.225

- 4 -

INTRODUCTION

les actions. D'autre part, l'approche computationnelle, qui

consiste à imiter la logique rationnelle humaine.

Les enjeux juridiques de l'intelligence artificielle sont

directement liés à son état de développement. Un

important débat doctrinal oppose à ce sujet les partisans de

l'attribution d'une personnalité juridique aux robots. Maître F.

Chafiol considère que cette attribution est d'une part

non-pertinente21, car « si on commence à donner une

personnalité juridique à un robot, on l'associe à une

personne » ; et d'autre part non-nécessaire, car les

régimes existants de responsabilité civile, de protection des

données à caractère personnel et de

propriété intellectuelle permettent déjà d'encadrer

ces nouveaux usages issus de cette technologie. Ainsi, la conception d'une IA

forte est rejetée au profit de la conception d'une IA faible. Des

experts en informatique sont également opposés à cette

conception d'une IA forte, comme Y. Le Cun22 et J. G. Ganascia qui

dénoncent le fait que ce débat sur l'IA forte élude les

questions actuelles posées par l'IA faible23. Ce

mémoire sera donc axé sur les traitements effectués par

des intelligences artificielles faibles.

3. Comment fonctionne l'intelligence artificielle ?

Afin de saisir en quoi consiste le traitement des

données par l'intelligence artificielle, il convient de comprendre au

préalable les rouages de la programmation, qui nécessitent de

réunir des données, des algorithmes et une grande capacité

de calcul24. Pour développer un logiciel, le

développeur doit rédiger un code informatique sur son ordinateur.

L'ordinateur est composé de deux couches. La première est celle

de l'environnement matériel, constitué du clavier, de

l'écran, des câbles, et de l'ensemble des composants

électroniques, appelé communément « hardware

». La seconde comprend l'environnement numérique

immatériel, composé de logiciels appelés «

software ». L'ordinateur est ainsi la combinaison du support

matériel et du logiciel. Le développeur utilise donc son

ordinateur afin d'accéder à des logiciels permettant de

développer son code informatique dans le langage de programmation qu'il

souhaite, parmi les langages comme « Python », «

C++ » ou « SQL » en fonction de ses besoins

propres.

Le langage de programmation va interpréter l'algorithme

en langage informatique, afin qu'il soit compréhensible par le

système binaire de l'ordinateur. L'algorithme est communément

défini comme « une suite finie et non ambiguë

d'étapes (ou

21 F. Chafiol, « Débat Club des

juristes : Droit et IA : Quels impacts ? », octobre 2017

22 V. Béranger, « Le terme IA est

tellement sexy qu'il fait prendre des calculs pour de l'intelligence

», Le monde, 7 février 2020

23 CNIL, les enjeux éthiques des

algorithmes et de l'intelligence artificielle, op. cit., p. 19

24 Commission Européenne, « livre blanc

sur l'intelligence artificielle - une approche européenne de

l'excellence et de la confiance », 19 février 2020, p.2, 16

- 5 -

INTRODUCTION

d'instructions) permettant d'obtenir un résultat

à partir d'éléments fournis en

entrée25 ». Il s'agit donc de l'expression d'un

raisonnement mathématique d'algorithmie. Par ailleurs, le logiciel est

défini26 comme « l'ensemble des programmes,

procédés et règles, et éventuellement de la

documentation, relatifs au fonctionnement d'un ensemble de traitement de

données ».

Le logiciel permet donc d'exécuter les instructions

définies par l'algorithme et de traiter des données. Le logiciel

fonctionne en plusieurs étapes. Premièrement, l'initialisation

est composée de l'entrainement de l'algorithme et des retours

apportés afin de l'améliorer. Deuxièmement,

l'entrée constitue l'étape où l'algorithme intègre

les données externes dans son fonctionnement. Troisièmement,

l'étape de traitement cible l'exécution du logiciel. Enfin, la

sortie signifie le moment où le logiciel affiche le résultat

souhaité. Dès lors, pour fonctionner, n'importe quel logiciel

exécute les étapes suivantes :

Rédaction Initialisation Entrée Traitement

Sortie

Il a été expliqué

précédemment que la spécificité de l'intelligence

artificielle résulte du fait que le logiciel est doté d'un

certain niveau d'autonomie. Cela signifie donc que le développeur ne

rédige pas toutes les étapes de traitement dans son algorithme.

Néanmoins en pratique, les logiciels sont constitués par un

ensemble de briques algorithmiques dont seule une partie utilise la technologie

d'intelligence artificielle. C'est dans cette perspective que le groupe

d'experts indépendants de haut niveau sur l'intelligence artificielle

constitué par la Commission Européenne propose de définir

l'intelligence artificielle par l'approche des systèmes : «Les

systèmes d'intelligence artificielle (IA) sont des systèmes

logiciels (et éventuellement matériels) conçus par des

êtres humains et qui, ayant reçu un objectif complexe, agissent

dans le monde réel ou numérique en percevant leur environnement

par l'acquisition de données, en interprétant les données

structurées ou non structurées collectées, en appliquant

un raisonnement aux connaissances, ou en traitant les informations,

dérivées de ces données et en décidant de la/des

meilleure(s) action(s) à prendre pour atteindre l'objectif donné.

Les systèmes d'IA peuvent soit utiliser des règles symboliques,

soit apprendre un modèle numérique. Ils peuvent également

adapter leur comportement en analysant la manière dont l'environnement

est affecté par leurs actions antérieures. » 27

25 CNIL, les enjeux éthiques des

algorithmes et de l'intelligence artificielle, op. cit., p. 19

26 Journal Officiel, Vocabulaire de

l'informatique, 17 janvier 1982, p. 625

27 GEIDHNSIA, « Définition de l'IA :

principales capacités et disciplines », juin 2018

- 6 -

INTRODUCTION

Si l'on se base sur le critère de l'autonomie du

logiciel, il existe de nombreuses techniques d'intelligence artificielle,

réunies sous le terme d'intelligence artificielle. Il est donc

préférable de parler « d'intelligences artificielles

»28. Par ailleurs, L'Institut National de Recherche en

Informatique et en Automatique (INRIA), dans son livre blanc

sur l'intelligence artificielle29 considère qu'effectuer de

nombreuses typologies sur les technologies d'intelligence artificielle est

possible mais qu'aucune ne prévaut car « L'IA est un vaste

domaine; toute tentative de le structurer en sous-domaines peut donner lieu

à débat. ». Néanmoins, la technologie de

l'intelligence artificielle est dominée par les techniques

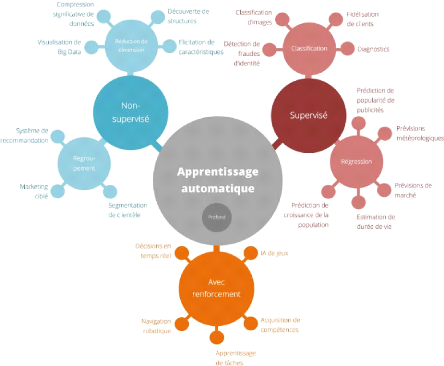

d'apprentissage automatique30. Seront ainsi

étudiées dans ce mémoire, les techniques d'apprentissage

automatique supervisé, non supervisé et par renforcement.

L'apprentissage automatique, ou « machine learning

», peut se définir comme une « branche de

l'intelligence artificielle, fondée sur des méthodes

d'apprentissage et d'acquisition automatique de nouvelles connaissances par les

ordinateurs, qui permet de les faire agir sans qu'ils aient à être

explicitement programmés.31 » Concrètement,

le développeur doit ici « alimenter la machine avec des

exemples de tâche que l'on se propose de lui faire accomplir. L'homme

entraine ainsi le système en lui fournissant des données à

partir desquelles celui-ci va apprendre et déterminer lui-même les

opérations à effectuer pour accomplir la tâche en question

»32. La CNIL caractérise ce type de

logiciel comme ayant la particularité d'être conçu de sorte

que son comportement évolue dans le temps, selon les données qui

lui sont fournies. En effet, ces types d'algorithmes ont la

particularité de ne pas être totalement programmés, ils se

différencient ainsi des algorithmes classiques de programmation par leur

logique d'apprentissage33.

L'algorithme de machine learning est une innovation

de rupture par rapport à l'algorithme classique. Selon J.P. Desbiolles,

on passe progressivement « d'un monde de programmation à un

monde d'apprentissage »34. On peut donc opposer les

algorithmes classiques, déterministes, qui fonctionnent selon des

instructions définies, aux algorithmes apprenants, probabilistes. La

machine découvre par elle-même les corrélations entre les

phénomènes traduits en données35. Si les types

de logiciels d'apprentissage automatique sont

28 T. Morisse, « intelligence artificielle,

un nouvel horizon : pourquoi la France a besoin d'une culture numérique

? », Les Cahier Lysias, 2017, p. 41

29 INRIA, « intelligence artificielle, livre

blanc n°1 », 2016, p. 20

30 Commission Européenne, « robustness

and Explainability of Artificial Intelligence », JRC technical report,

2020, p. 1

31 Vocabulaire de l'intelligence artificielle, JORF

n°0285, 9 décembre 2018

32 CNIL, les enjeux éthiques des

algorithmes et de l'intelligence artificielle, op. cit., p. 16

33 C. Villani, Rapport «Donner un sens à

l'intelligence artificielle», 2018, p. 26

34 CNIL, les enjeux éthiques des

algorithmes et de l'intelligence artificielle op. cit., p. 16

35 Y. Meneceur, « Pourquoi nous devrions (ne

pas) craindre l'IA », LinkedIn, 23 février 2020

- 7 -

INTRODUCTION

nombreux et complexes (cf. schéma - Typologie

des logiciels d'apprentissage automatique selon le Conseil de

l'Europe), l'étude ci-après vise à saisir les

étapes de traitement des données de manière

simplifiée36 et non technique37.

i. L'apprentissage automatique

supervisé

L'apprentissage automatique supervisé38

fonctionne en traitant des données d'entrée «

annotées », qualifiées par l'humain,

c'est-à-dire qu'à chaque donnée fournie, un label ou une

catégorie lui est attribué. Par exemple, à

côté de la photo de chien est associé le mot «

chien ». Le logiciel définit ensuite les règles

à partir d'exemples qui sont autant de cas validés39

lors de l'initialisation. Il sera donc capable de déterminer des

standards permettant de déterminer avec un niveau de probabilité

élevé un chien sur une photo. Il pourra ensuite traiter

l'information sur n'importe quelle photo entrée, et afficher en sortie

s'il s'agit bien d'un chien. On peut donc décrire les étapes du

fonctionnement d'un algorithme de machine learning de la

manière suivante :

Rédaction du logiciel

Initialisation

données

annotées

Traitement

Entrée probabilités

Sortie Résultat

Il s'agit par exemple du système de « Google

recaptcha », où les utilisateurs du moteur de recherche

définissent les zones d'une image où se situe un panneau de

signalisation. Ainsi, l'utilisateur annote la donnée et permet au

logiciel d'initialiser son fonctionnement à partir

d'elle40.

ii. L'apprentissage automatique non

supervisé

L'Apprentissage automatique non supervisé41,

est un type de machine learning. Dans ce système, «

l'algorithme apprend à partir de données brutes et

élabore sa propre classification qui est libre d'évoluer vers

n'importe quel état final lorsqu'un motif ou un élément

lui est présenté »42. Cette méthode

d'apprentissage ne permet pas de calculer le taux d'erreur en l'absence

d'informations en amont. Les données ne sont ici plus annotées

mais « brutes ». Par exemple, en initialisation, le logiciel

traitera un ensemble de photos sans savoir

36 M. Zimmer, «Apprentissage par

renforcement développemental », intelligence artificielle,

thèse, [cs.AI]. Université de Lorraine, NNT : 2018LORR0008, 2018,

p.10

37 O. Padilla, «Cheat sheets for AI»,

LinkedIn, février 2020, p.6

38 C. M. Bishop, «Pattern recognition and machine

learning», Springer, 2006

39 Vocabulaire de l'intelligence artificielle

(liste de termes, expressions et définitions adoptés), JORF

n°0285, 9 décembre 2018

40 CNIL, les enjeux éthiques des

algorithmes de l'intelligence artificielle, op. cit., p. 17

41 H. B. Barlow, «Unsupervised learning.

Neural computation», 1(3):295-311, 1989

42 Vocabulaire de l'intelligence artificielle, JORF

n°0285, op. cit.

- 8 -

INTRODUCTION

au préalable si ces photos sont des photos de chien. On

peut donc présenter les étapes du fonctionnement d'un algorithme

de deep learning de la manière suivante :

Rédaction du logiciel

Initialisation

données

brutes

Entrée Traitement

probabilités

Sortie Résultat

iii. L'apprentissage automatique par

renforcement

L'apprentissage automatique par renforcement43

fonctionne par un système de récompense. Le logiciel traite des

données brutes et détermine tout seul son raisonnement. Le

développeur effectue ensuite un retour sur le logiciel et l'informe du

succès ou de l'échec du résultat obtenu. Par

conséquent, plus le logiciel traite de données, plus son

système de traitement est fiable44.

Rédaction du logiciel

Initialisation

données

brutes

Traitement

Entrée probabilités

Sortie

récompense

Amélioration

4. Les questions soulevées par l'usage de

l'intelligence artificielle

L'usage des logiciels d'intelligence artificielle

combiné au big data bouleverse de nombreux systèmes

traditionnels. Sur le plan politique, B. Ancel45 considère

que nous sommes entrés dans l'ère de la « pax

Technica46 », période caractérisée

par le lien fort unissant États et nouvelles technologies, propice au

développement de la surveillance de citoyens tant dans les

régimes démocratiques que dans les régimes

autoritaires.

La justice se voit également transformée. Elle

utilise désormais cette technologie pour automatiser le traitement des

décisions de certains litiges47, et même prédire

les risques de récidive48. Par ailleurs, « La

gouvernance par les nombres49 » provoque un renversement

de paradigme. A. Supiot analyse que la normativité est désormais

pensée non plus par la législation

43 R.S. Sutton, A. G. Barto «Reinforcement

Learning: An Introduction (Adaptive Computation and Machine Learning», A

Bradford Book, ISBN 0262193981, 1998

44 J. Hurwitz, D Kirsh, «Machine Learning For

Dummies», IBM Limited Edition, 2018, p. 16

45 B. Ancel, « La vie privée dans un

monde digitalement connecté : la démocratie en danger ? »,

Revue Lamy Droit de l'Immatériel, N° 159, 2019

46 Notion attribuée à Phil Howard,

professeur à Yale dans la révue ci-après : C. Fried,

Privacy (1968) 77 3 Yale L. J. 475, 482

47 E. Niler, «Can AI Be a Fair Judge in Court?

Estonia Thinks So», Wired, 2019

48 Revue Lamy Droit de l'Immatériel, N° 159,

1er mai 2019

49 A. Supiot, « La gouvernance par les nombres

», cours au Collège de France, 2012-2014, Fayard, 2015

- 9 -

INTRODUCTION

mais par la programmation : « On n'attend plus des

hommes qu'ils agissent librement dans le cadre des bornes que la loi leur fixe,

mais qu'ils réagissent en temps réel aux multiples signaux qui

leur parviennent pour atteindre les objectifs qui leurs sont

assignés50 ».

Sur le plan économique, nous entrons dans une «

quatrième révolution industrielle ». K. Schwab,

fondateur du World Economic Forum de Davos, prévoit un

bouleversement de paradigme lié à cette nouvelle

révolution industrielle du fait de sa vitesse, de sa portée et de

son impact. Cette révolution marque un tournant du fait qu'elle est

davantage immatérielle qu'industrielle. Issue du bouleversement du

numérique engendré par la troisième révolution

industrielle - le développement des technologies de l'information et de

la communication - la quatrième révolution se caractérise

par « une fusion des technologies qui gomme les frontières

entre les sphères physique, numérique et

biologique51 ». Au coeur de cette révolution figure

la donnée. La première valeur lucrative dans le monde n'est plus

le pétrole, mais la donnée52 et les économies

évoluent en conséquence. Le marché est dominé

aujourd'hui par des acteurs non-européens et 80% des données sont

stockées sur des « clouds », c'est-à-dire des

serveurs situés sur un espace physique différent du lieu de

consultation de l'information53.

D'une manière plus globale, notre société

vit actuellement un « coup data », caractérisé

par le renversement du pouvoir des données choisissant en temps

réel la meilleure configuration pour déployer son programme :

« Les statistiques se sont progressivement substituées aux

expériences et aux vécus personnels pour percer les

mystères de la réalité54 ».

50 Ibid

51 K. Schwab, «La Quatrième

révolution industrielle : ce qu'elle implique et comment y faire

face» World Economic Forum, 2017

52 The Economist, «Regulating the internet

giants. The world's most valuable resource is no longer oil, but data»,

2017

53 Commission Européenne, livre blanc sur

l'intelligence artificielle, op. cit., p. 4

54 A. Basdevant, JP Mignard, op. cit., p.

59

- 10 -

INTRODUCTION

5. La régulation de l'utilisation des données

i. Les étapes de la régulation

« La maîtrise de nos

vies dépendra de l'usage et de la protection des données

personnelles » affirmait déjà en 2015

la Commission de réflexion et de propositions sur le droit et les

libertés à l'âge du numérique en introduction de son

rapport55.

La règlementation en matière de données

à caractère personnel n'est pas nouvelle. En France, la loi

n° 78-17 du 6 janvier 1978 relative à l'informatique, aux fichiers

et aux libertés (ci-après « LIL ») a

posé le socle de ce cadre légal. Elle a par la suite

été modifiée par la transposition de la directive 95/46/CE

du 24 octobre 1995, élargissant le périmètre de protection

à l'ensemble des États membres de l'Union Européenne. La

troisième étape de régulation en matière de

données à caractère personnel est marquée par le

Règlement Européen de Protection des Données n°

2016/679 du 27 avril 2016 entré en vigueur le 25 mai 2018

(ci-après « RGPD », ou le «

Règlement »). Or, si un règlement

européen est en principe d'application immédiate, la France a

choisi de transposer ce règlement en modifiant la LIL. Ainsi, la LIL a

été modifiée par la loi n°2018-493 du 20 juin 2018 et

l'ordonnance 2018-1125 du 12 décembre 2018. Enfin, le décret

n° 2019-536 du 29 mai 2019 est venu préciser cette loi. Cette

dernière version de la Loi informatique et libertés,

entièrement réécrite et complétée par

décret, constitue le cadre législatif sur lequel sera basé

ce mémoire.

Au niveau européen, le droit à la protection des

données à caractère personnel apparait dès les

prémices de la construction européenne, dans l'article 16 du

Traité sur le Fonctionnement de l'Union Européenne56.

Si le premier paragraphe consacre ce droit, le second dispose des

compétences législatives des États-membres et du parlement

afin de protéger « la libre circulation de ces données

». On remarquera par ailleurs que le RGPD poursuit cette même

idée de libre circulation et de protection, étant donné

que le titre complet du Règlement s'intitule « règlement

(...) relatif à la protection des personnes physiques à

l'égard du traitement des données à caractère

personnel et à la libre circulation de ces données

».

De plus, le Considérant (1) du RGPD dispose que «

La protection des personnes physiques à l'égard du traitement

des données à caractère personnel est un droit

fondamental. » En effet, la Charte des droits fondamentaux de l'Union

Européenne57 dédie l'intégralité de son

article 8 à un droit à la protection des données à

caractère personnel. A l'échelle du Conseil de l'Europe, la

Convention Européenne de Sauvegarde des Droits de l'Homme et des

libertés fondamentales

55 Ass. nat, Commission de réflexion et de

propositions sur le droit et les libertés à l'âge du

numérique, C. Paul, C. Feral-Schuhl (prés.), rapp. no

3119, Numérique et libertés : un nouvel age

démocratique, 9 oct. 2015, Introduction.

56 TFUE, signé le 25 mars 1957 et entré

en vigueur le 1er janvier 1958.

57 Charte des droits fondamentaux de l'union

européenne, 2000/c 364/01, 2000

- 11 -

INTRODUCTION

consacre ce droit de manière indirecte par le biais de

son article 8 relatif au droit au respect de la vie privée et

familiale.

Il faut néanmoins distinguer le droit à la

protection des données à caractère personnel et le droit

à la vie privée58. Le droit à la protection des

données à caractère personnel est un « outil de

transparence59 ». Il vise à protéger

l'individu d'une atteinte par des acteurs puissants en garantissant une

information propice à son autodétermination et donc sa

liberté de choix. A l'inverse, le droit à la vie privée

est un « outil d'opacité60 », qui permet

à l'individu d'interdire les formes invasives d'interférence dans

sa vie privée, et donc de ses données personnelles. Ces deux

droits sont complémentaires dans l'exercice d'un traitement de

données à caractère personnel. Les jurisprudences de la

Cour Européenne des Droits de l'Homme (CEDH) et de la

Cour de Justice de l'Union Européenne, (CJUE)

illustrent le lien de ces deux notions. Dans L'affaire Atakunnan

Markkinapörssi oy et Satamedia oy c./ Finlande61, la Cour

Européenne des Droits de l'Homme, rappelle que la CJUE a de nombreuses

fois rappelé que la protection des données à

caractère personnel doit être interprétée à

la lumière de la Convention et de la Charte comme la vigilance du risque

d'un traitement puisqu'un traitement risque de porter atteinte aux

libertés fondamentales et notamment à la protection de la vie

privée. La CEDH se base sur la réglementation européenne

en matière de protection des données personnelles dans l'affaire

Big Brother Watch62. Dans l'arrêt Tele2

Sverige63, la Cour de Justice de l'Union Européenne juge

que le droit à la protection des données personnelles est un

droit fondamental qui doit être pris en compte avec autant

d'intérêt que le droit au respect de la vie privée. La

jurisprudence européenne a ainsi fortement participé au

renforcement du droit à la vie privée en consolidant les

garanties procédurales existantes64 .

Cette protection s'exerce au niveau collectif, à

l'instar de l'arrêt Digital Rights Ireland65 qui a

invalidé la directive 2006/24, qui autorisait les gouvernements à

traiter des données à des fins de prévention du

terrorisme.

Ce droit offre également une protection des individus

à titre individuel, à l'image du célèbre

arrêt Google Spain66 de 2014 qui consacre un droit au

déréférencement. La CJUE juge à cet

58 S. Watcher, «The GDPR and the Internet of

Things: A Three-Step Transparency Model», 2018

59 P.D. Hert, S. Gutwirth « Privacy, Data

Protection and Law Enforcement. Opacity of the Individual and Transparency of

power», 2006, p. 76

60 Ibid., p 71

61 CEDH, Arrêt Satakunnan Markkinapörssi oy

et Satamedia oy c. Finlande, Requête no 931/13, 27 juin 2017 §70

62 CEDH, Arrêt case of big brother watch and

others V. The United Kingdom, no 58170/13, 62322/14 and 24960/15,13 septembre

2018

63 CJUE, Arrêt Tele2 Sverige, C-203/15,

EU:C:2016:970, 21 décembre 2016, § 93

64 B. Ancel, « La vie privée dans un monde

digitalement connecté : la démocratie en danger ? », op.

cit

65 CJUE, Digital Rights Ireland, nos C-293/12,

C-594/12, 8 avril 2014

66 CJUE, Affaire Google Spain, C-131/12, 13 mai

2014

- 12 -

INTRODUCTION

effet que ce droit prévaut « en principe, non

seulement sur l'intérêt économique de l'exploitant du

moteur de recherche, mais également sur l'intérêt de ce

public à accéder à ladite information lors d'une recherche

portant sur le nom de cette personne. »

Le droit à la protection des données

personnelles est également consacré au niveau international par

l'article 12 de la Déclaration Universelle des Droits de l'Homme relatif

à la vie privée. Le Pacte international relatif aux droits civils

et politiques y fait référence en son article 17. L'OCDE a

également créé un cadre dédié à la

protection des données à caractère personnel67.

Enfin, la norme ISO / IEC 29100 propose également depuis 2011 un cadre

de protection des données personnelles et la norme ISO IEC 27 0000

encadre les solutions informatiques en matière de sécurité

et techniques.

Ainsi, ces différentes sources et définitions

illustrent bien que le « droit à la vie privée se

révèle [être] un concept polymorphe qui varie selon le

temps, l'espace et le contexte.68 »

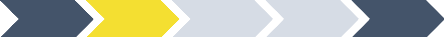

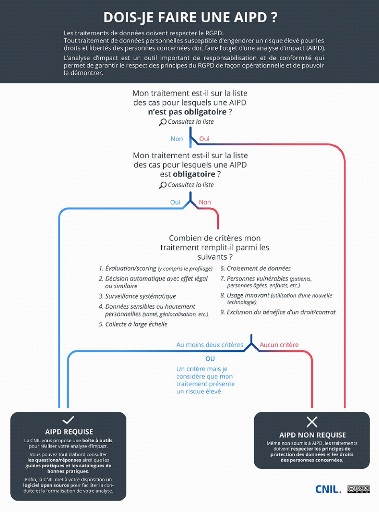

ii. Les obligations du RGPD

Le RGPD s'applique en cas de traitement de données

à caractère personnel, c'est-à-dire dès lors qu'une

donnée permet de ré-identifier directement ou indirectement une

personne physique69, appelée « personne

concernée ». Ainsi, l'organisme, personne physique ou

morale, qui traite ces données, le « responsable du

traitement »70, doit respecter la

réglementation, à savoir : chaque donnée doit être

traitée en vue d'une finalité déterminée. De plus,

chaque traitement doit respecter les principes de licéité,

minimisation, conservation limitée, sécurité et

transparence71. Le traitement inclut tout le cycle de vie de la

donnée, de sa collecte à sa destruction. L'exercice du droit des

personnes concernées doit également être

garanti72. Le responsable du traitement doit être en mesure de

démontrer cette conformité en cas de contrôle de la

CNIL73, et peut le faire par le biais d'outils tels que le registre

de traitement, l'analyse d'impact à la protection des données,

les notifications de violation, les codes de conduite et les certifications,

...

67 OCDE, « The OECD privacy framework

», 2013

68 B. Ancel, « La vie privée dans un monde

digitalement connecté : la démocratie en danger ? », op.

cit.

69 Art. 2 RGPD

70 Art. 4, 7) RGPD

71 Art. 5.1 RGPD

72 Art. 12 et s. RGPD

73 Art. 5.2 RGPD

- 13 -

INTRODUCTION

iii. L'apport du RGPD

Le réel apport du Règlement tient non pas par

son contenu, mais par le pouvoir normatif du texte74, imposant tant

aux acteurs publics que privés de respecter ce standard

élevé de protection des données, au risque de se voir

infliger des amendes importantes pouvant atteindre jusqu'à 4% du chiffre

d'affaires mondial75. En France, le non-respect de principes du RGPD

est sanctionné pénalement de cinq ans d'emprisonnement et de

300.000€ d'amende76. Si les sanctions ne sont pas

nouvelles77, elles font encore l'objet d'actualité. L'UFC Que

Choisir a interrogé la CNIL sur la conformité des pratiques de

Google et Facebook le 27 juin 2018. Cette saisine intervient à la suite

de la publication d'un rapport de l'autorité de contrôle

norvégienne qui interroge la licéité des astuces

graphiques et sémantiques de ces entreprises face aux principes de

privacy by design et de privacy by default. L. Costes analyse ces

comportements comme étant illicites et remettant en question la

validité du consentement des personnes

concernées78.

Le RGPD marque également un changement de

contrôle en matière de protection des données à

caractère personnel. Auparavant basé sur un régime de

déclaration préalable auprès de la CNIL et donc a

priori79, le contrôle s'effectue

désormais a posteriori, par un contrôle de

74 C. Villani, Rapport «Donner un sens à

l'intelligence artificielle», 2018, p. 28

75 Art. 83 RGPD

76 C. pèn. Art. 226-17

77 Conseil de l'Europe, « Protection des

données personnelles », février 2020

78 L. Costes, Introduction, Revue Lamy Droit de

l'Immatériel, N° 150, 1er juillet 2018

79 B. Ancel, « La vie privée dans un monde

digitalement connecté : la démocratie en danger ? », op.

cit.

- 14 -

INTRODUCTION

la CNIL. Cette nouvelle approche encourage ainsi

l'autorégulation, « accountability », soit la

responsabilisation des responsables du traitement, qui doivent eux-mêmes

créer des procédures de conformité pour garantir les

droits et libertés des personnes concernées. F. Mattatia

considère que ce glissement vers un système

d'autorégulation basé sur une approche par le risque juridique,

constitue une réponse pragmatique80. Toutefois, l'aspect

transdisciplinaire du risque et ses origines dérivées de la

gestion d'entreprise expliquent cette difficulté à définir

clairement la gestion du risque à adopter en matière de

protection des données personnelles. Dans son rapport annuel, la CNIL

interprète cette notion de responsabilisation des acteurs qui peuvent

être aussi bien des responsables du traitement ou des sous-traitants :

« Cette notion de responsabilisation (accountability) se traduit

notamment par la prise en compte de la protection des données dès

la conception du service ou du produit et par défaut (privacy by design

et by default). Le respect de la nouvelle législation européenne

implique, pour les administrations comme pour les entreprises, une adaptation

profonde de leurs outils, de leurs méthodes et, au-delà, de leur

culture en matière de protection des données » 81.

iv. Privacy by design et privacy by

default

Le terme de vie privée, traduction française de

« privacy » renvoie à la notion de

confidentialité, de contrôle et de pratique82. La

confidentialité est liée à la notion de confiance du fait

de ses origines latines, du terme « confidere », qui

signifie confier. En ce sens, la confidentialité des données est

une obligation incombant au responsable du traitement, qui se voit confier une

partie de la sphère privée de la personne

concernée83. Néanmoins, le terme de « respect

de la vie privée dès la conception » désigne de

manière large les mesures technologiques qui visent à garantir le

respect de la vie privée, tandis que les termes de «

confidentialité » ou de « protection »

des données dès la conception ou par défaut visent les

obligations légales de l'article 25 du RGPD84.

o Le privacy by design

Qu'est-ce que le privacy by design ? Le principe

du privacy by design peut se définir comme le fait de concevoir

le traitement, le produit, le service en prenant en compte la vie

privée85. P. Pucheral, A. Rallet, F. Rochelandet, et C.

Zolynski définissent le privacy by design

80 F. Mattatia, « La mise en oeuvre du RGPD au

prisme du risque juridique », Revue Lamy Droit de

l'Immatériel, N° 140, 1er août 2017

81 L. Costes, « CNIL. Rapport annuel 2017 de la

CNIL et principaux enjeux pour 2018 », 11 avril 2018

82 R. Sayaf, «Algebric Approach to Data

Protection by Design For Data Subjects», EDPS, p.6

83 G. Hass, A. Dubarry, « clause de

confidentialité, savoir-faire et secret des affaires », Dalloz

IP / IT, 2017, p. 322

84 EDPS, « Avis préliminaire sur le

respect de la vie privée dès la conception » avis 5/2018, 31

mai 2018, p. 1

85 M. Brogoli, N. Catelan, ..., Dalloz, Droit

européen des affaires, Protection des données personnelles, 2019,

§74

- 15 -

INTRODUCTION

par sa finalité, consistant en «

l'intégration de la protection de la vie privée dès la

conception du traitement des données à caractère personnel

à un nouvel outil, procédure ou service qui devra s'y conformer

tout au long de sa vie86 ». Ces auteurs reprennent la

définition de G. Loiseau87 qui considère qu'«

il s'agit de faire ab initio de la garantie de la vie privée une

cellule de veille placée au sein de la technologie en phase de

conception ». Concrètement, il peut s'agir notamment du

développement de nouveaux systèmes, services informatiques qui

impliquent le traitement de données à caractère personnel,

du développement de règles organisationnelles, du design

physique, de l'usage de données à caractère personnel pour

de nouvelles finalités88.

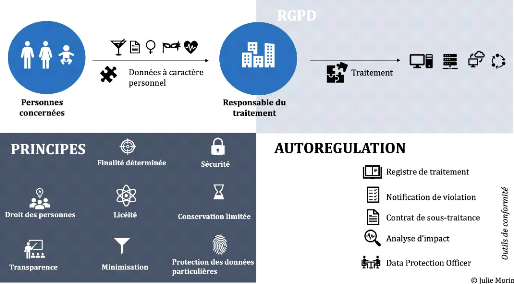

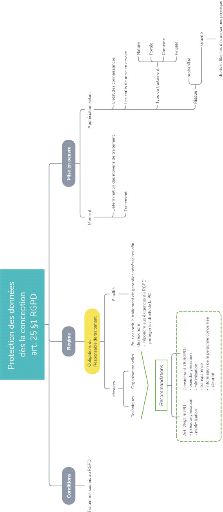

La protection des données dès la conception est

consacrée à l'article 25 du RGPD89 :

« Compte tenu de l'état des connaissances, des

coûts de mise en oeuvre et de la nature, de la portée, du contexte

et des finalités du traitement ainsi que des risques, dont le

degré de probabilité et de gravité varie, que

présente le traitement pour les droits et libertés des personnes

physiques, le responsable du traitement met en oeuvre, tant au moment de la

détermination des moyens du traitement qu'au moment du traitement

lui-même, des mesures techniques et organisationnelles

appropriées, telles que la pseudonymisation, qui sont destinées

à mettre en oeuvre les principes relatifs à la protection des

données, par exemple la minimisation des données, de façon

effective et à assortir le traitement des garanties nécessaires

afin de répondre aux exigences du présent règlement et de

protéger les droits de la personne concernée. »

La notion de privacy by design n'est ni

française, ni nouvelle. Ce concept est employé pour la

première fois en 1995, dans le rapport conjoint élaboré

par les autorités de protection de la vie privée canadienne et

hollandaise intitulé « Technologies renforçant la

protection de la vie privée : le chemin vers l'anonymat»

90. Les autorités, déjà conscientes de la

nécessité de protéger les données,

démontrée dans le volume 1, proposent des solutions techniques et

organisationnelles détaillées dans le volume 2 de ce rapport.

Le privacy by design a ainsi été développé

pour combler l'écart entre les tendances du marché et les

réglementations91. En effet, le privacy by design

est intimement lié aux technologies renforçant la protection

de la vie privée92, appelées Privacy Enhanced

Technologies (PETs). Développées

dès les années 1970

86 P. Pucheral, A. Rallet, F. Rochelandet,

Célia Zolynski, op. cit., p.89-99

87 G. Loiseau, « De la protection

intégrée de la vie privée (privacy by design) à

l'intégration d'une culture de la vie privée »,

Légipresse 2012/300, p. 712.

88 Information Commissioner's Office, «Data

protection by design and default», 2019

89 Règlement n? 2016/679

90 A. Cavoukian, J. Borking,

«Privacy-Enhancing Technologies: The Path to Anonymity», 1995

p.7

91 G. Rostana, A. Bekhardi, B. Yannou, «From

privacy by design to design for privacy», ICED, Canada, p. 2

92 R. Hes, J. J. Borking, Information and Privacy

Commissioner/Ontario of Canada , «Privacy-Enhancing Technologies: The

Path to Anonymity» 1995

- 16 -

INTRODUCTION

par D. Chaum, ces technologies visent à construire des

systèmes prenant en considération la vie privée tout au

long du cycle de vie du système93.

C'est une quinzaine d'années plus tard que la

Commissaire à l'information et à la vie privée de

l'Ontario, A. Cavoukian publie les sept principes fondateurs du privacy by

design94 qui sont les suivants :

· proactif et non réactif, préventif et non

curatif

· le respect de la vie privée comme paramètre

par défaut

· la vie privée intégrée à la

conception

· fonctionnalité complète - gagnant-gagnant

et non perdant-perdant

· protection intégrale tout au long du cycle

· visibilité et transparence - gardez l'esprit

ouvert

· respect de la vie privée de l'utilisateur -

recentrer autour de l'utilisateur

Ainsi, la conformité à ces principes suppose

d'adopter une politique tant technique qu'organisationnelle, de « data

responsable95 ». Cette vision vise un double objectif :

recentrer le traitement des données autour de l'utilisateur et imposer

une prise de conscience par des pratiques concrètes96. Il

faut toutefois interpréter ces principes davantage comme une

propriété plutôt que des instructions à respecter.

Dès 2014, l'ENISA recommandait97 de nuancer l'application de

ces principes : « l'approche holistique est prometteuse, mais elle

n'est pas assortie de mécanismes permettant d'intégrer la vie

privée dans le processus de développement d'un

système98 ».

Ce principe acquiert en 2010 une portée internationale

lors de la 32è conférence internationale des

Commissaires de la protection des données et de la vie

privée99. Les deux premiers points de la résolution

reconnaissent le privacy by design comme une composante essentielle de

la protection de la vie privée et encouragent l'adoption des 7 principes

du privacy by design. Le privacy by design a également

été consacré à l'échelle de l'Union

Européenne à l'article 25 du RGPD. En 2018, le Conseil de

l'Europe a modernisé la Convention n°108 de 1981 qui impose

désormais des obligations complémentaires aux responsables du

traitement et sous-traitants de prendre « des mesures techniques et

organisationnelles tenant compte des implications du droit

93 G. Danezis, J. Domingo-Ferrer, ENISA, «

Privacy and Data protection by design - form policy to engineering»,

décembre 2014, p. 5

94 A. Cavoukian, « Privacy by Design, the 7

foundational principles», 2009

95 P. Pucheral, A. Rallet, F. Rochelandet,

Célia Zolynski, « La Privacy by design : une fausse bonne solution

aux problèmes de protection des données personnelles

soulevés par l'open data et les objets connectés ? »,

Legicom, Victoires open data : une révolution en marche,

Editions, 2016, p.89-99

96 A. Cavoukian, «Operationalizing Privacy by

Design: A Guide to Implementing Strong Privacy Practices », 2012, p.15

97 G. Danezis, J. Domingo-Ferrer, ENISA, Privacy

and Data protection by design, op. cit., p. 2

98 Ibid., p. 6

99 Data Protection and Privacy Commissioners,

«Resolution on Privacy by Design», 2010

- 17 -

INTRODUCTION

à la protection des données à

caractère personnel à tous les stades du traitement des

données1°° ».

La protection des données dès la conception

consacrée à l'article 25 du RGPD se conçoit donc de pair

avec le nouveau principe de responsabilisation du responsable du traitement

introduit dans le RGPD, également appelé «

accountability ». Ce principe impose une proportionnalité

entre l'intérêt du traitement et la protection des données

personnelles. Il requiert aussi la mise en oeuvre d'une analyse de risque, qui

privilégie une approche pragmatique et rejette une approche englobante.

Le risque généré par le traitement des données

à caractère personnel sera donc vecteur du niveau de

conformité du responsable du traitement101. Ce principe

permet enfin d'intégrer tous les stades du traitement des données

à caractère personnel, de la création des outils de

collecte, au traitement ainsi qu'aux méthodes d'exploitations des

données. C'est notamment pour cette raison que les autorités de

régulation encouragent ce principe lors du développement de

nouveaux usages102. Néanmoins, les obligations du RGPD

restent imprécises quant aux obligations à

respecter103.

Ainsi, le privacy by design est un concept

polymorphe. Néanmoins il ne doit ni être interprété

comme un principe général, ni limité à l'usage des

technologies améliorant la protection de la vie privée, mais

comme un processus impliquant des composants techniques et

organisationnels variés, qui implémentent les principes de vie

privée et de protection des données104. Ce

concept impose notamment de prendre en compte la protection des données

personnelles tout au long du cycle de vie du projet, apprécier le

degré de rigueur d'application du principe selon les risques

générés par le traitement, mettre en oeuvre des mesures

appropriées et effectives, et intégrer les garanties

définies au traitement105.

o Le privacy by default

L'article 25 du RGPD dispose dans son deuxième

paragraphe de l'obligation du responsable du traitement de mettre en place une

protection des données par défaut :

« Le responsable du traitement met en oeuvre les

mesures techniques et organisationnelles appropriées pour garantir que,

par défaut, seules les données à caractère

personnel qui sont nécessaires au regard de chaque finalité

spécifique du traitement sont traitées. Cela s'applique à

la quantité de données à caractère

personnel

100 Conseil de l'Europe, Convention 108 +, «

Convention pour la protection des personnes à l'égard du

traitement des données à caractère personnel »,

mai 2018

101 Ibid

102 P. Pucheral, A. Rallet, F. Rochelandet, Célia

Zolynski, op. cit. p. 89-99

103 G. Rostana, A. Bekhardi, B. Yannou, op. cit., p.

2

104 G. D'acquisto, J. Domingo-ferrer, ENISA, « Privacy by

design in big data», décembre 2015, p.21

105 EDPS, «Avis préliminaire sur le respect de la

vie privée dès la conception», avis 5/2018, 31 mai 2018, p.

7

- 18 -

INTRODUCTION

collectées, à l'étendue de leur

traitement, à leur durée de conservation et à leur

accessibilité. En particulier, ces mesures garantissent que, par

défaut, les données à caractère personnel ne sont

pas rendues accessibles à un nombre indéterminé de

personnes physiques sans l'intervention de la personne physique

concernée. »

L'autorité de contrôle anglaise analyse la

protection des données par défaut comme un mécanisme qui

requiert seulement de traiter la donnée nécessaire et pour une

finalité déterminée. Il s'agit donc d'un concept

profondément lié aux principes de minimisation des données

et de limitation des finalités. Autrement dit106 : «

La protection des données par défaut signifie qu'il faut

spécifier la donnée avant de débuter le traitement,

informer de manière appropriée les personnes et ne traiter que

les données dont vous avez besoin pour atteindre votre objectif. Il

n'est pas nécessaire d'adopter une solution de type « par

défaut sans données à caractère personnel ».

Ce que vous devez faire dépend des circonstances de votre traitement et

des risques encourus par les personnes. » Le privacy by

default s'incarne par exemple par le recours à une case

pré-cochée en cas de collecte du consentement.

Conformément au considérant 32 du RGPD, une case

pré-cochée, et encore moins un silence, ne constituent un

consentement licite de la personne concernée pour accepter la politique

de confidentialité et accéder au site internet. Par

conséquent, le fait de prévoir systématiquement des cases

devant être cochées par l'utilisateur lui-même constitue une

mesure de protection des données par défaut. L'Agence

Européenne chargée de la Sécurité des

Réseaux et de l'Information (ENISA) recommande aux

autorités de clarifier leurs attentes sur l'application concrète

du principe de privacy by default107.

Dans le cas des systèmes d'information, l'application

de la protection des données par défaut vise le

paramétrage par défaut, soit le système

préconfiguré. Ce paramétrage est nécessaire afin de

permettre une navigation fluide sans imposer une multitude de choix à

l'utilisateur. Il s'agit donc d'un paramètre en «

opt-in108 », qui s'applique sans le consentement de

l'utilisateur. Néanmoins, le consommateur doit conserver la

possibilité de choisir un autre paramétrage, en «

opt-out109 »110. Le degré de

configuration s'apprécie au cas par cas111. L'ENISA

recommande112 pour garantir ce principe de minimiser la

quantité, l'étendue, la

106 Information Comissioner's Office, «Data protection

by design and default», 2019

107 M. Hansen, K. Limniotis, ENISA, « recommendations on

shaping technology according to GDPR provisions», décembre 2018,

p.6

108 L'avis de l'utilisateur est requis

109 L'avis de l'utilisateur n'est pas requis

110 M. Hansen, K. Limniotis, ENISA, recommendations on GDPR

provisions, op cit., p.11

111 Ibid., p.16

112 Ibid., p.17

- 19 -

INTRODUCTION

période et l'accessibilité de la donnée

personnelle. Le concept de « privacy by default » inclut le

principe de « Security by default113 ».

Le privacy by default cible donc

l'application des principes du RGPD en intégrant les choix et les

besoins des individus dès la conception des

données114.

Dès lors, le privacy by default et le

privacy by design sont profondément liés dans la mesure

où la nécessité d'un paramétrage par défaut

favorable au respect de la vie privée est aussi importante que la

capacité pour l'utilisateur à faire évoluer son

choix115. Un équilibre est d'autant plus nécessaire

à trouver que des études démontrent les effets sur les

personnes concernées. En effet, rendre le choix actif par défaut

impacte davantage le comportement de l'utilisateur qu'un choix

prédéterminé par les développeurs.116

6. Mise en oeuvre du privacy by design et by default dans

un traitement d'intelligence artificielle

Les principes de protection des données dès la

conception et par défaut disposent d'une obligation incombant au

responsable du traitement de veiller à respecter l'ensemble des

principes du RGPD tout au long du cycle de vie de la donnée, en mettant

en place des mesures techniques et organisationnelles. Or, le traitement

spécifique par un processus automatisé, ce qui est le cas de

l'intelligence artificielle, fait l'objet de dispositions

supplémentaires117, notamment en matière d'explication

du raisonnement algorithmique118 et de décisions

intégralement automatisées119. Il convient donc

d'analyser les spécificités de ce régime, même si

elles ne ciblent qu'une partie restrictive des traitements par un logiciel

d'intelligence artificielle120.

Par conséquent, la problématique de ce

mémoire sera :

Comment être conforme à ces principes

dans le cadre d'un traitement par un logiciel

d'intelligence artificielle ?

113 Ibid., p.20

114 Ibid., p.12

115 Ibid., p.13

116 P. A. Keller, ... «Enhanced active choice: A new

method to motivate behavior change», Journal of Consumer Psychology

21, p.376-383, 2011

117 C. Villani, Rapport «Donner un sens à

l'intelligence artificielle», 2018, p. 28

118 Art. 15.1 RGPD

119 Art. 22 RGPD

120 G. Malgieri, « Accountable AI: myth andrealities

», Legal Edhec,Webinar, 13 mai 2020

- 20 -

INTRODUCTION

Dans le rapport sur l'intelligence artificielle dirigé

par C. Villani,121 la difficulté d'encadrer le traitement des

logiciels d'intelligence artificielle est soulignée. Il s'agit d'un

« angle mort » de la législation actuelle, du fait

que l'IA ne traite pas que des données à caractère

personnel, et n'est donc pas intégralement soumise aux dispositions du

RGPD. L'intelligence artificielle ne fait pas non plus l'objet d'une

régulation à l'échelle européenne122, ni

d'exigences ou de lignes directrices spécifiques123.

L'efficacité de la mise en oeuvre des principes du RGPD est en

parallèle discutée, à l'heure où les conditions de

confidentialité de Facebook sont plus longues que la Constitution

américaine124.

Ce mémoire vise à dépasser

l'oxymore traditionnel big data / vie privée125,

afin d'aspirer à un objectif de « big data et vie

privée126 ». Cette réflexion s'aligne avec

les recommandations de la Commission Européenne qui

affirme127 et réaffirme128 de «

faire le lien entre les attentes légitimes (...) et le paysage actuel de

l'intelligence artificielle ».

Le big data bouleverse la vie privée dans la

mesure où il réduit le contrôle et la transparence,

augmente la réutilisation des données, et permet la

ré-identification des individus129. De nouvelles technologies

doivent être anticipées telle que la technologie quantique qui

pourrait augmenter la capacité de traitement de manière

exponentielle130. De nouvelles pratiques qui participent à

l'essor du big data131 tels que l'open

data132 et l'internet des objets133 posent

également de nouvelles questions.

Si le choix du paramètre par défaut n'est pas

nouveau dans la conception d'un logiciel, il n'en est pas de même du

principe de «priorité à la protection des

données» imposé par le RGPD134 qui constitue

une approche nouvelle pour les développeurs. Pourtant, la

conformité de ces principes impose une Protection Intégrée

de la Vie Privée. Il s'agit d'« intégrer des mesures

protectrices directement dans les systèmes informatiques, les pratiques

d'affaires et

121 C. Villani, Rapport «Donner un sens à

l'intelligence artificielle», 2018, p. 148

122 Commission Européenne, livre blanc sur

l'intelligence artificielle, op. cit

123 EDPB, «Response to the MEP Sophie in't Veld's letter

on unfair algorithms», 29 janvier 2020, p. 5

124 N. Bilton «Price of Facebook Privacy? Start

Clicking», The New York Times, 12 mai 2010

125 G. D'acquisto, J. Domingo-ferrer, ENISA, « Privacy by

design in big data», décembre 2015, p.18

126 Ibid., p.49

127 Commission Européenne, robustness and

Explainability of Artificial Intelligence, op. cit., p. 5

128 Ibid., p. 5

129 G. D'acquisto, J. Domingo-ferrer, ENISA, « Privacy by

design in big data», décembre 2015, p.13

130 Commission Européenne, livre blanc sur

l'intelligence artificielle, op. cit., p.4

131 36th Conference of Data protection and Privacy

commissioners, «resolution big data», 2014

132 C. Villani, « Donner un sens à l'intelligence

artificielle », mars 2018, p.29 et s.

133 36th Conference of Data protection and Privacy

commissioners, «Mauritius Declaration on the Internet of

Things», 14 octobre 2014

134 M. Hansen, K. Limniotis, ENISA, recommendations on GDPR

provisions, op cit., p.5

- 21 -

INTRODUCTION

l'infrastructure en réseau135

». Les PETs permettent une garantie technique de ces principes. Des

initiatives existent et portent leurs fruits136. La Commission

européenne rappelle qu'il est essentiel de trouver un équilibre

entre les attentes légitimes de protection de la vie privée et le

paysage scientifique de l'intelligence artificielle, d'autant plus que le RGPD

ne prévoit pas d'outils et de normes techniques137.

Par ailleurs, ces techniques ne portent pas atteinte à

l'innovation138. Pour le Contrôleur Européen de

Protection des Données139, ce cadre réglementaire de

protection des données n'est pas un frein à l'innovation, mais un

vecteur essentiel du développement d'une technologie d'intelligence

artificielle durable. Face à cette innovation perpétuelle de la

technologie, la réflexion éthique est nécessaire pour

trouver un équilibre entre la « liberté de droit

» et la « liberté de fait », avant

même d'élaborer une régulation140. Dès

lors, malgré l'effet de mode de ces concepts141 et pour

paraphraser le Contrôleur Européen de Protection des

Données, all we need is privacy by design and privacy by

default142.

Il convient donc, dans un premier temps d'analyser

l'application théorique du privacy by design et du privacy

by default dans le cadre d'un traitement effectué par un logiciel

d'intelligence artificielle et des questions sous-jacentes

(Première partie), pour dans un second temps, proposer

un cadre d'application pratique, respectueux des données à

caractère personnel (Seconde partie).

135A. Cavoukian, D stewart, B. Dewitt, «

Gagner sur tous les tableaux Protéger la vie privée à

l'ère de l'analytique » Deloitte Canada, 2014, p.1

136 F. Baudot, « Un service de localisation

décentralisé et privacy by design entre appareils »,

LINC, 24 octobre 2019

137 Commission Européenne, « Une stratégie

européenne pour la donnée », 19 février 2020, p.

12

138 A. Cavoukian, D stewart, B. Dewitt, Gagner sur tous les

tableaux, op. cit.

139 EDPS, «Press Statement - Data Protection and

Competitiveness in the Digital Age», 10 juillet 2019

140 LINC, «Éric Fourneret : « Le

numérique appelle la pensée », 3 avril 2020

141 A. E. Waldman, «Privacy's Law of Design», UC Irvine

Law Review, 8 octobre 2018, p.63

142 EDPS, «Speech on «All we need is L....Privacy

by design and by default», 29 mars 2017

- 22 -

PREMIERE PARTIE

Une nécessaire adaptation des principes de

protection des données

à caractère personnel à

l'intelligence artificielle

|

|

La mise en oeuvre du privacy by design et du

privacy by default dans le cadre d'un traitement réalisé par

un logiciel d'intelligence artificielle se heurte aux principes

intrinsèques de la protection des données personnelles

consacrés par le RGPD. Le Règlement étant

technologiquement neutre, il n'a pas pu prévoir des solutions à

des questions techniques. Il convient donc de dépasser cette

contradiction en adaptant ces principes à des objectifs

réalisables par l'intelligence artificielle par le biais de la norme

éthique. En étant réellement effective, la norme

éthique pourra guider le responsable du traitement dans la conception

et/ ou l'utilisation de l'intelligence artificielle (Titre 1).

La réflexion en amont du traitement se voit

également bouleversée et amène à une adaptation

spécifique aux problématiques de l'intelligence artificielle.

Conformément au principe d'autorégulation, le responsable du

traitement est tenu d'un devoir de responsabilisation à l'égard

du traitement qu'il effectue. Le privacy by design et le privacy

by default imposent à cet effet de mettre en oeuvre des mesures

techniques et organisationnelles adaptées. Ce dernier devra alors

mesurer le risque adéquat du traitement et mettre en oeuvre des outils

adaptés pour y pallier. Il s'avère ainsi nécessaire de

faire évoluer la notion de risque en prenant en compte les

spécificités techniques de l'intelligence artificielle (Titre

2).

- 23 -

Titre 1 : L'application des principes de protection des

données à caractère personnel à l'intelligence

artificielle

Le RGPD s'applique à tout traitement de données

à caractère personnel, y compris les traitements

automatisés (art. 2. 1 RGPD). Par conséquent, dès lors

qu'un logiciel d'intelligence artificielle utilise comme entrée des

données à caractère personnel, les dispositions du

Règlement s'appliquent. Néanmoins, les spécificités

techniques de cette technologie défient les principes constituant

l'essence même du texte (Chapitre 1). Respecter l'objectif de protection

des données personnelles amène aussi à envisager des

principes spécifiques à ce régime (Chapitre 2).

Chapitre 1 : Les principes directeurs du RGPD, des

principes limités

L'usage de l'intelligence artificielle lors du traitement de

données à caractère personnel révèle les

zones d'ombres du RGPD tant dans ses définitions (Section 1) que ses

principes directeurs (Section 2). Les principes de privacy by design

et de privacy by default peuvent alors servir de balance pour une

réglementation efficace (Section 3).

Section 1 : La remise en question des

définitions par l'intelligence artificielle

L'intelligence artificielle questionne tant la

définition de donnée à caractère personnel

(§1) que la possibilité de ré-identifier des personnes

concernées (§2).

§1. La distinction entre données à

caractère personnel, données pseudonymes, données anonymes

Le RGPD s'applique dès lors qu'un traitement cible des

données à caractère personnel (art. 2.1 RGPD). Une

donnée à caractère personnel est une donnée qui

permet d'identifier directement ou indirectement une personne (art. 4.1 RGPD).

Par conséquent, les données anonymes ne sont pas des

données à caractère personnel. Elles sont définies

au considérant (26) du Règlement comme les «

informations ne concernant pas une personne physique identifiée ou

identifiable ». En revanche, les données pseudonymes sont des

données à caractère

- 24 -

L'application des principes de protection des données

à caractère personnel à l'intelligence

artificielle

personnel143. Elles ne permettent pas de

ré-identifier des personnes concernées directement, mais

indirectement via des mécanismes tels que des clés de

ré-identification par une technique de hachage144, ou de

stockage sur des espaces distincts.

Données anonymes

|

Données à caractère personnel

|

|

Autres données

|

Identification impossible

|

Personnes identifiables

indirectement

|

Personnes identifiables directement

|

Non soumises au RGPD

|

Soumises aux dispositions du RGPD

|

|

Une donnée anonyme peut l'être soit par nature,

soit en faisant l'objet d'un processus d'anonymisation. L'anonymisation

empêche la ré-identification de la personne concernée de

manière définitive145. Dans un avis146 de

2014, le Groupe de travail « article 29 » sur la protection des

données (G29) considère qu'une donnée est

anonymisée si et seulement si aucun des trois critères suivants

n'est rempli. Si un de ces critères est rempli, les données ne

sont pas anonymes.

· L'individualisation : Est-il toujours

possible d'isoler un individu ?

Il s'agit de la «

possibilitéì d'isoler une partie ou la

totalitéì des enregistrements identifiant un individu

dans l'ensemble de données »147.

· La corrélation : est-il

toujours possible de relier entre eux les enregistrements relatifs à un

individu ?

Cela consiste en « la

capacitéì de relier entre elles, au moins, deux

enregistrements se rapportant àÌ la même

personne concernée ou à un groupe de personnes concernées

(soit dans la même base de données, soit dans deux bases de

données différentes) ».

· L'inférence : peut-on

déduire des informations concernant un individu ?

Il s'agit de « la

possibilitéì de déduire, avec un degré

de probabilité élevé, la valeur d'un attribut à

partir des valeurs d'un ensemble d'autres attributs. »

Par ailleurs, le G29 insiste sur le fait que les techniques du

numérique évoluent et qu'il faut donc s'adapter à

l'état de l'art, c'est-à-dire à l'évolution

technique de chaque innovation148 : « Les

éléments contextuels ont leur importance : il faut prendre en

considération «l'ensemble»

143 Art. 4.5 RGPD

144 La fonction de hachage permet de transformer une

donnée en une suite définie de chiffres et de lettres.

145 Conseil d'État, décision n° 393174, RJDA

5/17 n° 386, 8 février 2017

146 G 29, Avis 05/2014 sur les Techniques d'anonymisation,

0829/14/FR WP216, 2014 p.3

147 Ibid., p.13

148 Ibid., p.7

- 25 -

L'application des principes de protection des données

à caractère personnel à l'intelligence

artificielle

des moyens «susceptibles» d'être

«raisonnablement» utilisés à des fins d'identification

par le responsable du traitement ou par des tiers, en prêtant une

attention particulière aux moyens que l'état actuel de la

technologie a rendu récemment «susceptibles» d'être

«raisonnablement» mis en oeuvre (compte tenu de l'évolution de

la puissance de calcul et des outils disponibles). »

Le Conseil d'État149, dans sa

décision JCDecaux du 8 février 2017 statuant en

appel150 sur la notion d'anonymisation, s'inspire des

critères du G29, même si cet avis est dépourvu d'une valeur

normative. Il considère les données comme anonymisées

lorsque « l'identification de la personne concernée,

directement ou indirectement, devient impossible que ce soit par le responsable

du traitement ou par un tiers. Tel n'est pas le cas lorsqu'il demeure possible

d'individualiser une personne ou de relier entre elles des données

résultant de deux enregistrements qui la concernent. » En

l'espèce, le Conseil d'État considère que les

données traitées sont des données pseudonymes et non

anonymes. Le procédé utilisé est un processus de hachage,