|

ECOLE SCIENCES-U - LYON

Master II - Expert en Ingénierie Informatique

|

|

Demain, tous développeurs?

|

|

Mémoire de fin d'études 2011-2012

|

|

GODARD Romain

ECOLE SCIENCES-U - LYON

Master II - Expert en Ingénierie Informatique

|

Demain, tous développeurs?

|

|

Mémoire de fin d'études 2011-2012

|

|

GODARD Romain

Remerciements

En préambule à ce mémoire, je souhaitais

adresser mes remerciements les plus sincères aux personnes qui m'ont

apporté leur aide et qui ont contribué à

l'élaboration de ce mémoire ainsi qu'à la réussite

de cette formidable année scolaire.

Je tiens à remercier sincèrement Monsieur

Gevrin, Madame Huin et Monsieur Bouiche (professeurs et directeur de ma

formation) qui m'ont permis de cadrer mon sujet, de m'apporter de l'aide sur

les axes de développement et qui m'ont orienté sur des pistes de

recherches.

Mes remerciements s'adressent également à

Monsieur Villard, mon tuteur en entreprise, qui m'a permis de m'épanouir

énormément dans mon milieu professionnel durant cette

année chargée au niveau scolaire.

Une reconnaissance spéciale à monsieur Bendraou,

mon professeur de génie logiciel lors de ma licence, qui a eu des

conseils avisés à mon égard.

Je n'oublie pas mes parents pour leur contribution, leur

soutien et leur patience malgré la distance.

J'adresse mes plus sincères remerciements à tous

mes proches et amis, qui m'ont toujours soutenu et encouragé au cours de

la réalisation de ce mémoire et qui m'ont toujours

supporté même dans les moments les plus difficiles.

Et un énorme merci à la classe de master EII

avec qui nous avons passé deux très bonnes années de joie,

de rires, de soutiens, de conseils et d'aides.

Merci à tous et à toutes.

Résumé

Actuellement plusieurs outils permettent la création de

logiciels, de sites web, de bases de données et d'interfaces graphiques

sans avoir aucune connaissance en programmation. Avec les logiciels il existe

des outils de modélisation de systèmes qui vont permettre de

générer le code de l'application. La création d'interfaces

graphiques peut se faire via le système WYSIWYG ("What You See Is What

You Get" "ce que tu vois c'est ce que tu obtiens") basé sur du

glisser-déposer : on choisit quel type d'élément on veut

mettre en place et il suffit de le sélectionner et de le positionner

dans la fenêtre de conception. Pour ce qui est de la conception de sites

Internet, il y a ce qu'on appelle des CMS (Content Management System ou

Système de Gestion de Contenu) et des éditeurs de sites qui vont

nous permettre de concevoir et mettre à jour des sites web ou des

applications multimédia en utilisant également le WYSIWYG. Les

bases de données peuvent, quant à elles, se gérer

facilement via des SGBD (Système de Gestion de Base de Données),

qui sont eux très explicites quand à la création,

modification et suppression d'éléments de la base : de simples

clics de souris et un clavier sont suffisants pour gérer une base de

données.

Cependant ces systèmes ne permettent pas encore de

développer quelque chose de robuste, entièrement fonctionnel et

sécurisé. Ils vont permettre de créer des applications

basiques avec quelques petites fonctionnalités dans le meilleur des cas,

mais dans le pire des cas ce ne sera qu'une simple interface inexploitable.

Néanmoins, l'évolution des technologies, les

manières de développement et la démocratisation des moyens

énumérés plus haut peuvent laisser imaginer de bons

présages pour l'avenir. Ces outils seraient accessibles par tous,

faciles d'usage et ils permettraient surtout d'avoir un résultat final

des plus aboutis. Avec les possibilités du web 2.0, il est possible

d'imaginer, non pas un développement individuel où chacun fait sa

propre application (un peu comme les macros Excel dans les entreprises), mais

plutôt un développement collaboratif et participatif où

chacun pourrait apporter sa pierre et son savoir à l'édifice.

L'apparition des SaaS (Software as a Service) et du Cloud Computing, vont

peut-être permettre le développement de logiciels à l'image

du développement des sites web, où l'on aurait un

développement participatif et collaboratif au travers du web.

Mots clefs : WYSIWYG, CMS,

modélisation, interfaces graphiques, glisser-déposer,

fenêtre de conception, éditeurs de sites, bases de données,

web 2.0, applicatif, logiciel, SGBD, participatif, collaboratif, SaaS, Cloud

computing, développement.

Abstract

Currently several tools allow the creation of softwares,

websites, databases and graphical interfaces without any programming knowledge.

Concerning softwares there are systems modeling tools that allow to generate

the application code. Creating graphical user interfaces can be done via a

WYSIWYG system ("What You See Is What You Get") based on the drag and drop : we

choose what type of elements we want to be set up, simply by selecting it and

positioning it in the design window. Regarding websites conceptions, there are

CMS (Content Management System) and websites editors that will allow us to

design and update websites or multimedia applications using the WYSIWYG too.

Databases can be managed easily via DBMS (DataBase Management System), which

are themselves very explicit about creation, modification and removal of

elements of the database, simple mouse clicks and keyboard are good enough to

manage a database.

However these systems don't allow to develop something robust,

fully functional and secure yet. They allow to create applications with few

basic features in the best case, in the worst case it will be a simple

interface unusable.

However, technological evolutions, ways of development and

democratization of means listed above can be good omens for the future, when

these tools will be accessible by all of us, easy to use and will allow to have

a final result the most accomplished as possible. Without going up to this

tools that everyone will not use, we can imagine, with what the Web 2.0 showed,

not a development where everyone make their own application each of its side

(like the Excel macros in companies) but rather a collaborative and

participatory development where everyone can bring its own contribution and

knowledge to the conception. The emergence of SaaS (Software as a Service) and

Cloud Computing, maybe will allow the development of software like the

development of websites, where we would have a collaborative and participatory

development through the web.

Key words : WYSIWYG, CMS, modeling,

graphical interfaces, drag and drop, design windows, websites editors,

databases, Web 2.0, application, software, DBMS, participatory, collaborative,

SaaS, Cloud Computing, development.

Table des matières

REMERCIEMENTS

IV

RÉSUMÉ

V

ABSTRACT

VI

TABLE DES MATIÈRES

VII

TABLE DES MATIÈRES DES

ILLUSTRATIONS

IX

I. INTRODUCTION

1

1. HISTOIRE DU GUI (GRAPHICAL USER

INTERFACE, INTERFACE UTILISATEUR GRAPHIQUE)

1

A. Les premiers pas

1

B. Les stations de travail

adoptent le GUI

2

C. La micro s'empare à

son tour des interfaces à fenêtres

2

2. LE LOGICIEL

2

A. Le déploiement

2

B. L'évolution des

langages de programmation

3

C. Les interfaces

utilisateurs

3

D. Les principales tendances

dans la fabrication du logiciel

4

E. Le Génie Logiciel

(GL)

5

3. PROBLÉMATIQUE

5

II. ETAT DE

L'ART

7

1. LE LOGICIEL

7

A. Ingénierie

Dirigée par les Modèles (IDM ou MDE) MDE : Model-Driven

Engineering

8

B. Les IHM (Interface

Homme-Machine)

25

2. WEB

26

3. LES SYSTÈMES DE GESTION DE BASES

DE DONNÉES (SGBD)

27

III. NOUS POUVONS

ÊTRE TOUS DÉVELOPPEURS

31

1. LE LOGICIEL

31

A. La génération

de code

31

B. La génération

d'interfaces graphiques

37

2. LES SITES WEB

39

A. Le CMS (Content Management

System, Système de Gestion de Contenu)

40

B. Les éditeurs de

sites

42

3. LA SIMPLICITÉ D'UTILISATION D'UNE

BASE DE DONNÉES

44

IV. NOUS NE POUVONS

PAS TOUS ÊTRE DÉVELOPPEURS

49

1. LE LOGICIEL

49

A. Le MDA présente ses

faiblesses

49

B. Le DSML et ses limites

50

C. L'UML

51

D. Les éditeurs

graphiques WYSIWYG et leurs limites

53

2. LES SITES WEB

54

A. Les limites des CMS

54

B. Les faiblesses des

éditeurs de site web

55

3. LA CONSTRUCTION D'UNE BASE DE

DONNÉES NÉCESSITE UN APPRENTISSAGE

55

A. Un processus de conception

à assimiler

55

B. La

sécurité

56

C. Un vocabulaire à

connaitre et un apprentissage à faire

58

V. ET DEMAIN?

59

1. DES DÉVELOPPEURS BASIQUES?

59

2. TOUS DÉVELOPPEURS WEB?

59

A. Des nouveaux

développeurs Web

59

B. Développer c'est

partager l'information

63

C. Du contenu et du flux

64

D. Le Web participatif

65

E. On parle déjà

de web 3.0

66

3. TOUS DÉVELOPPEURS DE

LOGICIELS?

67

4. L'HYPER CONNECTIVITÉ

68

5. L'HISTOIRE NOUS DIS QUE OUI?

68

6. EST-CE QUE ÇA APPORTERAIT QUELQUE

CHOSE?

69

7. ET LES BASES DE DONNÉES QU'EN

FAIT-ON?

69

8. LE DÉVELOPPEUR DE "BASE" SERA

TOUJOURS LÀ.

70

9. ET SI C'ÉTAIT TOUT AUTRE

CHOSE?

70

A. Programmation par langage

naturel écrit

70

B. Programmation par langage

naturel parlé

71

VI. CONCLUSION

73

VII. TRAVAUX

CITÉS

75

VIII.

BIBLIOGRAPHIE

76

IX. ANNEXES

78

1. ANNEXE 1 : DIAGRAMMES UML

78

2. ANNEXE 2 : LE CODE SOURCE

GÉNÉRÉ PAR VISUAL EDITOR

82

3. ANNEXE 3 : EXEMPLE D'UNE

GÉNÉRATION DE CODE

83

Table des matières

des illustrations

FIGURE

1 : LE MACINTOSH

1

FIGURE 2 : EVOLUTION DE LA PRODUCTIVITÉ

DEPUIS 50 ANS

4

FIGURE

3 : CONSTAT DES PROJETS EN GÉNIE LOGICIEL

7

FIGURE

4 : EVOLUTION DE CES CHIFFRES

7

FIGURE 5 : EVOLUTION DU NOMBRE DE LIGNES DE

CODE

8

FIGURE 6 : UN EXEMPLE DE MODÈLE, LA PIPE

SELON MAGRITTE

10

FIGURE 7 : UN EXEMPLE DE

MÉTA-MODÈLE

11

FIGURE 8 : UNE ARCHITECTURE À 4 NIVEAUX

12

FIGURE 9 : NIVEAUX DE MODÉLISATION, EXEMPLE

DU JEU D'ÉCHEC

13

FIGURE 10 : PLUSIEURS VUES SUR UN MÊME

MODÈLE

14

FIGURE

11 : ABSTRACTION ET SÉPARATION DES PRÉOCCUPATIONS, L'EXEMPLE DE

GOOGLE MAPS

15

FIGURE 12 : LES TROIS TYPES DE MODÈLES DE

MDA

17

FIGURE 13 : EXEMPLE D'UTILISATION DES

MODÈLES DU MDA POUR RÉALISER UNE APPLICATION

17

FIGURE 14 : DSML

19

FIGURE 15 : HISTORIQUE DE L'UML

20

FIGURE 16 : L'ENSEMBLE DES DIAGRAMMES UML

22

FIGURE 17 : QUELQUES MODÈLES

D'ÉLÉMENT UML

23

FIGURE

18 : MÉTHODE DE DÉVELOPPEMENT UML

24

FIGURE 19 : APERÇU DE LA PARTIE GRAPHIQUE DE

VISUAL EDITOR SOUS JAVA

26

FIGURE 20 : APERÇU DE LA PARTIE SOURCE DE

VISUAL EDITOR SOUS JAVA

26

FIGURE 21 : L'APPROCHE BASE DE DONNÉES

28

FIGURE 22 : ARCHITECTURE D'UN SGBD

28

FIGURE 23 : ETAPE 1, LE POINT DE VUE FONCTIONNEL

(USE CASE)

32

FIGURE 24 : ETAPE 2, DIAGRAMME DE CLASSE

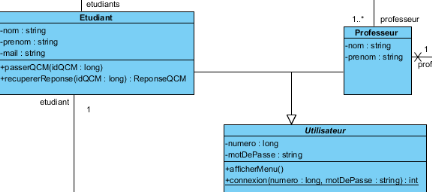

33

FIGURE 25 : ETAPE 3, DIAGRAMME DE

SÉQUENCE

33

FIGURE 26 : ETAPE 4, GÉNÉRER DU CODE

VIA LA MODÉLISATION

34

FIGURE 27 : UN EXEMPLE DE NOTES.

35

FIGURE 28 : EXEMPLE D'UN PROJET AVEC UN DSML

36

FIGURE 29 : RETOMBÉES ÉCONOMIQUE,

SOURCE METACASE 2009

37

FIGURE 30 : LA PALETTE

38

FIGURE 31 : UN EXEMPLE DE CONCEPTION EN DRAG AND

DROP

39

FIGURE 32 : RÉSULTAT LORSQUE L'ON

EXÉCUTE LE PROGRAMME

39

FIGURE 33 : UN EXEMPLE D'UTILISATION DU CMS

40

FIGURE 34 : LA PARTIE ADMINISTRATION DU CMS

41

FIGURE 35 : UN EXEMPLE DE CE QUI EST STOCKÉ

DANS LA BASE DE DONNÉES

41

FIGURE 36 : SAISIE DIRECTEMENT DANS L'INTERFACE

42

FIGURE 37 : UN EXEMPLE D'ÉDITEUR DE SITE

AVEC DES BOUTONS D'ÉDITION

43

FIGURE 38 : UN EXEMPLE DE PLATEFORME ONLINE AVEC DU

DRAG AND DROP

44

FIGURE 39 : UNE DES NOMBREUSE INTERFACE DES

SGBD

44

FIGURE 40 : LE CODE SQL LORSQUE LA TABLE A

ÉTÉ CRÉÉE

45

FIGURE 41 : CRÉATION D'UNE TABLE

45

FIGURE 42 : SPÉCIFICATION DES COLONNES

46

FIGURE 43 : REMPLISSAGE DES CHAMPS DE LA TABLE.

46

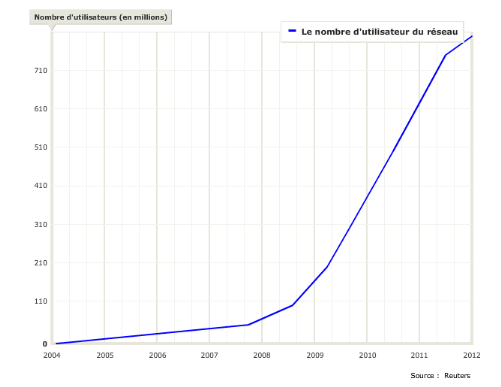

FIGURE 45 : EVOLUTION DU NOMBRE DE SITE CONSULTABLE

DEPUIS 1995

60

FIGURE 46 : EVOLUTION DU NOMBRE D'ARTICLE DE

WIKIPÉDIA EN FRANCE

63

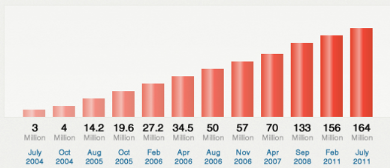

FIGURE 48 : EVOLUTION DU NOMBRE DE COMPTE FACEBOOK

DANS LE MONDE

64

FIGURE 47 : AUGMENTATION DU NOMBRE DE BLOG DANS LE

MONDE, SOURCE TECHNORAITI

65

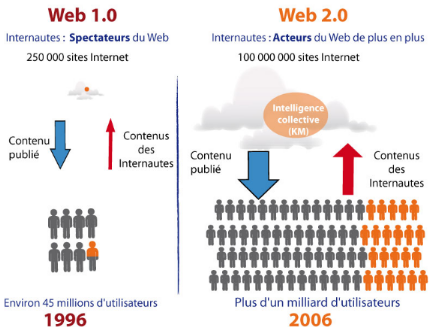

FIGURE 49 : LES INTERNAUTES DU WEB DEVIENNENT

ACTEURS

66

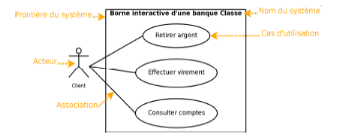

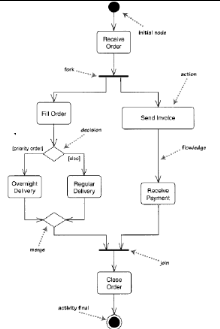

FIGURE 50 : DIAGRAMME DE CAS D'UTILISATION

78

FIGURE 51 : DIAGRAMME D'ACTIVITÉ

78

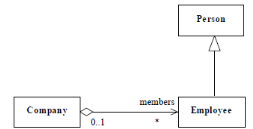

FIGURE 52 : DIAGRAMME DE CLASSE

79

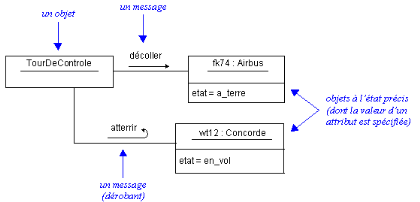

FIGURE 53 : DIAGRAMME DE COLLABORATION

79

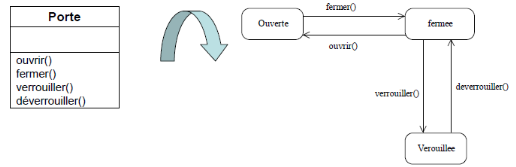

FIGURE 54 : DIAGRAMME

D'ÉTATS/TRANSITIONS

79

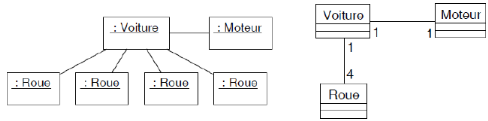

FIGURE 55 : DIAGRAMME D'OBJETS

80

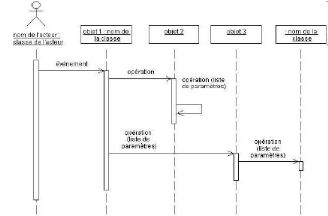

FIGURE 56 : DIAGRAMME DE SÉQUENCES

80

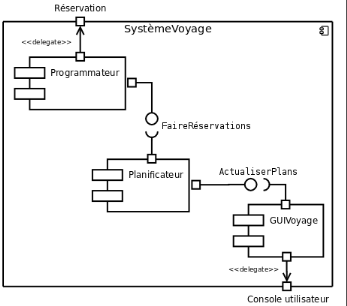

FIGURE 57 : DIAGRAMME DE COMPOSANTS

81

FIGURE 58 : EXEMPLE DE GÉNÉRATION DE

CODE

83

I. Introduction

"Moi aussi je peux jouer ?". Petite phrase très commune

chez les enfants dans la cour de récréation désirant

participer à un simple jeu avec leurs camarades, afin de pouvoir

s'épanouir et éventuellement apprendre une nouvelle discipline.

La similitude peut être de mise avec le monde informatique et plus

particulièrement tous ces logiciels qui existent à profusion.

Beaucoup de personnes, hors du monde informatique, m'ont déjà

demandé "mais comment on créé un logiciel ?". Cette

question, qui peut paraitre anodine, montre bien que le monde informatique est

omniprésent dans la vie de tous les jours, et que chacun se montre

très curieux sur ces logiciels qu'on utilise quasiment quotidiennement

(pour ne pas dire tous les jours). Et bien sûr qui dit logiciel dit

interface graphique...

1. Histoire du GUI

(Graphical User Interface, Interface Utilisateur Graphique)

A. Les premiers pas

C'est du côté de Palo Alto (Etat-Unis), dans le

laboratoire de recherche de Xerox Parc, qu'une révolution informatique

va intervenir. En 1973, Xerox conçoit l'Alto, c'est une

révolution dans le domaine informatique car c'est la première

station à combiner une interface graphique avec des fenêtres, et

l'utilisation de la souris. Malheureusement Xerox ne prend pas le risque de

commercialiser sa machine qui est en totale rupture avec le marché.

Xerox la diffusera seulement sur ses sites pour pouvoir tester le concept, et

commercialisera le Xerox Star (qui reprend les grandes lignes de l'Alto)

seulement en 1981.

Figure 1 : Le Macintosh

Aujourd'hui tout le monde est au courant, c'est Apple qui fait

triompher cette nouvelle interface révolutionnaire avec son projet Lisa

(le nouveau micro-ordinateur de la marque), ceci c'est grâce à

Steve Jobs (suite à sa visite au Xerox Parc) qui va pousser Apple

à développer une interface similaire à l'Alto. Lisa est

commercialisé en 1983 mais c'est un échec car les performances

sont décevantes et la machine coûte 9995 dollars. L'arrivée

du Macintosh en 1984 rencontrera quant à lui le succès avec la

même interface (totalement intégrée à l'OS) que sur

Lisa. Apple se différencie ainsi de la concurrence des constructeurs

d'ordinateurs de bureau qui sont tous alignés sur le standard IBM PC et

MS/DOS.

B. Les stations de travail

adoptent le GUI

Ainsi tous les constructeurs vont équiper leur machine

du système à fenêtre. Apollo Computer lance son Display

Manager dès 1981, Sun Microsystems avec son interface SunTools, qui

s'exécute sur son système d'exploitation SunOS, James

Gosling and David Rosenthal développent NeWS, une interface

révolutionnaire car elle est basée sur une évolution

orientée objet de Postscript (langage d'impression exploité

notamment sur les imprimantes lasers), il n'y aura pas de suite à cette

expérience.

Mais les initiatives des industries convergent vers un

même standard : le X Window. Le X Window a été

développé en 1984 par le MIT (Massachusets Institute of

Technology) et est également connu sous le nom de X11. Il est

composé d'un logiciel serveur, d'un module client et d'un protocole de

communication pour permettre l'échange de l'un vers l'autre. X11 va

conduire à une génération de terminaux graphiques haute

résolution qui sont capables d'exécuter ce client X. Les machines

Unix par exemple disposeront d'une interface graphique et d'une ergonomie

semblable.

C. La micro s'empare à

son tour des interfaces à fenêtres

Par la suite les fournisseurs de micro-ordinateurs grand

public se sont mis à développer ces interfaces graphiques

grâce à la génération des processeurs 16/32 bits. On

peut citer l'AmigaOS créé par Commodore, le TOS de Atari ST, BeOS

créé par Jean-Louis Gassée ou encore le NextSTEP

créé par Steve Jobs.

Ces interfaces graphiques ont permis le développement

du logiciel.

2. Le logiciel

A. Le déploiement

La miniaturisation guide le rythme d'évolution de la

technologie du matériel mais c'est le déploiement logiciel qui

détermine la pénétration des ordinateurs dans les

activités qu'elles soient industrielles ou intellectuelles. Le logiciel

a complètement transformé l'ordinateur. Il est passé de

l'étape d'un outil pouvant dans la théorie solutionner un

problème à un outil qui le résout dans la pratique. Le

matériel est au logiciel ce que les instruments sont à la

musique. Léonard De Vinci avait défini la musique comme

"modelage de l'invisible", sa définition est d'autant plus

adaptée pour décrire un logiciel.

Les progrès du matériel ont été

énormes et ils le sont tout autant pour le logiciel. La grande

majorité des logiciels avait été inventée 15 ans

seulement après que Von Neuman ait définit l'architecture des

machines. Les programmeurs attendaient même des machines bien plus

puissantes pour pouvoir progresser. Pour s'en convaincre il suffit de regarder

les dates d'apparition des langages : Fortran en 1957, Lisp en 1959, Cobol en

1960, Basic en 1964,... Il en a été de même pour les OS

où les fonctions qu'un programme pouvaient exécuter en 1966 sous

l'OS des IBM 360 étaient quasiment les mêmes que celles de

l'OS/390 en 1995.

Les tous premiers programmes des ordinateurs ont

été conçus par des mathématiciens et des

scientifiques car ils croyaient que c'était du travail logique et

simple. Mais le logiciel s'est révélé bien plus

délicat à développer qu'ils ne l'avaient pensés. A

l'époque les ordinateurs étaient têtus, ils faisaient ce

qui été écrit plutôt que ce qui était voulu.

Les programmeurs sont donc apparus, ils n'étaient ni

mathématiciens, ni scientifiques mais étaient engagés dans

une nouvelle histoire avec les ordinateurs.

B. L'évolution des

langages de programmation

Les prémices des langages de programmation sont aussi

vieilles que le calculateur digital. Il a donc fallu inventer des notations

symboliques (un langage), ces notations sont ensuite traduites en code binaire

par des autres programmes (un compilateur). Le langage qui a été

le plus influent est le Fortran (développé en 1954 et 1957 par

John Backus & co. chez IBM). A l'époque, il n'était pas

certain que le compilateur puisse suivre la machine afin de produire du code

efficace. Pourtant l'objectif a été atteint et Fortran est encore

utilisé de nos jours. Mais Fortran avait des contraintes inutiles, des

limitations dans les structures de données et des carences dans le

contrôle logique du programme. Dans une moindre mesure on peut

considérer que les nouveaux langages ont vu le jour pour solutionner les

défauts de Fortran.

Malgré toutes les tentatives pour sortir un langage

universel par un comité (Cobol), une organisation commerciale (PL/I),

une personne (Pascal), ou par le ministère de la Défense

américaine (ADA) celles-ci ont échoué et ont ouvert la

voie à d'innombrables langages dont seulement une toute petite dizaine

est aujourd'hui utilisée.

A l'inverse du matériel, les forts progrès du

logiciel ne viennent pas d'une seule et même technologie mais d'un

ensemble de paramètres (structures de contrôle des programmes,

environnement de programmation, outils de programmation, etc). Malgré

cela, certains continuent de coder dans des langages qui datent de plus de 30

ans (Fortran).

"Je parle en espagnol à Dieu, en italien aux

femmes, en français aux hommes et en allemand à mon cheval"

disait Charles Quint, il n'y a pas de langage idéal en informatique

chacun fait selon ses sensations.

C. Les interfaces

utilisateurs

Un programme permet à l'ordinateur de se transformer en

un outil adapté à un usage particulier (fabrication d'un avion,

traitement de texte, etc). L'interface va servir d'intermédiaire entre

l'utilisateur et le logiciel, on parle d'IHM (Interface Homme Machine). Avant

on concevait l'interface utilisateur en dernier, désormais cela se fait

en premier ainsi chacun peut s'approprier "son" ordinateur. Bien sûr cela

reste une illusion, mais cette illusion est la métaphore

simplifiée que chacun se construit pour expliquer les actions du

système ou pour provoquer de nouvelles actions.

La majorité des principes et des

périphériques sont développés pour perfectionner

cette métaphore, c'est quelque chose qui est devenue commun dans la

programmation. Le principe le plus important est sans conteste le WYSIWYG

("What You See Is What You Get") c'est à dire ce que l'ont voit sur

l'écran est une représentation fidèle de la

métaphore de l'utilisateur. Un utilisateur veut un carré ? Il

obtient un carré. Chaque utilisation du carré entraîne une

modification prévisible du système, en tout cas du point de vue

de l'utilisateur. Les éléments de cette métaphore qui sont

les plus employés sont les fenêtres, les icônes, les menus,

etc.

Grâce à cela une nouvelle

génération de logiciel a émergé afin de

facilité la tâche de l'utilisateur.

D. Les principales tendances

dans la fabrication du logiciel

Sans le logiciel, les ordinateurs et les matériels de

communication ne pourraient pas fonctionner. Au tout début, les

coûts et les temps de développement des programmes ainsi que la

productivité des programmeurs n'étaient pas des données

critiques : Si une machine coûtait 2 millions de dollars, est-ce que

c'était important que le logiciel en coûte 200 000 dollars ?

L'arrivée des PC a bouleversé cette donne. En effet, la baisse

des prix du matériel a mit en lumière le coût des

logiciels.

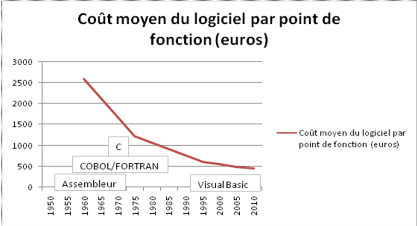

La mesure de la productivité du logiciel est une

question très discutée. En utilisant la méthode des points

de fonction inventée par Allan Albrecht, chercheur chez IBM, vers la fin

années 70, on obtient la courbe suivante sur les 50 dernières

années :

Figure 2 : Evolution de la productivité depuis

50 ans

Comme on peut le voir la courbe est en constante baisse depuis

la création des premiers logiciels, il y a donc peu de chance de voir la

productivité progresser considérablement dans les années

à venir. Les besoins en logiciel sont tels qu'on a vu apparaitre de

nouvelles idées et de nouvelles approches pour la programmation de

logiciel : le génie logiciel.

E. Le Génie Logiciel

(GL)

Le terme de software engineering (Génie

logiciel en français) a vu le jour à la sortie de deux

conférences du comité scientifique de l'OTAN (à Garmisch,

en Allemagne, du 7 au 11 octobre 1968, et à Rome, en Italie, du 27

au 31 octobre 1969).

Le génie logiciel est "une science de

génie

industriel qui étudie les méthodes de travail et les

bonnes pratiques des ingénieurs qui

développent

des logiciels. Le génie logiciel s'intéresse en

particulier aux procédures systématiques qui permettent d'arriver

à ce que des logiciels de grande taille correspondent aux attentes du

client, soient fiables, aient un coût d'entretien réduit et de

bonnes performances tout en respectant les délais et les coûts de

construction", selon Wikipédia. Son but est de maximiser les

durées de vie et les qualités des logiciels en minimisant les

coûts et les délais.

On retrouve la productivité au coeur du

développement des technologies de l'information et par conséquent

au coeur de l'activité des ingénieurs informaticiens. Ainsi se

dégagent deux aspects complémentaires :

· Perfectionner la productivité des codeurs et des

équipes qui réalisent le programme. Tout ceci grâce

à plusieurs méthodes, outils, facilités d'emploi et un

savoir-faire qui forment un tout homogène.

· Accroître le nombre d'ingénieurs pouvant

réaliser des programmes, où même éventuellement

permettre à un usager traditionnel de faire son propre programme dont il

a besoin (comme par exemple les tableurs qui ont vu le jour dans les

années 80 grâce à la micro informatique).

C'est ce dernier point qui va être le fil conducteur de

ce mémoire.

3. Problématique

L'idée de savoir si de simples usagers étaient

capables de réaliser eux-mêmes des programmes m'est venue l'an

dernier lors d'un projet où je devais développer une application

de production et de gestion de stocks en Java. Pour ce faire, j'ai dû

développer une IHM mais j'ai été confronté à

un problème : je n'avais pas toutes les compétences pour en

réaliser une qui soit, entre autres, ergonomique et visuellement

attractive.

En faisant des recherches sur Internet, j'ai trouvé un

plug-in pour Eclipse (environnement de développement libre) nommé

WindowsBuilderPro qui permet de créer des GUI sans écrire la

moindre ligne de code.

Ainsi je me suis demandé, est-ce que de tels outils ne

pourraient pas se généraliser dans l'avenir afin que chacun

puisse créer son propre logiciel? En condenser, demain, serons-nous tous

développeurs de programmes (et/ou sites web)?

Après avoir fait un état des lieux de

l'existant, je vous expliquerai de quel manière nous pouvons

déjà tous êtres développeurs, puis pourquoi

finalement nous ne pouvons pas l'être tous avant de savoir dans quelle

mesure cette problématique peut être légitime.

Il ne faut pas perdre des yeux que dans ce sujet je parle de

personnes qui n'ont aucune connaissance en programmation et qui dans le futur

pourraient être amenées à créer un logiciel, un site

web ou une base de données. Tout au long de ce mémoire

j'essaierai de répondre à la problématique en distinguant

bien ces trois notions que sont le logiciel, le site web et la base de

données dont la conception fait partie du métier de

développeur.

II. Etat de l'art

Dans cette partie, nous allons passer en revue tout ce qui va

nous permettre de développer un programme (ou un site web) sans

écrire une seule ligne de code. Comme expliquer dans la

problématique je distinguerai bien le logiciel, le site web et la base

de données.

1. Le logiciel

Le logiciel contrôle le monde, il est présent

absolument partout : processus métiers (administrative etc.),

gouvernement, l'industrie (Usines, chaines de fabrication), transports,

défense, finance, santé, édition, médias, nouvelles

technologies du web, commerce électronique, et bien plus encore.

Le logiciel a des enjeux aussi bien politiques

qu'économiques, d'autant plus que si un problème survient

à cause d'un logiciel les conséquences peuvent être

très lourdes :

· Therac 25, de 1985 à 1987 : 6 patients

irradiés, 2 morts

· Ariane 5 vol 88/501, en 1996 : le vol est

détruit au bout de 37 secondes et a coûté 850 millions de

dollars

· Mars Climate Orbiter & Mars Polar Lander sont

détruits en 1999

· Le projet d'informatisation de la bourse de Londres a

été abandonné au bout de 4 ans et a coûté 100

millions de livres

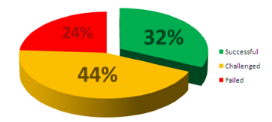

Figure 3 : Constat des projets en Génie

Logiciel

Figure 4 : Evolution de ces chiffres

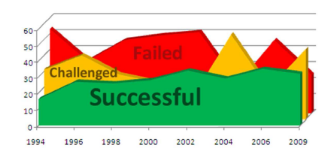

The Standish Group montre qu'en 2009 seulement 32% des projets

en génie logiciel respectent toutes les spécifications

prévues au départ et que 24% ne voient pas la fin. Bien que le

taux de succès reste en constante hausse, le taux d'échec est

quant à lui aléatoire :

Aujourd'hui les logiciels sont de plus en plus complexes car

ils ont plusieurs préoccupations, points de vue et aspects. Ces points

de vues sont noyés dans le code, il est donc impossible de les isoler.

Les applications sont également de plus en plus larges et le nombre de

lignes de code ne cesse d'augmenter, selon Wikipédia et Source Line Of

Code (SLOC) Windows XP c'est 40 millions de lignes de codes, ceci complique

grandement la communication ente les différents intervenants.

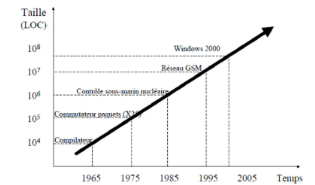

Figure 5 : Evolution du nombre de lignes de

code

Le logiciel c'est également des besoins qui

évoluent en cours de route, on a donc des besoins de variabilité.

Pour répondre à ces problématiques et à

l'évolution permanente des technologies, il est apparu, entre autres,

l'ingénierie dirigée par les modèles.

A. Ingénierie

Dirigée par les Modèles (IDM ou MDE) MDE : Model-Driven

Engineering

L'Ingénierie Dirigée par les Modèles

(IDM) est une méthodologie/vision de développement de logiciels

qui met l'accent sur la création de modèles (ou l'abstraction)

plus proche du concept du domaine concerné plutôt

qu'orienté informatique ou algorithmique.

Un paradigme de modélisation pour IDM est

considéré comme efficace si ses modèles ont un sens par

rapport au point de vue de l'utilisateur et peut servir de base pour

l'implémentation de systèmes.

Les principes de l'IDM :

· P1 : «Models as first class entities»

· P2 : Montée en abstraction

· P3 : Séparation des préoccupations

· P4 : Modèles productifs (Vs.

Contemplatifs)

P1 : Les modèles comme des entités de

première classe

Avec l'IDM on veut passer du "tout objet" au "tout

modèle", c'est-à-dire modéliser au lieu de coder. Il y a

un changement d'état d'esprit : on était dans le "coder une fois,

lancer partout" désormais on veut "modéliser une fois,

générer partout".

Le modèle objet a atteint ses limites, les concepts

objets sont plus proches de l'implémentation que du domaine

métier (Gabriel, 2002) et (Nierstrasz, 2010).

Avec le concept de l'objet il est difficile de raisonner et de

communiquer (code) car les aspects qu'ils soient fonctionnels ou pas sont

noyés dans des lignes de codes. Le défi est donc de s'orienter

vers une expertise métier et avoir un bon langage de

modélisation.

La définition d'un modèle : "A Model

represents reality for the given purpose ; the model is an abstraction

of

reality in the sense that it cannot represent all aspects

of reality. This allows us to deal with the world in a simplified manner,

avoiding the complexity,danger and irreversibility of reality" (Rothenber,

1989)

Traduction : un modèle représente une

réalité pour un sujet donné. Le modèle est une

abstraction de la réalité dans le sens où il ne peut pas

représenter tous les aspects de la réalité. Cela nous

permet de traiter le problème de manière simplifiée en

évitant la complexité, les dangers et

l'irréversibilité de la réalité.

La définition de la modélisation : "in the

broadest sense, is the cost-effective use of something in place of something

else for some cognitive purpose. It allows us to use something that is simpler,

safer or cheaper than reality instead of reality for some purpose" -

(Rothenber, 1989)

Traduction : au sens large, c'est l'utilisation rentable de

quelque chose à la place d'une autre dans un but cognitif. Elle nous

permet d'utiliser quelque chose qui est plus simple, plus sûre ou moins

chère que de la réalité.

Il faut cependant faire attention au débat qui dit que

l'abstraction est la même chose que la simplification car ce n'est pas le

cas. En effet, la modélisation simplifie la compréhension et la

communication autour du problème mais elle ne simplifie pas le

problème lui-même.

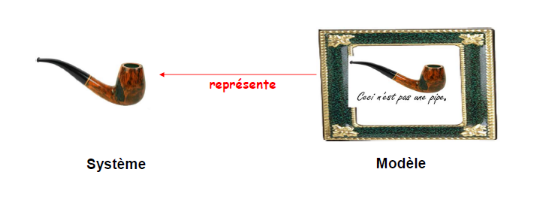

Figure 6 : Un exemple de modèle, la pipe selon

Magritte

Pour être productifs, les modèles doivent

être utilisés par des machines, on a donc besoin d'un langage

précis pour les définir, on appelle ceci

Méta-Modèle.

D'après l'OMG (Object Management Group. : Association

de professionnels de l'informatique

orientée objet

ayant défini la norme

Corba, ainsi que l'

OMA 1(*)et les

ORB2(*)) a "metamodel is a model that defines the language

for expressing a model". Traduction : un Méta-Modèle est un

modèle qui définit un langage pour définir un

modèle.

Pour Seidewitz, a «metamodel makes statements about

what can be expressed in the valid models of a certain modeling

language». Traduction : un méta-modèle fait des

déclarations sur ce qui peut être exprimé en modèles

valides de certains langages de modélisation.

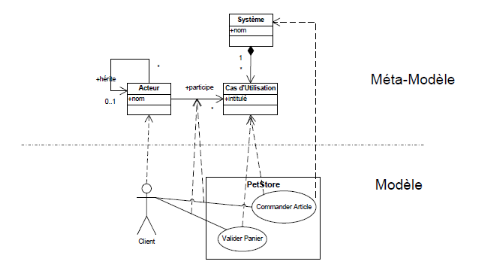

La relation entre un modèle et son

méta-modèle est une relation "conforme à". Un

modèle est conforme à son méta-modèle si les

éléments et les relations entre ces éléments sont

définis dans le méta modèle

Conforme à

Représente

Méta-modèle

Modèle

Système

Figure 7 : Un exemple de

méta-modèle

Les langages utilisés pour exprimer les

méta-modèles ont eux-mêmes un modèle qu'on appelle

méta-méta-modèle et qui se trouve être

traditionnellement auto-descriptif. C'est en particulier le cas pour MDA (voir

plus loin). Un méta-modèle réflexif est exprimé

dans le même langage de modélisation qu'il décrit. Les

principaux langages de méta-modélisation existants sont MOF (pour

Meta-Objet Facilities), EMOF (pour Essential MOF), CMOF (pour Complete MOF) et

ECore défini par IBM et utilisé dans le framework de

modélisation d'Eclipse EMF (Eclipse Modeling Framework).

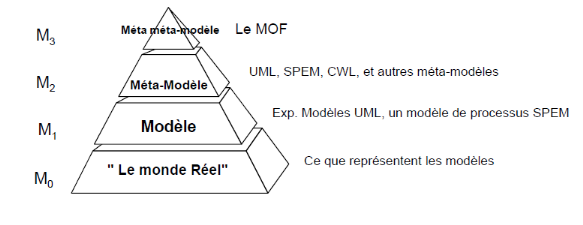

La spécification de MOF adopte une architecture de

méta-modélisations à quatre couches :

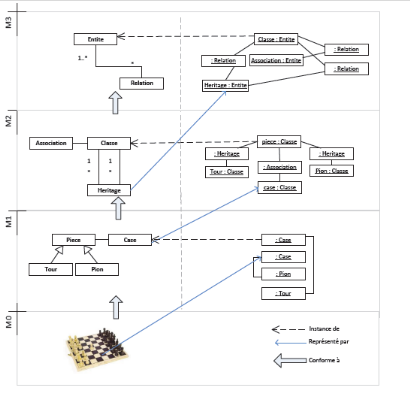

M0 : Ce niveau représente le

système réel à modéliser.

Exemple : Jeu d'échecs dans la figure ci

après.

M1 : Ce niveau est composé du

modèle représentant le système réel à

modéliser.

Exemple : modèle de jeu d'échecs via un DSL

(Domain Specific Langage)

M2 : Dans ce niveau on trouve le

méta-modèle décrivant le langage de

modélisation.

Exemple : méta-modèle du DSL de jeu

d'échecs.

M3 : Un niveau qui comporte le

méta-méta-modèle décrivant le langage de

méta-modélisation.

Exemple : Ecore, MOF.

Figure 8 : Une architecture à 4

niveaux

On retrouve ces couches dans la figure 9, qui illustre un

système de jeu d'échec. L'échiquier est situé au

niveau M0, chaque élément de ce système est

modélisé au niveau M1. Dans ce niveau on retrouve le

modèle qui représente l'échiquier, les pièces sont

modélisées par une classe nommée pièce et qui a

certains attributs décrivant la pièce, même chose pour le

plateau et les cases. Ensuite on retrouve le méta-modèle au

niveau M2, ce dernier représente le langage de modélisation et il

est conforme à un méta-méta-modèle. Ce

méta-méta-modèle est situé dans le niveau M3, il

est conforme à lui-même et représente le langage de

méta-modélisation.

Figure 9 : Niveaux de modélisation, exemple du

jeu d'échec

P2 : Abstraction

L'abstraction c'est ignorer les détails insignifiants

et ressortir des détails les plus importants. Pour rappel l'importance

c'est décider de ce qui est signifiant et de ce qui ne l'est pas, cela

dépend directement de l'utilisation visée du modèle. Pour

le Larousse l'abstraction c'est l' "Opération intellectuelle qui

consiste à isoler par la pensée l'un des caractères de

quelque chose et à le considérer indépendamment des autres

caractères de l'objet."

Les modèles permettent de s'abstraire de certains

détails qui ne sont pas indispensables pour comprendre le système

selon un point de vue donné. Pour rappel le but du génie logiciel

c'est l'amélioration de la productivité via l'augmentation du

niveau d'abstraction.

Les langages de 3ème génération (

Fortran,

COBOL,

Simula,

APL, etc.) ont

amélioré la productivité du développeur par 450%

(Jones, 2006), alors que l'introduction des langages orientés objets

n'ont pas fait autant. Par exemple Java est 20% plus productif que le BASIC.

Les langages de programmation arrivent aujourd'hui à leur limite en

terme d'abstraction. Ainsi le défi c'est d'assurer la

transformation/transition vers le niveau le plus bas et de choisir le bon

niveau d'abstraction.

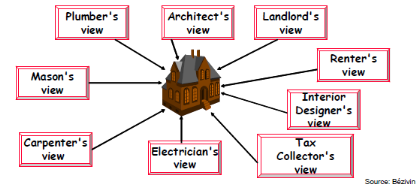

P3 : Séparation des

préoccupations

La séparation des préoccupations est

indispensable dans le cas d'applications complexes. Plusieurs aspects et/ou

points de vue signifient que nous avons plusieurs métiers

(sécurité, communication, GUI, QoS,..), mais un point de vue

concerne un modèle.

Figure 10 : Plusieurs vues sur un même

modèle

Chaque vue peut être exprimée en utilisant un

langage de modélisation différent. Il y a du coup plusieurs

intervenants dans la boucle. Le défis de l'IDM est d'intégrer des

vues et d'assurer une cohérence entre ces vues.

Vue plan

Vue satellite

Vue trafic

Un autre niveau d'abstraction

Street view

Figure 11 : Abstraction et séparation des

préoccupations, l'exemple de Google Maps

· P4 : Modèle productifs

La modélisation reste un investissement qu'il faudra

rentabiliser. On se dirige vers de plus en plus de code

généré automatiquement à partir des modèles.

Les défis des modèles productifs consistent en

des langages de modélisation proche du métier et précis,

des générateurs de code fiable, intégration du code

généré à partir de plusieurs vues vers un seul

système, génération du comportement, définition de

la chaine de transformation (raffinement) modèle vers code.

Les promesses de l'IDM sont donc :

· Gérer la complexité : les applications

sont de plus en plus énormes (Windows 2000 c'est 40 millions de lignes

de code) et ne peuvent pas être gérées par un seul

développeur.

· Meilleure communication : le code n'est pas toujours

compréhensible pour les développeurs qui ne l'ont pas produits,

on peut difficilement communiquer avec du code. Comme il y a souvent plusieurs

dizaines de personnes sur un projet cela permet d'avoir un langage commun et

universel (monde). Avec l'apparition de nouvelles façons de travailler

(outsourcing, sous-traitance,...) la communication y apparait comme

très importante.

· Pérenniser un savoir-faire : de part la

durée de certains projets. Les projets peuvent durer plusieurs

années donc ce ne sont pas toujours les mêmes personnes qui

travaillent dessus. Du coup il y a un besoin de capitaliser un savoir-faire

indépendant du code et des technologies. On veut capturer le

métier sans se soucier des détails techniques.

· Augmenter la productivité : On

génère du code à partir de modèles et on

maîtrise la variabilité c'est-à-dire que nous avons une

vision ligne de produits où l'on veut un modèle

générique pour un produit avec plusieurs variantes.

Exemple de NOKIA qui a vendu 1,1 milliard de

téléphones portables avec des milliers de versions logiciels

alors que le délai de mise sur le marché n'est que de 3 mois.

Ainsi se pose la question suivante : Quel langage utiliser

pour modéliser, méta modéliser (créer de nouveaux

langages) ? Pour cela nous allons voir deux approches :

· L'approche MDA : utilisation d'un ensemble de standards

fournis par l'OMG3(*) i.e.

MOF4(*), UML.

· L'approche DSML (Domain-Specific Modeling Languages)

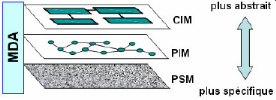

L'approche MDA (Model-Driven Architecture)

L'approche MDA est une vision promue par l'OMG depuis 2001

(Soley, 2001), qui se base sur les modèles. La principale idée

est qu'un modèle indépendant de la plate-forme (Platform

Independent Model, PIM) définit l'ensemble des fonctionnalités du

système à développer. Le PIM va quand à lui

être traduit en modèle PSM (Platform Specific Model)

c'est-à-dire en modèle qui est spécifique à la

plate-forme. Le PSM va être utilisé par la suite pour

générer le code de la plate-forme cible. On entend aussi parler

de CIM (Computational Independent Model), il est encore plus abstrait que le

PIM et il est indépendant de tout système informatique selon

l'OMG. Il est là pour expliquer ce que le système devra

réellement faire.

Figure 12 : Les trois types de modèles de

MDA

En résumé, les modèles CIM

décrivent les exigences sur le logiciel (services rendus, environnement

d'exécution, procédés métiers exploitants). Les

modèles PIM décrivent la conception abstraite du logiciel

(abstraction par la définition d'une machine conceptuelle), les

modèles PSM décrivent l'exploitation d'une plate-forme (choix

d'une machine d'exécution).

Attention, le CIM n'est pas une abstraction du PIM,

c'est-à-dire que les exigences ne sont pas une abstraction de la

conception abstraite, sauf si on suit le principe de raffinement. Le PIM est

une abstraction du PSM, c'est-à-dire que la conception abstraite est une

abstraction de la conception concrète. Le CIM et le PIM se recouvrent,

c'est à dire que les exigences du CIM doivent être

supportées par la conception, de même que le PIM et le PSM se

recouvrent, c'est-à-dire que la conception concrète doit

être conforme à la conception abstraite.

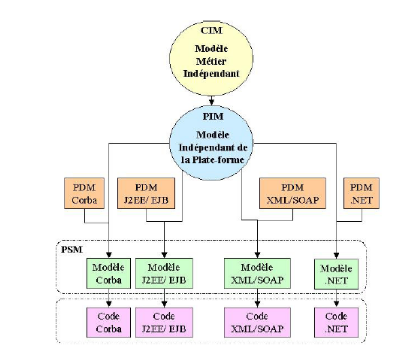

*

Figure 13 : Exemple d'utilisation des modèles

du MDA pour réaliser une application

* PDM pour Plateform Description Model. Il correspond

à un modèle de transformation du PIM vers un PSM

d'implémentation. L'architecte doit choisir une ou plusieurs plateformes

pour l'implémentation du système avec les qualités

architecturales désirées. Ce modèle propre à la

plate-forme est utile pour la transformation du PIM en PSM. La démarche

MDA est ainsi basée sur le détail des modèles

dépendants de la plate-forme. Il représente les

particularités de chaque plate-forme. Il devrait être fourni par

le créateur de la plate-forme.

Le MDA s'appuie sur plusieurs standards :

· Grâce au MOF, tous les méta-modèles

sont homogènes (diagramme de classe)

· Grâce à UML, il existe un langage de

modélisation très généraliste et ciblant plusieurs

niveaux d'abstraction (voir la partie dédiée à l'UML).

· Grâce à OCL, il est possible de

préciser des contraintes d'exploitation des modèles

· Grâce à AS, il est possible de

modéliser finement des comportements

· Grâce à XMI, il existe un format unique de

sauvegarde des modèles vers XML

· Grâce à SPEM, les procédés

de développement sont modélisables

· Grâce à QVT, les transformations sont

modélisables.

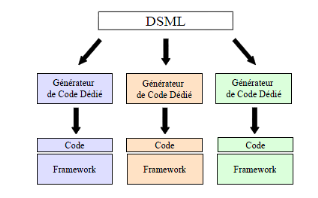

L'approche DSML (Domain-Specific Modeling Languages)

Dans le monde du génie logiciel, un DSML est un langage

de modélisation dédié à un domaine

précis.

A l'inverse du MDA qui utilise des méthodologies de

modélisation généraliste, la modélisation

spécifique à un domaine (DSM) lui utilise une méthodologie

qui est centrée sur un domaine spécifique et qui a pour but de

perfectionner la productivité. L'idée c'est de baisser l'espace

de conception afin d'avoir dans la plupart des cas une seule gamme de produit

par organisation. Ainsi le niveau d'abstraction des modèles est

élevé et la génération totale de

l'implémentation sera sur mesure pour l'organisation, d'où le

gain de productivité.

Le principe de la modélisation DSM est simple, et

réside dans la notion de langage de modélisation

spécifique à un domaine (Domain-Specific Modeling Language ou

DSML). On rassemble l'ensemble des connaissances du domaine d'application dans

un langage de modélisation qui lui est dédié, on en fait

des modèles et à partir de ces modèles on

génère du code.

L'approche DSML fait partie d'un environnement complet avec un

générateur de code et un environnement d'exécution

(framework) pour former les DSM.

Figure 14 : DSML

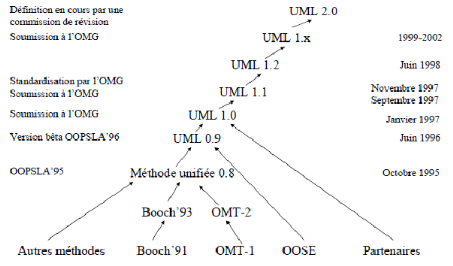

L'UML (Unified Modeling Language)

Entre 1989 et 1994 : le nombre de méthodes

orientées objet est passé de 10 à plus de 50, où

chacune proposait son propre langage de modélisation. Toutes ces

méthodes avaient pourtant d'énormes points communs (objets,

méthodes, paramètres, ...). Au milieu des années 90, UML

est l'accomplissement de la fusion de précédents langages de

modélisation objet :

Booch,

OMT,

OOSE principalement issus des

travaux de

Grady Booch,

James Rumbaugh et

Ivar Jacobson. Les

principales influences de l'UML sont :

· Booch : Catégories et sous-systèmes

· Embley : Classes singletons et objets composites

· Fusion : Description des opérations,

numérotation des messages

· Gamma, et al. : Frameworks, patterns,

et notes

· Harel : Automates (Statecharts)

· Jacobson : Cas d'utilisation (use cases)

· Meyer : Pré- et post-conditions

· Odell : Classification dynamique, éclairage sur

les événements

· OMT : Associations

· Shlaer-Mellor : Cycle de vie des objets

· Wirfs-Brock : Responsabilités (CRC)

Figure 15 : Historique de l'UML

Aujourd'hui, UML est le langage de modélisation

orienté objet (OO) le plus connu et le plus utilisé et s'applique

à plusieurs domaines tels que : OO, RT, Déploiement,

Requirement,... Peu d'utilisateurs connaissent le standard, ils ont une vision

outillée d'UML (Vision Utilisateur) où 5% ont une forte

compréhension, 45% une faible compréhension, 50% aucune

compréhension.

Il y a trois utilisations possibles d'UML :

· Comme un langage pour faire des croquis, esquisses,

ébauches... (explorer)

Probablement la manière dont UML est le plus

utilisé aujourd'hui : pouvoir échanger, communiquer

rapidement autour d'une idée où les modèles ne sont pas

forcément à 100% complets. Ses objectifs sont d'analyser,

réfléchir et décider (brainstorming)

· Comme un langage de spécification de

modèles, patrons... (spécifier). On spécifie ici, des

modèles complets, prêts à être codés,

utilisés pour prendre des décisions poussées de design,

des modèles issus du Reverse Engineering (afin de

réfléchir dessus, d'améliorer la conception, de casser des

dépendances, etc.). Il y a également une possibilité de

faire du round-trip engineering (Génération de code et Reverse

engineering)

· Comme langage de programmation (produire). Ici, on veut

tout mettre dans le modèle, le modèle UML devient alors la source

du code afin de pouvoir générer et compiler du code à

partir du modèle.

C'est ce dernier point qui va nous intéresser.

La génération de code conduit à plus de

productivité (la structure d'une centaine de classes,

d'opérations, ... sont générés en un seul clic). Il

y a également moins d'erreurs car le savoir faire est codé dans

les générateurs de code.

Les principes d'un générateur de code consistent

en :

· un ensemble de règles décrivant la

correspondance entre concepts du modèle et concepts du langage (Java par

exemple, voir ci-après).

· paramétrages d'option (dans certains

cas/outils)

o Choix des constructions dans le langage cible (Vector ou

ArrayList en JAVA)

o Générer les accesseurs et les constructeurs

o Implanter les méthodes abstraites

· Un moteur de génération de code avec en

input le modèle et en output le code.

Voici à titre d'exemple quelques règles sur la

génération de code UML 2 vers JAVA :

· Une classe UML correspond à une classe JAVA

ayant le même nom.

· Une interface UML correspond à une interface

JAVA ayant le même nom

· Si une classe UML est associée à une

autre et que l'association est navigable, il y a alors un attribut dans la

classe JAVA qui va correspondre à la classe UML. Le nom de cet attribut

correspond au nom du rôle de l'association. Si l'association

spécifie une cardinalité supérieure à 1, alors

l'attribut de JAVA est une ArrayList.

· Une opération d'une classe UML correspond une

opération d'une classe JAVA ayant le même nom, ainsi que les noms

des éventuels paramètres.

Cette liste est non exhaustive, il existe encore beaucoup de

principes mais qui ne seraient pas pertinents ici.

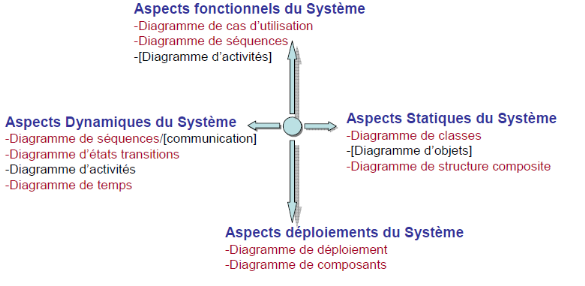

UML se décompose en trois sous ensemble :

· En vue

· En diagramme

· En modèles d'élément

Les vues :

· des cas d'utilisation : montrent les besoins de chaque

acteur du système

· logique : montrent comment les besoins des acteurs

peuvent être satisfaits

· d'implémentation : montrent les

dépendances entre les modules

· des processus : montrent la vue temporelle et

technique

· de déploiement : montrent la position

géographique et l'architecture des éléments

Les diagrammes :

Ils sont au nombre de treize, représentant

différents aspects du système.

Figure 16 : L'ensemble des diagrammes UML

Je vais vous présenter succinctement les principaux

diagrammes UML

Point de vue fonctionnel :

Cas d'utilisation : OMG définit le cas d'utilisation

par une "représentation d'un ensemble de séquences d'actions

qui sont réalisées par le système et qui produit un

résultat observable intéressant pour un acteur

particulier".

Point de vue statique :

Diagramme de classes : va représenter les classes qui

interviennent dans le système.

Diagramme d'objets : représente la vue statique d'un

ensemble d'instance de classe

Point de vue dynamique :

Diagramme de séquences : représente les

interactions entre les objets dans la réalisation du processus de

l'application

Diagramme de collaboration/communication : il possède

les mêmes constituants que le diagramme de séquences mais il met

davantage l'accent sur les objets impliqués dans l'interaction que sur

l'aspect temporel des échanges.

Diagramme d'état/transition : description d'un objet

aux changements de son environnement.

Diagramme d'activité : modélise les traitements

effectués par une opération.

Point de vue déploiement :

Diagramme de composants : sert à montrer le lien entre

les différents composants d'une application

Les modèles d'élément

:

Ce sont les briques des diagrammes. Ce sont tous les

éléments qui vont permettre de concevoir les diagrammes.

Figure 17 : Quelques modèles

d'élément UML

La méthode de développement UML respecte un

processus strict. Après avoir lu le cahier des charges, il y a

établissement en parallèle le diagramme de cas d'utilisation (UC)

et de classes (seulement avec les attributs). A partir du diagramme de UC on

établit les diagrammes de séquences d'analyses et

d'activités. On peut ainsi peaufiner le diagramme de classes avec les

opérations et finir par les diagrammes de séquences de

conception.

Figure 18 : Méthode

de développement UML

Classes d'analyse

Classes de conception

Activités

Séquence de conception

Séquences d'analyses

Cas d'utilisation

En parallèle

Cahier des charges

B. Les IHM (Interface

Homme-Machine)

L'exemple de Visual Editor pour Java

Tout ce que l'on a vu jusqu'à maintenant concernait la

conception pure de logiciel, mais sans un brin d'IHM, les logiciels ne seraient

utilisables que par une petite partie de personnes. Ainsi, toujours dans

l'idée de s'abstenir de programmer, de nombreux éditeurs d'IHM

existent. J'ai choisi de vous expliquer le fonctionnement de l'un d'entre eux :

Visuel Editor qui est un plug-in pour Eclipse (environnement de

développement).

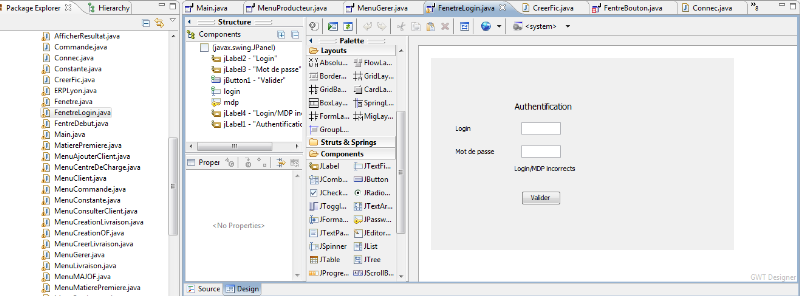

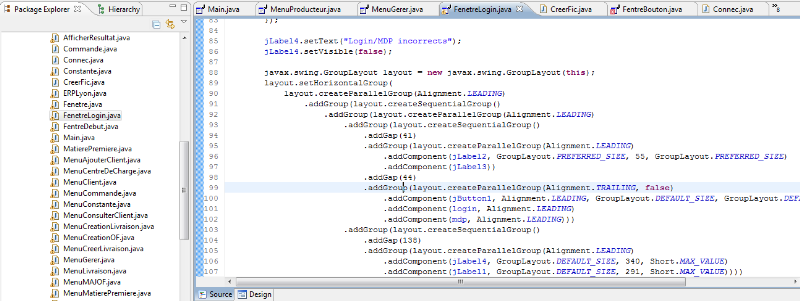

L'éditeur graphique Visual Editor (VE) permet de

développer rapidement des interfaces graphiques basées sur

SWING/SWT (bibliothèque graphique pour JAVA). L'éditeur graphique

génère un code Java standard de bonne qualité qui peut

être modifié par la suite. Les évènements des objets

graphiques peuvent également être générés

avec VE. Il est aussi possible de gérer les modèles abstraits

pour les objets complexes tels que les Jtable ou encore les Jlist. La prise en

main de VE est intuitive, par exemple la gestion des layouts (mise en page)

permet de définir des structures graphiques complexes d'objets

imbriqués avec les containers (conteneurs). Le code

généré n'a pas un format spécifique à

Eclipse VE, un simple éditeur comme notepad++, peut suffire pour

continuer un développement.

VE est divisé en deux fenêtres, l'une montrant

les composants de Java dans une fenêtre de conception, et l'autre

montrant la source associée. Dans la fenêtre de conception ce sont

des représentations graphiques (boutons, label, layout,...). Lorsque

vous modifiez les composants dans la fenêtre de conception, la source est

mise à jour. Inversement, lorsque vous modifiez les fichiers source, la

fenêtre de conception est mise à jour afin de refléter les

modifications que vous apportez. Ce cycle de déclenchement des

fenêtres de conception et de la source est conçu de telle sorte

que l'éditeur visuel pour Java peut être utilisé non

seulement comme un outil pour générer du code, mais comme un

éditeur pour montrer l'effet de modifications du code source au cours du

développement. Une fois que vous apportez des modifications à

votre fichier dans un autre éditeur, vos changements seront

reflétés dans la fenêtre de conception de VE.

VE montre par défaut la fenêtre de conception

dans un onglet "Design" et la source dans un onglet "source". La fenêtre

de conception est une surface WYSIWYG qui vous permet de composer l'interface

graphique que vous construisez, tandis que le volet source affiche le contenu

du fichier Java. La fenêtre de conception dispose d'une palette sur la

gauche qui vous permet de contrôler la sélection des composants. A

tout moment vous pouvez utiliser l'option Annuler dans le menu d'édition

ou de l'action afin d'annuler une modification.

Bien sûr VE n'est pas le seul éditeur graphique

pour JAVA, on peut également citer WindowsbuilderPro ou encore

Jbuilder.

Figure 19 : Aperçu de la partie graphique de

Visual Editor sous JAVA

Figure 20 : Aperçu de la partie source de

Visual Editor sous JAVA

Pour la source, voir l'Annexe 2.

3. Web

Concernant la partie Web, beaucoup de sites proposent de

créer son site web en cinq minutes sans la moindre connaissance en

programmation. Ces sites s'adaptent aux besoins des utilisateurs et permettent

de créer un site dynamique, un blog, un

site

e-commerce - ou les 3 à la fois - sans aucune connaissance

technique.

L'ambition de ces sites est d'assouvir les besoins des

utilisateurs. Ils travaillent pour leur faire profiter des dernières

avancées technologiques à des prix accessibles, voire gratuits.

Parallèlement, ils concentrent leur activités afin

d'élaborer des solutions Web complètes et faciles à

configurer sachant que la majorité de leurs clients ne sont pas des

informaticiens professionnels.

Beaucoup proposent des "extras" comme par exemple une

collection de logiciels ou l'utilisation d'un serveur

sécurisé.

Les espaces clients deviennent de plus en plus ergonomiques et

leur permettent de pouvoir configurer facilement un nom de domaine ou

gérer un compte email POP3 par exemple. Beaucoup d'utilisateurs ne sont

pas des professionnels de la création de sites, ainsi ces sites

conçoivent des applications de telle manière que n'importe qui

sachant surfer sur le net puisse instinctivement utiliser ces programmes en

ligne.

Ces sites proposent d'enregistrer des noms de domaine qui sont

de moins en moins cher (<10€/an) avec des solutions

d'hébergements consistants (vaste espace disque, trafic inclus

considérable, collection gratuite de logiciels...).

Ces sociétés se développent après

avoir acquis, pendant des années, de l'expérience et de la

maturité en tant que fournisseurs de produits et services à la

pointe de l'innovation. Ils ciblent les petites et moyennes entreprises ainsi

que les particuliers soucieux d'un service de qualité à bon prix.

Ces sites investissent énormément pour

construire les plus grands et plus modernes centres de calcul. Surpassant tous

les standards de sécurité, d'alimentation, de

connectivité, de hardware et de performance, les sites web se trouvent

entre de bonnes mains. Leurs équipes de maintenance surveillent en

permanence l'activité des serveurs, garantissant ainsi une

disponibilité réseau proche de 100%.

Parmi ces sites on peut citer Jimbo ou Prestashop pour faire

des sites de e-commerce, Joomla ou Drupal qui sont des CMS (on y reviendra plus

tard dans ce mémoire) afin de faire de la gestion de contenu, et des

plates-formes en ligne comme OneAndOne ou Wix pour élaborer n'importe

quel type de site et bien sûr sans oublier l'utilisation des blogs et des

wikis qui ont explosé au milieu des années 2000 et qui permettent

de poster régulièrement des billets, ou faire de la modification

de contenu. On a dénombré pas moins de 156 millions de blogs

début 2011.

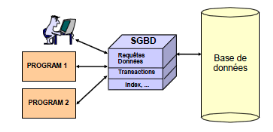

4. Les systèmes de

gestion de bases de données (SGBD)

Sans les bases de données la programmation web et

applicatif ne servirait à rien. En effet, nous aurions seulement de

simples interfaces où l'on ne pourrait pas stocker (ou remonter) des

données. Par exemple, une identification sur un site ne serait pas

possible. Le métier de programmeur ne se limite donc pas simplement aux

développements de logiciels, mais il faut également qu'il sache

créer et gérer une base de données.

Une base de données (BDD) est une collection de

données structurées sur des entités (objets, individus) et

des relations dans un contexte (applicatif) particulier. Un système de

gestion de base de données (SGBD) est un (ensemble de) logiciel(s) qui

facilite la création et l'utilisation de bases de données. Les

données sont définies, administrées et

gérées en utilisant des langages fondés sur des

modèles de données.

Figure 21 : L'approche base de

données

L'objectif du SGBD est de faciliter le partage de grands

volumes de données entre différents utilisateurs/applications. Il

doit garantir la cohérence et l'intégrité des

données en cas d'erreurs de programmation, d'accès concurrents,

de pannes, d'accès non autorisés, etc. Il doit également

garantir des performances d'accès sur des grands volumes de

données pour un grand nombre de clients.

Un SGBD a trois fonctions principales. Il doit, tout d'abord,

représenter et structurer l'information. Ceci par le biais d'une

description de la structure de données (ex : employés, âge,

noms,...), d'une description de contraintes logiques sur les données (ex

: 0 < Age < 150, ...) et d'une vue, c'est-à-dire une

réorganisation (virtuelle) de données pour des besoins

spécifiques. Un SGBD doit ensuite gérer l'intégrité

des données. Pour cela il y a une vérification des contraintes,

une exécution transactionnelle des requêtes (mise à jour)

et une gestion de la concurrence multiutilisateurs et des pannes. La

dernière fonction principale d'un SGBD est le traitement et

l'optimisation de requêtes.

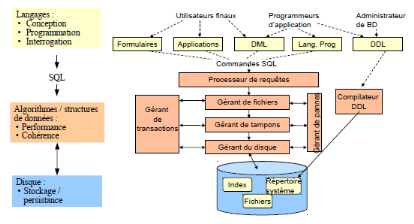

Figure 22 : Architecture d'un SGBD

Nous avons également trois types d'utilisateurs pour un

SGBD. Tout d'abord il y a l'utilisateur final (end user) qui accède

à la base de données par des formes d'écran, des formes

applicatives ou, pour les plus experts, des requêtes SQL5(*). Ensuite il y a le

développeur d'application qui va construire le schéma conceptuel,

définir/gérer le schéma logique et les vues et

concevoir/implémenter des applications qui accèdent à la

base de données. Le dernier type d'utilisateur d'un SGBD est

l'administrateur de base de données que l'on appelle DBA (DataBase

Administrator). Le DBA gère le schéma physique et règle

les performances, charge/organise la base de données (BDD) et

gère la sécurité et la fiabilité.

De nombreux SGBD existent sur le marché dans lesquels

on peut citer : Ingres, Oracle, Access, MySQL, PostgreSQL ou encore Progress.

III. Nous pouvons

être tous développeurs

1. Le logiciel

A. La génération

de code

Nous allons voir deux exemples de projet qui vont permettre de

générer du code via l'ingénierie dirigée par les

modèles. Pour rappel l'idée est de générer du code

à partir de modèles que nous allons au préalable

créer. Comme vu dans l'état de l'art, il y a deux langages de

modélisation: le MDA via l'UML et le DSML. Nous allons traiter un

exemple pour chacun, et voir que créer un programme peut être

à la portée de tous, et ce même dès aujourd'hui.

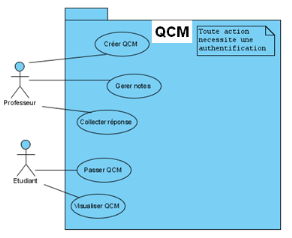

Exemple d'un projet avec UML

Nous allons traiter le cas d'une application que nous

appellerons "QCM".

QCM est une application de passages d'examens de type

"questions à choix multiples" en ligne et possède deux aspects

:

· Système côté enseignants

· Système côté étudiants

Ainsi, les professeurs peuvent, à partir de fichiers

XML ou en revisitant les anciens QCM, créer des QCMs pour évaluer

le niveau de leurs étudiants.

Les étudiants de leur côté, sont

prévenus par l'administration qu'un compte leur est affecté sur

le programme et leur fournis leur identifiant afin de procéder à

la validation de celui-ci.

Ces jeunes diplômants peuvent ainsi, lorsqu'ils entrent

dans la période de passage d'un QCM d'un des modules suivis, se

connecter au site et passer leur examen en ligne pendant un temps défini

par le créateur du QCM.

Une fois la date de passage du QCM arrivée à

échéance, les notes peuvent être récoltées

par le professeur et s'il le désire, envoyées aux

étudiants. Les étudiants peuvent, quant à eux, visualiser

les réponses aux QCMs qu'ils ont passé et savoir où ils

ont commis des erreurs.

Pour traiter ce sujet, nous avons les étapes classiques

d'un projet : recueil des besoins, modélisation, etc. Les modèles

vont nous permettre de générer du code. A la fin du projet nous

avons une synchro entre le code et les modèles, sous prétexte que

le code n'ait pas été modifié par un

développeur.

Dans un premier temps, dans un souci de communication nous

commençons par un diagramme de Use Case (ou cas d'utilisation), qui est

très parlant pour tout le monde.

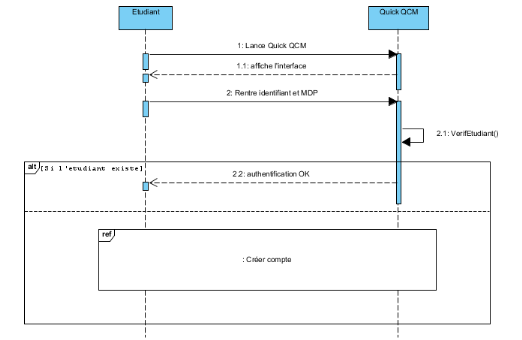

Figure 23 : Etape 1, le point de vue fonctionnel (Use

Case)

Dans notre cas, tout accès à QCM

nécessite une authentification. Il y a deux types d'authentification :

soit professeur, soit étudiant. Un professeur pourra créer un

QCM, gérer les notes et collecter des réponses. Un

étudiant pourra quant à lui passer un QCM et le consulter.

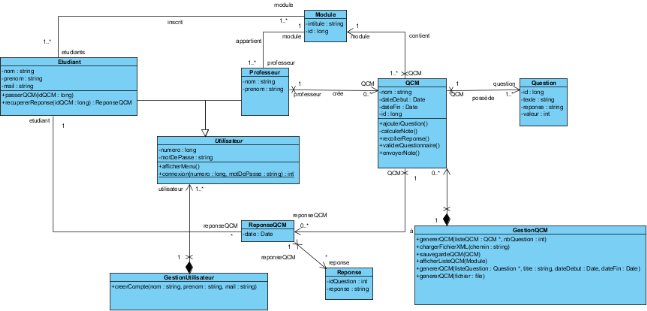

La deuxième étape consiste à passer au

point de vue structurel avec des diagrammes de classes. Cela va permettre de

présenter les classes et les interfaces du système ainsi que les

différentes relations entre celles-ci. Avec ceci nous avons des

"classes" et des "associations" au lieu de "widget", "menu", "champs". Il y

également une notation graphique sans aucun lien avec le domaine,

l'utilisateur manit ainsi des noms qui lui parlent, ce n'est pas du code

incompréhensible qu'il doit manipuler.

Figure 24 : Etape 2, diagramme de classe

Ensuite vient le point de vue comportemental via le diagramme

de séquences, qui permet à l'utilisateur d'avoir une

représentation graphique des interactions entre les acteurs et le

système selon un ordre chronologique.

Figure 25 : Etape 3, diagramme de

séquence

Par le biais de ces trois étapes, nous avons fait le

strict minimum niveau modélisation pour pouvoir générer du

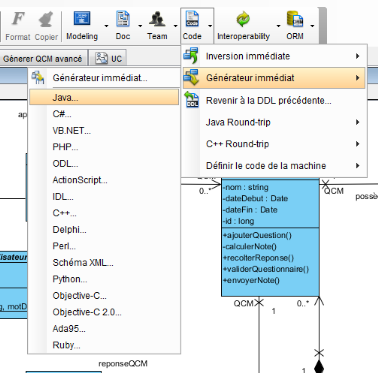

code. Cela se fait par un simple clic :

Figure 26 : Etape 4, générer du code via

la modélisation

Nous avons même plusieurs choix de langage concernant la

génération. Nous nous en tiendrons au Java. Vous pouvez voir un

exemple de génération de code en Annexe 3 concernant la partie

Utilisateurs de l'application. Seulement nous pouvons voir sur cette annexe,

qu'avec cette technique, le corps des méthodes reste vide. Pour cela, il

y a deux solutions : soit spécifier le corps des opérations avec

les activités et actions UML 2.0 soit associer des notes aux

opérations contenant le code des opérations.

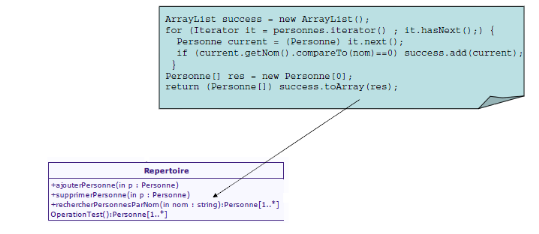

Figure 27 : Un exemple de notes.

L'association de notes nécessitent des connaissances en

programmation, nous ne l'expliquerons pas davantage.

L'idée, avec le diagramme d'activité c'est de

pouvoir en faire pour chaque opération du diagramme de séquence.

Ainsi chaque action du diagramme de séquence saura quand se

déclencher et quand s'arrêter. Le tout pourra être ainsi

interprété par le générateur de code et être

retranscrit.

Beaucoup d'outils UML permettent la génération

de code tels que :

· EclipseUML

· JDeveloper

· MagicDraw UML

· ModelSphere

· Objecteering

· PowerAMC

· QDesigner

· Visual Paradigm

· Visual UML

Ces outils permettent la création de langage de

modélisation et de suite outillée dans leur environnement

respectif (Eclipse par exemple). Ils permettent de créer des

modèles et des méta-modèles, générer des

bibliothèques permettant la manipulation de modèles. Tout ceci

grâce à des facilités dédiées

(transformation, éditeur graphique, vérificateur de contraintes,

...).

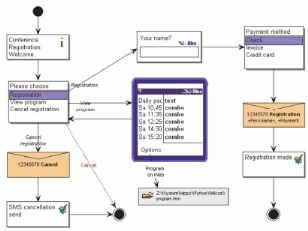

Exemple d'un projet avec DSML (Domain Specific Modeling

Language)

Dans le projet DSML nous allons ici traiter le cas d'une

application dans le domaine de la téléphonie mobile. Le projet

est de faire une application pour s'enregistrer à une conférence

depuis son téléphone portable.

Nous sommes ici dans un domaine

métier propre. Il est délimité, ce qui sous entend qu'on a

un grand besoin de productivité, d'où l'utilisation du DSML. Si

on doit faire une similitude avec UML, on peut dire que le DSML s'apparente

à un diagramme d'activité enrichi. Tout projet DSML commence par

un noeud initial, chaque étape est modélisée sous une

forme graphique compréhensible. Pour chacune d'elle il y a aussi la

possibilité de donner l'étape suivante en fonction du choix de

l'utilisateur. Pour mettre un terme à une suite d'instructions on met un

noeud final qui va marquer la fin de l'activité en cours.

Figure 28 : Exemple d'un projet avec un

DSML

Dans un projet avec DSML les modèles sont accessibles

et sont faits par des experts métier et pas forcément des

développeurs/analystes. En effet, c'est un langage avec peu de concepts,

tout est graphique et donc beaucoup plus compréhensible. Le niveau

d'abstraction est meilleur, donc il y a une utilisation de concepts propres au

domaine de modélisation.

Les générateurs de code intègrent

directement les librairies du Framework/plateforme d'exécution. Ainsi on

a 100% du code généré avec peu de maintenance à

faire car tout le savoir-faire est dans les générateurs.

L'utilisation de DSML a conduit à beaucoup de "success

stories" telles que :

· Nokia qui est de 300% à 1000% plus productif.

David Narraway, chef de projet chez Nokia "UML and other methods and

technologies say nothing about mobile phones. We are looking for more".

· US Air Force 300% plus productif

· Alcatel Lucent plus de 300% plus productif, et a

développé plusieurs DSMLs pour leurs clients.

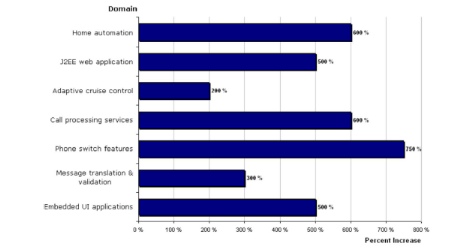

Figure 29 : Retombées économique, Source

MetaCase 2009

Nous avons avec les DSML un time-to-market plus court, un

feedback plus rapide avec les clients, une réduction des coûts (si

répétition + plusieurs variantes). Le nombre de participants au

projet devient potentiellement plus grand donc une réduction des

coûts de formation. David Narraway "Nokia case showed that the domain

knowledge contained in the modeling language produced faster learning curve for

new employees or transferred personnel. Before, a new developer becomes

productive after 6 months. 2 weeks with the DSML".

B. La génération

d'interfaces graphiques

Comme nous l'avons vu dans l'état de l'art il existe de

nombreux éditeurs graphiques se basant sur le drag and drop (glisser et

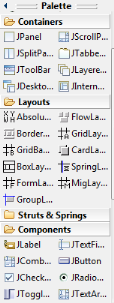

déposer). Le principe est très simple : nous avons à

disposition une palette qui liste l'ensemble des représentations

graphiques, on choisit l'élément que l'on veut mettre dans la

fenêtre de conception. Pour cela il suffit de sélectionner

l'élément, maintenir enfoncer la souris et le glisser dans la

partie conception. Ainsi nous avons un rendu visuel, et le code associé

généré automatiquement.

Figure 30 : La palette

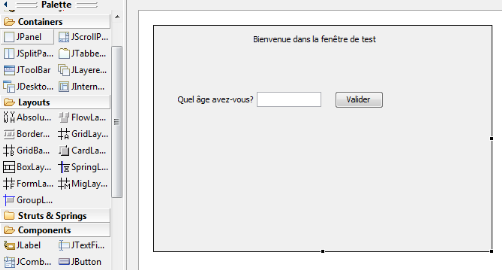

Pour montrer la simplicité de la manipulation, nous

allons créer une fenêtre de Test. Cette fenêtre demandera

notre âge, proposera un champ pour entrer notre réponse et un

bouton pour la valider.

Nous avons donc trois champs à mettre en place : la

question, le champ de réponse et le bouton de validation. La question

est matérialisée par un Label, le champ de réponse par un

TextFiel et le bouton de validation par un Button. Il suffit simplement de

choisir ces trois éléments et de les glisser sur la fenêtre

de conception.

Il est donc très accessible et très simple de

pouvoir créer une IHM pour un logiciel, sans avoir aucune connaissance

en programmation.

Figure 31 : Un exemple de conception en drag and

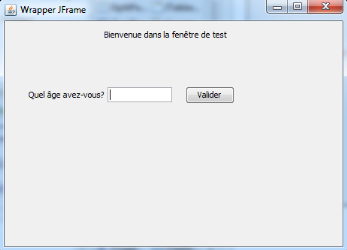

drop

Figure 32 : Résultat lorsque l'on

exécute le programme

2. Les sites web

Comme nous l'avons vu dans l'état de l'art, nous avons

plusieurs moyens de créer des sites web en n'ayant aucune connaissance

en programmation. Nous avons deux grands types de conception : par CMS pour

faire de la gestion de contenu ou par des éditeurs de sites qui vont

nous permettre de créer n'importe quel type de site. Nous avons

parlé également de sites e-commerce, de blogs, de wikis, etc. Je

n'en parlerai volontairement pas dans cette partie car les processus de

conception se rapprochent grandement de ce qui se fait soit pour les CMS soit

pour les éditeurs de sites.

A. Le CMS (Content Management

System, Système de Gestion de Contenu)

Le but d'un CMS est de proposer à l'utilisateur de

pouvoir modifier le contenant et le contenu d'un site Internet sans avoir de

connaissances techniques complexes (HTML, FTP, PHP, etc.). Un CMS va apporter

à l'utilisateur une autonomie, même s'il n'est pas

familiarisé avec la technique. Il va pouvoir également faire de

la maintenance et faire vivre son site.

Un CMS est composé de deux parties : le front office et

le back office.

Concernant la partie front office, le but est d'utiliser

simplement des styles centralisés (couleurs, polices, attributs, etc)

afin de pouvoir modifier à un seul endroit l'aspect

général de toutes les pages de l'application.

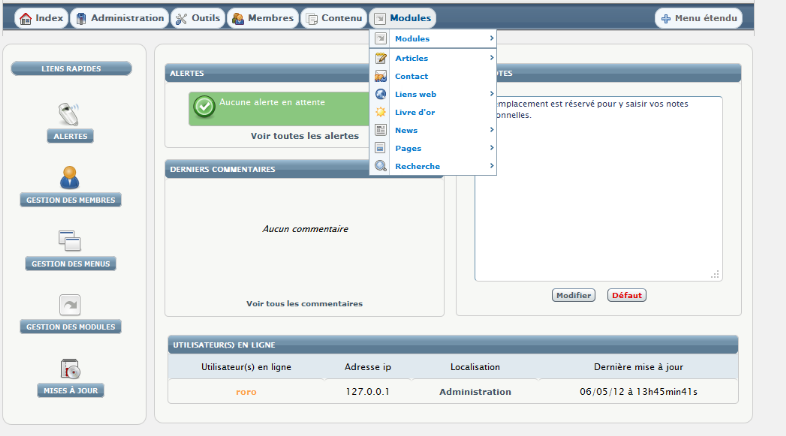

Figure 33 : Un exemple d'utilisation du

CMS

Concernant la partie back office (partie étant

réservée à l'utilisateur de manière

sécurisée), elle permet la modification ou la création

d'une page en saisissant son contenu et en affectant les styles aux

différents blocs de textes (paragraphes, mots...) qui composent la page.

Cette action se fait via un outil similaire à un traitement de texte, il

suffit donc de savoir écrire avec un clavier. Il faut simplement

enregistrer la manipulation et le changement apparait en ligne.

Figure 34 : La partie administration du

CMS

Le CMS est une solution qui permet de gérer de

manière autonome son site sans aucune connaissance en

développement web. Cependant certains CMS ne gèrent que des pages

statiques, il a donc fallu que les CMS intègrent des possibilités

de liberté, pour l'utilisateur, presque infinie tant sur le

côté contenu que contenant.

Pour avoir du contenu dynamique il faut donc une base de

données. Une base de données est le coeur de toute application

(internet ou pas).

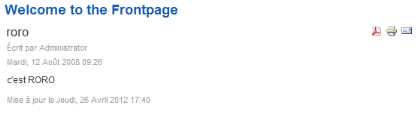

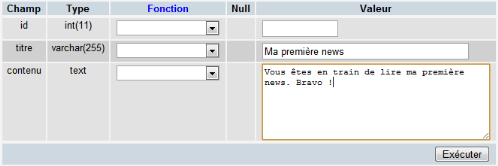

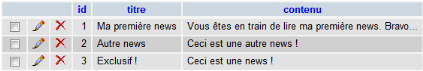

Figure 35 : Un exemple de ce qui est stocké

dans la base de données

Les CMS mettent à disposition de l'utilisateur des

pages d'édition permettant de gérer le contenu des tables de la

base de données en modification/création et suppression. La

saisie se fait directement dans l'interface du site.

Le véritable backoffice d'une application internet

consiste à mettre à disposition de l'administrateur, des pages

d'édition permettant de gérer le contenu de leurs bases de

données (tables) en modification, création, suppression, etc. Ce

qui est généralement proposé permet la saisie directement

dans l'interface du site.

Figure 36 : Saisie directement dans

l'interface

Concernant le contenant (configuration libre de l'affichage,

avec un gabarit dynamique, des styles dynamiques, des menus dynamiques), la

personnalisation va nous permettre d'affecter de nombreux

éléments comme le gabarit général des pages, les

styles de l'application, ainsi que les contenus latéraux, ou encore la

barre supérieure de liens vers les pages principales.

"Avec Joomla, il y une grande possibilité de

création où les articles sont faciles à mettre en pages.

Le petit plus de l'aide en ligne est vraiment appréciable pour une

débutante". Noémie VIANA, lors de la création d'un

site internet dans le cadre de ses études.

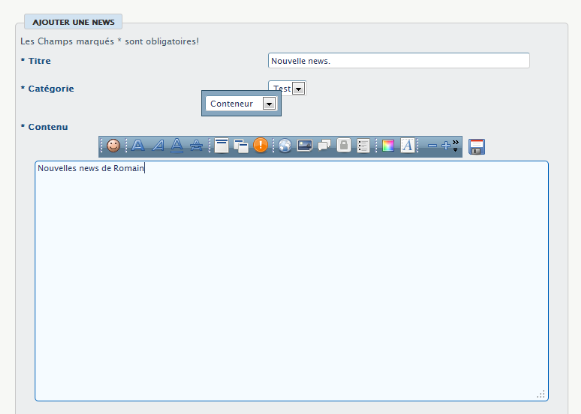

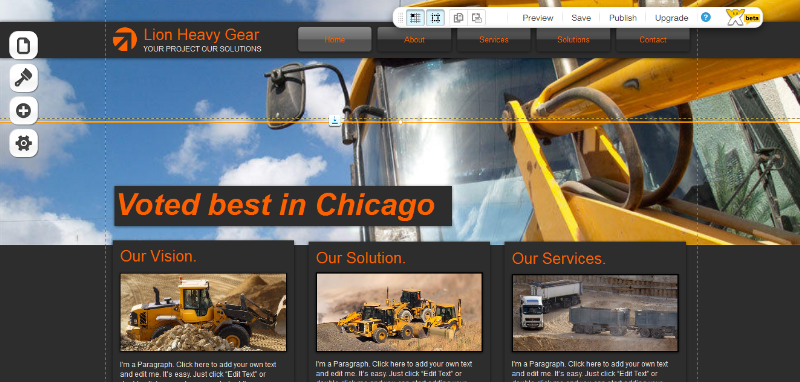

B. Les éditeurs de

sites

Beaucoup de solutions online, ou pas, existent sur le

marché qui permettent de réaliser des sites sans coder une seule

ligne de code. Le principe est très proche des CMS mais en beaucoup plus

intuitif. Parmi les sites on peut citer Wix,

Weebly,

Synthasite,

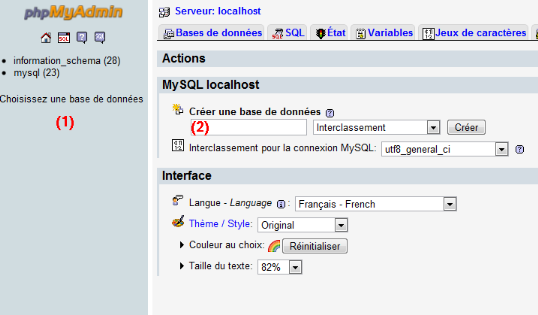

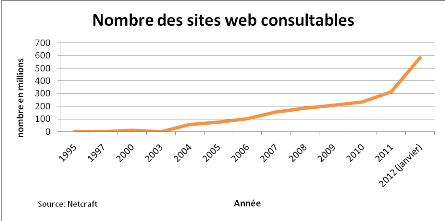

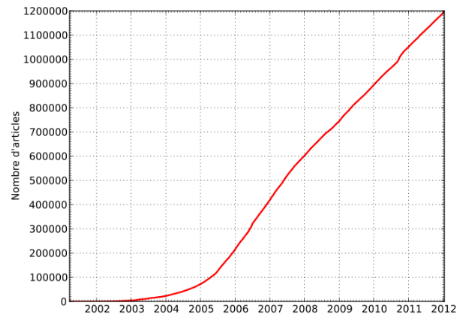

Google Sites,