|

INSTITUT DES HAUTES ÉTUDES ÉCONOMIQUES ET

COMMERCIALES

MÉMOIRE DE RECHERCHE APPLIQUÉE

PEUT-ON EVITER LES CRISES ?

MESURE DU RISQUE DE MARCHÉ ET THÉORIE DES VALEURS

EXTRÊMES :

UNE VISION QUANTITATIVE DU RISQUE EXTRÊME

APPLIQUÉE À LA CRISE DES SUBPRIMES

MASTER : FINANCE DE MARCHÉ [SMT]

AUTEUR : JEAN MEILHOC

TUTEUR : ARNAUD AUBRY, QUANTITATIVE FUND MANAGER

DATE : 2 JUIN 2012

RÉSUMÉ

Les récentes crises financières et

monétaires ont conduit le développement de nouveaux outils de

protection contre le risque de marché. Le théorème de la

limite centrale, qui décrit le comportement asymptotique de la moyenne

d'un grand nombre de variables indépendantes, ne semble plus

adéquat lorsque des événements rares ou extrêmes

deviennent normes, comme lors de la crise des Subprimes. A ce titre, la

Value-at-Risk, qui peut se définir comme le quantile déterminant

la plus grande perte que peut subir un portefeuille avec une probabilité

d'occurrence déterminé, permet de mesurer ce risque

extrême. La théorie des valeurs extrêmes (TVE),

étudiée dans le cadre de la recherche d'évènements

rares d'une suite de variables aléatoires indépendantes,

associée à la Value-at-Risk peut être un excellent

indicateur. Ce mémoire de recherche prend son essence dans la recherche

des valeurs extrêmes appliquées à la Value-at-Risk, afin

d'y élaborer un modèle de prévention du risque

cohérent.

MOTS-CLÉS : FINANCE QUANTITATIVE ;

MODÉLISATION MATHÉMATIQUE ; PROBABILITÉS ET

STATISTIQUES ; RISK MANAGEMENT ; THÉORIE DES VALEURS

EXTRÊMES ; VALUE-AT-RISK (VAR)

ABSTRACT

Financial crises have become a principal concern to lead the

development of new market risk indicators. The central limit theorem, which

describes the average asymptotic behavior of a random process, does not

characterize rare or extreme events, like subprime mortgage crises do.

Value at Risk (VaR) is defined by risk exposure at a given probability level at

a specified time horizon. Computing extreme value theory (EVT),

focusing on the tails of the sample distribution, is an excellent approach

for its use in managing risks. This research paper presents an application of

extreme value theory to compute to Value-at-Risk of a market position in order

to provide a consistent risk measurment.

KEY-WORDS : QUANTITATIVE FINANCE ; MATHEMATICAL

MODELING ; PROBABILITY AND STATISTICS ; RISK MANAGEMENT ;

EXTREME VALUE THEORY ; VALUE-AT-RISK (VAR)

Sommaire

Introduction

6

I. Section théorique

10

I.I. Modèle de fréquence des

rentabilités anormales

10

I.I.1 Taux de rentabilités normales et anormales

11

I.I.1.1 Processus d'évaluation

11

I.I.1.2 Procédure de test

12

I.I.2 Calcul des rentabilités anormales

12

I.I.2.1 Modèles théoriques

12

I.I.2.1.1 Modèle de moyenne

13

I.I.2.1.2 Modèle de marché

13

I.I.2.2 Évaluation des paramètres

14

I.I.3 Rentabilités anormales

16

I.I.4 Test de significativité

17

I.I.4.1 Moindres carrés ordinaires

17

I.I.4.2 Rentabilités anormales transversales et

cumulés

19

I.I.4.3 Méthode de Brown et Warner

19

I.I.4.4 Méthode de Pattel

20

I.I.4.5 Méthode de Bohemer, Musumeci et Poulsen

20

I.II. Mesure du risque

22

I.II.1 Mesure du risque gaussien

25

I.II.1.1 Distribution de gauss

25

I.II.1.2.1 Loi des grands nombres

25

I.II.1.2.2 Loi de Gauss

26

I.II.1.2 Value-at-Risk classique

27

I.II.2 Distribution des valeurs extrêmes

29

I.II.2 1 Études fondamentales

30

I.II.2.2 Lois des maxima : résultat exacts

31

I.II.3 Mesure du risque extrême

33

I.II.3.1 Théorème de Fisher-Tippet

33

I.II.3.1.1 Modélisation paramétrique des maxima par

blocs

36

I.II.3.1.2 Sélection de la taille des blocs

36

I.II.3.1.3 Estimation du modèle BM par le maximum de

vraisemblance

36

I.II.3.2 Théorème de Balkema-de Haan-Picklands

39

I.II.3.2.1 Modélisation paramétrique de la

distribution des excès

42

I.II.3.2.2 Estimation du modèle de seuil par le maximum de

vraisemblance

43

I.II.3.3 4 Value-at-Risk extreme

43

II. Section empirique

46

II.I Mesure des fréquences anormales

46

II.I.1 Processus

46

II.I.2 Taux de rentabilités normales et anormales

52

II.I.2.1 Fréquences normales

52

II.I.2.2 Fréquences anormales

53

II.I.3 Résultat des fréquences anormales

54

II.I.3.1 Rentabilités anormales stationnaires

54

II.I.3.2 Rentabilités anormales cumulées

55

II.I.4 Test de significativité

56

II.II. Théorie des valeurs extrêmes et

Value-at-Risk

58

II.II.1 Analogie statistique de la distribution des

rendements et maximum de vraisemblance

59

II.II.1.1 Analogie statistique de la distribution des rendements

60

II.II.1.1.1 Comportement limite de la loi exponentielle

60

II.II.1.1.2 Comportement limite de la loi de Pareto

62

II.II.1.1.3 Comportement limite de la loi normale

63

II.II.1.2 Maximum de vraisemblance

65

II.II.2 Modèle de sélection de maxima

66

II.II.2.1 Réalité erratique

66

II.II.2.2 Sélection de seuil

69

II.II.3 Value-at-Risk

71

II.II.3.1 Couverture conditionnelle

72

II.II.3.2 Modèle de rentabilité ajustée du

risque

75

Conclusion

78

Bibliographie

81

Annexes

85

A. Graphiques : Sélection de seuil

86

B. Stratégie : Synthèse

générale

87

C. Graphiques : VaR

91

D. Stratégie

92

E. Visual Basic Application : Loi de valeurs

extrêmes

94

F. Visual Basic Application : Loi de

probabilité

96

G. Origines macroéconomiques de la crise des

subprimes

100

REMERCIEMENT

Nous tenons à remercier sincèrement

Mr Aubry pour avoir accepté d'encadrer ce mémoire. Ses

orientations, ses conseils et ses contacts nous ont permis de mener à

bien cette recherche. Je remercie aussi tout particulièrement

Mr Assemat, directeur du pôle finance de marché, pour

avoir su transmettre sa passion et son esprit d'analyse. Enfin, nous souhaitons

remercier également Mr Rudelle, professeur d'économie

et Mr Viar, professeur de mathématiques, sans qui tout cela

n'aurait été possible.

INTRODUCTION

« [...] Les idées, justes ou

fausses, des philosophes de l'économie et de la politique ont plus

d'importance qu'on ne le pense en général. À vrai dire le

monde est presque exclusivement mené par elles. Les hommes d'action qui

se croient parfaitement affranchis des influences doctrinales sont d'ordinaire

les esclaves de quelque économiste passé. Les illuminés du

pouvoir qui se prétendent inspirés par des voies célestes

distillent en fait des utopies nées quelques années plus

tôt dans le cerveau de quelque écrivailleur de

Faculté. »

John Maynard Keynes

« Théorie générale de

l'emploi, de l'intérêt et de la monnaie »

Chapitre 24, 1936

Les récentes crises financières et

monétaires sont indubitablement une préoccupation majeure des

acteurs des marchés financiers, des banques, des pouvoirs politiques et

des instances de régulation. Les fluctuations extrêmes des cours

de bourse sont importantes pour l'activité économique

réelle. La hausse de la volatilité en temps de crise,

corrélée à la chute des marchés financiers est

particulièrement inquiétante. Nous pouvons donner à ce

titre l'exemple de la crise des Subprimes, qui a annoncé la chute de la

banque américaine Lehman-Brothers disparue le 15 septembre 2008. Ce

climat pousse les acteurs du marché, comme les régulateurs

bancaires, à développer de nouveaux outils de protection contre

le risque de marché. La finance moderne met en avant les

mathématiques du hasard et de la statistique, conceptualisées par

des lois mathématiques probabilistes capables de mesurer le risque de

marché. Celui-ci se matérialise par l'espérance de pertes

auxquelles les investisseurs sont impliqués. Les variations des

marchés financiers : marchés des instruments de base -

actions, obligations, devises, matières premières - mais aussi

les marchés des produits dérivés - contrats à

terme, options - sont par définition risquées et instables. Il

faut par conséquent déterminer ce risque de manière

précise pour mieux l'appréhender. Parmi ces outils, il existe

deux mesures générales : la mesure de sensibilité et

la mesure de variance.

La première peut être théorisée en

fonction de la sensibilité que représente un

produit financier par rapport à son indice de référence.

Ainsi, le risque de marché est la probabilité de perte

liée aux évolutions des marchés. Naïvement, si nous

possédons une action du Dow Jones Industrial Average et que l'ensemble

du marché subit une baisse, il semble naturel de considérer qu'il

va en être de même pour notre action. Cette première mesure

s'assimile à la sensibilité relative d'un actif détenu par

rapport aux facteurs de risque de marché. Ainsi, des modèles de

risque se sont développés comme le « Capital Asset

Pricing Model » (CAPM)1(*) pour le plus connu. Ils mesurent la variance de la

rentabilité implicite du marché par un coefficient de

régression à des facteurs de risque par rapport au marché

dans son ensemble. Cependant, le « risk manager »

a besoin d'une mesure pragmatique du risque d'exposition. En effet,

lorsqu' un nombre important d'instruments très différents compose

le portefeuille, il est difficile d'adjoindre l'ensemble des covariances

pouvant exister. C'est pour cette raison qu'il est décisif

d'appréhender le risque à partir de profils à la fois

différents et complémentaires : la dispersion des pertes et

profits des actifs.

La deuxième met en exergue deux mesures de risque

venant de la distribution des rentabilités des actifs : la

volatilité et la Value-at-Risk (VaR). Ces mesures ne se

concentrent pas sur les mêmes paramètres : La

volatilité mesure les variations d'un actif autour de la tendance

centrale. Cette mesure accorde le même poids aux gains

espérés qu'aux pertes potentielles. Or la notion de risque est

directement liée aux pertes émanant d'un actif détenu,

lequel implique un revenu aléatoire. Une mesure asymétrique

pouvant juger du risque de perte est nécessaire. La volatilité

prend donc en compte toutes les rentabilités, positives ou

négatives, extrêmes ou modéré. La Value-at-Risk peut

se définir comme le quantile déterminant la plus grande perte que

peut subir un portefeuille avec une probabilité d'occurrence et sur un

horizon de temps déterminé : C'est un indicateur pouvant

estimer le risque extrême. Ces deux indicateurs donnent une information

différente. D'une part, la volatilité peut enregistrer un taux

élevé et seulement capturer des risques moyens, certes

significatifs, mais pas extrêmes. Tout l'enjeu d'une mesure du risque

synthétique pertinente est d'estimer convenablement la perte

éventuelle que peut subir un actif. D'autre part, déterminer le

risque par la volatilité, moment2(*) d'ordre 2, présuppose que les moments suivants,

le skewness3(*) et le

kurtosis4(*), ne

nécessitent pas d'être ajoutés dans une mesure de risque

viable. La théorie sous- jacente en est la normalité des

rentabilités. La loi Normale est en effet caractérisée par

les deux premiers moments. La volatilité n'est assurément pas la

meilleure mesure de risque extrême. Utiliser la Value-at-Risk permet de

passer outre ces difficultés dans la mesure où le quantile de la

distribution ne représente pas un équilibre moyen mais prend en

compte les pertes extrêmes. Ce mémoire de recherche prend son

essence dans la recherche des valeurs extrêmes appliquées à

la Value-at-Risk, afin d'y élaborer une mesure de performance

ajustée du risque cohérente. La prévention des

évènements extrêmes est aujourd'hui en plein essor. Nous le

constatons régulièrement :

§ Dans l'étude du vent : à

près de 650 km de rayon, ayant atteint un maximum de 280 km/h,

l'ouragan5(*) Katrina fut le

plus puissant et le plus meurtrier des phénomènes naturels qu'ont

connu les Etats-Unis, prenant près de 1836 vies et causant plus de 108

milliards de dollars à la collectivité locale6(*).

§ Dans l'étude des plaques

tectoniques : le tremblement de terre Crustal, touchant Haïti le

12 janvier 2010, était d'une magnitude de 7.0 - 7.3. Il a causé

la perte de 230 000 vies, faisant 300 000 blessés7(*). 1.2 million d'hommes et de

femmes furent privés de ressources vitales.

§ Dans l'étude

séismologique : le séisme de la côte pacifique de

Töhoku, où le japon fut impliqué, le 11 mars 2011, dans

l'une des plus importantes catastrophes de son histoire : Le Tsunami de

Fukushima. Cet accident majeur a impacté les réacteurs d'une

centrale nucléaire laissant un important volume de rejet radioactif.

L'ensemble de ces évènements, dont

l'espérance mathématique d'en connaître la manifestation

est mince, est de nature extrême. Ils existent effectivement et doivent

être pris en compte.

Les statisticiens ont mis en place des mesures de

prévention de ces mouvements, utilisant la « théorie

des valeurs extrêmes ». Aujourd'hui les domaines d'applications

utilisant ces analyses sont nombreux. En hydrologie, par exemple, les

données excessives sont particulièrement utiles pour la

prévision des crues. Dans le domaine assuranciel, elles sont

utilisées dans l'évaluation des grands sinistres. En finance, les

marchés financiers connaissent eux aussi des mouvements erratiques

extrêmes liés à l'incertitude de l'environnement

macro-économique. Faire appel à la théorie des valeurs

extrêmes appliquées à la Value-at-Risk dans un tel climat

est un bon point d'appui quant à la recherche de la

vérité. Expérimenter ces analyses pendant la crise des

Subprimes est intéressant : un investisseur aurait-il pu

contrôler son risque en mesurant le risque de perte extrême ?

Ce mémoire met en évidence les méthodes

théoriques et empiriques d'évaluations des valeurs extrêmes

conditionnelles appliquées à la Value-at-Risk afin

d'émettre une stratégie performante ajustée du risque.

Celui-ci est divisé en deux sections :

Dans la première section, nous verrons l'aspect

théorique de la fréquence des rentabilités anormales sur

les 30 composantes du DJIA. Cette fréquence nous permettra

d'apprécier la vélocité et l'ampleur avec laquelle les

rendements d'un actif se meuvent d'un niveau de stabilité donné

vers un niveau supposé par la crise, transformant ainsi le discernement

qu'ont les investisseurs du risque d'un actif. Puis, nous étudierons la

mesure du risque appliquée à la VaR liée aux

théories des valeurs extrêmes.

Dans la deuxième section, à travers la partie

empirique, nous pourrons nous intéresser à leurs applications sur

le DJIA en période de crise des Subprimes.

I. SECTION THÉORIQUE

« Imaginez une règle tenue verticalement sur

votre doigt : cette position très instable devrait conduire à sa

chute, au moindre mouvement de la main ou en raison d'un très

léger courant d'air. La chute est liée fondamentalement au

caractère instable de la position ; la cause immédiate de la

chute est, elle, secondaire »

Didier Sornette, 2002

I.I. MODÈLE DE

FRÉQUENCE DES RENTABILITÉS ANORMALES

Les aspects macroéconomiques montrent de façon

indubitable les conséquences d'une crise, particulièrement celle

des Subprimes, qui fut, pour les observateurs les plus avertis, aussi

importants que celle qui a vu le jour du jeudi noir de 19298(*). Cependant, lorsqu'on se situe

sur un marché financier, dans notre exemple le Dow Jones Industrial

Average (DJIA), comment considérer l'impact qu'a eu cette crise sur les

actifs le composant ? Évaluer la hausse de la volatilité,

sur un intervalle de temps représentant la crise, afin d'y extraire des

rentabilités anormales, peut être un bon point d'appui. Mais

comment pouvons-nous juger de ce que peut représenter le niveau de la

volatilité dite normale à titre de comparaison ?

La technique de l' « étude

d'événement », initié par E. Fama9(*), a précisément

pour objectif d'apprécier la précipitation et la profusion avec

laquelle un actif se déplace, transformant ainsi le discernement qu'ont

les investisseurs du risque d'un actif.

Nous allons pour ce faire nous focaliser sur la recherche des

rentabilités anormales, puis juger de leur significativité

à travers des tests statistiques.

I.I.1 TAUX DE RENTABILITÉS

NORMALES ET ANORMALES

Les crises financières et monétaires

occasionnent donc des mouvements particuliers sur le cours d'un titre.

L'approche utilisée pour isoler ceux-ci des fluctuations liées

à l'influence de facteurs exogènes à la crise des

Subprimes repose ainsi sur le calcul de rentabilités anormales. Par

définition, ces taux de rentabilités sont obtenus par

différence entre les rentabilités observées,

influencées par l'incertitude qui règne sur les marchés en

période de crise, et les rentabilités dites normales,

données par l'absence de perturbations majeures.

Les rentabilités anormales sont nécessairement

calculées en fonction d'un modèle de calcul. A ce titre, nous

avons choisi d'en présenter deux dans notre étude :

§ Le modèle de moyenne

§ Le modèle de marché.

I.I.1.1 PROCESSUS

D'ÉVALUATION

Les variables du modèle permettant le calcul des

rentabilités anormales font l'objet d'une évaluation

préalable. Cette estimation doit être conduite sur une

période de temps antérieure dans laquelle il n'y eu aucune

représentation de crise ou d'évènements extraordinaires

capables de biaiser l'étude10(*).

I.I.1.2 PROCÉDURE DE

TEST

C'est lorsque nous avons calculé les

rentabilités anormales que nous pouvons juger de la robustesse de

ceux-ci.

§ Une première étape consiste à

calculer la somme des taux de rentabilités anormaux obtenue à

partir des différents titres de l'échantillon.

§ Une deuxième étape sera également

réalisée pour calculer les rentabilités anormales

cumulées (RAC) des titres pendant la crise. Cette information nous

permet de connaître la véritable intensité d'un

évènement par rapport à ses fluctuations

exogènes.

§ Une troisième étape montre

statistiquement comment, à un seuil de risque octroyé, la crise

des subprime agit sur le cours.

I.I.2 CALCUL DES

RENTABILITÉS ANORMALES

I.I.2.1 MODÈLES

THÉORIQUES

Dans ce mémoire de recherche, nous allons analyser deux

méthodes couramment utilisées dans la littérature

financière. Ces méthodes repèrent de façon

efficiente la présence de trajectoire de cours anormaux. Selon Stephen

J. Brown et Jerold B. Warner11(*), il s'agit du :

§ Modèle de moyenne (constant mean return model,

« CMRM »)

§ Modèle de marché (market modele,

« MM »)

I.I.2.1.1 Modèle de

moyenne

Attachée à l'évaluation du modèle

de moyenne, l'évolution des taux de rentabilité de l'action

i est formulée par :

Où   indique le

taux de rentabilité de l'action i à la période

t, indique le

taux de rentabilité de l'action i à la période

t,   , le taux de rentabilité moyen de l'action i, est , le taux de rentabilité moyen de l'action i, est   l'innovation en date t, hypothétiquement homoscédastique

l'innovation en date t, hypothétiquement homoscédastique

et

d'espérance nulle. Un modèle ARCH - GARCH12(*) peut également

être étudié afin d'estimer une variance non constante dans

le temps. et

d'espérance nulle. Un modèle ARCH - GARCH12(*) peut également

être étudié afin d'estimer une variance non constante dans

le temps.

I.I.2.1.2 Modèle de

marché

Le modèle de marché fut initié par

Sharpe13(*) en 1963. Ce

modèle postule pour une relation linéaire entre le taux de

rentabilité   d'un actif

et le taux de rentabilité d'un actif

et le taux de rentabilité   de l'indice

de référence, mesuré à partir de l'action

i. Ce modèle s'inscrit donc dans le cadre d'une mesure de

sensibilité du titre étudié. Expressément, nous

avons : de l'indice

de référence, mesuré à partir de l'action

i. Ce modèle s'inscrit donc dans le cadre d'une mesure de

sensibilité du titre étudié. Expressément, nous

avons :

Où   et et   sont les

deux éléments du modèle de marché, et sont les

deux éléments du modèle de marché, et   et une

perturbation homoscédastique et une

perturbation homoscédastique   d'espérance nulle. Comme pour le modèle de moyenne, la variance

peut être calculée selon des critères

hétéroscédastique avec ARCH - GARCH.

d'espérance nulle. Comme pour le modèle de moyenne, la variance

peut être calculée selon des critères

hétéroscédastique avec ARCH - GARCH.

I.I.2.2 ÉVALUATION DES

PARAMÈTRES

En ce qui concerne le modèle de moyenne, nous devons

calculer un simple paramètre donné par la rentabilité

moyenne   de l'action i sur N, la période pour laquelle

nous tirons nos taux de rentabilités normales. Le modèle de

marché quant à lui requière l'intervention de deux

paramètres distincts, à savoir de l'action i sur N, la période pour laquelle

nous tirons nos taux de rentabilités normales. Le modèle de

marché quant à lui requière l'intervention de deux

paramètres distincts, à savoir   et et   de

i sur les mêmes périodes. de

i sur les mêmes périodes.

Pour ce faire, nous pouvons estimer l'ensemble des

paramètres liés à chaque modèle à l'aide

d'une représentation matricielle de la période N. A ce

titre, nous pouvons consulter les études de John Y. Campbell, Andrew W.

Lo et Craig MacKinlay, publiées en 199714(*).

Deux composantes sont à calculer. Soit

Ri, le vecteur composer des N taux de

rentabilité et Xi :

§ Un vecteur de N lignes égales à

1 pour le modèle de moyenne

§ Une matrice à deux colonnes et N lignes

dans le cas du modèle de marché dans laquelle les lignes de la

première colonne sont égales à 1 et celles de la

deuxième colonne prennent pour valeur le taux de rentabilité du

marché en N.

§ Enfin, nous avons un vecteur   de

paramètre agrégé au modèle utilisé, soit de

paramètre agrégé au modèle utilisé, soit

pour le

modèle de moyenne, soit pour le

modèle de moyenne, soit   pour le

modèle de marché. pour le

modèle de marché.

Cette représentation donne formellement

l'équation suivante :

Pour chaque modèle, l'appréciation des

paramètres peut aussi s'effectuer par le calcul des moindres

carrés ordinaires (MCO). On peut observer à présent

l'expression des différents estimateurs comme suit:

Où k désigne le nombre de

paramètres du modèle utilisé.

§ k = 1 pour le modèle de moyenne

§ k = 2 pour le modèle de

marché

I.I.3 RENTABILITÉS

ANORMALES

Énoncées précédemment, les

rentabilités anormales sont obtenues par différence entre les

rentabilités étudiées en Ai et les

rentabilités dévoilées par le modèle en

Ni. Estimé à partir d'une reproduction

matricielle des données, le vecteur  des

A rentabilités anormales estimées est décrite par

la relation : des

A rentabilités anormales estimées est décrite par

la relation :

Dans lequel   et et   sont les

corollaires de sont les

corollaires de   et et   respectivement. Le vecteur des taux anormaux sur Ai

peut s'analyser de telle sorte qu'il existe une

« erreur » commise dans la prévision de la

rentabilité du titre i. Mathématiquement, cette

« perturbation » réelle s'exprime

comme : respectivement. Le vecteur des taux anormaux sur Ai

peut s'analyser de telle sorte qu'il existe une

« erreur » commise dans la prévision de la

rentabilité du titre i. Mathématiquement, cette

« perturbation » réelle s'exprime

comme :

L'espérance mathématique des taux de

rentabilités anormales, liés aux valeurs   ,

elles-mêmes tirées des variables explicatives sur la

période de crise, est donnée par : ,

elles-mêmes tirées des variables explicatives sur la

période de crise, est donnée par :

Avec   ,

calculé précédemment, l'équation donnée par ,

calculé précédemment, l'équation donnée par

. Celle-ci

montre une espérance nulle dans la mesure où la perturbation est

supposée indépendante et identiquement identifiée sur

Ni et Ai. . Celle-ci

montre une espérance nulle dans la mesure où la perturbation est

supposée indépendante et identiquement identifiée sur

Ni et Ai.

I.I.4 TEST DE

SIGNIFICATIVITÉ

Comment pouvons-nous juger de la significativité des

tests réalisés selon les modèles théoriques

réalisés précédemment? Plusieurs étapes

peuvent être mise en oeuvre pour en tirer une hypothèse viable.

Afin de montrer la véracité du raisonnement utilisé dans

cette étude, nous allons dans un premier temps étudier, en

passant par la technique des moindres carrés ordinaires, un actif

considéré indépendamment avant d'initier une analyse sur

données associées.

I.I.4.1 MOINDRES CARRÉS

ORDINAIRES

Dans la littérature économétrique, une

rentabilité anormale est assimilable à un point aberrant par

rapport à une suite de variables iid. Dans notre étude, nous

usons des hypothèses classiques dans laquelle les moindres carrés

ordinaires sont donnés par le vecteur des espérances des

Ai lignes et de la matrice de variances-covariances des

Ai lignes et des Ai colonnes de cette

erreur. Nous avons :

Où I montre formellement la matrice identifiée

par les Ai lignes et des Ai colonnes.

Parce qu'il prend en compte un élément additionnel lié

à l'étude de l'indice de référence, les indicateurs

de la

diagonal Vi dans le modèle de marché prend

l'expression suivante : de la

diagonal Vi dans le modèle de marché prend

l'expression suivante :

Où

m se rapporte au taux de rentabilité moyen de l'indice

de référence sur Ni. Nous le verrons dans la

sous-section suivante lorsque Pattel dans son ouvrage publié en 1976 et

Boehmer dans sa publication de 1991, utilisent cette expression dans leurs

tests statistiques. En outre, cette formule permet de dissocier la hausse de la

volatilité, exprimée par l'écart-type des fluctuations des

cours, et la perturbation liée aux rentabilités anormales.

Logiquement, l'accroissement de la variance est une fonction

décroissante du nombre d'observations N utilisé pour

estimer les valeurs des paramètres. Cela a pour effet de lisser la

volatilité de l'étude des rentabilités normales. C'est

pour cette raison qu'il est justifié d'utiliser un laps de temps

N équilibré entre stabilité et précision.

L'augmentation sera d'autant plus forte que les conditions de marché

dans lesquelles sont calculées les rentabilités anormales

s'écartent de celles qui avaient cours lors de la phase d'estimation des

paramètres. Dans les faits, la valeur de m se rapporte au taux de rentabilité moyen de l'indice

de référence sur Ni. Nous le verrons dans la

sous-section suivante lorsque Pattel dans son ouvrage publié en 1976 et

Boehmer dans sa publication de 1991, utilisent cette expression dans leurs

tests statistiques. En outre, cette formule permet de dissocier la hausse de la

volatilité, exprimée par l'écart-type des fluctuations des

cours, et la perturbation liée aux rentabilités anormales.

Logiquement, l'accroissement de la variance est une fonction

décroissante du nombre d'observations N utilisé pour

estimer les valeurs des paramètres. Cela a pour effet de lisser la

volatilité de l'étude des rentabilités normales. C'est

pour cette raison qu'il est justifié d'utiliser un laps de temps

N équilibré entre stabilité et précision.

L'augmentation sera d'autant plus forte que les conditions de marché

dans lesquelles sont calculées les rentabilités anormales

s'écartent de celles qui avaient cours lors de la phase d'estimation des

paramètres. Dans les faits, la valeur de   est

inconnue. Nous utiliserons alors l'estimateur sans biais noté est

inconnue. Nous utiliserons alors l'estimateur sans biais noté   . Pour ce

faire, nous serons amenés à utiliser l'estimateur . Pour ce

faire, nous serons amenés à utiliser l'estimateur   de la

matrice de variances-covariances des taux anormaux dont la formule est

donnée par15(*) : de la

matrice de variances-covariances des taux anormaux dont la formule est

donnée par15(*) :

Exprimé par la quantité, calculé

avec :

I.I.4.2 RENTABILITÉS

ANORMALES TRANSVERSALES ET CUMULÉS

L'analyse des rentabilités anormales transversale

permet de juger de la signification d'un échantillon donné

à une période   . Une

quantité importante de travaux de recherche a été

réalisée en fonction du comportement des rentabilités

sélectionnées. Parce que nous travaillons sur les queues de

distribution, ces statistiques vont avoir pour propriétés

d'être asymptotiquement normales, d'espérance nulle et de variance

égale à 1. La convergence vers la normalité étant

vérifiée dès lors que le nombre de données est

important (Brown et Warner) ou que le nombre d'actifs étudié soit

supérieure ou égale à 30 (Pattel, Boehmer et al.). Les

rentabilités anormales cumulées (RAC) permettent de juger de

l'effet de la crise sur les différents actifs que peut détenir un

actionnaire. C'est la représentation de l'amplitude des

rentabilités anormales d'un échantillon sur une période

donnée. . Une

quantité importante de travaux de recherche a été

réalisée en fonction du comportement des rentabilités

sélectionnées. Parce que nous travaillons sur les queues de

distribution, ces statistiques vont avoir pour propriétés

d'être asymptotiquement normales, d'espérance nulle et de variance

égale à 1. La convergence vers la normalité étant

vérifiée dès lors que le nombre de données est

important (Brown et Warner) ou que le nombre d'actifs étudié soit

supérieure ou égale à 30 (Pattel, Boehmer et al.). Les

rentabilités anormales cumulées (RAC) permettent de juger de

l'effet de la crise sur les différents actifs que peut détenir un

actionnaire. C'est la représentation de l'amplitude des

rentabilités anormales d'un échantillon sur une période

donnée.

I.I.4.3 MÉTHODE DE BROWN ET

WARNER

La méthode de Brown et Warner, notée , est la

plus couramment utilisée dans l'industrie financière. Cette

statistique s'exprime : , est la

plus couramment utilisée dans l'industrie financière. Cette

statistique s'exprime :

Nous avons donc les rentabilités anormales

équipondérées de l'ensemble des titres sur la

volatilité que peuvent générer celles-ci. C'est donc la

rentabilité Ai obtenue divisée par le risque

que celle-ci génère par ses variations erratiques en

période de crise. Il est à noter que cette statistique implique

une constance de la volatilité dans le temps. Nous pouvons aussi

remarquer que cette hypothèse n'est plus vérifiée en phase

de « partitionnement des données » ou

« Clustering » dans lequel deux ou plusieurs

titres réagissent, sur un intervalle de temps i, à un

évènement lambda. Cette corrélation est exprimée

à travers de nombreux exemples sur les marchés financiers.

I.I.4.4 MÉTHODE DE

PATTEL

La méthode de Pattel peut se conceptualiser en deux

parties. Les rentabilités anormales appartenant à la

période de crise sont pris un à un afin d'être

calculées par l'écart-type (soit le risque) de l'erreur

d'estimation. Cet écart-type correspond au   élément de la diagonale de la matrice

élément de la diagonale de la matrice   ,

donné par l'expression ,

donné par l'expression , vu

précédemment. Pour la méthode de Pattel, nous avons la

formule de la rentabilité anormale standardisée, telle

que : , vu

précédemment. Pour la méthode de Pattel, nous avons la

formule de la rentabilité anormale standardisée, telle

que :

Le poids que peut donner un titre à forte

volatilité historique dans le portefeuille est diminué. La

statistique de Pattel prend la forme de :

I.I.4.5 MÉTHODE DE BOHEMER,

MUSUMECI ET POULSEN

Faisant foi d'une robustesse plus importante lorsque la

variance augmente, cette statistique cherche à valider ou non

l'hypothèse selon laquelle A tend vers 0 pendant la

période d'échantillonnage. La méthode de Bohemer, Musimeci

et Poulsen s'exprime dès lors comme :

L'incertitude est au coeur de la logique financière. Le

profil de risque que les investisseurs prennent à travers leurs

positions est par conséquent déterminant. Le test des

rentabilités anormales prend en compte deux paramètres :

l'espérance mathématique et l'écart-type. Lorsque les

marchés sont en équilibre, il est alors possible d'envisager une

relation entre la rentabilité attendue et son risque intrinsèque,

déterminé à partir de l'écart qu'il peut exister

entre la rentabilité moyenne historique amenée par cette

dernière. Le test des fréquences anormales sur un temps long a

donc pour objet de connaître l'ampleur, mais aussi la durée, que

peut amener de telles rentabilités en période d'incertitude. Nous

pouvons désormais reconnaître, de façon plus rigoureuse,

l'état de crise, la quantifier, peut-être la comparer.

Cette introduction nous amène à penser qu'il est

nécessaire d'établir une solide gestion de mesure des risques.

I.II. MESURE DU RISQUE

« Les influences qui déterminent les

mouvements de la Bourse sont innombrables, des événements

passés, actuels ou même escomptables, ne présentant souvent

aucun rapport apparent avec ses variations, se répercutent sur son

cours. [...] Mais il est possible d'étudier mathématiquement

l'état statique du marché à un instant donné,

c'est-à-dire d'établir la loi de probabilité des

variations de cours qu'admet à cet instant le marché. Si le

marché, en effet, ne prévoit pas les mouvements, il les

considère comme étant plus ou moins probables, et cette

probabilité peut s'évaluer

mathématiquement »

Louis bachelier

« Théorie de la

spéculation ».

Annales scientifiques de l'E.N.S.

3ème série, tome 17 (1900), p

21-86

La finance moderne met en avant les statistiques. Ceux-ci

rationalisent le mouvement de prix des marchés financiers. Le risque en

est par conséquent mesurable et gérable. Les travaux en ce

domaine ont débuté selon la connaissance générale

en 1900, quand un jeune mathématicien, Louis Bachelier, eut la

curiosité d'étudier la fluctuation des cours des marchés

financiers dans sa thèse : « Théorie de

la spéculation ». Inspiré par Pascal et Fermat,

qui avait initié le concept de probabilité, L. Bachelier

étudia dans sa thèse les bons du trésor français.

Considéré comme le précurseur de la théorie moderne

du portefeuille et des mathématiques financières, L. Bachelier

met en avant un concept nouveau : les prix montent et descendent avec des

probabilités égales. Pour ainsi dire, si le nombre de

données augmente à un rythme élevé, les

échanges boursiers se fondent en un bruit stationnaire. Le risque de

marché matérialise l'espérance de pertes auxquelles les

investisseurs sont impliqués. Pour le gérer, il faut donc

l'évaluer de manière précise. A ce titre, parmi ces

outils, existe :

§ Les mesures de sensibilité

§ Les mesures de variance

Une première mesure du risque est en fonction de la

sensibilité que représente un actif par rapport

à son indice de référence. Cette première mesure

s'assimile à la sensibilité relative d'un actif détenu par

rapport aux facteurs de risque de marché. Elle mesure la variance de la

rentabilité implicite du marché par un coefficient de

régression à des facteurs de risque, tel le marché dans

son ensemble. Formellement, nous avons :

Où  est le taux

de rentabilité de l'action et est le taux

de rentabilité de l'action et  , celui du

marché16(*).

Cependant, le « risk manager » a besoin d'une

mesure pragmatique du risque d'exposition. En effet, lorsqu'un nombre important

d'instruments très différents compose le portefeuille, il est

difficile d'imbriquer de façon cohérente l'ensemble des

covariances pouvant exister. C'est pour cette raison qu'il est décisif

de capturer le risque à partir de profils différents : La

dispersion des pertes et profits des actifs. , celui du

marché16(*).

Cependant, le « risk manager » a besoin d'une

mesure pragmatique du risque d'exposition. En effet, lorsqu'un nombre important

d'instruments très différents compose le portefeuille, il est

difficile d'imbriquer de façon cohérente l'ensemble des

covariances pouvant exister. C'est pour cette raison qu'il est décisif

de capturer le risque à partir de profils différents : La

dispersion des pertes et profits des actifs.

Nous pouvons mettre en exergue deux mesures de risque venant

de la distribution des rentabilités des actifs : la volatilité et

la Value-at-Risk (VaR). Ces mesures ne se concentrent pas sur

les mêmes paramètres :

§ La volatilité mesure les variations d'un actif

autour de la tendance centrale. En effet son expression en fonction du vecteur

des taux de rentabilités R est17(*) :

Cette mesure accorde le même poids aux gains

espérés qu'aux pertes potentielles. Or la notion de risque est

directement liée aux pertes émanant d'un actif détenu,

lequel implique un revenu aléatoire. Une mesure asymétrique

pouvant juger du risque de perte est nécessaire. La volatilité

prend donc en compte toutes les rentabilités, positives ou non,

extrêmes ou non.

§ la Value-at-Risk peut se définir comme le

quantile déterminant la plus grande perte que peut subir un portefeuille

avec une probabilité d'occurrence donné sur un horizon

déterminé à l'avance : nous sommes en présence

d'un indicateur pouvant estimer le risque extrême.

Ces deux indicateurs donnent une information

différente. D'une part, la volatilité peut enregistrer un taux

élevé et seulement capturer des risques moyens, certes

significatifs, mais pas extrêmes. Tout l'enjeu d'une mesure du risque

synthétique pertinente est d'estimer convenablement la perte

éventuelle que peut subir un actif. Or un titre

« a » peut avoir une volatilité de 10% mais

ne pas observer d'extremum très important, avec un maximum de 5% de

perte sur une journée par exemple. Au contraire, un actif

« b » comptant une volatilité de 5%, peut

connaître des pertes, certes rares, de plus de 20%. Le titre

« b » nous semble donc plus risqué,

même si ses risques « moyens »

s'avèrent être moins importants que ceux du premier. D'autre part,

déterminer le risque par le moment18(*) d'ordre 2, la volatilité, présuppose

que les moments suivants, le skewness19(*) et le kurtosis20(*), ne nécessitent pas d'être

ajoutés dans une mesure de risque viable. La théorie sous-

jacente en est la normalité des rentabilités. La loi Normale est

en effet caractérisée par les deux premiers moments. Utiliser la

Value-at-Risk permet de passer outre ces difficultés dans le sens

où le quantile de la distribution ne représente pas un

équilibre moyen mais prend en compte les pertes extrêmes. En

outre, nous pouvons souligner le fait que la volatilité n'est

assurément pas la meilleure mesure de risque extrême. Nous allons

dans cette partie étudier plus en détail cette mesure de risque

en utilisant la théorie des valeurs extrêmes.

I.II.1 MESURE DU RISQUE

GAUSSIEN

I.II.1.1 DISTRIBUTION DE GAUSS

I.II.1.2.1 Loi des grands

nombres

D'un point de vue théorique, une variable continue

prend une infinité de valeurs à l'intérieur de son

intervalle de définition. La loi des grands nombres compte pour ce faire

un échantillon assez important de variables aléatoires. En ce

sens, la théorie des grands nombres est simple : Si la taille de

l'échantillon est assez importante, la moyenne empirique de la variable

étudiée tend vers celle théorique de somme unitaire. Par

conséquent, considérons un échantillon d'observation  d'une

variable aléatoire d'une

variable aléatoire ,

d'espérance ,

d'espérance  et

d'écart-type et

d'écart-type  finis.

Dès lors, la loi des grands nombres énonce que, quand finis.

Dès lors, la loi des grands nombres énonce que, quand  , la

moyenne empirique , la

moyenne empirique  converge

en direction de converge

en direction de  . Nous

avons alors : . Nous

avons alors :  . La loi

des grands nombres est une loi asymptotique qui assure ainsi que la moyenne

empirique est un estimateur convergent de l'espérance

mathématique. . La loi

des grands nombres est une loi asymptotique qui assure ainsi que la moyenne

empirique est un estimateur convergent de l'espérance

mathématique.

I.II.1.2.2 Loi de Gauss

La loi normale fait partie de la famille des lois

continues21(*). Elle est

associée aux noms de Carl Friedrich Gauss et de Pierre Simon Laplace.

Appelé, le théorème central limite, celui-ci indique que

la somme des variables est distribuée de façon aléatoire

et indépendante lorsque le nombre de données dans la somme

augmente. Cette loi est définie par la moyenne , et la

variance , et la

variance  parce qu'elle est symétrique par rapport à la tendance

centrale. Nous exprimons la fonction de densité de probabilité de

la loi normale avec parce qu'elle est symétrique par rapport à la tendance

centrale. Nous exprimons la fonction de densité de probabilité de

la loi normale avec  comme : comme :

La loi normale a une tendance centrale nulle et un

écart type égale à 1. Nous avons donc par définition égale à 1. Nous avons donc par définition .

Puisque .

Puisque , pour toute variable centrée et réduite, la

médiane, la moyenne et le mode sont confondus. Pour exprimer la

continuité de ce théorème, nous pouvons écrire la

fonction de distribution cumulée pour , pour toute variable centrée et réduite, la

médiane, la moyenne et le mode sont confondus. Pour exprimer la

continuité de ce théorème, nous pouvons écrire la

fonction de distribution cumulée pour  : :

Si les différents écarts-types pris un à

un sont dérisoires par rapport à l'ensemble, le

théorème de la limite centrale reste valide. La distribution

gaussienne d'écart-type proportionnel à  représente la différence entre le moyenne empirique

représente la différence entre le moyenne empirique  de

l'échantillon et l'espérance de

l'échantillon et l'espérance  de la

variable aléatoire de la

variable aléatoire .

L'approximation de la moyenne théorique .

L'approximation de la moyenne théorique  par la

moyenne empirique par la

moyenne empirique  permet de

contrôler l'erreur énoncée précédemment. La

probabilité que permet de

contrôler l'erreur énoncée précédemment. La

probabilité que  soit dans

l'intervalle soit dans

l'intervalle  se retrouve représentée par l'aire sous la courbe

comprise entre les abscisses se retrouve représentée par l'aire sous la courbe

comprise entre les abscisses  et et  . Sur les

marchés financiers, la plupart des mouvements sont inférieurs

à une fois l'écart-type. Cette mesure représente 68% des

amplitudes à la hausse comme à la baisse. 95% doivent être

à moins de deux écarts-types et 98% à moins de trois

écarts-types. Selon cette loi de probabilité, il existe

très peu de grands mouvements. . Sur les

marchés financiers, la plupart des mouvements sont inférieurs

à une fois l'écart-type. Cette mesure représente 68% des

amplitudes à la hausse comme à la baisse. 95% doivent être

à moins de deux écarts-types et 98% à moins de trois

écarts-types. Selon cette loi de probabilité, il existe

très peu de grands mouvements.

La thèse de L. Bachelier fut largement ignorée

par ses contemporains. Cependant, ses travaux furent traduits,

réédités, puis développés pour aboutir au

grand édifice de l'économie et de la finance moderne22(*).

I.II.1.2 VALUE-AT-RISK

CLASSIQUE

La Value at Risk est une mesure de risque statistique

popularisée dans les années 1990 par JP Morgan. La Value-at-Risk

peut se définir par la perte maximale que peut engranger un portefeuille

sur un laps de temps et un niveau de confiance donnée.

« The greatest benefit of Value-at-Risk lies in the imposition of

a structured methodology for critically thinking about risk. Institutions that

go through the process of computing their VAR are forced to confront their

exposure to financial risks and to set up a proper risk management function.

Thus the process of getting to Value-at-Risk may be as important as the number

itself » souligne P. Jorion dans son ouvrage :

« Value at Risk: The New Benchmark for Controlling Market

Risks », paru en 1996. P. Jorion23(*) nous enseigne que la valeur  du

portefeuille est donnée par du

portefeuille est donnée par  avec

W0, la valeur initiale d'un portefeuille de titres et avec

W0, la valeur initiale d'un portefeuille de titres et  son taux de

rentabilité continu sur un horizon T donné par son taux de

rentabilité continu sur un horizon T donné par  .

Dès lors, nous notons l'équation .

Dès lors, nous notons l'équation  ,

représentant la valeur minimale du portefeuille que l'on étudiera

avec une probabilité égale au seuil q, le seuil de

risque dont nous voulons étudier la représentativité. La

valeur de la VaR est donnée par : ,

représentant la valeur minimale du portefeuille que l'on étudiera

avec une probabilité égale au seuil q, le seuil de

risque dont nous voulons étudier la représentativité. La

valeur de la VaR est donnée par :

De manière plus formelle, notons   , la

distribution des valeurs du portefeuille à la date T, la valeur

W* est analogue à , la

distribution des valeurs du portefeuille à la date T, la valeur

W* est analogue à  . A ce

titre, si nous notons la probabilité . A ce

titre, si nous notons la probabilité   ,

l'espérance mathématique de la valeur du portefeuille se situe

au-dessus de W*, nous obtenons : ,

l'espérance mathématique de la valeur du portefeuille se situe

au-dessus de W*, nous obtenons :

D'un point de vue économétrique,

W* se définit comme le

pème percentile de la distribution de

l'échantillon à la date T. La Value-at-Risk

s'intègre pleinement dans le cadre de la gestion de portefeuille,

pouvant signifier précisément au gérant ou aux

institutions financières à quelle valeur peut être

estimée le risque économique et réglementaire24(*).

I.II.2 DISTRIBUTION DES VALEURS

EXTRÊMES

« Les théoriciens classiques ressemblent

à des géomètres euclidiens qui, dans un monde

non-euclidien découvrant par l'expérience que des lignes droites

parallèles se rencontrent souvent, reprocheraient aux lignes de ne pas

rester droites - comme seule remède aux collisions malheureuses qui se

produisent. Pourtant, en vérité, il n'existe pas d'autre

remède que de se débarrasser de l'axiome des parallèles et

de travailler dans une géométrie non-euclidienne. C'est une chose

similaire qui est requise aujourd'hui en économie »

John Maynard Keynes

La théorie des valeurs extrêmes (TVE) est

étudiée dans le cadre de la recherche d'évènements

rares d'une suite de variables aléatoires indépendantes et

identiquement identifiées. L'observation des cours des actifs financiers

montre que ceux-ci sont hypothétiquement influencés par leurs

cours passés, auquel l'aléa est souvent modélisé

par un mouvement brownien géométrique. La théorie des

valeurs extrêmes est donc un cas particulier de ce mouvement.

L'intérêt concret de l'étude des extrêmes se trouve

dans l'analyse des maxima et des minima des séries statistiques

concernées.

Sur les marchés financiers, nous gardons toujours

à l'esprit les grandes crises qui ont marquées notre histoire,

poussant les actifs à atteindre des valeurs extrêmes comme pour la

crise des Subprimes. En outre, bien connaître la distribution maximum et

minimum se révèle être un excellent outil d'aide à

la décision, voire une opportunité de gestion en temps de

crise.

La Théorie des Valeurs Extrêmes

s'intéresse non pas à la modélisation totale d'une

distribution mais seulement aux queues des lois spécifiques25(*).

Deux théorèmes sont indispensables pour une

bonne compréhension de la Théorie des Valeurs Extrêmes :

celui de Fisher- Tippet et celui de Balkema-de Haan-Picklands. Deux

méthodes principales de modélisation des évènements

rares sont possibles : La méthode « Block

Maxima » (BM) qui modélise la distribution des extrêmes

par la Generalized Extreme Value Theory (GEV) dérivant explicitement du

théorème de Fisher-Tipett, et la méthode « Peaks

Over Theshold » (POT) qui modélise la distribution des

excés au-dessus d'un seuil élevé (faisant apparaître

les queues de distribution) par la Generalized Pareto Distribution (GPD)

estimé par le théorème de Balkema-de Haan-Picklands. Cette

dernière méthode sera modélisée en fréquence

des rentabilités anormales afin d'estimer le paramètre u

de la crise des Subprimes.

I.II.2

1 ÉTUDES FONDAMENTALES

Concernant la loi faible des grands nombres, rappelons

cependant les études fondamentales permettant de lier la théorie

fondée sur le comportement asymptotique de la distribution d'une somme

de variable aléatoire et celui de la distribution du maximum et du

minimum.

Soit X une variable aléatoire appartenant au

domaine d'attraction d'une fonction  avec avec  et

(bn) une suite croissante de nombre et

(bn) une suite croissante de nombre   telle que telle que

,

F1 = X1 et ,

F1 = X1 et  ,

alors ,

alors

Cela nous permet de connaître la probabilité,

pour un nombre n grand, du dépassement d'un seuil x

par l'ensemble de la composition d'une suite de n variables

aléatoires. Lorsqu'une de ces variables se présente de

façon extrême par rapport aux valeurs prises par chacun des autres

éléments de la suite, nous considérons que le seuil  a

été franchi. Ceci caractérise l'événement

rare dont nous cherchons à étudier la distribution. a

été franchi. Ceci caractérise l'événement

rare dont nous cherchons à étudier la distribution.

I.II.2.2 LOIS DES MAXIMA : RÉSULTAT EXACTS

Le phénomène empirique suit une marché

aléatoire, mesuré par une variable X, décrivant

l'évolution du prix d'un actif financier. La variable aléatoire

X présente la rentabilité logarithmique. Nous

dénommons

§ la

fonction de densité notée § la

fonction de densité notée

§ la

fonction de répartition de probabilité de la variable

aléatoire X. § la

fonction de répartition de probabilité de la variable

aléatoire X.

Soit X1, X2,..., Xn

une suite de variables aléatoires aux dates 1, 2 ..., n. Nous

écrivons Fn la rentabilité maximum et

fn le minimum, dont ceux-ci observées sur n

séances boursières. Dans la suite de notre mémoire de

recherche, nous traiterons les résultats ne concernant que le maximum

(Fn), car ceux obtenus au minimum (fn)

s'en déduisent en considérant la série opposée ,

démontrée par l'équation suivante : ,

démontrée par l'équation suivante :

Si les cours suivent une marche aléatoire  .de variable X1, X2,...,

Xn indépendamment, alors les distributions du maximum

Fn sont conférées par .de variable X1, X2,...,

Xn indépendamment, alors les distributions du maximum

Fn sont conférées par . Les

propriétés statistiques du maximum dépendent de

GX pour les grandes valeurs de x. En ce qui

concerne les autres valeurs de x, l'influence de

GX(x) se révèle être de moins

en moins important avec n. C'est donc dans les queues de distribution

de X, par définition synonymes d'extrême, que nous allons

nous pencher dans cette étude. Nous pouvons en déduire la forme

de la loi limite de Fn en faisant tendre n vers

l'infini et en se servant de la formule. La fonction de répartition . Les

propriétés statistiques du maximum dépendent de

GX pour les grandes valeurs de x. En ce qui

concerne les autres valeurs de x, l'influence de

GX(x) se révèle être de moins

en moins important avec n. C'est donc dans les queues de distribution

de X, par définition synonymes d'extrême, que nous allons

nous pencher dans cette étude. Nous pouvons en déduire la forme

de la loi limite de Fn en faisant tendre n vers

l'infini et en se servant de la formule. La fonction de répartition  et et  . Dans ce

cas, la loi limite est dégénérée parce qu'elle se

réduit à une masse de Dirac26(*) portée en u. Toutefois, les formules

présentées ci-dessus présentent un intérêt

limité. La loi de la variable X est rarement connue

précisément en pratique, ainsi que la loi du terme maximum.

Nonobstant, même si la loi de la variable X est exactement

connue, le calcule de Fn peut être vecteur de

difficulté. Dépossédée d'expression analytique, la

distribution d'une variable normale se révèle être une

intégrale incalculable. Sa nème puissance

nous conduit à de sérieux problèmes numériques que

ce soit pour les grandes valeurs de n ou de x. C'est pour ces

différentes raisons que nous sommes astreints à étudier le

comportement asymptotique du terme maximum Fn'. . Dans ce

cas, la loi limite est dégénérée parce qu'elle se

réduit à une masse de Dirac26(*) portée en u. Toutefois, les formules

présentées ci-dessus présentent un intérêt

limité. La loi de la variable X est rarement connue

précisément en pratique, ainsi que la loi du terme maximum.

Nonobstant, même si la loi de la variable X est exactement

connue, le calcule de Fn peut être vecteur de

difficulté. Dépossédée d'expression analytique, la

distribution d'une variable normale se révèle être une

intégrale incalculable. Sa nème puissance

nous conduit à de sérieux problèmes numériques que

ce soit pour les grandes valeurs de n ou de x. C'est pour ces

différentes raisons que nous sommes astreints à étudier le

comportement asymptotique du terme maximum Fn'.

Cependant, Il existe deux théorèmes distincts

capables de contourner le problème de

dégénérescence. Selon la méthode employée,

il s'agit du théorème de Fisher-Tippet et du

Théorème Balkema-de Haan-Picklands. Nous allons rentrer dans les

détails dans la section suivante.

I.II.3

MESURE DU RISQUE EXTRÊME

I.II.3.1 THÉORÈME DE FISHER-TIPPET

Théorème Fisher-Tippet :

Si pour une distribution G non connue, l'échantillon

des maxima normalisés converge en loi vers une distribution non

dégénérée, alors il est équivalent de dire

que G est dans le MDA de la GEV Hî

A partir des données de prix traitées de

façon journalière lors de la crise de Subprimes,

nous supposons avoir une suite première d'observations

X1, X2, ... , Xn

issue d'une fonction de distribution inconnue F27(*). Cet échantillon peut être

séparé en k blocs28(*) disjoints de même longueur s. Les

données   ,

i = 1, ..., k sont de natures indépendantes et

identiquement identifiées avec comme fonction de distribution

F. ,

i = 1, ..., k sont de natures indépendantes et

identiquement identifiées avec comme fonction de distribution

F.

Nous nous attachons à connaître les maxima de

ces k blocs comme :

Qui agence la base de ce qui sera notre échantillon de

données supposées indépendante   . La loi

fondamentale à la modélisation des maxima est la Generalized

Extreme Value (GEV) définie par la fonction de répartition

suivante : . La loi

fondamentale à la modélisation des maxima est la Generalized

Extreme Value (GEV) définie par la fonction de répartition

suivante :

Où x est tel que  . .  est le

paramètre de forme. La GEV rassemble trois distributions

particulières : est le

paramètre de forme. La GEV rassemble trois distributions

particulières :

§ Si  >0, la loi de Fréchet (Type I) : >0, la loi de Fréchet (Type I) :

§ Si  <0, la loi de Weibull (Type II) : <0, la loi de Weibull (Type II) :

§ Si  =0,

la loi de Gumbel (Type III) : =0,

la loi de Gumbel (Type III) :

Ainsi, nous avons exposé sur les graphiques

correspondant à chaque itération deux paramètres29(*) : Le paramètre de

localisation   et celui de dispersion et celui de dispersion   >0. La

GEV prend alors la forme de : >0. La

GEV prend alors la forme de :

La démonstration fondamentale de la modélisation

des maximas est celui de Fisher-Tippet30(*). Supposons que nous ayons deux suites d'entiers

réels tel que   et et   tel

que : tel

que :

Avec H, une loi non

dégénérée.  , et Pour , et Pour

, les

k maxima normalisés. Alors, F est dans le

« maximum domain of attraction » (MDA) de

H, que nous pouvons écrire plus formellement par , les

k maxima normalisés. Alors, F est dans le

« maximum domain of attraction » (MDA) de

H, que nous pouvons écrire plus formellement par   . .

Fisher-Tippet montre alors que   si, et

seulement si, H est du type de si, et

seulement si, H est du type de  . La GEV

est donc la seule distribution limite non dégénérée

pour un échantillon de maxima normalisé. Nous obtenons alors une

méthode simple de sélection de forme F. Le tableau

ci-joint souligne quelles distributions sont associées aux lois de la

GEV. . La GEV

est donc la seule distribution limite non dégénérée

pour un échantillon de maxima normalisé. Nous obtenons alors une

méthode simple de sélection de forme F. Le tableau

ci-joint souligne quelles distributions sont associées aux lois de la

GEV.

|

TAB: MDA

|

|

|

|

|

Gumbel

|

Fréchet

|

Weibull

|

|

|

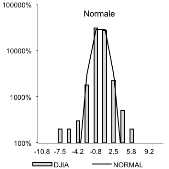

Normale

|

Cauchy

|

Uniforme

|

|

|

Exponentielle

|

Pareto

|

Beta

|

|

|

Lognormale

|

Student

|

|

|

|

Gamma

|

|

|

I.II.3.1.1 Modélisation paramétrique des maxima

par blocs

La modélisation issue du théorème

Fisher-Tippet, suppose que l'échantillon de maxima suive exactement une

loi GEV.

I.II.3.1.2 Sélection de la taille des blocs

La littérature financière classique et

l'exercice des statistiques en finance ne définissent pas une dimension

standard dans la sélection des blocs. Il faut cependant que s

soit de taille suffisamment importante pour que la condition asymptotique vue

précédemment soit considérée. L'ingénierie

financière dans les faits prend en compte un nombre de maxima

caractéristique pour que l'estimation des paramètres de la GEV

soit assez précise. Il est donc usuel de prendre s = 21, soit

un mois boursier, ou s = 254, soit un an.

I.II.3.1.3 Estimation du modèle BM par le maximum de

vraisemblance

C'est à partir de l'échantillon lié

à la sélection des maximas précédente que nous

pouvons estimer les paramètres de la GEV. La méthode

utilisée pour l'évaluation du modèle BM se

réfère au maximum de vraisemblance initié pour la

première fois par Fisher au début du siècle dernier. Soit

l'échantillon de maxima supposé indépendant   et et  , la

densité de la loi GEV , la

densité de la loi GEV  pour pour    : :

La vraisemblance de l'échantillon Y est :

. Il

fait appel à des procédures numériques31(*) pour la maximisation de la

vraisemblance. Il est alors aisé de calculer les estimateurs dans le

cadre de la loi des grands nombres. En revanche, il est difficile de donner un

estimateur asymptotique efficace et normal, particulièrement lorsque

l'échantillon est de petite taille. R. Smith32(*) montre qu'il suffit que . Il

fait appel à des procédures numériques31(*) pour la maximisation de la

vraisemblance. Il est alors aisé de calculer les estimateurs dans le

cadre de la loi des grands nombres. En revanche, il est difficile de donner un

estimateur asymptotique efficace et normal, particulièrement lorsque

l'échantillon est de petite taille. R. Smith32(*) montre qu'il suffit que    pour que

les états de régularité du maximum de vraisemblance soient

conformes. Pour le cas où pour que

les états de régularité du maximum de vraisemblance soient

conformes. Pour le cas où  = 0, la

log-vraisemblance est égale à : = 0, la

log-vraisemblance est égale à :

Plus précisément, en dérivant cette

fonction afin de mettre en scène les deux paramètres

exposés antérieurement nous obtenons le système

d'équations suivant.

Il est à noter pour conclure qu'il n'existe pas de

solution à ces équations de maximisation33(*).

I.II.3.2 THÉORÈME DE BALKEMA-DE

HAAN-PICKLANDS

Théorème Balkema-de

Haan-Picklands : Il s'en déduit que la

distribution des excès au-dessus d'un seuil élevé converge

vers la GPD   lorsque le seuil tend vers la lmite supérieure du support de G.

lorsque le seuil tend vers la lmite supérieure du support de G.

Supposons que X1, X2,

..., Xn sont des variables aléatoires de prix

indépendantes appartenant à une distribution appelée

F(X). Soit xF, l'extrémité finie ou

infinie de la distribution F. Alors, la fonction de distribution

dépassant Xi après un seuil donné

u, quand y   0, est

donné par : 0, est

donné par :

Belkema et de Haan en 1974, ou encore Pickands en 1975, ont

théorisé la fonction de Pareto généralisée

en montrant qu'elle s'apparente à une distribution limite

Fu(y) quand le seuil u tend vers

l'extrémité de la fonction. Il s'agit d'une découverte

statistique majeure. Si F   MDA

(Hî), il est alors possible de trouver une fonction

positive mesurable par MDA

(Hî), il est alors possible de trouver une fonction

positive mesurable par   (u) de telle sorte que : (u) de telle sorte que :

Pour   , ou , ou  correspond

à la distribution Pareto généralisée (GPD)

exprimée par : correspond

à la distribution Pareto généralisée (GPD)

exprimée par :

Ou   pour pour   et et   pour pour   .

Néanmoins, le choix du seuil u est primordial pour la

réussite de cet exercice de modélisation de la distribution

Pareto généralisée. Comme pour le test de fréquence

anormale, où nous devions choisir préalablement une fenêtre

de test de plus ou moins longue distance, la valeur représentative est

généralement choisie en fonction d'un compromis, capable de

biaiser l'étude. .

Néanmoins, le choix du seuil u est primordial pour la

réussite de cet exercice de modélisation de la distribution

Pareto généralisée. Comme pour le test de fréquence

anormale, où nous devions choisir préalablement une fenêtre

de test de plus ou moins longue distance, la valeur représentative est

généralement choisie en fonction d'un compromis, capable de

biaiser l'étude.

se

révèle être un paramètre de forme

particulièrement important, quant à se

révèle être un paramètre de forme

particulièrement important, quant à   , il

s'apparente à un paramètre d'échelle. Nous pouvons

dès à présent émettre une concordance avec le

théorème précédant, respectivement , il

s'apparente à un paramètre d'échelle. Nous pouvons

dès à présent émettre une concordance avec le

théorème précédant, respectivement   et et   La GPD

intègre par sa particularité d'autres formes de distribution. En

considérant que La GPD

intègre par sa particularité d'autres formes de distribution. En

considérant que   > 0, la

version paramétrique de G se rapporte à la distribution

originaire de Pareto, laquelle est souvent utilisée en actuariat dans

l'approche des probabilités d'erreurs. Vilfredo Pareto34(*) décrivit la

répartition de la richesse selon la notation suivante: > 0, la

version paramétrique de G se rapporte à la distribution

originaire de Pareto, laquelle est souvent utilisée en actuariat dans

l'approche des probabilités d'erreurs. Vilfredo Pareto34(*) décrivit la

répartition de la richesse selon la notation suivante:  . En . En

outre, Quelle est la proportion P des ménages

gagnant plus qu'un niveau de revenu u? V. Pareto estimait   à

-3/2. La puissance est donc en premier lieu élevée au cube puis

à la racine carrée divisé par 1. Ceci fut la base des

premières lois à

-3/2. La puissance est donc en premier lieu élevée au cube puis

à la racine carrée divisé par 1. Ceci fut la base des

premières lois   -stable de

Paul Lévy35(*),

repris quelques années plus tard par B. Mandelbrot36(*) dans son étude sur les

variations du prix du coton. A contrario, si -stable de

Paul Lévy35(*),

repris quelques années plus tard par B. Mandelbrot36(*) dans son étude sur les

variations du prix du coton. A contrario, si   < 0

prend la forme d'une loi de Gumbel. Enfin, lorsque < 0

prend la forme d'une loi de Gumbel. Enfin, lorsque   = 0, sa

correspondante est une distribution exponentielle. = 0, sa

correspondante est une distribution exponentielle.

Le premier cas (  > 0) se

retrouve pertinent dans le cadre d'une distribution réelle

possédant des queues de distribution épaisses. Les estimations de > 0) se

retrouve pertinent dans le cadre d'une distribution réelle

possédant des queues de distribution épaisses. Les estimations de

et de et de   sont

calculées à partir de l'expression sont

calculées à partir de l'expression   par la

méthode du maximum de vraisemblance37(*). Lorsque par la

méthode du maximum de vraisemblance37(*). Lorsque  > 0.5,

Hosting et Wallis montrent que l'estimation tirée du maximum de

vraisemblance tend à être asymptotiquement normalement

distribué. > 0.5,

Hosting et Wallis montrent que l'estimation tirée du maximum de

vraisemblance tend à être asymptotiquement normalement

distribué.

I.II.3.2.1 Modélisation paramétrique de la

distribution des excès

Cette modélisation de queue de distribution engage un

échantillon au-dessus du seuil u, lequel conduit à une

forme de loi GPD.

Dans la littérature financière et statistique,

les méthodes utilisées reposent sur le comportement graphique des

valeurs considérées supérieures à un seuil

donné. Cette méthode porte le nom de

« Peak-Over-Threshold ». Initialement

développé par Picklands en 1975, ce concept fut

étudié par de nombreux auteurs38(*). Cependant, cette méthode reste arbitraire. En

réalité, u, doit être assez grand pour que

l'estimation de la distribution de Pareto généralisée soit

valide, mais pas trop élevée pour garder une certaine

cohérence avec le modèle. Cet arbitrage est analogue à la

méthode BM vue postérieurement.

I.II.3.2.2 Estimation du modèle de seuil par le maximum

de vraisemblance

Supposons que notre échantillon des excès   est

indépendante et identiquement identifiée avec comme fonction de

distribution la GPD. La fonction de densité g de G est

alors pour est

indépendante et identiquement identifiée avec comme fonction de

distribution la GPD. La fonction de densité g de G est

alors pour   : :

. .

Nous pouvons dès lors estimer la

log-vraisemblance :  . Hosking

et Wallis montre que lorsque nous dérivons . Hosking

et Wallis montre que lorsque nous dérivons  et et  , nous

obtenons les équations de maximisation à partir desquelles nous

calculons les estimateurs du maximum de vraisemblance. , nous

obtenons les équations de maximisation à partir desquelles nous

calculons les estimateurs du maximum de vraisemblance.

I.II.3.3 4 VALUE-AT-RISK EXTREME

Nous pouvons reconnaître qu'il existe une similitude

certaine entre le concept de Value-at-Risk et la méthode d'approche des

queues de distribution des lois de valeurs extrêmes. Unir ensemble ces

deux fondements pourrait indubitablement donner un véritable outil de

contrôle du risque. Formulé précédemment, la

propriété des extrêmes peut être faite de deux

façons distinctes :

§ Par la méthode des maximums d'une série

de variable aléatoire dans le temps : La méthode BM

§ Par la méthode du seuil en prenant l'ensemble

des valeurs se situant entre [    ] : La

méthode POT ] : La

méthode POT

Dans ce papier de recherche, nous utilisons la dernière

méthode énoncée qui représente la plus

récente, mais aussi la plus efficace des méthodes connues sur ce

sujet. De plus, ce modèle se révèle être pratique

dans le fait qu'il considère un nombre limité de

donnée.

Afin de construire le modèle de Pareto

généralisée, nous allons donner un seuil u

important. Soit Y1, Y2, ...,

Yn, les données supérieures au seuil

défini comme   . Belkema

et de Haan en 1974 comme Picklands en 1975 nous enseignent que . Belkema

et de Haan en 1974 comme Picklands en 1975 nous enseignent que   est une

estimation assez importante de u. A partir de est une

estimation assez importante de u. A partir de   , prenons , prenons

, nous

pouvons approximer F(x), pour x > u.

Nous obtenons : , nous

pouvons approximer F(x), pour x > u.

Nous obtenons :

La fonction F(u) peut être

estimée empiriquement de façon non-paramétrique par la

fonction de distribution cumulative :

Où   représente le nombre d'occurrence supérieure au seuil u

et n l'échantillon. En corroborant

représente le nombre d'occurrence supérieure au seuil u

et n l'échantillon. En corroborant   et et   à à

, nous

pouvons ainsi écrire : , nous

pouvons ainsi écrire :

Les paramètres   et et   sont

estimés à partir de î et sont

estimés à partir de î et   respectivement, obtenus à partir du maximum de vraisemblance.

respectivement, obtenus à partir du maximum de vraisemblance.

Pour q > F(u), la VaRq peut

être calculé en résolvant x :

Dans lequel u est le seuil défini,   est

l'estimation du paramètre d'échelle et est

l'estimation du paramètre d'échelle et   est

l'estimation du paramètre de localisation. est

l'estimation du paramètre de localisation.

Le principal avantage de cette mesure non-paramétrique

réside dans le fait qu'elle se concentre exclusivement sur les queues de

distribution. Cependant, nous pouvons en conclure que cette méthode ne

considère pas les rendements comme indépendants et identiquement

distribués les uns des autres.

II.

SECTION EMPIRIQUE

Ce mémoire de recherche appliquée fut

réalisé à partir de données diffusées sur

Bloomberg®. L'estimation des taux de rentabilités anormales et le

calcul des lois de valeurs extrêmes appliquées à la

Value-at-Risk font l'objet de deux sous-parties. Nous distinguerons donc d'une

part l'estimation des fréquences anormales, représentant

statistiquement l'état de crise, et d'autre part la performance

ajustée du risque liée aux valeurs extrêmes.

II.I

MESURE DES FRÉQUENCES ANORMALES

II.I.1

PROCESSUS

Nous nous sommes intéressés aux cours

journaliers spot des 30 valeurs composant le Dow Jones Industrial Average. La

première chronique dans laquelle nous calculons les taux de

rentabilités normales avant crise couvre la période du 13/06/2006

au 15/06/2007, soit 7 620 observations alors que la deuxième,

d'où sont évaluées les rentabilités anormales, se

déploie sur une période allant du 02/07/2007 au 01/02/2010, soit

19 560 observations. Nous aurons donc à étudier 27 180

données totales.

Ce choix est justifié pour trois raisons :

§ La période d'échantillonnage avant crise

représente une année boursière. Plus le nombre

d'observations augmente, plus la représentation graphique de la variance

s'aplatira, ce qui aura pour effet de donner une volatilité moyenne

biaisée, que l'on utilise l'un ou l'autre des modèles39(*). Il est justifié d'user

de pragmatisme quant à la précision et la représentation

des données utilisées. De plus, il serait hâtif de se

précipiter sur un nombre de données plus important dans le sens

où il n'est pas très adéquate d'y incorporer

l'instabilité de variance dû à une autre crise

antérieure.

§ Les tests de cohérence statistiques ont tous

pour particularités d'être asymptotiquement normales avec N

(0, 1). Cette convergence est qualifiée à partir du moment

où le nombre de jours post-crise est grand et que le nombre N

de valeur étudiée est supérieur ou égal à

3040(*). Ainsi, les 30

valeurs du DJIA et le nombre important de données sont en accord avec

les statisticiens.

(0, 1). Cette convergence est qualifiée à partir du moment

où le nombre de jours post-crise est grand et que le nombre N

de valeur étudiée est supérieur ou égal à

3040(*). Ainsi, les 30

valeurs du DJIA et le nombre important de données sont en accord avec

les statisticiens.

§ Pour des raisons de programmation en Visual Basic, nous

avons préféré laisser un espace-temps de 10 séances

boursières entre la période de temps dite normale et celle de la

crise des Subprimes. Ce laps de temps fut fixé de façon

arbitraire.

§ La crise des Subprimes a véritablement

commencé entre juillet et août 2007. Pour des raisons de

cohérence et parce que les experts semblent divergents quant à la

date précise de commencement de la crise, et parce que cela ne peut

être absolument incontestable, notre étude commence le 02/07/2007

et fini début 2010. Il s'agit d'une période

particulièrement volatile sur l'ensemble des marchés financiers,

ce qui nous conforte dans le choix de cet échantillonnage.

Statistiques

préliminaires

Nous avons réalisé une étude statistique

préalable sur 4 titres de natures différentes, afin de mieux

appréhender nos rentabilités anormales. Nous allons

étudier 651 observations par titre, du 02/07/2007 au 01/01/2010, soit 2

604 données. Impacté par la crise des Subprimes et par une forte

volatilité des cours, nous avons sélectionné :

§ Le DJIA