Ludovic SACHOT

Titre RNCP de niveau 7 | Expert Informatique et

systèmes d'information

2021-2022

Tuteur établissement : Madame GASSIER Esther Tuteur

Entreprise : Madame GLAUME Sophie

Table des matières

Introduction 4

1. En quoi consiste l'informatique quantique ?

5

Constat de l'existant : pourquoi adopter une démarche

quantique dans le cadre de

l'informatique ? 5

Comment fonctionnent les algorithmes quantiques? 5

Loi de Moore 6

Les limites de notre technologie 6

Loi de Neven 7

Relation entre la physique quantique et l'informatique 7

Les « qubits », évolution du « bit »

7

Le bruit 7

Spin quantique 8

Valeurs discrètes & valeurs continues 8

Le chat de Schrödinger 8

1.2 Les concepts apportés par l'informatique

quantique 9

Principe de superposition 9

Principe d'intrication 9

Stabilité des qubits 9

Intégration des technologies quantiques dans la couche

réseau 10

Comment un réseau quantique est-il agencé ? 10

Composition d'un réseau quantique 11

Le principe d'intrication appliquée sur des noeuds

quantiques 12

Boites quantiques (quantum dots) 12

Téléportation quantique 13

Canal quantique (EPR) 14

État quantique adiabatique (AQT) 14

Cristaux temporels 14

Cryptographie 15

Code César 15

Primitives cryptographiques 15

Le transfert inconscient (Oblivious Transfert => QOT) 15

Projet Nessie 16

Sélection des primitives 17

Cryptographie actuelle et enjeux quantiques 17

Échange de clés « Diffie Hellman » 17

1

Protection des communications numériques 18

Distribution de clés quantiques (QKD) 20

TLS 21

IPSec 22

Comment intégrer QKD dans les protocoles de

sécurité actuels ? 23

Utilisation de QKD dans IPsec et TLS 24

Les différents types de certificats 24

1.3 Acteurs engagés et secteurs concernés

25

Les géants de l'informatique et les startups 25

QuTech Research Center : Mise en place du réseau à

trois noeuds quantiques 27

Des scientifiques de la NASA et leurs partenaires

réalisent pour la première fois une

"téléportation

quantique" à longue distance. 28

La place de la France dans cette course au quantique 28

Les secteurs visés 29

Quantum Cloud 29

Quantum Gaming 30

Médecine & santé 30

Machine Learning et Intelligence artificielle 31

Automobile 32

Finance 32

Conquête de l'espace. 33

PROBLÉMATIQUE 35

2. Les technologies quantiques ont-elles le pouvoir de

compromettre les technologies actuelles ? 36

Etat des lieux des risques rencontrés avec l'informatique

37

Usage militaire potentiel 38

Intelligence artificielle 39

Crypto monnaie et blockchain 40

Qu'est-ce qu'une crypto-monnaie ? 41

Biométrie 43

Document de voyage électronique lisible à la

machine 43

La migration vers des eMRTD à preuve quantique prendra du

temps 44

Internet of Things (IoT) 44

2.2 Comment endiguer la menace et devrait-on s'y atteler

dès aujourd'hui ? 46

Existe-t-il un moyen d'éliminer ou d'atténuer les

risques liés aux crypto-monnaies ? 46

Adaptation des protocoles de cryptage utilisés dans les

documents de voyage électroniques

lisibles à la machine pour atteindre une

sécurité quantique. 47

2

Déploiement de documents de voyage électroniques

lisibles par machine à sécurité quantique

49

Comment protéger les données face à la

puissance du quantique ? 50

Cryptographie post-quantique 50

Standardisation de la cryptographie post quantique 51

Les mots de passe et les systèmes de cryptages en danger

56

Alternatives non-quantiques pour se protéger 57

Le protocole ZRTP (Zimmermann Real-time Transport Protocol) 57

Législation européenne relative à L'IA 58

AI Act 58

Projet RISQ. La France se place comme un acteur imposant 59

Conclusion 61

Bibliographie commentée 62

Ouvrages 62

Articles scientifiques 63

Revues 65

3

Introduction

Plus de puissance de calcul, une rapidité accrue du

traitement de l'information et une meilleure protection de nos systèmes,

voilà ce que nous promet les technologies quantiques. La soif de

progrès nous pousse à toujours rechercher l'évolution de

nos appareils, logiciels, protocoles et algorithmes.

L'essor du nombre d'appareils connectés, notamment avec

l'IoT, entraine inéluctablement un besoin de cyber protection

supplémentaire. Les logiciels certes, de plus en plus performants, mais

également de plus en plus gourmands en ressources, sont soumis à

la puissance de calcul du ou des processeurs de la machine hôte. Le

besoin en bande passante s'accroit, les besoins en matière de protection

des flux réseau également.

L'informatique tend, dans un premier temps, à

répondre aux besoins des professionnels : Les supercalculateurs actuels,

certes performants, paraissent obsolètes face aux ordinateurs quantiques

et leur puissance de calcul bien supérieure. Certaines opérations

complexes, notamment la modélisation de phénomènes

climatiques ou médicaux ou encore des estimations extrêmement

précises pourront s'effectuer bien plus rapidement qu'a l'heure

actuelle, avec nos superordinateurs.

Les technologies quantiques ne s'appliquent pas uniquement

à l'aspect matériel, de nouvelles méthodologies

algorithmiques, qui seront en capacité d'exploiter

l'accélération quantique et les principes d'intrication et

superposition devront être développées, ne serait-ce que

pour un souci de compatibilité entre la couche logicielle et

matérielle.

Malgré l'ensemble des aspects positifs que

présente l'informatique quantique, cette dernière expose ceux qui

n'y sont pas préparés à des risques de sabotage. Les

technologies quantiques seront aptes à déchiffrer les algorithmes

de sécurité actuels. Les appareils, base de données et

tout autre type de biens matériel ou immatériel

protégé par des algorithmes traditionnels sont exposés aux

algorithmes dits « quantiques ».

La première partie du mémoire permettra de

définir les bases de l'informatique quantique, en démontrant

certains principes fondamentaux de la mécanique quantique, tout en

s'appuyant sur des faits. Nous analyserons également l'impact des

technologies quantiques au sein des réseaux dits quantiques.

La deuxième partie du mémoire sera

consacrée à l'analyse des risques engendrés par l'essors

des technologies quantiques. Nous nous pencherons également sur les

actions défensives possibles et entreprises notamment par les hautes

instances gouvernementales.

4

1. En quoi consiste l'informatique quantique ?

Étant donné que les principes de physiques

« classiques » ne permettaient pas d'expliquer certains

phénomènes, le principe de physique quantique a été

admis au cours du XXème siècle. Il regroupe un ensemble de

théories physiques décrivant le comportement des atomes et des

particules. Elle agit donc au niveau atomique.

La physique quantique est utilisée dans l'ensemble des

domaines recourant aux lois de la mécanique quantique, l'informatique,

et plus précisément l'architecture de nos microprocesseurs, en

fait partie.

L'informatique quantique découle de la physique

quantique, et se présente comme une révolution technologique. Si

l'on devait résumer les apports potentiels des technologies quantiques,

ces dernières permettraient de démultiplier la vitesse de calcul

et de traitement des données de nos appareils et programmes, tout en

apportant des algorithmes de cryptage bien plus robustes que ceux

utilisés de nos jours.

Constat de l'existant : pourquoi adopter une démarche

quantique dans le cadre de l'informatique ?

Au rythme actuel, et avec les technologies conventionnelles

d'aujourd'hui, il est estimé que nous pourrons miniaturiser nos

appareils technologiques durant encore les vingt prochaines années. Le

quantique promet également une amélioration de la puissance de

calcul des processeurs, tout en réduisant leur consommation

d'énergie grâce au principe de superposition, qui sera

développé plus tard. Une vitesse accrue du traitement des

informations permettrait de résoudre plus rapidement des

problèmes mathématiques, renforcer les systèmes de

cybersécurité, développer de nouveaux algorithmes de

chiffrement, traiter de plus grandes quantités d'informations

L'objectif serait de garder notre rythme de croisière

en matière d'évolution technologique le plus longtemps

possible.

Comment fonctionnent les algorithmes quantiques?

La plupart des algorithmes quantiques suivent le schéma

suivant:

· Étape de préparation: préparer

les qubits d'entrée et définir la valeur initiale de ces

derniers. Habituellement, une partie de cette préparation consiste

à mettre les qubits les uns sur les autres.

· Étape de calcul: Lancement de la conversion des

qubits afin de minimiser les résultats incorrects. Pour cela, des qubits

intriqués sont généralement nécessaires.

· Etage de mesure: mesure le qubit, détruisant

ainsi l'état interne de l'amplitude du sous-bit mesuré et

obtenant la sortie classique de 1 et 0.

5

·

Étape itérative: Les résultats obtenus

étant probabilistes et pas toujours les résultats attendus,

il est généralement nécessaire de

vérifier si les résultats obtenus sont valides ou il est

nécessaire de redémarrer l'algorithme. À d'autres moments,

vous pouvez obtenir le résultat statistiquement attendu en le

répétant plusieurs fois.

Loi de Moore

Cette loi, énoncée en 1965 par Gordon E. Moore,

l'un des co-fondateurs de la société Intel, repose sur

l'évolution de la taille et du prix des microprocesseurs.

Elle postule qu'à coût égal, le nombre de

transistors présents sur une puce double tous les ans.

Elle a été revisitée en 1975 par cette

même personne, et postula que désormais, ce doublement aurait lieu

tous les deux ans jusqu'en 2015 au minimum.

De nombreux experts, dont Gordon E. Moore, postulaient que

cette loi atteindrait ses limites dès lors que les limites physiques de

la micro-électronique seraient atteintes, et ce fût le cas ; la

courbe d'évolution de nombre de transistors décline depuis

environ 2015.

La quantité toujours plus importante de transistors

amène de nouvelles problématiques, dont celle de la gestion et de

la dissipation de la chaleur générée par la

fréquence en Hertz des microprocesseurs. Cette dernière stagne

depuis environ 2004 pour, en partie, les mêmes raisons.

Les limites de la Loi de Moore

Nous sommes en droit de nous demander jusqu'à quelle

date cette loi sera fiable. Jusqu'où les limites technologies peuvent

allées ? Comment l'améliorer lorsque ces dernières

stagneront ?

Le quantique tend à répondre partiellement

à ces questions, en proposant un champ technologique nouveau,

basé sur des principes technologiques encore très peu

exploités. La transition vers de nouvelles lois commence à

être opérée.

Les limites de notre technologie

Au fur et à mesure de la progression de la puissance

de calculs et de la quantité d'informations traitées par les

microprocesseurs, nous constatons les limites d'une architecture binaire.

L'informatique quantique permettrait de modifier la manière dont les

informations sont traitées et conçues, ce qui amènerait un

accroissement des performances des algorithmes de calculs et de traitement des

données.

6

Loi de Neven

La loi de Neven, nommée en l'honneur d'Hartmut Neven,

scientifique de renom chez Google, est présentée et pressentie

comme la remplaçante et l'évolution de la loi de Moore. Elle

dicte la rapidité avec laquelle les processeurs quantiques

s'améliorent ou accélèrent le traitement des calculs par

rapport aux ordinateurs classiques.

Cette loi constitue l'une des raisons qui a poussé

Google à annoncer qu'ils venaient d'atteindre la «

suprématie quantique », le 23 octobre 2019.

D'après eux, leur ordinateur quantique aurait

été capable de résoudre un calcul en 3 minutes et 20

secondes, tandis que cela prendrait environ 10 000 ans au supercalculateur

traditionnel le plus rapide du monde.

Relation entre la physique quantique et l'informatique

Pour commencer, il est bon de savoir comment une

donnée est stockée et transmise. Un bit (Binary

Digit) désigne d'une part la plus petite

quantité de donnée possible pouvant être transmise par un

message, et d'autre part l'unité de mesure de base de l'information.

Un bit peut avoir deux états : 0 et 1. En adoptant une

démarche humainement logique, nous pouvons considérer qu'un bit

peut adopter les états « faux », associé au 0, et

« vrai », associé au 1.

Les « qubits », évolution du « bit

»

Un « qubit » ou « bit quantique » partage

le même principe qu'un bit, mais embarque une structure plus complexe. La

grande différence s'identifie dans le fait qu'il soit capable d'adopter

plusieurs états à la fois, lui permettant de contenir plus

d'informations tout en ayant la possibilité de les traiter

simultanément, ayant pour effet d'augmenter la vitesse de traitement des

données. Le qubit est soumis à de nouveaux principes

nommés « superposition » et « intrication »

Le bruit

L'état d'un bit peut, dans certains cas, être

modifié à causes de perturbations extérieures (radiations,

champs électromagnétiques), de sorte que la valeur 0 peut

être convertie en la valeur 1 et inversement. Ce phénomène

se dénomme SEU, pour Single Event Upset.

Ce phénomène s'observe la plupart du temps dans

les domaines de l'aéronautique et du spatial, du fait principalement du

rayonnement solaire. La miniaturisation constante de nos appareils les rend

plus vulnérables aux SEUs, de par le fait que moins d'électrons

circulent dans ces derniers. L'altération d'un système comportant

un faible nombre d'électrons à plus de chance de modifier

l'état des bits transmettant l'informations, ce qui entraine une

détérioration de la fiabilité.

7

Spin quantique

Le spin est une caractéristique quantique des

particules intimement liée à leurs propriétés de

rotation. Il s'agit d'une manifestation du magnétisme de la particule

dans le champ de la mécanique quantique

Valeurs discrètes & valeurs continues

Une variable discrète est une variable qui ne peut

prendre des valeurs que dans un ensemble d'éléments, tandis

qu'une variable continue prendra ses valeurs dans un intervalle.

Bien qu'à l'échelle classique, le processeur

utilise un "support continu" pour placer des données discrètes,

il est impossible de faire de même au niveau quantique. En effet,

à cette échelle, le niveau d'énergie n'est plus une

donnée continue mais discrète. Puis est apparu un problème

théorique qui ne pouvait pas être résolu par la

mécanique classique, le soi-disant problème du corps noir. Le

terme « corps noir » fait référence à un objet

capable d'absorber tout rayonnement qui lui est dirigé, quel que soit le

type de rayonnement. Un tel objet ne réfléchit pas la

lumière, c'est pourquoi on l'appelle aussi corps noir. En fait, ce corps

ne sera pas complètement noir. En fait, s'il absorbe du rayonnement,

cela signifie qu'il chauffe. Or, tout objet chauffé émet un

rayonnement, ce qui est le vrai principe des ampoules électriques.

Le chat de Schrödinger

Le chat de Schrödinger est une expérience

imaginée en 1935 par le physicien autrichien Erwin Schrödinger,

considéré comme l'un des pères de la physique

quantique.

Le chat peut adopter 2 états ; s'il est mort, son

état est considéré comme 0, et s'il est encore vivant, son

état est considéré comme 1.

Le chat est placé dans une boîte fermée,

contenant un flacon de gaz motel (de l'acide cyanhydrique, d'après le

physicien) et une source radioactive.

Il est impossible de voir le contenu du chat de

l'extérieur. Dans la boîte est également placé un

dispositif conçu pour libérer des poisons si la

désintégration des atomes est détectée.

L'appareil ne peut fonctionner que pendant un temps

limité, après quoi il y a 50 % de chances de trébucher.

Une fois l'expérience commencée, il est

impossible de connaître l'état du chat, alors la

probabilité qu'il soit encore en vie est égale à la

probabilité que le poison ne soit pas libéré, et la

probabilité qu'il soit mort est égale à la

probabilité que le poison soit libéré.

Cependant, la libération de poison est

aléatoire. Si nous pouvons calculer la probabilité, Il est

impossible d'en être sûr. Ce n'est que par l'observation directe du

chat, c'est-à-dire la «mesure», que nous pouvons

connaître sa véritable condition.

8

1.2 Les concepts apportés par l'informatique

quantique

Principe de superposition

Ce principe définie la capacité d'une

architecture quantique à pouvoir se trouver dans plusieurs états

à la fois. Lorsque l'on parle d'une particule, nous pouvons imaginer

qu'elle puisse se trouver dans deux états différents => A et

B

La particule ne se trouvera pas dans ces deux états au

même moment, mais pourra se déplacer entre A et B. Un principe de

proportion peut également s'appliquer ; une particule peut avoir plus de

probabilité de se trouver dans un état bien particulier

plutôt qu'un autre.

Ce principe permettrait aux processeurs de traiter plusieurs

opérations de calcul en même temps, augmentant drastiquement la

vitesse de traitement des informations reçues.

Lorsque l'on parle d'un bit, nous pouvons remplacer les

états « A » et « B » par « 0 » et « 1

».

Principe d'intrication

Ce principe se base sur le fait que deux qubits forment un

système lié, ayant des états dépendants des uns des

autres peu importe la distance, du moins en théorie.

Ce concept est encore méconnu et difficile à

concevoir ; La modification d'état d'un des qubit intriqué

engendrerait une modification sur l'autre qubit intriqué, et ce sans

connexion, support pour véhiculer l'information entre les deux

qubits.

Selon le physicien Nicolas Gisin « L'intrication permet

à un événement aléatoire de se manifester en

plusieurs endroits ».

Toutefois, en 2017, une équipe chinoise a battu le

record de distance entre deux particules intriquées, des photons

émis par le satellite Micius. Les chercheurs les ont

séparés puis captés dans deux stations au sol, distantes

de 1 200 km. Malgré la distance, les particules intriquées

l'étaient toujours, malgré la distance.

Stabilité des qubits

L'une des principales problématiques réside

dans le fait de multiplier les interactions entre les qubits ainsi que leur

durée de vie ; Une superposition peut se rompre du fait d'un manque de

stabilité lors des processus d'échanges d'informations. S'en suit

la destruction du qubit, et la perte de l'information.

9

Intégration des technologies quantiques dans la couche

réseau

Un réseau quantique promet de permettre la

communication quantique sur de longues distances et d'assembler de petits

dispositifs quantiques en une grande grappe de calcul quantique, tout en

garantissant un haut niveau de sécurité des données en

transit.

Chaque noeud quantique du réseau pourrait être

considéré comme un petit ordinateur quantique à quelques

qubits. Les qubits peuvent être envoyés par des liens physiques

directs reliant ces noeuds quantiques proches par

télétransmission ou par téléportation sur une

intrication préétablie entre des noeuds de réseau

distants. Une telle intrication forme effectivement un raccourci - un lien

quantique virtuel - utilisable une fois.

La communication quantique offre des avantages

inégalés par rapport à la communication classique.

Côté sécurité, la distribution de clés

quantiques qui permet à deux parties d'établir une clé de

de chiffrement avec des garanties de sécurité qui sont

manifestement impossibles à obtenir de manière classique.

Néanmoins, la communication quantique offre un large éventail

d'autres applications allant des protocoles cryptographiques aux protocoles de

communication efficaces, des applications dans les systèmes

distribués, ou encore une meilleure synchronisation des horloges

Alors que la distribution de clés quantiques est

déjà disponible dans le commerce sur de courtes distances, le

maintien d'un état stable pour les qubits sur de longues distances reste

un défi important qui nécessite la construction d'un

répéteur quantique (cet élément sera

détaillé par la suite).

Cependant, le fait de parcourir de longues distances ne

suffit pas. Il est également nécessaire de permettre à la

communication d'être fiable et d'arriver à destination, et ce

même lorsque plusieurs noeuds communiquent simultanément. Pour

cela, de nombreux qubits sont nécessaires.

Comment un réseau quantique est-il agencé ?

Chaque noeud d'un réseau quantique est un petit

ordinateur quantique qui peut stocker et exploiter

quelques qubits. L'objectif d'un réseau quantique est

d'envoyer des qubits d'un noeud à l'autre ou, de manière

équivalente, d'établir une intrication entre eux.

Il est possible de créer un cluster de calcul

quantique afin d'obtenir un plus grand potentiel de calcul. Des ordinateurs

moins puissants peuvent être reliés de cette manière pour

créer un processeur plus puissant. Cela est analogue à la

connexion de plusieurs ordinateurs classiques pour former un cluster

d'ordinateurs dans l'informatique classique. Tout comme l'informatique

classique, ce système peut être mis à l'échelle en

ajoutant de plus en plus d'ordinateurs quantiques au réseau.

10

Composition d'un réseau quantique

Tout d'abord, les noeuds finaux sur lesquels les applications

sont finalement exécutées. Ces noeuds finaux sont des processeurs

quantiques d'au moins un qubit. Certaines applications nécessitent

malgré tout des processeurs quantiques de plusieurs qubits ainsi qu'une

mémoire quantique aux noeuds finaux.

Deuxièmement, pour transporter les qubits d'un noeud

à l'autre, nous avons besoin de lignes de communication. Pour la

communication quantique, on peut utiliser des fibres de

télécommunication standard. Pour l'informatique quantique en

réseau, dans laquelle les processeurs quantiques sont reliés

à de courtes distances, différentes longueurs d'onde sont

choisies en fonction de la plate-forme matérielle exacte du processeur

quantique.

Troisièmement, pour utiliser au maximum

l'infrastructure de communication, il faut des commutateurs optiques capables

de fournir des qubits au processeur quantique. Ces commutateurs doivent

préserver la cohérence quantique, ce qui les rend plus difficiles

à réaliser que les commutateurs optiques standard.

Enfin, un répéteur quantique est

nécessaire pour transmettre des qubits sur de longues distances. Ce

dispositif permet de capturer et traiter les qubits, tout en les stockant afin

de préparer le reste du réseau à les

réceptionner.

La perte de photons et l'impossibilité d'amplifier le

signal a conduit au développement du concept de répéteurs

quantiques, qui augmentent la distance de communication en utilisant les

propriétés non locales de l'intrication, sa distribution par

téléportation et mémoires quantiques .

Divers protocoles de répéteurs quantiques ont

été développés au fil des ans, et les premiers pas

vers leur réalisation ont été faits très

récemment.

Des répéteurs apparaissent entre les noeuds

d'extrémité. Comme les qubits ne peuvent pas être

copiés, l'amplification conventionnelle du signal ne peut pas être

effectuée. Selon les besoins, le mode de fonctionnement des

répéteurs quantiques est fondamentalement différent de

celui des répéteurs traditionnels.

11

Le principe d'intrication appliquée sur des noeuds

quantiques

Il existe de nombreuses façons d'enchevêtrer des

noeuds quantiques, mais l'une des méthodes les plus courantes consiste

à enchevêtrer les qubits stationnaires (qui forment les noeuds du

réseau) avec des photons, avant de tirer les photons les uns sur les

autres. Lorsqu'ils se rencontrent, les deux photons s'emmêlent

également, ce qui a pour effet d'emmêler les qubits. Cela lie les

deux noeuds stationnaires qui sont séparés par une certaine

distance. Toute modification apportée à l'un d'eux se traduit par

une modification instantanée de l'autre.

Boites quantiques (quantum dots)

Les boites quantiques sont des cristaux nanométriques

qui peuvent transporter des électrons. Lorsque les rayons ultraviolets

frappent ces nanoparticules semi-conductrices, elles peuvent émettre de

la lumière de différentes couleurs. Ces nanoparticules

semi-conductrices artificielles ont trouvé des applications dans les

matériaux composites et les cellules solaires.

Les nanoparticules semi-conductrices ont été

théorisées dans les années 1970 et ont été

créées au début des années 1980. Si les particules

semi-conductrices sont suffisamment petites, les effets quantiques commencent

à fonctionner, ce qui limite l'énergie des électrons et

des trous dans les particules. Puisque l'énergie est liée

à la longueur d'onde (ou à la couleur), Cela signifie que les

propriétés optiques des particules peuvent être

ajustées en fonction de la taille des particules. Par conséquent,

ce n'est qu'en contrôlant la taille des particules que les particules

peuvent émettre ou absorber la lumière d'une longueur d'onde

(couleur) spécifique.

Les points quantiques sont des nanostructures artificielles

qui peuvent avoir de nombreuses propriétés différentes

selon leurs matériaux et leurs formes. Par exemple, en raison de leurs

propriétés électroniques particulières, ils peuvent

être utilisés comme matériaux actifs dans les transistors

à un électron. Les propriétés des points quantiques

dépendent non seulement de leur taille, mais également de leur

forme, de leur composition et de leur structure, par exemple s'ils sont pleins

ou creux. Les technologies de fabrication fiables qui utilisent les

propriétés des points quantiques - dans diverses applications

dans les domaines de la catalyse, de l'électronique, de la photonique,

du stockage d'informations, de l'imagerie, de la médecine ou de la

détection - doivent être capables de produire un grand nombre de

nanocristaux, chaque lot étant basé sur le même

paramètre.

Parce que certaines biomolécules peuvent effectuer la

reconnaissance moléculaire et l'autoassemblage, les nanocristaux peuvent

également devenir une partie importante des nanodispositifs fonctionnels

auto-assemblés. L'état d'énergie atomique des points

quantiques contribue en outre à des propriétés optiques

spécifiques, telles que l'effet des particules de longueur

12

d'onde fluorescentes en fonction de la longueur d'onde, qui

peuvent être utilisées pour fabriquer des sondes optiques pour

l'imagerie biologique et médicale

Jusqu'à présent, les points quantiques

colloïdaux ont obtenu le plus d'applications dans les domaines de la bio

analyse et du biomarking. Bien que les points quantiques de première

génération aient prouvé leur potentiel, il a fallu

beaucoup d'efforts pour améliorer les propriétés de base,

en particulier la stabilité colloïdale dans les solutions salines.

Au départ, les points quantiques étaient utilisés dans des

environnements très artificiels, et ces particules ne seraient

déposées que dans des échantillons

«réels» (comme le sang).

Téléportation quantique

La téléportation quantique est basée sur

l'intrication partagée et la mesure quantique, et fournit une

méthode pour transférer des états quantiques inconnus

entre des systèmes à longue distance. La

téléportation est l'élément de base requis pour

effectuer diverses tâches de calcul quantique dans les réseaux

quantiques.

Afin de mettre en place une téléportation

quantique fonctionnelle, un état quantique intriqué doit

être créé pour que le qubit soit transmis. L'intrication

impose une corrélation statistique entre d'autres systèmes

physiques différents en créant ou en plaçant deux ou

plusieurs particules différentes dans un seul état quantique

partagé.

Cet état intermédiaire contient deux particules

dont les états quantiques dépendent l'un de l'autre car ils

forment une connexion: si une particule se déplace, l'autre particule se

déplacera avec elle. Tout changement dans une particule dû

à l'intrication se produira également pour l'autre particule, de

sorte que la particule intriquée agit comme un état quantique

unique. Ces corrélations sont maintenues même lorsqu'elles sont

sélectionnées et mesurées indépendamment, et il n'y

a pas de relation causale entre elles.

L'émetteur prépare la particule dans le qubit

et la fusionne avec l'une des particules intriquées dans l'état

intermédiaire, ce qui entraîne un changement de l'état

quantique intriqué.

L'état modifié de la particule intriquée

est ensuite envoyé à l'analyseur, qui mesurera ce changement de

l'état intriqué. La mesure des «changements» permettra

au récepteur de recréer les informations originales dont dispose

l'expéditeur, de sorte que les informations puissent être

transmises ou transportées entre deux personnes à des endroits

différents. Puisque les informations quantiques initiales sont

«détruites» lorsqu'elles font partie de l'état

intriqué, le théorème de non-clonage est maintenu car

l'information est recréée à partir de l'état

intriqué et ne sera pas copiée pendant le processus de

téléportation.

13

Canal quantique (EPR)

Un canal quantique est un mécanisme de communication

utilisé pour toute la transmission d'informations quantiques et un canal

utilisé pour la téléportation (la relation entre un canal

quantique et un canal de communication traditionnel est similaire au fait que

les qubits sont des analogues quantiques de bits classiques). Cependant, en

plus des canaux quantiques, les canaux traditionnels doivent également

être utilisés pour accompagner les qubits afin de «

préserver » les informations quantiques. Lors de la mesure du

changement entre le qubit d'origine et la particule intriquée, le

résultat de la mesure doit être transmis via un canal traditionnel

afin que les informations quantiques puissent être reconstruites et que

les informations d'origine puissent être obtenues par le

récepteur. En raison du besoin de canaux traditionnels, la vitesse de

transmission furtive ne peut pas être supérieure à la

vitesse de la lumière (elle ne viole donc pas le théorème

de non-communication).

Le principal avantage de ce système est qu'il peut

utiliser les photons du laser pour partager l'état de Bell, ce qui

permet de réaliser une transmission furtive en espace libre sans avoir

besoin d'envoyer des informations via des câbles physiques ou des fibres

optiques.

État quantique adiabatique (AQT)

Les chercheurs ont démontré pour la

première fois une méthode d'utilisation des qubits de spin

électronique pour transférer des informations entre les qubits,

appelée transfert d'état quantique adiabatique (AQT).

Contrairement à la plupart des méthodes qui reposent sur des

impulsions de champ électrique ou magnétique soigneusement

réglées pour transmettre des informations entre les qubits, la

transmission de l'état quantique adiabatique n'est pas affectée

par les erreurs d'impulsion et le bruit.

Les chercheurs ont prouvé l'efficacité de l'AQT

en utilisant l'intrication. Ces derniers peuvent utiliser l'AQT pour

transférer l'état de spin quantique des électrons à

travers quatre chaînes d'électrons dans des semi-conducteurs

à points quantiques, à l'échelle nanométrique avec

d'excellentes performances.

Cristaux temporels

Les cristaux temporels sont un état de la

matière dans lequel l'interaction entre les particules qui composent le

cristal peut stabiliser indéfiniment les oscillations du système.

Imaginez une horloge fonctionnant à l'infini ; le pendule oscille avec

le temps, comme un cristal temporel oscillant.

En imposant une série d'impulsions de champ

électrique aux électrons, il est possible de créer un

état similaire à un cristal temporel. Il est ensuite possible

d'utiliser cet état pour améliorer le transfert des états

de spin des électrons dans les chaînes de points quantiques

semi-conducteurs.

Actuellement, les ordinateurs quantiques utilisent les spins

des électrons pour construire la mémoire, les différents

spins représentant des 1 ou des 0 binaires. Un problème,

cependant, est que les spins des électrons ne sont pas si stables, et

que des forces externes telles que thermiques ou magnétiques

14

peuvent facilement interférer avec le spin choisi. Les

données ultérieures deviendront inexactes. Cependant, les

cristaux temporels constituent un système stable et

répétitif qui peut être gravé au laser selon des

motifs spécifiques. Une fois que nous pouvons écrire ou

réécrire les oscillations de ces systèmes stables, le

système résultant est une forme supérieure de stockage de

données.

Cryptographie

Code César

La cryptographie est une technique de fabrication et de

décodage de codes et de communication sécurisée. Son

histoire d'application militaire, diplomatique et commerciale remonte à

l'Antiquité. Le code César est un exemple bien connu de

système cryptographique. Chaque lettre de César est

remplacée par 2 lettres plus loin dans l'alphabet. C'est ce que l'on

appelle de la substitution ( Le C peut être remplacé par le F, par

exemple et ainsi de suite).

Primitives cryptographiques

Les primitives cryptographiques servant de briques de base

dans l'élaboration de systèmes de sécurité plus

complexes, elles se doivent d'être extrêmement fiables,

c'est-à-dire qu'elles doivent se conformer exactement à leurs

spécifications. Ainsi, si une fonction de chiffrement prétend ne

pouvoir être cassée qu'avec un nombre N d'opérations

informatiques alors, s'il est possible de la casser avec un nombre

inférieur à cette valeur nominale, on dit de cette primitive

qu'elle est compromise. Si une primitive cryptographique est compromise, tout

protocole l'utilisant devient virtuellement vulnérable.

Ce n'est qu'en les combinant au sein de protocoles de

sécurité que l'on peut résoudre une problématique

de sécurité complexe. Les primitives cryptographiques en

elles-mêmes, de par leur nature, sont assez limitées. Elles ne

peuvent être considérées comme un système

cryptographique à part entière.

L'exemple le plus ancien de primitive cryptographique

normalisée est le chiffrement par blocs Data Encryption Algorithm (DEA),

qui fait partie de la norme Data Encryption Standard (DES) publiée par

le gouvernement américain. Le gouvernement américain a ensuite

publié la description de la fonction de hachage SHA et de la signature

DSA. Cette normalisation n'a cependant pas été effectuée

de manière publique, ce qui posait des problèmes de confiance.

L'AES fut le successeur du DES, dont la normalisation a cette fois-ci

été publique.

Le transfert inconscient (Oblivious Transfert => QOT)

En tant que protocole cryptographique de base important, le

protocole de transfert inconscient est l'une des technologies clés pour

la protection de la vie privée en cryptographie. Ce dernier est un

15

protocole dans lequel l'expéditeur envoie de nombreuses

informations potentielles au récepteur, mais l'expéditeur

lui-même n'est pas au courant du contenu spécifique de la

transmission. Le concept de transfert inconscient quantique a été

proposé pour la première fois par Crépeau en 1994. Par la

suite, de nombreux travaux ont été consacrés à ce

protocole.

En 1994, la sécurité du "transfert inconscient"

contre toute mesure individuelle permise par la mécanique quantique a

été prouvée par Mayers et Salvail.

Depuis lors, une série de travaux ont

étudié d'autres primitives cryptographiques qui pourraient

exister dans le monde quantique. Cependant, le résultat ultérieur

était négatif. Mayers et Lo, Chau ont prouvé que la

participation idéale et sécurisée du qubit et la

transmission par inadvertance sont impossibles, de sorte que tout type de

calcul sécurisé entre deux parties est impossible.

il a également été montré que

plusieurs variantes imparfaites de ces primitives sont possibles. Trouver les

meilleurs paramètres pour ces primitives de base a toujours

été un problème non résolu. La raison pour laquelle

nous nous intéressons à ces primitives abstraites est qu'elles

constituent la base de tout protocole cryptographique que l'on pourrait

souhaiter construire, y compris les protocoles de sécurité. Les

protocoles cryptographiques que les gens peuvent souhaiter construire

comprennent les systèmes d'identification, les signatures

numériques, le vote électronique.

Projet Nessie

Le projet NESSIE, financé par l'Union

européenne sous le numéro IST-1999-12324, avait pour objectif

principal la sélection d'un portefeuille de primitives cryptographiques,

à recommander aux industriels européens.

Les primitives ci-dessous ont été

étudiées dans le cadre de ce projet :

· Chiffrement de flot. C'est une primitive

symétrique pour la confidentialité, qui consiste principalement

en la génération d'une suite de bits parfaitement

aléatoire en apparence.

· Chiffrement par bloc. C'est une autre primitive

symétrique pour la confidentialité, qui sert à chiffrer un

message de taille fixe (le bloc).

· Fonction de hachage cryptographique. C'est une

fonction en apparence injective, qui fabrique un condensé de taille fixe

à partir d'un message quelconque.

· Authentification de message (MAC). C'est une primitive

symétrique qui fabrique un condensé à partir d'un message

et d'une clé secrète.

· Chiffrement asymétrique. Il s'agit ici de

décrire un algorithme public permettant de chiffrer un message, tel que

seul le détenteur de la clé secrète soit capable de le

déchiffrer.

16

·

Signature numérique. Il s'agit ici de décrire un

algorithme public permettant de vérifier une signature d'un message, tel

que seul le détenteur de la clé secrète soit capable

d'avoir engendré une signature valide.

Sélection des primitives

Quatre chiffrements par blocs ont été

sélectionnés, deux d'entre eux pour une taille de bloc de 128

bits (Rijndael et Camellia), un pour 64 bits (Misty1) et un pour 256 bits

(Shacal-2)

· Aucun chiffrement de flot n'a été

sélectionné, car aucun n'atteint le niveau de

sécurité exigé.

· Quatre fonctions de hachage cryptographique ont

été sélectionnées (Whirlpool, SHA-256, SHA-384 et

SHA-512).

· Quatre techniques d'authentification de message ont

été sélectionnées (UMAC, TTMAC, EMAC et UMAC.

· Trois systèmes de chiffrement

asymétriques ont été sélectionnés (PSEC-KEM,

RSA-KEM et ACE-KEM.

· Trois systèmes de signature numérique

ont été sélectionnés (RSA-PSS, ECDSA et SFLASH.

Cryptographie actuelle et enjeux quantiques

La cryptographie et la sécurité des

réseaux sont des technologies clés pour assurer la

sécurité des systèmes d'information. La cryptographie

quantique est une branche importante de la cryptographie, combinant

mécanique quantique et cryptographie classique.

Échange de clés « Diffie Hellman »

L'échange de clés Diffie-Hellman a

été la première méthode populaire pour

élaborer et échanger des clés en toute

sécurité sur des canaux non sécurisés. Cet

algorithme permet de créer en toute sécurité une

clé partagée, même à travers un canal non

sécurisé qu'un attaquant peut surveiller, même si vous ne

l'avez jamais rencontré auparavant.

L'échange de clés Diffie-Hellman établit

un secret partagé entre deux parties qui peut être utilisé

pour des communications confidentielles afin d'échanger des

données sur des réseaux publics. Nous allons prendre un exemple

qui met en scène 2 personnes souhaitant échanger des couleurs.

Le processus commence avec Alice et Bob, ils choisissent une

couleur de départ qui n'a pas besoin d'être gardée

secrète (mais elle doit être différente à chaque

fois).

Dans cet exemple, la couleur est le bleu. Chaque personne

choisit également une couleur secrète à garder

elle-même - le vert et le rose dans ce cas. Alice et Bob mélangent

chacun leurs propres couleurs

17

secrètes avec les couleurs partagées, puis

échangent publiquement les deux couleurs mélangées. Enfin,

ils mélangent chacun les couleurs reçues de leur partenaire avec

leurs propres couleurs privées. Le résultat est le même

mélange final de couleurs que le mélange final de couleurs de son

partenaire.

Lorsqu'un tiers écoute l'échange, il ne

connaît que la couleur commune (bleu) et la première couleur

mélangée, mais il lui est difficile de déterminer la

couleur secrète finale. Cette décision est très exigeante

en termes de calcul afin de rendre l'analogie avec un échange

réel en utilisant un grand nombre de couleurs.

Protection des communications numériques

Aujourd'hui, presque toutes les communications

numériques sont protégées par trois systèmes

cryptographiques :

· Le chiffrement asymétrique (également

appelé chiffrement à clé publique, ou PKC) :

Solution retenue suite au projet Nessie, cette primitive

utilise une clé accessible au public pour permettre aux personnes de

chiffrer les messages envoyés au destinataire, qui est la seule personne

à disposer de la clé privée requise pour le

déchiffrement. Il est principalement utilisé pour établir

un canal crypté entre deux parties, que ce soit pour la

vérification d'identité ou la signature numérique.

Malheureusement, le cryptage à clé publique est

beaucoup plus lent que le cryptage à clé symétrique.

L'algorithme RSA est un exemple éminent de la PCC, qui s'appuie

fortement sur la structure algébrique de la factorisation des nombres

premiers ou des courbes elliptiques.

Les signatures numériques sont une autre application de

la PCC qui est utilisée plus largement. Dans ce cas, le détenteur

de la clé privée chiffre le hachage du document et joint le

condensé du message au document. Toute personne possédant la

clé publique peut vérifier que le document a été

signé par le détenteur de la clé privée. Les

algorithmes PKC sont sûrs du point de vue informatique et leur

sécurité repose sur la difficulté des calculs

mathématiques, comme la factorisation de grands nombres entiers. Il

n'existe aucun algorithme connu capable de résoudre ce type de calcul en

un temps raisonnable sur un ordinateur ordinaire. Lorsque la taille du facteur

premier augmente, le calcul devient plus difficile (pour les ordinateurs

normaux), ce qui a pour effet d'augmenter la taille de la clé.

· Cryptographie symétrique (également

connue sous le nom de cryptographie à clé, ou SKC) : Consiste en

des algorithmes qui chiffrent et déchiffrent les messages en utilisant

la même clé. L'utilisation de la même clé des deux

côtés (chiffré et décryptage) est un

inconvénient, car la

18

distribution des clés peut être difficile dans

certains cas. Il existe deux grandes classes d'algorithmes dans le SKC :

o Le chiffrement par flux, qui traite un message comme un flux

d'octets ou de lettres (généralement des octets), en chiffrant un

octet à la fois

o Le chiffrement par blocs, qui prend plusieurs bits et les

crypte en un seul bloc. La longueur du texte en clair doit être un

multiple de la taille du bloc, il est donc complété si

nécessaire. Les algorithmes de chiffrement par blocs couramment

utilisés sont AES, Twofish, Blowfish, RC4 et IDEA.

· Le hachage : Une fonction de hachage cryptographique

est un algorithme mathématique qui fait correspondre un condensé

ou un hachage de message de longueur fixe à des données ou des

messages de taille arbitraire.

Cependant, il existe certaines limitations. Les

condensés de messages doivent être calculés relativement

rapidement. La même entrée doit produire la même valeur de

hachage. Il doit être impossible de générer un message qui

donne une valeur de hachage spécifique. Il doit également

être impossible de trouver deux messages différents avec le

même condensé de message (collision).

Même une modification d'un bit dans le message original

peut avoir un effet si important sur le hachage de sortie que le nouveau

hachage n'a aucune corrélation discernable avec l'ancien. Cependant, en

raison de la longueur et du nombre arbitraires des valeurs d'entrée et

du nombre fixe de valeurs de sortie résultant d'une longueur fixe du

condensé de message, les collisions sont inévitables. En raison

des caractéristiques des ordinateurs quantiques, de nombreux

chiffrements à clé publique existants ne seront plus

sécurisés dans les ordinateurs quantiques. Cela montre que pour

résister aux ordinateurs quantiques, de nouveaux systèmes de

cryptage doivent être explorés. Ce n'est qu'ainsi que la

sécurité des informations pourra être assurée.

L'objectif principal de la recherche sur la cryptographie

quantique est de concevoir des algorithmes et des protocoles cryptographiques

qui entrent en conflit avec les attaques informatiques quantiques. Comme

mentionné précédemment, l'exploration des protocoles

cryptographiques quantiques constituera une partie importante des futurs

problèmes de sécurité du cyberespace Internet.

19

Distribution de clés quantiques (QKD)

Quantum Key Distribution (QKD) utilise les principes de la

mécanique quantique pour envoyer des communications

sécurisées, permet aux utilisateurs de se distribuer en toute

sécurité des clés et permet des communications

cryptées qui ne peuvent pas être décryptées par des

espions. Le système QKD protège la communication, mais ne crypte

pas les données de communication comme les certificats de

sécurité quantique.

Le système QKD établit une clé

privée partagée entre deux parties connectées et utilise

une série de photons (particules lumineuses) pour transmettre des

données et des clés via des câbles à fibres

optiques.

L'échange de clés avec QKD fonctionne sur la

base du principe d'incertitude de Heisenberg en mécanique quantique,

à savoir que les photons sont générés de

manière aléatoire dans l'un des deux états quantiques

polarisés et que la propriété quantique d'un photon ne

peut être mesurée sans altérer l'information quantique

elle-même.

Ainsi, les deux extrémités connectées

d'une communication peuvent vérifier la clé privée

partagée et la sécurité de son utilisation, tant que les

photons ne sont pas altérés. Si un acteur malveillant

accède à un message ou l'intercepte, le fait d'essayer de

connaître les informations clés modifie la propriété

quantique des photons. Le changement d'état d'un seul photon est

détecté et les parties savent que le message a été

compromis et qu'il n'est pas digne de confiance.

Bennett et Brassard ont proposé le premier protocole

QKD pratique en 2011. Ils ont pris les devants dans la réalisation du

protocole de distribution de clé quantique en utilisant la technologie

de polarisation à photon unique. Par la suite, de nombreux efforts ont

été faits dans le domaine du QKD pour améliorer la

sécurité et l'efficacité.

En 1991, Ekert a proposé un accord basé sur le

théorème de Bell. En 1992, Bennett a proposé des

améliorations au plan. En utilisant deux états non orthogonaux

quelconques, cette amélioration est plus efficace et simple.

Après cela, de nombreux protocoles QKD utilisant les principes de base

de la mécanique quantique ont été proposés.

Les protocoles de cryptographie quantique comprennent

également les protocoles d'engagement de bit quantique (QBC) et les

protocoles de signature quantique (QS).

Pour fonctionner correctement, tout système utilisant

QKD doit transmettre des données quantiques et non-quantiques à

partir de sources et destinations spécifiques, gérer des

clés secrètes partagées entre des noeuds de confiance

adjacents sur un mécanisme à sauts multiples.

20

Pour les données non-quantiques, une

fonctionnalité similaire peut être fournie par le biais de

protocoles de niveau inférieur par défaut tels que TCP/IP,

Ethernet, etc., mais la transmission des données quantiques

nécessite l'établissement de nouveaux protocoles de cryptage.

Nous devons donc concevoir une nouvelle interface de service pour fournir une

solution de cryptage performante à la partie quantique du flux de

protocole.

L'interface de service doit fournir les services suivants :

Protocole de la couche réseau pour la gestion des sous-réseaux

QKD, synchronisation/démultiplexage des clés QKD et clé

QKD multi-sauts. Identique aux autres niveaux de QKD Les messages entre pairs

de la couche service doivent être protégés en termes

d'intégrité, alors que les messages de configuration de routage

de la couche réseau peuvent ne pas l'être.

Mais avant que les professionnels ne puissent obtenir une

solution de cryptage capable de faire face à la puissance de traitement

des ordinateurs quantiques, il reste encore de nombreux problèmes

à résoudre.

Le premier est la taille de la clé elle-même.

Dans l'algorithme post-quantique en cours de développement, la taille de

la clé varie de 40 000 octets à un mégaoctet (par rapport

aux centaines ou milliers de bits de l'algorithme actuel). Cela signifie

trouver un moyen efficace de stocker ces clés.

Lors du développement de la cryptographie

post-quantique, les besoins en bande passante sont également un

problème, car avec l'avènement des ordinateurs quantiques, les

besoins en bande passante peuvent augmenter considérablement. Il en va

de même pour l'infrastructure et l'architecture réseaux existants,

qui peuvent nécessiter une mise à niveau ou même un

remplacement pour prendre en charge ces nouvelles solutions. En clair, il

s'agit actuellement d'une technologie coûteuse qui nécessite un

matériel spécialisé. La transition n'en est encore

qu'à ses débuts, et les distances de transfert sont

limitées tant qu'il n'y aura pas de répéteurs quantiques

performants.

Par rapport aux méthodes actuelles d'échange de

clés purement logicielles, à travers le réseau, QKD est

limité au sous-réseau auquel son matériel est

connecté. Ainsi, si QKD est entre deux noeuds du réseau, certains

contrôles supplémentaires sont nécessaires pour la

vérification.

L'urgence de la situation est un problème en soi : le

chiffrement est profondément enraciné dans de nombreux

systèmes différents, ce qui signifie qu'il faudra un certain

temps pour les démêler et déployer de nouveaux

systèmes.

TLS

Le protocole TLS (Transport Layer Security) est basé

sur le protocole SSL (Secure Session Layer) antérieur et est

invoqué explicitement par les applications. Bien qu'il soit maintenant

largement utilisé

21

parmi diverses applications, il est le plus souvent

utilisé pour chiffrer le trafic entre les serveurs web et les

navigateurs.

Le TLS « handshake » permet à deux parties

de convenir d'une méthode d'accord de clé et d'algorithmes de

chiffrement et MAC (collectivement appelés suites de chiffrement)

utilisés pour protéger les données.

Les deux parties utilisent ensuite un processus de partage de

clés pour convenir d'un secret maître commun que l'une ou les deux

parties peuvent authentifier au cours de ce processus. Enfin, elles utilisent

la clé maîtresse pour obtenir les clés de chiffrement et

MAC. Le protocole d'enregistrement TLS utilise des clés et des

numéros de séquence établis pour chiffrer et

protéger l'intégrité des paquets (empêche le tri

malveillant des paquets dans le flux de données).

Le mécanisme de sécurité TLS ne repose

sur aucun algorithme cryptographique particulier et met en oeuvre un

modèle de confiance à clés publiques et

pré-partagées. L'algorithme par défaut est

spécifié pour favoriser l'interopérabilité. Le

premier échange aller-retour du protocole de poignée de main TLS

spécifie la suite de chiffrement à utiliser pendant et

après la session TLS. Les échanges sont utilisés pour

établir un secret partagé et authentifier une ou les deux

parties.

IPSec

IPSec est un ensemble de protocoles qui assurent la

sécurité des communications Internet au niveau de la couche

réseau. IPsec doit donc également gérer toute erreur non

malveillante dans le flux de données. L'utilisation la plus courante

d'IPsec aujourd'hui consiste à déployer un réseau

privé virtuel (VPN) entre deux sites (gateway-to-gateway) ou entre des

utilisateurs distants et le réseau de l'entreprise (host-to-gateway).

IPsec fournit également une sécurité de bout en bout.

Des contrôles de sécurité existent pour

les communications réseau à différents niveaux du

modèle ISO. Les contrôles appliqués à la couche

réseau s'appliquent à toutes les applications et ne sont pas

spécifiques à une application. Par exemple, toutes les

communications réseau entre deux hôtes ou réseaux peuvent

être sécurisées à ce niveau sans qu'il soit

nécessaire de modifier l'application sur le client ou le serveur. Les

contrôles de la couche réseau fournissent également aux

administrateurs de réseau un moyen d'appliquer des politiques de

sécurité spécifiques.

Un autre avantage des contrôles de la couche

réseau est que, puisque les informations IP (par exemple, les adresses

IP) sont ajoutées à cette couche, les contrôles peuvent

protéger à la fois les données contenues dans les paquets

et les informations IP de chaque paquet. Cependant,

les contrôles de la couche réseau offrent moins

de contrôle et de flexibilité pour protéger des

applications spécifiques que les contrôles des couches transport

et application.

22

IPsec est un protocole comportant les éléments

suivants :

· Deux protocoles de sécurité,

Authentication Header et Encapsulating Security Payload. L'entête AH

assure la protection de l'intégrité sans confidentialité.

ESP et AH fournissent tous deux une authentification de l'origine des

données, un contrôle d'accès et, en option, une protection

contre le rejeu et/ou une protection contre l'analyse du trafic.

· Le protocole IKE (Internet Key Exchange) est le

protocole de gestion des clés privilégié pour IPsec. IKE

négocie les algorithmes de chiffrement et les paramètres connexes

pour AH et ESP. IPsec utilise également IKE pour négocier les

paramètres de connexion IPsec ; authentifier les points

d'extrémité ; définir les paramètres de

sécurité pour les connexions protégées par IPsec ;

gérer, mettre à jour et supprimer les canaux de communication

protégés par IPsec.

La protection assurée par IPsec et par IKE pour son

propre trafic d'échange de clés nécessite l'utilisation

d'algorithmes de chiffrement, notamment des algorithmes de cryptage, des MAC

(Message Authentication Codes for Integrity Protection) et des Prfs (Fonction

pseudo-aléatoire qui génère les clés et autres

valeurs utilisées dans le protocole IPsec). Les mécanismes de

sécurité IPsec ne dépendent pas d'un algorithme de

chiffrement spécifique. Cependant, des algorithmes standard sont

spécifiés pour favoriser l'interopérabilité.

Comment intégrer QKD dans les protocoles de

sécurité actuels ?

Nous pouvons appliquer deux modèles pour connecter QKD

aux applications sécurisées. L'un est l'interface de service QKD

fournit la clé pour l'application, et l'application permet à

l'application de traiter les données de l'application. Les messages sont

chiffrés, authentifiés et transmis comme ils le sont

actuellement. Ce qui permet à cette interface d'agir comme la fonction

d'échange de clés pour l'application de sécurité.

Un autre modèle est Enregistrer les clés dans l'interface de

service QKD et demander à l'application de les transmettre Les messages

sont chiffrés, authentifiés et transmis de bout en bout. en ont

besoin pour cela L'application sécurisée fournit à

l'interface de service QKD les chiffres chiffrés et Le MAC

utilisé pour l'algorithme d'intégrité, et la destination

du message de bout en bout.

Alors que les deux modèles devraient être

capables d'atteindre le même niveau de sécurité, nous

pensons que le traitement des messages par la couche de support QKD reproduit

la fonctionnalité existante du protocole de sécurité,

introduisant potentiellement des conséquences inattendues et contournant

tous les efforts de spécification et de validation. Prouvé.

Tout en suivant le modèle d'échange de

clés, nous essayons de minimiser l'impact sur les protocoles existants

en maintenant l'intégration de la QKD dans la plus petite partie

possible de l'application.

23

Une façon d'intégrer QKD à IPsec est de

conserver QKD dans IKE au lieu de créer une fonction d'échange de

clés parallèle. IKE accède à la clé QKD sur

commande au lieu de la calculer. Cette approche a deux objectifs. Tout d'abord,

elle évite de développer une autre fonction d'échange de

clés qui serait source de duplication des efforts, de bogues et de

conséquences involontaires. Les fonctions sont pleines de duplications,

de bogues et de conséquences involontaires.

Deuxièmement, il encapsule QKD en dehors du protocole

de sécurité lui-même. Bien que TLS ne dispose pas d'une

fonction d'échange de clés explicite comme IKE, cette fonction

est intégrée au protocole et l'intégration de QKD devrait

minimiser tout impact.

Utilisation de QKD dans IPsec et TLS

IPsec et TLS développent tous deux un secret

partagé, qui est ensuite utilisé pour calculer les clés de

chiffrement et de protection de l'intégrité. Par

conséquent, le matériel QKD peut être utilisé dans

TLS, IPsec et IKE en tant que secret partagé, clé secrète

ou comme mot de passe à usage unique :

Les clés quantiques peuvent être

utilisées pour établir des secrets partagés pour les

sessions TLS ou les SA IKE. Dans ce cas, la clé quantique remplacera la

clé partagée calculée dans IKE et la clé

pré-maître ou maître dans TLS, éliminant ainsi la

nécessité de calculer la clé partagée.

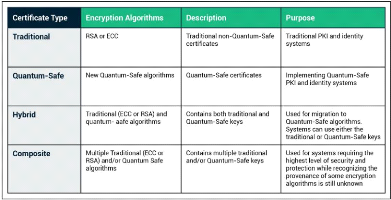

Les différents types de certificats

· Certificat PKI traditionnel : Le certificat PKI

traditionnel est aujourd'hui la référence en matière

d'authentification et de cryptage d'identité numérique. Ces

certificats sont dits « traditionnels » car ils utilisent des

algorithmes de chiffrement ECC ou RSA existants. La plupart des systèmes

PKI continueront à utiliser les certificats PKI traditionnels pendant un

certain temps encore. Ils offrent une protection efficace contre les attaques

informatiques existantes, mais à l'avenir, ils seront obsolètes

contre les ordinateurs quantiques et les attaques quantiques sur les cryptages

ECC et RSA.

· Certificat de sécurité quantique : Les

certificats de sécurité quantique sont des certificats X.509 qui

utilisent des algorithmes de chiffrement de sécurité

quantique.

· Certificat hybride : Les certificats hybrides sont des

certificats à signature croisée qui contiennent des clés

et des signatures traditionnelles (RSA ou ECC) et des clés et signatures

de sécurité quantique. Les certificats hybrides sont une voie de

migration pour les systèmes qui ont plusieurs composants et ne peuvent

pas être mis à niveau ou remplacés en même temps. Les

certificats hybrides permettent au système de migrer progressivement,

mais finalement tous les systèmes qui utilisent le cryptage ECC ou RSA

doivent migrer vers le nouvel algorithme de cryptage de sécurité

quantique.

24

·

Certificat composite : Les certificats composites sont

similaires aux certificats hybrides en ce qu'ils contiennent plusieurs

clés et signatures, mais ils diffèrent en ce qu'ils utilisent une

combinaison d'algorithmes de chiffrement existants et d'algorithmes de

chiffrement de sécurité quantique. Le certificat composite est

comme une porte avec plusieurs serrures : Il faut avoir toutes les clés

de toutes les serrures pour ouvrir la porte.

L'objectif de la clé composite est de dissiper la

crainte qu'un algorithme de chiffrement, qu'il soit actuellement disponible ou

disponible à l'avenir, ne soit craqué par un ordinateur

quantique. Si une vulnérabilité exploitable est trouvée

dans un algorithme de chiffrement, l'ensemble du système restera en

sécurité.

https://sectigo.com/resource-library/quantum-cryptography

1.3 Acteurs engagés et secteurs concernés

Les géants de l'informatique et les startups

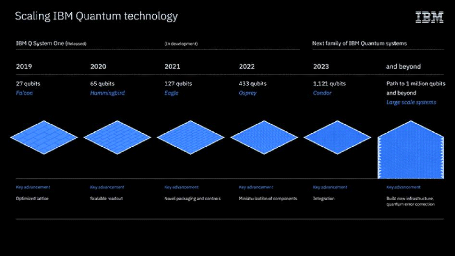

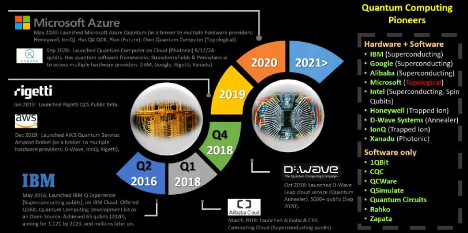

C'est en 2016 que la société IBM a mis au point

un ordinateur à cinq Qubits via le Cloud. Ce dernier aurait

évolué en 2017 et embarque désormais vingt Qubits.

La firme a également, durant cette même

année, mis en place un ordinateur à cinquante Qubits ( qui ne se

trouve pas dans le Cloud). L'état de cette machine fut cependant

instable et ne tenait son état quantique que pendant 90

microsecondes.

Selon le CEO d'IBM, Arvind Krishna, une commercialisation des

premiers ordinateurs quantiques devrait être possible pour 2023.

25

L'entreprise à dévoiler une feuille de route de

l'évolution de leur progression en matière d'informatique

quantique. L'entreprise à d'or et déjà commencé le

développement du processeur Quantique « Eagle » doté de

127 qubits.

https://www.ibm.com/blogs/research/2020/09/ibm-quantum-roadmap/

Des startups se sont également lancées dans

l'étude des systèmes quantiques, comme D-wave, startup

canadienne, qui a annoncé avoir mis au point un ordinateur à 2000

qubits, ou Rigetti, startup Californienne, qui privilégie la

stabilité plutôt que le nombre de qubits. Ce mode

opératoire pourrait leur permettre de créer un véritable

ordinateur quantique utilisable.

La Chine s'est également lancée dans la course.

Après que Google ait annoncé avoir atteint la «

suprématie quantique » en 2019, grâce à leur

processeur quantique « Sycamore » ait effectué en 3 minutes et

20 secondes une tâche qui nécessiterait 10 000 ans à un

ordinateur classique.

Les chercheurs chinois annoncent en 2020 que leur

système « Jiuzhang » serait « dix milliards de fois plus

rapides que Sycamore ». La différence fondamentale entre le

système américain de Google et le système chinois

réside dans la composition des qubits.

Pour appuyer leurs dires, un calcul complexe, «

l'échantillonnage de boson », qui consiste à calculer la

production d'un circuit optique extrêmement complexe où des

photons rebondissent contre des miroirs, a été résolu en

quelques minutes. A titre de comparaison, les chercheurs ont estimé que

le superordinateur le plus puissant aujourd'hui, Fugaku, aurait mis six cents

millions d'années à résoudre ce même

problème.

26

Les qubits de Google étaient à base de

métal, tandis que les qubits chinois étaient à base de

photons. Cette nuance aurait grandement aidé Jiuzhang à atteindre

de tels résultats, de par la non nécessité de refroidir le

système car les photons restent stables même à

température ambiante, contrairement à son homologue

américain, qui impose un contrôle minutieux du refroidissement de

ce dernier.

Cette expérience démontre d'une part des

résultats sans précédent, mais d'autre part que des

systèmes quantiques basés sur la lumière sont capables de

prouesses calculatoires, agrandissant de fait le champ des possibles en

matière de technologie quantique.

https://andisama.medium.com/quantum-computing-challenges-opportunities-b13286203a2b

QuTech Research Center : Mise en place du réseau à

trois noeuds quantiques

Les chercheurs du centre de recherche QuTech, basé sur

Delft aux Pays-Bas, ont créé le système, qui se compose de

trois noeuds quantiques. C'est la première fois que plus de deux qubits

sont reliés entre eux en tant que noeuds

La plus grande difficulté résidait dans le fait

de maintenir l'intrication entre 2 qubits. Une nouvelle fois, ce cas pratique

illustre la place centrale qu'offre le principe d'intrication au sein des

technologies quantiques.

Étendre un réseau quantique de deux noeuds

à trois noeuds, et éventuellement de trois à plusieurs

noeuds, n'est pas aussi simple que d'ajouter plus de liens. Le fait que le

bruit (qui détruit les informations quantiques) et les niveaux de

puissance optique varient considérablement dans tout le réseau,

ce qui complique la tâche.

27

L'équipe de Delft résout ce problème en

utilisant un système stable à deux volets. Le premier

élément ici est de stabiliser l'enchevêtrement entre le

qubit de communication et le qubit «volant».

À cette fin, l'équipe a mesuré la phase

de la lumière réfléchie par la surface du diamant pendant

le processus d'enchevêtrement et a utilisé un faisceau laser plus

puissant pour améliorer ce signal de phase faible. Le choix de la

polarisation garantit que la lumière réfléchie n'atteint

pas le détecteur qui enregistre l'intrication, ce qui peut produire un

faux signal d'intrication. La phase de la lumière amplifiée est

mesurée par d'autres détecteurs, et

l'interféromètre est stabilisé en renvoyant le signal de

phase mesuré au contrôleur piézoélectrique où

son miroir est placé.

La deuxième partie intégrante de la

stabilité consiste à diriger une certaine lumière laser

vers un interféromètre séparé, qui est

utilisé pour créer un enchevêtrement entre les noeuds.

Mesurer l'interférence et coupler le signal à une rallonge de

fibre dans le bras de l'interféromètre. En étirant la

fibre optique, la phase de la lumière dans le bras peut être

contrôlée et l'interféromètre peut être

stabilisé. Le schéma de stabilité local et global peut

être adapté à n'importe quel nombre de noeuds, ce qui

permet d'étendre le réseau.

L'objectif de l'entreprise est de relier les villes de Deflt

et La Haye, distantes l'une de l'autre de dix kilomètres. Actuellement,

leur système multinoeud sont situés à une distance de dix

à vingt mètres.

Des scientifiques de la NASA et leurs partenaires

réalisent pour la première fois une "téléportation

quantique" à longue distance.

Pour la première fois, un groupe de scientifiques et

de chercheurs a réussi à réaliser une

"téléportation quantique" haute-fidélité et durable

- la transmission instantanée de l'unité de base "qubit" de

l'information quantique. La NASA et son équipe ont

démontré avec succès la transmission à distance et

continue de qubits de photons avec une fidélité supérieure

à 90%. En utilisant les détecteurs à photon unique les

plus avancés et l'équipement standard, les qubits sont transmis

à 44 kilomètres (27 miles) à travers un réseau de

fibre optique.

La place de la France dans cette course au quantique

La France entend bien participer au développement des

technologies quantiques, et en devenir un puissant acteur.

Un budget d'1.8 Milliard d'euros est prévu

d'être alloué dans les domaines de la recherche, de l'industrie et

de la formation aux technologies quantiques.

Selon Monsieur Emmanuel Macron « Le quantique fait

partie des quelques clés du futur que la France doit avoir en main

». La France compte déjà des scientifiques,

ingénieurs et indépendant se consacrant à l'étude

des technologies quantiques. Nous aurions toutes les cartes en main pour

assurer une

28

souveraineté et une indépendance en la

matière, seul un besoin budgétaire est requis pour permettre

l'évolution de la R&D quantique.

Afin de concurrencer Les États-Unis et la Chine, la

France compte bien coopérer avec le reste de l'Europe. Des programmes de

financement sont également prévus pour nos voisins

européens tels que l'Allemagne, l'Angleterre ou encore les Pays-Bas. La

France espère des résultats concrets en 2026, notamment

l'achèvement d'un ordinateur quantique entièrement

fabriquée et assemblée sur notre territoire. Cette

expérience tente de démontrer deux points:

· L'état superposé ne peut pas exister

à une échelle macroscopique. En fait, il est impossible d'avoir

un chat à la fois mort et vivant.

· La mesure a en effet changé l'état du

système, il est dans un état de superposition quantique, et est

maintenant dans un état défini.

L'existence de cette superposition d'états montre

clairement qu'après une certaine étape de miniaturisation, les

calculs classiques à base de bits ne peuvent plus être

utilisés. Sans valeurs stables de 0 et 1, le résultat ne peut

être garanti, ce qui va à l'encontre des principes de base du

calcul. Cependant, il est possible d'utiliser le fait qu'il y a à la

fois 0 et 1 en même temps pour calculer la possibilité de deux

valeurs en même temps. C'est là qu'intervient l'informatique

quantique.

Les secteurs visés Quantum Cloud

Azure Quantum

Le 1er février 2021, Microsoft a lancé Azure

Quantum en avant-première (version beta), rendant sa plateforme de cloud

computing quantique accessible à tous

Azure Quantum est un service fourni par Microsoft via son

cloud Azure. Le service comporte deux parties différentes,

l'informatique quantique et l'optimisation. Les deux peuvent être

déployés en créant des ressources Quantum Workspace dans

Azure.

Avec l'informatique quantique Azure, nous pouvons utiliser le

langage de programmation Q# et

QDK (Quantum Development Kit) pour développer des

algorithmes quantiques. Q# et QDK sont tous deux open source. QDK comprend des

bibliothèques spécifiques pour la

chimie, l'apprentissage automatique et le calcul quantique.

Nous pouvons utiliser nos outils préférés : Visual Studio,

VS Code et Jupyter Notebooks. Les algorithmes mis en oeuvre peuvent être

exécutés à petite échelle à l'aide du

simulateur QDK local, ou il est possible de télécharger sur le

cloud en tant que tâches à l'aide de l'espace de travail

Quantum.

29

Quantum Gaming

Grâce aux jeux vidéo, il est devenu possible de

découvrir les limites des systèmes informatiques, ce qui a

également contribué à l'amélioration des premiers

jeux vidéo pour PC quantiques, les jeux vidéo sur les

systèmes informatiques quantiques. Tant du côté d'IBM

Quantum que de Microsoft, des didacticiels simples et faciles à

utiliser, avec des facteurs ludiques, ou même des didacticiels sur la

création de jeux vidéo et de différents logiciels sur des

systèmes informatiques quantiques ont également vu le jour. Les

premiers essais de jeux vidéo sur des systèmes informatiques

quantiques ont été réalisés en 2017 sur le premier

dispositif IBM Quantum accessible au public, à l'aide du kit

d'amélioration de la machine récemment lancé, le Project

Q. Adapté pour correspondre à l'électricité des

qubits disponibles à l'époque, le jeu « Cat/Box/Scissors

», inspiré du « Pierre/Feuille/Ciseaux », fut le premier

jeu fonctionnant sur un ordinateur quantique.

Ce jeu s'inspire des règles du classique «

Pierre/Feuille/Ciseaux », mais avec une dimension hasardeuse

apportée par le quantique.

Un autre jeu a été développé,

« Quantum Battleship ». Ce dernier est capable d'englober plus

clairement les phénomènes quantiques d'intrication entre qubits

et de cohérence dans un qubit, car ces derniers contenaient une grande

quantité de bruit. Ces deux jeux vidéo étaient

entièrement jouable en ligne de commande.

Un ordinateur quantique est capable de créer à

l'avance certains types de données souhaitées pour un jeu, ce qui

donne par conséquent la possibilité de développer un jeu

quantique qui pourrait être plus rapide et plus réactif qu'un jeu

classique exécuté sur un ordinateur quantique. Cela a conduit

à l'amélioration du Quantum Solitaire, un jeu de cartes sur

Internet développé à l'aide d'Unity. Dans ce jeu, le

caractère aléatoire est généré de

manière traditionnelle, mais en se basant totalement sur les

possibilités calculées à partir d'un prototype de PC

quantique.

Ainsi, même si le jeu fait appel à la

non-localité quantique à un moment donné, il est

régi par un exemple où ce phénomène a

été mis en oeuvre de manière honnête. Dans ce jeu,

l'objectif consiste à rassembler toutes les cartes rouges et noires en

utilisant le moins de tours possible. Ici, le participant peut également

utiliser l'expertise de la mécanique quantique pour tirer des

conclusions sur les combinaisons possibles afin de tirer les meilleures

combinaisons de cartes à jouer qui offrent les meilleures chances de

succès.

Médecine & santé

Le domaine de la santé serait l'un des secteurs les

plus friands des technologies quantiques ; des modélisations d'atomes de

molécules seront possibles avec la puissance de calcul d'un ordinateur

quantique. Ces dernières pourront servir à l'élaboration

de nouveaux procédés médicaux, à la

30

conception de médicaments. Des maladies comme Alzheimer

ou Parkinson seront peut-être curables notamment grâce à

l'apport technologique qu'offre les technologies quantiques.

L'amélioration de la puissance de calcul pourra

également permettre d'apporter des soins plus personnalisés aux

patients. Les modèles de facteurs de risques déjà

existants, qui permettent de définir les antécédents

médicaux d'un patient et ainsi estimer le risque de développer

certaines maladies, seront plus complets et précis.

Au cours des deux dernières décennies, le

domaine de l'information et de l'informatique quantiques a progressé au

point que l'on peut théoriquement démontrer que les ordinateurs

quantiques peuvent exploiter des effets quantiques tels que l'intrication et la

superposition quantiques pour résoudre des problèmes de calcul