Chapitre II : Réalisation

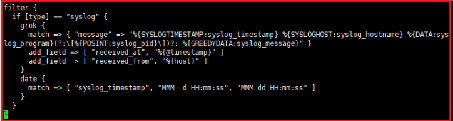

On va créer un fichier `syslog-filter.conf' contenant la

configuration du fichier du filter. Comme pour le input le contenu du fichier

filter va se situer dans la section filter{}

La fonction grok permet de correspondre des données log

non structurées en entrée à des champs qu'on peut ajouter

pour mieux structurer la sortie du filtre. Les agent beats effectuent un

filtrage par défaut donc cette partie peut être

négliger.

Figure 13 : Fichier de configuration filter de

Logstash

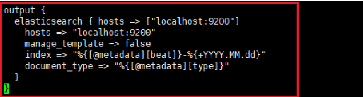

Nous allons maintenant crée le fichier

`output-elasticsearch.conf' et y indiquer des instructions indiquant à

Logstash d'envoyer les log après filtrage à Elasticsearch sur

l'adresse `localhost :9200' puisque celui-ci est installé sur la

même machine que Logstash et nous allons indiquer l'index à

instruire dans Elasticsearch.

Figure 14 : Configuration du fichier output de

Logstash

Si notre configuration est sans erreur, nous pouvons

démarrer Logstash pour qu'il puisse prendre en compte les changements de

configuration et activer l'auto démarrage.

|

sudo systemctl start logstash sudo systemctl enable logstash

|

33

Chapitre II : Réalisation

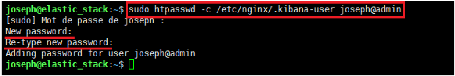

3.5 Configuration Nginx

Nginx servira comme proxy inverse HTTPS et offrira un

accès externe à l'aide d'un utilisateur et un mot de passe. On

crée un utilisateur joseph@admin avec un mot de passe à travers

la commande « htpasswd » pour restreindre l'accès à

l'interface Kibana à notre administrateur seulement. Ceci sera

stocké dans le fichier "/etc/nginx/htpasswd.user".

Figure 15 : Génération du mot de

passe

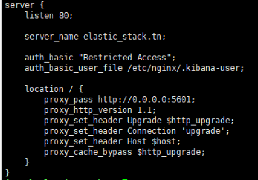

Par la suite, on doit configurer Nginx pour rediriger les

requêtes Kibana vers le HTTP (port 80) en précisant les chemins

vers le certificat SSL et la clef privée du serveur. Nous devons

maintenant créer un nouveau fichier de configuration d'hôte

virtuel dans le répertoire conf.d. Pour ce faire on crée un

fichier 'kibana.conf' avec les configurations suivantes :

Figure 16 : Configuration de Nginx pour le

reverse proxy

3.6 Configuration de Filebeat

Filebeat prend en charge de nombreuses sorties, mais nous

enverrons généralement les événements que

directement à Elasticsearch ou à Logstash pour un traitement

supplémentaire.

34

|