|

Élaboration des critères de performance des

établissements privés de l'enseignement supérieur

INTRODUCTION

Au lendemain des indépendances, les Gouvernements

Africains prirent une conscience aiguë du rôle capital que

l'éducation peut jouer dans le processus du développement

économique et social. Aussi, le Bénin dès 1972,

était-il contraint d'opérer une réforme de son

système éducatif, afin que l'école béninoise soit

un véritable instrument de lutte contre le sous-développement et

de formation de capital humain. L'éducation peut se définir en

termes généraux, en tant qu'ensemble des méthodes de

formation humaine, et de manière plus étroite en tant que

processus survenant dans les institutions spécialisées. Elle

constitue indiscutablement la forme essentielle d'épanouissement des

ressources humaines. Selon Khôï (1967, 13), «

l'éducation peut être définie comme l'ensemble des

processus qui forment les hommes et les préparent à leur

rôle dans la société ». De ce fait, le

secteur de l'éducation joue un rôle primordial dans le

développement économique et social.

Au Bénin, la constitution du 11 décembre 1990 et

les résolutions des États Généraux de

l'éducation, en exprimant une volonté populaire, affirment que

l'éducation est la première priorité du pays. La nouvelle

loi d'orientation de l'éducation nationale (loi n02003-17 du

17 octobre 2003) en ses articles 1, 2, 3 et 4 précise et insiste sur le

principe que l'école doit permettre à tous d'avoir accès

à la culture, à la science et au savoir-être. Ce secteur

est subdivisé en quatre (04) domaines dont l'Enseignement

Supérieur. Ce dernier est assuré à la fois par le public

et le privé. Le secteur privé de l'enseignement supérieur,

composé de centres privés et des universités

privées, est sous l'autorité du Ministère de

l'Enseignement Supérieur et de la Recherche Scientifique. Il forme les

étudiants dans de diverses filières compte tenu du besoin ou de

la demande exprimée par le marché de l'emploi.

Les étudiants formés dans les établissements

privés de l'enseignement supérieur, comblentils l'attente des

offreurs d'emplois ?

Les établissements privés apportent-ils une

solution à la gestion du flux des étudiants? Les programmes de

formation sont-ils respectés ?

Quelle est l'efficacité externe des établissements

privés?

Les enseignants qui interviennent dans ces établissements

sont-ils qualifiés?

C'est pour tenter de réponses à ces questions

que nous avons choisi de réfléchir sur le thème : «

élaboration des critères de performance des

établissements privés de l'enseignement supérieur

». Le présent travail s'articule autour de deux (02) parties:

- La première partie présente

l'intérêt de l'étude à travers la

problématique et informe sur les objectifs fixés ainsi que les

hypothèses sous-jacentes. Il s'agit de présenter

également, les travaux déjà réalisés sur le

classement des établissements d'enseignement supérieur ;

- La deuxième partie est consacrée d'une part

à la méthodologie utilisée, aux résultats de

l'étude ainsi qu'à leur analyse, la présentation de

l'indicateur et ses valeurs par établissement. D'autre part, une

étude comparée de l'indicateur avec ses principales variables a

été réalisée. Elle comporte enfin l'analyse des

résultats, les limites de l'indicateur ainsi que les recommandations

formulées.

CHAPITRE 1 : Cadre institutionnel de l'étude

Cette partie est décomposée en deux : la

première renseigne sur le cadre institutionnel et la seconde concerne la

présentation du cadre d'étude

1.1 Cadre institutionnel : Historique et mission de

MESRS 1.1.1 Historique de MESRS

Situé à Cotonou, capitale économique du

Bénin, le MESRS est l'un des Ministères en charge de

l'éducation au Bénin. En effet, l'administration du

système éducatif béninois a connu toutes sortes d'avatars.

Le cadre institutionnel a varié au rythme des changements politiques.

Jusqu'à l'avènement de la Réforme de 1975, un seul

ministère, le Ministère de l'Éducation Nationale, de la

culture, de la Jeunesse et des sports s'occupait du secteur. De 1975 à

la Conférence des Forces Vives de la Nation (Février 1990),

quatre ministères se sont partagés la tutelle du système

qui a mis en place un modèle de développement socialiste. Avec

les contestations à la fois politiques et institutionnelles de 1990, on

est revenu à un Ministère de l'Éducation Nationale et de

la Recherche Scientifique, la Culture et l'Alphabétisation étant

toujours logées dans un autre ministère. En 2001 de nouveau,

l'Éducation est placée sous la tutelle de quatre

ministères :

- Le Ministère de l'Enseignement Primaire et Secondaire

(MEPS), qui s'occupe aussi de l'enseignement maternel qui n'est pas

explicitement mentionné dans la dénomination du

ministère.

- Le Ministère de l'Enseignement Technique et de la

Formation Professionnelle (METFP) a en charge l'éducation formelle (les

établissements d'enseignement technique et de formation professionnelle)

et l'éducation non formelle (les apprentissages)

- Le Ministère de l'Enseignement Supérieur et de

la Recherche Scientifique (MESRS) dont relèvent les universités

et tous les établissements d'enseignement supérieur (les

Instituts Universitaires de Technologie et les établissements de

formation au BTS et autres formations professionnelles)

- Le Ministère de la Culture, de l'artisanat de du

Tourisme (MCSL) définit et gère la politique culturelle du

Bénin. Il s'occupe de l'alphabétisation des adultes.

En Avril 2006, le Ministère de l'Enseignement Technique

et de la Formation Professionnelle (METFP) et le Ministère de

l'Enseignement Supérieur et de la Recherche Scientifique a

été fusionnés en un seul ministère,

Ministère de l'Enseignement Supérieur et de la Formation

Professionnelle (MESFP). L'alphabétisation est placée sous la

tutelle du Ministère de la culture, des Sports et Loisirs (MCSL). Un an

plus tard ; les ministères ont changé de dénomination pour

devenir Ministère de l'Enseignement Maternel et Primaire

(MEMP) ; Ministère de l'Enseignement Secondaire et de

la Formation Professionnelle (MESFP) et le Ministère de l'Enseignement

Supérieur et de Recherche Scientifique (MESRS). Depuis lors, ces

ministères ont gardés leurs dénominations jusqu'à

ce jour.

1.1.2 Mission de MESRS

Il assure la conception, la mise en oeuvre et le suivi de la

politique de l'Etat en matière d'enseignement supérieur et de la

recherche scientifique conformément aux conventions internationales,

lois et règlements en vigueur en République du Bénin et

à la politique du gouvernement dans le développement des

ressources humaines. Il doit veiller au développement harmonieux de

l'ensemble du système éducatif et former des cadres

supérieurs compétents et compétitifs capable d'assurer

leur propre épanouissement et le développement de la Nation.

L'éducation supérieure est assurée par les

universités publiques et les universités et centres

privés.

Dans les secteurs publics, ils accueillent dans les

facultés, les écoles et les institutions supérieures, les

titulaires du baccalauréat ou toute autre certification admise en

équivalence pour les préparer aux différents

diplômes nationaux de l'enseignement supérieur, dans des cursus de

deux à huit ans (2 à 8 ans). La variation des durées de

formation est fonction des domaines et niveaux d'études ainsi que les

filières.

Pour assurer sa mission, le MESRS dispose: de structures

rattachées au ministre, d'un Cabinet du Ministre, d'un Secrétaire

Général du Ministère, des directions centrales, des

directions générales, des directions techniques, des Organismes

et Établissements publics sous tutelle et des Organismes consultants

et/ou délibérants. A l'enceinte du ministère même,

se trouvent le Cabinet du Ministre, le Secrétariat Général

et les trois directions centrales que sont :

La Direction des Ressources Humaines (DRH), la Direction des

Ressources Financières et Matérielles (DRFM) et la Direction de

la Programmation et de la Prospective (DPP).

1.2 Présentation du cadre d'étude : la

DPP

Conformément aux dispositions l'arrêté

N°146/MESRS/CAB/DC/SGM/DPP/SA de l'année 2008, portant

Attributions, Organisation et Fonctionnement de la DPP, elle doit suivre des

règles pour le bon fonctionnement des tâches qui lui ont

été assignées.

1.2.1 Attribution

En tant que direction centrale du Ministère, elle est

l'organe de conception, de planification et de suivi-évaluation des

projets et programmes du Ministère. Elle est chargée, en relation

avec les autres Directions et Organismes sous tutelle, d'une fonction d'aide

à la décision stratégique.

Élaboration des critères de performance des

établissements privés de l'enseignement supérieur

À ce titre, elle :

- Réalise toutes les études prospectives et

d'évaluation qui permettent d'éclairer les stratégies

à mettre en oeuvres par le Ministère, en fonction des

orientations de politique éducative dans le domaine de l'Enseignement

Supérieur et de la Recherche Scientifique ;

- Aide à la définition et au suivi, par leurs

responsables respectifs, des programmes d'activités et plans d'action

à mettre en oeuvre par le Ministère (conseil en management, aide

méthodologique)

- Élabore le budget-programme du Ministère avec

le concours de la Direction des Ressources Financières et du

Matériel (DRFM) et de la Direction des Ressources Humaines DRH) ;

- Assure le pilotage, la maintenance et l'exploitation des

systèmes d'information, en liaison avec les utilisateurs et les

producteurs ;

- Coordonne la programmation et le suivi des projets et

programmes du Ministère inscrits ou à inscrire au Programme

d'Investissements Publics ;

- Élabore les rapports trimestriels et annuels de

l'exécution du Programme d'Action du Gouvernement et du Programme

d'Investissements Publics ;

- Assure le suivi des tâches assignées au

Ministère par le conseil des Ministres et soumet

régulièrement au Ministre le point d'exécution de ces

tâches ;

- Centralise les informations relatives à la gestion des

projets et programmes en cours d'exécution, ainsi que leur

suivi-évaluation ;

- Fournit l'information en vue d'aider à la prise de

décisions stratégiques ;

- Assure les travaux d'organisation et d'amélioration des

méthodes de gestion dans l'ensemble des structures du Ministère

;

- Assure tous les travaux de suivi de la mise en oeuvre du

Plan Décennal du Secteur Éducation et du Plan Stratégique

de Développement de l'Enseignement Supérieur et de la Recherche

Scientifique ;

- Assure les plaidoyers en vue de l'amélioration de la

qualité et de l'équité de l'enseignement supérieur

et de la recherche scientifique.

1.2.2 Organisation et Fonctionnement

La DPP est divisée en sept services que sont : un

Service des Études et de la Prospective (SEP) ; un Service de

l'Organisation et de la Méthode (SOM) ; un Service de la Statistique et

de la Gestion de l'Information (SSGI) ; un Service de la Qualité et de

l'Équité (SQE), la Cellule de Suivi-Évaluation des Projets

et Programmes (CSEPP) et un Service Administratif et Financier (SAF). Parmi les

sept services, les six premiers s'occupent de la programmation et de la

prospective, et le dernier s'occupe des dossiers administratif et financier.

Service des Etudes et de la

Prospective

Il est composé de deux divisions à savoir la

division des études et celle de la prospective. Il est chargé

:

· de Réaliser ou de faire réaliser les

études prospectives et d'évaluation permettant d'éclairer

les stratégies à mettre en oeuvre au Ministère, en

fonction des orientations de la politique de formations dans le domaine de

l'enseignement supérieur et de la recherche scientifique ;

· de Contribuer à la définition des

programmes d'activité et des plans d'action ;

· d'Assurer l'étude, la conception et la

rédaction, à l'initiative des directions techniques et des

organismes sous-tutelle, des projets destinés au développement de

ce secteur de l'enseignement supérieur et de la recherche scientifique

;

· d'Assurer tout les travaux de suivi de la mise en

oeuvre du plan décennal du secteur éducation et des plan

stratégiques de développement de l'enseignement supérieur

et de la recherche scientifique ;

· de Définir, en relation avec les structures

responsables, la politique d'évaluation des diverses activités du

plan de développement de l'enseignement supérieur et de la

recherche scientifique ;

·

de Contribuer à l'identification et à la mise en

oeuvre des actions environnementales du ministère.

Service de l'Organisation et des

Méthodes

Il comprend deux divisions : division des normes et

procédures, et division du suivi organisationnel. Il est chargé

:

· de Définir, en relation avec les structures

concernées, le mécanisme d'évaluation de

l'exécution des diverses activités du ministère ;

· d'Élaborer et de faire appliquer les manuels de

procédures d'exécution des activités du Ministère

en vue d'améliorer la gouvernance et les performances des structures du

Ministère ;

· d'Assurer les travaux d'organisation et

d'amélioration des méthodes de gestions dans l'ensemble des

structure du Ministère en vue d'atteindre les résultats attendus

;

· de Déterminer les besoins en matière de

renforcement des capacités dans les directions centrales, les directions

techniques et les organismes sous tutelle ;

·

de Suivre et évaluer l'exécution du programme

d'activités du Ministère. Service des Statistiques et

de la gestion de l'information

Ce service est composé de deux divisions : la division

des Statistiques et celle de la Gestion de l'information. Il est chargé

:

· de Collecter, de traiter, d'analyser et de centraliser

les données du secteur et d'en assurer la synthèse et la

diffusion en vue de leur exploitation ;

· d'Élaborer et de diffuser l'annuaire statistique

du Ministère ;

· d'Élaborer au besoin avec la Direction

Générale de l'Enseignement Supérieur (DGES) des outils

d'aide à la décision dans le secteur de l'enseignement

supérieur et de la recherche scientifique : tableau de bord, carte

universitaire, guide d'orientation ;

· d'Assurer le pilotage, la maintenance et l'exploitation

des systèmes d'information, en liaison avec les utilisateurs et les

acteurs du système ;

· de Promouvoir l'utilisation des technologies de

l'information et de la communication dans les différentes structures du

Ministère en collaboration avec le Secrétariat

Général du Ministère ;

· de Coordonner en liaison avec la DGES toutes les

activités relatives à l'organisation du Conseil Consultatif

National de l'Enseignement Supérieur et d'en assurer le

Secrétariat.

|

Service de la Qualité et de

l'Équité

|

|

Ce service est composé de deux divisions : une division

de la qualité et celle de l'équité. Il est chargé

:

· d'Assurer l'amélioration de la qualité des

infrastructures académiques des universités ;

· de Contribuer à l'amélioration de

l'efficacité interne des Établissements de Formation et de

Recherche des universités ;

· de Veiller à la qualité et à la

durabilité des ouvrages réalisés par le Ministère

et ses différents structures, à savoir la construction et ou la

réhabilitation d'infrastructures administratives, pédagogiques et

sociales ;

· de Veiller à l'efficacité et à

l'équité dans la programmation et la mise en oeuvre de toutes les

actions du Ministère et de ses structures, en élaborant des

indicateurs appropriés régulièrement traités et

actualisés ;

· de Veiller à l'élaboration et à

la mise en oeuvre des mesures favorisant la discrimination positive au profit

des filles, des femmes et des handicapés dans les entités

universitaires en collaboration avec la DGES ;

· d'Assurer les plaidoyers auprès des

institutions nationales et internationales et auprès des partenaires au

développement, en vue de mobiliser des ressources matérielles et

financières pour soutenir les actions découlant de la mise en

oeuvre des différents programmes de promotion des jeunes filles et des

femmes de l'enseignement supérieur.

|

Cellule de Suivi-Evaluation des Projets et

Programmes

|

|

Elle est coiffée par un comité de pilotage de

la réforme budgétaire au sein du Ministère,

composée d'un secrétariat permanent et d'une division du

contrôle et de l'évaluation. Elle est chargée :

· d'Assurer la liaison entre le MESRS et les

Ministères en charge des Finances et de l'Économie, de la

Prospective et du Développement en matière de programmation, de

budgétisation et de suivi des opérations de développement

;

· d'Élaborer les budgets-programmes du

Ministère en collaboration avec la DRFM et DRH ;

· de Veiller à la définition, à

l'élaboration des indicateurs de performance des budgets-programmes du

Ministère et d'en assurer le suivi et l'évaluation ;

· d'Établir les bilans mensuels, trimestriels et

annuels d'exécution du budget-programme ;

· d'Assister les Directions Techniques en matière

d'élaboration de programmes, de rédaction des plans d'actions et

de suivi-évaluation des budgets-programmes,

· d'Initier des programmes de formation des acteurs

impliqués dans la gestion et l'animation des budgets-programmes

(préparation, exécution, suivi-évaluation). La CSEPP

dispose d'un point focal dans toutes les structures du Ministère.

|

Service Administratif et Financier

|

|

Il est composé de deux divisions, une division des

affaires administratives et l'autre des affaires financières et du

matériel. Il est chargé :

· d'Assurer la saisie et la reprographie des

correspondances et des dossiers de la direction ;

· de Réceptionner, d'enregistrer et

d'expédier le courrier administratif,

· de Classer et de tenir les dossiers et les archives ;

· de Coordonner les travaux de secrétariat de tous

les services de la direction ;

· de Gérer les ressources financière et

matérielles affectées à la direction ;

· de Coordonner la préparation du budget de

fonctionnement de la direction et d'en assurer l'exécution ;

· de Veiller à la mise en oeuvre des nouvelles

procédures budgétaires des ressources financières

affectées à la direction ;

· d'Exécuter toutes autres tâches à lui

confiées par le directeur.

CHAPITRE 2 : Cadre théorique de

l'étude

Cette section vient décrire le contexte, la

problématique, les objectifs, les hypothèses de recherche ainsi

que la revue de littérature.

2.1 Contexte et problématique de recherche

L'éducation, l'une des bases de développement

de toute nation, s'impose comme secteur prioritaire dans l'élaboration

de toute stratégie de développement. Il est difficile

d'espérer produire un capital humain compétent si rien n'est fait

dans le sens de l'amélioration de la qualité et de la

quantité de l'offre de la scolarisation.

Au Bénin, l'éducation formelle, assurée

par le secteur public et celui du privé, est subdivisée en trois

grandes parties à savoir : Enseignement maternel et primaire,

Enseignement secondaire et technique, enfin l'Enseignement supérieur.

Depuis les années 1990, le secteur de l'enseignement

supérieur public et de la recherche de notre pays est confronté

à une crise profonde dont l'origine se situe principalement dans le

déséquilibre croissant entre les besoins nécessaires pour

assurer un enseignement de qualité et les ressources financières

disponibles. L'un de ces nombreux problèmes est :

Comment gérer le paradoxe entre les effectifs

d'étudiants pléthoriques au regard des capacités

d'accueil, du nombre d'enseignants, des infrastructures et équipements

?

Pour trouver des solutions à cette crise et

maîtriser un peu l'évolution des flux et des ressources, on

assiste depuis les années 1990, à la création des

établissements privés d'enseignement supérieur. Il en

existe deux catégories : les universités privées et les

centres privés d'enseignement supérieur. Depuis lors, leur nombre

ne cesse d'augmenter. C'est ainsi qu'avec 29 établissements au cours de

l'année académique 1999-2000, on est passé à 95 au

cours de l'année académique 2008-2009. Ainsi, ce nombre a

été multiplié par 3 en 10 ans. Parmi ces 95

établissements privés autorisés par le Ministre en charge

de l'enseignement supérieur, on distingue 7 universités

privées et 88 centres privés qui assurent la formation d'un bon

nombre d'étudiants dans différentes filières. En

1999-2000, ces établissements privés avaient encadré

environ 6096 étudiants sur un effectif total de 24849 soit un

pourcentage de 24,53%. En 2008-2009, cet effectif du

privé est passé à 20438 sur un total de 82402 soit un

pourcentage de 24,80%. En effet, l'effectif des étudiants

absorbés par le privé a été aussi multiplié

par 3 en 10 ans (d'après l'annuaire statistique 2008-2009 du MESRS). Ce

secteur de l'enseignement supérieur se développe de

manière significative sans que cette évolution soit

véritablement encadrée et contrôlée par les pouvoirs

publics. Après leur autorisation pour la création d'une

filière, une fois arrivée sur le terrain, ils en créent

d'autres de leur choix, et délivrent des diplômes qui par la suite

amènent le problème de non reconnaissance de diplômes par

l'État. Malgré les nombreux efforts que font le gouvernement et

les récentes réformes entamées dans ce secteur, il se pose

la question de savoir :

Dans quel établissement privé envoyé un

enfant après son baccalauréat pour commencer ses études

supérieures ?

Quel est le niveau de la qualité de l'enseignement

dispensé par les EPES par rapport aux établissements publics au

Bénin ?

Quels sont les établissements autorisés et quelles

sont les filières autorisées dans chaque établissement

?

Est-ce que leurs programmes sont approuvés par le CAMES

?

Sur quels critères se base chaque établissement

pour dire qu'il est le meilleur à titre publicitaire à l'approche

de chaque rentrée universitaire ?

Comment est perçue la qualité des prestations des

EPES par les parents, l'État et certains apprenants?

Ces interrogations revêtent une importance capitale

pour le développement de l'éducation d'un pays, surtout au niveau

de l'enseignement supérieur. C'est pour répondre à

celles-ci que nous avons choisi de réfléchir sur le thème

: « élaboration des critères de performance des

établissements privés de l'enseignement supérieur

».

2.2 Objectif de recherche

L'objectif de ce travail est d'élaborer des

critères de performance des établissements privés

d'enseignement supérieur en vue de proposer des recommandations de

politiques ou stratégies socio- économiques ou éducatives

pouvant contribuer à l'amélioration de la performance de ces

établissements. A cet effet, nous nous sommes fixés les objectifs

spécifiques (OS) suivants:

Objectif Spécifique1 : Identifier les variables

pertinentes pouvant servir de critère d'appréciation de la

performance de ces établissements.

Objectif Spécifique2 : Élaborer un

indicateur composite en vue d'évaluer la performance de ces

établissements.

2.3 Hypothèses de recherche

Eu égard aux objectifs ci-dessus énoncés,

les hypothèses ci-après ont été formulées

:

Hypothèse1: Les variables qualité et

accès expliquent fortement la performance des établissements.

Hypothèse2: La variable qualité a le

coefficient le plus élevé dans la formation de l'indicateur.

2.4 Revue de littérature

Dans cette rubrique, nous ferons un compte rendu des travaux

de certains auteurs et institutions qui ont parlé des critères de

performance des établissements d'enseignement supérieur. Cette

revue est subdivisée en trois sections. La première concerne la

définition de quelques concepts. La deuxième présente les

différents classements principaux existants. Enfin, la troisième

section est consacrée à une synthèse qui présente

les grandes conclusions de la revue ainsi que la liste des variables

recensées.

2.4.1 Définition des concepts « performances

d'un système » et « indicateur »

2.4.1.1 Performance d'un système

Dans le dictionnaire français LAROUSSE, le mot «

performance » est défini comme étant le résultat

obtenu dans un domaine précis par quelqu'un, une machine, un

véhicule...Elle est aussi définie comme un exploit ou une

réussite remarquable en un domaine quelconque. Selon l'UNESCO, la

performance est la capacité qu'un établissement a pour atteindre

ses objectifs. En définissant la performance comme le résultat

perçu et évalué, nous supposons qu'il peut être

situé sur une échelle ordinale de quantité (par exemple,

plus loin ou moins loin) ou de qualité (par exemple, plus beau ou moins

beau) et qu'il est aussi comparé à d'autres résultats. Par

conséquent, le terme performance doit être utilisé d'une

manière très spécifique. Il fait référence

à un résultat situé sur un continuum évaluatif.

Depuis la mise en application de la LOLF, la performance

s'impose progressivement comme une évidence, un incontournable objet

à prendre en compte dans tous les domaines. La définition de la

performance du service public peut constituer une entrée pour

dépasser une première approche formelle et en comprendre le sens

et les conséquences dans le champ de l'éducation. La performance

est définie par l'atteinte des objectifs de l'administration dans la

réalisation d'un programme. Trois critères sont associés

à cette définition, la prolongent et la précisent. Le

critère de l'efficacité est mobilisé pour signifier

l'impact ou le résultat final sur l'action publique. L'efficience

constitue un deuxième critère de référence et

renvoie à l'amélioration du rapport entre les moyens

consommés et la réalisation. Le dernier critère consiste

à quantifier la qualité du service apporté à

l'usager. Les indicateurs de performance renvoient implicitement à ces

critères de référence. L'analyse de ce dernier se fait

soit sur l'enseignement soit sur l'établissement. Par rapport à

l'enseignement, la performance se mesure suivant plusieurs angles à

savoir : l'accès, l'efficacité interne, la pertinence et

l'efficacité externe, la qualité de l'enseignement, la

professionnalisation de l'enseignement supérieur, la capacité de

recherche et d'innovation, l'équité, les coûts et

dépenses, la capacité de gestion et de pilotage, (guide UNESCO).

Par contre, par rapport à l'établissement cette opération

se fait sous trois angles : en matière d'enseignement, il est important

de connaître les effectifs par formation; leur évolution dans le

temps; les diplômes par formation et par niveau; les taux de

réussite et d'abandon par formation.... Pour les enseignants, il s'agira

de

connaître leurs statuts; leurs qualifications et leurs

expériences. Ensuite, en matière de recherche, il faut voir le

nombre d'enseignants qui effectue des recherches (publication), et enfin, en

matière de gestion des établissements, il est aussi important de

connaître les sources de financement et de savoir si l'évolution

correspond au plan stratégique.

2.4.1.2 Rappel sur la notion d'indicateur

Généralement utilisé pour mesurer une

situation ou pour apprécier l'évolution d'un

phénomène dans le temps et/ou dans l'espace, un indicateur se

présente comme une variable quantitative ou qualitative qui permet de

caractériser une situation évolutive, une action ou les

conséquences d'une action, de façon à les évaluer

et à les comparer à leur état à différentes

dates. Dans le système éducatif, c'est un outil qui doit à

la fois permettre de rendre compte de l'état d'un système

éducatif, et également informer l'ensemble de la

communauté éducative d'un pays de cet état.

Il est élaboré à partir des informations

qui permettent d'étudier un phénomène

éducatif. Donc un indicateur est un outil d'aide à la

décision, dont l'utilisation s'inscrit dans une démarche qui

répond à un objectif et se situe dans un contexte donné.

Les indicateurs de performance permettent de caractériser

l'évolution des systèmes éducatifs dans leur contribution

à l'élévation du niveau général de

formation, dans la lutte contre les inégalités sociales et de

manière plus générale, dans l'optimisation du rapport

coût/ qualité du service. Ces indicateurs ont pour objectif de

mesurer la performance interne (part de marché des formations par

discipline, taux de diplômés par classe), la performance externe

(destination des diplômés, publications par le personnel

enseignant) et la performance opérationnelle (coûts unitaires,

ratios enseignants/étudiants).

Par ailleurs, on distingue les indicateurs simples et les

indicateurs composites. Les indicateurs simples ou élémentaires

sont rattachés à une grandeur simple, qui traduit une seule

variable. Quant aux indicateurs composites, encore appelé indicateurs

synthétiques, ils sont un agrégat ou une chaîne

d'indicateurs individuels valorisés c'est-à-dire une combinaison

d'indicateurs élémentaires qui traduisent le comportement d'une

grandeur

complexe. Dans sa forme la plus simple, un indicateur composite

suit la représentation

linéaire de l'exemple suivant : IC w y w y

= +

1 1 n 2 2

|

p

+ + w y

n p pn = ? w y

i in

|

où :

|

|

i = 1

IC , correspond au score du composite dans

l'unité n,

yin , correspond à l'indicateur individuel pour

l'attribut i dans l'unité n, wi , spécifie le

poids attaché à l'attribut i.

Un bon indicateur doit avoir un certains nombres de

caractéristiques :

- sa pertinence ;

- sa capacité à résumer l'information sans

la déformer ;

- son caractère coordonné et structuré qui

permet de le mettre en relation avec un autre indicateur pour une analyse du

système ;

- sa précision et sa comparabilité ;

- sa fiabilité.

Il doit permettre :

- de mesurer la distance par rapport à un objectif ;

- d'identifier les situations problématiques ou

inacceptables ;

- de répondre aux préoccupations des politiques et

au questionnement qui a conduit à son choix ;

- de comparer sa valeur à une valeur de

référence, à une norme ou à lui-même

calculé pour une période d'observation.

2.4.2 Les différents classements existants

Les pouvoirs publics s'intéressent de plus en plus aux

analyses comparatives nationales et internationales de l'éducation.

Elles leur permettent d'identifier des politiques d'éducation efficaces

qui contribuent à la fois à améliorer les perspectives

économiques et sociales des individus, à promouvoir une gestion

efficace des systèmes scolaires et à mobiliser des ressources

supplémentaires pour répondre à une demande croissante. Un

classement des universités et centres privés d'enseignement

supérieur va éclairer les différents acteurs sur le

bon fonctionnement de ces établissements, la

qualité de l'enseignement de leur formation ainsi que l'évolution

du système éducatif privé du supérieur.

La raison d'être des

classements

L'évaluation des programmes d'études et des

établissements n'est pas chose nouvelle. Depuis 1983, U.S. News and

World Report publie un palmarès des meilleures universités

américaines. C'est plutôt la comparaison, à

l'échelle mondiale, de la performance des universités, qui est

récente. En effet, la position qu'occupe une université dans

l'univers de la recherche, au plan national ou international, est souvent

perçue comme le gage de qualité de l'enseignement par excellence,

à l'époque où la connaissance, l'innovation, la recherche

et le développement sont essentiels au progrès des pays. Dans

notre pays le Bénin, un tel travail n'a jamais été

abordé, du moins à notre connaissance.

A quel besoin ces classements

répondent-ils?

D'abord, ils satisfont un besoin d'information au sein de la

clientèle étudiante, quant aux programmes d'études

proposés par ces universités. Ensuite, la comparaison nationale

de ces établissements d'enseignement supérieur, notamment sous la

forme des classements, vient satisfaire la demande d'information quant aux

forces et faiblesses de ces institutions. Enfin, elle comble un déficit

de transparence, alors que ni les institutions, ni les gouvernements ne sont en

mesure de fournir toutes les informations que requièrent leurs

clientèles (Usher & Savino, 2006). Selon le rapport Bourdin (2008),

les classements viendraient, en effet, pallier l'opacité qui plane sur

les performances des établissements. Toutefois, malgré leur

première utilité, les classements sont loin d'être des

outils servant à mesurer l'« assurance-qualité ».

Il s'avère essentiel d'étudier les classements

universitaires puisque de plus en plus d'institutions d'enseignement

supérieur s'y réfèrent pour orienter leurs actions et que

plusieurs gouvernements s'en servent pour formuler leurs politiques publiques

dans le domaine de l'éducation. Les classements ont un impact

réel sur les politiques. Devant la nécessité de fonder ces

politiques sur de solides données, on peut s'interroger sur la

qualité de cette source d'information. Les renseignements sur lesquels

s'appuient les décideurs publics et les gestionnaires

d'établissements sont-ils exacts, fiables, objectifs? Ces

classements permettent-ils d'évaluer la valeur

réelle des établissements en matière d'enseignement, de

recherche, missions premières des universités?

Les experts répondent que la meilleure façon de

tirer profit des informations que fournissent les classements est encore de

bien les connaître et les comprendre afin de correctement les

interpréter. Actuellement, il existe deux sortes de palmarès

à savoir :

· les palmarès nationaux qui présentent la

liste des meilleurs établissements d'enseignement supérieur

à l'échelle nationale et ;

· les palmarès internationaux qui présentent

la liste des meilleurs établissements d'enseignement supérieur

à l'échelle mondiale.

2.4.2.1 Les classements internationaux

Les principaux classements internationaux évaluent

à peu près les mêmes établissements d'enseignement

universitaire et leurs appréciations se fondent sur des principes et

approches assez similaires (Dyke, 2005). Au-delà de ces aspects, les

classements diffèrent considérablement dans les objectifs qu'ils

poursuivent, les données qu'ils collectent et les champs qu'ils

couvrent. Pour la seule notion de « qualité » d'un

établissement, que tous les classements se targuent d'évaluer,

les définitions peuvent grandement varier (Dyke, 2005; Usher &

Savino, 2006).

Aujourd'hui, il existe dans le monde au moins dix

palmarès en concurrence, que sont : le Shanghai Academic Ranking of

World Universities de l'université chinoise Jiao Tong (le classement de

Shanghai), le Times Higher Education World University Rankings (classement de

Times), le Webometrics Ranking of World Universities (classement Webometrics)

du Conseil supérieur de la recherche scientifique espagnol, le Leiden

World Ranking du Centre d'études sur les sciences et les technologies de

l'université de Leiden aux Pays-Bas, le classement des programmes de MBA

du Financial Times, le classement de l'École des Mines de Paris, le

Higher Education Evaluation and Accreditation Council of Taiwan (HEEACT), le

classement Newsweek du magazine américain Newsweek, le classement

Scimago proposé par un laboratoire espagnol et le classement

d'excellence du Centrum für Hochschulentwicklung, un think tank

allemand.

Parmi tous ces classements, trois d'entre eux, le Shanghai

Academic Ranking of World Universities de l'université chinoise Jiao

Tong, le World University Ranking du Times Higher Education Supplement et le

Webometrics Ranking of World Universities sont mieux connus, attendus et

même parfois redoutés. Ils sont compulsés par les chefs

d'établissements, les autorités gouvernementales, les

étudiants à la recherche de l'université où

poursuivre leurs études et même par les dirigeants d'entreprises

en recrutement. Cette section présente un tour d'horizon de ces trois

classements internationaux.

Le classement de Shanghai

Le classement de Shanghai est apparu la première fois

en 2003, et a été créé par 4 professeurs de

l'université de Jiao Tong en Chine. Le succès de leur classement

une fois publié a été tel qu'il a fini par faire le tour

du monde seulement en quelques mois, ce qui a conduit les enseignants à

continuer l'expérience face à ce succès, et le remettre

à jour tous les ans au mois d'août.

À l'origine, les initiateurs du projet avaient pour

objectif de situer, sur l'échiquier mondial, les établissements

d'enseignement supérieur chinois en les comparant à leurs

homologues à travers le monde (Pech, 2009; Bourdin, 2008). Le

succès retentissant de ce classement, principalement auprès des

médias, les incita à répéter annuellement cette

comparaison. Le classement de Shanghai compare 1200 institutions d'enseignement

supérieur sur la pondération de 6 indicateurs, tous liés

à la recherche. Cinq de ces indicateurs ont un effet de taille :

à qualité égale, plus le nombre de chercheurs est grand

dans une institution, plus sa note sera élevée.

Tableau N°1: Les indicateurs du classement de

Shanghai et leur pondération

|

Critères

|

|

Indicateurs

|

Pondération

|

|

Qualité formation

|

de

|

la

|

Nombre de prix Nobel et de médailles Fields parmi les

anciens élèves

|

10 %

|

|

Nombre de prix Nobel et de médailles Fields parmi les

chercheurs

|

20 %

|

|

|

|

Nombre de chercheurs largement cités dans les

disciplines des sciences du vivant, de la médecine, de

|

|

|

|

|

la physique, des sciences de l'ingénieur et des

sciences

|

20 %

|

|

Qualité personnel

|

|

du

|

sociales

|

|

|

|

|

Nombre d'articles publiés dans Nature et Science entre

|

20 %

|

|

|

|

2004 et 2009

|

|

|

|

|

Nombre d'articles répertoriés dans le Science

Citation

|

|

|

|

|

Index-expanded (SCI Expanded) et dans le Social

|

|

|

Output

|

de

|

la

|

|

20 %

|

|

recherche

|

|

|

Science Citation Index (SSCI) en 2009. Les articles du

|

|

|

|

|

SSCI comptent double. (Le SSCI entre dans le

décompte des articles depuis 2006).

|

|

|

Grandeur institutions

|

|

des

|

Performance académique au regard de la taille de

l'institution

|

10 %

|

Source : ARWU, 2008.

Basé sur des critères que ces créateurs

ont jugés représentatifs du niveau d'une université, ce

classement est néanmoins critiqué de par le fait qu'il met en

avant la recherche menée au sein des universités au

détriment de la qualité de l'enseignement. Ainsi, la logique fait

que plus l'université a de moyens, plus elle se retrouve proche du haut

du classement. Le classement de Shanghai nous donne donc une indication sur la

taille et la renommée d'une université, mais en aucun cas de la

qualité de l'enseignement qui y est dispensé. Aussi, dans ces

critères n'apparaissent malheureusement pas certaines orientations

jugées prioritaires en France comme la formation supérieure des

cadres, des ingénieurs et des gestionnaires pour les milieux

socio-économiques ou les sciences humaines et sociales. Les secteurs de

l'ingénierie et du management, l'ouverture sociale et l'innovation

technologique sont peu pris en compte dans les critères de ce

classement.

Le Times Higher Education World University Rankings

Un an après la publication du premier palmarès

de Shanghai, flairant la bonne affaire, le magazine britannique Times Higher

Education Supplement (THES) publie le World University Ranking, classement

devenu lui aussi l'un des plus connus à travers le monde. En tenant

compte des critiques émises à l'égard du classement de

Shanghai et cherchant à élargir les bases de l'évaluation

des établissements, le Times prend en considération non seulement

la recherche, mais aussi l'enseignement dispensé par

l'université. Cinq critères, qualitatifs et quantitatifs,

permettent au Times d'ordonner les 200 « meilleures »

universités du monde.

Tableau N°2: Les critères du THE (Times Higher

Education)

|

Critères

|

|

Indicateurs

|

Pondération

|

|

Évaluation par les pairs

|

|

Points obtenus lors de

l'enquête auprès des pairs (divisée en cinq

domaines)

|

40 %

|

|

Évaluation par

employeurs

|

les

|

Réponses à l'enquête

auprès des employeurs

|

10 %

|

|

Taux d'encadrement

|

|

Rapport entre les effectifs d'étudiants et

d'enseignants

|

20 %

|

|

Citation par Facultés

|

|

Nombre de citation divisé par le nombre de

chercheurs

|

20 %

|

|

Internationalisation corps enseignant

|

du

|

Proportion d'enseignants

étrangers

|

5 %

|

|

Internationalisation étudiants

|

des

|

Proportion d'étudiants

étrangers

|

5 %

|

Source: Times Higher Education, 2008.

Ce que certains reprochent au classement du Times, c'est

l'importance qu'il accorde à la réputation de

l'établissement : on y récompense davantage les efforts de

marketing plutôt que les chercheurs de l'institution (Marginson &

Wende, 2007). Cette mesure est obtenue, depuis 2005, grâce à

l'évaluation de l'établissement par les pairs (40% de la

pondération totale), de même que par les employeurs (10%). Cet

aspect, qui démarque grandement le classement du Times par rapport

à celui de Shanghai, repose sur le jugement de milliers de professeurs

et chercheurs des cinq continents qui portent un verdict sur les

universités dans les disciplines de recherche pour lesquelles ils sont

eux-mêmes spécialisés. Cette façon de

procéder a toutefois connu quelques ratés.

Le Webometrics Ranking of World Universities

Ce classement est réalisé par le laboratoire de

recherche Cybermetric du CSIC (Consejo Superior de Investigaciones cientificas)

en Espagne. Il rassemble plus de 4000 universités et centres de

recherche dans le monde, répartis par grandes régions

géographiques. Ce classement veut surtout promouvoir les publications

sur le web et les initiatives en Archives Ouvertes, comme ressort du texte sur

les pratiques conseillées pour le positionnement des sites et de la

méthode employée. Le classement Webometrics propose une approche

différente des autres classements mondiaux. En effet, celui-ci a pour

but d'évaluer la présence des universités sur internet, et

non leur niveau d'enseignement ou de recherche. Ils se basent avant tout sur la

quantité du contenu présent sur le net, et l'accessibilité

du site de l'université en question.

Le classement se base sur plusieurs critères en lien avec

le référencement dans les principaux moteurs de recherche, que

sont :

- Le Nombre de pages du site : Nombre de pages

récupérées par 4 moteurs Google, Yahoo, Live Search et

Exalead

- La Visibilité : Nombre de liens extérieurs

(backlinks) pour le site que l'on peut obtenir en interrogeant Yahoo Search,

Live Search et Exalead

- Les Fichiers téléchargés : Les formats

suivants ont été sélectionnés : Adobe Acrobat

(.pdf), Adobe PostScript (.ps), Microsoft Word (.doc) et Microsoft Powerpoint

(.ppt).

Il faut alimenter les moteurs en fichiers. On compte aussi le

nombre de fois que les fichiers sont téléchargés

- Les publications Académique : Google scholar donne le

nombre d'articles et des citations par domaine des articles publiés dans

le site.

Malgré sa renommée internationale, ce classement

n'est pas resté sans critiques :

Si le classement semble intéressant à consulter,

il faut savoir interpréter sa réelle utilité. La

présence d'une université sur internet dépend en grande

partie de sa renommée pour les internautes, plus le site d'une

université a de liens pointant vers elle sur le net, plus elle semble

populaire. Le nombre de pages du site indique aussi la quantité de

contenu mis à disposition des internautes, idem pour les fichiers

disponibles au téléchargement. Cependant ces indicateurs ne

doivent pas être pris comme un indice de renommée sur le net, et

pour plusieurs raisons.

Premièrement, un internaute mécontent parle plus

qu'un internaute satisfait. Le résultat de cette règle

déjà démontrée par le passé par Google remet

en cause l'indice des backlinks. En effet, les avis négatifs des

internautes avec un lien vers le site de l'université en question

comptent en tant que vote positif pour le classement.

Deuxièmement, si le nombre de pages du site et de

fichiers mis à disposition indiquent que le contenu sur le site est

important, il ne juge en rien sa qualité, mais uniquement sa

quantité. Seul l'indice Google Scholar semble prendre en compte la

qualité du contenu.

Critique des classements

universitaires

Le rapport Bourdin (2008) distingue des critiques sur la

légitimité de la mesure et sur la méthode.

- Critique de leur légitimité

Les classements comparent souvent des institutions

difficilement comparables. Ainsi, ces classements mettent sur un même

pied des universités généralistes, des grandes

écoles, ou encore Harvard, alors que cette dernière dispose d'un

budget annuel de 3 milliards de dollars pour vingt mille étudiants.

Les classements agrègent des indicateurs difficilement

comparables. Le choix d'indicateur pour chacune des missions de

l'université (enseignement, recherche, services à la

cité,...) et leur agrégation pour obtenir un score unique conduit

généralement à « additionner des pommes et des poires

». Pour prendre un exemple, le nombre d'articles publiés dans des

revues prestigieuses a probablement moins d'importance que le taux

d'encadrement des étudiants si vous cherchez une université

où étudier, mais elle en aura plus si vous êtes une

entreprise désireuse de débuter un partenariat de recherche. Et

l'addition entre ce nombre d'articles et le taux d'encadrement n'a pas grande

signification. Ceci explique les grandes variations que l'on peut observer,

pour la même université, d'un classement à l'autre et

même d'une année à l'autre dans le même

classement.

Par construction, les classements privilégient le monde

anglophone et les grandes universités spécialisées telles

que les écoles polytechniques. Pour les raisons évoquées

cidessus, les classements sont conçus avec un modèle

d'université idéale. Implicitement, ce modèle est bien

souvent celui des grandes universités anglo-saxonnes. Il n'est donc pas

étonnant de voir que les universités nord-américaines

occupent les premiers rangs, suivis des universités anglaises. De

même, les universités qui se spécialisent dans un petit

nombre de domaines porteurs grimpent plus facilement dans ces classements. Les

universités européennes généralistes de service

public ne cadrent donc pas forcément avec les critères

utilisés pour ces classements.

- Critique de leur méthode

Gingras (2008) souligne le manque de fiabilité du

classement de Shanghai, qui fait varier de 100 rangs la position de

l'université Humboldt de Berlin, en 2008, en raison de la publication en

1922 du Prix Nobel d'Einstein.

Le rapport Bourdin soulève plusieurs limites

méthodologiques :

Les mesures et pondérations choisies ne font l'objet

d'aucune justification théorique. Les utilisateurs des classements sont

invités à partager des choix dont ils ne sont pas toujours bien

informés. De façon générale, la

légitimité des indicateurs synthétiques est incertaine,

d'une part parce qu'ils agrègent des données disparates, et

d'autre part, parce qu'ils résultent de choix qui placent en fait

l'observateur supposé en situation d'acteur.

La source des indicateurs est problématique, dans le

cas de données déclarées par les universités

elles-mêmes. Des études menées aux États-Unis ont

montré que ces données étaient l'objet de manipulations,

ou que certaines règles étaient modifiées par les

universités en sorte d'améliorer artificiellement leur place dans

les classements.

Les indicateurs choisis ont parfois un caractère

indirect (utilisation de << proxies >>). Ainsi par exemple, que

mesurent, en réalité, les enquêtes de réputation

telles que celles effectuées dans le cadre du classement du Times

(TH-QS) ? Mesurent-elles la sélectivité de

l'établissement, la qualité de sa recherche, son prestige

historique ? Ces mesures créent des effets de rémanence, car la

réputation d'un établissement dépend en partie des

classements passés.

Les indicateurs retenus sont liés entre eux, en sorte

que la dimension << multicritères >> du classement est en

partie superficielle. Dans le cas du classement de Shanghai, les

critères bibliométriques se chevauchent (<< nombre

d'articles référencés au niveau international >> et

<< nombre d'articles publiés dans les revues << Science

>> et << Nature >> >> par exemple) ou recoupent

indirectement d'autres critères comme l'obtention de distinctions

académiques (prix Nobel, médailles Fields). Dans le cas du

classement du TH-QS, la réputation dépend aussi de ce qui est

mesuré par les autres indicateurs employés, en sorte que les

mêmes éléments sont pris en compte plusieurs fois pour la

réalisation d'un classement, dans une mesure qu'il est difficile

d'évaluer.

Enfin, les écarts statistiques ne sont pas toujours

suffisamment significatifs pour qu'un classement établissement par

établissement, par ordre décroissant de performance soit

réellement pertinent.

2.4.2.2 Les classements nationaux

Outre les classements internationaux qui évaluent les

universités dans le monde entier, il y a aussi les classements

nationaux, classement réalisé à l'intérieur d'un

pays. Les classements nationaux permettent à chaque pays

d'évaluer et de classer ses établissements d'enseignement

supérieur. Ce travail se réalise aujourd'hui dans plusieurs pays,

mais en Afrique, seulement quelques pays évaluent leurs

universités. Ainsi, c'est le cas de la Côte-

d'Ivoire en Afrique, du Canada en Europe et les États Unis

en Amérique, le premier pays au monde qui a commencé ce travail

depuis 1980.

La Côte d'Ivoire

La Côte d'Ivoire a commencé le classement de ces

établissements et centres d'enseignement supérieur depuis 2007.

Pour faire le travail, elle distingue les établissements de type

Universitaire et les grandes écoles formant au BTS (centres

d'enseignement supérieur). Les critères retenus dans

l'évaluation de ces entités d'enseignement supérieur sont

:

Pour les établissements de types universitaires

- Environnement et infrastructure ;

- Équipement ;

- Organisation institutionnelle et gouvernance ;

- Financement ;

- Rémunération, charges sociales et fiscales ;

- Coopération nationale et internationale ;

- Déroulement de la scolarité ;

- Organisation pédagogique ;

- Ressources humaines ; - Vie des étudiants ;

- Recherche et progrès des connaissances ;

- Service à la communauté ;

- Assurance qualité.

Pour les grandes écoles formant pour le BTS

- Environnement et infrastructure ;

- Équipement ;

- Gestion pédagogique ;

- Rendement ;

- Charges sociales et fiscales.

Le Canada

Les classements des universités au Canada se basent sur

la qualité perçue et la valeur.

Deux classements annuels des universités canadiennes sont

publiés par la revue Maclean's et

le quotidien The Globe and Mail.

Les critères de classement comprennent:

- Taux d'admission ;

- Le niveau moyen d'admission du nombre d'étudiants

poursuivant un 2e et 3e cycle ;

- Ampleur de la bibliothèque ;

- Nombre de professeurs titulaires d'un PhDs ;

- Subventions reçues pour la recherche et publications

;

- Interaction étudiants/corps professoral ;

- Cours disponibles ;

- Dépenses consacrées aux services des

étudiants ;

- Bourses d'études et prêts-bourses.

Les Principes de Berlin sur le classement des

établissements d'enseignement supérieur.

Les classements des établissements d'enseignement

supérieur sont devenus l'un des éléments de

responsabilisation et d'assurance qualité au niveau national,

régional et même mondial. Ils se développent et divers

classements sont proposés au niveau national, régional et

mondial. Du fait de l'hétérogénéité des

méthodologies des classements, un groupe d'experts internationaux en

classements - IREG [International Ranking Expert Group] a été

fondé en 2004 par le Centre européen pour l'enseignement

supérieur de l'UNESCO (UNESCO-CEPES) de Bucarest et l'Institute for

Higher Education Policy de Washington, D.C. C'est à partir de cette

initiative que s'est tenue la deuxième réunion de l'IREG (Berlin,

2006) afin de formuler un ensemble de principes concernant la qualité et

les bonnes pratiques dans les classements des établissements

d'enseignement supérieur appelés les Principes de Berlin sur le

classement des établissements d'enseignement supérieur. Au nombre

de 16, ils s'attachent à définir plusieurs critères de

bonne conduite à destination des producteurs de classements.

Les classements devraient:

A) Buts et objectifs des classements

1. Être l'une des nombreuses approches de

l'évaluation des ressources, des processus et des résultats de

l'enseignement supérieur. Les classements peuvent offrir des

informations comparatives et une meilleure compréhension de

l'enseignement supérieur, mais ne devrait pas être la

méthode principale utilisée pour évaluer ce qu'est et ce

que faire l'enseignement supérieur. Les classements offrent une

perspective basée sur le marché qui peut seulement

compléter le travail effectué par le gouvernement, les

autorités responsables de l'accréditation et des agences

expertises indépendantes.

2. Être explicites quant à leur objectif et

à leurs publics cibles. Les classements doivent être conçus

en tenant compte de leur objectif. Les indicateurs élaborés pour

atteindre un certains objectifs ou pour informer un certain public peuvent ne

pas être adéquats pour d'autres objectifs ou publics cibles.

3. Reconnaître la diversité des

établissements et prendre en considération leurs

différentes missions et objectifs. Par exemple, les critères de

qualité pour les établissements axés sur la recherche sont

tout-à-fait différents de ceux qui sont pertinents pour les

établissements qui assurent un plus large accès à des

communautés défavorisées. Les établissements qui

sont classés et les experts qui sont à la base du processus de

classement doivent être fréquemment consultés.

4. Être clairs quant à la gamme de sources

d'information employées dans les classements et des informations rendues

accessibles par chaque source. La pertinence des résultats des

classements dépend des publics qui reçoivent les informations et

des sources de ces informations (bases de données, étudiants,

enseignants ou employeurs). Une bonne pratique serait de combiner les

différentes perspectives fournies par ces sources afin d'obtenir une

image plus complète de chaque établissement d'enseignement

supérieur inclus dans un classement donné.

5. Indiquer les contextes linguistiques, culturels,

économiques et historiques des systèmes d'enseignements qui font

l'objet du classement. Les classements internationaux devraient être

particulièrement attentifs à toute possibilité de biais et

être précis sur leurs objectifs. Les états ou les

systèmes ne partagent pas tous les valeurs et croyances concernant ce

qui constitue la « qualité » dans les établissements

tertiaires, et des systèmes de classement ne devraient pas être

conçus dans le but d'imposer des comparaisons inadéquates.

B) Création et pondération des

indicateurs

6. Être transparents quant à la

méthodologie employée pour la création de classements. Le

choix des méthodologies employées pour élaborer les

classements devrait être clair et sans équivoque. Cette

transparence devrait inclure le calcul des indicateurs ainsi que l'origine des

données.

7. Choisir les indicateurs en fonction de leur pertinence et

de leur validité. Le choix des données devrait se baser sur la

reconnaissance de la capacité de chaque critère à

représenter la qualité et les atouts académiques et

institutionnels, et non pas sur la disponibilité des données. Les

raisons justifiant la prise en compte de chaque type de mesure ainsi que ce

qu'elles sont censées représenter doivent être

explicités.

8. Mesurer de préférence, et dans la mesure du

possible les résultats plutôt que les ressources. Les

données concernant les ressources sont pertinentes parce qu'elles

reflètent la situation générale d'un établissement

donné et sont plus fréquemment disponibles. L'analyse des

résultats offre une évaluation plus correcte de la position et/ou

de la qualité d'un établissement ou d'un programme donné.

Les producteurs de classements devraient s'assurer qu'un juste équilibre

est atteint.

9. Mettre en évidence les points assignés aux

différents indicateurs (si employés) et limiter leurs

changements. Les changements de poids font que les utilisateurs ont du mal

à discerner si le statut d'un établissement ou d'un programme

à changer dans le cadre des classements à cause d'une

différence inhérente ou du faite d'un changement

méthodologique.

C) Collecte et traitement des

données

10. Accorder une attention sévère aux standards

éthiques et aux recommandations concernant les bonnes pratiques

formulées dans ces Principes. Afin d'assurer la

crédibilité de chaque classement, les personnes responsables de

la collecte et de l'utilisation des données, ainsi que les visites sur

place, devraient être aussi objectifs et impartiaux que possible.

11. Utiliser les données auditées et

vérifiables chaque fois que cela est possible. Ces données

présentent plusieurs avantages comme le fait qu'elles ont

été acceptées par les établissements et qu'elles

sont comparable et compatibles entre établissements.

12. Inclure les données qui sont collectées par

des procédures appropriées de conforme à la collecte

scientifique de données. Les données rassemblées à

partir d'un groupe non-représentatif ou incomplet d'étudiants,

d'enseignants ou d'autres parties pourraient ne pas représenter un

établissement ou un programme, et devraient être exclues.

13. Appliquer des critères d'assurance qualité

aux processus même de classements. Ces processus devraient tenir compte

des techniques d'évaluation des établissements et mettre à

profit ces connaissances pour évaluer les classements eux-mêmes.

Les classements devraient être des systèmes d'apprentissages

capables d'utiliser ces connaissances pour améliorer leur

méthodologie.

14. Appliquer des critères organisationnels qui

accroissent la crédibilité des classements. Cela peut comprendre

des groupes à vocation des conseils, ou de surveillances, de

préférence à participation internationale.

D) Présentation des résultats des

classements

15. Offrir aux consommateurs une compréhension claire

de l'ensemble des facteurs employés pour la construction d'un

classement, ainsi que le choix de la manière dont les classements

doivent être présentés. Ainsi, les utilisateurs des

classements pourront mieux comprendre les indicateurs utilisés dans les

classements des établissements ou de programmes. De plus, ils devraient

avoir la possibilité de faire leurs propres choix quant aux poids

accordés à ces indicateurs.

16. Être compilés d'une manière qui

élimine ou réduise le nombre d'erreurs au niveau des

données d'origine, et être organisés et publiés

d'une manière qui permettent la correction des erreurs et des fautes

potentielles. Les établissements et le public devraient être

informés au sujet des erreurs apparues durant le processus.

2.5 Synthèse de la revue de littérature

De la même manière que la rareté, le

prestige, et l'accès au «meilleur» sont des critères de

plus en plus utilisés dans l'achat de biens comme les voitures, les sacs

à mains etc., les consommateurs (les étudiants, les parents qui

envoient leurs enfants dans les universités, ...) de l'enseignement

supérieur recherchent aussi des indicateurs qui les aident à

identifier et à choisir les meilleures universités. Dans cette

course à l'éducation «de luxe», les pays s'efforcent de

développer des «universités de rang mondial» qui

conduiront le développement d'une économie du savoir. À

cause de l'impact des classements, les institutions innovent et investissent en

tenant compte des critères et des méthodologies de classement

car, dans chaque classement, les critères et la méthodologie

retenus varient compte tenu des objectifs visés par les autorités

de ces classements.

En dépit des nombreuses critiques et même la non

acceptation par certains, les classements d'universités sont aujourd'hui

répandus et ne sont pas prêts à disparaître, parce

qu'ils définissent pour l'audience la plus large, ce que signifie un

«rang mondial». Ils ne

peuvent être ignorés par toute personne

intéressée par la mesure des performances des institutions

d'enseignement supérieur. Mais malgré leur réputation, ces

classements ne prennent pas en compte tous les principes de Berlin. Aussi,

depuis près de 10 ans que se développent et se répandent

les classements nationaux et internationaux, force est de constater que ce

travail n'a encore impressionné et intéressé beaucoup de

pays africains comme le nôtre.

Dans tous les classements, les critères pris en compte

sont nombreux compte tenu du vaste champ de la qualité et de la

performance. Dans le présent travail, nous retiendrons ceux propres et

communs aux établissements de notre pays en ayant toujours à

l'esprit, les principaux documents de référence en matière

de classement des établissements d'enseignement supérieur. Le

tableau que voici illustre les grandes variables proposées ainsi que les

indicateurs les mesurant.

Tableau N°3 : les différentes variables

|

Grandes Variables

|

Indicateurs

|

|

Accès

|

Nombre de Nouveaux Bacheliers qui s'inscrivent dans un

établissement

|

|

Taux de croissance des effectifs par année

d'étude

|

|

Qualité

|

|

Taux de réussite au BTS

|

|

Taux d'admission

|

|

Rapport enseignant élève (Ratio)

|

|

Proportion d'enseignants étrangers

|

|

Proportion d'étudiants étrangers

|

|

Nombre d'enseignants ayant le diplôme de doctorat

|

|

Taux d'achèvement

|

|

Performance académique au regard de la taille de

l'institution

|

|

Points obtenus lors de l'enquête auprès des pairs

(divisée en cinq domaines)

|

|

Réponses à l'enquête auprès des

employeurs

|

|

Le niveau moyen d'admission du nombre d'étudiants

poursuivant un 2e et 3e cycle

|

|

Ampleur de la bibliothèque

|

|

Recherche et innovation

|

Nombre de prix Nobel et de médailles Fields parmi les

anciens élèves

|

|

Nombre de prix Nobel et de médailles Fields parmi les

chercheurs

|

|

Nombre de chercheurs largement

cités dans les disciplines des sciences du vivant, de

la médecine, de la physique, des sciences de l'ingénieur et des

sciences sociales.

|

|

Nombre d'articles publiés dans Nature et Science entre

2004 et 2009

|

|

Nombre d'articles répertoriés dans le

Science Citation Index-expanded (SCI

Expanded) et dans le Social Science

Citation Index (SSCI) en 2009. Les

|

|

articles du SSCI comptent double. (Le SSCI entre dans le

décompte des articles depuis 2006).

|

|

Nombre de citations divisé par le nombre de chercheurs

|

|

Bonne gouvernance

|

Dépense totale de l'enseignement de

l'établissement

|

|

Rapport salaire des enseignants/Dépense totale

|

|

Nombre de bourses attribuées aux

étudiants par an

|

|

Les frais de formation payés par chaque étudiant

dans chaque établissement

|

|

Subventions reçues pour la recherche et les

publications

|

|

Cours disponibles

|

|

Dépenses consacrées aux services des

étudiants

|

Source : Les auteurs, 2011.

Malgré les nombreux critères qui existent pour

évaluer les établissements, nous autres, nous ne pouvons pas

retenir tous ces critères compte tenu des réalités de

notre pays. Pour la suite de ce présent travail nous prendrons en compte

la qualité de l'enseignement et l'accès de l'enseignement pour

pouvoir élaborer notre indicateur composite.

CHAPITRE 3 : Méthodologie de recherche et

analyse des résultats

Pour atteindre nos objectifs, nous avons adopté une

démarche méthodologique qui se résume en plusieurs phases

:

3.1 Recherche documentaire

Après la prise de contact avec le personnel de la DPP,

nous avons commencé la recherche des ouvrages ayant trait à notre

thème. C'est ainsi que les recherches sur internet ont commencé,

la consultation des anciens mémoires de l'ENEAM et les documents sur les

EPES. L'examen des documents trouvés et dont la liste est publiée

dans la bibliographie nous a, d'une part, permis de cerner le contenu de la

notion de critère de performance ainsi que les instruments de sa mesure

et d'autre part de découvrir non seulement les différents travaux

déjà réalisés en la matière mais aussi les

différentes techniques d'élaboration d'un indicateur

composite.

Au vue de l'explication donnée au critère de

performance, ainsi que les variables qui permettront de le cerner, il s'agira

d'exposer ici quelques méthodes statistiques de construction des

indicateurs composites.

3.1.1 Quelques méthodes statistiques pour

élaborer un indicateur composite

Après nos recherches, nous avons retenu deux

méthodes pour l'élaboration d'un indicateur composite. Il s'agit

: une approche d'entropie et une approche d'inertie.

3.1.1.1 Approche entropie

L'approche d'entropie est issue de la mécanique

dynamique. Elle est beaucoup exploitée dans la théorie

statistique de l'information. Massoumi (1986) s'est basé sur cette

théorie pour proposer un indicateur composite optimal qui minimise une

somme pondérée de divergences deux à deux.

Soit X une variable aléatoire à valeur dans x1,

x2, ..., xn ; posons pi = P(X = xi) la probabilité de

réalisation de l'évènement X = xi. Soit g (pi) la

quantité d'information associée à la réalisation de

cet évènement.

L'entropie H(P) associée à cette distribution de

probabilité P se définit comme

n

l'espérance de

g p H p E g p

( ) : ( ) ( ( ))

= =?

p g p

( )

i i

i = 1

Si g ( pi ) = - log(

pi), on obtient l'entropie de Shannon dont l'expression est

donnée par :

n

H p

( ) = -? p p

log( )

i i

i = 1

Elle est comprise entre 0 et log(n), ces deux valeurs

correspondent respectivement aux évènements certains et aux

évènements équiprobables. Il devient ainsi possible de

définir des mesures pour capter la divergence entre deux distributions.

Les principales limites de cette approche résident dans le choix des

paramètres et des pondérations utilisées dans la forme

fonctionnelle de l'indicateur composite.

3.1.1.2 Approche d'inertie

Elle tire son origine du champ de la mécanique

statique. Elle est principalement basée sur les techniques d'analyses

multidimensionnelles, encore appelées analyses factorielles. Parmi les

principales techniques d'analyses factorielles utilisées, on peut citer

: l'Analyse Factorielle des Correspondances (AFC), l'Analyse en Composante

Principales (ACP), et l'Analyse Factorielle des Correspondances Multiples

(AFCM). Sur la base des différentes techniques, l'application de cette

approche à la construction d'un indicateur composite présente

l'avantage de laisser moins de place à l'arbitraire dans le choix des

pondérations.

Ensuite, si le but de l'AFC est d'analyser les relations entre

deux variables qualitatives à partir d'un tableau de contingence obtenu

du croisement de deux variables, l'ACP s'applique aux variables quantitatives

alors que l'Analyse factorielle des correspondances multiples (AFCM), est une

généralisation de l'analyse factorielle des correspondances

permettant de décrire les relations entre les différentes

modalités de plus de deux variables qualitatives simultanément

observées sur un ensemble d'individus.

Enfin, la limite de cette approche se résume sur les

différentes limites de ses méthodes. En effet, elles consistent

à faire observer des données dans un espace de

dimensions réduites. Ceci signifie qu'il peut y avoir

perte d'informations car en appliquant de telles méthodes on peut

effacer voire obscurcir certaines différences dans la population.

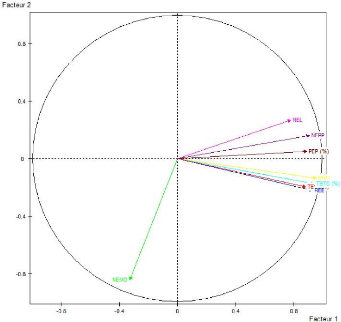

3.1.2 Justification et méthode adoptée

Comme décrit, chacune des deux méthodes

ci-dessus présentées comporte dans son application des limites.

Toutefois, pour ce travail, c'est l'approche par inertie qui sera

employée notamment à cause de son avantage d'éviter des

pondérations arbitraires dans la construction de l'indicateur, biais que

présente l'autre méthode. Principalement, vu la nature

quantitative de toutes nos variables, c'est l'ACP qui sera adoptée. En

voici une description sommaire.

La méthode adoptée ici pour la construction de

l'indicateur composite recherché est celle de l'approche par inertie, en

particulier l'Analyse en Composantes Principales (ACP).

Elle est une méthode exploratoire dans la mesure

où elle recherche à détecter d'éventuelles

structures latentes dans un jeu de données. En d'autres termes, cette

méthode vise à dégager des relations de ressemblance ou de

différence intéressantes entre les variables. L'ACP accorde la

même importance à l'ensemble des variables, c'est-à-dire

qu'il n'y a pas de variables dépendantes et indépendantes comme

dans une analyse confirmatoire qui vise plutôt la modélisation des

données. L'ACP fait partie de la famille des méthodes

factorielles. Dans la recherche des structures latentes, l'ACP opte pour une

simplification de la représentation graphique des données. Le

moyen utilisé pour ce faire est de construire des axes factoriels qui

vont définir un espace de dimensions réduites. Chaque axe est une

combinaison linéaire des variables et doit répondre à deux

conditions:

Les axes doivent être orthogonaux entre eux et le

premier axe doit décrire le maximum de l'information contenue dans les

données ; le second, le maximum de l'information restante, etc. C'est ce

qu'on appelle la condition d'optimisation.

L'Analyse en Composantes Principales utilisée dans le

cadre de cette étude, permet de détecter les corrélations

entre les variables et de réduire celles superflues. Le choix de cette

méthode factorielle s'est fait en fonction de la nature des

données. L'Analyse en Composantes Principales s'adresse à des

données quantifiables. C'est grâce au logiciel

SPAD que nous allons obtenir le poids de chaque variable pour

construire l'indicateur composite.

3.2 Entretiens et collecte des données

3.2.1 Entretiens

C'est une phase qui permet de consulter les personnes

ressources ayant des compétences dans les notions de critères de

performance et d'élaboration d'indicateurs composites. Ensuite, en

dehors de nos maîtres de mémoire et de stage, nous avons

rencontré certains de nos professeurs d'économie et de

statistique ainsi que les techniciens de l'INSAE et le DEPES, qui nous ont

aidés à bien cerner ces notions.

3.2.2 Collecte des données

Un indicateur utile devant être renseigné par des

données, nous avons alors procédé à la collecte

d'importantes informations chiffrées sans lesquelles les variables de

notre indicateur ne pouvaient être alimentées. Ladite collecte a

lieu auprès des structures (DEC, DEPES...) détenant les

informations. Certaines données ont été également

collectées dans certains documents fournis par la DPP (Annuaire

statistique 2008-2009)

3.3 Synthèse des indicateurs retenus et

explication des variables retenues

3.3.1 Synthèse des indicateurs retenus Tableau

N°4 : Synthèse des indicateurs retenus

|

Grandes variables

|

Indicateurs

|

|

Accès

|

Nombre de Nouveaux Bacheliers qui s'inscrivent dans un

établissement

|

|

Qualité

|