|

i

Table des matières

|

1

I

2

|

Introduction

Cadre conceptuel et théorique

Généralités sur la théorie

des treillis

2.1 Origine de la théorie des treillis

2.2 Treillis ordinale et treillis algébrique

2.2.1 Définitions algébrique et ordinale d'un

treillis

2.2.2 Irréductibles et générateurs minimaux

d'un treillis

2.3 Treillis de fermés et système de fermeture

2.3.1 Treillis de fermés

2.3.2 Système de fermeture

2.4 Treillis des concepts et treillis de Galois

7

|

1

5

6

6

7

10

15

16

16

16

|

|

|

2.4.1 Treillis des concepts

|

17

|

|

|

2.4.2 Treillis de Galois

|

18

|

|

3

|

Aspects algorithmiques des treillis

|

19

|

|

3.1

|

Algorithme de construction du graphe de couverture d'un

treillis . . .

|

20

|

|

3.2

|

Algorithme de construction de treillis de concepts

|

26

|

|

|

3.2.1 Définitions

|

26

|

|

|

3.2.2 Algorithme Genall

|

29

|

|

|

3.2.3 Etude de la compléxité

|

35

|

|

3.3

|

Algorithme de génération de treillis quelconques

|

35

|

|

|

3.3.1 Algorithme de L.Nourine

|

36

|

|

|

3.3.2 Etude de la compléxité

|

37

|

|

II

|

Application de la méthode

|

39

|

|

4

|

Fouille de données et navigation dans un

treillis

|

40

|

|

4.1

|

Bref aperçu sur les fouilles de données

|

40

|

|

|

4.1.1 La fouille d'images

|

41

|

|

|

4.1.2 La fouille de textes

|

41

|

|

|

4.1.3 La fouille du web

|

42

|

|

4.2

|

Chaîne d'extraction des connaissances

|

42

|

|

4.3

|

L'Analyse Formelle des Concepts

|

44

|

|

|

4.3.1 L'extraction de motifs fréquents

|

44

|

|

|

4.3.2 Algorithme d'extraction des motifs fréquents

|

46

|

|

|

4.3.3 Extraction de règles d'associations

|

48

|

ii

|

5

|

4.3.4 Règles d'association

4.3.5 Algorithme de génération de règles

d'associations valides . .

Application des treillis en représentation des

connaissances et extraction d'informations

|

49

50

53

|

|

5.1

|

Web sémantique et représentation des

connaissances

|

53

|

|

|

5.1.1

|

Web sémantique

|

53

|

|

|

5.1.2

|

Représentation des connaissances

|

54

|

|

5.2

|

Extraction d'informations

|

58

|

|

|

5.2.1

|

Recherche d'informations

|

59

|

|

|

5.2.2

|

Traitement automatique de la langue

|

60

|

|

5.3

|

Application des règles d'associations aux textes

|

63

|

|

|

5.3.1

|

Description du problème

|

63

|

|

|

5.3.2

|

Expérimentations

|

65

|

|

|

5.3.3

|

Extraction de connaissances par règles d'association

|

69

|

|

|

5.3.4

|

Interprétation des résultats

|

73

|

|

6

|

Conclusion et perspectives

|

78

|

iii

Table des figures

|

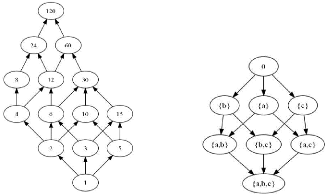

2.1

|

Exemple de treillis

|

10

|

|

2.2

|

Exemple de treillis distributif et treillis booléen

|

11

|

|

2.3

|

Autre exemple de treillis

|

12

|

|

2.4

|

Treillis de la figure 2.3 où sont precisés, pour

chaque noeud de x, les

|

|

|

ensembles Jx et Mx

13

|

|

|

2.5

|

Treillis des concepts du contexte de la table 2.3

|

18

|

|

3.1

|

Arbre lexicographique de la famille F

|

24

|

|

3.2

|

le graphe de couverture G = (F, ?)

|

26

|

|

3.3

|

Arbre lexicographique associé au dictionnaire

|

28

|

|

3.4

|

Matrice decrivant la relation R du contexte K =

(X, Y, R)

|

29

|

|

3.5

|

Treillis des concepts formels, extrait du contexte K,

décoré par quelques

|

|

|

générateurs minimaux

|

34

|

|

3.6

|

Un ordre qui ne représente pas un treillis

37

|

|

|

4.1

|

Chaîne d'extraction de connaissances

|

42

|

|

4.2

|

Exemple de treillis des parties ordonnées par inclusion

|

49

|

|

5.1

|

Exemple d'ontologie dans le domaine zoologique

|

54

|

|

5.2

|

Représentation graphique d'un ensemble classique et d'un

ensemble

|

|

|

flou

|

57

|

|

5.3

|

Schéma général de la recherche d'information

|

59

|

|

5.4

|

Représentation syntaxiques d'une phrase

|

62

|

|

5.5

|

Exemple d'un document du corpus

|

65

|

|

5.6

|

Treillis des concepts généré à partir

du logiciel Concept Explorer 1.3

|

76

|

iv

Liste des tableaux

|

2.1

|

Générateurs minimaux des éléments du

treillis de la figure 2.3 . . . .

|

13

|

|

2.2

|

Table du treillis de la figure 2.3

|

15

|

|

2.3

|

Exemple de contexte

|

17

|

|

3.1

|

Notation utilisée dans l'algorithme GENALL

|

31

|

|

3.2

|

Le contexte d'extraction K

|

33

|

|

4.1

|

Exemple de base de données formelle

|

45

|

|

5.1

|

Illustration de l'appartenance à A, selon la

théorie choisie

|

58

|

|

5.2

|

Contexte d'extraction associé à la base de

données textuelle (Livres

|

|

|

éléctroniques et mots clés)

|

68

|

|

5.3

|

Mots clés candidats à l'analyse et leurs supports

respectifs

|

70

|

|

5.4

|

Dépendance des règles d'association

|

74

|

|

5.5

|

Intérêt des règles d'association

|

75

|

v

Avant propos

Avant de soumettre ce travail aux critiques de ceux qui sont

épris du goût de la connaissance, nous tenons à remercier

tous ceux qui, par leurs connaissances, nous ont apporté soutien,

assistance et consolation durant notre parcours universitaire et nous ont

prêté main forte pour la réalisation du présent

travail.

Nos remerciements s'adressent à l'Eternel notre Dieu

pour la grâce, la paix, la force nous accordées dès nos

premiers pas sur le chemin de l'éducation jusqu'au jour où nous

rédigeons ce travail. Que l'honneur, la magnificence et la gloire Lui

appartiennent aux siècles des siècles, Amen!

Nos sentiments de profonde gratitude s'adressent au Professeur

Kaninda Mu-sumbu pour nous avoir fait l'honneur de diriger ce travail.

Notre reconnaissance s'adresse à tous les professeurs,

chefs des travaux et assistants de la faculté des sciences et en

particulier à ceux du département des mathématiques et

informatique, à savoir : Professeur Saint Jean Djungu, Professeur

Bavueza Munsana Daniel, Professeur Ramadhani Issa, Professeur Mabela Matendo

Rostin, Professeur Bukweli Kyemba Joseph Désiré, Professeur

Ntumba Pele, Professeur Kalala Mutombo Franck, Professeur Yumba Nkasa,

Professeur Lubala Toto Ruanaza, CT Lunda Mwakono, CT Balowayi Bondo Bernard, CT

Omari Baba, CT Nkomba Tshola Norbert, Chargé des cours Kumakinga Mobimba

Patrice, Chargé des cours KATOTO, CT Kumwimba Didier, CT Charles

Kitenge, Ass Mathina di Mathina, Ass Bukasa Serge, Ass Mulumba Bidwaya, Ass

Bula Axel, Ass Mayuke Jean-Paul, Ass Tshidingi Matthieu, Ass Tailoshi Mateso

Brigitte, Chargé des cours Marc Songolo pour nous avoir donné la

formation et la connaissance nécessaires.

Nos remerciements s'adressent également à nos

amis et connaissances, neveux et nièces, cousins et cousines à

savoir : Kishiko Cedrick, Kabuya Arsène, Faila Annie, Wasingya

Héritier, Banza Ilunga Shoudelle, Nzaji Gabriel, Mukatshung Elvis,

Mwenge Kestia, Mwilambwe Joyce,...Pour leurs affection, conseils et leurs

soutien nous témoignés. Les amis nous sécurisent et nous

réequilibrent. Les ennemis et les obstacles nous traumatisent, mais nous

poussent à remettre constamment notre vie et notre univers en question

et nous font comprendre que « La vie n'est jamais un acquis.

»

Enfin, que toute personne dont le nom ne figure pas dans ce

travail, trouve ici l'expression de notre sincère reconnaissance.

Plaise à la divine bonté de vous accorder ses

belles et solides récompenses que recevront les justes dans

l'au-delà.

SUNGU NGOY Pascal

1

Chapitre 1

Introduction

L

E 4 mai 1980, alors que le pays s'appelait encore

Zaïre, le Pape Jean-Paul II, alors aux affaires au Vatican, s'adressait

aux intellectuels de la République Démocratique du Congo et

encourageait les universitaires à poursuivre les objectifs de science et

de conscience qui sont l'apanage de toute formation universitaire.

Nous voilà 35 ans plus tard, en train d'accomplir ce

devoir noble que nous ont légué nos parents.

Une des caractéristiques du travail universitaire et du

monde intellectuel est que, plus qu'ailleurs peut-être, chacun se trouve

constamment renvoyé à sa propre responsabilité dans

l'orientation qu'il donne à son travail. Le nôtre, vous

présente deux facettes : la première est tournée vers les

mathématiques et la seconde vers l'intelligence

artificielle. Ces facettes sont complémentaires et constituent les

deux ailes dont nous avons besoin pour voler vers la connaissance.

1.1 Choix et intérêt du sujet

Il est un fait que les mathématiques sont de plus en

plus présentes en science et interviennent dans beaucoup de domaines. Si

la forte composante mathématique dans plusieurs domaines n'est un secret

pour personne, nombre de gens découvrent avec effroi qu'ils devraient

« faire les maths » dans le cadre de leurs études.

Au-delà de ces possibles déceptions, le caractère abstrait

des mathématiques les rend hostiles à beaucoup de personnes,

opposant ainsi une résistance hermétique à la moindre

équation. Alors, pourquoi servir les mathématiques à

toutes les sauces jusque dans les domaines où on ne les attendaient pas

a priori? Est-ce un phénomène de mode ou une réelle

nécessité? En toute honnêteté, on ne peut pas

exclure le phénomène de mode.

En effet, le caractère réputé difficile

des mathématiques évoqué ci-dessus fait que celles-ci

impressionnent et par là inspirent une certaine forme de respect : elles

rendent tout de suite une étude plus sérieuse ou un chercheur

plus savant. Ainsi il arrive que les mathématiques soient effectivement

utilisées sans aucune nécessité particulière,

simplement pour donner au discours une apparence plus scientifique.

Au-delà de ce phénomène de mode, le but de ce travail est

toutefois de convaincre que si les mathématiques sont de plus en plus

utilisées, c'est aussi et surtout parce qu'elles sont réellement

utiles à la démarche scientifique en général, et

dans le domaine de fouille de données et la représentation des

connaissances en particulier.

L'exploration des données pour en extraire des

connaissances est une préoccupa-

2

tion constante de l'être humain car elle est une

condition essentielle de son évolution. L'homme a toujours

mémorisé sur des supports différents des informations qui

lui ont permis d'inférer des lois. En effet, le développement des

capacités de stockage et les vitesses de transmission des réseaux

ont conduit ce dernier à accumuler de plus en plus de données.

Certains experts estiment même que le volume des données double

tous les ans. Ainsi, il a fallu une méthode pouvant traiter ces

données et bien les structurer afin d'en extraire les connaissances

indispensables. Le data mining en tant que méthode

mais aussi en tant qu'art d'extraire les connaissances à

partir d'une base de données utilise des outils et la structure de

treillis s'est avérée être un outil adéquat en

vue de permettre au data mining d'arriver à ses fins.

Quant à l'intérêt porté sur ce

thème, trois aspects essentiels sont à relever :

1. Intérêt scientifique;

2. Intérêt personnel;

3. Intérêt social.

Sur le plan scientique, cette étude nous permet

d'appréhender la notion de fouille de données textuelles en se

servant des outils mathématiques qu'est la structure de

treillis.

Sur le plan personnel, le thème sous étude nous

permet de fouiller dans le profondeur de la science, les quelques notions sur

les structures de treillis pouvant nous permettre, dans l'avenir, de

représenter les connaissances qu'on aura extraites de nos bases de

données géologiques.

Sur le plan social, notre travail constituera un outil pour

des nombreux chercheurs qui effectueront des investigations analogues au notre

pour leurs recherches à comprendre l'extraction de connaissances

à partir des bases de données.

1.2 Problématique

La problématique est considérée comme une

question maîtresse à laquelle nous allons répondre tout au

long du travail.

Cependant, la seule question qu'il importe de ne pas se poser

c'est : « pourquoi... ? ». Nous pouvons plutôt nous

demander « comment une science aussi exacte et rigoureuse

comme les mathématiques peut être utilisée pour comprendre

l'extraction des connaissances à partir des bases de données

textuelles ? » Le présent travail éclairera

votre lanterne.

1.3 Hypothèse

L'hypothèse est l'ensemble de réponses

provisoires posées sur un sujet d'étude lesquelles attendent une

vérification.

En effet, l'Analyse Formelle des Concepts en tant que branche

de la théorie des treillis permettant la génération des

règles d'association à partir des concepts formels, s'est

avéré être un cadre théorique intéressant

pour la fouille de données. Introduite par Wille en 1980, elle est

appliquée à l'acquisition automatique de connaissances,

elle a donc pour objectif d'étudier le problème de l'extraction

et de la représentation des connaissances sous l'angle de la

théorie mathématique des treillis.

3

1.4 Etat de l'Art

Rien n'étant nouveau sous le soleil, pas même le

sujet que nous traitons à ce jour, il est important de mentionner les

travaux qui ont été réalisés avant nous. Cependant,

nous évoquerons les travaux réalisés par:

1. Karell Bertet portant sur La

structure de treillis ainsi que ses contributions algorithmiques. Ses

travaux portent sur la structure de treillis avec des contributions qui se

situent à la fois sur un plan fondamental, avec des aspects structurels

et algorithmiques des treillis, et sur un plan applicatif, avec l'étude

de quelques usages de treillis pour de données images.[1]

2. Yannick Toussaint lui,

nous a présenté Les méthodes symboliques pour la

construction d'ontologies et l'annotation sémantique guidée par

les connaissances appliquées à la fouille de textes. Dans

cette thèse, il construit une ontologie à partir d'une base de

données textuelles, en nous montrant que la construction de cette

ontologie depend à la fois du domaine et de la tâche à

laquelle cette ontologie est déstinée.[11]

Pour ce qui nous concerne, nous avons étudié

l'impact de la structure de treillis dans le domaine de data mining en

considérant une base de données constituées des documents

éléctroniques et nous avons extrait mais aussi

représenté ces connaissances à l'aide de cette

théorie mathématique de treillis.

1.5 Méthodes et techniques de recherche

Pour bien effectuer notre recherche, nous avons utlisé

l'Analyse Formelle des Concepts qui est une branche de la théorie de

treillis nous permettant d'extraire les connaissances de manière

automatique à partir d'une base de donnée avec un outil

appelé règles d'association.

1.6 Délimitation du sujet

Dans ce sujet, il sera question de montrer l'utilisation des

outils mathématiques, les treillis, en extraction et

représentation des connaissances en utilisant les règles

d'associations. Par la suite, nous allons générer un treillis

associé aux connaissances extraites de la base de données et nous

allons éventuellement interpréter ces résultats en se

basant sur quelques indices stastiques associés aux règles

d'association : le support, la confiance,...

En revanche, nous ne vous présenterons pas un logiciel

approprié capable d'ex-traire et de représenter ces

connaissances. Cela fera l'objet de nos travaux ultérieurs.

4

1.7 Division du travail

Notre travail est subdivisé de la manière

suivante :

Le premier chapitre est consacré à

l'introduction afin de présenter le travail de manière sommaire.

Le deuxieme chapitre traite de la structure de treillis qui constitue

même la théorie mathématique sur laquelle portera notre

étude. Dans le souci de rendre cette étude plus sérieuse,

afin, non seulement de réveiller la curiosité, mais aussi

d'attirer l'attention des « non boréliens » ou « non

matheux », nous présenterons, en plus, un aspect algorithmique

des treillis. Tel est l'objet du troisième chapitre.

Les structures mathématiques, y compris les treillis,

étant, cependant, des notions non concrètes, il sera important de

les utiliser dans un domaine concret afin de les rendre plus «

palpables». C'est ainsi que nous consacrerons tout un chapitre qui

sera intitulé Fouille de données et navigation dans un

treillis.

Le data mining est cet art d'extraire des

connaissances à partir de données, lesquelles

données auront besoin d'être traitées mais aussi

représentées à des fins soit de

prédiction, soit de description. En effet, pour manipuler ces

connaissances, les notions sur les modèles de représentation des

connaissances reposant essentiellement sur des théories issues de la

logique sont nécessaires. C'est dans ce cadre que, dans notre

cinquième chapitre, nous appliquerons les structures vues au

deuxième chapitre dans la représentation de ces connaissances et

la recherche d'information. Par la suite, nous vous présenterons, une

conclusion générale de ce qu'aura été notre travail

ainsi que nos perspectives dans ce domaine.

Première partie

5

Cadre conceptuel et théorique

6

Chapitre 2

Généralités sur la théorie

des treillis

C

E chapitre a pour but d'introduire les éléments

de base de la théorie des treillis, et s'organise de la manière

suivante : La section 2.1 présente un bref historique de la

théorie de treillis. La section 2.2 pose les définitions

algébrique et ordinale d'un treillis qui introduisent toutes deux la

notion de borne superieure et borne inferieure (section 2.2.1). La

théorie des treillis repose en partie sur l'existence

d'éléments particuliers d'un treillis que sont ses

éléments irréductibles qui décrivent la structure

même du treillis, et servent à en définir ses

générateurs minimaux (section 2.2.2). C'est sur la base des

éléments irréductibles que se définissent des

représentations d'un treillis qui contiennent l'information

nécessaire à sa reconstruction. Il sera introduit

également, dans cette section, la table d'un treillis ainsi que son

graphe de dépendance (section 2.2.3)

La section 2.3 introduit la représentation d'un

treillis sous forme ensembliste par une famille de parties d'un ensemble S,

stable par intersection et contenant S lui-même. Cette

représentation permet ainsi de manipuler de façon

équivalente un treillis sous sa forme algébrique, ordinale ou

ensembliste, car tout treillis est représentable par un treillis de

fermés (section 2.3.1). Un treillis de fermés est classiquement

associé à un système de fermeture, ensemble muni d'un

opérateur de fermeture, et l'apport principal de cette

représentation ensembliste reside dans le lien unissant treillis et

système de fermeture (section 2.3.2). En effet, tout treillis

étant représentable par un treillis de fermés, il l'est

également par un système de fermeture.

Le système de fermeture étant un ensemble muni

d'un opérateur de fermeture est utilisé, non seulement dans le

treillis des concepts (section 2.4.1) mais aussi dans le treillis de Galois

(section 2.4.2) qui est présenté comme une

généralisation du treillis des concepts à des

données plus complexes pour lesquelles il existe une connexion de

Galois. Ce deux notions réunit feront l'objet de la section 2.4.

2.1 Origine de la théorie des treillis

La notion de treillis définie comme une structure

algébrique munie de deux opérateurs appelés borne

inférieur et borne supérieur a été introduit par

Dedekind et Ernest Schöder, puis oubliée. Elle a été

redécouverte et développée au 20e siècle

sous diverses formes et terminologies entre 1928 et 1936 dans les travaux de

Merger, Klein, Stone, Garrett Birkhoff, Oystein Öre ou encore Von Newman.

L'introduction d'un treillis sous forme ordinale, structure ordonnée

définie par l'existence d'élé-

7

ments particuliers appelés bornes superieures et

inferieures, trouve son origine dans les axiomatiques des treillis

booléens dues à Pierce en 1880 ou à Huntington. Le terme

de treillis a, quant à lui, été proposé

par Birkhoff lors du premier symposium sur la structure de treillis en 1938,

pour être finalement repris dans son ouvrage de référence

« G. Birkhoff. Lattice theory. American Mathematical society,

1st edition, 1967 ». De nombreux ouvrages sur la

théorie de treillis portent sur la définition ordinale, en

particulier celui de Davey et Priestley ou encore de Grätzer.[2]

Un resultat fondamental de la théorie des treillis se

constitue, selon Karell Ber-tet[1], autour d'un résultat principal qui

établit que tout treillis fini est isomorphe au treillis de Galois ou

treillis de concepts de sa table. Barbut et Monjardet introduisent ainsi le

terme de treillis de Galois, alors que le terme de correspondance de Galois a

quant à lui été introduit par Öre en 1944. Plusieurs

travaux font apparaître la notion d'éléments

irréductibles d'un treillis qui permettent par exemple de

caractériser certaines classes de treillis, ou encore d'en concevoir des

représentations compactes du treillis.

Le treillis des concepts a été introduit dans

les années 1980 par Wille dans le cadre de l'Analyse Formelle des

Concepts( AFC) avec un ouvrage de référence dantant de 1999,

« Formal Concept Analysis, Mathematical foundations. Spriger Verlag,

Berlin, 1999 ». L'AFC est une approche à la représentation

des connaissances en pleine emérgence dans les années 90 qui

définit le treillis des concepts à partir de données

binaires de types Objet x attributs. L'émergence du treillis des

concepts ces dernieres années s'explique à la fois par la part

grandissante de l'informatique dans la plupart des champs disciplinaires, ce

qui conduit à la production de données en quantité de plus

en plus importante ; mais également par la recente montée en

puissance des ordinateurs qui, bien que la taille du treillis puisse être

exponentielle en fonction des données dans le pire des cas, rend

possible le développement d'un grand nombre d'applications le

concernant.[1]

2.2 Treillis ordinale et treillis algébrique

2.2.1 Définitions algébrique et ordinale d'un treillis

On appelle treillis ou lattis ou encore

ensemble réticulé, un ensemble partiellement

ordonné dans lequel, pour toute paire d'éléments, existent

une borne inférieure et une borne

supérieure[4]. On trouve, également, dans la

littérature deux autres définitions d'un treillis : Une

définition algébrique et une définition ordinale. Ces

définitions introduisent toutes deux la notion de borne

supérieure (ou supremum) et de borne inferieure

(ou infimum) alors qu'il s'agit d'opérateurs binaires dans

la définition algébrique, ce sont des éléments

particuliers dans la définition ordinale.[1]

Définition 1 (Définition

algébrique)

Un treillis ou encore une algèbre de

treillis est un triplet L = (S, V, ?) ou V et ?

sont deux opérateurs binaires sur l'ensemble S qui

vérifient les propriétés suivantes :

- Associativité : Pour tout x, y, z

E S, (x V y) V z = x V (y V

z) et (x ? y) ? z = x ? (y ?

z).

- Commutativité : Pour tout x, y E

S, x V y = y V x et x ? y = y

? x

- Idempotence : Pour tout x E S,

x V x = x = x ? x

8

- Loi d'absorption : Pour tout x, y E

S, x V (x ? y) = x = x ?

(x V y)[1] Définition 2 (Définition

ordinale)

Un treillis est une paire L =

(S,<) où < est une relation d'ordre sur

l'ensemble S, c'est à dire une relation binaire qui

vérifie les proprietés suivantes :

- Réflexivité : Pour tout x E

S, on a xRx.

- Antisymetrie : Pour tout x, y E S,

xRy et yRx impliquent x = y.

- Transitivité : Pour tout x, y, z E

S, xRy et yRz impliquent xRz.[1][3]

Un ensemble sur lequel est défini une relation d'ordre

(partiel ou total) est dit (partiellement ou totalement) ordonné.

Considérons un ensemble S partiellement

ordonné par la relation < (être inférieur ou égal

à) et une partie X de cet ensemble[4] ;

Définition 3 Minorant (Majorant) :

Un élément m(M) de S

qui est inférieur (supérieur) ou égal à tout

élément x de X est un minorant (majorant)

de X.

Définition 4 Elément maximal (minimal)

:

Un élément noté T(1) de X, tel

qu'il n'existe pas d'éléments de X supérieur

(inférieur) à T(1) est un élément maximal

(minimal) de X.

Définition 5 Plus grand (petit)

élément :

Le plus grand (petit) élément

E(e) ou encore le maximum (minimum) de X est

l'élément de X tel que pour tout x E

X, E > x(e < x).

Définition 6 Borne supérieure

(inférieure) :

La borne supérieure (inférieure) de X

Ç S notée VX (?X) ou le supremum

(infimum) de X noté sup(X) (inf(X) ) est le

plus petit (grand) élément de l'ensemble des majorants

(minorants) de X. Les bornes inférieure et supérieure

entre x et y notée respectivement par x ?

y et x V y se définissent de la même

manière que pour une partie X Ç S

Définition 7 Elément universel (nul)

:

L'élément universel (nul) de S est le

plus grand (petit) élément de S. Exemple

1

Soit S = {1, 2, 3, 5,

10, 20, 30} un ensemble partiellement ordonné

par la relation x||y (x divise y).

N.B : x||y peut s'interpréter comme x

< y et x|y comme x < y.

1. Prenons X = {2, 3,5,

10}

Il existe un majorant de X qui vaut 30 et un

minorant qui vaut 1, un élément maximal : 10,

trois élément minimaux : 2, 3, 5 ni

plus grand élément, ni plus petit élément de X. La

borne supérieure de X est 30 et la borne inférieure vaut

1. S

9

n'admet pas d'élément universel, mais un

élément nul : 1.

2. Prenons maintenant X = {2,

5,10}

X compte 3 majorants : 10, 20,

30, un minorant : 1, un élément maximal :

10, deux éléments minimaux : 2 et 5,

un plus grand élément : 10, pas de plus petit

élément. La borne supérieure de X est 10 et la

borne inférieure est 1.

Pour une partie réduite à deux

éléments {x, y}, d'un ensemble ordonné, il peut

exister une borne inférieure, une borne supérieure. Lorsque seule

l'existence de la borne inférieure est vérifiée, on parle

d'inf-demi-treillis. Un sup-demi-treillis est défini

dans le cas dual où seule l'existence d'une borne supérieure est

vérifiée. Un treilis est donc à la fois un

inf-demi-treillis et un sup-demi-treillis[1].

Définition 8 (Relation d'ordre strict)

:

Une relation d'ordre strict notée <

est une relation vérifiant les propriétés suivantes

:

- Irréflexive : Pour tout x E

S, (x, x) E6 R.

- Asymétrique : Pour tout x, y E

S, (x, y) E R implique (y, x) E6

R.

- Transitive : Pour tout x, y, z E S,

(x, y) E R et (y, z) E R = (x, z)

E R.[5]

Définition 9 (Relation de couverture)

:

On dit qu'un couple (x, y) E X x X

avec X C_ S est une couverture ou que y

couvre x (y est successeur immédiat de

x) ou encore x est couvert par y (x est

prédécesseur immédiat de y), s'il

n'existe pas z tel que x < z < y lorsque x <

y. Elle est notée par "-<" et elle se déduit de la

relation d'ordre en supprimant les relations de

réflexivité et de transitivité[6].

Définition 10 (Diagramme de Hasse) :

La représentation graphique d'un treillis s'exprime

à l'aide d'un diagramme, appelé diagramme de Hasse, dans

lequel les noeuds correspondent aux éléments de l'ensemble et les

arcs aux relations de couverture (successeurs et prédécesseurs

immédiats) entre ces noeuds.

Le plus souvent, Relation binaire et Graphe

orienté simple (C'est-à-dire un graphe sans arcs multiples)

s'identifient où chaque élément est

représenté par un sommet du graphe, et où la relation

entre deux éléments x et y est

représentée par un arc du graphe entre le sommet x et le

sommet y. Le diagramme de Hasse, tel que décrit

ci-haut, est une représentation proche de la représentation

habituelle d'un graphe ; les orientations des arcs ne sont pas toujours

représentées parce qu'elles peuvent se déduire du

positionement des noeuds. Ainsi il permet de ne pas surcharger le dessin pour

faciliter une meilleure lisibilité[1].

Exemple 2

Considérons, à titre d'exemple, les diviseurs

de 30 : {1, 2, 3, 5,

6,10,15, 30} ordonnés par la relation

x divise y[4]. Ces éléments forment un treillis dont le

diagramme de Hasse est donné par la figure Figure

2.1.

On peut vérifier que toute paire

d'éléments admet une borne inférieure(p.g.c.d) et

une borne supérieure(p.p.c.m). Ainsi :

- 5 V 6 = 5 x 6 = 30; 5 ? 6 = 1; 6 V 15 = 5 x 3 x 2 = 30; 6 ?

5 = 3; etc. L'élément

10

FIGURE 2.1 - Exemple de treillis universel de ce treillis est 30

et l'élément nul est 1.

Définition 11 (Treillis distributif)

:

Un treillis est distributif si V et ? verifient la

proprieté de distributivité : Pout tout x, y, z E

S, x V (y ? z) = (x V y) ? (x

V z).[5]

Définition 12 (Treillis

complémenté) :

Un treillis est complémenté si tout

élément x E S admet au moins un

complément, c'est-à-dire un élément x' E

S tel que x V x' = T (élément

maximal) et x ? x' = 1 (élément

minimal)[1].

Définition 13 (Treillis

V-Complémenté) :

Un treillis est V-Complémenté si pour tout

élément x E S, il existe un V-complément

(c'est-à-dire un élément x' E S tel que

x V x' = T). Un treillis

?-complémenté est défini dans le cas

dual[1].

Définition 14 (Treillis booléen)

:

Un treillis est booléen s'il est à la fois

distributif et compléménté[1].

Exemple 3

Un exemple classique d'un treillis distributif est

fourni à la figure 2.2(a). La relation d'ordre est la relation

« ... divise... ». L'ensemble P(S) des parties d'un ensemble

S muni de la relation d'inclusion est quant à lui un exemple

classique de treillis booleen (figure 2.2(b))[1]

2.2.2 Irréductibles et générateurs

minimaux d'un treillis

Soient x ? y et x V y les

bornes inférieur et supérieur respectivement. Un

élément d'un treillis est dit réductible s'il est

résultat de x ? y ou x V y. Dans le

cas contraire, il sera dit irréductible.

11

FIGURE 2.2 - Exemple de treillis distributif et treillis

booléen.

Définition 15 (Elements irréductibles)

Soit L = (S, ) un treillis.

- Un élément j E S est appelé

sup-réductible s'il existe dans S des éléments

x1 et x2 tel que j = x1 V

x2 avec x1 < x et x2 <

x. Un élément x de S ne possédant pas de

décomposition de cette forme est dit

sup-irréductible.

- Dualement, un élément in E S est appelé

inf-réductible s'il existe dans S des éléments

x1 et x2 tel que j = x1 ?

x2 avec x1 > x et x2 >

x. Un élément x de S ne possédant pas de

décomposition de cette forme est dit inf-irréductible.

L'ensemble des sup-irréductible et celui des

inf-irréductible du treillis L est noté respectivement

par JL et ML[3].

Proposition 1

Soit L = (S, ) un treillis.

- Un élément j E S est un

sup-irréductible, si et seulement si j couvre un seul

élément dans le diagramme de Hasse.

- Un élément in E S est un

inf-irréductible, si et seulement si in est couvert par un seul

élément dans le diagramme de Hasse.

Définition 16 (Treillis atomistique) :

Un treillis est dit atomistique lorsque tous les

sup-irréductibles sont des atomes (un atome est un

élément qui couvre l'élément minimal I).[3]

Définition 17 (Treillis co-atomistique) :

Un treillis est dit co-atomistique lorsque tous les

inf-irréductibles sont des co-atomes (un co-atome est un

élément qui est couvert par l'élément maximal T).

Tout élément x E S d'un treillis L = (S, ) est la borne

supérieure de l'ensemble de ses prédécesseurs, ainsi que

la borne inférieure de l'ensemble de ses successeurs. La

12

FIGURE 2.3 - Autre exemple de treillis

définition latticielle permet d'établir qu'il

est possible de réduire ces ensembles aux seuls

prédécesseurs sup-irréductibles, et un successeurs

inf-irréductibles[3] :

x = ?Jx = ?{y

sup-irréductible tel que y = x} (2.1)

x = ?Mx = ?{y

inf-irréductible tel que y = x} (2.2)

Par conséquent, les ensembles d'éléments

irréductibles peuvent nous permettre de reconstruire le treillis dans sa

globalité par reconstruction successives de bornes supérieures ou

de bornes inférieures en utilisant respectivement les

sup-irréductibles et les

inf-irréductibles.[1]

Exemple 3

Considérons la figure 2.3. Nous constatons

que seul six éléments possèdent un seul arc

entrant, et forment ainsi l'ensemble des sup-irréductibles

alors que les inf-irrédutibles,

caractérisés, quant à eux, par un seul arc sortant sont au

nombre de huit:

J = {b, f, e, a, c, d} (2.3)

M = {b,l,m,n,d,k,i,c} (2.4)

Quatre sup-irréductibles {b, f, e,

a} sont des atomes et que trois inf-irréductibles

{l, i, c} sont des co-atomes. Ces éléments

irréductibles sont utilisés dans le treillis de la figure 2.4

où dans le noeud de chaque élément x sont

precisés l'ensemble Jx des

sup-irréductibles inférieurs ou égaux à

x ainsi que l'ensemble Mx des

inf-irréductibles supérieurs ou égaux à

x. Les générateurs minimaux de chaque

élément sont, quant à eux, donnés par la table

2.1. On peut ainsi observer que chaque sup-irréductible est son

propre générateur minimal, mais aussi que tous les

éléments, excepté l'élément maximal T, ont

pour unique générateur minimal l'ensemble de leurs

prédécesseurs sup-irréductibles.[1]

TABLE 2.1 - Générateurs minimaux des

éléments du treillis de la figure 2.3

13

FIGURE 2.4 - Treillis de la figure 2.3 où sont

precisés, pour chaque noeud de x, les ensembles

Jx et Mx

14

Définition 18 (Générateur

minimal)

Soit L = (S,=) un treillis et x ?

S un élément du treillis. Un

générateur minimal de x est un sous ensemble B

de Jx tel que x = ?B et qui soit

minimal au sens de l'inclusion, c'est-à-dire pour tout A ?

B, on a x < ?A. La famille

âx des générateurs minimaux de x

se définit par :[6]

âx = {B ? Jx :

x = ?B et x < ?A pour tout A ?

B} (2.5)

Définition 19 (Table et graphe de

dépendance d'un treillis)

La notion d'éléments irréductibles d'un

treillis permet de concevoir des représentations compactes du treillis

entre autre la représentation par une table composée en colonne

par des sup-irréductibles et en ligne par des

inf-irréductibles. Il existe, cependant, une différence

entre une table binaire d'un treillis et une table

complète.[1]

La table (complète) d'un treillis se

définit à partir des relations flèches qui

parti-tionnent les différents liens possibles entre un

sup-irréductible et un inf-irréductible à

l'aide de relations binaires définies sur JL ×ML.

Nous avons entre autre, la relation de comparabilité = qui

permet d'établir une première partition de JL ×

ML en deux parties notées P= et

P6= définit par :

P= = {(j,m) ? JL ×

ML : j = m} (2.6)

P6= = {(j,m) ? JL ×

ML : j =6 m} (2.7)

Définition 20 (Relations

flèches)

Soit L = (S,=) un treillis, j ?

JL et m ? ML. Une relation flèche

est définit comme suit[1] :

- j ? m si j =6 m et

j < m+(unique successeur, dans le diagramme de Hasse,

pour tout m ? ML).

- j ? m si j =6 m et

j- < m avec j- unique

prédécesseur pour tout j ? LL. Notons que les

relations flèches (j ? m et j ?

m ) affinent les cas où j et m ne sont pas

comparables. C'est-à-dire, de cette relation

d'incomparabilité, il en résulte quatre autres

combinaisons possibles qui permet de partitionner l'ensemble de paires (j,

m) ? P6= en quatre parties notées P?,

P?, Pl, P? définit par :

P? = {(j,m) ? JL ×

ML : j ? m et j ?6m} (2.8)

P? = {(j,m) ? JL ×

ML : j ?6m et j ? m} (2.9)

Pl = {(j, m) ? JL ×

ML : j ? m et j ? m} (2.10)

P? = {(j,m) ? JL

× ML : j ?6m et j ?6m} (2.11)

La table d'un treillis se définit comme étant

une représentation tabulaire de ce partionnement.

meture se sont avérées fondamentales

pour plusieurs domaines de l'informatique : Base de données, Analyses

formelles de concepts.

15

TABLE 2.2 - Table du treillis de la figure 2.3

Définition 21 (Table d'un treillis) :

La table T d'un treillis L = (S, <)

est composée des sup-irréductibles qui apparaissent

en colonne et des inf-irréductibles qui apparaissent en ligne.

Ainsi pour m E ML et j E JL, la table

T[m, j] contient x, t, 1,, $ ou o selon que (m, j)

appartienne à P<, Pt, P~, P$

ou Po(cf table 2.2).

Il vient que la table binaire se définit

juste à partir d'une seule partition composée de deux parties

P< et Pg où T[m, j] contient x si (m,

j) E P< et rien dans le cas contraire, c'est-à-dire le

cas où (m, j) E Pg

Notons que lorsque la table (complète)

possède exactement une double flèche sur chacune de ses lignes et

colonnes, alors on parle d'un treillis distributif. Un treillis

atomistique se caractérise quant lui par l'absence de flèche

t dans sa table, alors qu'un treillis co-atomistique se

caractérise par l'absence de flèche 1,. Il en découle que

la table d'un treillis booléen, qui en revanche est à la

fois distributif, atomistique et co-atomistique se

carastérise par une unique double flèche $ sur chacune de ses

lignes et colonnes, ainsi que par l'absence de flèches simples t et

1,.[1]

Définition 22 (Graphe de dépendance)

:

Le graphe de dépendance se définit

pour les sup-irréductibles sur la base de la relation de

dépendance. Soit L = (S, <) un treillis, le

graphe de dépendance du treillis L est un graphe

valué G = (JL, 8, w) tel que :

- 8 relation de dépendance définie sur

JL par j8j'. Alors 8 est une relation de

dépendance s'il existe un élément de l'ensemble S

qui ne majore pas j et j' éléménts

de JL, c'est-à-dire s'il existe x E S tel que

j <6 x, j' <6 x et j < j'

V x ;

- w une valuation des arcs définie pour

chaque relation j8j' de tel sorte que l'arc (j, j') peut

être valué par les générateur minimaux de

x, c'est-à-dire les parties de l'ensemble

Jx défini pour x :[5]

Jx = {j < x

tel que j E JL}

2.3 Treillis de fermés et système de

fermeture

Comme la notion de treillis, les familles de Moore, dites aussi

systèmes de fer-

16

Soit S un ensemble stable. Une famille de Moore

est une famille de parties fermées de l'ensemble S stable

par intersection et contenant l'ensemble lui-même. Elle est aussi

définie comme étant une partie de l'ensemble de parties de S

vérifiant certaines propriétés(cf définition

8)[1].

2.3.1 Treillis de fermés

Toute famille F E P(S) munie de la relation

d'inclusion est ordonnée, l'inclusion étant transitive,

réflexive et antisymétrique. Il s'en suit que (F, Ç)

est un treillis. On parle alors de treillis de fermés.

Définition 23 (Treillis de fermés) :

Un treillis de fermés sur un ensemble S est

une paire (F, Ç) où F est une famille sur S

possèdant les propriétés d'une famille de Moore,

encore appelée famille de fermés[3] :

- F contient S ;

- F est stable par intersection : Pour tout

F, F' E F, on a F n F' E F

Exemple 4 :

Soit S = {a, b, c, d, e}. Alors F = {ø, a,

b, d, de, bcd, abcde} est une famille de Moore sur l'ensemble S.

Les ensembles finis, ici, sont notés comme des mots. Par exemple

»de» designe la paire {d, e}

2.3.2 Système de fermeture

La propriété principale des treillis de

fermés reside dans le lien qui les unissent au système de

fermeture.

Définition 24 (Système de fermeture) :

Un système de fermeture est une paire C =

(S, ?) où S est un ensemble et ? un

opérateur de fermeture, c'est-à-dire une application

définie sur P(S) à la fois isotone,

extensive et idempotente[3] :

- isotonie : Pour tout X, Y Ç S, X

Ç Y = ?(X) Ç ?(Y ).

- extensivité : Pour tout X Ç S,

X Ç ?(X).

- idempotence : Pour tout X Ç S,

?(?(X)) = ?(X).

Pour une partie X Ç S quelconque, ?(X)

est appelée fermeture de X ou encore un fermé

de C. L'ensemble de fermé forme une famille de Moore F

:[1]

F = {?(X) : X Ç S} (2.12)

2.4 Treillis des concepts et treillis de Galois

Une structure mathématique permettant de

représenter les classes non disjointes sous jacentes à un

ensemble d'objets (exemples, instances, tuples ou

observations) décrits à partir d'un ensemble d'attributs

(propriétés, descripteurs ou items), les

treillis de concepts formels (ou treillis de Galois) permet

d'organiser l'information concernant des classes d'objets possédant des

propriétés communes. Ces classes non

17

TABLE 2.3 - Exemple de contexte

disjointes sont aussi appelées concepts

formels, hyper-rectangles ou ensembles

fer-més[1].

2.4.1 Treillis des concepts

En analyse de données, l'analyse formelle des concepts

pose le treillis des concepts comme espace de recherche sous-jacent

à des données qui s'organisent sous forme d'un table binaire

objets × attributs encore appélé contexte. Le

treillis de concepts et un treillis dont les noeuds, appelés

concepts sont composés à la fois d'un ensemble d'objets

et un ensemble d'attributs.[11]

Définition 25 (Treillis des concepts)

Le treillis des concepts se définit pour une

relation binaire R entre un ensemble O d'objets et un

ensemble I d'attributs, encore appelés contexte[1]. Le

treillis des concepts d'un contexte (O, I, R) est une paire

(C, ) où :

- C est un ensemble de concepts définit sur

P(O) × P(I) par :

(A,B) ? C ? A ? O,B ? I,B =

á(A) et A = â(B)

avec

á(A) = {b ? I, aRb pour

touta ? A}

â(B) = {a ? O, aRb pour

toutb ? B}

- est une relation binaire définie sur l'ensemble des

concepts C par, pour (A1,B1) et (A2,B2) ? C :

(A1, B1)(A2, B2) ? B1 ? B2 ? A1

? A2 (2.13)

Lorsque le contexte est représenté sous forme

d'une table, un concept correspond à un rectangle maximal, ou encore

à une sous matrice première. Un contexte pourra être

noté par (O, I, R) ou encore par (O, I, (á,

â)) selon que l'on considère la relation binaire R

entre O et I, ou, de façon équivalente,

les deux applications á et â, l'une de O

vers I, l'autre dans le sens contraire.[1][5]

18

FIGURE 2.5 - Treillis des concepts du contexte de la table 2.3

Exemple 5 :

Considérons comme exemple le contexte décrit

par la table 2.3 définie par un ensemble d'objets {1,

2, 3, 4, 5, 6, 7,

8, 9} et un ensemble d'attributs {a, b, c, d, e, f, g, h},

ainsi que son treillis des concepts donné par la figure 2.6.[1] On

constate que :

- L'objet numéro 9 possède tous les

attributs, et par conséquent il apparaît dans tous les

concepts;

- L'attibut g est partagé par tous les objets, il

apparaît, ipso facto, dans tous les concepts;

- L'attribut h, quant à lui, est partagé

par seulement 3, 4, 5 et 9,

c'est-à-dire par les objets possédant à la fois l'attribut

e et f. Par conséquent l'attribut h n'apparaît que dans les

concepts contenant à la fois l'attribut e et f.

2.4.2 Treillis de Galois

Le treillis de Galois se définit à partir d'une

correspondance de Galois entre deux ensembles qui elle-même

définit deux opérateurs de fermetures sur chacun de deux

ensembles.

Définition 26 (Treillis de Galois)

Un treillis de Galois se définit à

partir d'une correspondance de Galois (á, 8) entre deux

ensemble S et U où :[7]

- á est une application isotone de

P(S) vers P(U) : X C_ Y =

á(X) C_ á(Y ) ;

- 8 est une application antitone de

P(U) vers P(S) : X C_ Y =

8(X) D 8(Y ) ;

- (8 o á) est une application extensive

sur P(U) : X C_ U = X C_ (8 o

á)(X) ;

- (á o 8) est une application extensive

sur P(S) : X C_ S = X C_ (á

o 8)(X). Les termes (8 o á) et (á o

8) sont les deux opérateurs de fermeture, l'un définit sur

U et l'autre sur S.

19

Chapitre 3

Aspects algorithmiques des treillis

P

Rocédure de calcul bien définie qui prend en

entrée une valeur ou un ensemble de valeurs, et qui donne en sortie une

valeur ou un ensemble de valeurs. Un algorithme est donc une sequence

d'étapes de calcul qui transforment l'entrée en sortie. La notion

d'algorithme est intimement liée à la notion de

complexité. En informatique, le mot compléxité recouvre en

faite deux réalités :

· La compléxité des algorithmes :

C'est l'étude de l'efficacité

comparéé des algorithmes. On mesure ainsi le temps et aussi

l'espace nécessaire à un algorithme pour resoudre un

problème.

· La compléxité des problèmes :

La compléxité des algorithmes a abouti à

une classification des problèmes en fonction des performances

des meilleurs algorithmes connus qui les resolvent. Ils en existent de trois

sortes :

* La classe P se compose des problèmes qui

sont résolubles en temps polynomial. Plus précisement, il existe

des problèmes qui peuvent être résolus en temps O(n')

pour une certaine constante k(n est la taille des

données en entrée).

* La classe NP se compose des problèmes qui

sont vérifiables en temps polynomial. Cela signifie : si l'on nous donne

d'une façon ou d'une autre une solution certifiée, nous pouvons

vérifier que cette solution est correcte en un temps qui est polynomial

par rapport à la taille de l'entrée.

* La classe NPC encore appelée Classe NP-

Complet. Un problème est dans la classe NPC s'il

appartient à NP et s'il est aussi difficile que n'importe quel autre

problème de NP.[8][10]

Les calculs à effectuer pour évaluer les temps

d'exécution d'un algorithme peuvent parfois être longs et

pénibles. Ainsi on aura recours à une approximation de ce temps

de calcul, représentée par la notation

O(·).

Soient f et g deux fonctions positives d'une

même variable entière n. Avec n, la taille des

données à traiter.

la fonction f est dite avoir un ordre de grandeur au

plus égal à celui de la fonction g s'il existe un entier

strictement positif k et un entier N tels que,

- Pour tout n = N, on ait |f(n)| =

k|g(n)| c'est-à-dire que f(·)

est toujours dominée par la fonction g(·),

à une constante multiplicative fixée près;

- On écrira f = O(g) (notation de

Landau).[9]

20

Dans ce chapitre, nous vous présenterons les quelques

aspects algorithmiques qu'ils soient. En effet, il existe deux familles

d'algorithmes de génération ou de contruction des treillis.

* Algorithmes incrémentaux Ce sont des algorithmes qui

contruisent le treillis au fur et à mesure qu'on a connaissances des

objets.

* Algorithmes non incrémentaux ce sont des algorithmes

qui contruisent le treillis une fois que tous les objets sont connus.

3.1 Algorithme de construction du graphe de couverture

d'un treillis

Nourine et Raynaud sont les concepteurs de cet algorithme non

incrémental. Il a été conçu pour la construction et

le calcul du graphe de couverture d'un treillis; il utilise une approche en

deux étapes :[1]

* Génére la famille F

représentée dans un arbre lexicographique.

* Calcule les relation de couverture des

éléments de F

Première étape : L'algorithme calcule l'arbre

lexicographique représenté par la famille F

générée par la base B.

Soit X un ensemble, P un ordre total sur

X et B une base composée par l'ensemble des parties de

X. Désignons par F la famille

générée par l'union des éléments de la

base B, avec;

U

F = {b, b E I/I ? B}

on dit aussi que B est un générateur de

la famille F. Chaque élément de F est

représenté par un couple (f, ã(f)) où;

ã(f) = {b E B/b ?

f}

Il faut voir chaque constituant comme un mot de l'alphabet

X ordonné dans l'ordre croissant.

Montrons maintenant comment construire cet arbre

lexicographique à partir d'une base;

B = {b1,b2,...,bm}

* La racine correspond à F0

qui est un ensemble vide;

* A l'etape j c'est le calcul de la famille

F fermée par l'union. Ce calcul se fait à partir de

F -1 en utilisant la formule suivante :

F = F -1 u {f u b /f

E F -1}; avec B =

{b1,b2,...,b }

Ainsi l'algorithme de construction du graphe de couverture d'un

treillis et le sui-

vant :[5]

Algorithme 1 Graphe de couverture d'un treillis;

Donnée : La base B

Résultat : Arbre lexicographique TF de

F

Début F = {ø}; {La racine de TF};

ã(F) = {ø}

Pour chaque b E B faire

Pour f E F faire

f' = f u b

f» = f ? {b/b ? 0(f», f)} = f'

21

Si f' ?6 F

alors

F = F ? {f'}

ã(f') = ã(f) ? b

ã(F) = ã(F) ? ã(f')

Fin si

Fin pour

Fin pour

Fin

Théorème 3.1 L'algorithme 1

calcule l'arbre lexicographique de la famille F générée

par la base B en O((|X| + |B|) * |B| * |F|) étapes.

Preuve La première instruction dans la

deuxième boucle Pour ainsi que la deuxième

instruction dans Si...alors

sont faites en O(|X|+|B|) étapes; l'instruction

Si...alors

vérifie si f' est dans l'arbre ; sinon

elle l'insère( première instruction du test). Elle

est donc implémentée en O(|F|). Ainsi la

compléxité de la deuxième boucle Pour

vaut O((|X| + |B|) * |F|).

Il s'en suit que la première boucle Pour

se répète |B| fois.D'où le résultat

obtenu.

Deuxième étape Cette étape

consiste à calculer le graphe de couverture G = (F, ?)

à partir de l'arbre lexicographique de la famille F

générée par la base B ; et cela en

utilisant le théorème de couverture suivant :

Théorème 3.2 On définit

;

0(f', f) =

ã(f')\ã(f);

et on note par ? la relation de couverture. Soient f et

f' ? F tels que f ? f' alors :

f ? f' ? ?(b1, b2) ?

0(f', f), b1\f' =

b2\f. Preuve Soient f et f' ? F

tels que f ? f' alors f' peut s'ecrire

:

f' = f ? {b/b ? 0(f',f)}

(1) Supposons que f soit couvert par f',

montrons que pour tous les (b1, b2) ?

0(f', f) ; nous avons :

b1\f' = b2\f.

Supposons que b1\f' ?6

b2\f ; il vient que : f ? b1 = f» ? f'

= f ? {b/b ? 0(f', f)} . Par conséquent

:

f ? f» ? f'.

ce qui est en contradiction avec l'hypothèse selon

laquelle f est couvert par f' ainsi :

b1\f' ? b2\f

De même b1\f' ? b2\f

en utilisant le même raisonnement.

(2) Inversement, supposons que pour tout (b1,

b2) ? 0(f', f) on a : b1\f'

= b2\f. Soit f» ? F tel que f ? f» ? f'

ce qui implique que ;

ã(f) ? ã(f») ? ã(f')

ainsi donc ;

22

ce qui implique que :

ã(f»)\ã(f) ?

ã(f')\ã(f) = Ä(f', f)

Le corollaire suivant est une conséquence du

théorème précédent : Corollaire 3.1

Soient f et f' ? F tels que ;

f ? f';

alors :

f ? f' ? ?f' = f ? b pour

tout Ä(f', f);

Decrivons maintenant comment calculer le graphe de couverture

G = (F, ?). Consi-derons la famille F

généré par la base B utilisée dans

l'algorithme 1. La strategie de cet algorithme consiste à

calculer l'ensemble des éléments de couverture noté par

Imsucc(f) pour chaque élément de la famille F.

En clair f' ? F est candidat si f ? f' et

f' peut être calculé par f' = f ? b

pour certains b ? B\ã(f).

Posons ;

S(f) = {f ? b/b ?

B\ã(f)}

Cet ensemble de candidats S(f) pour la couverture

f, peut avoir des éléments redon-

dants, l'algorithme explore cet ensemble et décide que

f' ? S est une couverture de

f si f' est trouvé |Ä(f',

f)| fois dans S(f). Pour ce faire, nous calculons l'ensemble

S(f) en maintenant le nombre d'occurences de chaque

élément f' dans le compteur

count(f'), ensuite pour chaque élément

f' ? S, on vérifie si |Ä(f', f)| =

count(f')

alors f' couvre f.

L'algorithme suivant construira le graphe de couverture de G

= (F, ?), étant donné

l'arbre lexicographique TF de la famille F

générée par la base B.[5]

Algorithme 2 Graphe de couverture de G = (F,

?)

Donnée Arbre lexicographique de F

et de ã(F)

Résultat Listes d'adjacence des

Imsucc du graphe de couverture du treillis (F,

?).

Début

Initialiser count(f) à 0 pour tout f

? F

Pour f ? F

faire

S(f) = {f ? b/b ?

B\ã(f)}

Pour b ? B\ã(f)

faire

f' = f ? b

count(f') = count(f) + 1

Si |ã(f')| = count(f') +

|ã(f)| faire

Imsucc(f) = Imsucc(f) ? {f'}

Fin si

Fin pour

réinitialiser count(f')

Fin pour

Fin

Théorème 3.3 L'algorithme 2

calcule les listes d'adjancence des Imsucc du graphe

de couverture pour le treillis (F, ?) en

O((|X| + |B|)|B| *

|F|) étapes.

Preuve L'algorithme 2 calcule le graphe

de couverture du treillis (F, ?) par corol-

laire 3.1

Le calcul de |ã(f)| et |ã(f')|

(l'instruction Si...alors) se fait en

O(|X| + |B|) en

utilisant la recherche dans l'arbre lexicographique ; d'où

la compléxité de la boucle

23

interne Pour est de O((|X| + |B|) *

|B|).

Reinitialiser count pour tous les

éléments calculés par la première et la

deuxième instruction de la boucle interne Pour qui se fait en

O(|F|). Il s'en suit que la compléxité de l'algorithme 2

est de O((|X| + |B|)|B| *

|F|).[13]

Exemple 1

Soit X = {1, 2, 3, 4,

5} un ensemble et B une base composée par quelques

parties

de X.

On désigne par F la famille

générée par l'union des éléments de la base

B, tel que

F = {UbEB /I C B}. Par abus

d'écriture, on pose {1, ..., 5} = {12345}. On définit

B={x=245,y=1234,z=15}.

Appliquons l'algorithme 1 afin de générée la

famille F représentée dans un arbre

lexicographique.

On pose ã(f) = {b ? B/b

? f}

1.F = {0} ; (la racine de l'arbre TF ) ;

ã(F) = {0} ;

(a) Pour b = {245} et f = 0 ;

f'=fUb=0U{245}={245} ?6F ;

F = F U {f'} = {0} U {{245}} =

{0,{245}};

ã(f') = ã(f) U

b = {245} = x;

ã(F) = {0, {x}} ;

2.F = {0, {245}}, ã(F)

= {0, {x}};

(a) Pour b = {1234} et f = 0 ; f' =

f U b = {1234} ?6F ; F = {0,

{245}, {1234}} ; ã(f') =

ã(f) U b = {1234} = y ;

ã(F) = {0, {x},

{y}} ;

(b) Pour b = {1234} et f = {245} ;

f' = f U b = {12345} ?6F ;

F = {0, {245}, {1234},

{12345}} ;

ã(f') = ã(f) U

b = {12345} = xyz ;

ã(F) = {0, {x},

{y}, {xyz}} ;

3.F = {0,

{245},{1234},{12345}},ã(F) =

{0, {x}, {y}, {xyz}};

(a) Pour b = {15} et f = 0 ;

f' = f U b = {15} ?6F ;

F = {0, {245}, {1234},

{12345}, {15}} ;

ã(f') = ã(f) U

b = {15} = z ;

ã(F) = {0, {x},

{y}, {xyz}, {z}} ;

(b) Pour b = {15} et f = {245} ;

f' = f U b = {1245} ?6F ;

F = {0, {245}, {1234},

{12345}, {15}, {1245}} ;

ã(f') = ã(f) U

b = {1245} = xz ;

ã(F) = {0, {x},

{y}, {xyz}, {z},

{xz}} ;

(c) Pour b = {15} et f = {1234} ; f'

= f U b = {12345} ? F ;

(d) Pour b = {15} et f = {12345} ;

f' = f U b = {12345} ? F ;

Finalement à partir de la base B = {x =

245, y = 1234, z = 15}, on obtient :

F = {0, {245}, {1234},

{12345}, {15}, {1245}}

24

FIGURE 3.1 - Arbre lexicographique de la famille F

`y(F)

= {0, {x}, {y},

{xyz}, {z},

{xz}};

Ainsi nous obtenons l'arbre lexicographique de F

présenté à la figure 3.1. Appliquons

maintenant l'algorithme 2 qui consiste à calculer le graphe de

couverture à partir de l'arbre lexicographique des familles ;

F = {0, {245},

{1234}, {12345}, {15},

{1245}}

et

`y(F) = {0, {x},

{y}, {xyz}, {z},

{xz}};

générée par la base ;

B={x=245,y=1234,z=15}.

Cet algorithme donne les listes d'adjacence des successeurs

immédiats du graphe de couverture du treillis (F,

Ç). Ainsi on démarre l'algorithme 2 par ;

count(f) = 0 ; pour tout f E F, on

calcule ;

8(f) = {f U b/b E

B\`y(f)};

1. f = 0; 8(f) = 8(0) = {0 U

{245}, 0 U {1234}, 0 U {15}} =

{{245}, {1234}, {15}} ;

calcule de count(f') pour f' E 8(f)

(a) Pour f' = {245},

count(f') = count({245}) = 1;

A(f',f) = `y(f') \ `y(f) = {x} \ 0

= {x};

|A(f',f)| = 1 = |A(f',f)| =

count(f') = 1;

(f, f') = (0, {245}) est une

couverture ;

Imsucc(f) = Imsucc(0) = {{245}} ;

(b) Pour f' = {1234},

count(f') = count({1234}) = 1 ;

A(f', f) = `y(f') \ `y(f) = {y} \ 0

= {y} ;

|A(f', f)| = 1 = |A(f', f)| =

count(f') = 1;

(f, f') = (0, {1234}) est

une couverture ;

Imsucc(f) = Imsucc(0) = {{245},

{1234}} ;

(c) Pour f' = {15},

count(f') = count({15}) = 1; A(f', f) = `y(f')

\ `y(f) = {z} \ 0 = {z} ;

|A(f',f)| = 1 = |A(f',f)| =

count(f') = 1;

25

(f, f') = (0, {15}) est une couverture;

Imsucc(f) = {{245}, {1234}, {15}} ;

count(f') = 0;

2. f = {245}; S(f) = S({245})

= {{245} U {1234}, {245} U {15}} = {{12345},{1245}}; calcule

de count(f') pour f' E S(f)

(a) Pour f' = {12345}, count(f') =

count({12345}) = 1 + 1 = 2;

Ä(f', f) = -y(f') \

-y(f) = {xyz} \ {x} = {yz} ;

|Ä(f', f)| = 2 = |Ä(f', f)| =

count(f') ;

(f, f') = ({245}, {12345}) est une

couverture;

(b) Pour f' = {1245}, count(f') =

count({1245}) = 2 ;

Ä(f', f) = -y(f') \

-y(f) = {xz} \ {x} = {z} ;

|Ä(f', f)| = 1 = |Ä(f', f)| =6

count(f') ;

(f, f') = ({245}, {1245}) n'est pas une

couverture;

Imsucc(f) = Imsucc({245}) = {{1245}} ;

count(f') = 0;

3. f = {1234}; S(f) = {{1234} U

{245}, {1234} U {15}} = {12345} ;

calcule de count(f') pour f' E

S(f)

(a) Pour f' = {12345},

count(f') = count({12345}) = 2 ;

Ä(f', f) = -y(f') \

-y(f) = {xyz} \ {y} = {xz} ;

|Ä(f',f)| = 2 = |Ä(f',f)| =

count(f') = 2;

(f, f') = ({1234}, {12345}) est une

couverture;

Imsucc(f) = Imsucc({1234}) = {{12345}}

;

count(f') = 0;

4. f = {12345}; S(f) =

S({12345}) = 0; count(f') = 0

5. f = {15}; S(f) = S({15}) =

{{15} U {245}, {15} U {1234}} = {{1245}, {12345}} ; calcule

de count(f') pour f' E S(f)

(a) Pour f' = {1245}, count(f') =

count({1245}) = 2 ;

Ä(f', f) = -y(f') \

-y(f) = {xz} \ {z} = {x} ;

|Ä(f', f)| = 1 = |Ä(f', f)| =

count(f') = 1;

(f, f') = ({15}, {1245}) n'est pas une

couverture;

(b) Pour f' = {12345}, count(f') =

count({12345}) = 2 ;

Ä(f', f) = -y(f') \

-y(f) = {xyz} \ {z} = {xy} ;

|Ä(f', f)| = 2 = |Ä(f', f)| =

count(f') ; (f, f') = ({15}, {12345}) est

une couverture; Imsucc(f) = Imsucc({15}) = {{12345}}

;

count(f') = 0;

6. f = {1245}; S(f) =

S({1245}) = {{1245} U {1234}} = {{12345}} ;

calcule de count(f') pour f' E

S(f)

(a) Pour f' = {12345},

count(f') = count({12345}) = 2 + 1 = 3;

Ä(f', f) = -y(f') \

-y(f) = {xyz} \ {xz} = {y} ;

|Ä(f', f)| = 1 = |Ä(f', f)| =

count(f') = 1;

(f, f') = ({1245}, {12345}) n'est pas une

couverture;

On va récupèrer toutes les informations necessaires

pour pouvoir déssiner le graphe

de couverture G = (F,=) du treillis.

Les couvertures (f, f') ou successeurs immédiats

sont les suivants :

1.(0, {245}) est une couverture;

Imsucc(0) = {{245}};

2.(0, {1234}) est une couverture;

Imsucc(0) = {{245}, {1234}};

3.(0, {15}) est une couverture;

Imsucc(0) = {{245}, {1234}, {15}};

26

FIGURE 3.2 - le graphe de couverture G = (F,

Ç)

4. ({245}, {12345}) est une couverture;

Imsucc({245}) = {{12345}};

5. ({1234}, {1245}) est une couverture;

Imsucc({1234}) = {{1245}};

6. ({15}, {1245}) est une couverture;

Imsucc({15}) = {{12345}};

7. ({12345}, {1245}) est une couverture;

Imsucc({1245}) = {{12345}}; On récupère aussi F

et ã(F) tels que :

F = {ø, {245}, {1234},

{12345}, {15}, {1245}}

et

ã(F) = {ø,

{x}, {y}, {xyz},

{z}, {xz}};

Ainsi nous obtenons le graphe de couverture G = (F,

Ç) presenté à la figure 3.2.

3.2 Algorithme de construction de treillis de

concepts

Un concept étant un regroupement maximal d'objets

possédant des caractéristiques communes, l'algorithme de

construction de treillis de concepts construit un treillis dans lequel chaque

concepts formel est décoré par l'ensemble de

générateurs minimaux qui lui est associé. Les «

input »sont représentés sous forme de contexte

formel. Un contexte est représenté sous forme d'un tableau dont

les objets X sont en lignes et les attributs Y en

colonnes.[5]

3.2.1 Définitions

Définition 1 (Contexte d'extraction ou contexte

formel)

Un contexte d'extraction ou formel est un triplet K =

(X, Y, R) où X et Y sont respectivement

l'ensemble d'objets et celui d'attributs et R Ç X X

Y une relation binaire telle que ?(x, y) E R, y est

un attribut de l'objet x.

Définition 2 (Contexte binaire)

Un contexte K = (X, Y, R) est dit binaire si

les éléments de Y ont uniquement deux valeurs (0 ou 1)

qui indique l'absence ou la présence de l'attribut concerné

respectivement.

27

Définition 3 (Fermeture des ensembles)

Soient deux fonctions g et h qui nous serviront à

calculer la fermeture des sous ensembles d'objets O et d'attributs A. Ainsi,

les ensembles fermés sont définis comme suit :

O» = h(g(O))

A» = g(h(A))

Alors, un ensemble est dit fermé s'il est égal

à sa fermeture.[4]

Définition 4 (Concept formel)

Un concept formel est une paire Ck = (O, A)

avec O C X et A C Y tel que :

O = {x E X/Va E A, (x, a) E R}

où O = h(A)

est l'extension ou objets couverts, elle est notée

Ext(Ck).

A = {y E Y/Vo E O,(o,y) E R}

où A = g(O)

est l'intention ou attributs partagés, elle est

notée Int(Ck).[11] Définition 5 (Ordre

sur les concepts)

Soient C1 = (O1, A1) et C2 = (O2,

A2) deux concepts, une relation d'ordre notée « <

»peut être définie sur ces deux concepts de la manière

suivante :

(O1, A1) < (O2, A2) = O1

C O2 et A1 D A2

C1 < C2 = (O1, A1) est un sous-concept de

(O2, A2) et

(O2, A2)est un sur-concept

de(O1, A1).

Définition 6 (Ordre lexicographique)

La plupart des méthodes proposées dans les

fouilles des données définissent un ordre total sur les

itemsets ou sous ensemble d'attributs. Cet ordre total pouvant

s'étendre en un ordre lexicographique, permet à la fois

d'éviter des redondances des calculs en parcourant chaque itemset au

plus une seule fois, mais également de stocker efficacement les itemsets

dans des structures de données appropriées. Ainsi, on

étend l'ordre total sur X en un ordre lexicographique comme suit :

Soient A, B deux sous-ensembles distincts d'un ensemble X

totalement ordonné. On dit que A est inférieur

lexicographiquement à B si le plus petit élément qui

distingue A et B appartient à A. On note « A

-<lex B »et on lit « A est inférieur

lexicographiquement à B. »[5]

Définition 7 (Arbre lexicographique)

Soit une liste de mots ordonnée. Si l'ordre sur les

mots est obtenu comme un ordre lexicographique à partir des composants

des mots, alors on peut représenter un ensemble de mots en utilisant la

structure d'arbre de recherche lexicographique.

Soit le dictionnaire constitué des mots suivants : AI,

AIL, AILE, AINE, ALE, BAT, BAS ; où à chaque mot du dictionnaire

on adjoindra un chemin de la racine à un noeud comme representé

dans l'arbre lexicographique de la Figure 3.3 :[5]

28

FIGURE 3.3 - Arbre lexicographique associé au dictionnaire

Définition 8 (Treillis de Galois)

La notion de treillis de Galois ou treillis de concepts est

definie sur l'ensemble des concepts L

L = {(o, a) E P(X) x P(Y )/O =

h(A), A = g(O)} muni de la relation d'ordre <. On le note T = (L,

<).[1][11]

Définition 9 (Face)

Soit Ck = (O, A) un concept formel et soit

predi(Ck) le ième prédécesseur immédiat de

Ck. La ième face du concept formel Ck

correspond à la différence entre son intention et

l'intention de son ième prédécesseur. Soit p le

nombre de prédécesseurs immédiats du concept formel Ck

et FCk la famille des faces. La famille des faces du

concept formel Ck est exprimée par la relation suivante[5] :

FCk = {A - Intent(predi(Ck))}, i

E {1, ..., p}. Définition 10

(Bloqueur)

Soit G = {G1, ..., Gn}

une famille de n ensembles, un bloqueur B de la famille de

G est un ensemble où son intersection avec tout ensemble Gi

E G est non vide.[12]

Définition 11 (Bloqueur minimal)

Un bloqueur B est dit minimal s'il n'existe pas

B1 C B et VGi E G, B1f1Gi =6 0.[5]

Définition 12 (Générateur minimal)

Soit Ck un concept formel et FCk

sa famille de faces. L'ensemble G des générateurs

minimaux associés à l'intention A du concept formel

Ck, correspond aux bloqueurs minimaux associés à la

famille de ses faces FCk.

D'une manière équivalente, soit Y un

ensemble d'attribut, un itemset a C_ Y est appelé

générateur minimal d'un concept formel Ck = (O,

A), si et seulement si h(a) = A et , a1 C a

tels que h(a1) = A.[5][12]

29

FIGURE 3.4 - Matrice decrivant la relation R du contexte

K = (X, Y, R) Exemple 2

Soit une application permettant de calculer une correspondance de

galois, un

concept et les opérateurs de fermeture à partir

d'une matrice binaire (Figure 3.4)

générée par un contexte K = (X,

Y, R)

X =

{1,2,3,4,5,6,7} et Y

= {a,b,c,d,e,f,g,h};

g({1,2,3,4}) =

{a,b,c,d} et h({a,b,c,d}) =

{1,2,3,4}

On constate que ({1, 2, 3, 4},

{a, b, c, d}) est un concept; alors que ({1, 2},

{e, f})

ne l'est pas parce que :

g({1, 2}) = {a, b, c, d, e, f} et

h({e, f}) = {1, 2}

Si X = {2, 4, 5} alors

g(X) = {a, b, d}

X» = {1, 2, 3,4,

5} = h(g(X))

Si X = {1,5} alors g(X) =

{a,b,d,e,g}; X» = {1,3,5}

Si Y = {a}, alors h(Y ) =

{1, 2, 3, 4, 5, 6, 7};

Y » = {a}

Si Y = {a,c}, alors h(Y ) =

{1, 2, 3, 4, 6, 7}; Y

» = {a,c}

Seuls les ensembles {a} et {a, c} sont fermés.

3.2.2 Algorithme Genall

L'algorithme « Genall

»élaboré par Ben Tekaya et al. construit le treillis

dans lequel chaque concept formel est décoré par l'ensemble de

générateurs minimaux qui lui est associé. Les

données d'entrées sont sous forme de contexte d'extraction et en

sortie nous aurons l'arbre lexicographique de la famille F des

concepts formels Ck, la liste ImmSucc des successeurs

immédiats du concept Ck ainsi que la liste des

générateurs minimaux du concept.[12]

1. Algorithme Genall

Entrée Le contexte d'extraction K = (X, Y,

R)

Sortie Arbre lexicographique de F, ImmSucc,

Liste - gen

Début

// Initialiser la famille des concepts à l'ensemble

des attributs

2. F = (ø,Y )

3. Pour chaque tuple t ? K Faire

// Initialiser la liste de l'ensemble des concepts

trouvés dans une itération

4. L = ø

30

5. Pour chaque concept Ck E F

Faire

6. C.intent = Ck.intent f1 t.items

7. Si C.intent E6 F Alors

// Nouveau concept

8. F=FUC

9. C.extent = Ck.extent U t.TID

10. C.ImmSucc = {t} U {Ck} \ {C}

11. L=LUC

12. Sinon

// Concept existant

13. C.extent = C.extent U Ck.extent U t.TID

14. Si C E6L Alors

15. L=LUC

16. Fin Si

17. C.LP = {t} U {Ck} \ {C} // Mise à jour de

C.ImmmSucc

18. Pour chaque Pk E C.LP

Faire

19. Pour chaque Succ E C.ImmSucc

Faire

20. Compare - Concept(Succ, Pk)

21. Fin Pour

22. Fin Pour

23. Fin Si

24. Fin Pour

// déterminer l'ensemble des successeurs

immédiats et les générateurs minimaux

25. Pour chaque concept Ck E L

Faire

26. Ck.ImmSucc = Find - Succ(Ck, L)

27. Pour chaque Succ E Ck.ImmSucc

Faire // Calcul de la face du successeur

immédiat

28. face = Succ \ Ck

29. Pour chaque facek E Succ.liste - face

Faire

30. Succ.liste - face = Compare - Face(face, facek)

31. Fin Pour

32. Fin Pour

33. Fin Pour

34. Fin Pour Fin

Sont presentés dans la table 3.1, les notations

utilisées dans l'algorithme GE-NALL Cet algorithme est

scindé deux partie : D'une part il génère les concepts

formels et de l'autre, il raffine la liste des successeurs immédiats et

détermine les générateurs minimaux.[5]

31

TABLE 3.1 - Notation utilisée dans

l'algorithme GENALL Génération des concepts formels

Cette génération est montrée à

partir de la ligne 4 jusqu'à la ligne 22. Dans cette étape, nous

commençons par initialiser la liste L avec l'ensemble vide

(ligne 4). Cette liste sera utile pour la mise à jour de l'ensemble des

successeurs immédiats de chaque concept formel trouvé dans une

itération.

Pour calculer l'ensemble des concepts formels, nous effectuons

une intersection entre l'intension de chaque concept formel de la famille F

et chaque transaction de la base de données. Il en résulte

deux cas:

1. L'intention n'existe pas dans la famille F : Dans

ce cas, un nouveau concept formel est trouvé et doit être

ajouté à la famille F. Ensuite l'exten-sion du concept

est calculée (ligne 9). Les successeurs immédiats potentiels de

ce nouveau concept formel sont alors initialisés avec les concepts

formels utilisés(ligne 10). En effet, pour déterminer le

successeur immédiat potentiel d'un concept formel, nous devrions

distinguer deux cas particuliers :

- Si le concept formel produit est égal à la

transaction, alors seul le concept formel utilisé dans cette

intersection peut être un successeur immédiat. En effet un concept

formel ne peut pas être égal à son successeur

immédiat;

- Sinon la transaction et le concept formel sont

considérés comme successeurs immédiats potentiels du

concept formel.

Ensuite, ce nouveau concept formel est ajouté à la

liste L(ligne 11).

2. L'intention existe déjà dans la famille

F : Dans ce cas l'extension du concept formel (ligne 13) doit

être mise à jour, et nous vérifions si le concept existe

déjà dans la liste L (14-15). Le but étant de

mettre à jour la liste des successeurs immédiats ImmSucc

du concept formel, et étant donné que nous maintenons, pour

chaque concept formel, une liste ImmSucc, nous allons construire une

liste LP devant contenir les concepts formels utilisés. Cette

liste est nécessaire pour pouvoir faire les comparaisons et mettre

à jour la liste des ImmSucc. En effet pour chaque

élément dans LP et pour chaque élément

dans la liste des ImmSucc, nous examinons l'inclusion de ces concepts

formels en utilisant la fonction Compare-concept(ligne 20).

Cette fonction est appliquée

32

pour mettre à jour la liste ImmSucc des

concepts formels considérés. Ainsi cette liste ne peut subir des

modifications que dans les deux cas suivants :

(a) L'élément de LP est plus petit (en

terme d'inclusion) par rapport à un élément de

ImmSucc. Dans ce cas, l'ancien successeur sera remplacé par le

nouveau successeur.

(b) les deux concepts sont incomparables : un nouveau

successeur sera alors ajouté à la liste ImmSucc du

concept formel en considération.

Raffinement de la liste des successeurs immédiats et la

détermination des généateurs minimaux