|

N°

d'ordre :

UNIVERSITÉ CADI AYYAD

FACULTÉ DES SCIENCES ET TECHNIQUES -

MARRAKECH

****************************

MÉMOIRE

Présenté à la FST pour obtenir :

Le Diplôme des

Études Supérieures Approfondies (DESA)

UFR : Télécommunications instrumentations et

micro électroniques

Référence : P06/03

Étude de l'impact du protocole TCP sur la

capacité et performance du système UMTS-HSDPA

Par :

Abdessamad Darim

(Licence : Electronique)

Soutenu le : /03/08

devant la commission d'examen :

Président : Abdel jalil El Kari

PES FST

Encadrant : Rajaa El Assali PA ENSA

Examinateurs : Brahim Essaid PES

FSSM

Nourdine Idboufker PA ENSA

À ma femme

À mes parents

À mes soeurs et frères

À mes amis

Et à tous ceux que j'aime

« Pour faire de grandes choses, il ne faut pas

être

Un si grand génie, il ne faut pas être

au-dessus des

Hommes, il faut être avec eux»

Montesquieu

REMERCIEMENTS

Je tiens tout d'abord à remercier Madame El

Assali professeur `a l'ENSA de Marrakech, de m'avoir accueilli au sein de la

composante INSA de Marrakech et d'avoir accepté de diriger mon projet

de fin d'étude DESA TER

Mes remerciements vont également à

tous mes professeurs et collègues qui ont assuré ma formation

durant deux années de DESA,

Et enfin je tiens à remercier Messieurs les

professeurs, membres de jury d'avoir accepté de juger et

d'évaluer ce travail.

Sommaire

1

Introduction Generale

13

Chapitre 1 : Réseau UMTS

14

Introduction

15

1. 1 Technique d'accès radio

15

1.1. 1 Techniques de base

17

1.1. 2 Technique d'étalement

18

1. 2 Présentation du système

UMTS

18

1.2 1 Principes de base

19

1.2 2 Service UMTS

19

1. 3 Architecture globale de l'UMTS

22

1.3 1 Domaine Equipement utilisateur

23

1.3 2 UTRAN ( Universal terestrial Radio

Network Acces )

23

1.3 3 Node B

25

1.3 4 Réseau Coeur

25

1. 4 Les interfaces logiques dans

l`UTRAN

25

1.4 1 L'interface Uu

26

1.4 2 Canaux UMTS

27

1.4.2. 1 Canaux logiques :

27

1.4.2. 2 Canaux de transport

28

1.4.2. 3 Canaux physiques

29

1.4 3 Couche physique

31

1.4 4 Couche liaison :

36

1.4.4 1 Couche MAC

36

1.4.4 2 MAC Architecture

37

1.4.4 3 La couche RLC (Radio Link Control

)

39

1.4.4 4 La couche PDCP (Packet Data

Convergence Protocol)

42

1.4.4 5 La couche RRC (Radio Ressource

Control)

42

1.4.4 6 Protocole ARQ (Automatic Repeat

Request Protocol)

42

1.4.4.6 1 Protocole Stop Wait

44

1.4.4.6 2 Protocole Glissement de fenêtre

« Sliding Window «

44

1.4 5 Power control

45

1. 5 Modélisation de la capacité

cellulaire

46

1.5. 1 Capacité du sens descendant

46

CONCLUSION :

47

Chapitre 2 : Technique HSDPA

73

Introduction

49

2.1 Présentation générale

du HSDPA

49

2.2 Structure HSDPA

50

2.3 Architecture de Protocole

52

2 .4 Canaux HSDPA

53

2.5 Mécanisme de retransmission hybride

HARQ

57

2.5.1 Protocole HARQ

58

2.6 Modulation et codage adaptatifs

59

2.7 Fonctionnement de la couche physique

61

2.8 FCSS (Fast Cell Site Selection)

63

2.9 Interval de temps de transmission

(TTI)

63

2.10 Modélisation du HSDPA et Sortie de

Cellule

64

2.10.1 HARQ

64

2.10.2 AMC

64

2.10.3 Ordonnancement rapide (Fast Scheduling)

65

2.10.3.1 Méthode de Round Robin (RR)

66

2.10.3.2 Méthode FFTH (Fast Fair

Throughput)

67

2.10.3.3 Méthode du Maximum C/I (Signal

sur Interférence)

68

2.10.3.4 Méthode du Proportionnel Fair

69

Résultats

71

Conclusion :

72

Chapitre 3 : TCP au dessus

des réseaux sans fils

73

Introduction

73

3.1 Facteurs d'environnement sans fils

73

3.1.1 Limitation de largeur de Bande et

Durée RTT

73

3.1.2 Taux de perte élevé

75

3.1.3 Mobilité

76

3.1.4 Asymétrie de la largeur de bande

76

3.2 Performance TCP

77

3.2.1 Présentation des

procédés

77

3.2.1.1 Solutions niveau liaison

78

3.2.1.2 Split Solutions

78

3.2.3 End-to-End Solutions

79

Chapitre 4 : TCP au dessus des

réseaux sans fils 80

Introduction

80

4.1 Performance TCP

81

4.2 Architecture de la connexion TCP au

dessus UMTS-HSDPA

81

4.3 Comparaison entre RLC, MAC-hs, et TCP

84

4.3.1 Fiabilité

84

4.3.2 Contrôle de flux et Glissement de

fenêtre

85

4.3.3 Segmentation

85

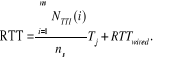

4.4 Modélisation du TCP au dessus

UMTS-HSDPA

86

La variation du débit binaire TCP

au-dessus de l'interface radio est due à deux raisons : diminution de la

taille de fenêtre TCP, et retransmissions des segments TCP.

86

4.4.1 Timeout

86

4.4.1.1 Proposition

87

4.4.1.2 Preuve

87

4.4.2 Démarrage lent ( Slow Start )

88

4.4.3 Temps de rétablissement du premier

perte

89

4.4.4 Etat de stabilité

90

4.5 Effet du TCP sur les réseaux sans

fils a canal partage

93

CONCLUSION

95

Perspective :

Erreur ! Signet non

défini.

Liste des figures

Figure 1.1 Technique d'accès Parmi

les méthodes d'accès de base :

17

Figure 1.2- Architecture générale du

réseau UMTS

23

Figure 1.3 - Éléments du

réseau d'accès UTRAN

24

Figure 1.4 Architecture générique

des interfaces de l`UTRAN

26

Figure 1.5 Couches de protocoles de l'interface

radio Uu

27

Figure 1.6 - Fonctions de la couche physique dans

la chaîne de transmission UTRA/FDD

31

Figure 1.7- Exemple d'une chaîne

d'émission utilisant la modulation QPSK

35

Figure 1.8 : Architecture Générale du

MAC du UMTS cote UE

38

Figure 1.9 Format du MAC PDU

39

Figure 1.10 Format d`un paquet RLC-PDU en mode de

UM

40

Figure 1.11 Format d`un RLC-PDU en m ode AM

41

Figure 1.12 Architecture de la couche PDCP

42

Figure 1.13 probability en fonction du nombre

d'utilisateur dans le sens Descendant

47

Figure 2.1 - Architecture système avec le

HSDPA

50

Figure 2.2 Architecture Protocolaire de

l'interface Radio du système hsdpa

51

Figure 2.3 Architecture Protocolaire de

l'interface Radio du système HSDPA

51

Figure 2.4 Les entités fonctionnelles

incluses dans la MAC-hs

53

Figure 2.5 - Exemple de multiplexage de code avec

deux usagers actifs

54

Figure 2.6 - Relation du timing entre le canal

HS-SCCH et le HS-DSCH

55

Figure 2.7 - Structure du canal HS-DPCCH

56

Figure 2.8 - Technique HARQ dans la chaîne

de codage du canal HS-DSCH

58

Figure 2.9 - Principe de fonctionnement de

l'HARQ

58

Figure 2.10 - Constellations de la modulation

16-QAM et QPSK

60

Figure 2.11 - Fonctionnement de la couche physique

du HSDPA

63

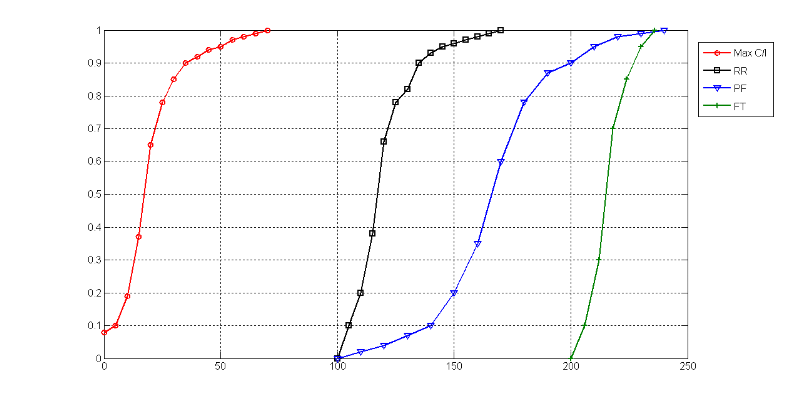

Figure 2.12 Debit de sortie de la cellule HSDPA

pour différent algorithme

70

Figure 2.13 Débit de sortie de la cellule

HSDPA pour différent algorithme

70

Figure 4.1 Structure protocolaire de la connexion

TCP au dessus du système UMTS

83

Figure 4.2 Structure protocolaire de la connexion

TCP au dessus du système UMTS

83

Figure 4.3 Effet du TCP sur la performance d'une

application de 32 kbps

92

Figure 4.4 Effet du TCP sur la performance d'une

application de 64 kbps

92

Figure 4.5 Effet du TCP sur la performance d'une

application de 128 kbps

92

Figure 4.6 Effet du TCP sur la capacite d'une

cellule HSDPA

95

Liste des tableaux

tableau 3.1 Classes de services de l'UMTS

21

tableau 3.2 Comparaison du canal HS-DSCH avec les

autres canaux du lien descendant

54

tableau 3.3 - Schémas de modulation et de

codage MCS sur le lien DL

61

tableau 3.4- Catégories de terminaux

supportant la technologie HSDPA

61

Abbreviations

3GPP Third Generation Partnership Project

Ack Acknowledgement

AM Acknowledge Mode

AMC Adaptive Modulation and Coding

ARQ Automatic Repeat reQuest

BER Bit Error Rate

BlER Block Error Rate

BMC Broadcast/Multicast Control Protocol

CDMA Code Division Multiple Access

CN Core Network

DupAck Duplicated Acknowledgement

EDGE Enhanced Data Rates for GSM Evolution

FDD Frequency Division Duplex

FEC Forward Error Correction

FTP File Transfer Protocol

GGSN Gateway GPRS Support Node

GMSC Gateway Mobile Switching Centre

GSM Global System for Mobile communication

GPRS General Packet Radio Service

HARQ Hybrid Automatic Repeat reQuest

HLR Home Location Register

HS High Speed

HSCSD High Speed Circuit Switched Data

HSDPA High Speed Downlink Packet Access

HS-DShCH High Speed Downlink Shared Channel

HS-PDShCH High Speed Physical Downlink Shared Channel

HS-ShCCH High Speed Shared Control Channel

IP Internet Protocol

ITU International Telecommunication Union

Iu Interface UTRAN - Core Network

Iub Interface Node B - RNC

Iur Interface RNC - RNC

MAC Medium Access Control

MAC-b MAC-broadcast

MAC-d MAC-dedicated

MAC-c/sh MAC-common/shared

MAC-hs MAC-high speed

MCS Modulation and Coding Scheme

MinInter-TTI Minimum Inter-TTI

MSC Mobile Switching Centre

MSS Maximum Segment Size

NAck Negative Acknowledgment

OSI Open System Interconnection

Phy Physical Layer

PDCP Packet Data Convergence Pro tocol

PDU Protocol Data Unit

PLMN Public Land Mobile Network

PU Payload Unit

QoS Quality of Services

RLC Radio Link Control

RNC Radio Network Controller

RNS Radio Network Sub-system

RTO Retransmission Time-Out

RTP Real-Time Transport Protocol

RTT Round Trip Time

RRC Radio Resource Control

SACK Selective Acknowledgment

SDU Service Data Unit

Abbreviations 109

SDL Specification and Description Language

SGSN Serving General Packet Radio Service Support Node

SMS Short Message Service

SRF Simulated Radio Frame

SS7 Common Channel Signaling System No. 7

Status PDU Status information control Protocol Data Unit

SuFi Super Field

TCP Transmission Control Protocol

TDD Time Division Duplex

TDMA Time Division Multiple Access

T-slot Three slots

TM Transparent Mode

TTI Transmission Time Interval

UDP User Datagram Protocol

UE User Equipment

UM Unacknowledged Mode

UMTS Universal Mobile Telecommunication System

UTRAN UMTS Terrestrial Radio Access Network

Uu Interface UE - Node B

VLR Visitor Location Register

WCDMA Wideband Code Division Multiple

Contexte &

Problématique

Un modèle analytique pour évaluer l'effet du

protocole TCP sur la capacité d'UMTS-HSDPA est présenté.

On propose également une méthode pour réduire au minimum

l'effet du TCP sur les réseaux sans fil à l'aide des canaux

partagés. HSDPA (accès à grande vitesse de paquet de

Downlink) réalise des débits binaires globaux plus

élevés par l'introduction de la modulation et du codage

adaptatifs, l'hybride ARQ, les algorithmes d`ordonnancement rapide, la

sélection rapide de cellules. Le modèle proposé est

utilise pour évaluer l'effet du protocole de TCP relatif au

débit binaire de divers services de données (à 64 et

à 128kbps). Comme été prévu le flux du

débit binaire diminue fortement si la congestion dans le réseau

câble augmente. Cependant, la capacité réalisée par

HSDPA n'est pas affectée par TCP.

Mot cle : UMTS , HSDPA , ARQ, AMC ,TCP

Abstract

An analytical model to evaluate the impact of TCP on the

UMTS-HSDPA capacity is presented. A method to minimize the effect of TCP on

wireless networks using shared channels is also proposed. HSDPA (High Speed

Downlink Packet Access) achieves higher aggregate bit rates through the

introduction of adaptive modulation and coding, Hybrid ARQ, fast scheduling,

fast cell selection. The proposed model is used to evaluate the effect of the

TCP protocol on the bit rate of various data services (at 64 and 128kbps). As

expected the bit rate per flow decreases strongly if congestion in the wired

network increases. However, the capacity achieved by HSDPA is not as affected

by TCP.

ãÜáÎÕ

äÚÑÖ

äãæÐÌ

áÊÞííã

ÊÇËíÑ

ÈÑäÇãÌ

ÇáÊÚÇæä

Çáäí Úáì

ÞÏÑÉ äÙÇã UMTS - HSDPA .

äÞÊÑÍ íÖÇ

ØÑíÞÉ

áÊÞáíá ËÑ

ÈÑäÇãÌ

ÇáÊÚÇæä

Çáäí Úáì

ÇáÔÈßÇÊ

ÇááÇÓáßíÉ

ÂÜÊí ÊÓÊÎÏã

ÞäæÇÊ

ãÔÊÑßÉ. HSDPA

íÍÞÞ ÈÊ ãä

Úáì

ÇáãÚÏáÇÊ

ÇáÇÌãÇáíå

ãä ÎáÇá

ÅÏÎÇá ÊÚÏíá

Úáì ÇáÊßí

æÇáÊÑãíÒ arq

áåÌíäå

æÌÏæáÉ

ÓÑíÚÉ ÓÑÚÉ

ÇÎÊíÇÑ

ÇáÎáíÉ. åÐÇ

ÇáäãæÐÌ

ÇáãÞÊÑÍ

íÓÊÎÏã

áÊÞííã ÊËíÑ

ÈÑäÇãÌ

ÇáÊÚÇæä

Çáäí Úáì

ãÚÏá ÇáÈÊ

áãÎÊá ÎÏãÇÊ

ÇáÈíÇäÇÊ (64 í

æ128kbps).

æßãÇ ßÇä

ãÊæÞÚÇ Çä ÈÊ

ãÚÏá ÊÏÞ

ÇáÇäÎÇÖÇÊ

ÈÞæÉ ÇÐÇ

ÇáÇÒÏÍÇã í

ÇáÔÈßå

ÇáÓáßíå

ÇáÒíÇÏÇÊ.

ÔÈå äãæÐÌ

ÊÍáíáí

áÊÞííã

ÇáÞÏÑÉ ÎáíÉ

åæ ÇíÖÇ

ÇáãÚÑæÖÉ í

åÐå ÇáæÑÞå

æÇáãÑÇÓáÇÊ

Èíä ÇáÎáíÉ

ÇáÞÏÑÉ

æãÖãæäå

ÈÑäÇãÌ

ÇáÊÚÇæä

Çáäì åæ ÇÈáÛ

ãÚÏá ÇáÈÊ í

åÐå ÇáæÑÞå

áÌæáÉ ÑæÈä

ÇáãÌÏæá. æãÚ

Ðáß Çä

ÇáÞÏÑÉ ÇáÊí

ÍÞÞåÇ HSDPA áíÓÊ

ßãÇ åí

ãÊÇËÑå

ÈÑäÇãÌ

ÇáÊÚÇæä

Çáäí.

ÈÇÓÊÎÏÇã

åÐå ÇáäÊíÌÉ

æÓíáÉ

ááÍÇÙ Úáì

ÓÚÑ ÇáÞØÚå

ÇáæÇÍÏÉ ãä

ÈÑäÇãÌ

ÇáÊÚÇæä

Çáäí í ÊÏÞ

ãÚíä Ïæä Çä

ÊÊÎáì Úä

ÇáßËíÑ ãä

ÞíãÉ ÇáÎáíÉ

åí ÇáÞÏÑÉ

ÇáãÞÊÑÍÉ

Introduction

Générale

TCP (Transport Control Protocole) est un protocole qui assure

une transmission fiable des données et un contrôle de flux au

niveau de la couche de transport. Ceci est assure par l'utilisation d'un

mécanisme de transmission a fenêtre glissante couple avec un

mécanisme de retransmission des segments TCP erronées et un

contrôle de la taille de la fenêtre de transmission en fonction des

congestions dans les réseaux. TCP est utilise comme protocole de

transport dans la majorité des services véhicules sur Internet

(presque 90%) et il est prévu d'occuper une large partie des services "

données " véhicules dans les réseaux mobiles de

troisième génération. Dans les réseaux sans fil,

les erreurs sur l'interface radio sont interprétées par TCP comme

étant des congestions ce qui entraînera une retransmission des

Segments TCP contenant les erreurs et une baisse de la taille

de la fenêtre de transmission. Ceci entraînera une baisse de la

capacité totale du système et une perte d'efficacité du a

une baisse de la fenêtre sans qu'il y ait de congestion baisse).

L'utilisation de Hybrid-ARQ résout une partie ce problème. En

effet, ARQ retransmet les paquets erronés au niveau de la couche MAC -

hs empêchant ainsi le transfert des erreurs à la couche transport.

Par conséquent, les erreurs causées par l'interface radio seront

transparentes par rapport à la couche transport. Cependant, le

mécanisme Hybrid-ARQ génère un délai de

réception du aux retransmissions fréquentes des paquets. Si ce

délai est important (ce qui est le cas malheureusement cause des

erreurs fréquentes sur l'interface radio), un phénomène de

" timeout " surgit (i.e. un timer déclenché au moment de la

transmission du segment TCP expire sans recevoir un acquittement du

récepteur indiquant la réception du segment sans erreur). TCP mal

interprète ce délai comme étant du a une congestion et

déclenché un mécanisme de

Retransmission suivie d'une baisse de la fenêtre de

transmission jusqu' à sa valeur initiale entraînant ainsi une

perte d'efficacité et une baisse de la capacité totale du

système. Dans cette partie de la thèse, on a développe une

analyse mathématique de ce problème en proposant un modèle

analytique capable de déterminer quantitativement l'effet des

algorithmes d'ordonnancement (étudies précédemment) sur

les performances et services TCP véhicules sur HSDPA. Par

conséquent nous allons fournir des études et

modélisations analytiques couvrant les aspects suivants:

· Capacité du système UMTS dans le sens

descendant

· Analyse et modélisation de la capacité

des cellules HSDPA

· Caractérisation et modélisation de

l'interaction entre le protocole TCP et l'entité MAC-hs. Cette

interaction est due essentiellement à l'utilisation des techniques

Hybrid-ARQ et algorithme d'ordonnancement (scheduling) dans le système.

Chapitre 1 :

Ce chapitre décrit brièvement

l'évolution des réseaux cellulaires. Nous s'intéressons

uniquement aux réseaux UMTS .Durant ce Chapitre nous définissons

l'architecture des réseaux, le différent type de canaux et couche

en fin nous procéderons à une modélisation de la

capacité du système UMTS dans le sens descendant

Chapitre 2 :

Ce chapitre commence par une description

détaillée du système HSDPA et les nouveaux

mécanismes introduits par cette technique tel que les nouveaux canaux

, par la suite nous passerons à une modélisation analytique de la

capacité de la cellule

Chapitre 3 :

Dans ce chapitre nous étudierons le protocole TCP

Chapitre 4 :

Ce chapitre porte sur l'étude de l'impact du protocole

TCP sur les système UMTS et HSDPA en prenant comme algorithme

d'ordonnancement le fair throuphput

Chapitre 1 : Réseau UMTS

Introduction

Pendant les deux dernières décennies,

l'Internet est devenu dans le monde entier le plus grand réseau pour

l'échange d'information. Le transfert de données dans les

réseaux cellulaires sera sans doute l'un des principaux marchés

de télécommunication les années à venir.

Les utilisateurs demanderont de plus en plus la

même qualité de service sur leurs systèmes cellulaires

que celle reçue avec les environnements câblés. Ainsi le

développement technologiques de ces réseaux à connu grand

essor en effet , après la première génération

des téléphones mobiles des années 1970-1980

caractérisée par une modulation analogique, une couverture

limitée, la deuxième génération a vu le jour. Cette

deuxième génération a introduit la technologie

numérique présentant ainsi une meilleure qualité de

service et assurant une certaine confidentialité. Elle comprenait quatre

systèmes : Le GSM (Global System for Mobile Communication) en

Europe, Le D-AMPS (Digital AMPS) aux Etats-Unis, Le Code Division Multiple

Access (IS-95)-Qualcomm aux Etats-Unis aussi Le PDC (Personal Digital

Cellular) au Japon.

Mais au début des années 90, la

norme GSM était adoptée en Europe et depuis, elle s'est

imposée à peu près partout, sauf au Japon, en

Amérique du Nord. Les réseaux GSM qui n'autorisent qu'au mieux

des débits de 9.6 Kbit/s destiner principalement aux appels vocaux, aux

SMS (Short Message Services) et peu à l'acheminement de données,

ce qui n'a pas répondu complètement aux exigences des

utilisateurs bien que des améliorations permettant d'atteindre 14.4

Kbit/s ont été prévu. Donc, afin d'assurer des

débits plus importants et pour répondre aux attentes des

utilisateurs, des nouvelles technologies ont été conçues

et il y a eu ainsi passage à la génération 2.5. Les

technologies de cette génération sont le HSCSD (High Speed

Circuit Switched Data) et le GPRS (General Packet Radio Service) qui permettent

théoriquement à l'utilisateur de bénéficier de

débits allant jusqu'à 171 Kbit/s. Le HSCSD est une

amélioration des services de données en mode circuit de la norme

GSM phase 2. Cette technologie permet d'obtenir des débits de 57.4

Kbit/s en concaténant 4 intervalles de temps de 14.4 Kbit/s au sein

d'une cellule GSM TDMA. Concernant ses services, ils sont très

consommateurs de ressources radio et mal adaptés au monde Internet

pourtant cette technologie est très facile à implémenter

pour les opérateurs.

Pour le GPRS, c'est une technologie orientée

paquet destinée à fonctionner sur les réseaux GSM

fonctionnant en mode circuit. Cette commutation de paquets permet de ne pas

monopoliser le canal de communication comme c'est le cas en commutation de

circuit et autorise une tarification plus souple à l'usage. Outre cet

avantage, GPRS permet d'atteindre des débits de 171.2 Kbit/s si le

schéma de codage utilisé est sans correction et des débits

de 126.4 Kbit/s si le schéma de codage utilisé est avec

correction ; ces débits concernent l'infrastructure du

réseau, donc pour l'utilisateur final ils sont environ de 160 Kbit/s ou

115 Kbit/s .En fait ces débit élevés correspondent

à un utilisateur utilisant les 8 time slots disponibles, mais en

réalité les périphériques ne se verront attribuer

que deux ou trois time slots, ce qui correspondra à des débits

maximum de 28.8 Kbit/s et 43.2 Kbit/s et dans certains cas, GPRS permet une

allocation asymétrique des ressources sur les deux voies montantes et

descendantes (par exemple 1 slot sur la voie montante et 4 sur la voie

descendante) ce qui correspondra à un débit de 14.4 Kbit/s pour

le lien montant et 57.6 Kbit/s pour le lien descendant .Une autre

évolution de GSM formant la génération 2.75 est en passe

d'être déployée ; c'est la technologie EDGE (Enhanced

Data rate for GSM Evolution) qui est conçue pour fournir un pont entre

les technologies de deuxième génération et celles de

troisième génération donc entre GPRS et UMTS. EDGE utilise

une technologie en mode paquets offrant des débits de 384 Kbit/s pour un

utilisateur immobile donc elle permet de tripler le débit de l'interface

radio entre les terminaux et un BTS (Base Transceiver Station) ; en

réalité, ce débit ne dépasse pas les 250 Kbit/s

pour un utilisateur en mouvement. Or le monde des

télécommunications connaît une augmentation du volume des

communications mobiles et un développement extrêmement rapide de

l'Internet ,tant au niveau du nombre d'abonnés qu'au nombre de services

offerts , pour faire face a cet évolution , il est nécessaire

d'effectuer un saut technologique et de franchir le pas vers les réseaux

cellulaires de 3 eme génération , un changement de la

configuration et la structure des réseaux existant est devenu essentiel

.Ces systèmes de troisième génération, et en

particulier l'UMTS, devront évident assurer la continuité avec

les services actuels de téléphonie mobile, mais aussi de

supporter de nouveaux services de transmission de données en mode

paquet, à haut débit, avec différentes qualités de

service pour répondre aux besoins des usagers pour des systèmes

mobiles d'accès à l'Internet. Plusieurs version ont

été développe ; La première version de

l'UMTS : dite Release 99 , Elle utilise la technique WCDMA comme technique

d'accès et emploie pour son domaine de paquet le réseau GPRS

pour fournir la convergence en IP ,tout en appliquant les protocoles ATM pour

technique de transmission . Cette étape d'évolution reste

insuffisante pour compléter la compatibilité avec le monde IP.

L'interface air comme indiquée dans la version 99 ne fournit pas les

débits nécessaires. L'augmentation de l'utilisation de

l'Internet et des services de données motive l'évolution des

réseaux cellulaires des troisièmes et après

troisièmes générations. Par conséquent L'UMTS (

Universal Mobile for Télécommunications System) a

été prépare pour cette évolution a travers les

versions successives (releases) de la norme développées au sein

du 3GPP ( Third génération partnership project). Après

ses promesses de départ d'être capable de supporter des transferts

de données à 2Mb/s, qui se sont avérés par la

suite être plutôt que 384 kbit/s, Dans ce contexte, HSDPA ( High

Speed Downlink Packet Access) a été développe dans les

releases 5 et 6 pour poursuivre l'évolution du mode "paquet" de l'UMTS.

1. 1 Technique d'accès radio

Dans cette section, nous allons présenter les

méthodes d'accès de base avant de détailler le principe

d'étalement de spectre sur lequel s'appuie le WCDMA. Nous verrons

ensuite les codes d'étalement utilisés dans le processus

d'étalement.

1.1. 1 Techniques de base

Figure 1. 1 Technique

d'accès

Parmi les méthodes d'accès de base :

Le FDMA représente la technique la plus

utilisée dans les réseaux mobiles de première

génération. Avec cette méthode, le spectre est

divisé en plusieurs canaux radio avec une largeur de bande (delta f)

Quand un usager désire effectuer un appel, un des canaux est alors

exclusivement alloué à cet usager pendant toute la durée

de la communication. Cette technique s'applique principalement aux signaux

analogiques.

Le TDMA est surtout utilisé dans les

systèmes de deuxième génération, tels que le GSM ou

le IS-136 (appelé aussi Digital AMPS). Par cette technique, une

même bande de fréquences est partagée par un certain nombre

d'utilisateurs qui se voient attribués un intervalle (slot) de temps

unique, comme le montre Dans le cas de la norme européenne GSM, chaque

canal de 200 kHz est divisé en huit tranches de temps, tandis que selon

la norme américaine IS-136, chaque canal de 30 kHz est divisé en

trois tranches de temps. Ces systèmes permettent d'avoir, dans des

conditions réelles d'utilisation, une capacité en terme de nombre

d'utilisateurs 3 à 6 fois supérieure à celle des

systèmes qui se basent sur le FDMA

Le WCDMA, utilisé entre autre en UMTS, permet

à un grand nombre d'usagers d'utiliser la même onde porteuse mais

sans s'interférer les uns avec les autres. Elle consiste à

répartir l'information radioélectrique émise sur une bande

de fréquences plus large que celle réellement nécessaire

à la transmission du signal utile (étalement de spectre). Ce

dernier apparaît alors comme un bruit et sa densité spectrale est

constante sur l'intégralité de la bande occupée. Chaque

utilisateur transmet ses informations sur le canal continûment et en

utilisant toute la bande passante. Ceci veut dire qu'il y a interférence

entre les différents utilisateurs, mais chaque utilisateur envoie sa

propre signature avec ses informations. Cette signature est appelée

code (désigné par pi) et elle est combinée avec les

informations utiles avant de tout transmettre. Les codes sont

caractérisés par les propriétés suivantes :

· Chaque code doit être facilement

distingué de sa répétition dans le temps.

· Chaque code doit être facilement

distingué des autres codes utilisés dans le réseau.

· Les différents codes sont pseudo orthogonaux et

donc pi ' pj » 0 " i j.

1.1. 2

Technique d'étalement

La technique d'étalement de spectre est

utilisée pour affecter à chaque utilisateur un code, ou

séquence, unique qui détermine les fréquences et la

puissance utilisées. Le signal contenant l'information de

l'émetteur est modulé avec la séquence qui lui est

attribuée, ensuite le récepteur recherche la séquence en

question. En isolant toutes les séquences provenant des autres

utilisateurs (qui apparaissent comme du bruit), le signal original de

l'utilisateur peut alors être extrait.

1. 2 Présentation du

système UMTS

L'Universel Mobile

Télécommunications System (UMTS) est la nouvelle norme de

téléphonie mobile, appelée aussi plus

généralement téléphonie de troisième

génération ou 3G. Les puristes préfèrent utiliser

le terme W-WCDMA ( Wide band Code Division Multiple Access ) qui reprend le nom

de la technologie déployée en Europe et par certains

opérateurs asiatiques. Cette technologie permet de faire transiter

davantage de données et va permettre l'apparition de contenus

multimédias sur les téléphones mobiles tel la visiophonie.

On parlera alors plutôt de terminaux multimédias. Ainsi, en plus

de ces évolutions technologiques, la troisième

génération doit répondre à la notion de

qualité, de variété, de capacité et de couverture.

L'organisme UIT (Union Internationale des Télécommunications) qui

règlemente les différents standards de

télécommunications au niveau mondial avait pour objectif de

définir un standard unique et international pour la troisième

génération : l'IMT-2000. Mais cela a échoué puisque

pas moins de quinze technologies d'accès radio lui ont été

proposées. Au final, seulement 6 technologies d'accès radio

terrestre auront été gardées : UTRA/FDD, UTRA/TDD,

TD-SWCDMA, WCDMA2000, UWC-136, DECT. L'UMTS quant à lui regroupe les

deux premières technologies.

1.2 1 Principes de base

Selon l'UIT, les 6 réseaux

d'accès radio terrestre, dont l'UMTS fait parti, doivent satisfaire aux

caractéristiques techniques suivantes :

v Garantir des services à haut débit avec un

minimum de 144kbps dans tout type d'environnement et jusqu'à 2Mbps dans

des environnements intérieurs et avec une mobilité

réduite.

v Transmettre des données symétriques

(même débit montant et descendant) et asymétriques

v Fournir des services à commutation de circuits

(idéal pour la voix) et à commutation de paquets (idéal

pour la transmission de données)

v Qualité de parole comparable à celle des

réseaux câblés

v Capacité et efficacité spectrale doivent

être supérieures à celles des systèmes cellulaires

actuels de deuxième génération

v Possibilité d'offrir des services multimédias

lors d'une même connexion avec des qualités de services

différentes (débit, taux d'erreurs, ...) pour les

différents types de médias (voix, audio, données)

v Compatibilité avec les réseaux d'accès

radio de deuxième génération

v Itinérance entre les différents

systèmes de troisième génération,

c'est-à-dire la compatibilité entre eux.

v Couverture universelle associant des satellites aux

réseaux terrestres

1.2

2 Service UMTS

Standardiser un nouveau service nécessite

généralement une modification des spécifications

techniques, procédées long et ardues qui peut représenter

un frein à l'innovation et à la standardisation de services.

[1]

Par conséquent, dans l'UMTS, on standardise

uniquement certains services afin de préserver une continuité

dans l'offre et on donne les moyens aux opérateurs et aux fournisseurs

de services de développer et de personnaliser leurs propres. Les

services standardisés en UMTS regroupent les :

- services support (bearer services) ;

- télé services (remote services) ;

- services supplémentaires.

Un service support est une sorte de « tuyau

» que l'opérateur du réseau mobile met à la

disposition de l'abonné pour transmettre de l'information entre deux

points. Il joue un rôle fondamental dans le réseau en transportant

l'information liée au service (voix, données, vidéo...) et

à la signalisation. Les télés services proposent une offre

complète pour la transmission d'information en incluant les fonctions de

l'équipement terminal. On peut citer, par exemple, la transmission de la

voix (téléphonie et appels d'urgence), le service de messages

courts SMS (Short Message Service), la transmission de fax ou alors des

services de voix groupés (communication en groupe, voix en diffusion).

Les services supplémentaires sont toujours proposés en

association ou comme complément à un service support ou à

un télé service. Ils offrent la possibilité de

personnaliser les services support et les télé services, en

apportant des fonctionnalités additionnelles

Un même service supplémentaire peut

être proposé en association avec des services support ou des

télé-services différents. Parmi ces services, nous pouvons

citer le renvoi d'appel, le transfert d'appel, le rappel automatique, etc.

Chaque service support est caractérisé par un certain nombre

d'attributs qui concernent, entre autres, le débit, le temps qu'il met

pour acheminer l'information d'un bout à l'autre, le taux d'erreur qu'il

garantit, etc.

Tous ces paramètres doivent être choisis

pour que le service support soit le plus adapté possible, car la

qualité finale du service offert, appelée QoS (Quality of

Service), en dépend. La QoS regroupe une série de

caractéristiques quantitatives et qualitatives qui permettent au

destinataire de considérer que la qualité du service est

satisfaisante. A chaque Service correspond une QoS particulière. Ainsi,

les services support doivent-ils être choisis en conséquence

Les caractéristiques du service support sont choisies

pour chaque télé-service ou application en fonction de la QoS que

ces services ou applications requièrent. Ainsi, un service support

pourra être caractérisé en fonction de la capacité

du réseau pour le transfert de l'information et de la qualité de

l'information une fois transférée. Ces paramètres sont

spécifiés ou négociés lors de

l'établissement de la communication et il est possible de les modifier

de manière dynamique au cours de celle-ci.

Le transfert de l'information fait référence

à la capacité du réseau à acheminer

différents types d'information entre deux ou plusieurs points. La

qualité de l'information transférée entre deux ou

plusieurs points peut être quantifiée en fonction d'un nombre

limité de paramètres :

v le délai maximum toléré pour le

transfert de l'information ;

v les variations du délai ;

v le débit binaire ;

v le taux d'erreur binaire.

La maîtrise des variations du délai est

fondamentale pour offrir des services en temps réel. Le taux d'erreur

binaire BER (Bit Error Rate) mesure le rapport entre le nombre de bits

d'informations erronés et le nombre total de bits transmis. Le

débit représente la quantité d'information transmise entre

deux points par intervalle de temps et que l'on mesure en bits par seconde

(bps).

En conclusion, l'application doit indiquer ses besoins

en termes de QoS au réseau UMTS. Plus précisément, elle

doit spécifier les attributs du service support requis : le type de

trafic (temps réel ou non), les caractéristiques du trafic (point

à point, point à multipoint), le délai de transfert

maximum, les variations du délai et le taux d'erreur.

Nous allons donner quelques exemples de services que

l'UMTS peut offrir suivant un découpage par « classes » qui

dépendent de la QoS désirée. Ces classes de services sont

résumées dans le tableau 3.1 et définies comme suit :

|

Service

|

Délai

|

Exemples d'application

|

Débit

|

Tolérant à des erreurs

|

|

Conversationnel (temps réel)

|

<< 1s

|

Téléphonie

Vidéophonie

|

28.8 kbps

32-384 kbps

|

Oui

Oui

|

|

Interactif

|

environ 1 s

|

Commerce électronique

Internet

|

Non garanti

N on

garanti

|

Non

Non

|

|

Streaming

|

< 10 s

|

Audio/vidéo haute qualité

|

32-128 kbps

|

Oui

|

|

Arrière-plan (Background)

|

> 10 s

|

Fax

E-mail

|

Non garanti

Non garanti

|

Oui

Non

|

Tableau 1 Classes de

services de l'UMTS [6,7]

a) Services conversationnels [5].

Les services de cette catégorie permettent de

transmettre principalement du son et des images entre deux personnes ou groupes

de personnes. Leur qualité est donc assez sensible à des

délais dans la transmission, ces délais pouvant être

facilement perceptibles par les utilisateurs. Parmi ces services, nous pouvons

citer la téléphonie en mode circuit, la téléphonie

en mode paquet utilisant le protocole VoIP (Voice over IP) et la

vidéophonie. Néanmoins, cette dernière est moins

tolérante aux erreurs que la téléphonie et requiert

généralement un débit plus important [4]

b) Services interactifs : ce type de service est

caractérisé par le fait que le terminal ayant envoyé un

message/commande attend une réponse du destinataire dans un certain

intervalle de temps. Par conséquent, un paramètre clé pour

identifier la QoS des services interactifs est le temps d'aller-retour, c'est

à dire le temps écoulé entre le moment où le

message/commande est émis et celui où la réponse arrive.

Comme exemple, nous pouvons citer le commerce électronique ainsi que les

services de localisation qui se développent de plus en plus ; [6,7].

c) Services streaming : on retrouve dans cette classe les

services qui traitent l'information au niveau du terminal de façon

continue, c'est à dire au moment même où elle est

reçue (avant de la recevoir dans sa totalité). Ce type de service

est unidirectionnel. Ces services sont assez récents et offrent un

potentiel d'application assez vaste. Le streaming audio et vidéo sont

des exemples d'applications typiques. [7]. A la différence des services

conversationnels, les services de type streaming sont assez asymétriques

(on ne reçoit pas au même débit que l'on émet) et on

peut tolérer dans ce cas des délais importants ;

d) Services en arrière-plan : il existe des services

qui ne posent, ou presque, aucune contrainte de temps dans le transfert de

l'information qu'ils génèrent. Ils peuvent s'exécuter en

« arrière-plan » (background). Parmi ces services, nous

pouvons trouver l'envoi d'un courrier électronique, d'un message court

SMS ou alors le téléchargement d'un fichier. Le paramètre

pour quantifier la QoS de ce type de ce service est principalement le taux

d'erreurs qui doit être souvent assez [4]

1. 3 Architecture globale de

l'UMTS

Le réseau UMTS repose sur une architecture

flexible et modulaire. Cette architecture n'est associée ni à une

technique d'accès radio, ni à un ensemble de services, ce qui

assure sa compatibilité avec d'autres réseaux mobiles et garantit

son évolution[3]. Une telle architecture, illustrée à la

Figure 1 2 , est composée de trois « domaines » :

_Le domaine de l'équipement de l'usager UE (User

Equipement),

_Le réseau d'accès radio « universel »

UTRAN (Universel Terestrial Radio Access Network)

_ Le réseau coeur CN (Core Network).

Figure 1. 2- Architecture générale du

réseau UMTS

Chaque domaine réalise une fonction bien

précise dans le réseau, tandis que les points d'échange,

notés par Uu et Iu, Iub servent d'interfaces permettant les

échanges entre les différentes parties du réseau.

1.3.1 Domaine Equipement utilisateur

Le domaine de l'équipement utilisateur (UE) comprend

l'ensemble des équipements terminaux. Il comprend à la fois

l'équipement Terminale et l'USIM. Ce domaine permet à

l'utilisateur d'accéder à l'infrastructure par

l'intermédiaire de l'interface Uu. .

L'équipement mobile se subdivise en deux parties [10].

- l'équipement terminal (TE) est la partie où

les données d'information sont génères en

émission ou traitées en réception

- USIM (Universel Subscriber Identity Module), quand

à elle, est une application qui gère les procédures

d'authentification et de chiffrement services auxquels l'abonné a

souscrit. L'USIM réside dans une carte à puce appelée UICC

(UMTS Integrated Circuit Card). Elle peut être utilisée terminal

UMTS indépendamment du fabricant et en général de

l'opérateur du réseau : la carte associe un abonné

à un ou plusieurs fournisseurs de services et pas nécessairement

à l'opérateur du réseau courant.

1.3.2 UTRAN ( Universal terestrial

Radio Network Acces )

L'UTRAN assure le transport des flux entre le terminal mobile

et le réseau coeur. Il fournit à l'UE (User Equipment) les

ressources radio et les mécanismes nécessaires pour

accéder au Réseau Coeur (Core Network) [9,12]. L'UTRAN

contient les entités qui contrôlent les fonctions liées

à la mobilité et l'accès au réseau. Ils

également assurent établissement et libération des

connexions radio L'UTRAN se compose des sous-systèmes par dite RNS

(Radio Network Subsystem). Reliés au réseau Coeur par

l'interface Iu . Chaque RNS se contient RNC (Radio Network Contrôler)

et un ou plusieurs node B comme le montre la Figure1.3

RNS

RNC

RNS

RNC

Core Network

NodeB

NodeB

NodeB

NodeB

Iu

Iu

Iur

Iub

Iub

Iub

Iub

Figure 1.3 - Éléments du réseau

d'accès UTRAN

Le RNS Radio Network Subsystem)

Il est constitué

d'un seul contrôleur de réseau radio RNC et de plusieurs noeuds B

(Node B).

Le RNC (Radio Network Controller)

Le RNC contrôle et gère les ressources radio

(établissement, maintien et libération des canaux radio),

effectue le contrôle d'admission CAC (Call Admission Control) et alloue

des codes pour des nouveaux liens radio. Il effectue également le

contrôle de la charge et de congestion, ainsi que d'autres fonctions

liées à la mobilité notamment le handover qui permet

à un terminal mobile de se déplacer d'une cellule à

l'autre. Deux types de RNC sont définis [12]. Le Serving RNC (S-RNC):

il gère les connexions radio avec le mobile et sert de point de

rattachement au core network via l'interface Iu. Il contrôle et

exécute le handover. Il assure aussi les fonctions de

Division/recombinaison dans le cas du soft-handover pour acheminer un seul

flux vers l'interface Iu. Le Drift RNC (D-RNC): sur ordre du S-RNC, il

gère les ressources radio des stations de base (Node B) qui

dépendent de lui. Il effectue la recombinaison des liens lorsque du fait

de la macro diversité, plusieurs liens radio sont établis avec

des stations de base qui lui sont rattachés. Il route les données

utilisateurs vers le Serving RNC dans le sens montant et vers ses stations de

base dans le sens descendant.

1.3.3 Node B

Il assure la transmission et la réception

d'informations entre l'UTRAN et un ou plusieurs équipements usagers.

Parmi ses fonctions, on peut citer le contrôle de puissance. En effet, la

puissance d'émission de l'UE est contrôlée

systématiquement pour lui assurer la même qualité de

service indépendamment de sa position dans le réseau. Allocation

des ressources radio. Dans la release 99 le node B contient uniquement les

procédures assurant uniquement la gestion de la couche physique tel

que : le codage, étalement de spectre et signalisation couche

physique. Dans la release 5 et 6, des fonctions intelligentes ont

été introduit dans le node B, pour améliorer les

performances de la couche MAC est spécialement le HARQ et le programme

d'ordonnancement

1.3.4

Réseau Coeur

Le réseau Coeur (Core Network) : il

assure la connexion entre les différents réseaux d'accès

et entre le réseau UMTS et les autres réseaux comme le

réseau téléphonique (PSTN : Public Switched

Téléphone Network), le réseau GSM, le réseau

RNIS [9] (Réseau Numérique à Intégration de

Services ou ISDN : Integrated Services Digital Network), etc. Il

fournit le support des services de télécommunications UMTS et

gère les informations de localisation des utilisateurs mobiles ainsi

qu'il contrôle les services et les caractéristiques du

réseau. Le réseau coeur est composé de deux

domaines : le domaine à commutation de circuits CS (Circuit

Switched domain) et le domaine à commutation de paquets PS (Packet

Switched domain).

1.4 Les interfaces logiques

dans l`UTRAN

L`architecture générique des interfaces logiques de

l`UTRAN est représentée dans la Figure 1.4 La structure de la

pile protocolaire se divise en deux couches : la couche du

réseau radio RNL (Radio Network Layer) et la couche du

réseau de transport TNL (Transport Network Layer). Ces deux

couches sont séparées dans le but de pouvoir modifier la

couche de transport sans besoin de reconfigurer la couche radio.

[13]

Figure 1. 4 Architecture générique des

interfaces de l`UTRAN

La couche réseau de transport est

destinée à transporter les données de la couche radio

au sein de l`UTRAN. La couche réseau radio assure la gestion des

ressources de l`interface radio et les fonctions d`établissement et de

libération des connexions entre le terminal mobile et le réseau

UTRAN. Le plan de contrôle de la couche réseau radio

gère les canaux de signalisation nécessaires pour transmettre les

données des protocoles applications comme RANAP (Radio Access

Network Application Protocol), RNSAP (Radio Network Subsystem Application

Part) ou NBAP ( Node B Application Part). Les protocoles du plan de

contrôle de la couche réseau radio sont indépendants de la

technologie employée dans le réseau de transport .Les protocoles

ALCAP (Access Link Control Application Part) du plan de contrôle de la

couche réseau de transport assurent les services de

signalisation nécessaires pour l`établissement des connexions

du plan utilisateur pour transporter les données de la couche

réseau radio. Le plan utilisateur de la couche réseau radio

contient les protocoles nécessaires pour transporter les flux des

données de l`interface radio ainsi que es informations

nécessaires aux mécanismes de synchronisation des trames et de

macro diversité.

1.4 .1 L'interface Uu

L'interface logique Uu sert à connecter

le terminal mobile à la station de base par l'intermédiaire

d'une liaison radio. La couche physique de l'interface Uu est basée

sur la technique d'accès multiple à répartition en

codes WCDMA (Code Division Multiple Access

Dans le but de comprendre les fonctions de

l'interface d'accès au réseau UTRAN, nous allons décrire

les protocoles de communication mis en oeuvre sur l'interface entre un terminal

mobile et le réseau d'accès radio du système UMTS. On

pourra distinguer sur cette interface radio trois couches principales de

protocoles illustrées à la Figure 1.5

Couche physique (couche 1) ;

ü la couche de liaison de données (couche 2)

compose aussi des quatre sous couches :

ü la sous-couche MAC (Medium Access Control) ;

1- la sous-couche RLC (Radio Link Control) ;

2- la sous-couche PDPC (Packet Data Convergence Protocol) ;

3- _ la sous-couche BMC (Broadcast/Multicast Control

ü la couche 3 Réseau est la couche de

contrôle de ressource radio RRC (Radio Ressource Control). Elle est

divisée en trois sous-couche : la couches : RRC (Radio

Ressource Control), MM (Mobility Management) et CC (Call Control).

L3

control

control

control

Logical

Channels

Transport

Channels

C-plane signalling

U-plane information

PHY

L2/MAC

L1

RLC

DC

Nt

GC

L2/RLC

MAC

RLC

RLC

RLC

RLC

RLC

RLC

RLC

Duplication avoidance

UuS boundary

BMC

L2/BMC

control

PDCP

PDCP

L2/PDCP

DC

Nt

GC

Radio

Bearers

RRC

control

Figure 1. 5 Couches de protocoles de l'interface

radio Uu

1.4.2

Canaux UMTS

1.4.2.1 Canaux

logiques :

Les canaux logiques sont définie selon

l'information transporte, nous distinguons alors deux classes de canaux

logiques, ceux pour le contrôle et ceux pour le trafic

Canaux logiques de contrôle

Le transfert des donnes de la couche Mac est effectues sur

les canaux logiques, il existe deux type de canaux logique : canaux de

trafic et canaux de contrôles. Les canaux logiques de contrôles

sont utilises pour le transport d'information au niveau de plan de

contrôle et ceux de trafic sont utilises pour achemines les information

du plan user [16,17]

ü Broadcast control Channel (BCCH) utilisé

dans le sens descendant pour la diffusion des informations du réseau au

niveau de toutes les cellules.

ü Paging control Channel (PCCH) utilises dans le sens

downlink pour achemines les information du paging

ü Common control Channel (CCCH) utilise dans le sens

montant et descendant pour transporter l'information de contrôle entre le

réseau et UE

ü Dedicated control Channel (DCCH) utilise dans le sens

montant et descendant pour transporter les informations de signalisation entre

UTRAN et le Mobile. ce canal est utilisé durant

l'établissement de connexion avec le RRC

Les

canaux logiques de trafic : [16,17]

ü Dedicated Trafic Channel (DTCH) utilise dans le sens

descendant et montant, pour la transmission des informations entre l'utran et

utilisateur

ü Common Trafic Channel (CTCH) utilise pour la

transmission des messages pour les utilisateurs

ü MBMS point to multipoint trafic Channel (MTCH) utilise

dans le sens descendant pour transporter le trafic MBMS au mobile

1.4.2.2 Canaux de transport

Les canaux de transport sont des services offerts par

la couche 1 aux couches plus élevées. Le canal de transport est

unidirectionnelle (montante ou descendant), comprend les

caractéristiques exigées pour le transfert des données

sur interface par radio. Par exemple, la taille du bloc de transport (pour

transporter l'unité de données de la couche MAC est l'une des

caractéristiques de canal de transport . Noter que la période

correspondante à la transmission du bloc de transport est connue comme

l'intervalle de temps de transmission (TTI). Dans la version 99, le TTI peut

prendre les valeurs en ms 10, 20, 40, ou 80. Pour le Service

conversationnelle, le TTI est fixe 10 ms. Pour les services de données

il change selon le service utilisé. Les canaux de transport sont classes

en trois groupe : canaux communs, canaux Dédies, et canaux

partagés.

Un canal commun est un canal point à multipoint

unidirectionnel utilisé pour le transfert d'informations de donnes et de

contrôle des couches supérieur entre UTRAN et le Mobile. La couche

physique est transparente pour les informations transmises. Les principaux

canaux communs sont :

ü Broadcast Channel (BCH) utilise dans le sens

descendant pour la diffusion des systèmes informations et

spécifique cellule informations

ü The random access

channel (RACH)

Il existe un seul type de canal partagé

spécifié dans la R99 le DSCH (Downlink Shared Channel). C'est

un canal utilisé uniquement sur la voie descendante en association avec

un ou plusieurs canaux dédiés. Il est partagé

dynamiquement par différents utilisateurs et transporte des

données de contrôle ou de trafic.

Un canal dédié est un canal point à

point dédié à un seul UE. Le DCH (Dedicated CHannel) est

le seul type de canal dédies dans la R99. Ce type de canal existe dans

les deux sens de la liaison et transporte des données.

1.4.2.3 Canaux physiques

Canaux physiques

dédiés de la voie montante

Il existe deux types de canaux physiques

dédiés dans la voie montante :

ü Le canal physique dédié de données

DPDCH (Dedicated Physical Data CHannel)

ü Le canal physique dédié de contrôle

DPCCH (Dedicated Physical Control CHannel).

De manière générale, dans la voie

montante, la transmission de plusieurs services en parallèle

dotés de débits différents est accomplie en accommodant

plusieurs canaux de transport dédiés (DCH) dans un seul canal

physique de données dédié (DPDCH). Cette approche devient

rapidement limitée lorsque l'on souhaite accroître le débit

utile. Par exemple, avec SF=4, le débit maximum sur le DPDCH est de 960

kbps. Par ailleurs, si l'on considère que cette information a subi un

codage avec un taux de codage de 1/2, le débit utile maximum que l'on

obtient est de 480 kbps. Une autre manière d'augmenter le débit

consiste à agencer l'information des canaux de transport sur plusieurs

canaux physiques dédiés. Cette approche est appelée

transmission « en Multicode », car plusieurs DPDCH peuvent être

réquisitionnés pour transmettre en parallèle cette

information, chaque canal étant étalé avec un code de

canalisation différente. La valeur SF peut aussi être

différente. Le nombre maximum de DPDCH par utilisateur est de six [4].

Les différents DPDCH sont additionnés et étalés

avec le même code d'embrouillage . On peut noter que l'information de

contrôle associée à la liaison radio est convoyée

par un seul DPCCH.

Avec la transmission en Multicode, le débit utile

total que l'on obtient en considérant un taux de codage de 1/2, un

facteur d'étalement SF=4 et six canaux DPDCH est de 2.88 Mbps.

Cependant, dans la pratique, en présence de trajets multiples et des

limitations dues au contrôle de puissance, il serait difficile de

garantir des performances acceptables avec un tel schéma de

transmission.

Canaux physiques

dédiés de la voie descendante :

À la différence de la voix montante, il

existe un seul type de canal physique dédié dans la voie

descendante appelé :

v DPCH (Dedicated Physical CHannel). Ce canal achemine

l'information du canal de transport

DCH - information qui peut être du trafic de

données ou de contrôle généré par les couches

supérieures. Il transporte également de l'information de

contrôle engendrée par la couche physique elle-même et, de

ce fait, il peut être considéré comme le multiplexage

temporel d'un canal physique de données dédié (DPDCH) et

d'un canal physique de contrôle dédié (DPCCH).

La transmission en Multicode est également

possible dans la voie descendante. Les DPCH sont transmis en parallèle

vers l'UE concerné avec la même valeur ou non de SF. Chaque DPCH

possède un code de canalisation différent. Par contre, le

même code d'embrouillage est appliqué à tous les DPCH

impliqués.

Canaux physiques

communs

Nous allons citer uniquement trois canaux physiques communs

sur la voix descendante :

ü PDSCH (Physical Downlink Shared Channel),

ü CPICH (Common Pilot Channel)

ü SCH (Synchronization Channel).

Le canal PDSCH supporte le DSCH lors de l'envoi de

trafic de données à haut débit vers un ou plusieurs

équipements usagers situés dans une même cellule. Plusieurs

utilisateurs peuvent se partager ce canal à des moments

différents. Ceci est particulièrement précieux pour

l'UTRAN dans des situations où les codes de canalisation dont dispose la

cellule se font rares. L'allocation d'un PDSCH à un UE est

cadencée par TTI.

Dans certains cas, UTRAN peut attribuer, dans une

même trame, plusieurs PDSCH à un UE en utilisant la technique de

transmission Multicode où chaque PDSCH possède la même

valeur de SF. Des débits aussi élevés que ceux que l'on

obtient avec un canal dédié peut être ainsi atteints.

Comme son nom l'indique, le CPICH est composé

d'une séquence prédéfinie de bits dits « pilotes

» qui sont transmis en permanence sur la cellule. Le débit de ces

bits est constant et égal à 30 kbps, ce qui est fixé avec

une valeur de SF constante et égale à 256.

Le CPICH peut être considéré comme

un canal « balise » dont les terminaux mobiles se servent, entre

autres, pour estimer la qualité du canal de propagation. La

précision de cette estimation permet d'améliorer les performances

des techniques de détection mises en place à la

réception, pour récupérer l'information binaire transmise

par le biais des canaux physiques dédiés et communs de la voie

descendante.

Le SCH permet aux stations mobiles de se synchroniser

avec le réseau et de récupérer le code d'embrouillage

spécifique à la cellule courante. Il ne transporte pas

d'informations des couches supérieures et il n'est associé

à aucun canal de transport.

1.4.3 Couche physique

La couche physique est chargée de transporter

l'information générée par les couches supérieures.

Il s'agit de véhiculer cette information tout en respectant des

contraintes de qualité imposées par le service (délai,

débit, taux d'erreur, etc). Nous commencerons par présenter la

chaîne de transmission UTRA/FDD. Puis, nous aborderons le multiplexage et

le codage canal en détail. Nous verrons ensuite l'application de

l'étalement de spectre de manière spécifique au

réseau UMTS. Nous terminerons par la modulation radio.

Chaîne de transmission UTRA/FDD :

La couche physique fournit le service de transfert d'information à la

couche MAC au travers des canaux de transport. En émission, les

données fournies par la couche MAC sont passées dans une

chaîne de codage de canal avant d'être transmises sur le

médium physique. En réception, les données reçues

sur un canal physique sont passées dans une chaîne de

décodage de canal avant d'être remises à la couche MAC.

Lorsque plusieurs canaux de transport de même type sont portés

simultanément par un seul canal physique, la chaîne de codage est

suivie d'une chaîne de multiplexage et la chaîne de décodage

est précédée d'une chaîne de démultiplexage.

La Figure 1.6 illustre les différentes opérations de traitement

du signal utilisées dans la chaîne de transmission de

l'UTRA/FDD.

Figure 1. 6 - Fonctions de la couche physique dans la chaîne de transmission

UTRA/FDD

Les fonctions de multiplexage et de codage canal

s'appliquent aux canaux de transport par lesquels transitent les bits

délivrés par les couches supérieures à la couche

physique. Les bits véhiculés par les canaux de transport sont

agencés sur les canaux physiques. Une fois qu'ils sont présents

dans ces canaux, ils subissent des traitements de signal spécifiques

pour pouvoir être transmis à travers l'air. Auparavant, les bits

sont convertis en symboles et subissent l'opération d'étalement

de spectre qui va les transformer en chips. Ce sont des chips qui sont transmis

par l'antenne de l'émetteur après avoir été

modulés et placés sur une fréquence porteuse. Les

fonctions inverses sont mises en place à la réception

Multiplexage et codage : Les services

qui seront offerts par l'UMTS seront riches en contenu multimédia.

Supporter ces services implique la transmission en parallèle de

plusieurs flots d'information et, avec elle, l'utilisation de plusieurs canaux

de transport lors d'une même connexion : Chacun d'eux correspond à

un service ayant une QoS différente. Dans le but d'avoir l'assurance que

la QoS du service en question soit respectée, et plus

particulièrement que le taux d'erreurs et le délai de

transmission soient conformes aux attentes, la couche physique met en place des

mécanismes de multiplexage flexibles et des techniques performantes de

codage pour la détection et la correction des erreurs. Un UE peut

utiliser plusieurs canaux de transport simultanément, chacun

étant doté de ses propres caractéristiques en termes de

qualité de service. Ainsi, un ou plusieurs canaux dédiés

de transport (DCH) peuvent être traités en parallèle pour

constituer débit binaire de données unique appelé CCTrCH

(Coded Composite Transport CHannel). Les bits dans un CCTrCH peuvent être

convoyés par un même canal physique. Les différentes

étapes de la procédure de multiplexage et de codage dans la voie

montante sont mises en évidence dans la et résumées par

les points suivants :

Ø Insertion de bits CRC : le CRC (Cyclic Redundancy

Check) est une technique de détection d'erreurs en réception,

à laquelle les systèmes de radiocommunication ont souvent

recours, car elle est efficace et simple à mettre en oeuvre. Avec la

détection d'erreurs, il est possible d'estimer la probabilité

d'erreur dans un bloc de bits de transport. Cette estimation permet

d'évaluer la qualité de la liaison radio et elle peut être

utilisée dans des procédures tel que le contrôle de

puissance ;

Ø Concaténation et segmentation des blocs de

transport : chaque groupe de blocs de transport, correspondant à un

même canal de transport dans un intervalle de temps de transmission TTI

(Transmission Time Interval), est traité avant d'être

envoyé vers le codeur canal, ce afin que le codeur canal ne

détecte en entrée qu'une séquence de bits unique dont la

taille ne dépasse pas la valeur maximale notée Z. Si le nombre de

blocs de transport dans un TTI est M et si p est le nombre de bits par bloc de

transport, la longueur de cette séquence après

concaténation est M × p. Dans le cas où la taille de la

séquence dépasse Z, on applique alors une procédure de

segmentation dont l'objet est de diviser la séquence en sous

séquences ayant la même taille. La valeur Z est imposée par

le type de codage que l'on met en place. Cette opération permet de

réduire la complexité du codeur ainsi que celle du

décodeur lorsque la séquence à coder est trop longue ;

Ø Codage : une fois que les blocs de transport ont subi

les phases de concaténation et de segmentation, les séquences de

bits qui en résultent sont livrées au codeur. Le codage fait

partie des techniques appelées FEC (Forward Error Correction).

L'idée est de coder les bits en émission en ajoutant des bits de

redondance, de telle sorte qu'en réception, l'on puisse détecter

et corriger d'éventuelles erreurs survenues pendant la transmission. Le

codage se décompose donc en deux phases : le codage, qui est

appliqué en émission et le décodage en réception.

D'une manière générale, quel que

soit le type de codage, l'encodage est effectué en faisant passer une

séquence de bits dans un registre à décalages. Ce registre

est composé de N états où des opérations

algébriques sont appliquées suivant les polynômes

générateurs utilisés. Pour k bits qui rentrent dans

l'encodeur, on obtient n bits en sortie, ce qui détermine le « taux

de codage » défini par le ratio R = k/n. Le paramètre N,

appelé « longueur de contrainte », détermine la

capacité du codage canal à corriger les erreurs et la

complexité de mise en oeuvre de cette technique. Le choix du taux de

codage à appliquer dépend du service. Plus le taux de codage est

faible, plus les performances de codage sont bonnes, même si en contre

partie, le débit utile diminue et les opérations d'encodage et de

décodage sont plus complexes. Il existe deux types de codage en

UTRA/FDD : le codage « convolutionnel » et le codage « Turbo

». Le premier est particulièrement approprié pour des

services de transmission de voix où le taux d'erreur BLER (block Error

Rate) que l'on tolère est de l'ordre de 10-3. En revanche, pour des

services de transmission de données, le taux d'erreur est

généralement plus faible (moins de 10-5). C'est pourquoi l'on

fait appel à des techniques plus sophistiquées, tel que le codage

Turbo qui peut être vu comme la concaténation de deux encodeurs

convolutionnels qui opèrent en parallèle, séparés

par un entrelaceur interne

Une fois l'opération de codage

terminée, d'autres étapes sont nécessaires avant d'entamer

le multiplexage et que nous résumons par ce qui suit : Ajustement de la

taille de trames : cette étape, utilisée sur le lien montant,

consiste à scinder les séquences de bits codés (ou non) en

segments de la même taille et à mettre ces segments en

série. Ce procédé est nécessaire lorsque le nombre

de bits présents dans la séquence de bits en entrée n'est

pas un multiple du nombre de trames par TTI. Afin de s'assurer que tous les

segments aient la même taille, des bits de bourrage peuvent être

insérés ;

Premier entrelacement : l'entrelacement est une

technique qui permet d'obtenir une forme de diversité temporelle et

d'éviter ainsi les erreurs en rafale. Ce procédé consiste

à mélanger une séquence de bits en émission, de

façon à étaler les erreurs pendant la transmission et

rendre plus aléatoire leurs propriétés statistiques.

L'entrelacement permet donc d'améliorer les performances de l'algorithme

de décodage canal utilisé ;

Segmentation des trames : ce traitement vient

compléter l'ajustement de la taille des trames et s'applique lorsque le

TTI est supérieur à 10 ms. Son rôle est de segmenter la

séquence de bits contenue dans un TTI en un nombre entier de trames

consécutives ;

Adaptation du débit : un même canal physique

peut convoyer des bits d'information issus des différents canaux de

transport. Or, le débit d'un canal physique est limité. Il faut

donc adapter le débit à la sortie de chaque canal de transport.

Pour ce faire, on peut être amené à retrancher des bits

dans des flots d'information de chaque canal de transport ou à en

rajouter [4].

Multiplexage des canaux de transport : chaque canal

délivre une séquence binaire codée tous les 10 ms. Ces

séquences sont ensuite concaténées les unes après

les autres pour ne créer qu'un flot binaire unique en série : le

CCTrCH .

Segmentation des canaux physiques et deuxième

entrelacement : la segmentation ne s'applique que lorsque plusieurs canaux

physiques sont utilisés pour le même CCTrCH, autrement dit lors

d'une transmission en multicode. Dans ce cas, le deuxième entrelacement

s'applique individuellement sur chaque canal physique. A la sortie,

l'information est répartie sur le ou les canaux physiques. À ce

stade, on est sûr que les bits d'information provenant de chaque canal de

transport pourront être accommodés dans des trames de 10 ms, et ce

en respectant la QoS requise par le service.

Les fonctions de multiplexage et de codage canal sur le

lien descendant sont similaires à celles mises en place dans la voie

montante. Cependant, il existe des particularités propres au lien

descendant. En effet, le nombre de bits présents dans la trame d'un

canal physique est dicté par le facteur d'étalement SF. Dans la

voie montante, ce paramètre peut changer d'un TTI à un autre.

Tandis que, dans la voie descendante, la valeur du SF reste constante tout au

long de la communication. Ainsi, les fonctions d'adaptation de débit et

de segmentation sont différentes

Application de l'étalement de spectre :

Suite à l'opération de multiplexage et de codage,

les bits sont transformés en symboles, puis on applique les

opérations d'étalement de spectre et de modulation. Auparavant,

il convient de citer les paramètres radio qui caractérisent les

canaux physiques de l'UTRA/FDD. Parmi ces paramètres, on trouve : Les

métriques suivantes sont également

référencées pour définir la durée des canaux

physiques : Une « trame radio » a une durée où on

traite l'information qui s'étend sur quinze intervalles de temps ou

slots, soit 38 400 chips (10 ms) ; Un slot est un intervalle de temps de

longueur fixe et égale à 2560 chips ( 0.667 ms). Le nombre de

bits par slot est variable.

Dans la voie descendante, les codes de canalisation

permettent d'identifier les symboles d'information appartenant à chaque

utilisateur dans une cellule. Dans la voie montante, ils permettent de

différencier les symboles d'information du canal ou des canaux physiques

de données dédiés (DPDCH) et du canal physique

dédié de contrôle (DPCCH) appartenant à un

même utilisateur. Le rôle fonctionnel des codes de canalisation

utilisés dans un réseau UTRA/FDD peut être comparé

aux slots de temps alloués dans le réseaux mobiles à base

de TDMA, aux différents utilisateurs dans la cellule pour les distinguer

(du moins pour ce qui concerne la voie descendante).

Les codes d'embrouillage, dans la voie descendante, permettent

d'identifier une cellule. Il existe donc un code unique d'embrouillage par

cellule. L'utilisation des codes d'embrouillage rend les

propriétés statistiques de l'interférence proche de celles

d'un bruit Gaussien, sachant que cette interférence est invoquée

par les cellules voisines qui émettent sur la même

fréquence porteuse. Le code d'embrouillage permet donc de faciliter la

tâche du récepteur lors de la détection des symboles

transmis. Dans la voie montante, les codes d'embrouillage sont utilisés

non seulement pour améliorer les propriétés statistiques

des codes de canalisation, mais aussi pour différencier les utilisateurs

présents dans une même cellule.

Modulation : La modulation consiste

à transformer le signal en bande de base, une fois converti en

analogique, en signal radio, afin de pouvoir le transmettre dans l'air. La

Figure 1.7 donne un exemple de modulation effectuée au niveau de

l'émetteur de la station mobile et de la station de base

Figure 1. 7- Exemple d'une chaîne

d'émission utilisant la modulation QPSK

Après avoir été étalé et

embrouillé, le signal complexe qui en résulte, composé de

chips, est réparti sur une voie réelle et sur une voie imaginaire

appelée respectivement « voie I » et « voie Q ».

Puis, il est filtré avec un filtre numérique et converti en un

signal analogique à l'aide d'un convertisseur

numérique/analogique (CAN). Le signal passe encore par un filtre

analogique avant d'être modulé en quadrature et transposé

sur une fréquence ?. Une fois filtré, le signal analogique est

ensuite modulé suivant le principe de la modulation QPSK (Quadrature

Phase Shift Keying) [10]. Ce type de modulation permet la transmission de deux

chips par symbole. La phase du signal modulé prend différentes

valeurs qui représentent une paire unique de chips. Dans le

schéma simplifié de la Figure 1.7, le signal modulé est

amplifié à l'aide d'un amplificateur de puissance PA (Power

Amplifier) avant d'être transmis. Le choix de la modulation QPSK a

été effectué précisément avec le souci

d'améliorer son efficacité. En effet, l'efficacité de

l'amplificateur de puissance est particulièrement importante dans la

station mobile, car elle a une influence directe sur la consommation

d'énergie du terminal

1.4.4 Couche liaison :

1.4.4.1 Couche MAC

La couche MAC fournit des services à la

sous-couche de RLC par l'intermédiaire des canaux logiques

(contrôle et du trafic) et coordonne l'accès à la

couche physique par l'intermédiaire des canaux de transport. La couche

MAC multiplexe les canaux logiques sur les canaux physiques et inversement

grâce a une table de correspondance. La couche MAC doit

également négocier les paramètres de QoS en gérant

les contentions entre les demandes de services et en établissant des

priorités entre les accès Les fonctions principales de la couche

MAC sont les suivants [16,17]

ü Sélection du format de transport correspondant

a chaque canal de transport en fonction du débit instantané et

des indications de la couche RRC

ü Gestion des priorités entre flux de donnes pour

chaque mobile. lors de la sélection entre plusieurs format de transport,

la couche MAC détermines les priorités entre flux de donnes

véhicules sur les canaux de transport correspondant .Ces

priorités sont base sur les services support Radio, l'état du

buffer RLC et les indications de puissance de la couche physique. la gestion de

priorité est réalise en sélectionnant le format de

transport pour lequel les donnes à la priorité la plus

élevée sont transportées sur les canaux physiques à

haut débit

ü Gestion dynamique des priorités entre usager a

fin d'utiliser les ressources spectrales pour le transfert des données

sporadiques. la couche MAC gère les priorités sur les canaux de

transport commun et partages

ü Organisation des messages de diffusion de paging

ü Identification des mobiles sur les canaux de

transport : Quand plusieurs canaux logiques dédies à

différents utilisateurs sont acheminées par le même canal

commun (par exemple, FACH, RACH), identification de l' équipement

utilisateur (c.-à-d., cell radio network temporary identity ) [ C-RNTI

] ou identité temporaire de l'UTRAN dans le réseau [ U-RNTI ])

(UTRAN radio network temporary identity ) présent dans

l'en-tête du MAC est employé pour identifier les canaux logiques

de chaque utilisateur du côté de récepteur.

ü Adaptation entre canaux c a d entre les canaux

logiques et les canaux de transport

ü Multiplexage et demultiplixage des PDU en provenance ou

émis vers les couches supérieures vers ou en provenance de la

couche physique sur les canaux de transport commun

ü Commutation dynamique de canal de transport .la couche

MAC commute les flux de donnes entre les canaux de transport commun et

dédies sur la base des indications de la couche RRC

Dans la version 5, une nouvelle entité du MAC

appelé MAC -high speed (MAC -hs) est introduit dans le node B, a

été présenté dans les caractéristiques 3GPP.

Cette entité est responsable de manipuler et de contrôler le

mécanisme de HARQ présenté dans HSDPA. L'entité

MAC_hs est responsable d'assembler, et desa-sembler, et de commander à

nouveau une couche plus élevée PDU. Les PDUs sont livrés

dans l'ordre aux couches plus élevées.

1.4.4.2 MAC Architecture

Afin de manipuler les fonctions décrites

précédemment, la couche MAC est divisée en domaines ou

entités suivants [16,17]

ü MAC - b est l'entité qui manipule le canal de

BCH. Il existe uniquement une seule pour chaque équipement utilisateur,

ainsi qu'une seule au niveau de chaque UTRAN (noeud B) comme spécifie

par le 3GPP.

ü MAC-d est l'entité qui manipule le canal de DCH.

Cette entité est spécifique à chaque utilisateur. Dans

l'UTRAN, cette entité est située dans le SRNC. Notez que le

chiffrage est exécuté par cette entité.

ü MAC-c/sh/m est l'entité qui manipule le FACH,

le PCH, le RACH, le CPCH, le choix de formats de transport, ordonnancement /

manipulation de priorité Il y a un MAC-c/sh/m situés dans

l'équipement utilisateur et dans l'UTRAN (situé dans le CRNC).

Note que dans la version 99, cette entité a été

appelée MAC-c/sh. Dans la version 6, c'est appelé MAC-c/sh/m

puisqu'il est impliqué dans les services de MBMS en multiplexant et en

lisant l'identité de MBMS (qui est employée pour distinguer les