|

MÉMOIRE DE FIN D'ÉTUDES

CONCEPTION D'UN FILTRE D'UN RESEAU D'OBJETS CONNECTES

PAR APPRENTISSAGE PROFOND

Réalisé par :

NYABENG MINEME SANDRA ROCHELLE

Matricule : 15T31081

En vue de l'obtention du

DIPLÔME DE MASTER EN

TELECOMMUNICATIONS

Option

SECURITE DES RESEAUX ET SYSTEMES

Sous la supervision de :

Sous la supervision de :

Dr. SAMEH NAJEH

Maître Assistante, Enseignante à

SUP'COM

Encadreur Académique

Enseignante à Sup'Com

Année académique : 2019-2020

DÉDICACE

A MA MERE NYANDING BLANDINE PASCAL ET MON PERE MINEME AFANA

MVODO

REMERCIEMENTS

Tout d'abord je remercierais Dieu tout puissant pour la

volonté d'entamer et de terminer ce projet de fin d'étude.

Ensuite ma gratitude ira vers mon Encadreur Madame Sameh

Najeh pour sa patience, son suivi, ses remarques et sa confiance. Ses conseils

m'ont énormément aidé.

Je remercie l'Ecole Nationale Supérieure des Postes,

des Télécommunications et des Technologies de l'Information et de

la Communication, SUP'PTIC et les enseignants qui m'ont accompagné

durant ma formation.

Enfin je voulais remercier ma famille et toute les personnes

qui m'ont soutenu et aidés pour ce projet

RÉSUMÉ

L'insécurité des objets connectés est une

menace pour la société connectée vers laquelle nous

évoluons. Les technologies propriétaires et le manque de

sensibilisation chez les utilisateurs n'arrangent pas les choses. C'est chaque

fabricant ou développeur qui conçoit son objet et les solutions

de sécurité. Malheureusement ce qu'ils proposent sont souvent

propres à leurs objets uniquement ou à un protocole de

communication spécifique. Le risque s'accroît encore plus

lorsqu'on sait qu'un virus peut se propager dans un réseau. Des

solutions applicables à l'ensemble des objets sans prendre en compte le

protocole de communication ou les caractéristiques des objets sont

nécessaires. Un réseau d'objet connecté peut

représenter une menace pour les utilisateurs. Avec des données

collectées sur plusieurs types d'objets utilisant des protocoles de

communications et des systèmes différents, quelques solutions

impliquant ou pas des algorithmes d'intelligence artificielle ont

déjà été suggérés. Ceci pour isoler

les objets suspects ou créer des règles de pare-feu après

avoir filtré les paquets. Nous proposons dans ce mémoire une

autre approche qui implique de filtrer les paquets. Nous nous basons sur la

détection des attaques spécifiques aux objets connectés

grâce à l'apprentissage profond et détectons les objets de

notre réseau domotique en se basant sur des empreintes digitales elles

aussi construites par des algorithmes. Tout ceci permettra d'une part de

protéger des objets connectés dans le réseau domotique

mais aussi mais aussi d'alléger la tâche d'un pare-feu. De plus

sans avoir à générer des règles

supplémentaires qui entraînent des anomalies au fil du temps.

Nous avons choisi des algorithmes d'apprentissage profond pour réaliser

nos modèles. Les réseaux de neurones ont montré de bonnes

performances même s'il a fallu beaucoup de modifications de nos

réseaux.

Mots clés : Objets Connectés,

Réseau, Apprentissage Profond, Sécurité

ABSTRACT

The insecurity of connected objects is a threat to the

connected society we are moving towards. Proprietary technologies and a lack of

awareness among users don't help. It is each manufacturer or developer who

designs their purpose and security solutions. Unfortunately what they offer are

often specific to their objects only or to a specific communication protocol.

The risk is further increased when it is known that a virus can spread over a

network. Solutions applicable to all objects without taking into account the

communication protocol or the characteristics of the objects are necessary. A

connected object network can pose a threat to users. With data collected on

several types of objects using different communication protocols and systems, a

few solutions involving or not involving artificial intelligence algorithms

have already been suggested. This is to isolate suspicious objects or create

firewall rules after filtering the packets. We propose in this paper another

approach which involves filtering the packets. We rely on the detection of

attacks specific to connected objects through deep learning and detect the

objects of our home automation network based on fingerprints also built by

algorithms. All this will on the one hand protect connected objects in the home

automation network but also but also lighten the burden of a firewall. Plus

without having to generate additional rules that cause anomalies over time. We

chose deep learning algorithms to build our models. Neural networks have shown

good performance even though it took a lot of modifications to our networks.

Keywords: Connected Objects, Network, Deep Learning,

Security

TABLE DES MATIÈRES

DÉDICACE

i

REMERCIEMENTS

ii

RÉSUMÉ

iii

ABSTRACT

iv

TABLE DES MATIÈRES

v

LISTE DES TABLEAUX

vii

LISTE DES FIGURES

viii

LISTE DES ABREVIATIONS

x

INTRODUCTION GENERALE

1

CHAPITRE 1 : ETAT DE L'ART, CONTEXTE ET

PROBLÉMATIQUE

3

Introduction

3

1. Caractéristiques d'un réseau

d'objet connecté

3

1.1. Acteurs d'un réseau d'objet

connecté

3

1.2. Architecture d'un objet

connecté

5

1.3. Protocoles de communication des objets

connectés

6

2. Problèmes de

sécurités rencontrés sur les objets connectés

8

2.1. Vulnérabilités des objets

connectés

8

2.1.1. Mots de passe faible,

prévisibles ou codés en dur

9

2.1.2. Services réseaux non

sécurisés

9

2.1.3. Interfaces de

l'écosystème non sécurisé

9

2.1.4. Absence de mécanisme de mise

à jour sécurisé

9

2.1.5. Utilisation de composant non

sécurisé ou obsolète

10

2.1.6. Insuffisance dans la protection de la

vie privée

10

2.1.7. Stockage ou transfert de

données sensible non sécurisé

11

2.1.8. Manque de gestion des appareils

11

2.1.9. Configuration par défaut non

sécurisé

11

2.1.10. Manque de protection physique

11

2.2. Attaques sur les objets

connectés

12

3. Quelques solutions de pare-feu des objets

connectés

15

3.1. IoT Sentinel

15

3.2. BPF

17

3.3. Filter.tlk

18

4. Contexte et intérêt du

projet

20

5. Problématique

23

6. Objectif du projet

25

CHAPITRE 2 : MÉTHODOLOGIE

26

Introduction

26

1. Définition de concepts

clés

26

1.1. Algorithme d'apprentissage profond

26

1.2. Empreinte digitale

30

2. Conception de la solution

32

2.1. Architecture de la solution

32

2.2. Les différentes

fonctionnalités

34

3. Outils utilisés

34

4. Conception des modèles

36

4.1. Conception des modèles

d'apprentissage profond

36

4.1.1. Acquisition du jeu de

données

37

4.1.2. Préparation et nettoyage des

données

41

4.1.3. Formation du modèle

d'apprentissage profond

48

4.2. Implémentation du modèle

de détection de trafic malveillant

51

Conclusion

52

CHAPITRE 3 : SIMULATIONS ET

INTERPRÉTATION DES RÉSULTATS

53

Introduction

53

1. Métriques d'évaluation des

modèles

53

2. Tests des modèles et

évaluation

55

2.1. Détection de trafic IoT

malveillant

55

2.2. Identification du type d'objet

59

3. Implémentation du modèle de

détection de trafic malveillant

61

4. Discussions

67

Conclusion

70

CONCLUSION ET PERSPECTIVES

71

ANNEXES 1

73

ANNEXES 2

77

ANNEXES 3

78

RÉFÉRENCES

79

LISTE DES TABLEAUX

Tableau 1 : Les outils utilisés pour

concevoir les modèles

2

Tableau 2 : Ensemble du jeu de donnée

obtenu grâce à des logiciels malveillants sur des objets

connectés

39

Tableau 3 : Ensemble du jeu de donnée du

trafic normal et bénin d'objets connectés

39

Tableau 4 : Attributs utilisés dans

notre jeu de donnée

43

Tableau 5 : Valeurs possibles du champ

conn_state

44

Tableau 6 : Valeurs possibles du champ

history

45

Tableau 7 : Comparaison entre les

résultats des modèles sur le jeu de test

58

Tableau 8 : Configuration des machines du

réseau

63

Tableau 9 : Comparaison des résultats

entre le modèle d'IoT Sentinel et notre modèle

68

LISTE DES FIGURES

Figure 1 : Les acteurs du réseau

d'objets managés

2

Figure 2 : les couches de l'architecture d'un

objet connecté [6]

5

Figure 3 : Liste non exhaustive des protocoles

de communications possibles pour un objet connecté

7

Figure 4 : le top 10

vulnérabilités des objets connectés selon l'OWASP

8

Figure 5 : les cyber-attaques d'une maison

intelligente [8]

12

Figure 6 : l'objet sert de relais de diffusion

d'une attaque.

14

Figure 7 : Design d'un système d'IoT

Sentinel [16]

16

Figure 8 : Architecture de filter.tlk [19]

19

Figure 9 : classement des pays du monde par

détection d'activité de botnet [22]

20

Figure 10 : Classement sur le continent

africain des activités de détection de botnet [22]

21

Figure 11 : Détection d'activité

de botnet au Cameroun du 12 janvier au 18 janvier [22]

21

Figure 12 : Détection d'intrusion au

Cameroun du 11 Janvier au 17 Janvier[22]

21

Figure 13 : Vue en temps réel d'une

infection du botnet Sality su MTN Cameroun [23]

22

Figure 14 : un réseau de neurone avec

trois couches

27

Figure 15 : Connexion des entrées d'une

couche précédente vers un neurone de la couche suivante

27

Figure 16 : Détail de fonctionnement du

réseau LSTM [26]

29

Figure 17 : Architecture du réseau

interne vers le réseau externe

32

Figure 18 : Architecture de la solution

33

Figure 19 : modèle d'apprentissage

profond pour prédire le trafic bénin ou malicieux

33

Figure 20 : Architecture du modèle

d'identification des objets grâce à l'apprentissage profond

33

Figure 21 : Appareil Amazon echo[32]

38

Figure 22 : Dispositif de verrouillage de porte

Somfy[32]

38

Figure 23 : liste des objets connectés

utilisés et de leurs technologies de communications correspondantes

[16]

41

Figure 24 : description des 23 attributs

utilisés pour former le modèle [16]

47

Figure 25 : Architecture réseau LSTM

49

Figure 26 : Architecture réseau MLP

50

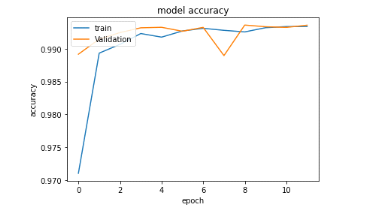

Figure 27 : Evolution de la précision de

l'algorithme LSTM lors de l'entraînement avec le jeu de validation et

d'entraînement lors du premier entrainement avec 04 couches de 128

neurones chacun

55

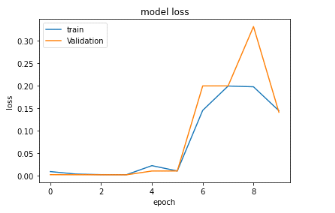

Figure 28 : Evolution de la perte de

l'algorithme LSTM lors de l'entraînement avec le jeu de validation et

celui d'entraînement lors du premier entraînement avec 04 couches

de 128 neurones chacun

56

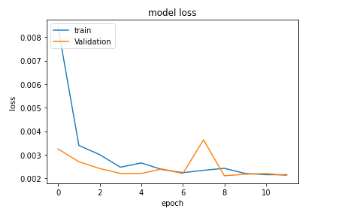

Figure 29 : Evolution de la précision de

l'algorithme LSTM lors de l'entraînement avec le jeu de validation et

d'entraînement lors du dernier entraînement avec 02 couches de 100

neurones chacun

56

Figure 30 : Evolution de la perte de

l'algorithme LSTM lors de l'entraînement avec le jeu de validation et

d'entraînement lors du dernier entraînement avec 02 couches de

10101 neurones chacun

57

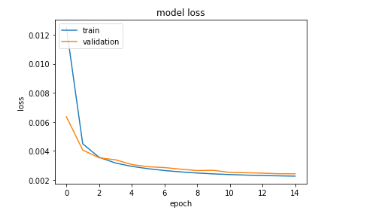

Figure 31 : Evolution de la perte de

l'algorithme lors de l'entraînement avec le jeu d'entrainement et celui

de validation

57

Figure 32 : Evolution de la précision de

l'algorithme lors de l'entraînement avec le jeu d'entraînement et

le jeu de validation

58

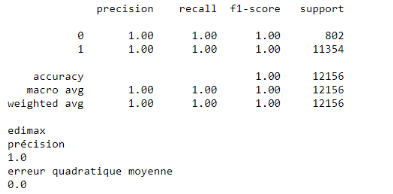

Figure 33 : Rapport de classification de

l'objet connecté Amazon echo

59

Figure 34 : Rapport de classification de

l'ampoule hue bridge

60

Figure 35 : Rapport de classification de la

serrure somfy

60

Figure 36 : Matrice de confusion entre x_test

et les prédictions

60

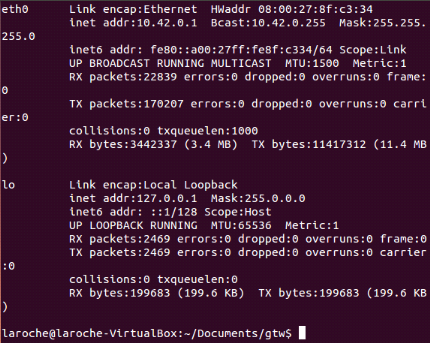

Figure 37 : Configuration des interfaces du

gateway

62

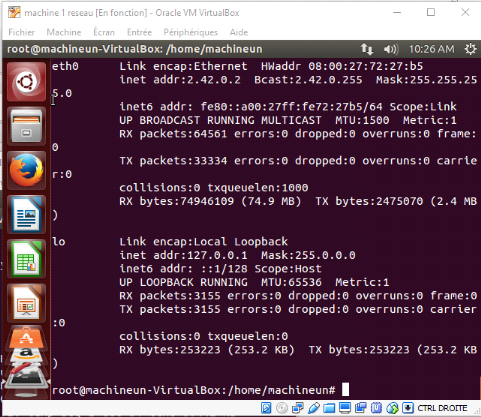

Figure 38 : Configuration des interfaces d'une

autre machine sur le réseau interne

62

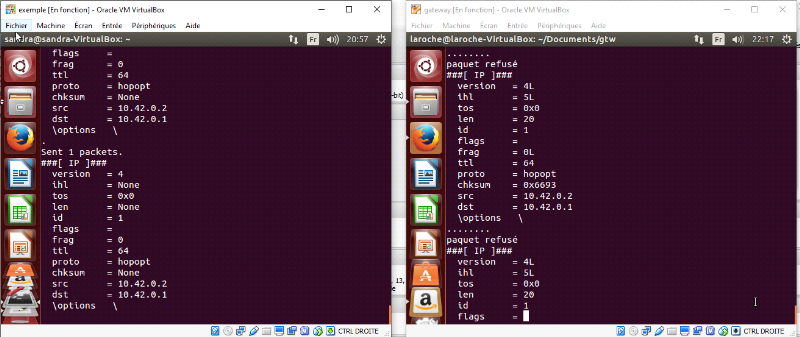

Figure 39 : envoie, réception et

détection des paquets malveillants

63

Figure 40 : Configuration IP des deux machines

de 2 réseaux différents

64

Figure 41 : Ping entre les 2 machines de 2

réseaux différents

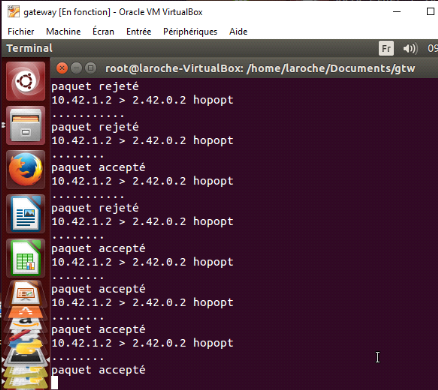

65

Figure 42 : Envoi et réception des

paquets de part et d'autre du réseau

65

Figure 43 : Filtrage du trafic

66

Figure 44 : la machine interne renifle les

paquets qu'elle reçoit

66

Figure 45 : Partie 1 résultat du

modèle d'identification des objets

77

Figure 46 : Partie 2 résultat du

modèle d'identification des objets

77

Figure 47 : Résultats des travaux d'IoT

Sentinel

78

LISTE

DES ABREVIATIONS

ARP: Address Resolution Protocol

API: Application Programming Interface

BTT: BPF testing tool

BDAT: BPF design aid tool

BPF: Berkeley Packet Filter

CSV: Comma-Separated Values

C&C: command-and-control

CVE: Common vulnerabilities and Exposures

DDoS: Distributed Denial of Service

DHCP: Dynamic Host Configuration

Protocol

DoS: Denial of Service

DNS: Domain Name System

FAI : Fournisseurs d'accès à

Internet

GSM: Global System for Mobile

Communications

GPRS: General Packet Radio Service

HTTP: HyperText Transfer Protocol

ICMP: Internet Control Message Protocol

IRC: Internet Relay Chat

IPTRB: IPTable rule builder

IP: Internet Protocol

IoT: Internet of Things

LED: light-emitting diode

LTE: Long Term evolution

LSTM: Long Short Term Memory

MLP: multilayer perceptron

MAC: Media Access Control

NF: NetFilter

NFC: Near Field Communication

NBIoT: Narrowband Internet of Things

OWASP: Open Web Application Security Project

OS: Operating System

PCAP: Packet Capture

PC: Personal Computer

SSH: Secure Shell

SSL: secure sockets layer

SD: Secure Digital

TCP: Transmission Control Protocol

UDP: User Datagram Protocol

USB: Universal Serial Bus

UMTS: Universal Mobile Telecommunications

System

6LOWPAN: IPV6 Low-power wireless Personal Area

Network

INTRODUCTION GENERALE

Tous les objets de notre quotidien peuvent devenir

connectés et rendre notre vie plus confortable. Des caméras

intelligentes, des écouteurs sans fil, des télévisions ou

encore des montres connectées. En fait, il suffit d'ajouter un capteur

à un objet et le faire communiquer avec un réseau pour

transmettre et recevoir des données pour en faire un objet

connecté. Les objets connectés représentent une

opportunité immense pour de nombreuses entreprises.

Toutefois, la sécurité des objets

connectés à travers le monde inquiète de plus en

plus. Non seulement on compte environ 26.6 milliards d'appareils

connectés (On compte aussi les téléphones tablettes, etc)

en 2019 [1] mais leur chiffre continue exponentiellement d'augmenter. On ne

cesse de lire dans la presse et les divers sites et blogs liés à

la cyber sécurité tel que celui d'Olivier Ezratty les nombreuses

vulnérabilités dont elle souffre. Dans un des articles de son

site intitulé « peut-on sécuriser l'internet des

objets» [2], il présente les fragilités connues des

objets connectés et leur sécurisation. Nous nous rendons compte

que presque tout est « piratable » si ce n'est tout, que ce

soit des voitures, des caméras, des thermostats, des grille-pain etc.

Tout ceci à partir d'applications facilement trouvables sur internet et

téléchargeables sur son téléphone androïde.

D'ailleurs Kaspersky, l'éditeur de logiciels antivirus avait

déjà estimé en 2019 le nombre de piratages à 105

millions au premier semestre alors qu'il ne s'élevait qu'à 12

millions sur la même période en 2018 - soit neuf fois plus [3].

Parmi tous les domaines d'applications de l'internet des

objets tels que la santé, l'agriculture, les finances, c'est la

domotique qui va nous intéresser. Ceci simplement à cause du fait

que les objets connectés utilisés au sein d'un réseau

domotique sont des proies faciles et parfaites pour des attaquants. Les pirates

utilisent des « maliciels » (logiciels malveillants) pour

infecter ces objets connectés en exploitant des failles connues car peu

de fabricants de ces objets pensent à la sécurité de leurs

objets dès leur conception. Les attaquants les organisent ensuite en

« botnets » (réseau d'automates informatiques

souvent destinés à des usages malveillants) prompts à

déferler sur une cible, bien souvent des serveurs.

De plus, les caractéristiques de ces objets sont

très inférieures à celles d'un équipement de bureau

ce qui rend leur gestion difficile, sans parler de leur nombre et du fait que

certains sont mobiles ou facilement transportables (hors du réseau

domotique). Tout ceci révèle plusieurs difficultés pour

sécuriser les objets connectés : il est difficile

d'être informés d'une attaque en cours, un objet peut être

piraté hors du réseau et s'y reconnecter ensuite, il est

difficile d'avoir une vue des appareils connectés à un certain

temps dans un réseau, il est presque impossible de mettre des agents de

surveillance local sur chaque objet, en bref il est difficile de superviser la

sécurité d'un réseau d'objet connectés.

Cela inquiète et emmène donc à se poser

des questions sur la fiabilité des objets connectés d'une part

pour la confidentialité des données des utilisateurs de ces

objets et d'autre part sur la façon dont les hackers utilisent les

objets dont ils prennent le contrôle.

Nous voulons sécuriser les appareils d'un réseau

domotique au niveau de la passerelle. Un réseau domotique peut

être installé au sein d'une maison comme au sein d'une entreprise.

La domotique est l'ensemble des techniques permettant de centraliser le

contrôle des différents systèmes de la maison et/ou de

l'entreprise. Le plus important est que nous ne concentrons sur la passerelle

qui est l'élément central avec lequel les objets communiquent.

Nous voulons d'une part connaitre quels sont les objets connectés au

réseau et d'autre part bloquer les attaques avant même qu'elles

n'arrivent sur les objets car ceux-ci n'ont presque pas de mécanismes de

défense.

Nous proposons une passerelle qui s'occupe du trafic IoT et de

filtrer les paquets malveillants. Une passerelle permettrait non seulement de

protéger les objets connectés d'attaques auxquels elles sont le

plus exposées mais qui permettrait aussi d'avoir une vue globale des

objets du réseau. Ce travail vise à protéger les appareils

à l'intérieur du réseau interne d'attaques externes.

Notre travail sera présenté en 3

chapitres :

- Chapitre 1 : Nous présenterons ce que c'est

qu'un réseau d'objet connecté, les éléments qui le

composent, les éléments de son environnement, la façon

dont il communique dans le réseau, ses vulnérabilités, les

attaques fréquentes dont il fait face mais aussi des projets

existant.

- Chapitre 2 : Nous parlerons de la méthodologie

c'est-à-dire pour présenter les concepts clés qui nous

ont aidé à proposer une solution, de la façon dont nous

pensons pouvoir protéger le réseau interne et de la conception

des modèles proposés pour nous aidés dans notre

approche.

- Chapitre 3 : Nous présenterons les

résultats obtenus durant l'entraînement et les tests des

modèles suggérés tout en ayant précédemment

expliqués les métriques d'évaluation que nous utiliserons

et l'implémentation du code servant à vérifier le filtrage

sans création de règles de filtrage.

CHAPITRE 1 : ETAT DE

L'ART, CONTEXTE ET PROBLÉMATIQUE

Introduction

Les objets connectés sont un domaine d'étude

très vaste. Il serait facile d'essayer de les limiter à de

simples capteurs capables de communiquer avec une passerelle mais en fait c'est

bien complexe que ça. Leurs composants diffèrent d'un

constructeur à l'autre. Pour mieux cerner le cadre de notre projet, ce

chapitre sera consacré aux réseaux d'objets connectés, ce

qui les caractérisent, les failles et les attaques dont ils sont

victimes, les travaux qui se sont penchés sur les problèmes de

sécurité et présenter notre approche pour une solution.

1. Caractéristiques d'un

réseau d'objet connecté

1.1. Acteurs d'un réseau d'objet connecté

D'après l'article de Pallavi Sethi et Smruti R. Sarangi

qui passe en revue l'internet des objets [4], les objets connectés sont

généralement de petit équipements dotés de

processeurs, de mémoire vive, de stockage de masse et d'interfaces

d'entrées/sorties. Ils ont ajouté que d'un point de vue

logiciel, ces équipements embarquent un système d'exploitation,

plus généralement connu sous le nom de «firmware».

Cependant, afin d'optimiser les coûts par rapport à un ordinateur,

le fabricant intègre généralement «juste ce qu'il

faut» afin d'implémenter les fonctionnalités

nécessaires. Ce qui implique d'après eux des puissances de calcul

réduites, des espaces de stockage limités, des interfaces

d'entrées/sorties correspondant aux fonctionnalités de

l'équipement ainsi qu'un système d'exploitation limité aux

fonctionnalités prévues par le fabricant.

Mahmoud Elkhodr, Seyed Shahrestani et Hon Cheung proposent

dans un article une plateforme pour la gestion des objets [5] dans laquelle ils

ont détaillé les caractéristiques d'un objet

connecté et son environnement.

Un objet connecté possède plusieurs attributs

tels que son identifiant, sa localisation, son nom, les données utiles,

etc. Ce sont des données que nous pouvons exploités pour

identifier ces objets.On distingue principalement deux types

d'attributs :

? Attributs de gestion : Ils permettent

de représenter l'objet virtuellement grâce au nom, à l'Id,

le numéro de série, l'adresse Mac, son adresse IP, la version du

firmware, sa localisation si elle fixe, etc. Ces attributs permettent de

décrire l'objet.

? Attributs comportementaux : Ils

représentent les données récupérer par l'objet

comme le son, la température, la pression, la localisation, les

déplacements, détection d'eau ou de feu, etc.

Sur un objet connecté peut être installé

une application «agent » responsable :

? D'établir la communication avec le manageur

? Envoyer des données mises à jour au

manageur

? Récupérer les instructions du manageur et

s'assurer que l'objet les exécute

? Envoyer des notifications au manageur

? Manipuler les requêtes et les réponses

correspondantes depuis ou vers le manageur

Lorsqu'un objet possède un agent, on parle d'objet

managé.

L'objet ne dispose pas des capacités physiques et

logiciels nécessaires pour traiter les informations qu'il récolte

lui-même. Pour ce faire, il aura donc besoin d'un manageur ou d'une

passerelle. La passerelle reçoit et stocke les données qu'il a

reçues de l'objet dans une base de données.

Figure 1 : Les

acteurs du réseau d'objets managés

La figure ci-dessus nous montre que

l'objet connecté constitué d'un agent et de l'objet

lui-même communique avec internet soit à travers une passerelle

appelé ici manageur sur laquelle est téléchargé

une API responsable de la gestion des objets du réseau ou encore les

objets managés communiquent directement vers le Cloud qui possède

la base de donnée et peut être le serveur de l'application afin

que les objets puissent récupérer les résultats des

calculs qu'ils ne peuvent pas faire eux-mêmes et envoyer des

données aux applications qui les gèrent.

Un manageur possède un module d'enregistrement

des objets responsable d'enregistrer les objets dans le

réseau. Un objet rejoint le réseau et devient un objet

managé en se connectant au manageur grâce à son agent. Il

y'a 03 méthodes d'enregistrement d'un objet :

i) Rejoindre directement le

réseau : Dans ce cas l'objet est

préprogrammé avec l'adresse IP du manageur. Cela permet à

l'objet d'envoyer une requête « DIRECT-JOIN ».

ii) Enregistrement via l'association :

l'objet doit faire une requête, optionnellement s'authentifier

auprès du manageur, envoyé une requête d'association et

lorsque celui-ci est approuvé la connexion est établie

iii) Reconnexion au réseau :

l'objet a perdu sa connexion avec le manageur et essaye de se reconnecter.

Cela arrive lorsque l'objet sort de la zone de couverture du manageur ou

lorsque celui-ci pour une raison ou une autre est indisponible. Il utilise

l'une des deux méthodes précédentes à l'exception

que lui n'a pas besoin qu'on l'enregistre une nouvelle fois dans la base de

données ou alors il y aura une mise à jour !

Pour notre projet, connaître les différents

acteurs d'un réseau d'objets connectés et leur

caractéristique physique est important. Un objet connecté est

très simple et restreint en termes de capacité, nous n'allons

donc pas y installer de logiciel mais plutôt surveiller ses

communications avec le manageur. Il n'y aura pas de fonctionnalité en

plus à ajouter à l'agent responsable de l'objet et pas de module

supplémentaire au manageur. Le manageur lui par contre possède

les ressources physiques et logicielles intéressantes pour

installé nos modèles d'apprentissage profond.

1.2. Architecture d'un objet connecté

Il existe plusieurs architectures pour les objets

connectés mais nous allons nous intéresser ici à une

seule architecture à 03 niveaux développés par Pallavi

Sethi et Smruti R. Sarangi [6] dont la figure

ci-dessous est extraite de leur travail:

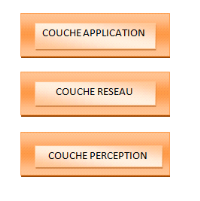

Figure 2 : les couches de l'architecture d'un objet

connecté [6]

i. Couche perception : Elle correspond

à la couche physique. Elle correspond aux capteurs qui collectent les

informations de leur environnement ou identifient d'autres objets intelligents

dans leur environnement. Cette couche comprend ainsi le matériel

nécessaire pour parvenir à la collection de données

contextuelles des objets connectés, à savoir les capteurs, les

étiquettes RFID, caméras, GPS (Global Positioning System) qui

peuvent aussi nous permettre de les identifier.

ii. Couche réseau : Elle est

responsable de la connexion avec les autres objets connectés, les autres

équipements réseaux et les serveurs. Elle est aussi responsable

de transmettre et traiter les données issues des capteurs. Lorsque les

capacités de l'objet ne le permettent pas, ces données sont

envoyées et traitées dans le Cloud.

iii. Couche application : Elle est

responsable de fournir des services applicatifs spécifiques aux

utilisateurs. Il définit les applications variées qu'un objet

connecté est capable de fournir dans différents domaines comme la

domotique, la santé, les villes intelligentes, etc.

Il est tout à fait possible de retrouver des

architectures à 05 ou 04 couches. Par exemple, nous pourrions ajouter la

couche middleware qui sert pour une interface entre la couche

matérielle et les applications. Elle permet la dissimulation de la

complexité des mécanismes de fonctionnement du réseau et

rend plus facile le développement des applications par les concepteurs.

Cette architecture très simple nous a simplifié

la tâche dans notre projet car au final pour nous il existait juste trois

grands objectifs pour un réseau d'objets connectés :

collectés des informations, les transmettre, recevoir des ordres et

fournir des applications.

1.3. Protocoles de communication des objets

connectés

Dans le domaine des réseaux sans-fil et filaire, un

protocole de communication définit les règles et les

procédures de communication des couches physiques et de liaison du

modèle OSI sur un support/canal physique. Il permet ainsi de

connecter un objet à un réseau filaire ou sans-fil. En outre, si

ce réseau comporte une passerelle, c'est-à-dire un appareil

connecté à la fois au réseau et à Internet, alors

cet objet peut transmettre et recevoir des données depuis Internet.

Pour pouvoir choisir quel protocole de communication est

adapté à notre situation, il faut prendre en compte plusieurs

critère tels que :

? Topologie : elle peut être

maillé (un noeud est connecté à un ou plusieurs noeuds du

réseau), en étoile (les objets sont connectés à un

concentrateur ou un routeur), en cellule (Il y'a des zones appelés

cellules et dans chaque cellule, une antenne assure la liaison radio entre les

objets et internet), à diffusion(les messages sont transmis sans que le

ou les destinataire(s) ne soit précisé. Le message sera

analysé par tous les objets du réseau).

? Portée : la distance maximale

à laquelle un récepteur est capable de décoder le signal.

Elle peut être courte (une centaine de mètres au plus), moyenne

(au plus quelques kilomètres), longue (On parle de dizaines de

kilomètres). La portée d'un signal dépend à la fois

de la valeur de la puissance maximale d'émission prévue par le

protocole et le milieu physique.

? Débit :

Le débit est principalement limité par la

modulation du signal et la largeur de la bande

de fréquences : plus celle-ci est large et plus le

débit est important. Bas débit : jusqu'à plusieurs

dizaines de bit/s. Moyen débit : jusqu'à plusieurs centaines de

Kbit/s. Haut débit : Plusieurs centaines de Kbit/s et jusqu'à

plusieurs dizaines de Mbit/s. Très haut débit: Plusieurs

centaines de Mbit/s voire plusieurs Gbit/s.

? Synchrone/Asynchrone : On parle de

synchronisation au niveau de la couche de liaison lorsqu'un objet

est à l'écoute continue ou périodique

des trames émises par la passerelle. En outre, l'objet est

susceptible de répondre à certaines trames pour notifier de sa

présence et fournir une indication sur la qualité du signal

en réception. Il s'agit du principe de Keep Alive.

Il existe des dizaines de protocoles de communication.

Figure 3 :

Liste non exhaustive des protocoles de communications possibles pour un objet

connecté

On distingue les protocoles de

communication cellulaire tels que le GSM/GPRS/3G/4G/LTE-M, d'autres

protocoles à longues portées tels que Sigfox, LoraWAN et

NBIoT et des protocoles à courte porté comme le

Wifi, ZigBee, Z-wave, NFC, Bluetooth Low Energy, Lifi et 6LowPAN

(IPv6 Low-power wireless Personal Area Network). Un tableau avec des

détails est donné en annexe.

Il existe tellement de protocoles que nous avons

décidé de concevoir une solution sans prendre en compte les

détails de chaque protocole. Plusieurs protocoles de communications ont

été utilisés pour la collecte des données. Nous ne

dépendons pas d'un protocole en particulier.

Ensuite pour la topologie, elle serait plutôt en

étoile puisque les objets sont connectés à la passerelle.

La portée n'est pas très grande dans une maison de quelques

dizaines de mètres, ce qui permet à des protocoles simples comme

le wifi ou le Bluetooth d'être facilement utilisés. Le

débit n'a pas non plus été déterminant pendant

notre travail.

2. Problèmes de

sécurités rencontrés sur les objets connectés

2.1. Vulnérabilités des objets

connectés

Pour pouvoir exposer plus facilement les

vulnérabilités des objets connectés, nous avons

adopté le rapport OWASP. Le projet OWASP [7] internet des objets explore

et publie les risques de sécurité liés à l'Internet

des objets, afin d'aider les développeurs, les fabricants et les

consommateurs à mieux les comprendre pour améliorer la

conception de leurs applications pour objets connectés.

Figure 4 : le

top 10 vulnérabilités des objets connectés selon

l'OWASP

2.1.1. Mots de passe faible,

prévisibles ou codés en dur

|

La plupart des objets, surtout ceux qui possèdent des

interfaces web ne sont pas configurés pour permettre aux utilisateurs de

changer facilement les mots de passe par défaut ou pire ce genre de

modification est impossible. Ce qui rend ces objets vulnérables aux

attaques qui se basent sur cette faiblesse. Leur système d'autorisation

est donc faillible.

De plus ces informations d'identifications peuvent être

facilement forcés, sont parfois accessibles via des sites de hackers,

le dark web ou juste des sites de développeurs.

2.1.2. Services réseaux non

sécurisés

L'attaquant utilise des services réseau

vulnérables tels que Telnet ou HTTP pour attaquer l'appareil

lui-même ou faire rebondir les attaques sur l'appareil.

Les services réseau non sécurisé peuvent

être sujets à des attaques par débordement de tampon ou

à des attaques qui créent une condition de déni de service

laissant le périphérique inaccessible à l'utilisateur. Les

attaques par déni de service contre d'autres utilisateurs peuvent

également être facilitées lorsque les services

réseau non sécurisés sont disponibles. Les services

réseau non sécurisés peuvent être

détectés par des outils automatisés tel qu'un scanner de

ports.

Les services réseau non sécurisés

peuvent entraîner la perte ou la corruption de données, le

déni de service ou la facilitation d'attaque sur d'autres appareils.

2.1.3. Interfaces de

l'écosystème non sécurisé

Les interfaces comme le web, le cloud, le mobile ou des API

qui permettent à l'utilisateur d'interagir avec des équipements

intelligent peuvent avoir des vulnérabilités dans

l'implémentation de l'authentification/l'autorisation ou une absence

totale de ceux-ci, des faiblesses dans le chiffrement des données

(faible ou absent), le filtrage des données, etc.

Les interfaces non sécurisées peuvent conduire

à une prise de contrôle complète de l'appareil.

2.1.4. Absence de mécanisme de mise

à jour sécurisé

Certains objets connectés n'offrent pas de mise

à jour sécurisée. Les mises à jour proposent

souvent des réparations de bugs et des nouvelles fonctionnalités,

mais leur intérêt principal réside dans la correction de

failles de sécurité Ces mises à jour doivent être

proposées par les fabricants des objets. Il y'a un véritable

manque de capacité à mettre à jour l'appareil en toute

sécurité. Cela inclut :

? Manque de validation du firmware sur

l'appareil : La validation d'un micrologiciel est une exigence

de qualité afin d'ajouter de la crédibilité aux

performances de celui-ci. Elle est réalisée par des tiers

indépendants qui s'appuient sur les caractéristiques du logiciel.

? Absence de livraison sécurisée (non

chiffrée en transit) : La transmission et le

téléchargement des mises à jour doit être

chiffrée.

? Absence de mécanismes anti-retour en

arrière ou anti-rollback : Le mécanisme de retour

en arrière permet d'annuler les dernières mises à jour.

Mais ce mécanisme permet aussi à des personnes malveillantes

d'installer des versions antérieures de firmware qui contiennent des

failles ultérieures. Il est donc important d'installer d'autres

mécanismes qui bloquent le retour en arrière du micro

logiciel.

? Absence de notifications de modifications de

sécurité en raison de mises à jour : Les

notifications de modifications de sécurité permettent d'afficher

des informations critiques sur la santé et

la sécurité d'un appareil à l'utilisateur.

Notifier ou informer sur les changements de sécurité dus aux

mises à jour est donc un mécanisme de mise à jour

sécurisé surtout lorsqu'elles doivent être faites

manuellement avec l'utilisateur de l'appareil.

2.1.5. Utilisation de composant non

sécurisé ou obsolète

On parle de l'utilisation de composants / bibliothèques

logiciels obsolètes ou non sécurisés qui pourraient

permettre à l'appareil d'être compromis. Cela inclut la

personnalisation non sécurisée des plates-formes du

système d'exploitation et l'utilisation de logiciels ou de composants

matériels tiers issus d'une chaîne d'approvisionnement

compromise.

2.1.6. Insuffisance dans la protection de

la vie privée

Il s'agit ici du stockage non sécurisé de

données personnelles, de leur traitement ou de leur utilisation sans la

permission de l'utilisateur. Les informations personnelles de l'utilisateur

stockées sur l'appareil ou dans l'écosystème qui sont

utilisées de manière non sécurisée, de

manière inappropriée ou sans autorisation.

Les données personnelles d'un utilisateur peuvent

être utilisées de plusieurs manières, que ce soit pour les

espionner, voler leur identités, les vendre, etc.

C'est un problème de confidentialité des

données.

2.1.7. Stockage ou transfert de

données sensible non sécurisé

Les données stockées, transférées,

traitées doivent être chiffrées. Si le chiffrement n'est

pas strictement implémenté, les données sont

vulnérables et deviennent un problème de sécurité

majeur.

Un attaquant peut récupérer et visualiser les

données transmises sur le réseau si celles-ci ne sont pas

chiffrées. Le manque de cryptage lors du transport des données

est répandu sur les réseaux locaux car il est facile de supposer

que le trafic du réseau local ne sera pas largement visible, cependant

dans le cas d'un réseau sans fil local, une mauvaise configuration de ce

réseau sans fil peut rendre le trafic visible à toute personne

à portée de celui-ci.

2.1.8. Manque de gestion des appareils

Il est très important de connaître des

équipements qui constituent le réseau mais également de

gérer ceux-ci de manière efficiente.

Il faut une prise en charge de la sécurité sur

les appareils déployés en production, y compris la gestion des

actifs, la gestion des mises à jour, sécurité mise hors

service, surveillance des systèmes et intervention.

Manager un objet qui a accès au réseau est d'une

importance primordial. Un objet mal géré est une

vulnérabilité pour le réseau entier.

2.1.9.

Configuration par défaut non sécurisé

Les configurations et les autorisations par défaut du

système de fichiers peuvent être non sécurisées.

Cela peut être de la négligence de la part de l'utilisateur qui ne

change pas la configuration par défaut de l'objet et d'autre fois, ce

n'est juste pas possible d'altérer les configurations du système

comme les mots de passe codés en dur ou encore des services

exposés qui fonctionnent avec des privilèges

d'administrateurs.

Les appareils ou systèmes peuvent être

livrés avec des paramètres par défaut non

sécurisés ou n'ont pas la capacité de rendre le

système plus sûr en empêchant les opérateurs de

modifier les configurations.

2.1.10. Manque de protection physique

Les attaques physiques visent à rendre l'objet

indisponible, à extraire des données sensibles pour de futures

attaques ou tout simplement prendre le contrôle de l'objet.

L'attaquant utilise des vecteurs tels que des ports USB, des

cartes SD ou d'autres moyens de stockage pour accéder au système

d'exploitation et potentiellement à toutes les données

stockées sur l'appareil, des informations privées ou des mots de

passe. L'attaquant peut aussi utiliser des fonctionnalités

destinées à la configuration ou à la maintenance.

Notre projet ne vise pas à résoudre tous ces

problèmes mais plutôt protéger les objets d'attaques qui

utilisent ces failles.

2.2. Attaques sur les objets connectés

Les objets connectés peuvent être la cible de

plusieurs attaques différentes. Toutefois nous nous sommes

concentrés ici sur les attaques majeures sur les réseaux

domotiques. Le réseau étant privé, les attaques visent

à prendre le contrôle des objets appartenant à ce

réseau ou à voler des informations.

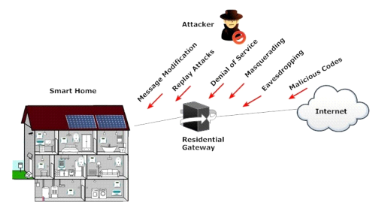

Figure 5 : les cyber-attaques

d'une maison intelligente [8]

Les principales menaces des

réseaux de maison intelligentes d'après le travail sur les

maisons intelligentes et les menaces auxquels ils font face de Shafiq Ul

Rehman et Selvakumar Manickam [8] représenté sur la

figure 5 sont :

? Écoute clandestine: Un

attaquant peut surveiller le trafic de données entrant et sortant des

réseaux domestiques intelligents sans en informer les utilisateurs

autorisés. L'écoute électronique est la menace de

sécurité reconnue la plus courante dans les systèmes

ouverts et est une attaque contre la confidentialité des environnements

de maison intelligente.

? Masquerading : Un attaquant peut

récupérer certains avantages non autorisés en devenant un

autre utilisateur légal. L'attaquant peut imiter un utilisateur

domestique non autorisé et accéder à distance au

système de réseau interne de la maison intelligente en gardant

à l'esprit que l'objectif final est d'obtenir des données

secrètes ou d'acquérir des services. Cette attaque est

fréquemment effectuée avec d'autres attaques, par exemple, une

attaque de relecture.

? Replay attack : Lors d'une attaque par

relecture, un intrus reçoit d'abord les messages qui sont

échangés entre deux parties légales et les retransmet plus

tard en tant qu'élément autorisé. L'attaquant peut

capturer une copie d'une demande de service légitime envoyée

à partir d'un appareil du réseau domestique intelligent et la

stocker. Ensuite, rejouer pour obtenir le service pour lequel l'utilisateur

à domicile a accès.

? Modification des messages : La

modification du message peut se produire lorsqu'un intrus vise à

détourner la communication entre deux parties légitimes, une

certaine modification du logiciel dans l'intention qu'il exécute de

manière malveillante ou modifie les valeurs d'une information. Ce type

d'attaque s'applique à l'intégrité des données.

? Dénis de service : L'attaque

par déni de service est utilisée dans le cadre des cas où

un intrus vise à rendre un réseau indisponible pour les

utilisateurs légitimes ou à réduire l'accessibilité

du service réseau. L'attaquant peut envoyer une énorme

quantité de messages sans fin au système de réseau

domestique intelligent afin de surcharger ses services. De cette

manière, les utilisateurs légitimes ne sont pas en mesure

d'obtenir le service du réseau domestique.

? Codes malveillants : Les codes

malveillants sont des menaces programmées par logiciel qui causent des

problèmes aux systèmes de réseau interne de la maison

intelligente exploitant ses vulnérabilités. Des codes

malveillants sont appliqués pour modifier, démolir ou obtenir des

informations et en plus pour permettre un accès non autorisé.

Pour mieux comprendre en quoi ces menaces sont dangereuses,

nous pouvons donner quelques exemples d'attaques concrets sur les objets

connectés qui utilisent plusieurs de ces failles ou plusieurs de ces

menaces et qui ont déjà causés beaucoup de

dégâts :

- Mirai : C'est un logiciel

malveillant qui transforme des ordinateurs exécutant des versions

obsolètes du noyau Linux et avec des mots de passe faible par

défaut en bots contrôlés à distance,

formant alors une armée de botnets utilisé notamment

pour réaliser des attaques à grande échelle sur les

réseaux. Une attaque en déni de service distribué

(DDoS) le 20 septembre 2016 sur le site de sécurité

informatique du journaliste Brian Krebs, une attaque sur

l'hébergeur français OVH et la cyber attaque

d'octobre 2016 contre la société Dyn (fournisseur de

système de noms de domaine) [9]. Nous pouvons aussi citer le malware

NyaDrop très similaire à celui de Mirai qui d'ailleurs a

été amélioré quelque temps après celui-ci.

- BASHLITE (également connu sous

le nom

de Gafgyt , Lizkebab , Qbot , Torlus et LizardStresser ) :

C'est un malware qui infecte

les systèmes Linux afin de lancer des attaques par

déni de service distribuées (DDoS). Il a

été utilisé pour lancer des attaques jusqu'à

400 Gbps. En 2016, il a été signalé qu'un million

d'appareils ont été infectés. Il se propage en utilisant

un dictionnaire intégré de noms d'utilisateur et de mots de passe

courants. Le logiciel malveillant se connecte à des adresses IP

aléatoires et tente de se connecter [10].

- Brickerbot : était

un logiciel malveillant qui tentait de détruire de

façon permanente les appareils non sécurisés de

l'Internet des objets. BrickerBot s'est connecté à des

appareils mal sécurisés et a exécuté des commandes

nuisibles pour les désactiver. Il a été

découvert pour la première fois par Radware (une entreprise

israélienne qui fournit des solutions de

cybersécurité) après avoir attaqué leur pot de

miel en avril 2017. Le 10 décembre 2017, BrickerBot a été

retiré. Selon Janit0r, l'auteur de BrickerBot, il a détruit plus

de dix millions d'appareils avant que celui-ci n'annonce le retrait de

BrickerBot le 10 décembre 2017 [11].

- Muhstik : Le botnet Muhstik existe

depuis mars 2018 et a une capacité d'auto-propagation de type ver pour

infecter les serveurs Linux et les appareils connectés. Muhstik a

utilisé plusieurs exploits de vulnérabilité pour infecter

différents services Linux, notamment WebLogic, WordPress et Drupal[12].

Le 28 avril 2019, une nouvelle variante du botnet Linux Muhstik a

été découverte qui exploite la dernière

vulnérabilité de serveur WebLogic pour s'installer sur des

systèmes vulnérables [13].

- Cache-cache ou Hide and Seek

: Découvert par le système de pots de miel de

BitDefender (entreprise qui fournit des solutions de

cybersécurité). Il a rassemblé plus de 90 000

appareils dans un vaste botnet en quelques jours [14]. Le malware

se propage via des informations d'identification SSH / Telnet à force

brute, ainsi que par d'anciens CVE. Il n'y a pas de serveur de commande et

de contrôle; à la place, il reçoit des mises à

jour à l'aide d'un réseau peer-to-peer personnalisé

créé à partir de périphériques

infectés [15].

La plupart de ces attaques utilisent des failles comme les

mots de passe simples, des configurations par défaut ou des services

réseaux non protégés ou mal protégés pour

infecter ces appareils.

Figure 6 : l'objet sert de

relais de diffusion d'une attaque.

Avec la figure ci-dessous, nous avons

voulu montrer que la prise de contrôle des appareils d'une maison peut

être une étape intermédiaire avant la véritable

cible. Il s'agit pour l'attaquant de prendre le contrôle du plus d'objets

connectés possible pour en faire des botnets et effectuer des attaques

sans que les utilisateurs de ces objets ne s'en rendent compte.

Avec les attaques énoncées plus haut, on peut se

rendre compte que les logiciels malveillants les plus répandues

destinées aux objets connectés les utilisent pour mener des

attaques de déni de services distribués de plus grande envergure

contre de gros sites ou de gros serveurs en ligne. Même s'il est tout

à fait possible pour un pirate informatique de se propager dans le

réseau domotique de sa victime et de lui voler des informations

personnelles ou juste de prendre le contrôle des autres objets

connectés du réseau. La cible finale n'est pas souvent l'appareil

connecté lui-même ou celui qui l'utilise à moins qu'il

s'agisse d'une attaque personnelle.

3. Quelques solutions de pare-feu des

objets connectés

3.1. IoT Sentinel

IoT Sentinel [16] est un système capable d'identifier

les types d'appareils connectés à un réseau et de

renforcer les mesures de sécurité pour chaque type d'appareil qui

possède des vulnérabilités de sécurité

potentielles. IoT Sentinel est basé sur la surveillance du comportement

de communication des appareils pendant le processus de configuration pour

générer des empreintes digitales spécifiques aux appareils

qui sont mappées aux types d'appareils à l'aide d'un

modèle de classification basé sur l'apprentissage automatique.

IoT Sentinel vise les réseaux domestiques et les

petits bureaux dans lesquels les objets sont connectés via une

passerelle qui offre des interfaces sans fil et filaire pour connecter des

appareils IP.

L'objectif d'IoT Sentinel est de restreindre la communication

avec le réseau local afin d'empêcher qu'un hacker se connecte

à un objet vulnérable afin d'exploiter ses faiblesses et pour

attaquer d'autres objets.

Afin d'arriver à ses objectif, IoT Sentinel :

? Identifie les caractéristiques d'un nouvel objet

connecté au réseau

? Répertorie les vulnérabilités de

l'objet grâce à ses caractéristiques

? Réduit la communication d'un objet nouvellement

connecté et/ou vulnérable

Pour chaque objet, ses vulnérabilités

potentielles peuvent être recensées en consultant de sources

extérieures. Le Common Vulnerabilities and

Exposures ou CVE est un

dictionnaire des informations publiques relatives aux

vulnérabilités de sécurité. Le dictionnaire est

maintenu par l'organisme MITRE, soutenu par le département de

la Sécurité intérieure des États-Unis [17]. En se

basant sur les vulnérabilités des objets qu'il identifie, IoT

Sentinel protège son réseau en limitant la communication de

l'objet vulnérable correspondant.

Figure 7 : Design d'un

système d'IoT Sentinel [16]

La figure ci-dessus tirée de

l'article [16] nous présente le design du système d'IoT

sentinel.

Elle nous montre clairement qu'IoT Sentinel a deux composants

majeurs :

- Passerelle de sécurité :

Sur la figure elle est en bleu et est constitué d'interfaces de

connexion sans fil et avec fil, des modules de création d'empreintes

digitale, de gestion des appareils Il agit comme un routeur de passerelle d'une

maison ou d'un petit bureau. Dans ce projet, les auteurs envisagent que la

passerelle de sécurité pourrait être déployé

en tant qu'équipement dédié, ou comme un module dans un

logiciel ou encore en tant que mise à jour dans un

« firmware » dans les points d'accès wifi qui ont

des ressources suffisantes. Cette passerelle gère et dresse un profil

de chaque objet du réseau et envoie ces informations appelées

empreintes digitales de l'objet au service de sécurité de l'IoT

pour une identification et une estimation des vulnérabilités de

chaque type d'objet du réseau. Basé sur les

vulnérabilités recueillies, le service de sécurité

de l'IoT retournera un niveau d'isolation que devra appliquer la passerelle de

sécurité sur l'objet.

- Service de sécurité des

objets connectés: Sous forme de nuage nommé IoT

Security Service sur la figure. Il est basé sur les empreintes digitales

de l'appareil fournies par la passerelle de sécurité, le

fournisseur de service de sécurité de l'IoT

(IoTSSP) utilise l'apprentissage par machine basé sur

des modèles de classification pour distinguer les objets suivant leurs

caractéristiques. C'est ainsi qu'on crée des profils pour chaque

objet. Pour chaque type d'objet dans les données d'entraînement,

l'IoTSSP effectue un recensement des vulnérabilités basé

sur l'interrogation des référentiels de la base de données

CVE pour les rapports de vulnérabilité liés au type de

périphérique. Lorsqu'une faille est

détectée, un niveau d'isolation est assigné nommé

«restricted ». Sinon on assigne un niveau appelé

« trusted ». Les objets inconnus se verront assigné

le niveau « strict ». Le fournisseur IoTSSP notifie

à la passerelle de sécurité le niveau d'isolation

assignée.

Pour gérer la vulnérabilité des objets,

il est possible de suivre plusieurs stratégies afin de minimiser le

risque :

- Isolation réseau : Il s'agit de

bloquer la communication d'un objet potentiellement corrompu avec d'autres

objets du réseau pour empêcher de possibles attaques. Dans ce cas,

la passerelle divise le réseau en deux sous réseaux

distincts : le réseau « trusted » et le

réseau « untrusted » où sont placés

les objets vulnérable ou corrompu qui sont strictement isolé des

autres objets.

- Filtrage de trafic : le but est

d'empêcher des personnes externes au réseau de communiquer avec

des objets vulnérables du réseau et exploiter leurs faiblesses ou

voler des données.

- Notifications à l'utilisateur : Dans

certains cas l'isolation du réseau et le filtrage du trafic ne sont pas

suffisants pour apporter une protection adéquate. Par exemple, si un

objet vulnérable est équipé d'une connexion cellulaire qui

ne peut pas être contrôlée par la passerelle de

sécurité, un autre objet compromis pourrait utiliser cette chaine

pour voler des données sensibles. La seule mesure efficace pour

sécuriser l'utilisateur du réseau est de retirer manuellement les

objets risqués.

Même si notre projet n'est pas une continuité du

projet IoT Sentinel, celui-ci nous a aidé à concevoir le

nôtre surtout en ce qui concerne l'identification des objets du

réseau. Nous nous sommes basés sur leur travail pour concevoir

l'algorithme qui permettait d'extraire les attributs dont notre futur

modèle avait besoin à l'aide des fichiers pcap dont nous

disposions mais aussi de concevoir l'algorithme d'apprentissage profond pour

l'identification des objets.

3.2. BPF

Le filtre de paquets de

Berkeley (BPF pour Berkeley Packet Filter) est une technologie

permettant entre autres d'analyser le trafic réseau et qui fournit une

interface brute aux couches de liaisons de données pour envoyer et

recevoir des paquets de couche de liaison bruts. Il est disponible sur la

plupart des systèmes d' exploitation de type

Unix. [18]

Il permet à l'utilisateur de filtrer les paquets

circulant dans le kernel tout en évitant de devoir les transférer

vers l'espace utilisateur. Toutefois, de par son côté minimaliste,

il possède peu d'instruction.

BPF permet à un processus de l'espace

utilisateur de fournir un programme de filtrage qui spécifie les

paquets qu'il souhaite recevoir. Par exemple,

un processus tcpdump peut souhaiter recevoir uniquement les

paquets qui initient une connexion TCP.

Les filtres comme ceux-ci fonctionnent en ayant des droits

administrateurs sur le système sur lequel nous travaillons car le kernel

est directement sollicité. Pour notre projet, avoir accès au

kernel et avoir des droits d'administrateurs est indispensable. De plus, il

serait très difficile pour nous de faire fonctionner un logiciel de

pare-feu propriétaire et qui a besoin de règles alors que nous

nous basons ici sur des modèles de prédiction. Nous avons

utilisé les syntaxes de filtre BPF pour filtrer le trafic reçu.

En fait même s'il n'est pas téléchargé ou

directement utilisé, certaines bibliothèques comme scapy

l'utilisent pour gérer les paquets dans le réseau.

3.3. Filter.tlk

Filter.tlk [19] est le fruit de recherches sur la protection

des objets connectés.

Sur la figure ci-dessous, Filter.tlk comprend trois

utilitaires différents pour aider à la création de filtres

BPF:

? une interface pour concevoir les conditions de

filtrage BPF, BPF design aid tool. BDAT est responsable de la

création de filtres BPF en tant que conditions définies à

partir des couches de transport et de réseau. BDAT a été

conçue comme une application Java autonome.

? un plugin Wireshark LUA pour automatiser le test des

filtres BPF avec les ensembles de données de paquets PCAP,

BPF testing tool. Le langage Lua a été utilisé

pour implémenter un écouteur Wireshark pour évaluer les

filtres et compter les paquets correspondant à la condition BPF cible

(acceptée) ou non (rejetée). Il applique un filtre ou un ensemble

de filtres sur un fichier pcap. En conséquence, nous obtenons des

informations pour chaque filtre appliqué sur le nombre de packages

analysés, acceptés et rejetés.

? un script pour compiler facilement les filtres BPF

et créer des règles iptables, IPTable rule

builder. IPTRB est un script bash qui utilise la commande dialog pour

fournir une interface utilisateur graphique intuitive et facile à

utiliser. Il peut transformer les filtres BPF non compilés en

règles IPTables complètes guidées par l'interface. La

règle peut être générée à des fins de

filtrage et / ou d'enregistrement de paquets nuisibles.

Figure 8 : Architecture de

filter.tlk [19]

Comme nous pouvons le déduire de la figure ci-dessus,

la conception d'une règle de pare-feu avec Filter.tlk comprend trois

étapes réalisées avec différents outils inclus dans

le package. Nous commençons par profiter du BDAT (outil d'aide à

la conception BPF) pour concevoir une condition de filtrage afin de

détecter un certain type de paquet. Ensuite Les filtres BPF peuvent

être testés avec différents ensembles de paquets (un

ensemble de paquets correspondant au format pcap et d'autres ne correspondant

pas au format pcap) à l'aide de l'outil de test BPF (BTT).Une fois les

règles BPF testées, elles peuvent être finalement

transformées en règles iptables à l'aide du script

IPTRB.

Enfin, ils ont utilisé Ansible (un outil

d'automatisation informatique) pour automatiser l'installation de Filter.tlk

sur toutes les plates-formes prises en charge.

Notre projet diffère de celui-ci dans le sens où

nous ne créons pas de règles iptables. Nous voulons simplifier le

travail du pare-feu. Les modèles d'apprentissage profond proposés

sont censés nous aider à détecter plus facilement le

trafic dont nous ne voulons pas et à décider plus rapidement

quel paquet est accepté et quel paquet est refusé.

L'inconvénient que nous avons trouvé à cet outil serait la

création de règles redondantes ou qui se ressemblent

énormément où l'un ferait en partie le travail d'une autre

règle.

4. Contexte et intérêt du

projet

Au Cameroun, les objets connectés sont plus en vogue

qu'on ne le croit. Les montres connectées grâce auxquelles on

reçoit nos messages et qui possèdent de ce fait nos informations

personnelles, les télévisions grâce auxquelles on peut

télécharger des jeux via sa console par exemple, les

écouteurs sans fil, les haut-parleurs Bluetooth, des caméras de

surveillance et même des brassards avec des capteurs de rythmes

cardiaques. Pour le moment cela concerne surtout des objets de divertissement

ou de simples gadgets mais il existe de plus en plus de start-up camerounaises

tel que ndoto [20] qui conçoit des compteurs intelligents par exemple,

d'ailleurs ENEO le concessionnaire du service public de

l'électricité au Cameroun a déjà installé

environ 4000 dans les ménages camerounais [21].

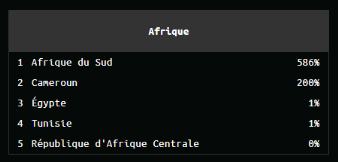

De ce fait, le Cameroun comme tous les autres pays du monde

n'est pas du tout épargné par les menaces qui planent sur les

objets connectés. D'après la carte des menaces de Kapersky, le

Cameroun est le pays 103ème pays le plus attaqué au

monde.

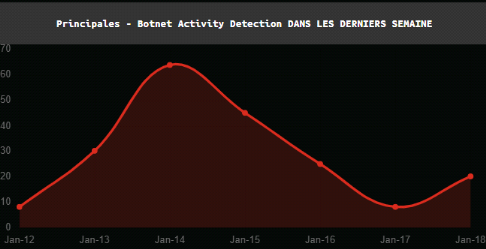

Figure 9 : classement des pays du

monde par détection d'activité de botnet [22]

Kaspersky fournit une carte des menaces

informatiques en temps réel. Sur le classement par pays ci-dessus vous

pouvez observer l'activité des botnets détectés dans le

mode les dernières semaines. Le Cameroun est 9ème

[22]. La détection de l'activité botnet montre les statistiques

des adresses IP identifiées des victimes d'attaques DDoS et des serveurs

C&C des botnet acquis avec le SSoS Intelligence System de Kaspersky.

Figure 10 : Classement sur le

continent africain des activités de détection de botnet [22]

Et sur le classement du continent

africain, est 2ème toujours Selon Kaspersky.

Figure 11 : Détection

d'activité de botnet au Cameroun du 12 janvier au 18 janvier [22]

Ceci est le volume des attaques de

botnet qu'a relevé Kaspersky du 12 janvier au 18 janvier 2021 au

Cameroun.

Le Cameroun reste donc une cible d'attaques de botnet à

travers le monde à ne pas négliger. D'ailleurs Kaspersky

décrit aussi le volume des intrusions détectées et

répertorié au Cameroun.

Figure 12 : Détection

d'intrusion au Cameroun du 11 Janvier au 17 Janvier[22]

Les intrusions cherchent à

exploiter à distances des applications, des services et des

systèmes d'exploitation vulnérables ou mal configurés via

un réseau pour réaliser l'exécution de code arbitraire et

effectuer des activités réseau non autorisées. Le Cameroun

a subi des dizaines de milliers d'intrusions en l'espace de 7 jours.

La carte des attaques de LookingGlass Threat Map [23]

présente aussi une vue des attaques en temps réel à partir

du moment où on se connecte donc il n'y a pas d'historique comme sur

Kaspersky. Au moment de la connexion un point d'infection est apparu sur le

Cameroun.

Figure 13 : Vue en temps

réel d'une infection du botnet Sality su MTN Cameroun [23]

Sality est un virus infectant des

fichiers. MTN Network Solutions Cameroun à Douala vers 08:15 subissait

une attaque de ce virus.

D'ailleurs vous pouvez observer sur les statistiques que le jour

où cette capture d'écran a été faite soit le 19

janvier, il représentait presque 90% des botnets détectés.

Les attaques vers le Cameroun étaient rares et très courtes,

juste quelques secondes. De plus, la plupart des entreprises attaquées

étaient des opérateurs de télécommunications et des

fournisseurs d'accès à internet.

Nous avons déjà démontré plus haut

que même si les objets connectés ne sont pas toujours des cibles,

bien qu'il soit possible de voler des données personnelles, de bloquer

les appareils ou alors d'espionner leurs utilisateurs, elles servent

d'appareils zombies qui permettent ensuite de s'attaquer à de plus gros

sites ou compagnies dans le monde afin de faire du chantage pour obtenir de

l'argent ou juste pour saboter une entreprise.

La véritable cible des attaques visant les objets

connectées et aussi la vraie bénéficiaire d'une issue

à ce problème n'est pas un pays ou un utilisateur en particulier

mais plutôt les infrastructures informatiques de grosses entreprises.

Les solutions présentées plus haut ont chacune

pour objectif de protéger les objets connectés. IoT Sentinel

utilise une base de données qui le renseigne sur le

« danger » que peut représenter un objet du

réseau pour ensuite l'isoler et empêcher toute attaque vers le

réseau IoT. BPF est un outil utilisé par les systèmes

d'exploitation qui est utilisé de manière implicite lors de la

construction de filtres. Et filter.tlk propose de filtrer les paquets et

concevoir des règles de pare-feu afin de protéger le

réseau ou un système.

Notre approche est différente. Nous ne voulons pas

créer des règles de pare-feu qu'il faudra gérer par la

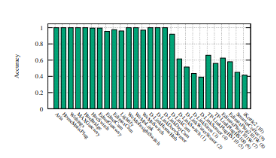

suite. Ensuite se baser sur une base de données mise à jour est

une solution qui présenterait des limites au cas où un objet ne

présente pas de « mauvais profil » mais serait une

fois entré dans la zone « trusted » plus tard

victime d'une attaque et propagent un virus.

Nous proposons d'utiliser une passerelle IoT pour filtrer les

paquets vers et depuis les paquets du réseau interne. Ce type

d'équipement sert de pont entre les capteurs, objets connectés,

équipements réseaux et le Cloud. Il comprend souvent plusieurs

ports pour plusieurs protocoles différents et grâce à lui

on peut connecter divers appareils IoT. De ce fait, on dégage d'abord

l'une des premières limites lorsqu'on veut créer une solution

pour l'IoT, la diversité des objets et protocoles de communication

rencontrés.

Nous ne sommes pas liés à un objet en

particulier et nous devrons obtenir des données variées pour

proposées des modèles qui ne sont pas dépendant d'une

seule technologie, qui devra fonctionner sur ces passerelles. Ces passerelles

pourront ainsi protéger tout le réseau d'appareils dont elle

gère la communication grâce aux modèles d'apprentissage

profond proposés.

5. Problématique

Les utilisateurs s'équipent d'objets connectés

sans vraiment se rendre compte de la vulnérabilité de ces objets

face aux hackers. En effet, la plupart des consommateurs d'objets

connectés ne s'intéressent pas vraiment à la

sécurité de leurs objets connectés ou ne voient pas en

quoi c'est important. Ceci est dû entre autres au fait qu'ils ne

manipulent pas de système d'exploitation de l'objet c'est-à-dire

pouvoir par exemple mettre à jour le système et n'ont

accès qu'aux options proposé par l'objet.

Ces objets connectés qui ne possèdent souvent

aucun moyen de protection à part des clés de chiffrement faible

pour assurer la confidentialité et l'intégrité ou encore

des mots de passe faible, peuvent être utilisés :

- Pour se propager vers nos téléphones

portables et ordinateurs

- Rendre vos appareils inutilisables

- Comme botnet pour attaqués des gros sites internet

ou serveurs important afin de les rendre indisponible

- Vous espionner et voler des informations confidentielles

voire votre identité

De plus, très peu de fabricants de ces objets

conçoivent la sécurité de l'objet. Ce n'est souvent

qu'après des attaques ou la révélation de leur faille dans

les médias que ceux-ci s'y intéressent un peu plus et fournissent

des mises à jour ou alors vendent d'autres objets mis à jour. Il

se peut aussi qu'ils ne connaissent pas les vulnérabilités des

objets qu'ils conçoivent.

De nouveaux objets peuvent intégrer le réseau

à tout moment, est-ce un objet fiable ? Faut-il autoriser les

connexions avec l'extérieur ? Comment surveiller le trafic et

éviter les connexions malveillantes ? Comment protéger un

réseau d'objets connectés

Le réseau domotique est un réseau privé

mais connecté à internet qui lui est un réseau public et

les objets qui composent le réseau domotique sont peu

protégés face aux intrusions à cause de leur

capacité limitée.

Nous suggérons d'installer un équipement ou une

application sur une passerelle d'objets connectés à la

frontière entre le réseau privé et le réseau public

pour filtrer le trafic échangé et ne laisser passer que le trafic

autorisé pourrait protéger le réseau domotique des

intrusions. Il pourrait aussi empêcher qu'un hacker n'exploite les

failles d'un objet du réseau privé.

Ceci se fait déjà avec un pare-feu classique,

sauf qu'un pare-feu utilise des règles qui ont besoin d'être

ajouté manuellement par un administrateur qui doit aussi se charger de

les mettre à jour, gérer des anomalies comme deux règles

avec des actions filtrantes différentes qui correspondent à un

même paquet, accepter un trafic vers des services ou objets inexistants,

une règle qui n'est jamais utilisé ou encore ou encore des

règles redondantes[24].

La réalisation d'un logiciel complet qui viendrait

résoudre les problèmes d'anomalies des pare-feu classiques

demanderait la réalisation de plusieurs algorithmes presque pour chaque

anomalie ou tâche ce qui serait très long !

D'où notre approche de faire intervenir une

intelligence artificielle pour effectuer des opérations de filtrage de

manière automatique en détectant la nature du trafic et en

identifiant les objets concernés, pour diminuer le travail d'un pare-feu

en allégeant sa tache de filtre de paquets. L'avantage d'un

modèle par rapport à un logiciel qu'on programmait pour faire ce

travail est qu'il demande moins de programmation pour décrire en

détail les étapes de calcul nécessaire à

l'ordinateur ou encore à gérer moins de bug lors de ces calculs.

6. Objectif du projet

L'objectif principal de ce mémoire est le

suivant :

Protéger les objets vulnérables d'un

réseau domotique en mettant en oeuvre le filtrage du trafic au niveau de

la passerelle grâce à l'apprentissage automatique.

Nous proposons de protéger un réseau d'objets

connectés d'attaques très connus en créant des

modèles d'apprentissage automatique qui vont permettre de filtrer le

trafic réseau. Notre proposition serait, grâce à

l'intelligence artificielle, de nous servir d'algorithmes pour

reconnaître beaucoup plus facilement et surtout plus rapidement le trafic

malveillant spécifiques aux objets connectés et pouvoir ainsi

accepter ou rejeter un paquet. Tout en identifiant les objets du réseau

et reconnaître plus rapidement les objets piratés ou malveillants.

Nous allègerons le travail d'un pare-feu.

Pour cela nous pouvons définir plusieurs sous objectifs

qui sont :

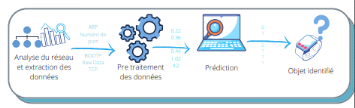

? Pouvoir analyser un réseau d'objets connectés

à travers la passerelle pour identifier les différents types

d'objets

? Analyser le trafic et détecter les paquets

malveillants en se basant sur quelques attaques connues des objets

connectés

? Bloquer les connexions malveillantes

en se basant sur des prédictions faites par le modèle

CHAPITRE 2 :

MÉTHODOLOGIE

Introduction

Dans ce chapitre nous allons principalement aborder notre

méthodologie de travail pour atteindre les objectifs posés,

proposer des modèles et suggérer une solution de filtrage des

paquets. Nous allons présenter les concepts sur les algorithmes

d'apprentissage profond et d'empreinte digitale. Nous allons présenter

la méthodologie de créations des modèles de la collecte

des données jusqu'à la création des réseaux de

neurones. Enfin nous allons parler de l'implémentation d'un filtre qui

fonctionne avec le kernel et qui permet de filtrer des paquets.

1. Définition de concepts

clés

1.1. Algorithme d'apprentissage profond

L'apprentissage profond est un sous domaine d'intelligence

artificielle qui s'appuie sur un réseau de neurones artificiels. Il

permet globalement « d'apprendre à reconnaître,

d'identifier ou prédire ». La particularité

intéressante de l'intelligence artificielle est d'apprendre de ses

erreurs à peu près comme un être capable de penser

à beaucoup encourager les recherches dans le but de développer

cette discipline. Il est présent aujourd'hui dans plusieurs domaines

différents tels que la reconnaissance d'image, la traduction

automatique, la voiture autonome, le diagnostic médical, des

recommandations personnalisées dans nos e-commerces, les

modérateurs automatique, les chatbots, l'exploration spatiale et bien

évidement la sécurité informatique dans la

détection de malware [25].

Les réseaux de neurones artificiels sont

inspirés de l'architecture des réseaux de neurones humains.

C'est une combinaison de plusieurs neurones connectés sous la forme d'un

réseau. Ces neurones sont interconnectés pour traiter et

mémoriser des informations, comparer des problèmes ou situations

quelconque avec des situations (informations en entrée, erreurs, etc)

similaires passées, analyser les solutions et résoudre le

problème de la meilleure façon possible. La figure

ci-dessous nous montre un exemple basique d'un réseau neuronal. Un

réseau neuronal artificiel a une couche d'entrée, une ou

plusieurs couches cachées intermédiaires et une couche de sortie.

Sa forme la plus simple est le perceptron simple où on retrouve deux

couches. La couche d'entré et la couche de sortie.

Figure 14 : un réseau de

neurone avec trois couches

Tel que montré à la

figure ci-dessus chaque couche possède un ensemble de neurones

connectés aux neurones de la couche suivante excepté la couche de

sortie.

La figure ci-dessous nous montre les détails des liens

entre les neurones de la couche précédente et un neurone de la

couche suivante. Chaque lien connectant un neurone à un autre est

associé à un poids wi

représentant la force de la connexion.

La somme (poids wi multiplié par la valeur de

l'entrée précédente du lien xi)

ou fonction d'agrégation des liens de la couche précédente

est multipliée par la fonction d'activation du neurone de la couche

suivante ce qui donne une sortie représentative de l'activation du

neurone. La figure ci-dessous nous montre que chaque neurone d'une couche

effectue des calculs en fonction des sorties des couches

précédentes.

Figure 15 : Connexion des

entrées d'une couche précédente vers un neurone de la

couche suivante

- f est la fonction

d'agrégation

- x est la valeur de la sortie d'un des neurones de la couche

précédente

- w est le poids synaptique d'un lien

Une fonction d'activation est une fonction mathématique

appliquée à un signal de sortie d'un neurone [25]. Il correspond

à un seuil d'activation qui une fois atteint entraine une réponse

du neurone. Il existe plusieurs fonctions d'activation. Par exemple la fonction

rampe ou identité f  (2), la fonction logistique ou sigmoïde (2), la fonction logistique ou sigmoïde   (3), la fonction relu ou unité de rectification

linéaire (3), la fonction relu ou unité de rectification

linéaire  (4)ou encore fonction tangente hyperbolique (4)ou encore fonction tangente hyperbolique   (5). (5).

Nous remarquons qu'il existe dans la plupart des cas un seuil

pour activer le neurone. Par exemple pour la fonction sigmoïde x elle se

trouve entre -1 et 1 ou encore celle de la fonction Relu où x doit

être supérieur à zéro.

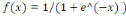

Dans le cadre de notre projet deux types de réseau de

neurone nous ont intéressés, le perceptron multicouche et le

réseau récurrent LSTM.

Le perceptron multicouche (PMC en français ou MLP pour

MultiLayer perceptron) est un algorithme d'apprentissage dans lequel

l'information circule dans un seul sens et qui apprend une fonction en

s'entraînant à partir d'un jeu de donnée ou dataset avec

des attributs en entrées, plusieurs couches intermédiaires et des

classe/labels à prédire en sortie.

L'apprentissage du MLP se fait généralement par

rétro-propagation. Cela permet de trouver les poids minimisant une

fonction d'erreur globale. Elle permet de calculer le gradient de l'erreur pour

chaque neurone du réseau, de la dernière couche vers la

première.

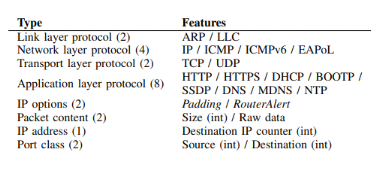

Il y'a deux étapes principales dans la rétro