II.4.3.Le perceptron :

Depuis les résultats des travaux de Mac Culloch et

Pitts (1943), qui ont abouti à La définition du neurone formel,

ainsi ceux de Hebb, expliquant les effets d'apprentissage de mémoire et

de conditionnement à partir de groupes de cellules. Pour expliquer ces

effets d'apprentissage, Hebb propose que les cellules apprennent à

modifier l'intensité des connexions qui les relient, en

fonction de leur activité simultanée. L'idée

de certains chercheurs fut d'utiliser les modélisations des neurones et

de l'évolution des synapses pour simuler des réseaux de neurones.

Le premier modèle solide fut présenté en 1959 par F.

Rosenblatt il s'agit du perceptron, autrement dit un réseau

réduit à un seul neurone formel [2].

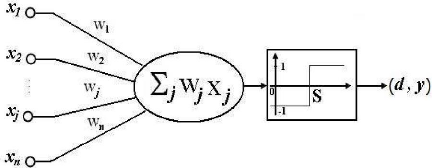

II .4.3.1. Description :

Les perceptrons sont des réseaux de type feedforward,

possédant la structure suivante : Une couche de connexions fixes,

située entre les unités d'entrée, la rétine, et les

unités d'association. La seconde couche relie les unités

d'association et les unités de réponse : c'est sur

ces poids que l'adaptation agit. Dans le perceptron, il n'y a qu'une seule

couche qui varie en fonction de l'adaptation. Dans le neurone du perceptron on

utilise la fonction d'activation à seuil. Le modèle du neurone

linéaire à seuil du perceptron à une cellule de

décision et relié à N cellules d'entrée est

présenté sur la (figure II.8)

Le neurone linéaire à seuil réalise donc,

une partition des vecteurs d'entrée qui lui sont soumis

en entrée en deux domaines. La frontière entre ces

deux dom

S = E ?????? * Xj (II-4)

m u S désigne le seuil de la cellule de

décision.

En effet, pour ?? E???? * Xj > S , le neurone répond 1

;

Pour ??E???? * Xj < S , il répond -1

La frontière séparant ces deux domaines sera donc

un hyperplan.

:

|