INTRODUCTION GENERALE

1. BREF APERÇU

Il y a quelques années, l'imagination de l'industrie

informatique s'est emparée de l'idée consistant à faire

fonctionner plusieurs systèmes d'exploitation de manière

concurrente sur un méme ordinateur. La virtualisation est devenue le mot

à la mode et des projets ont été lancés pour

réaliser ce rêve.

Grace à la virtualisation, vous n'avez pas besoin d'un

ordinateur supplémentaire chaque fois que vous voulez mettre en place un

nouveau serveur. On peut faire face à des besoins supplémentaires

en termes d'infrastructure en démarrant simplement un nouveau

système d'exploitation invité. Un système invité

peut être dédié à une application unique et il peut

être différent du système d'exploitation hôte. Les

fonctionnalités telles que la virtualisation de stockage permettent de

déplacer les systèmes invités sans interruption de

l'activité afin d'exploiter au mieux votre matériel

informatique.

La virtualisation est devenue une solution d'entreprise qui

permet de réduire le nombre des serveurs physiques. Mais, par contre,

elle permet d'augmenter conséquemment le nombre des serveurs virtuels

sur chaque serveur physique, en vue d'optimiser son utilisation, de

réduire les dépenses sur le matériel serveur, de diminuer

la consommation électrique ainsi que de libérer beaucoup d'espace

dans la salle serveur en facilitant l'administration du système

informatique.

Elle peut être déployée dans un

réseau d'entreprise, intranet, qui se définit comme tout

réseau TCP/IP privé, qui emploi les même technologies,

services que ceux de l'Internet.

2. PROBLEMATIQUE

Aujourd'hui les entreprises sont toujours en quête de

compétitivité, elles essaient continuellement d'améliorer

leur productivité mais aussi de diminuer leurs coûts. Cette

recherche de performance se traduit souvent dans les Directions de Services

Informatiques DSI en sigle par l'adoption de nouvelles technologies

matérielles et / ou logiciels. Une des technologies qui suscite un

intérêt grandissant au sein des services informatique est la

« virtualisation ». Mais que se cache -t-il derrière ce terme

encore peu connu, et qu'apporte cette technologie aux entreprises ? Quels sont

les enjeux de la virtualisation dans l'entreprise ? Pour quoi virtualiser les

serveurs d'un intranet cas :(ISTA) ? Quelle technologie et quelle solution de

virtualisation à utiliser dans l'intranet ISTA ? Comment virtualiser des

serveurs hétérogènes sous une

plateforme GNU1/Linux ?

Les réponses à ces différentes questions

consisteront notre apport scientifique dans cette étude qui va se

rapporter et se focaliser plus et uniquement sur la virtualisation des serveurs

Windows et Linux donc serveurs hétérogènes sous Linux,

c'est-à-dire déployer un système de base ou plateforme

sous linux, qui prendra en charge l'exécution de tous les autres

serveurs virtualisés ou invités qui y seront

déployés.

3. BUT ET OBJECTIF

Voyant ainsi les avantages que nous retirons de la

virtualisation des serveurs du parc informatique d'un Intranet donné,

nous allons dans le cadre de notre étude, présenter le

réseau Intranet et ses avantages, décrire les technologies et

expliquer les solutions de virtualisation des serveurs, en ressortant les

points forts et faibles dans l'Intranet ;

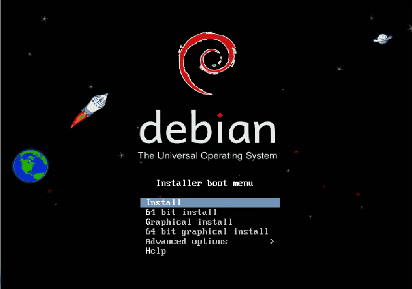

Puis, nous mettrons en oeuvre l'architecture virtuelle sur une

plateforme Linux sous debian 6.0 grâce à la solution XEN, nous

parlerons du fonctionnement, configuration et administration de Xen. Nous

mettrons également en oeuvre l'architecture virtuelle en

déployant des serveurs hétérogènes sur la

plateforme GNU/Linux, stable, fiable, puissante, facile à administrer,

à adapter et évolutif.

1 GNU qui signifie : Gnu is Not

Unix Applications du système Linux mise en place par

des développeurs libre Présenté par : Bonhomie

BOPE bonhomie.bope@ista.ac.cd 243 851 796 942, 243 898 297 100

4. DELIMITATION DU TRAVAIL

La notion de virtualisation des serveurs informatiques ayant

des racines qui peuvent être abordés dans différents

angles, il est donc conseillé par la méthodologie de la recherche

scientifique d'imposer un certain principe qui va abriter notre étude du

sujet pour éviter le débordement dans le temps et dans

l'espace.

Ainsi notre étude aura comme champ d'action : «

L'Intranet de l'ISTA » et se limitera sur l'étude et la mise en

place des serveurs hétérogènes virtualisés sous

Linux dans un réseau Intranet, dans le but d'alléger le cout, de

maximiser l'utilisation des serveurs ainsi que de faciliter l'administration de

l'Intranet de l'Institut Supérieur de Techniques Appliquées ISTA

en sigle.

5. METHODOLOGIE

Pour atteindre nos objectifs, nous nous sommes servi d'un

certain nombre de méthodes dont : la méthode analytique qui nous

a permis de décomposer les éléments du système dans

le but d'arriver à dégager les problèmes et la

méthode de conception. La phase d'analyse permet de lister les

résultats attendus, en termes de fonctionnalités, de performance,

de robustesse, de maintenance, de sécurité,

d'extensibilité ; tandis que la phase de conception permet de

décrire de manière non ambiguë, le plus souvent en utilisant

un langage de modélisation, le fonctionnement futur du système,

afin d'en faciliter la réalisation.

Les techniques suivantes ont été

utilisées pour arriver à un résultat fiable: les

techniques documentaires pour recueillir des informations relatives à

notre sujet, l'interview pour échanger avec les spécialistes dans

le domaine, la consultation des sites web afin de nous adapter à

l'évolution technologique, la consultation des spécialistes pour

des éventuels explications claires et précises, et nous nous

sommes servi aussi de notre expérience professionnelle dans ce

domaine

6. PLAN SOMMAIRE DU TRAVAIL

Notre mémoire sera subdivisé en deux parties et

s'étalera sur cinq différents chapitres. La première

partie parlera de la théorie et la seconde s'intéressera de la

pratique.

Première partie :

Chapitre I : Généralité sur l'intranet ;

Chapitre II : La virtualisation des serveurs dans un intranet;

Chapitre III : Les solutions de virtualisation des serveurs;

Deuxième partie :

Chapitre IV : Étude du réseau existant cas : ISTA

;

Chapitre V : Mise en oeuvre de l'infrastructure virtuelle de

l'ISTA;

CHAPITRE I : GENERALITE SUR L'INTRANET

I.1. L'INTRANET

Un intranet est un réseau informatique interne à

une entreprise, c'est aussi l'utilisation de tout ou partie des technologies et

des infrastructures de l'Internet pour transporter et traiter les flux

d'informations internes d'un groupe d'utilisateurs identifiés.

L'intranet va permettre à l'entreprise de mettre en oeuvre l'ensemble de

possibilités d'Internet, mais en interne.

Le réseau Intranet utilise les standards

client-serveur2 de l'internet en utilisant les protocoles TCP/IP,

comme l'utilisation de navigateurs Web basé particulièrement sur

le protocole http et de serveurs web, pour réaliser un système

d'information interne à une organisation ou une entreprise.

L'intérêt d'un tel réseau réside dans la

capacité qu'il possède à transmettre les données,

mais aussi et surtout dans sa possibilité de faire transiter des

informations confidentielles ou à destination des seuls employés

de l'entreprise. Ainsi, tout employé peut communiquer des notes de

service, lire des manuels en ligne, consulter des catalogues, agenda ou suivre

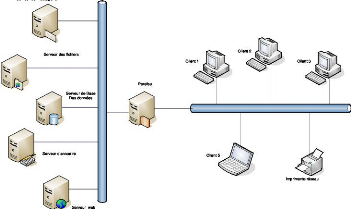

les projets en cours. La figure1 ci-dessous illustre le schéma

général d'un intranet.

Fig.1. Schéma général d'un intranet

d'an

2

http://www.commentcamarche.net/entreprise/intranet.php3

visité le 25 mai 2011 à 09h45

n

Impimn

Un intranet repose généralement sur une

architecture à trois niveaux, composée :

" De client grâce au navigateur Internet

généralement ;

" d'un ou plusieurs serveurs d'application: un serveur web

permettant d'interpréter des scripts CGI, PHP, ASP ou autres, et les

traduire en requêtes SQL afin d'interroger une base de données

;

" d'un serveur de bases de données ;

De cette façon, les machines clientes gèrent

l'interface graphique, tandis que les différents serveurs manipulent les

données. Le réseau permet de véhiculer les requêtes

et les réponses entre client et serveurs.

L'architecture intranet met en jeu des composants

organisationnels forts et permet enfin d'offrir aux utilisateurs un

environnement d'accès à l'information à la hauteur de

leurs légitimes prétentions. L'intranet est l'utilisation de tout

ou partie des technologies et des infrastructures de l'Internet pour

transporter et traiter les flux d'informations internes d'un groupe

d'utilisateurs identifiés. L'intranet va permettre à l'entreprise

de mettre en oeuvre l'ensemble de possibilités d'Internet, mais en

interne.

Parmi ces possibilités :

1) La publication des documents.

2) Le partage des fichiers et logiciels.

3) La messagerie interne.

4) Les groupes de discussion en ligne (News groupes).

5) Les bases de données.

Une application Intranet nécessitera au minimum un

réseau local ou

plusieurs réseaux locaux interconnectés

via le réseau public s'ils sont à

distance ou par le biais

d'une ligne spécialisée offrant une sécurité

totale.

I.1.1. Les Services de l'intranet

Un Intranet peut être constitué de nombreuses

applications et services destinés aux Utilisateurs finaux et aux

équipes informatiques et réseaux :

> Un serveur Web interne ;

> Un serveur Web accessible depuis l'entreprise et depuis

l'Internet par une communauté fermée d'utilisateurs (cas de

l'Extranet) ;

> Une interconnexion sécurisée des

réseaux locaux de l'entreprise et ses filiales est possible en utilisant

les infrastructures publiques de l'Internet ;

> Des forums de discussions entre des équipes au sein

d'une entreprise ;

> L'interconnexion des différents systèmes

d'information de l'entreprise est possible.

Une application Intranet ressemble à un site Web mais :

1. La population des utilisateurs du site intranet est connue et

identifiable.

2. Une plus grande maîtrise des infrastructures des

réseaux et du débit disponible :

Contrairement à Internet où les

intermédiaires sont multiples, on peut envisager d'utiliser l'intranet

pour faire fonctionner des applications difficiles à exploiter comme la

vidéoconférence.

I.1.2. Architecture d'un Intranet

Généralement, un réseau intranet

possède une architecture clients/serveur(s) qui repose sur tout ou

partie des composants suivant :

· Serveur http de l'Intranet semblable à un serveur

web ;

· Serveur de messagerie pour l'échange de courriers

électroniques ou la messagerie instantanée ;

· Serveur d'authentification pour l'identification

des

utilisateurs et le stockage des annuaires ;

· Serveur de fichiers, NAS, SAN pour le stockage et le

partage des données ;

· Serveur logiciel client de supervision réseau

/systèmes:

· Switchers, routeurs, pare-feux :

L'intranet d'une entreprise héberge souvent son

système d'information. Iiest généralement

connecté au réseau mondial Internet via une ou

plusieurs passerelle(s) et un ou plusieurs pare-feu(x)

Le modèle client/serveur a commencé à se

développer quand les informaticiens se sont mis à abandonner les

systèmes partagés reposant sur une logique centralisée, au

profit de réseaux de stations de travail et de serveurs. Une

architecture Client /Serveur met en valeur l'infrastructure du système

d'information dans les environnements informatiques.

Cette technologie permet d'implémenter d'une

manière modulaire et flexible des systèmes au sein d'une

organisation. Elle a été utilisée dans des applications

différentes : Gestion de la base de données, le web, l'Intranet,

les systèmes transactionnels, les systèmes de messageries, les

systèmes de partage de données etc.

Le modèle client/serveur repose sur une architecture

d'application qui permet de subdiviser un processus informatisé en au

moins deux tâches, avec un mécanisme de communication permettant

la coopération entre les deux processus client et serveur. La

finalité de cette subdivision est de disposer de couches de

fonctionnalités pouvant être écrites par des programmeurs

et déployées sur différentes machines d'une manière

optimale.

I.1.3. Avantage d'un Intranet

1. Travail des employés : L'intranet aide les

employés à trouver et visualiser rapidement des informations dans

des documents électroniques et des applications pertinentes dans leurs

domaines de compétence. Via une interface de navigateur Web facile

à utiliser, les utilisateurs peuvent accéder aux données

de n'importe quelle base de données que l'organisation veut rendre

disponible.

2. Communication : L'intranet est un puissant moyen de

communication à l'intérieur d'une organisation, verticalement et

horizontalement.

3. Publipostage Web : l'utilisation d'intranet permet aux

informations d'être publiées par des liens au-delà du

simple hypertexte.

4. Organisation et business : L'intranet est aussi

utilisé comme une plateforme pour développer et déployer

des applications de support aux transactions informatiques, utilisées

à des fins financières et décisionnelles.

1.2. L'EXTRANET

Un extranet est un réseau privé de type intranet,

accessible de l'extérieur.

Les réseaux extranet, basés sur une architecture

client /serveur, sont très répandus, car ils répondent aux

besoins des nouveaux modes de communication des entreprises.

L'accès à un réseau extranet est

limité c'est-à-dire, seule certaines personnes peuvent y

accéder et parfois uniquement à partir de lieux

prédéfinis. Les contrôles d'accès se fond par

l'utilisation d'un code d'identification, le nom de l'utilisateur, et d'un mot

de passe qui est un code secret censé être connu exclusivement par

l'utilisateur.

L'objectif d'un extranet est de profiter des

possibilités offertes par la technologie Web. Le site extranet est

identifié par une adresse électronique appelée URL

(Uniforme Resource Locator)

A l'aide de cette adresse, il suffit de se connecter au site

en utilisant un navigateur Web tel que Microsoft Internet Explorer ou Mozilla

Firefox, et ceci de n'importe quel endroit de la planète disposant d'une

ligne spécialisées.

A cette demande de connexion, le serveur Web hébergeant

le site extranet répond en demandant à l'utilisateur de

s'identifier en indiquant son nom d'utilisateur et son mot de passe .Si ceux-ci

sont corrects, la connexion est acceptée et l'utilisateur a accès

à tous les services proposés par l'extranet.

Un extranet n'est ni un intranet, ni un site Internet. Il

s'agit d'un système supplémentaire offrant par exemple aux

clients d'une entreprise, à ses partenaires ou à des filiales, un

accès privilégié à certaines ressources

informatiques de l'entreprise.

L'extranet peut avoir plusieurs utilités et peut

être source d'un gain de temps pour les entreprises.

Exemples de possibilité d'utilisation :

· Mise à disposition d'informations sur

l'entreprise,

· Accès, pour les clients au suivi des marchandises

en temps réel,

· Accès aux documentations techniques,

légales, douanières etc,

· Échanges de données entre

collaborateurs.

· Mise à disposition d'un annuaire du personnel

· Possibilité de faire la visioconférence et

messagerie électronique interne à l'extranet.

Avantages de l'extranet :

> Accès par Internet, c'est-à-dire de n'importe

quel poste connecté au Web : ordinateur, PDA, Pocket PC...

> Facilité du partage de l'information, fait gagner

en efficacité, réduit le courrier et commandes papier, les

commandes téléphoniques, et élimine donc le risque

d'erreurs de ressaisie des formulaires.

> Choix des destinataires par l'entreprise et

sécurité d'échange des informations.

> L'accès par Internet n'impose aucun logiciel

spécifique à installer chez les partenaires.

1.3. VIRTUEL PRIVATE NETWORK (VPN)

Il arrive ainsi souvent qu'une entreprise éprouve le

besoin de communiquer avec des filiales, des clients ou même des

personnes géographiquement éloignés Via Internet pour

autant, les données transmises sur Internet sont beaucoup plus

vulnérables que lorsqu'elles circulent sur un réseau internes

à une organisation, car le chemin emprunté n'est pas

définis à l'avance. Ce qui signifie que les données

empruntent une infrastructure réseau publique appartenant à

différents opérateurs.

Ainsi il n'est pas impossible que sur le chemin parcouru, le

réseau soit écouté par un utilisateur indiscret ou

méme détourné. Il n'est donc pas concevable de transmettre

dans des telles conditions, des informations sensibles pour l'organisation de

l'entreprise.

La première solution pour répondre à ce

besoin de communication sécurisé consiste à relier les

réseaux distants à l'aide des liaisons

spécialisées. Toutefois, pour la plus part d'entreprises ; relier

deux réseaux locaux distants par une ligne spécialisées

n'est pas une solution facile.

Un bon compromis consiste à utiliser Internet comme

support de transmission en utilisant un protocole d' « encapsulation

» en anglais tunneling, c'est-à-dire encapsuler les données

à transmettre de façon chiffrée. Le tunneling est

l'ensemble des processus d'encapsulation, de

transmission et de désancapsulation. On parle alors de

réseau privé virtuel (VPN, acronyme de Virtual Private

Network)3 pour désigner le réseau ainsi

artificiellement crée. Ce réseau est dit virtuel, car il relie

deux réseaux « physiques », réseaux locaux, par une

liaison non fiable, Internet. Il est privé car, seuls les ordinateurs

des réseaux locaux de part et d'autre du VPN peuvent voir les

données.

Afin d'assurer un accès aisé et peu

coüteux aux intranets ou aux extranets d'entreprise, les réseaux

privés virtuels d'accès simulent un réseau privé,

alors qu'ils utilisent en réalité une infrastructure

d'accès partagée, comme Internet. Ainsi, les utilisateurs ont

l'impression de se connecter directement sur le réseau de leur

entreprise.

1.4. INTERNET

Internet est le réseau informatique mondial qui rend

accessible au public des services comme le courrier électronique et le

World Wide Web. Ses utilisateurs sont désignés par le

néologisme « internaute ». Techniquement, Internet se

définit comme le réseau public mondial utilisant le protocole de

communication IP (Internet Protocole). Le Web, le courrier électronique,

la messagerie instantanée et les systèmes de partage de fichiers

poste à poste sont des applications d'Internet.

L'internet est composé d'une multitude de

réseaux répartis dans le monde entier. Chaque réseau est

rattaché à une entité propre (université,

fournisseur d'accès à Internet, armée) et se voit

attribué un identifiant unique appelé Autonomous

système (AS).

Afin de pouvoir communiquer entre eux, les réseaux

s'échangent des données, soit en établissant une liaison

directe, soit en se rattachant à un noeud d'échange (point de

peering).

Chaque réseau est donc connecté à

plusieurs autres réseaux. Lorsqu'une communication doit s'établir

entre deux ordinateurs appartenant à des systèmes autonomes

différents, il faut alors déterminer le chemin à effectuer

parmi les réseaux. Aucun élément ne connaît le

réseau dans l' ensemble, les données sont simplement

redirigées vers un autre noeud selon des règles de routage.

3

http://www.osmosis-corp.com/produit_02-1.php

visité le 25 juin à 19h32

1.5. SERVEUR

Un serveur est un ordinateur mettant des ressources à

la disposition des clients du réseau. Le serveur permet donc un partage

des ressources, mais celles-ci sont traitées localement par la suite. Le

programme et les données sont chargés dans la station de travail,

qui, comme son nom l'indique, effectue les tâches demandées. C'est

la particularité de ce type de réseau, dont la conception est en

totale rupture avec les réseaux du monde de la mini-informatique ou des

gros systèmes dans lesquels le serveur prend en charge l'ensemble des

tãches de stockage et de traitement. Les terminaux ne sont alors que des

organes de transmission/réception d'informations, avec l'ordinateur

serveur occupant une situation centrale. Tout part de lui et tout va à

lui. Longtemps, la majorité des réseaux locaux ont

été construits autour de serveurs de fichiers qui envoyaient le

fichier complet sur la requête d'une station de travail. Toutefois, cette

procédure augmente considérablement le trafic sur le

réseau et ralenti considérablement son fonctionnement. Par

exemple, pour effectuer une recherche dans une base de données,

l'intégralité des données devra être

transportée sur la station de travail même si une grande partie

des informations transférées est inutile.

L'architecture client/serveur a été

conçue pour un environnement idéal pour un usage collectif

combine les apports de la microinformatique (applications simples d'emploi,

coüts faibles) avec les avantages qu'apportent les systèmes

centralisés (traitement centralisé, partage d'informations,

sécurité). Le principe est simple, elle sépare la

tâche en une application « cliente » et une application «

serveur ». L'application cliente tourne sur la station de travail, elle

enregistre les données fournies par l'utilisateur et transmet les

requêtes au serveur. Le serveur traite les requêtes en renvoie les

résultats demandés à l'application cliente qui les

présente a l'utilisateur. Cette architecture permet

généralement à plusieurs applications clientes de partager

simultanément les mêmes données.

1.6. SYSTÈME D'EXPLOITATION

Un système d'exploitation, SE, en anglais

Operating système ou OS, est un ensemble de programmes responsables de

la liaison entre les ressources matérielles d'un ordinateur hardware, et

les applications informatiques de l'utilisateur, software. Il fournit aux

programmes applicatifs des points d'entrées génériques

pour les périphériques.

Le système d'exploitation est composé d'un

ensemble de logiciels. On distingue généralement les

éléments suivants :

· Le noyau en anglais kernel représentant les

fonctions fondamentales du système d'exploitation telles que la gestion

de la mémoire, des processus, des fichiers, des entrées/sorties

principales, et des fonctionnalités de communication.

· L'interpréteur de commande en anglais Shell,

par opposition au noyau permettant la communication avec le système

d'exploitation par l'intermédiaire d'un langage de commandes, afin de

permettre à l'utilisateur de piloter les périphériques en

ignorant tous des caractéristiques du matériel qu'il utilise, de

la gestion des adresses physiques, etc.

· Le système de fichiers permettant d'enregistrer

les fichiers dans une arborescence.

Ainsi, il a pour rôle :

" Gestion du processeur : le système d'exploitation

est chargé de gérer l'allocation du processeur entre les

différents programmes grâce à un algorithme

d'ordonnancement. Le type d'ordonnanceur est totalement dépendant du

système d'exploitation, en fonction de l'objectif visé.

" Gestion de la mémoire vive : le système

d'exploitation est chargé de gère l'espace mémoire

alloué à chaque application. En cas d'insuffisance de

mémoire physique, le système d'exploitation peut créer une

zone mémoire sur le disque dur, appelée « mémoire

virtuelle ». Elle permet de faire fonctionner des applications

nécessitant plus de mémoire qu'il n'y a de mémoire vive

disponible sur le système.

" Gestion des entrées/sorties : le système

d'exploitation permet d'unifier et de contrôler l'accès des

programmes aux ressources matérielles par l'intermédiaire des

pilotes.

" Gestion de l'exécution des applications : le

système d'exploitation en leur affectant les ressources

nécessaires à leur bon fonctionnement.

" Gestion des droits : le système d'exploitation est

chargé de la sécurité lié à

l'exécution des programmes en garantissant que, les ressources ne sont

utilisées que par les programmes et utilisateurs possédant les

droits adéquats.

" Gestion des fichiers : le système d'exploitation

gère la lecture et l'écriture dans le système de fichiers

et le droit d'accès par les utilisateurs.

Le système d'exploitation est adapté à

un type de microprocesseur. Ainsi, parmi les systèmes d'exploitation,

les plus célèbres sont : la famille Microsoft

Windows et le GNU/Linux pour les ordinateurs

compatibles PC ; Unix, VMS et OS/2 pour

d'autre types de processeurs.

a. Windows

Windows est une gamme de système d'exploitation

produite par Microsoft, principalement destinées aux machines

compatibles PC. C'est le remplaçant de MS-DOS. Depuis les années

1990, avec la sortie de Windows 95, son succès commercial pour

équiper les ordinateurs personnels est tel qu'il possède alors un

statut de quasi-monopole. La gamme Windows4 est composée de

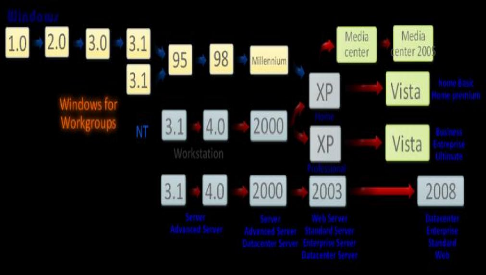

plusieurs branches comme nous montre la figure 2 :

Fig.2. La gamme du syst~me d'exploitation Windows

· La première est née en 1985.

· La seconde branche, dite branche NT (Windows NT, puis

2000) est apparue en 1993. C'est une réécriture complète

du système, destinée aux ordinateurs personnels et aux serve urs.

Elle s'est principalement développée dans le milieu

professionnel.

· La troisième branche est apparue en 1995 avec

Windows 95, puis Windows 98, et Windows ME. Elle était plus connue du

grand public et avait pour vocation de remplacer, dont elle était une

évolution 32 bits.

4

http://fr.wikipedia.org/wiki/windows

visité le 15 juillet 2011 à 13h54

· La quatrième branche, apparue en 1996 avec

Windows CE, est destinée au système embarqué et

matériel léger et portable.

· Windows XP, sorti en 2001, continue la branche NT en

fusionnant, avec branche Windows 9x : elle couvre à la fois le grand

public et les professionnels, en deux versions différentes. Windows

Vista en est une nouvelle évolution.

b. GNU/Linux

GNU/Linux, où Linux5 est un

système d'exploitation basé sur le noyau Unix, un logiciel libre

créé en 1991par Linux Torvalds sur un ordinateur compatible PC.

Développé sur Internet par des milliers d'informaticiens

bénévoles et salariés, Linux fonctionne maintenant sur du

matériel allant du modem au superordinateur.

Il existe de nombreuses distributions Linux

indépendantes, destinées aux ordinateurs personnels et serveurs

informatiques, pour lesquels Linux est très populaire.

Elles incluent des milliers des logiciels, notamment ceux du

projet GNU, d'où la dénomination GNU/Linux basé sous la

licence GPL (Général Public Licence) GNU GPL.

La licence GPL est une licence rédigée par la

Free software Fondation, organisation dont le but est de développer des

logiciels libres, qui protège les logiciels libres et leurs auteurs.

Cette licence stipule que le logiciel libre peut être

redistribué, utilisé, modifié librement pourvu que celui

qui en bénéficie accorde les mêmes droits à ceux

qu'il distribue les copies du logiciel, modifié ou non.

Les dits « libres » sont caractérisés par

quatre (4) libertés :

1. la liberté de l'améliorer et de le diffuser au

public.

2. la liberté de redistribuer des copies de façon

à pouvoir aider votre besoin.

3. la liberté d'étudier le fonctionnement du

programme et de l'adapter à ses besoins.

5. la liberté d'utiliser le logiciel pour n'importe quel

usage.

Le système GNU/Linux est constitué d'un noyau Linux

et d'un ensemble de logiciels GNU basé sur ce noyau.

Le noyau est le logiciel qui s'occupe d'interagir avec le

matériel, de gérer

la mémoire, l'exécution des

logiciels et des différentes ressources de la

5

http://fr.wikipedia.org/wiki/windows

visité le 15 juillet 2011 à 15h35

machine ; le noyau GNU/Linux est actuellement à sa version

2.6

Le système GNU/LINUX présente les

caractéristiques générales suivantes :

· code source disponible : chaque personne peut avoir le

code source de son système GNU/LINUX et l'adapter à ses besoins

tout en respectant la licence GPL.

· Multi plateforme : le système GNU/LINUX peut

être utilisé sur différentes plates-formes compatibles

PC.

· Multitâches : le système GNU/LINUX permet la

gestion de plusieurs tâches (processeurs) en même temps.

· Multiutilisateurs : GNU/LUNIX permet la gestion de

plusieurs utilisateurs.

· Gestion multiprocesseurs : il peut gérer plusieurs

processeurs mis en parallèle.

· Gestion de consoles virtuelles : permet la gestion des

écrans ou des interfaces virtuels.

· Support d'un grand nombre de systèmes de

fichiers : grâce à son système de fichier virtuel,

GNU/LINUX peut gérer plusieurs types de système de fichier.

Méme la création d'un nouveau système personnalisé

par l'utilisateur.

· Implémentation complète de la pile TCP/IP :

il incorpore toute la pile des protocoles TCP/IP.

· Services réseaux SLIP, PPP, SMB : le protocole SMB

lui permet

d'effectuer des partages de fichier avec les systèmes

Windows.

· Interfaces graphiques : dispose d'une interface graphique

X-WINDOWS.

Pour une version donnée du noyau, il existe plusieurs

distributions linux. Une distribution linux est un ensemble cohérent de

logiciels rassemblant un système d'exploitation composé d'un

noyau linux et d'applications, la plupart étant des logiciels libres.

Les distributions facilitent l'installation du système GNU/LINUX en

sélectionnant les bons logiciels GNU pour un usage donné. Ainsi,

parmi ceux-ci, nous citons :

- Debian est une distribution non commerciale

régie par le contrat social Debian.

Flle se distingue par le très grand nombre

d'architectures supportées, son importante logithèque et par son

cycle de développement relativement long, gage d'une certaine

stabilité. Elle est très utilisée sur les serveurs.

- Fedora est une distribution communautaire

supervisée par Red Hat. Elle est très basée sur le

système de gestion de paquetages logiciels RPM.

- Red Hat (officiellement Red Hat Entreprise

Linux ou RHEL) est une distribution commerciale largement répandue dans

les entreprises (surtout aux Etats-Unis). La société Red Hat, qui

la supervise, a développé RPM, un gestionnaire de paquets sous

licence GPL que d'autres distributions utilisent.

- Mandriva Linux est une distribution

internationale éditée par la société Mandriva en

France et dans le monde. Très orientée vers le grand public, elle

est conçue pour être facile d'installer et d'usage, pour les

débutants et les professionnels.

- Gentoo est une distribution

caractérisée par sa gestion des paquetages à la

manière des ports BSD, effectuant généralement la

compilation des logiciels sur l'appareil de l'utilisateur. Elle est

dédiée aux utilisateurs avancés, aux développeurs

et aux passionnés.

- Slackware est l'une des plus anciennes

distributions existantes. Slakware a été historiquement une des

premières permettant de faire tourner GNU/LINUX depuis un CD-ROM.

- SuSE Linux a été la

première distribution européenne. Elle propose deux distributions

principales : SUSE Linux Entreprise orientée vers les entreprises et

OpenSUSE orientée vers le grand public.

- Ubuntu, basée sur Debian. Plus

orientée vers le grand public aussi sur les serveurs, édite des

versions stables plus fréquemment. Cette distribution dispose d'une

solide base d'utilisateurs en France, et partout ailleurs.

I.7. CONCLUSION PARTIELLE

La connaissance préalable d'une infrastructure

réseau et des applications est nécessaire pour acquérir la

maitrise globale d'un environnement réseau.

Ce chapitre vient de décrire les types de réseau

d'entreprise, Intranet et Extranet, d'éléments qui les

constituent, en partant des systèmes d'exploitation :

propriétaire et libre, des serveurs physiques et même des

applications ainsi que des moyens d'accès aux informations disponibles

dans l'intranet.

Le chapitre suivant parlera de la virtualisation dans le

réseau à infrastructure Intranet et expliquera la

nécessité de virtualiser les serveurs.

CHAPITRE II : LA VIRTUALISATION DES SERVEURS

DANS UN INTRANET

II .1. INTRODUCTION

La virtualisation, comme définit par

l'encyclopédie en ligne Wikipedia6, est « l'ensemble de

techniques matérielles et/ ou logiciels qui permettent de faire

fonctionner sur une seule machine plusieurs systèmes d'exploitation

et/ou plusieurs applications, séparément les uns et les autres,

comme s'ils fonctionnaient sur des machines physiques, distinctes ». Il

s'agit donc d'utiliser une seule machine physique en remplacement de plusieurs

dans un Intranet et d'utiliser les possibilités offertes par la

virtualisation pour démultiplier le nombre de machines virtuelles.

La virtualisation permet de faire des installations d'autres

systèmes sur une seule et méme machine physique. L'avantage est

de pouvoir lancer la machine que l'on désire faire fonctionner quand on

veut et de ne pas avoir un nombre important de machines avec chacune un

système d'exploitation. Il est possible de lancer plusieurs

systèmes en même temps mais il faut que les capacités

matérielles soient importantes notamment en processeur et

mémoire. Pour pouvoir gagner de la place dans la salle de serveurs,

faciliter les installations et les redémarrages après incidents,

sécuriser les systèmes, les entreprises y ont de plus en plus

recours.

Au-delà de la possibilité de faire fonctionner

des applications qui ne peuvent normalement pas s'exécuter sur une

machine donnée, la virtualisation permet aussi de les rassembler sur une

même machine physique, sans avoir à maintenir un serveur distinct

par application. Traditionnellement, l'usage était de consacrer une

machine physique à un service, c'est-à-dire, une machine physique

pour la messagerie, le stockage, l'hébergement Web, etc.,

Tant pour des raisons pratiques : associer une machine à

un rôle unique, que pour la Sécurité c'est-à-dire,

séparation des services. Toutefois, cette dispersion a un coüt qui

n'est pas nul pour l'entreprise, que ce soit en espace occupé, en

énergie c'est-à-dire consommation électrique ou en

maintenance : plus de machines physiques implique plus de risques des pannes

matérielles. De plus, la plupart de services

6 http ://

fr.wikipedia.org/wiki/virtualisation

visité le 18 juillet 2011 à 20h17'

fournis sur un réseau local (DHCP, DNS, Intranet,....)

ne consomment qu'une très petite partie des ressources offertes par une

machine récente. Tous ces facteurs font qu'il n'est pas pertinent

aujourd'hui d'utiliser des machines séparées pour héberger

des services nécessitant qu'une fraction de la puissance d'une machine.

Le schéma ci-dessous illustre l'infrastructure traditionnelle.

erveurs

A l'heure actuelle, la tendance est plutôt au

rassemblement de plusieurs services, autrefois distincts, sur une seule

machine, par le biais de l'utilisation des technologies de virtualisation pour

maintenir une séparation entre les services. On parle de consolidation

de serveurs7.

En outre, la virtualisation permet de réduire le nombre

de machines physiques à acheter, administrer et maintenir. Il y a donc

une économie financière à la clef, qui peut être

substantielle si l'entreprise a besoin de beaucoup de serveurs pour son

activité.

7 La consolidation de serveurs est une restructuration de

l'infrastructure d'une organisation en vu de réduire les

Postes de travail

coûts et améliorer le contrôle en optimisant

les besoins en ressources.

Fig.3. Infrastructure tradie: Type ntranet

En plus du simple gain en nombre de machines, les

économies réalisées en consommation

d'électricité, location d'espace dans un Datacenter sont aussi

à prendre en compte comme nous montre le schéma de la figure4

ci-dessous.

Les technologies de virtualisation sont donc très

intéressantes, car elles permettent de réduire le temps

passé à administrer les machines et systèmes en

automatisant et centralisant la plupart des activités

traditionnelles.

II .2. ÉVOLUTION DE LA VIRTUALISATION

Les premiers ordinateurs, qui occupaient plusieurs

pièces d'un bãtiment, n'étaient pas faits pour

exécuter plusieurs programmes à la fois. On concevait un

programme (qui était à l'époque une simple succession de

calculs), on le mettait dans la file d'attente des programmes, et quand le

système d'exploitation avait fini de traiter un programme, on lui

donnait le suivant dans la liste.

Très vite, dès la fin des années

cinquante, l'idée de pouvoir exécuter plusieurs programmes en

parallèle voit le jour. On parle de temps partagé (time

sharing), de multiprogrammation, etc. L'idée était de

pouvoir faire cohabiter plusieurs programmes au même moment, ayant tous

accès au méme matériel, sans qu'ils ne se génent

mutuellement.

La virtualisation est très proche de concept.

Au milieu des années soixante, IBM effectue des

recherches sur les systèmes virtualisés avec le projet M44/44X.

L'architecture du système se basait sur des systèmes

d'exploitation virtualisés (nommés 44X) s'exécutant

au-dessus du matériel (une machine M44).

Les systèmes invités étaient

gérés par une simple multiprogrammation. En 1967 est

lancé, toujours par IBM, le système CP-40, le premier

système offrant une virtualisation complète. Le CP-40 sera suivi

par plusieurs évolutions, amenant chacune de nouvelles

fonctionnalités pour les utilisateurs. On peut notamment citer le

système VM/370, qui a connu un très fort succès dans les

entreprises, et est parfois encore en usage dans certaines entreprises

aujourd'hui.

Après le succès des machines virtuelles

introduites par IBM, les technologies ont assez peu évolué. Le

système hôte a vite été réduit à

l'état de simple arbitre entre les systèmes invités,

amenant la notion d'hyperviseur. Toutefois, toutes ces technologies de

virtualisation étaient réservées au monde professionnel,

destinées à être utilisées sur des

mainframes coûtant plusieurs millions de dollars.

Parallèlement à cela, le monde de la recherche

(souvent financé par ces mêmes entreprises) a continué

à étudier différentes possibilités pour

améliorer les performances et à essayer de nouvelles

technologies. La plupart de ces travaux de recherche sont toutefois

restés assez confidentiels et n'ont que rarement été

transposés sur un produit.

L'orientation « grand public » des technologies de

virtualisation est beaucoup plus récente. Dans les années

quatre-vingt-dix, l'intérêt pour les émulateurs de consoles

de jeu ainsi que l'explosion du marché de l'informatique personnelle

(les ordinateurs de type PC) ont fait prendre conscience aux entreprises qu'il

y avait un marché pour la virtualisation sur PC. Des

sociétés ont alors commencé à créer des

produits de virtualisation basés sur des machines virtuelles pour les

« petites » entreprises c'est à dire celles ne pouvant

s'offrir des serveurs à plusieurs millions de dollars et pour les

particuliers.

À partir de ce moment-là, les technologies ont

vraiment progressé, avec l'arrivée des nouveaux acteurs toujours

prêt à innover pour se démarquer des concurrents.

Prenons l'exemple d'une solution de virtualisation faite pour

le grand public, de type VMware : l'utilisateur possède un seul

ordinateur, sur lequel est installé un système d'exploitation

(Microsoft Windows, GNU/Linux, Mac OS X, etc.) ainsi qu'une application qui

fait office de machine virtuelle : le logiciel installé par VMware.

L'utilisateur peut à partir de son système d'exploitation

appelée aussi système hôte, démarrer un nouveau

système d'exploitation qui peut être totalement différent

de celui installé sur la machine physique.

Le système d'exploitation virtualisé

appelé système invité (guest system) est alors

exécuté par la machine virtuelle, et complètement

détaché de tout le matériel de l'ordinateur. La machine

virtuelle se charge d'émuler pour le système invité tout

le matériel « standard » d'un ordinateur : disque dur,

écran, clavier, souris, etc. L'utilisateur peut alors utiliser le

système invité comme normal : installer l'application, naviguer

sur Internet, exécuter un programme, etc. Le système hôte

installé sur la machine physique et le système invité sont

totalement indépendants : le système invité est vu par

l'hôte comme un simple programme, il n'a pas d'accès direct au

matériel contrairement à l'hôte.

Aujourd'hui, les solutions de virtualisation couvrent

principalement deux domaines : les systèmes de stockage

et les systèmes serveurs. Dans le cas des environnements de stockage, la

virtualisation est utilisée par les administrateurs pour gérer

les différentes ressources par une vue unique virtuelle. Par cette vue,

ils gèrent de façon centralisée l'espace disponible

indépendamment des technologies utilisées SAN, NAS, etc. La

virtualisation des systèmes serveurs répond à un objectif

similaire. Les entreprises en ont recours pour disposer d'une vue

générale sur l'utilisation de leurs ressources machines. Ils

peuvent ainsi découper un serveur physique en des multiples serveurs

logiques, dont

chacun se verra attribuer une tâche différente. Les

vues virtuelles ne tiennent pas compte des technologies exécutées

par la machine.

II.3. LA MACHINE VIRTUELLE

Une machine virtuelle est un ordinateur logiciel qui, à

l'instar d'un ordinateur physique, exécute un système

d'exploitation et des applications. La machine virtuelle se compose d'un

ensemble de fichiers de spécification et de configuration ; elle est

secondée par les ressources physiques d'un hôte. Chaque machine

virtuelle a des périphériques virtuels qui fournissent la

même fonction que le matériel physique et présentent un

intérêt supplémentaire en terme de portabilité,

maniabilité et sécurité. La figure 5 ci-après

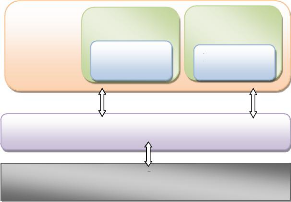

illustre une machine virtuelle.

Fig.5. illustration d'une machine virtuelle

Un ordinateur virtuel est constitué des composants

suivants :

> Une fenêtre dans laquelle l'ordinateur virtuel

s'exécute. Chaque ordinateur virtuel est doté de

paramètres qui déterminent sa relation de fonctionnement avec le

système d'exploitation hôte, tels que la quantité de

mémoire vive allouée à l'ordinateur virtuel ou les

affectations des ports COM1 et COM2. Virtual PC possède également

des options globales qui affectent tous les ordinateurs virtuels.

> Un fichier de configuration d'ordinateur virtuel

(.vmc), qui contient

toutes les informations de configuration d'un ordinateur

virtuel.

> Un fichier qui représente le disque dur de

l'ordinateur virtuel, appelé disque dur virtuel. Les disques durs

virtuels ont une

extension .vhd. Par défaut, ce disque

est un fichier de taille dynamique dont la taille augmente à mesure que

vous y installez des applications ou que vous y stockez des données.

Vous pouvez sélectionner différents types de disques durs

virtuels et configurer pour l'ordinateur virtuel jusqu'à trois disques

durs virtuels différents, afin qu'il bénéficie de plus

d'espace de stockage.

> Un système d'exploitation installé sur le

disque dur virtuel. Il peut s'agir de quasiment n'importe quel système

d'exploitation compatible avec les ordinateurs x86.

> Du matériel émulé et des

périphériques externes, tels que clavier, souris, CD, DVD,

disquette, carte audio, ports, imprimantes et autres

périphériques utilisés par l'ordinateur virtuel pour

émuler un ordinateur physique.

II.4. INTÉRÊT DE LA

VIRTUALISATION Les intérêts de la virtualisation

sont :

> utilisation optimale des ressources d'un parc de machines

c'est-àdire la réparation des machines virtuelles sur les

machines physiques en fonction des charges respectives ;

> installation, déploiement et migration facile des

machines virtuelles d'une machine physique à une autre, notamment dans

le contexte d'une mise en production à partir d'un environnement de

qualification ou de pré production, livraison facilitée ;

> économie sur le matériel par mutualisation

: consommation électrique, entretien physique, monitoring, support,

compatibilité matérielle, etc. ;

> installation, tests, développements,

réutilisation avec possibilité de recommencer, arrêt du

système hôte sans déranger les autres machines ;

> sécurisation et /ou isolation d'un réseau

(arrét des systèmes d'exploitation virtuels, mais pas des

systèmes d'exploitation hôtes qui sont invisibles pour

l'attaquant, tests d'architectures applicatives et réseau) ;

> isolation des différents utilisateurs

simultanés d'une méme machine ;

> allocation dynamique de la puissance de calcul en fonction

des besoins de chaque application à un instant donné :

> diminution des risques liés au dimensionnement des

serveurs alors de la définition de l'architecture d'une application.

II.5. CONTRAINTE DE LA VIRTUALISATION

Bien que la virtualisation nous amène plusieurs avantages,

nous allons évoquer ici quelques inconvénients :

a. Plusieurs serveurs virtuels sont sur une seule machine

physique, C'est un risque potentiel ;

b. Si une VM a un problème de performance (100% CPU)

alors les autres serveurs sont affectés (plus ou moins)

c. Perte de performance pour les disques durs

d. La facilité de création de VM implique une

surconsommation des ressources

Ces inconvénients peuvent bien sûr être

réglés par l'application de bonnes règles de gestion des

machines virtuelles.

II.6. TECHNOLOGIES DE LA VIRTUALISATION

Il existe plusieurs catégories de virtualisation,

utilisant chacune des technologies différentes. Les technologies les

plus répandues sont :

> la virtualisation complète ou machine virtuelle ;

> la para virtualisation ;

> la virtualisation assistée par le matériel ou

hyperviseur ; > le cloisonnement ou isolation.

Chacune de ces technologies est une technologie de

virtualisation, mais elles ne fonctionnent pas de la même façon.

Les principes et particularités de chaque technologie seront

détaillés dans les pages suivantes.

II.6.1. La virtualisation complète ou machine

virtuelle

La virtualisation complète en anglais « full

virtualisation » est une technologie qui consiste à émuler

l'intégralité d'une machine physique pour le système

invité. Le système invité « croit »

s'exécuter sur une véritable machine physique. Le logiciel

chargé d'émuler cette machine s'appelle « une machine

virtuelle », son rôle est de transformer les instructions du

système invité en instruction pour le système hôte.

Ainsi, la machine virtuelle est un programme comme un autre du point de vue du

système hôte, au méme titre qu'un navigateur Internet ou

traitement de texte.

Les programmes utilisateur n'ont pas d'accès direct au

matériel, mais uniquement aux couches d'abstraction. La machine

virtuelle émule donc de manière logique tout le matériel

habituel de l'architecture pour le système invite, ce dernier croit

dialoguer directement avec l'édit materiel comme nous montre la figure 6

ci-dessous.

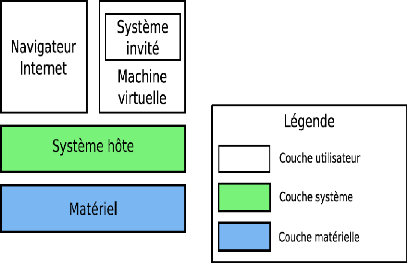

Fig. 6. Emulation des couches virtuelles

Cet empilage de couches est sensiblement identique pour tous

les peripheriques emules par la machine virtuelle. On retrouve. Du plus bas au

plus haut niveau :

1. Le materiel.

2. Le pilote du materiel pour le système hôte,

3. La couche d'abstraction du système hôte,

4. Le materiel emule par la machine virtuelle,

5. Le pilote du materiel pour le système invite,

6. La couche d'abstraction du système invité,

Le disque dur de la machine virtuelle est la plupart du temps

gere comme un volumineux fichier pour le système hôte, alors que

la memoire vive dont le système invite dispose, est reservee par le

programme de la

machine virtuelle. Le reste de l'architecture de l'ordinateur

peut varier grandement selon les implémentations, mais on retrouve

généralement au moins une carte réseau, un clavier

standard et une carte graphique.

Les systèmes s'exécutant dans la machine

virtuelle est un système d'exploitation à part entière,

tel qu'on pourrait en installer sur une machine physique : Microsoft Windows,

GNU/Linux, Mac OS X. etc. Cette particularité est la

caractéristique principale de la virtualisation complète : les

systèmes invités n'ont pas à être modifiés

pour être utilisés dans une machine virtuelle utilisant une

technologie de virtualisation.

Le système invité à son tour peut

exécuter n'importe quel programme prévu pour ce système,

dans la mesure où il ne nécessite pas de matériel non

fourni par machine virtuelle. Cette possibilité est due au fait que le

système d'exploitation sert (entre autres) de couche d'abstraction entre

le matériel et les applications s'exécutant par -dessus

fonctionneront aussi. Cette technique isole bien les systèmes

invités, mais elle a un coût en performance et en temps. Ces

performances sont donc limitées par les performances de la couche

d'abstraction du système hôte et par la qualité de

l'émulation du matériel implémenté. En effet, la

machine virtuelle ne peut pas, dans la plupart de cas, exécuter

directement les instructions du système invité sur le

système hôte.

Les instructions de manipulation de la RAM8, par

exemple, doivent être interprétées par la machine virtuelle

pour aboutir au résultat attendu, car c'est le processeur de la machine

virtuelle qui est censé s'occuper de la gestion physique de la

mémoire, et non le processeur de la machine hôte.

La machine virtuelle doit donc implémenter en logiciel

une gestion complète de la mémoire de l'invité, en

utilisant les couches d'abstraction de l'hôte pour accéder

à la mémoire centrale.

Cet empilement de couches réduit significativement les

performances, surtout en cas de forte pression sur la mémoire comme par

exemple quand la mémoire est utilisée de manière intensive

: lecture, écriture, déplacement de données,

etc. la figure 7 détaille les couches

d'abstraction entrant en jeu pour la gestion de la mémoire.

En échange cette technique permet de faire cohabiter

plusieurs systèmes invités hétérogènes sur

une même machine grâce à une isolation complète.

8 La RAM (Random Access Memory) ou mémoire vive de

l'ordinateur est une mémoire volatile et à accqs aléatoire

dans la quelle un ordinateur place les données lors de leur

traitement.

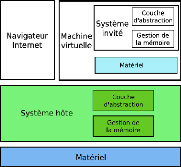

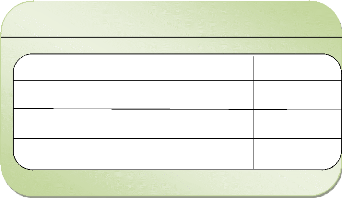

Fig.7. couche d'abstraction pour la gestion de la

mémoire

Du fait de l'empilement de couches d'abstraction et

l'impossibilité pour la machine virtuelle d'accéder directement

au matériel, les performances du système invité sont assez

éloignées de celles d'un système « natif ».

Selon les implémentations, diverses solutions sont utilisées pour

accélérer les machines virtuelles, par exemple en passant la

plupart des instructions destinées au processeur virtuel directement au

processeur physique. Cela accélère la vitesse de calcul du

système invité.

Il reste cependant le problème des

Entrées/Sorties (E/S), c'est-à-dire les accès au disque,

à la RAM, à la carte graphique, à la carte réseau,

etc. D'une manière générale, on appelle Entre/Sorties (I/O

Input/Output) tout ce qui intervient pour transférer des informations ou

des données entre un périphérique et le système

d'exploitation. Les E/S sont beaucoup plus dures à optimiser, car chaque

système a une façon propre de gérer cela. Il faut donc

cohabiter étroitement à la fois avec le système hôte

pour accès réel au matériel et avec le système

invité pour que ses accès au matériel soient le plus

rapide possible. Cela amène une plus grande complexité de code,

et une séparation en couches moins marquée que dans le

modèle vu sur la figure 6. Cette « rupture » dans le

modèle en couches est exploitée par une autre technologie de

virtualisation appelé « Para- virtualisation »

II.6.2. La para virtualisation

La paravirtualisation (paravirtualization ou en

coreparavirtualization) est très proche du concept de la

virtualisation complète, dans le sens où c'est toujours un

système d'exploitation complet qui s'exécute sur le

matériel émulé par une machine virtuelle, cette

dernière s'exécutant au-dessus d'un système hôte.

Toutefois, dans une solution de paravirtualisation, le système

invité est modifié pour être exécuté par la

machine virtuelle. Les modifications effectuées visent à rendre

le système émulé « au courant » du fait qu'il

s'exécute dans une machine virtuelle. De ce fait, il pourra collaborer

plus étroitement avec le système hôte, en utilisant une

interface spécifique, au lieu d'accéder au matériel

virtuel via les couches d'abstraction. Au final, l'architecture obtenue est

plus performante que l'empilement de couches d'abstraction de la figure 7.

En pratique, un système paravirtualisé

possède quelques pilotes de périphériques et

sous-systèmes modifiés, qui lui permettent de communiquer

directement avec la machine virtuelle, sans avoir passé par une couche

d'abstraction pour parler au matériel virtuel. Les pilotes

paravirtualisés échangent directement des données avec la

machine virtuelle, sans avoir à passer par une émulation du

comportement du matériel. Les parties du système hôte

généralement modifiées pour tirer profit de la

paravirtualisation sont la gestion de la mémoire et la gestion des E/S.

En effet, ce sont véritablement les deux goulets d'étranglement

d'un système virtualisé, du fait du nombre de couches

d'abstraction à traverser. Il est donc logique que les optimisations se

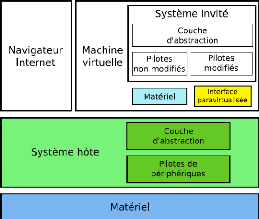

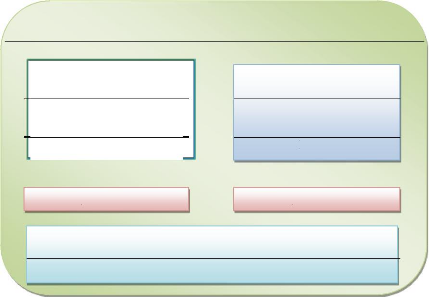

portent là-dessus. La figure 8 montre la structure d'une machine

virtuelle et d'un système hôte supportant la paravirtualisation.

Les pilotes non modifiés interagissent toujours avec le matériel

émulé par la machine virtuelle (rectangle bleu ciel), alors que

les pilotes modifiés communiquent directement les fonctions de la

machine virtuelle (rectangle jaune). La simplification qui en résulte

permet au système invité de collaborer plus efficacement avec

l'hôte : les parties critiques du système communiquent presque

directement avec le système hôte, en contournant les couches

d'abstraction virtuelles (i.e. le matériel

émulé). Le reste de l'architecture est inchangé, la

machine virtuelle est toujours une application utilisateur (rectangle blanc) et

le système d'exploitation (Rectangle vert) est toujours le seul à

avoir un accès privilégié au matériel (rectangle

bleu).

Fig.8. couche d'abstraction pour la gestion de la

mémoire

Les détails sur comment sont réalisées

ces optimisations varient selon les implémentations, mais il s'agit en

général pour le système invité d'utiliser des

appels systèmes ou des instructions spécifiques pour renseigner

la machine virtuelle sur les actions à entreprendre.

Cette dernière réalise alors ces actions, et

communique le résultat au système invité. Le type d'action

à effectuer varie également selon les implémentations,

mais on retrouve en général tout ce qui est déplacement de

données entre l'hôte et l'invité (accès disque,

transfert réseau, etc.) et gestion de la mémoire.

La paravirtualisation apporte un gain de performances

avéré, du fait du contournement des couches d'abstraction. En

effet, comme le système invité collabore activement avec la

machine virtuelle, il ne se comporte plus comme un système

d'exploitation à part entière s'exécutant directement sur

du matériel. Au contraire, il adapte son comportement pour que les

accès au matériel souvent difficiles à interpréter

de manière efficace par la machine virtuelle soient transformés

en des appels directs à cette dernière. De plus, étant

donné que seules les couches de bas niveau du système

invité ont été modifiées, toutes les applications

qui pouvaient fonctionner dans une architecture de virtualisation

complète peuvent aussi être utilisées dans une architecture

paravirtualisée.

Toutefois, cette augmentation des performances est restreinte

à certains systèmes. En effet, comme le système

invité doit être modifié9 pour être

paravirtualisé, il faut bien évidemment que l'on ait la

possibilité de réaliser cette opération de portage. Or,

cela nécessite à la fois l'accès au code source du

système d'exploitation et la permission du détenteur des droits

de le modifier. Si cela ne pose aucun problème pour un système

libre (notamment GNU/Linux et les systèmes BSD), il n'en va pas de

même pour les systèmes propriétaires, tels que Microsoft

Windows et Mac OS. L'usage de la paravirtualisation est donc

généralement limité aux systèmes libres, sauf

à utiliser une solution de virtualisation propriétaire compatible

avec un seul système d'exploitation invité, comme les produits

que Microsoft propose pour ses systèmes d'exploitation.

Tout comme la virtualisation complète, la

paravirtualisation garde une séparation nette entre le système

invité et le système hôte. De ce fait, seul le

système hôte a un accès direct et exclusif au

matériel. Le système invité doit donc toujours passer par

la machine virtuelle pour accéder au matériel, qui passe à

son tour par la couche d'abstraction. On peut donc améliorer davantage

le processus en laissant au système invité un accès direct

mais contrôlé au matériel. C'est le but des systèmes

à « hyperviseur ».

II.6.3. Le Système a Hyperviseur

Un hyperviseur est une plate-forme de virtualisation qui

permet à plusieurs systèmes d'exploitation de travailler sur une

machine physique en même temps. L'Hyperviseur est un noyau hôte

allégé et optimisé pour ne faire tourner que des noyaux

des systèmes invités adaptés et optimisés pour

tourner sur cette architecture spécifique, les systèmes

invité ayant conscience d'être virtualisés.

L'utilisation d'un hyperviseur est en quelque sorte

l'évolution logique de la paravirtualisation, l'on recherche encore une

amélioration des performances. Dans les technologies

précédentes, le système hôte était le seul

à avoir un accès direct au matériel ; avec hyperviseur, le

système hôte partage cet accès avec les systèmes

invités.

9 On parle de portage, de la même manière qu'on

porte un système ou une application vers une nouvelle architecture

matérielle.

Au démarrage de l'ordinateur, c'est normalement le

système d'exploitation qui prend la main et contrôle le

matériel. Dans le cas de l'utilisation d'un hyperviseur, c'est un

système minimaliste, l'hyperviseur, qui prend le contrôle du

matériel. Ensuite, il fait appel à un système

d'exploitation complet, qui sera donc exécuté par-dessus

l'hyperviseur.

Ainsi, le système d'exploitation doit passer par

l'hyperviseur pour tout accès au matériel. On peut donc

très facilement installer un deuxième système

d'exploitation, qui passera lui aussi par l'hyperviseur pour l'accès au

matériel. Comme les systèmes d'exploitation doivent

obligatoirement passer par ce dernier pour tout accès au

matériel, l'hyperviseur peut assurer qu'ils n'accèdent qu'aux

ressources autorisées, sans perturber le fonctionnement des autres

systèmes.

A la différence des deux technologies vues

précédemment, la virtualisation complet et la paravirtualisation,

l'hyperviseur est le seul à un accès privilégié au

matériel. Il n'y a cette fois pas d'accès direct au

matériel pour le système d'exploitation, uniquement une couche

d'abstraction minimale fournie par l'hyperviseur comme illustre la figure 9

ci-dessous.

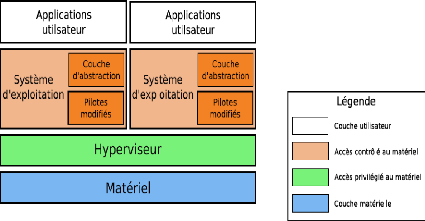

fig. 9. virtualisation par Hyperviseur

Sur la figure 9, les systèmes cohabitent au même

niveau de privilège,

uniquement régulés par

l'hyperviseur. Chaque système d'exploitation a un

accès

presque direct au matériel, par l'intermédiaire de l'hyperviseur.

Il n'y

a donc plus de couche d'abstraction logicielle, le

matériel accessible est celui de la machine physique, avec toutes les

fonctionnalités qu'il peut offrir. Le gain de performance est

significatif, notamment dans le cas des E/S, où le système peut

utiliser toutes les extensions des périphériques pour

accélérer les transferts.

Du point de vue privilège, et selon certaines

implémentations, il y a souvent un système

privilégié, qui est en général le premier

système démarré par l'hyperviseur. Ce système est

alors autorisé à modifier les paramètres de l'Hyperviseur

ou à installer des nouveaux systèmes invités. A

l'opposé, sur d'autres implémentations, la différence

entre hôte et invité est inexistante, tous les systèmes ont

les mêmes privilèges et l'Hyperviseur est alors

contrôlé d'une autre manière.

Les systèmes à hyperviseur contrôlent de

façon plus fine l'accès au matériel et l'utilisation des

ressources. Au niveau de l'hyperviseur, on veillera donc qu'un système

ne dérange pas les autres en consommant trop de ressources, alors que

dans le système de virtualisation complète, on s'assurera qu'un

programme utilisateur ne dérange pas la machine virtuelle qui

exécute les autres systèmes d'exploitation en tant que

systèmes invités. Tous les systèmes destinés

à s'exécuter au-dessus d'un hyperviseur doivent être

portés10, comme les systèmes invités pour la

paravirtualisation. Cette opération vise à adapter les couches

basses du niveau système d'exploitation pour qu'elles communiquent avec

l'hyperviseur plutôt qu'avec le matériel.

Les inconvénients sont donc les mêmes que pour la

paravirtualisation : il est nécessaire d'avoir accès au code

source de tous les systèmes ainsi que l'autorisation du détenteur

des droits. En outre, le portage est beaucoup plus lourd à

réaliser pour fonctionner sur un hyperviseur. En effet, pour la

paravirtualisation, seuls quelques pilotes et sous-systèmes avaient

besoin d'être réécrits pour tirer parti de

l'accélération. Au contraire, un hyperviseur nécessite la

modification de toutes les couches d'accès au matériel ; la

complexité du code s'en trouve grandement augmentée. Le portage

sur un hyperviseur revient quasiment à porter le système

d'exploitation sur une nouvelle architecture matérielle. Les

technologies vues jusqu'alors présentent une complexité

croissante quant à la mise en oeuvre. Cependant les technologies que

proposent le cloisonnement ou l'isolation sont différentes.

10 Un portage est l'adaptation d'un programme dans un

environnement autre que son environnement d'origine. Dans le domaine du jeu

vidéo, on parle de portage lorsqu'un jeu est adapté d'un

système à un autre ; (source :

http://fr.wikipedia.org/wiki/portage#Informatique

visité le 25 juillet 2011 à 17h14.

II.6.4. Le cloisonnement ou l'isolation

Un isolateur est une couche logicielle permettant d'isoler des

applications dans ces contextes d'exécution différentes. Cette

technique est très en performance (native), mais le cloisonnement des

environnements virtualisés reste en général imparfait.

Le cloisonnement vise à isoler chaque processus dans un

conteneur dont il est théoriquement impossible de sorti. Un processus

isolé de la sorte ne saura pas quels autres processus l'exécutent

sur le méme système, et n'aura qu'une vision limitée de

son environnement. Le but principal de cette technologie est d'améliorer

la sécurité du système d'exploitation et des applications.

Cette technologie est performante, mais les environnements virtualisés

ne sont pas complètement isolés.

Les « machines virtuelles » ici, les environnements

sont forcément issues du méme système d'exploitation. La

performance est donc au rendezvous mais le choix on ne peut pas vraiment parler

de virtualisation de systèmes d'exploitation. La figure 10,

décrit le processus de virtualisation avec le cloisonnement.

Application

De controle

Linux VSERVER

Proccess

isolé

Système hote

Matériel

Linux VSERVER

Proccess isolé

Fig.10. Virtualisation par cloisonnement

Uniquement liés aux systèmes linux, les

isolateurs sont en fait composés de plusieurs éléments et

peuvent prendre plusieurs formes. La plupart de systèmes d'exploitation

basés sur UNIX proposent un moyen d'isoler les processus. Le plus

répandu (et le plus ancien) est la commande chroot, qui permet

de créer un environnement minimal

contenant uniquement ce qui est strictement nécessaire

pour exécuter le programme isolé. Les systèmes

basés sur BSD comme OpenBSD, NetBSD, freeBSD proposent aussi

jail (prison), qui est une évolution de chroot, plus

sure, plus complète et plus souple dans son utilisation.

L'UNIX11 de Sun Microsystems, Solaris, propose un

système de zone très évolué, plus proche

d'une machine virtuelle que d'une simple isolation des processus. Toutes ces

technologies ont en commun le fait de conserver exactement la meme instance du

système d'exploitation accessible aux processus isolés. Ainsi, on

ne pourra pas avec le cloisonnement proposer un système d'exploitation

différent pour un processus isolé.

Les technologies de cloisonnement sont aussi utilisées

dans d'autres domaines que les systèmes d'exploitation. Par exemple, le

langage Java de Sun Microsystems propose une machine virtuelle, qui n'a rien

à voir avec les machines virtuelles étudiées ici signalons

le, qui est un interpréteur pour le langage Java. Cet

interpréteur exécute tous les programmes Java dans un conteneur

isolé, dont ils ne peuvent pas sortir.

II.7. LES ACTEURS DE LA VIRTUALISATION

Les acteurs principaux dans le domaine de la virtualisation

sont partagés entre les très grandes technologies de

virtualisation vues précédemment.

Les acteurs les plus connus dans le domaine des grands

systèmes ou mainframes sont IBM qui a un fort historique de

virtualisation, HP, Sun, Bull, etc. Toutes ces sociétés

fournissent des systèmes de virtualisation fonctionnant exclusivement

avec leur propre architecture matérielle. Les technologies

utilisées différent selon les systèmes, mais en

général ce sont des technologies à base de virtualisation

complète ou d'hyperviseur.

Dans les architectures de type PC, il y a plus de

sociétés proposant des produits et donc plus d'offres de

virtualisation. On peut notamment citer Microsoft, qui a racheté la

solution de virtualisation de connectix en février 2003. Ce rachat a

ensuite donné lieu à la diffusion de Virtual PC et Virttual

Server, produit permettant de virtualiser des

11 Unix est un systIme d'exploitation

multiutilisateur, multit~ches, ce qui signifie qu'il permet à un

ordinateur mono ou multiprocesseurs de faire exécuter

simultanément plusieurs programmes par un ou plusieurs utilisateurs.

systèmes à base de Windows, respectivement pour

un ordinateur personnel et pour un serveur. Microsoft travaille aussi avec

Citrix Systems pour développer un hyperviseur pour la

virtualisation des serveurs sur Windows Serveur 200812.

La société VMware édite plusieurs

produits à destination des entreprises souhaitant virtualiser leurs

serveurs, qui couvrent sensiblement les mêmes applications que les

solutions de Microsoft, mais avec en plus la possibilité de faire

fonctionner leurs produits avec le système GNU/Linux en tant que

système hôte.

Ces deux sociétés fournissent des solutions

propriétaires destinées aux particuliers et aux entreprises. Les

technologies utilisées sont soit de la virtualisation complète

soit de la paravirtualisation, en fonction des produits et systèmes.

Du côté de la communauté du logiciel

libre, il y a énormément de projets de virtualisation, ayant des

buts variables. Certains d'entre eux sont soutenus par une

société, qui fournit un service payant pour les clients le

souhaitant.

Les plus connus sont :

> Bochs (prononcer « box ») Bochs

est un émulateur très complet de l'architecture PC traditionnelle

(processeur Intel) ;

> KVM soutenu par la société

Qumranet, KVM se veut une

solution de virtualisation performante et facile à

administrer ;

> Linux-VServer projet de virtualisation

destiné à fonctionner sur

le système d'exploitation GNU/Linux ;

> Open VZ soutenu par la

société Virtuozzo, Open VZ est une solution de virtualisation

visant à obtenir les meilleures performances possibles ;

> QEMU créé et

développé par Fabrice BELLARD, QEMU est un projet visant à

offrir une machine virtuelle complète pour plusieurs architectures

matérielles, y compris l'architecture PC ;

> Xen soutenu par la société

Xensource, Xen vise à proposer une

solution performante pour la virtualisation de serveurs ;

12 Signalons que Microsoft collabore avec XenSource (Citrix

Systèmes) pour développer le système de virtualisation par

l'hyperviseur Xen sur Windows 2008 Serveur. Source :

http://www.microsoft.com/france/interop/news/fr/07-17MSXenSourcePR.mspx

23 juillet 2011 à 19h20'

Ces solutions de virtualisation utilisent les

différentes technologies étudiées : la virtualisation

complète, la paravirtualisation, les systèmes à

hyperviseur, et l'isolement ; et sont tous à des états

d'avancement différents, certains sont d'ores et déjà

utilisables en production alors que d'autres sont encore en phase de

développement.

Dans la suite de notre travail, nous ferons une étude

approfondie de chaque solution de virtualisation du monde libre.

II.8. CONCLUSION PARTIELLE

Dans ce chapitre nous venons de voir la virtualisation et son

importance, les différents types de virtualisations et leurs

applications ainsi que les différents acteurs de la virtualisation. Le

chapitre suivant nous parlera de différentes solutions de virtualisation

des serveurs.

CHAPITRE III. : LES SOLUTIONS DE VIRTUALISATION DES

SERVEURS

III.1. INTRODUCTION

Il existe plusieurs solutions de virtualisation dans le monde

libre sous GNU/Linux. Dans ce chapitre, nous ne verrons que les solutions le

plus en vogue et qui se basent sur les technologies vues dans le chapitre II.

Outre Bochs et VMware Serveur basé sur la virtualisation complète

c'est-à-dire que ces logiciels sont capables d'émuler le

processeur, le BIOS et les périphériques usuels :

Entrées/Sorties, nous parlerons que de QEMU, KVM, Linux-VServer, OpenVZ,

Xen.

III.2. VIRTUALISATION AVEC QEMU III.2.1.

Aperçu sur QEMU

QEMU

Virtualization complete

Paravirtualisation

Hyperviseur

x

Cloisonnement

QEMU est une machine virtuelle ou

émulateur de système, libre qui permet de faire tourner un ou

plusieurs systèmes d'exploitation13 ou seulement des

processus sur un système d'exploitation déjà

installé sur la machine. QEMU utilise la virtualisation complète

et isolée sur une même machine physique comme illustre la figure

11.

Fig. 11. Solution avec QEMU

13

http://fr.wikipédia.org/wiki/QEMU,

http://www2.wwweball.com/wiki/page.php/QEMU

visité le 25 juillet 2011 à 19h30'

QEMU fonctionne sur les plateformes x86-64, PPC, Sparc

et ARM et sous les systèmes d'exploitation Linux, FreeBSD,

NetBSD, OpenBSD, Mac OS X, Unix et Windows. Les systèmes invités

partagent ainsi les ressources de la machine physique et n'ont pas «

conscience » d'être virtualisés. Ils n'ont donc pas besoin

d'être adaptés pour fonctionner sur QEMU.

QEMU est un module pour le noyau linux qui

permet d'accélérer l'émulation sur les systèmes

d'exploitation linux en contournant certaines couches d'abstraction du

système se rapprochant ainsi des performances natives du système

hôte lorsque le processeur ne possède pas de fonctions

matérielles dédiées à la virtualisation. QEMU

permet d'exécuter le code de l'instance virtuelle de système

d'exploitation invité directement sur le processeur hôte comme

nous montre la figure 12.

Applications utilisateur

Système

invite

QEMU X86

Pilotes

Système Hôte: Linux, Windows

QEMU

Matériel

A hit

Applications utilisateur

Système invite

QEMU X86

Pilotes

Fig.12. La technologie QEMU

Le système invité est géré comme

une image disque complète par le système hôte et grossit au

fur et à mesure que le système invité remplit l'espace

réservé à la création.

III.2.2. La Gestion du réseau par QEMU

QEMU offre plusieurs modes de fonctionnement

pour la connexion de système invité au réseau.

La première méthode, la plus simple, consiste

à laisser un accès limité au réseau depuis la

machine virtuelle. Dans ce mode, appelé user mode networking,

QEMU offre un réseau privé au système

invité, et filtre les communications. Du point de vue du système

invité, il y a un réseau privé simple, avec un serveur

DHCP qui attribue dynamiquement des adresses

IP et une passerelle pour accéder à Internet. Ce mode

est totalement indépendant du système hôte, le DHCP et la

passerelle sont émulés par QEMU.

Le déroulement du processus est le suivant :

1. QEMU est initialisé en user mode Networking ;

2. Le système invité démarre ;

3. à l'initialisation du réseau, le système

invité effectue une requête DHCP pour configurer la carte

réseau ;

4. la pile user mode de QEMU répond à la

requête DHCP et attribue une adresse IP à la carte réseau

du système invité ;

5. une fois la carte configurée, le système

invité peut émettre du trafic sur le réseau virtuel, comme

s'il était connecté à un véritable réseau

;

6. quand le système invité émet du trafic,

QEMU récupère le trafic réseau et le passe au