|

ENSEIGNEMENT SUPERIEUR ET UNIVERSITAIRE

INSTITUT SUPERIEUR

PEDAGOGIQUE DE KAZIBA

I.S.P/KAZIBA

SECTION DES SCIENCES EXACTES

DÉPARTEMENT DE

MATHÉMATIQUE-PHYSIQUE

Prédiction de Durée De Séjour

hospitalier

en Gynécologie basée sur le Machine

Learning : Cas de quelques hôpitaux au

Sud-Kivu

Présenté par : CUBAKA ZAHINDA

René

Mémoire présenté et défendu pour

l'obtention du diplôme de Licence en Pédagogie Appliquée

Option : Mathématique-Physique

Directeur : Prof. Dr. ZIHINDULA MUSHENGEZI

Elie

Encadreur : CT. AMBO AMANDURE

Jean-Médard

ANNéE ACADéMIQUE : 2022-2023

Epigraphe

Change is the end result of all true learning

-- Leo Buscaglia Écrivain, professeur

d'éducation

Research is to see what everybody else has seen, and to think

what nobody else has thought -- Albert szent-Györgyi

Prix Nobel de physiologie ou médecine

I

René CUBAKA ZAHINDA

Dédicace

A toute personne vouée du bon sens dans ce monde

cassé A tous les amoureux de l'Intelligence Artificielle

Je dédie ce travail !!!

II

René CUBAKA ZAHINDA

III

Remerciements

Le présent travail n'est pas seulement le fruit d'un

labeur individuel, mais aussi celui

de plusieurs personnes que je tiens à remercier. Parmi

les personnes qui ont collaboré à la

réalisation de ce travail en offrant soit un support

moral, soit un support technique je

pense particulièrement à ma famille, à

mes amis et à mes collègues.

Sans doute, des personnes auront été,

involontairement oubliées dans l'énumération

suivante, je tiens en premier lieu à remercier mon Dieu

tout puissant, le créateur de

l'univers.

J'exprime toute ma reconnaissance à l'équipe de

direction de ce travail notamment le

Prof. Dr. ELIE ZIHINDULA et Msc. AMBO

AMANDURE.

Je tiens à remercier ma famille, en particulier mes

parents ZAHINDA KASHOSHO Faustin

et sa dulcinée NSIMIRE M'MUSOBO Adolphine

qui m'ont soutenu à réaliser mes études et

qui m'ont toujours encouragé dans mon destin. Je leurs

exprime toute ma reconnaissance.

Mes remerciements sont adressés au CT. BASHIGE

NTUGA Innocent et le Professeur

Balagizi Karhagomba Innocent pour leur appuie

matériel, moral durant notre cursus

de 5 ans à l'ISP Kaziba.

A toutes les autorités académiques et

administratives de l'Institut Supérieur Pédagogique

de Kaziba, plus particulièrement celles de la section

des sciences exactes.

A toutes les autorités scolaires de l'Institut Saint

Jean-Paul II Bugoye et de l'EP

Karhala, trouvez ici la plus profonde considération

à votre endroit.

Mes sincères et profondes gratitudes nous

assujettissent à remercier le Doctorant

ZIRHUMANANA BALIKE Dieudonné, NGANIZA

LUGERERO Bernadette et Msc. AGISHA Albert

pour les multiples conseils à mon égard dans

tout le cursus de ma formation.

Aux Réverendes Soeurs de la Paroisse de Burhinyi et aux

Réverends Prêtres de la

Congrégation des Franciscains de la paroisse de

Burhinyi, plus précisement le Père Jean

Claude.

A tous mes formateurs depuis l'école primaire

jusqu'à ce niveau, dans le cadre scientifique, spirituel, ... trouvez

ici, l'expression de ma profonde gratitude. Vous avez fait de moi ce que je

suis.

A mes frères, soeurs, cousins, cousines, neveux et

nièces : BISIMWA ZAHINDA, BULONZA ZAHINDA, KULONDWA ZAHINDA, MUSAFIRI

ZAHINDA, RHUGWASANYE ZAHINDA, FADHILI ZAHINDA, ZIRUKA ZAHINDA, CHRISTIAN

LUSHUHA, MUTABESHA MIHIGO, ...

A tous mes beaux-frères et belles-soeurs : NZIGIRE

M'MUSHOSHERE, OLINAMUNGU M'MUTABESHA, NEEMA KAGAYO, IZUBA MASHEGEYE, BAHATI

ONESPH0RE trouvez ici l'expression de ma profonde gratitude.

A mes amis, mes camarades étudiants du département

de maths et ceux de l'ISP KAZIBA en général : BIJIRAMUNGU BEKA,

MUSHAGALUSA BAHOYA, BWIRHONDE ZIHINDULA, CHOMBO NAMIKERE, ALEXANDRE BASHUSHANA,

BAHATI BASHIMBE, VOLONTE MINEKE, MUNGU WAMPAGA Innocent, ... trouvez ici

l'expression de ma gratitude.

A cette personne, laquelle la destinée nous unira et que

j'aimerai de tout mon coeur, j'espère qu'elle existe, elle trouvera,

dans la copie de ce travail mes sincères remerciements.

IV

René CUBAKA ZAHINDA

1

Introduction générale

Au cours de ces dernières années, la nouvelle

technologie est en train de prendre le devant dans la prise de décision

dans plusieurs domaines. Dans le domaine hospitalier, selon [18] et [19] une

rigoureuse collaboration entre les chercheurs universitaires et les agents de

santé dans plusieurs contextes est importante. Cette collaboration

cherche à rassembler les efforts de chaque partie pour améliorer

les performances d'efficacité des services des établissements de

soins. Avec l'apparition de la pandémie à Covid19 en 2019,

où le monde a fait face à un cas plus particulier du galopage du

taux d'hospitalisation dans plusieurs hopitaux du monde, les gestionnaires de

santé seraient peut-être confrontés à un

dilèmme : d'une part, du nombre de personnel soignant qui doit

assumer la permanance, et du nombre de patients pouvant être

réadmit dans une unité de soins de santé, ou alors, d'une

éventuelle sortie d'un patient x à l'hopital d'autre part.

Le cas concret est celui de la France car selon [18], elle a atteint le

nombre d'hospitalisation de 7,1 millions durant l'an 2019.

La Durée de Séjour Hospitalier (DDS) constitue

un des indicateurs de base d'évaluation de la pertinence d'un

hôpital. Cette durée représente l'intervalle de temps entre

l'admission du patient dans un service (ou hôpital) et sa sortie du

service (ou hôpital). Elle est donc le parcours suivi lors du

séjour [18]. Pendant que plusieurs services sanitaires au monde

s'approprient les nouvelles technologies de l'information et de la

communication pour rendre meilleures et fiables leurs structures sanitaires. Il

s'oberve jusque là, dans notre pays la non considération de la

nouvelle technologie de l'Information et de la Communication expliquée

par le fait que les institutions sanitaires ne sont pas

numérisées.

2

Les établissements de soin sont des systèmes

à plusieurs dimensions car, ils doivent gérer concomitamment la

pertinance des personnels soignants, de la gestion des malades, etc. En RDC

plus particulièrement au Sud-Kivu, le service de gynécologie

réçoit un nombre important de patientes car, des mamans en

processus de procréation, des cas de règles douloureuses, des

violences sexuelles, ... C'est ainsi que, dans ce travail, nous allons plus

nous intérésset à la Durée de Séjour du

service de Gynécologie dans certains hopitaux de la province du

Sud-Kivu.

Face aux besoins sanitaires croissants de la population,

à la surcharge du travail des

professionnels de santé et à l'allongement des

délais d'attente des patients, l'estimation de

la DDS doit être établie au moment de l'admission du

patient, suivie et la mise à jour

tout au long du séjour hospitalier. La prédiction

de la DDS contribue à :

- La planification des activités de soins des services

médicaux.

- L'amélioration des conditions organisationnelles de

l'hôpital.

- L'analyse du taux journalier d'admission des patients et le

suivi de leur séjour.

- La gestion des lits hospitaliers.

- L'optimisation des ressources matérielles et humaines de

l'hôpital.

Un des avantages les plus importants de la prédiction de

la DDS est la maîtrise des

contraintes budgétaires à la quelle les

hôpitaux sont tenus [19].

La prédiction de la durée de séjour

hospitalier, est une discipline complexe dont nous ne sommes pas les

précursseurs. C'est comme par exemple, MEKHALDI RASHDA NAILA

dans sa thèse de doctorant présentée et soutenue

le 27 janvier 2022, il fait des algorithmes pour la prédiction de la DDS

dans plusieurs unités de soins, notamment dans les services suivants :

le service de cardiologie, le service de médecine polyvalente, le

service de pédiatrie et le service de néonatologie. A chaque

fois, il faisait deux algorithmes l'un en apprentissage supervisé et

l'autre en apprentissage non supervisé et faire une comparaison et faire

une étude de savoir quel algorithme prédit mieux que l'autre. Il

génère deux modèles, l'un statique, le modèle qui

sera formulé au moment de l'admission du patient; et l'autre

séquentiel, qui intègre les données disponibles pendant le

séjour du patient.

3

Etant donné que la durée de séjour

hospitalier (DDS) joue un grand rôle dans la

définition d'un hopital fiable, la rédaction de ce papier est

axée sur le problème de la modélisation de la durée

de séjour hospitalier basée sur quelques techniques de Machine

Learning. Nous tâcherons de répondre à la question suivante

: Comment pouvons-nous faire un algorthme de préduction de durée

de séjour hospitalier (DDS) dans l'unité médicale de la

gynécologie et qu'il puisse prédire à quelques erreurs

près cette DDS ?

La prédiction de la durée de séjour

hospitalier sérait possible grâce aux données des hopitaux

se rapportant sur les informations des patients et voir même depuis

l'admission de ce dernier. Cet algorithme approximerait la population, au cas

où elle serait associée d'une technique et des algorithmes de

l'apprentissage automatique de l'intelligence artificielle.

Pour répondre d'une manière claire et

précise à notre problématique de

recherche, il nous sera impératif de définir deux algorithmes en

machine learning. L'un en apprentissage supérvisé et l'autre en

apprentissage non supérvisé; et à chaque

instant, étudier la pertinance de l'un ou l'autre. Ces algorithmes

seront possibles, après avoir étudié les

différentes causes d'un séjour quelconque dans une unité

de gynécologie, spécialement dans certainss hôpitaux du

Sud-Kivu. Mais aussi, une recolte de données qui nous conduira

à la méthode documentaire nous sera utile dans

la construction de l'algorithme de l'apprentissage supervisé.

Ce travail est constitué de quatres chapitres

bornés par l'introduction générale et la conclusion

générale. Le premier chapitre porte sur les

systèmes d'informations hospitaliers où nous essayons de

faire un apperçu sur les données d'hospitalisation et leur

origines ainsi que de la propriété de ces dernières. Dans

ce dernier, nous parlons aussi de la durée de séjour hospitalier

et des facteurs infuençant cette dernière. Le deuxième

chapitre parle des modèles de prédiction de Machine Learning.

Dans ce dernier, nous différencions les différentes formes

d'apprendissange avant de parler de quelques modèles de Machine Learning

(oui, quelques modèles car notre liste n'est pas exaustive) avant de

chutter par la pertinence d'un modèle de Machine Learning car, bien

évidement différentes modèles prédisent

différemment. Ce qui veut dire qu'il y a des erreurs qui peuvent surgir.

Ainsi donc, le meilleur modèle de prédiction sera celui qui

prédit à moins d'erreurs. Le troisième

4

chapitre est celui consacré à la

présentation des données que nous allons utiliser. Ces

données proviennent de plusieurs structures sanitaires de la province

car, bien évidemment, nous n'avons pas trouvé des données

pour toute la province stockées en un seul endroit. Et finalement, le

quatrième et dernier chapitre est celui où nous allons construire

nos différents modèles de machine Learning pour prédire le

séjour hospitalier dans l'unité médicale de la

gynécologie en province du Sud-Kivu. Pour ce faire, nous allons

constituer des modèles tantôt en apprentissage supervisé,

tantôt en apprentissage non supervisé et à chaque

étape nous allons nous rassurer de la pertinence de chaque modèle

pour en fin finir par une meilleure selection du modèle à

considérer.

5

Chapitre 1

Les systèmes d'informations

hospitaliers et la gestion hospitalière

1.1 Introduction

Actuellement, les établissements de soins font face

à une forte croissante du nombre de cas d'hospitalisation, et ceci,

c'est depuis l'apparution de la pandémie à COVID-19 où le

nombre d'hospitalisation a accru dans plusieurs pays du monde [7]. Pour ce

faire, il est donc question pour les services de santé,

d'améliorer leurs conditions de fonctionnement par une bonne gestion des

structures sanitaires et ainsi, parvenir à consolider la qualité

de soin pour permettre les entrées et sorties au sein de n'importe

quelle unité médicale. Ceci sera alors effectif, par le fait de

bien conserver les informations médicales, pour savoir administrer un

médicament à un quelconque patient et ne pas le faire

fortuitement.

D'une manière plus générale, les

Systèmes d'Informations Hospitaliers (SIH) s'occupent de la gestion de

l'ensemble des informations, de leurs règles d'utilisation et de leur

circulation. De plus, ils font face au stockage et au traitement des

données pour répondre aux besoins quotidiens des

établissements de soins ([11] et[19]).

Les performances et la qualité des services de soins

reposent sur la qualité et la quantité des informations

collectées dans les SIH. La DDS constitue un des indicateurs

d'évaluation le plus utilisé et sa prédiction basée

sur les données disponibles dans les SIH a été au centre

d'un grand nombre de travaux de recherche. Le problème de la

prédiction des durées

6

de séjours hospitaliers a été

abordé sous différents angles dans des recherches

précédentes. [19].

Le but de ce chapitre est de vouloir mettre à la

lumière du soleil certaines informations sur le Système

d'Information Hospitalier en partant de la sorte : tout d'abord nous allons

décrire les systèmes d'Information Hospitalier d'une

manière générale en parlant de la sources de ces

informations ainsi que des propriétés y afferantes. En suite,

nous allons parler de la durée de séjour hospitalier et les

facteurs influençant cette dernière pour enfin chutter avec le

rôle des machines learning dans tout ceci.

1.2 Les systèmes d'informations hospitaliers 1.2.1

Terminologie

Définition 1.1 Un Système

d'Information Hospitalier (SIH) est un Système

informatique destiné à faciliter la gestion de l'ensemble des

informations médicales et administratives d'un hôpital. Selon

[19], on appelle système d'information l'ensemble des

outils matériels, des logiciels et des réseaux de

télécommunications utilisés pour recueillir, créer

et distribuer des données utiles dans des organisations.

En particulier, un Système d'Informations Hospitalier

(SIH) désigne un système conçu pour gérer

l'ensemble des données médicales et administratives d'un

hôpital. Il se constitue d'un groupe d'éléments en

communication qui rassemblent, traitent et fournissent les informations

nécessaires à son activité.

Définition 1.2 Un Système

d'information de l'hôpital est un ensemble des

éléments en interaction ayant pour objectif de rassembler,

traiter et fournir les informations nécessaires à son

activité.

Définition 1.3 Un Système

d'Information de Santé (SIS) est un Système

d'information global, regroupant tous les types d'acteurs et ressources de

santé.

1.2.2 Type d'informations

Dans un milieu hospitalier, plusieurs informations sont

récueillies, tantôt lors de l'admission du patient et au fur et

à mesure que le patient augmente son séjour à l'hopital.

On a donc besoin souvent des informations antérieures du patient et

quelques informations administratives. Selon [19], ces informations comprennent

les données démographiques sur les patients, les

étapes de son suivi, les complications, les médicaments, les

signes vitaux, les antécédents médicaux, les

immunisations, les données de laboratoire et les rapports de radiologie

[HIM]. Les informations administratives concernent la gestion

opérationnelle d'un hôpital en matière de soins de

santé. Elles englobent les informations de la gestion des patients

(parcours, facturation, actes médicaux), la gestion de la finance et de

la comptabilité (budget, ressources matérielles, achats) et la

gestion des ressources humaines (affectations, planning, payement).

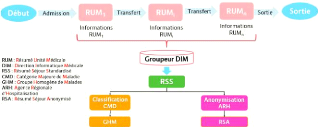

Le SIH est scindé en trois sous-systèmes comme

illustre la figure 1.1 ([11], [18] et[19] )

:

7

FIGURE 1.1 - Composantes des Systèmes d'Informations

Hospitaliers [11]

8

Le sous-système de production des

soins

Ce volet s'occupe de l'administration des données

patients, les unités de soins, la communication entre ces unités

et la gestion de la recherche et de l'enseignement médicaux. Il contient

toutes les données liées au patient comme par exemple : le

diagnostic médical, les prescriptions et la réalisation des actes

médicaux, l'édition des comptes rendus et les

résumés de dossier sont présentes au sein de ce

sous-système.

Le sous-système d'information

logistique

L'objectif est donc de mieux organiser les activités et

les structurer afin d'assurer une meilleure qualité de soins des

patients. Le sous-système d'information logistique permet de

gérer les différents ressources matérielles, humaines,

physiques et financières de l'hôpital. Il englobe la gestion de

stocks et des approvisionnements, la gestion des locaux, la gestion des

facturations et des commandes, la gestion des lits d'hospitalisation et de

soins ainsi que les archives et la documentation des établissements de

soins.

Le sous-système de pilotage

Il veille à la prise en charge de la gestion

médicoéconomique de l'hôpital. Il concerne la

qualité des soins et la gestion des risques. De plus, il

s'intéresse à l'allocation budgétaire des

différentes unités de soins .

Ces sous-systèmes sont souvent en interaction afin

d'assurer la continuité des services de soins, améliorer leur

qualité et gérer les ressources et les contraintes

budgétaires. Compte tenu du grand volume des données des SIH,

divers formats de stockage sont apparus. Ces données proviennent de

multiples sources et font l'objet de plusieurs études dans le domaine

médical. Quoi que ces données existent, elles proviennent de

quelque part effectivement. Dans la partie suivante, nous allons parler des

différentes sources des données hospitalières.

9

1.3 Sources des données des SIH

Les progrès technologiques et les progrès des

processus de traitement des données ont permis une augmentation

exponentielle de la quantité des données collectées dans

le domaine de la santé. Le volume des données contenues dans les

SIH ne cessent de croître. En fonction de leur type, les données

sont recueillies à partir de différentes sources. Ces sources de

données sont nombreuses et diffèrent selon le type de collecte,

le format de représentation et la nature des informations. Les

principales sources des données médicales sont : les dossiers

médicaux, les enquêtes auprès des patients et les

données administratives utilisées pour payer les factures ou

gérer les soins ([20],[19]). Dans ce qui suit, nous détaillons

les sources de données .

1.3.1 Dossier médical du patient

Il comporte les données démographiques du

patient acquises au moment de son admission : sa date de naissance, son

adresse, son statut marital et son sexe. Il contient également les

données liées à son état de santé comme les

résultats des analyses biologiques et les transcriptions

médicales, les résultats d'examens radiologiques, le diagnostic

médical, les antécédents médicaux et les rapports

textuels cliniques.

1.3.2 Les données administratives

Elles peuvent inclure les données des facturations et

des remboursements des séjours hospitaliers des patients. Les

données de facturation sont souvent liées aux motifs

d'hospitalisation représentés à l'aide de la Codification

Internationale des Maladies (CIM) et aux procédures que le patient a

subi au cours de son séjour. Les données administratives

comportent aussi des informations sur le type de l'unité

médicale, l'admission du patient, le nombre d'unités dans

lesquelles le patient est passé (ou le nombre de jours passés

dans chaque unité).

10

1.3.3 Les données issues des enquêtes et de

la recherche clinique

Une source importante des données médicales est

apparue avec l'explosion de l'utilisation d'internet comme moyen de

communication. Les données de santé peuvent provenir des

échanges des patients sur les réseaux sociaux et des recherches

effectuées sur le web. Elles proviennent également des

études cliniques réalisées par les professionnels de

santé, les scientifiques et les industriels.

1.4 Propriétés des données

médicales

"S'agissant des données de santé,

informations éminemment sensibles, la tentation est exacerbée de

se prévaloir d'un droit de propriété pour se garantir une

meilleure protection contre tout usage préjudiciable" N.

MALLET-POUJOL cité dans [9].

Vu que les données médicales doivent être

protégées comme vu dans la section 1.3, il existe des

données à caractère privé. Des lois pour palier

à un quelconque dérapage des données médicales sont

aussi de structe application.

Les données médicales sont à conserver

jalousement non seulement du fait qu'elles sont sensibles, mais aussi car elles

sont utilisées par des chercheurs, les hopitaux eux-mêmes, ... ces

dernières nous aident même à l'organisation des

établissements de soins, l'identification de profils homogènes de

patients, le suivi des parcours des patients et la recherche de leur diagnostic

médical. Cependant, avant d'utiliser ces données, il est

primordial de procéder à leur annotation, de les intégrer

et de les pré-renseigner de manière appropriée afin de

faciliter leur compréhension. La compréhension et la manipulation

des données médicales se heurtent à des défis

liés à leur complexité, la richesse des informations aussi

qu'à des contraintes de confidentialité [19]. Il existe donc des

garentis juridiques pour n'importe quel dérapage de la part des

données médicales [20].

La figure 1.2 nous illustre les différentes

propriétés des données médicales ainsi que leurs

sources. Particulièrement, les données que nous avons

utilisées dans l'analyse de ce présent travail ne sont pas loin

de respecter ces critères ici.

Les sous-sections suiventes nous servirons de détail

pour les propriétés du SIH en paraphrasant [19].

11

FIGURE 1.2 - Données médicales : sources et

propriétés [19]

1.4.1 Confidentialité

Selon l'article 4 du Règlement Général

sur la Protection des Données (RGPD) de l'Union Européenne :

« les données relatives à la santé physique ou

mentale d'une personne physique, y compris la prestation de services de soins

de santé, qui révèlent des informations sur l'état

de santé de cette personne » sont définies comme

données à caractère personnel. Ces donnes doivent donc

être protégées et une politique et une démarche de

sécurité de ces données doivent être définies

pour les protéger. Si la protection des données est un enjeu

majeur, d'autres risques liés au matériel et à

l'infrastructure informatique sont également des points d'attention

récurrents. Les données médicales sont exploitées

dans plusieurs recherches et études académiques et industrielles.

Elles peuvent être utilisées dans la conception des

systèmes d'aide à la décision du domaine médical,

l'amélioration des prestations de soins de santé, l'optimisation

des ressources matérielles et humaines des hôpitaux. Un processus

d'anonymisation ou de pseudo-anonymisation des données est donc utile

avant toute manipulation. L'anonymisation des données médicales

est définie comme la suppression de tout caractère identifiant un

ensemble de données d'une

12

manière irréversible. Toutes les informations

directement ou indirectement identifiables sont supprimées ou

modifiées afin d'empêcher toute ré-identification des

personnes. Quant à la pseudo-anonymisation, elle permet le retour

à l'information originale en cas de besoin particulier. Elle consiste

à remplacer les données à caractère personnel par

des pseudonymes. Cette technique est réversible et permet donc la

ré-identification ou l'étude de corrélations entre les

informations codifiées en cas de besoin particulier. De cette

manière, la réutilisation des données médicales est

possible ce qui suscite un intérêt et une demande croissante.

1.4.2 Données incrémentales

A l'aire du Big data, les données médicales ne

sont plus à ignorer. L'analyse des données massives est un

domaine en pleine croissance qui peut fournir des informations utiles dans le

domaine des soins de santé. Dans les systèmes d'aide à la

décision ou de prédiction, les éléments

collectés sont insérés dès leur

disponibilité dans le modèle comme des évènements

successifs. Un exemple qui caractérise cette particularité est de

modéliser le séjour hospitalier par un processus de trois

étapes : moment d'admission du patient, le séjour

hospitalier et la sortie du patient.

Lors de l'admission du (de la) patient(e), des informations

démographiques comme l'âge, l'adresse, le genre et l'état

civil sont acquises ainsi que des informations administratives comme le type

d'admission au service concerné, le motif d'hospitalisation et

l'unité médicale dans laquelle le patient est admis.

Au cours du séjour hospitalier, d'autres informations

médicales et administratives s'ajoutent. Par exemple les actes

médicaux réalisés pour le patient, les complications

médicales et les transferts entre unités médicales.

Et au finish, à la sortie du (de la) patient(e), les

rapports médicaux effectués par les médecins ou les

infirmiers sont élaborés. La régularisation de la facture,

la durée de séjour du patient et son mode de sortie sont

prélevés.

13

1.4.3

Hétérogénéité

De nos jours, il est nécessaire d'utiliser conjointement

des données provenant de systèmes d'information qui utilisent

différentes sources de connaissances comme par exemple, les rapports

médicaux textuels et les résultats d'imagerie médicale

pour l'enregistrement des données et les utiliser dans la

résolution de nombreux problèmes dans le domaine médical.

L'exploration de ces données dites hétérogènes pour

extraire des connaissances est un processus fastidieux imposant des contraintes

opérationnelles importantes. Les données

hétérogènes sont des données dont les types et les

formats présentent une grande variabilité. Il existe

principalement 4 types d'hétérogénéité :

- L'hétérogénéité

syntaxique : Elle se produit lorsque deux sources de données ne sont pas

exprimées dans le même langage.

- L'hétérogénéité

sémantique ou conceptuelle : Elle désigne les différences

de modélisation d'un même domaine d'intérêt.

- L'hétérogénéité

terminologique : Elle désigne les variations de noms lorsqu'on se

réfère aux mêmes entités à partir de

différentes sources de données.

- L'hétérogénéité

pragmatique : Elle correspond à des interprétations

différentes des entités.

De plus, nous rajoutons

l'hétérogénéité par type de données.

Elle réside dans ce cas dans la présence de données

quantitatives ou dites numériques et qualitatives ou dites

catégorielles. Les données quantitatives sont celles qui peuvent

être comptées ou comparées sur une échelle

numérique. On distingue alors les données quantitatives continues

et discrètes. Pour le type qualitatif, on sépare le qualitatif

nominal et le qualitatif ordinal. Par exemple l'âge d'un patient est une

donnée numérique discrète, sa taille est une donnée

numérique continue, son genre est une donnée catégorielle

nominale et son niveau d'étude est une donnée catégorielle

ordinale. Nous définissons aussi le type de donnée

catégorielle multivaluée comme par exemple les diagnostics

médicaux si le patient possède plusieurs diagnostics. Le format

des données médicales peut être structuré ou non

structuré. Le format des données structurées est

organisé et formaté. Par conséquent, il est facile de

saisir, rechercher et manipuler les données structurées. A

l'inverse, les données non structurées comme par exemple les

rapports médicaux en format textuel ou les images de

14

radiologie médicale, souvent classées comme des

données qualitatives, sont plus difficiles à traiter et à

analyser. Un processus d'intégration des données

hétérogènes est crucial pour permettre aux utilisateurs de

définir leurs requêtes sans connaître leurs sources et

donner une vue uniforme de l'ensemble de ces sources.

1.4.4 Complexité

La grande quantité d'informations

générées par les systèmes d'informations de

santé, la variété des sources des données

médicales et l'hétérogénéité des

données rendent leur traitement et leur analyse plus difficile et plus

complexe soulevant ainsi plusieurs défis. Parmi ces défis, nous

retrouvons la présence de plusieurs variables ce qui engendre une grande

dimension. De plus, ces données sont souvent incomplètes et

contiennent des variables fortement corrélées entre elles

résultant de la redondance de l'information. Les données

médicales présentent également d'autres problèmes

comme la présence des données aberrantes ou des erreurs dans les

informations enregistrées. Ces problèmes imposent des

méthodes de pré-traitement des données avant de les

utiliser afin de rendre leur exploitation plus facile et fiable. La

complexité des données médicales rend primordiale

l'implication de l'expertise médicale dans leur exploitation par les

utilisateurs afin de valider, interpréter et mieux valoriser leur

contenu.

1.5 Durée De Séjour hospitalier

Définition 1.4 La Durée de

Séjour Hospitalier peut être définie

comme un séjour pendant lequel le patient peut être

hospitalisé dans plusieurs services, que l'on appelle actuellement des "

unités médicales "[4].

La figure 1.3 explique en quelques sortes la durée de

séjour hospitalier dans un hopital en passant par une ou plusieurs

unités médicales.

Face à un accroissement sans précédent du

nombre de cas d'hospitalisation, l'apparution des nouvelles maladies et ou

épidémies, la famine en RDC, les institutions sanitaires font

face à un nombre accru des patients pouvant même dépasser

la capacité d'accueil de ces derniers.

15

FIGURE 1.3 - Évaluation des systèmes de

santé : DDS [19]

Pour faire face à tout ceci, la prédiction de la

durée de séjour hospitalier est un facteur clé dans un

service de santé, car contribue à la planification et à

l'organisation des activités de soins, ainsi qu'au management des lits

réduisant leur occupation inutile [19], mais aussi savoir gérer

le personnel soignant et ouvrier pour l'assurance des malades. Chaque structure

sanitaire est donc confrontée à faire face à un

système de santé sans pareil pour permettre une bonne

compétitivité au marché des hopitaux.

Selon [19], il existe trois facteurs importants pour

définir la pertinance d'un système de santé, on peut citer

: le taux de mortalité, le nombre de réadmissions et

la durée de séjour hospitalier (DDS) .

Quant à l'unité de mesure de la DDS, elle est

mesurée en journée. Cette définition peut changer

constamment dans d'autres contextes. Dans les services d'urgence et

ambulatoire, l'admission et la sortie du patient sont réalisées

dans la même journée. De ce fait, la DDS est égale à

0 jour. La valeur de la DDS est alors calculée en nombre d'heures et

peut s'étaler sur 24 heures au maximum. Plusieurs travaux ont

étudié les flux des patients en service d'urgence en se basant

sur l'estimation du nombre d'heures du séjour du patient dans ce

service. Nous distinguons donc deux définitions majeures de la DDS : la

DDS dans des unités médicales dites « programmées

» calculée en nombre de jours passés dans ces unités

et la DDS dans des services dits « non programmés »

calculée en nombre d'heures. Dans ces deux cas, la DDS est

quantifiée par une valeur numérique discrète.

Ce qui nous permet d'affirmer qu'une Durée de

Séjour Hospitalier au délà de la moyenne provoquerait des

coûts matériels que financiers suplémentaires à

l'hopital. C'est ainsi alors

16

que la prédiction de DDS dans un service sanitaire est

d'une importance capitale pour palier à ce problème.

1.6 Facteurs influençant la DDS

La durée de séjour hospitalieur est souvent

dû à plusieurs facteurs qui sont tantôt d'origine du patient

lui-même ( c'est à dire de son âge, de sa maladie, de son

état psychique, ...) ou d'un autre facteurs exterieur. D'où alors

la durée de séjour hospitalier dépend aussi de

l'Unité médicale dans laquelle le patient est admis ([19]).

Parmi les facteurs influançant la DDS, on peut citer

([18]) :

1. Les facteurs démographiques :

l'âge, le genre et la situation familiale du patient;

2. L'historique médicale du patient

3. Les mesures des signes vitaux et des résultats

du laboratoire,

4. Etc.

Ce travail étant borné dans le service de

Gynécologie, à part les facteurs vus ci-haut, les hopitaux aussi

jouent un rôle dans la prédiction de la DDS. C'est comme le cas

par exemple de la Gynécologie obstétrique où, pour un

accouchement eutocique la DDS va de 2 à 5 jours selon les hopitaux

consultés et pour un accouchement distocique, elle va de 4 à 9

jours.

1.7 Que vient faire l'intelligence artificielle dans tous

ça ?

L'intelligence artificielle (Artificial intelligence en

anglais) englobe plusieurs techniques comme par exemple l'apprentissage

automatique (Machine Learning), la vision par ordinateur, le raisonnement, la

représentation des connaissances et la fouille de données. Ces

techniques font partie des techniques les plus utilisées de nos jours

dans les différents domaines de recherche. Les applications de l'IA

s'étendent à des domaines que l'on pensait auparavant

réservés aux experts humains des données

numérisées, d'infrastructure informatique, d'amélioration

de la puissance et de la capacité de stockage des ordinateurs,

17

le domaine médical est identifié comme l'un des

domaines les plus promoteurs de l'IA. L'apprentissage automatique ou le Machine

Learning (ML) en anglais, est une technique de l'IA largement employée

dans les recherches cliniques. Elle est apparue dans les années

1950 avec Alan Turing quand il a écrit

un article sur « Computing machinery and intelligence » dans

lequel il explique que pour démontrer l'intelligence d'une machine, elle

doit être capable d'exécuter des tâches humaines de telle

sorte que personne ne peut la différencier de celle d'un être

humain.

La figure 1.4 illustre les principales techniques de

l'Intelligence Artificielle et leurs applications [19].

FIGURE 1.4 - Techniques de l'Intelligence Artificielle et leurs

applications [19]

L'apprentissage automatique consiste à doter les machines

de capacités d'analyse, d'apprentissage et de

généralisation à partir des données. L'objectif est

de résoudre des problèmes pour lesquels il aurait

été difficile de trouver une solution avec des approches

informatiques traditionnelles. Il existe quatre types d'apprentissage

automatique : l'apprentissage supervisé, l'apprentissage

non-supervisé, l'apprentissage semi-supervisé et l'apprentissage

par renforcement. En médecine, selon les nouvelles techniques de l'IA,

plusieurs solutions sont en train de voir le jour comme c'est le cas par

exemple de la prédiction du cancer, dans la prédiction d'une

quelconque réadmission à l'hopital [13], ...

Comme nous pouvons le constanter, la Nouvelle Technologie de

l'Information et de la Communication (NTIC) est au service de toute la

communauté et ceci par l'apparution de l'Intelligence Artificielle

où les machines prennent certaines décisions que prennaient

18

les humains dans l'ancien temps. Faudra-t-il que ceci soit

possible sans nous interroger comment ça marche ? La mise en place d'un

Algorithme de Machine Learning se fait le plus souvent par le canal de certains

algorithmes (Modèles de prédiction). La partie suivante sera

concencrée à certains modèles de machine learning qui nous

servirons dans les deux derniers chapitres.

19

Chapitre 2

Modèles de prédiction en Machine

Learning

2.1 Introduction

La durée de séjour hospitalier est sans doute un

facteur qui indique en quelques sortes la force et la viabilité d'un

système hospitalier. Cette prédiction a vu son essort depuis que

l'Intelligence Artificielle, spéciallement les Machines Learning sont

entrain de s'imposer dans la prise de décision dans presque tous les

domaines de la vie. Parfois, on ne sait pas distinguer ce qui est

intélligence artificielle, apprentissage automatique et

apprentissage profond.

Le but de ce chapitre est tout d'abord de présenter le

machine learning, son historique et ses champs d'application, en suite nous

mettrons au courant les differents modèles de prédiction de

machine learning, ainsi que la définition d'un modèle pertinant

et en fin, comprendre le rôle de ces modèles dans la

prédiction de DDS.

2.2 Intelligence Artificielle, Machine Learning et Apprentissage

Profond

Premièrement, nous devons définir clairement ce

dont nous parlons lorsqu'il est question d'IA. Que sont l'intelligence

artificielle, l'apprentissage automatique et l'apprentissage

20

profond ? Quels liens existent entre eux (figure 2.1) ?

FIGURE 2.1 - Les relations entre l'intelligence artificielle,

l'apprentissage automatique et l'apprentissage profond [10]

2.2.1 Intelligence Artificielle : Artificial

Intelligent (AI)

L'intelligence artificielle est née dans les

années 50, quand une poignée de pionniers de l'informatique

naissante ont commencé à se demander si les ordinateurs

pouvaient

être conçus pour « penser » une

question dont nous continuons aujourd'hui d'explorer

les ramifications. Une

définition précise de ce domaine serait la suivante : c'est

l'effort d'automatisation des tâches intellectuelles normalement

effectuées par des humains [10].

L'intelligence artificielle est donc un domaine

général qui englobe l'apprentissage automatique et

l'apprentissage profond, mais qui comprend également de nombreuses

autres approches qui n'impliquent aucun apprentissage. Pendant très

longtemps, de nombreux experts ont cru qu'une intelligence artificielle

équivalente à celle de l'homme pouvait être atteinte en

faisant en sorte que les programmeurs fabriquent un ensemble suffisamment large

de règles explicites pour manipuler les connaissances. Cette approche

est connue sous le nom d'intelligence artificielle symbolique (symbolic AI), et

ce fut le paradigme dominant de l'IA des années 1950 à la fin des

années 1980. Elle a atteint son apogée pendant le boom des

systèmes experts (expert systems) dans les années 1980 [10].

Bien que l'IA symbolique se soit révélée

apte à résoudre des problèmes logiques bien

définis, tels que jouer aux échecs, elle s'est

avérée incapable de définir des règles explicites

pour résoudre des problèmes plus complexes et flous, tels que la

classification d'images, la reconnaissance de la parole et la traduction

linguistique. Une nouvelle approche est apparue, et elle a pris la place de

l'intelligence artificielle symbolique : c'est

l'apprentissage

21

automatique (machine learning) [10].

2.2.2 Apprentissage automatique : Machine

Learning

Dans l'Angleterre victorienne, Lady Ada Lovelace était

une amie et une collaboratrice de Charles Babbage, l'inventeur de la machine

analytique (Analytical Engine) : le premier ordinateur mécanique

polyvalent connu. Bien que visionnaire et très en avance sur son temps,

la machine analytique n'était pas conçue comme un ordinateur

polyvalent (general purpose computer) lorsqu'elle a été

pensée dans les années 1830 et 1840, car le concept de calcul

polyvalent n'avait pas encore été inventé. C'était

simplement un moyen d'utiliser des opérations mécaniques pour

automatiser certains calculs du domaine de l'analyse

mathématique d'où le nom de machine analytique.

En 1843, Ada Lovelace a ainsi

commenté l'invention : « le moteur

analytique n'a aucune prétention à être à l'origine

de quoi que ce soit. Il peut faire toutes les tâches dont nous savons

comment lui ordonner de les effectuer [...]. Son domaine de compétence

est de nous aider à rendre disponible ce que nous connaissons

déjà. » Le pionnier de l'IA, Alan Turing, a cité

cette remarque plus tard comme « l'objection de Lady Lovelace » dans

son article phare de 1950 appelé « Computing Machinery and

Intelligence » qui présentait le test de Turing ainsi que les

concepts clés qui façonneront plus tard l'IA. Turing citait Ada

Lovelace en se demandant si les ordinateurs polyvalents pourraient être

un jour capables d'apprendre et de faire preuve de créativité, et

il en vint à la conclusion qu'ils en seraient capables. L'apprentissage

automatique découle de cette question : un ordinateur pourrait-il aller

au-delà des « tâches dont nous savons comment lui ordonner de

les effectuer », et apprendre par lui-même comment effectuer une

tâche spécifique ? Un ordinateur pourrait-il nous surprendre ?

À la place de programmeurs élaborant à la main des

règles de traitement de données, un ordinateur pourrait-il

apprendre automatiquement ces règles par l'exposition aux données

?

Cette question ouvre la porte à un nouveau paradigme de

programmation. En programmation classique, le paradigme de l'IA symbolique,

l'homme saisit des règles (un programme) et des données à

traiter conformément à ces règles, et il en découle

des réponses en sortie. Avec l'apprentissage automatique, les humains

entrent des données,

22

ainsi que les réponses attendues à partir de ces

données, et ils obtiennent des règles en sortie. Ces

règles peuvent ensuite être appliquées à de

nouvelles données pour produire des réponses originales.

Un système d'apprentissage automatique est

entraîné plutôt qu'explicitement programmé. De

nombreux exemples pertinents pour une tâche lui sont

présentés. Puis il trouve dans ces exemples une structure

statistique qui lui permet à terme d'élaborer des règles

pour l'automatisation de la tâche. Par exemple, si vous souhaitez

automatiser l'étiquetage de vos photos de vacances, vous pouvez

présenter à un système d'apprentissage automatique de

nombreux exemples d'images déjà étiquetées par des

humains, et le système apprendra des règles statistiques pour

associer, à des images spécifiques, des étiquettes

spécifiques. Bien que l'apprentissage automatique n'ait commencé

à prospérer que dans les années 1990, il est rapidement

devenu le sous-domaine de l'IA le plus populaire et le plus performant. Cette

tendance est alimentée par la disponibilité de matériels

informatiques plus rapides et de plus grands ensembles de données.

L'apprentissage automatique est étroitement lié aux statistiques

mathématiques, mais il diffère des statistiques sur plusieurs

points importants. À la différence des statistiques,

l'apprentissage automatique traite généralement de vastes et

complexes ensembles de données (par exemple un ensemble de

données de millions d'images, chacune comprenant des dizaines de

milliers de pixels) pour lesquels une analyse statistique classique telle

qu'une analyse bayésienne serait impossible à mettre en oeuvre.

En conséquence, l'apprentissage automatique, et en particulier

l'apprentissage profond : Deep Learning,

présente relativement peu de théorie mathématique

peut-être trop

peu et est axé sur l'ingénierie. C'est une

discipline pratique dans laquelle les idées sont

plus souvent

prouvées empiriquement que théoriquement.

2.2.3 Apprentissage des représentations à

partir de données

Pour définir l'apprentissage profond (deep learning en

anglais) et comprendre la différence entre l'apprentissage profond et

les autres approches d'apprentissage automatique, nous devons d'abord avoir une

idée du fonctionnement des algorithmes d'apprentissage automatique. Nous

venons juste d'énoncer que l'apprentissage automatique découvre

des règles permettant d'exécuter une tâche de traitement de

données, lorsque lui sont fournis

23

des exemples de résultats attendus. Pour faire de

l'apprentissage automatique, nous avons donc besoin de trois choses :

- des points de données d'entrée (input data

points) par exemple, si la tâche est

la reconnaissance vocale, ces

points de données peuvent être des fichiers audio de personnes qui

parlent ; si la tâche est l'étiquetage d'images, ces points de

données peuvent être des images ; si c'est dans le cas de ce

papier, on aura donc besoin de données d'entrées de la

patiente.

- des exemples de sortie attendue (expected output) dans une

tâche de reconnaissance vocale, il peut s'agir de transcriptions de

fichiers sonores générés par l'homme ; dans une

tâche d'étiquetage d'images, les sorties attendues peuvent

être des étiquettes telles que « chien », « chat

», etc. ; dans une tâche de séjour hospitalier les output

sont donc des séjours moyens de chacune des patientes.

- un moyen de mesurer la performance de l'algorithme c'est un

élément nécessaire pour déterminer la distance, au

sens mathématique, entre la sortie effective de l'algorithme et la

sortie attendue ; la mesure est utilisée comme un signal de retour

(feedback) pour ajuster le fonctionnement de l'algorithme ; cette étape

d'ajustement est ce que nous appelons l'apprentissage.

Un modèle d'apprentissage automatique transforme ses

données d'entrée en sorties qui ont un sens, c'est un processus

qui est « appris » à partir de l'exposition à des

exemples connus d'entrées et de sorties. Par conséquent, le

problème central de l'apprentissage automatique et de l'apprentissage

profond est de transformer de manière utile les données : en

d'autres termes, d'apprendre des représentations utiles des

données d'entrée disponibles

des représentations qui nous rapprochent du

résultat attendu. Avant d'aller plus loin : qu'est-ce qu'une

représentation ? Fondamentalement, c'est une façon

différente

de considérer les données de représenter

ou d'encoder les données. Les modèles

d'apprentissage

automatique ont pour but de trouver des représentations

appropriées pour

leurs données d'entrée des transformations de

données qui les rendent plus adaptées à

la tâche

à accomplir, telle que par exemple une tâche de classification.

Techniquement, voici ce qu'est l'apprentissage automatique :

c'est la recherche de représentations utiles de certaines données

d'entrée, dans un espace des possibilités

prédéfini, en s'appuyant sur un signal de retour. Cette

idée simple permet de résoudre un

24

très large éventail de tâches

intellectuelles, de la reconnaissance automatique de la parole à la

conduite automobile autonome.

Disons, ce qui est profond de

l'apprentissage profond est donc une nouvelle approche de

l'apprentissage des représentations à partir des données

qui met l'accent sur l'apprentissage de couches (layers) successives de

représentations qui sont de plus en plus significatives.

L'adjectif « profond » de l'apprentissage profond ne

fait pas référence à une forme de compréhension

plus approfondie réalisée par l'approche mise en oeuvre ; il

représente plutôt l'idée de couches successives de

représentations.

2.3 Les apprentissages en Machine Learning 2.3.1

Introduction

Dans cette section, nous allons voir quelques algorithmes de

prédictions de Machine Learning tantôt en apprentissange

supervisé, en apprentissage non supervisé ou en apprentissage par

renforcement.

Au delà de ces différents apprentissages, il

existe des algorithmes utiliés dans l'un ou l'autre apprentissage. Ces

modèles au finish nous serviront en grande partie dans la conception du

modèle de prédiction en Gynécologie qui fera l'objet de ce

mémoire.

Parlons d'abord de ce qui est de l'apprentissage

supervisé, l'apprentissage non supervisé et l'apprentissage par

renforcement ([19] et[25]).

2.3.2 Apprentissage supervisé

L'apprentissage supervisé est fait en utilisant une

vérité, c'est-à-dire qu'on a une connaissance

préalable de ce que les valeurs de sortie pour nos échantillons

devraient être. Par conséquent, le but de ce type d'apprentissage

est d'apprendre une fonction qui, compte tenu d'un échantillon de

données et de résultats souhaités, se rapproche le mieux

de la relation entre les entrées et les sorties observables dans les

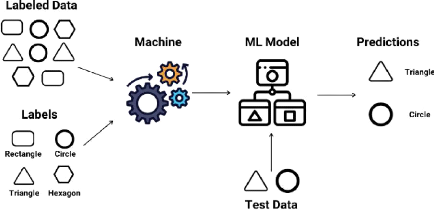

données. La figure 2.2 est un exemple d'un modèle de traitement

de données en apprentissage supervisé.

Dans l'apprentissage supervisé, on a deux types

d'algorithmes :

25

FIGURE 2.2 - Modèle de traitement de données en

apprentissage supervisé [1]

- Les algorithmes de régression, qui cherchent à

prédire une valeur continue, une quantité.

- Les algorithmes de classification, qui cherchent à

prédire une classe/catégorie.

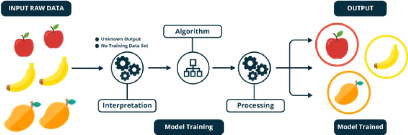

2.3.3 Apprentissage non supervisé

Dans l'apprentissage non supervisé (clustering en

anglais), l'ensemble de données est divisé en sous-groupes

homogènes pour obtenir une représentation simplifiée de

l'ensemble de départ [19]. Les algorithmes d'apprentissage automatique

non supervisés sont utilisés lorsque l'information

utilisée pour entraîner le modèle n'est ni

classifiée ni étiquetée. Le modèle en question

étudie ses données d'entrainement dans le but de déduire

une fonction pour décrire une structure cachée à partir

des données (figure 2.3). À aucun moment le système ne

connaît la sortie correcte avec certitude. Au lieu de cela, il tire des

inférences des ensembles de données quant à ce que la

sortie devrait être. [1].

Les algorithmes de ce type d'apprentissage peuvent être

utilisés pour trois types en problèmes.

- Association : un problème où

on désire découvrir des règles qui décrivent de

grandes portions de ses données. Par exemple, dans un contexte d'une

étude de

26

27

FIGURE 2.3 - Modèle de traitement de données en

apprentissage non supervisé [1]

comportement d'achat d'un groupe de clients, les personnes qui

achètent tel produit ont également tendance à acheter un

autre produit spécifique.

- Regroupement : un problème où

on veut découvrir les groupements inhérents

aux données, comme le regroupement des clients par le

comportement d'achat. - La réduction de dimension : on

vise à réduire le nombre de variables à prendre

en compte dans l'analyse.

2.3.4 Apprentissage semi-supervisé

Ce type d'algorithme est la combinaison entre l'apprentissage

supervisé et l'apprentissage non supervisé. Ces algorithmes sont

capables d'apprendre à partir d'ensembles de données

partiellement étiquetées [19].

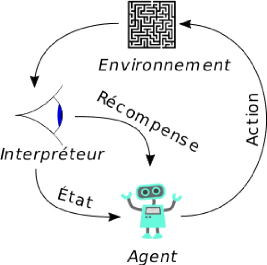

2.3.5 Apprentissage par renforcement

L'apprentissage par renforcement est une méthode qui

consiste à optimiser de manière itérative un algorithme

uniquement à partir des actions qu'il entreprend et de la réponse

associée de l'environnement dans lequel il évolue (figure

2.4).

Cette méthode permet aux machines et aux agents de

déterminer automatiquement le comportement idéal dans un contexte

spécifique pour maximiser ses performances. Une simple

rétroaction de récompense, connue sous le nom de signal de

renforcement, est

FIGURE 2.4 - Modèle de traitement de données en

apprentissage par renforcement

nécessaire pour que l'agent apprenne quelle action est la

meilleure.

La plus part des problèmes de la DDS utilisent les

algorithmes de l'apprentissage supervisé car, avant d'étudier la

DDS d'un patient, il faut donc savoir pour les précédents, leurs

DDS et ainsi, les faire appliquer au nouveau modèle.

2.4 Algorithmes de l'apprentissage automatique

Dans la partie suivante nous allons parcourir quelques

algorithmes en apprentissage supervisé car, sont eux qui nous serviront

dans la suite de ce travail.

Pour résoudre un problème en apprentissage

supervisé, on fait recours à plusieurs méthodes qui sont

applicables dans plusieurs domaines [1]. Dans la suite, nous allons essayer de

voir certains algorithmes en apprentissage automatique. Précisons que la

liste n'est pas exhaustive mais nous allons juste essayer de présenter

ici quelques modèles mais pas les tous.

28

2.4.1 Régression linéaire

La régression linéaire est l'une des

méthodes de prédiction en ML. Elle utilise des variables

quantitatives et l'idée plus générale ici est juste

d'exprimer les variables par une fonction f(x).

L'un de ses principaux mérites est de fournir une

illustration pédagogique élémentaire des différents

concepts du ML. Il suppose que la fonction de prédiction f qui

lie les variables prédictives x1, ..., xp

à la variable cible a la forme :

f(x) = a0x0 +

a1x1 + a2x2... +

apxp = a x x + b (2.1)

La régression linéaire est utilisée pour

l'estimation de certaines tendances en économétrie et dans le

marketing lorsqu'on a des raisons de penser qu'il existe une relation

linéaire entre la variable explicative et la cible. Établir la

relation entre l'augmentation du prix d'un produit et sa demande,

évaluer l'impact d'une campagne publicitaire en fonction des frais

engagés sont des exemples d'utilisation [15].

L' apprentissage du modèle consiste en l'occurrence

à calculer les coefficients ai qui minimisent les erreurs de

prédiction sur un jeu de données d'apprentissage. Le plus souvent

l'erreur est définie comme la somme des carrés des écarts

entre les valeurs prédites f(x(i))

et les valeurs observées yi. On parle à ce

titre de méthode des moindres carrés. Le

carré ici des erreurs nous permet de ne pas avoir des valeurs

négatives qui pourraient probablement se simplifier et ainsi faire

penser au concepteur du modèle que nous est correct or il y a des

valeurs érronées.

Erreur et la fonction coût

Un modèle de ML le plus souhaité, est celui qui

minimise l'erreur. C'est ainsi que dans la conception d'un algorithme de

Machine Learning, on cherche toujours à prendre le modèle qui a

moins d'erreurs.

En effet, pour chaque point xi, l'erreur unitaire

pour ce point xi est donné par la différence entre la

valeur prédite et la vraie valeur. Pour se rassurer que cette valeur

sera positive pour que l'équation 2.3 ne soit pas nulle, on

élève cette difference au carré :

(f(xi) - yi)2.

L'erreur unitaire étant déjà

définie, faisons une sommation de ces erreurs pour plusieurs points.

L'équation 2.2 donne [12] :

Xm (f(xi) -

yi)2. (2.2)

i=1

La fonction coût (équation 2.3) est

définie en normant cette somme de l'équation 2.2 par le nombre

m de points dans la base [12] :

m

1

J(è0, è1) = 2

X (f(xi) - yi)2 (2.3)

m i=1

29

Il existe aussi des modèles linéaires

généralisés qui se basent sur des lois de

probabilité. Les modèles linéaires

généralisés (GLM) étendent les modèles

linéaires de deux manières [2]. Premièrement, les valeurs

prédites y sont liés à une combinaison

linéaire des variables d'entrée x via une fonction de

lien inverse. Deuxièmement, la fonction de perte au carré est

remplacée par la déviance unitaire d'une distribution dans la

famille exponentielle (ou plus précisément, un modèle de

dispersion exponentielle reproductive (EDM).On fait alors le choix d'une

distribution statistique à faire. Ceci est guidé par la

caractéristique de données qu'on a [2] :

- Si les valeurs cibles y sont des nombres (valeur

entière non négative) ou des fréquences relatives (non

négatives), vous pouvez utiliser une distribution de Poisson avec un

lien logarithmique.

- Si les valeurs cibles y sont positives et

asymétriques, vous pouvez essayer une distribution Gamma avec un lien de

journal.

- Si les valeurs cibles y semblent avoir une queue

plus lourde qu'une distribution Gamma, vous pouvez essayer une distribution

gaussienne inverse (ou des puissances de variance encore plus

élevées de la famille Tweedie).

- Si les valeurs cibles y sont des

probabilités, vous pouvez utiliser la distribution de Bernoulli. La

distribution de Bernoulli avec un lien logit peut être utilisée

pour la classification binaire. La distribution catégorielle avec un

lien softmax peut être utilisée pour la classification

multiclasse.

30

D'après l'équation 2.1, nous pouvons encore

définir par 'q la DDS prédite à un moment

t [22]. Cette équation devient donc :

'17 = a0 + Xp

aixi (2.4)

i=1

2.4.2 Les k plus proches voisins

Le modèle des k plus proches voisins (KNN pour

k Nearest Neighbors) est un des modèles

prédictifs les plus simples. Il ne fait aucune hypthèse

mathématique et ne demande pas non plus toute une litanie des choses. Il

nécessite très peu de choses [15] :

- une notion de distance;

- et l'hypothèse que des points proches les uns des

autres sont similaires.

L'opérateur de distance le plus souvent utilisé

est la distance Euclidienne, cependant, en fonction du problème, on peut

encore utiliser d'autres distances [26], etc

Principe de l'algorithme

On suppose que l'ensemble E contient n

données labellisées et u , une autre donnée

n'appartenant pas à E qui ne possède pas de label. Soit

d une fonction qui renvoie la distance (qui reste à choisir)

entre la donnée u et une donnée quelconque appartenant

à E. Soit un entier k inférieur ou égal

à n [8]. Le principe de l'algorithme de k-plus proches voisins

est le suivant [3] et [8] :

- On calcule les distances entre la donnée u

et chaque donnée appartenant à E à l'aide de

la fonction d.

- On retient les k données du jeu de

données E les plus proches de u, c'est-à-dire,

les données déjà classifiées qui ont une distance

d la plus proche avec la nouvelle donnée entrée.

- On attribue à u la classe qui est la plus

fréquente parmi les k données les plus proches.

Les distances utilisées [3]

Les distances les plus souvent utilisées ici sont les

distances euclidienne et Manhattan.

1. Distance euclidienne

La distance Euclidienne est la distance utilisée pour

calculer la distance entre deux points. La distance Euclidienne d

entre les points A et B est donnée par la

relation suivante :

|

d(A, B) =

|

v u u Xn

tk=1

|

(yk -

xk)2. (2.5)

|

31

2. Distance Manhattan d

La distance de Manhattan est nommée ainsi car elle

permet de mesurer la distance parcourue entre deux points par une voiture dans

une ville où les rues sont agencées selon un quadrillage.

La distance de Manhattan d entre deux données

A et B est donnée par la relation suivante :

d(A,B) = Xn |

yk - xk |.

(2.6)

k=1

2.4.3 Les arbres de décision

Les arbres de décision sont des

modèles de ML supervisés et non paramétriques

extrêmement flexibles. Ils sont utilisables aussi bien pour la

classification que pour la régression. Nous décrirons ici

brièvement les principes utilisés pour la classification. Les

arbres de décision utilisent des méthodes purement algorithmiques

qui ne reposent sur aucun modèle probabiliste. L' idée de base

consiste à classer une observation au moyen d'une succession de

questions (ou critères de segmentation) concernant les valeurs des

variables prédictives Xi de cette observation.

Chaque question est représentée par un noeud d'un arbre de

décision. Chaque branche sortante du noeud correspond à une

réponse possible à la question posée. La classe de la

variable cible est alors déterminée par la feuille (ou noeud

terminal) dans laquelle parvient l'observation à l'issue de la suite de

questions [23].

Un modèle de Machine Learning comprend trois sortes de

noeuds [16] : les racines, les noeuds intermédiaires et les

branches. Deux noeuds sont reliés par des branches. La

figure 2.5 illustre ces diffentes parties d'un arbre de décision. Selon

la figure 2.5, on constate que la racine de cet arbre est

x0, les noeuds intermédiaires sont

x2, x3 et

x4. Par

32

FIGURE 2.5 - Exemple d'un arbre avec ses differentes parties

[16]

contre, les branches sont x1, x5;

x6, x7 et x8. On comprend dans ce sens que l'arbre

de décision n'est rien autre qu'une suite de questions où les

réponses constituent des branches et des feuilles.

La question de la profondeur de l'arbre qu'il faut retenir est

délicate et est directement liée au problème du

surapprentissage. Exiger que toutes les observations soient parfaitement

rangées peut rapidement mener au surapprentissage. Pour cette raison on

décide généralement de ne plus rajouter de noeuds lorsque

la profondeur de l'arbre excède un certain seuil, qui caractérise

la complexité maximale de l'arbre de décision, ou lorsque le

nombre d'observations par feuille est trop faible pour être

représentatif des différentes classes (on parle de

pré-élagage). On pratique aussi des opérations

d'élagage a posteriori (prunning) sur des arbres dont les feuilles sont

homogènes en utilisant un jeu de données distinct (prunning set)

de celui qui a permis la construction de l'arbre original [23].

Une fois l'arbre construit à partir des données

d'apprentissage, on peut prédire un nouveau cas en le

faisant descendre le long de l'arbre, jusqu'à une feuille.

Comme la feuille correspond à une classe, l'exemple sera

prédit comme faisant partie de cette classe [26].

Les arbres de décisions interviennent par ailleurs

comme brique de base de l'algorithme plus sophistiqué des forêts

aléatoires que nous présenterons au paragraphe suivant.

33

Quoi que l'arbre de décision soit un algorithme

important en prédiction, elle présente

aussi quelques faiblesses comme nous pouvons le lire selon [26]

:

- C'est un algorithme Glouton, sans backtrack (sans retracer ou

trace arrière).

- Transposables en règles avec des règles ayant des

attributs communs, en particulier

l'attribut utilisé à la racine.

- Présentent des difficultés avec les concepts

disjonctifs.

- Etc.

Aspect mathématiques

Dans cette partie, nous allons voir quelques fonctions

mathématiques utiles pour un arbre de décision. L'algorithme

utilise l'entropie (c'est une théorie tirant ses origines dans la

théorie de l'information. L'entropie en statistique designe le

désordre qui règne dans une population. La constuction de l'arbre

visera à minimiser ce bruit [12]) et le gain d'information comme

fonctions [6].

Etant donné un ensemble C de données

labélisées +, - et p la population totale,

l'entropie sur C de l'ensemble de données S est

donnée par l'équation 2.7

Entropie(C) = X

(-Pcilog2Pci)

(2.7)

ciEC

où Pci =

|Ci|

|S| représente une

probabilité de l'eventualité ci.

L'entropie étant déjà minimisée,

l'étape critialle est de savoir quel attribut testé en premier

(on choisira l'attribut qui maximisera le gain d'information ou, son

équivalent : qui minimisera l'entropie [6] [12] ). Il faut

connaître la notion de gain d'information. Le gain est défini par

un ensemble d'exemples et par un attribut. L'équation 2.8

formulée va donc servir à calculer ce que cet attribut apporte au

désordre de l'ensemble. Plus un attribut contribue au désordre,

plus il est important de le tester pour séparer l'ensemble en plus

petits sous-ensembles ayant une entropie moins élevée [6].

|

Gain(S, A) = Entropie(S) - X

cEvaleur(A)

|

| Sv |

| S | x Entropie(Sv)

(2.8)

|

Les arbres de décisions interviennent par ailleurs comme

éléments de base de l'algorithme

34

plus sophistiqué des forêts aléatoires que

nous présenterons au paragraphe suivant.

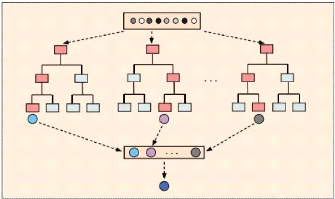

2.4.4 Les forêts aléatoires

Il est connu qu'une forêt est un ensemble de plusieurs

arbres (figure 2.6). Les forêts aléatoires sont donc un ensemble

de plusieurs arbres de décisions.

FIGURE 2.6 - Généralisation du modèle

prédictif Forêt aléatoire [16]

Prenons l'exemple suivant : imaginez-vous, vous vous

rendez à l'hôpital pour le CPN et d'un coût, un

médecin vous annonce que vous allez subir une opération (la

prémière après sept naissances d'avant.) Parfois vous

n'allez pas vous imaginer que cela soit possible. Il vous faut donc un

récours vers un autre médecin car vous supposez que

celui-là n'est pas soit à la hauteur de sa tâche.

[12]

Comme pour l'algorithme de l'arbre de décision, quoi

qu'il y a un seul arbre, mais à l'intérieur de ce dernier sont

groupés plusieurs autres questionnement qui permettent de bien

répondre à une certaine question. L'ensemble de ces portions

d'arbre à l'intérieur d'un arbre constituent pour ce faire un

algorithme appelé forêt aléatoire (Random Forest en

anglais) [12].

Origine des forêts aléatoires

[12]

On doit les random forests au fantastique Leo Breiman,

éminent statisticien américain connu pour ses travaux sur les

arbres décisionnels et sur la méthode CART, introduite

35

précédemment. Lui-même avait parfaitement

conscience du défaut majeur d'un arbre de décision : sa

performance est trop fortement dépendante de l'échantillon de

départ. De plus, on peut s'attendre à ce que l'ajout de quelques

nouvelles données dans la base d'apprentissage (ce qui est une bonne

nouvelle en soit !) ne modifie pas drastiquement le modèle, qu'il le

modifie de façon marginale pour l'améliorer. Ce n'est pas le cas

avec un arbre de décision, dont la topologie peut totalement changer

avec l'ajout de quelques observations supplémentaires. Plutôt que

de lutter contre ces défauts des arbres de décisions, Breiman a

eu l'idée géniale d'utiliser plusieurs arbres pour faire des...

forêts d'arbres ! Vous avez compris le forest dans random forest. Et

random alors ? Pour éviter de se retrouver avec des arbres égaux,

il donne à chaque arbre une vision parcellaire du problème, tant

sur les observations en entrée que sur les variables à utiliser.

Ce double échantillonnage est tout simplement tiré

aléatoirement. Notons que l'assemblage d'arbres de décision

construits sur la base d'un tirage aléatoire parmi les observations

constitue déjà un algorithme à part entière connu

sous le nom de tree bagging. Les random forests ajoutent au tree bagging un

échantillonnage sur les variables du problème, qu'on appelle

feature sampling. On retiendra que :

Random forest = tree

bagging + feature sampling

Avant d'entrer dans le détail de son fonctionnement,

notons enfin que l'on retrouve dans le random forest la polyvalence des arbres

de décision. En effet, on peut les utiliser :

- en classification, le résultat final étant obtenu

en faisant « voter » chaque arbre ;

- en régression, en moyennant le résultat des

arbres.

Le but de l'algorithme des forêts aléatoires est

de conserver la plupart des atouts des arbres de décision tout en

éliminant leurs inconvénients, en particulier leur

vulnérabilité au surapprentissage et la complexité des

opérations d'élagage. C'est un algorithme de classification ou de

régression non paramétrique qui s'avère à la fois

très fléxible et très robuste.

L' algorithme des forêts aléatoires repose sur trois

idées principales :

1. À partir d'un échantillon initial de N

observations (x(1), . . .

x(n)), dont chacune est décrite au moyen de

p variables prédictives, on crée « artificiellement

» B nouveaux échantillons de même taille N

par tirage avec remise. On appelle cette technique

36

le bootstrap. Grâce à ces B

échantillons, on entraîne alors B arbres de

décisions différents.

2. Parmi les p variables prédictives

disponibles pour effectuer la segmentation associée au noeud d'un arbre,

on n'en utilise qu'un nombre in < p choisies « au hasard

». Celles-ci sont alors utilisées pour effectuer la meilleure

segmentation possible.

3. L' algorithme combine plusieurs algorithmes « faibles

», en l'occurrence les B arbres de décisions, pour en

constituer un plus puissant en procédant par vote. Concrètement,

lors qu'il s'agit de classer une nouvelle observation x, on la fait

passer par les B arbres et l'on sélectionne la classe

majoritaire parmi les B prédictions. C'est un exemple d'une

méthode d'ensemble.

Le nombre B d'arbres s'échelonne

généralement entre quelques centaines et quelques milliers selon

la taille des données d'apprentissage. Le choix du nombre in de

variables à retenir à chaque noeud est le résultat d'un

compromis. Il a été démontré que les

prédictions d'une forêt aléatoire sont d'autant plus

précises que les arbres individuels qui la composent sont

prédictifs et que les corrélations entre prédictions de

deux arbres différents sont faibles. Augmenter le nombre in de

variables augmente la qualité de prédiction des arbres

individuels mais accroît aussi les corrélations entre arbres. Une

valeur in de l'ordre de /p constitue un bon compromis

[23].

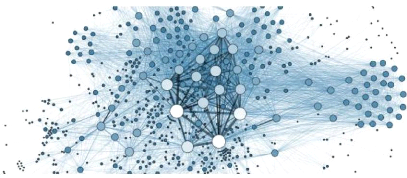

2.4.5 Les réseaux de neurones

artificiels

Les réseaux de neurones artificiels sont

utilisés tantôt dans plusieurs disciplines mais ne constituent pas

en quelques sortes eux mêmes une discipline [27]. Un réseau de

neurone artificiel (parfois simplement réseau de neurones) est un

modèle de prédiction qui met en exergue le fonctionnement du

cerveau. Le cerveau ici considéré est une collection de neurones

connectés les uns aux autres. Chaque neurone examine les sorties des

autres neurones, qui deviennent ses entrées, effectue un calcul, puis se

déclenche ou pas [15]. La figure 2.7 est un exemple illustratif d'un

réseau de neurones.

Les réseaux de neurones résolvent nombreux

problèmes tels que la réconnaissance de l'écriture, la

réconnaissance faciale [25],[15], voire même la fonction du

système nerveu central [24].

37

FIGURE 2.7 - Réseau de neurones [25]

Définition 2.1 Les réseaux

de neurones artificiels sont des réseaux fortement connectés de

processeurs élémentaires fonctionnant en parallèle. Chaque

processeur élémentaire calcule une sortie unique sur la base des

informations qu'il reçoit. Toute structure hiérarchique de

réseaux est évidemment un réseau.

Cependant, développer un réseau de neurones

à moindre coût est l'appanage de [25] : - Un Dataset beaucoup plus

grand (des millions de données)

- Un temps d'apprentissage plus long (parfois plusieurs

jours)

- Une plus grande puissance de calcul.

Pour dépasser ces challenges, les chercheurs dans le

domaine ont développés des variantes du Gradient Descent ainsi

que d'autres techniques pour calculer plus rapidement les

dérivées sur des millions de données. Parmi ces solutions

on trouve [25] :

- Mini-Batch Gradient Descent : Technique

pour laquelle le Dataset est fragmenté en petits lots pour simplifier le

calcul du gradient à chaque itération.

- Batch Normalization : Mettre à la

même échelle toutes les variables d'entrée et de sortie

internes au Réseau de Neurone pour éviter d'avoir des calculs de

gradients extrêmes.

- Distributed Deep Learning : Utilisation du

Cloud pour diviser le travail et le confier à plusieurs

machines.

Historique [27]

- 1890 : W. James, célèbre psychologue

américain introduit le concept de mémoire associative, et propose

ce qui deviendra une loi de fonctionnement pour l'apprentissage sur les

réseaux de neurones connue plus tard sous le nom de loi de Hebb.

- 1943 : J. Mc Culloch et W. Pitts laissent leurs noms

à une modélisation du neurone biologique (un neurone au

comportement binaire). Ce sont les premiers à montrer que des

réseaux de neurones formels simples peuvent réaliser des

fonctions logiques, arithmétiques et symboliques complexes (tout au

moins au niveau théorique).

- 1949 : D. Hebb, physiologiste américain explique le

conditionnement chez l'animal par les propriétés des neurones

eux-mêmes. Ainsi, un conditionnement de type pavlovien tel que, nourrir

tous les jours à la même heure un chien, entraîne chez cet

animal la sécrétion de salive à cette heure précise

même en l'absence de nourriture. La loi de modification des

propriétés des connexions entre neurones qu'il propose explique

en partie ce type de résultats expérimentaux.

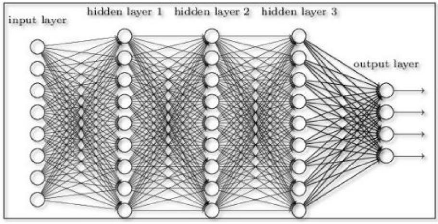

Comment comprendre un réseau de neurones

?

La réponse à cette question viendra à l'aide

de l'exemple sur la figure 2.8. Sur cette

FIGURE 2.8 - Réseau de neurones à plusieurs

neurones [25]

38

39

figure, on remarque à gauche des entrées

appelées input layers et à gauche des sorties

appelées Output layers. Les petits ronds sont

appelés les neurones et représentent des fonctions d'activation

[25].

Ils sont classés suivant le nombre de neurones de chaque

réseau.

Réseau de Neurone à 1 Neurone : Le

perceptron

Le réseau de Neurones le plus simple qui existe porte

le nom de perceptron. Il est identique à la

Régression Logistique de la section précedente.

Les entrées du neurone sont les x

multipliées par des paramètres c à

apprendre. Il existe deux étapes pour le calcul d'un réseau de

neurone d'abord, un calcul linéaire par la somme de toutes les

entrées et le calcul de la fonction d'activation ou la fonction

logistique [25].

On utilise souvent d'autres fonctions d'activation que la

fonction sigmoïde pour simplifier le calcul du gradient et ainsi obtenir

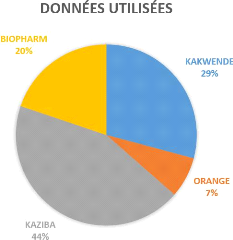

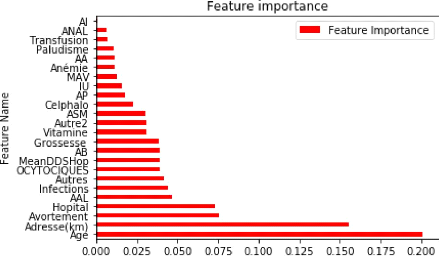

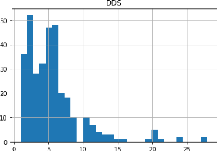

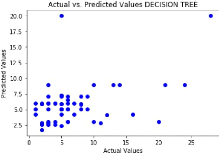

des cycles d'apprentissage plus rapides [25] :