|

IN MEMORIAM

En mémoire de mon défunt oncle et parrain

académique, MASUMBUKO BUNYAS W.J., pour l'orientation efficace

et mon bien-être ; j'en suis reconnaissant de tous ses biens

faits.

Paix à ton âme.

ÉPIGRAPHE

«Most of the knowledge in the world in the future is

going to be extracted by machines and will reside in machines»1(*)

Yann LeCun

DÉDICACE

À mes parents

Je vous suis reconnaissant pour les sages conseils prodigieux

et les directives insistantes. Je vous sais gré de votre bienveillance,

de vos attentions, de vos scrupules et des principes tant moral et spirituel

que vous m'avez insinués. À vous je dédie cet humble

travail, preuve de mon éternelle gratitude.

REMERCIEMENTS

C'est pour nous un honneur et un réel plaisir de

réaliser un tel travail. Son élaboration traduit, à sa

juste valeur, le dévouement le plus soutenu et l'intérêt

que nous lui avons accordé.

Avant tout, nous adressons nos sincères remerciements

au père céleste, créateur de tout, source d'intelligence

et sagesse.

Nous remercions nos très chers parents pour nous avoir

donné non seulement la vie mais aussi pour leurs sacrifices consentis

pour nous faire arriver au stade actuel de notre formation, que toute la

famille trouve un sentiment de profonde reconnaissance à travers ce

travail.

Au terme de nos études universitaires

sanctionnées par ce travail, nous tenons loyalement à remercier

nos professeurs pour leur formation des plus précieuses ainsi que

l'ensemble du corps académique de notre université.

Nos remerciements s'adressent àMonsieur le Professeur

DocteurKAFUNDA KATALAY Pierre,Professeur

attaché à l'Université de Kinshasa, le directeur de ce

mémoire, les assistantsGradi KAMINGU LUBWELE etCamile LIKOTELO

BINENE. ; pour nous avoir dirigé malgré leurs multiples

tâches. N'eut été votre soutien, ce travail ne

s'appellerait pas mémoire. C'est pour nous une meilleure occasion de

vous exprimer nos sentiments de reconnaissance et de profonde gratitude.

Nos remerciements s'adressent à tout le corps

académique et scientifique de la faculté des sciences

précisément ceux du département de Mathématique et

informatique, à la personne du professeur KAPENGA KAZADI, et tant

d'autres pour leur formation durant notre cursus universitaire.

Nos reconnaissances s'adressent non seulementaux ami(e)s et

ainé(e)s scientifiques mais aussi à nos encadreurs

telques :Serge DISUNDA,Hyppolite KABANGO, Glad MAMPUYA, Huguette LUSAMBA.,

Joe BALANGA, Basile MUAMBA, Arnold MWAMBAYI dit MK, Jerry LOMAYE, Ticky KISUBI,

Jean Denis ZOMBINA, Samuel MATONDO, Ignace AWEKWE, Patrick BANYANGA et Carmi

NDEKE.

Sans pourtant oublier nos compagnons de lutte à

l'instar de :Junior ZAKO, Carlos KALALA, Elysé TSHINAWEJ, Victor

KAINDA, Martin MATANDA, Modeste TANGELO, Éric BASA, Benjamin et Odia

TSHIKANGU, Apphia DISASHI, Mireille NGALULA, Alice MABILO, Blanche KAFUTI,

Déborah MOBUTSHI, Dorcas INYANGI, Gloria KANIONIO, Nora MISENGA, Eloi

KINGUEZE, Joe BONGO, Nadège YAHOBU, Brigitte KENGE, Samuel BIGA et

Steave MAYIRA.

Nos remerciements s'adressent aux famillesMASUMBUKOBunyas W.,

KATAGONDWA, Nathalis MUJANGA, Liévin AMISI,Eddy ELUMBA,Albert

VUNINGOMA, BAGAYA, MUDERHWA et MULENGABYUMA.

Nos remerciements s'adressent également à tous

les héros dans l'ombre qui ont contribués pour notre

bien-être physique, intellectuel et spirituel.

Nous dédions ce travail à Extrem Informations

Technology, notre chère entreprise.

AVANT-PROPOS

Le présent mémoire est le résultat de

cinq années d'études universitaires. En plus de son

témoignage de nos cinq longues années, il nous couronne du titre

de deuxième cycle. Ce travail devrait être lu avec un grand

intérêt, non seulement par les scientifiques, mais aussi par les

professionnels.

Le Big Data est une notion très récente dont

l'analyse s'articule plus sur l'administration des de base des données,

généralement rattachée à l'Informatique (surtout

pour son importance en support de stockage et d'analyse, ses applications

continuent à se multiplier du jour le jour.

Cependant, dans ce travail, nous présentons comment

faire l'administration et l'analyse des bases de données NoSQL, du type

document. Ces bases de données sont généralement

destinées aux applications qui gèrent des documents. La nature

souple, semi-structurée et hiérarchique des documents et des

bases de données de documents leur permet d'évoluer avec les

besoins des applications. Le modèle de document fonctionne bien avec les

cas d'utilisation, comme des catalogues, des profils d'utilisateurs et des

systèmes de gestion de contenu où chaque document est unique et

évolue au fil du temps. Les bases de données de documents

permettent une indexation flexible, des requêtes ad hoc efficaces et des

analyses sur des recueils de documents.

Nous remercions d'avance tous les utilisateurs qui voudront

bien nous faire parvenir leurs remarques, suggestions pour

l'amélioration tant syntaxique que sémantique de cet humble

travail.

LISTE DES ABRÉVIATIONS

UTILISÉES

|

Abréviation

|

Signification

|

|

ACID

|

Acide, Cohérence,Isolation et Durablité

|

|

AGPL

|

Affero General Public Licence

|

|

API

|

Application Programming Interface

|

|

BASE

|

Basically Available, Soft state, Eventually

|

|

BCDC

|

Banque Commerciale Du Congo

|

|

BD / BDD

|

Base de données

|

|

BI

|

Business Intelligence

|

|

CAH

|

Classification Ascendante Hiérarchique

|

|

CAP

|

Consistency, Availability, Partition Tolerance

|

|

CDH

|

Classification Descendante Hiérarchique

|

|

DB

|

Database

|

|

DBTG

|

Data Base Task Group

|

|

EA

|

Entité-Association

|

|

GPL

|

GNU General Public Licence

|

|

HA

|

High availability

|

|

HDFS

|

Hadoop Distributed File System

|

|

http

|

Hypertext transfer protocol

|

|

IBM

|

International Business Machine

|

|

IS - IS

|

Intermediate system to intermediate system

|

|

JDK

|

Java Development Kit

|

|

JVM

|

Java Virtual Machine

|

|

MCD

|

Modèle conceptuel des données

|

|

MERISE

|

Méthode de recherche en informatique pour les

systèmes d'entreprise

|

|

ML

|

Machine Learning

|

|

MongoDB

|

Mongo DataBase

|

|

MPD

|

Modèle physique des données

|

|

NASA

|

National Aeronautics and Space Administration

|

|

NoSQL

|

Not only SQL

|

|

OLAP

|

Online Analytical Processing

|

|

OLTP

|

Online Transaction Processing

|

|

OMT

|

Object Modeling Technique

|

|

ORM

|

Object-Relational Mapping

|

|

OSPF

|

Open Shortest Path Protocol

|

|

RN

|

Réseaux de Neurones

|

|

RPG

|

Retro Propagation de Gradient

|

|

SGBD

|

Système de gestion de base de données

|

|

SGBDR

|

Système de gestion de base de données

relationnelle

|

|

SQL

|

Structured Query Language

|

LISTE DES FIGURES

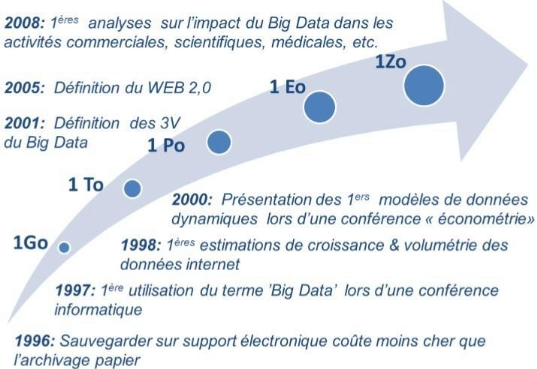

Figure 1.1: Graphique historique du Big Data

[developpez.com-big data-evolution]

3

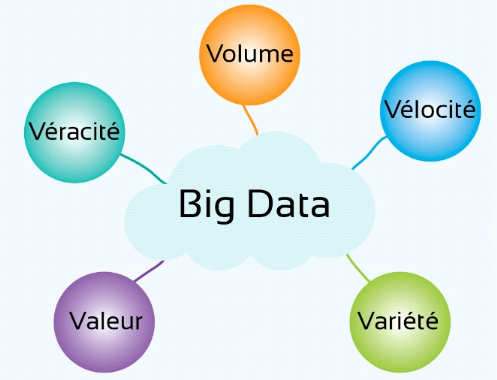

Figure 1.2: Les 5V du Big Data.[Évolution

du Big Data]

10

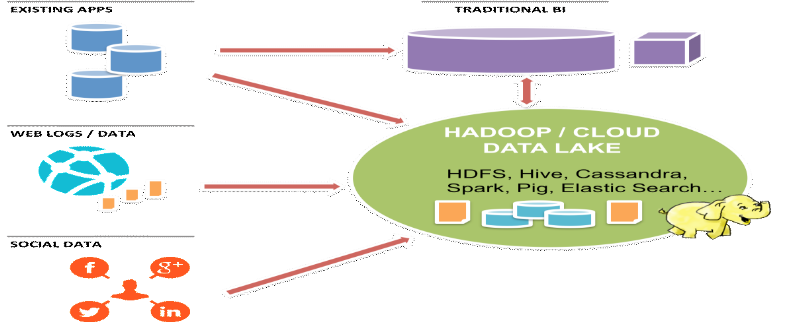

Figure 1.3: Les données du Big Data.[Big

Data et ses données]

11

Figure 1.4: les solutions sur le cloud

computing.

14

Figure 1.5: Guide visuelle au

théorème du CAP.

18

Figure

1.6: Illustration d'une base de données orientées document. [MS

Office Word 2016].

19

Figure 1.7: Illustration d'une donnée

orientées-colonne.

20

Figure 1.8: Illustration d'une base de

données orientées-graphe. [KAMINGU Gradi L, Mémoire

2014].

21

Figure

1.9: Illustration d'une base de données

orientées-clé-valeur [Outil de modélisation

Win'Design].

21

Figure

1.10: Illustration du Cloud Computing.[Du Big Data au Business]

25

Figure 2.11:Présentation logo du SGBD

MongoDB.

32

Figure 2.12:Présentation de Stockage en

GridFS.

34

Figure 2.13: Le modèle de

répartition de MongoDB [Noureddine DRISSI, MongoDB,

Administration].

38

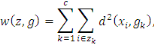

Figure 14: Déroulement de l'algorithme de

centre mobile.

47

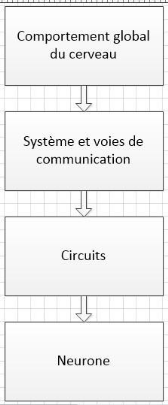

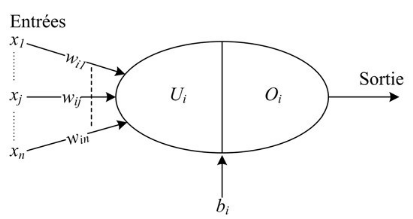

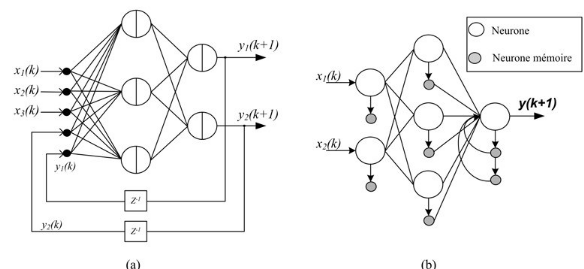

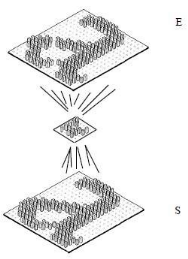

Figure 3.15: Hypothèse biologique de

génération d'un comportement intelligent.

50

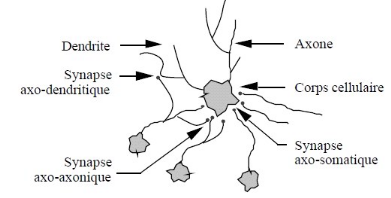

Figure 3.16: Neurone biologique avec son

arborisation dendritique.

51

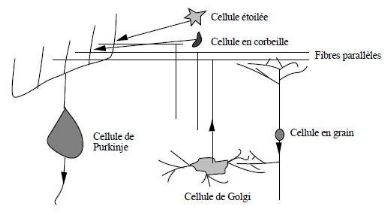

Figure 3.17: Description schématique des

divers types structuraux de neurones présents dans le cortex

cérébelleux.

52

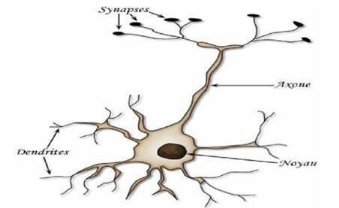

Figure

3.18: Mise en correspondance du neurone biologique/neurone artificiel.

53

Figure 3.19: le fonctionnement d'un

RNA.

54

Figure 3.20: Neurone formel.

55

Figure 3.21: réseau de neurones

bouclé.

58

Figure 3.22: Comportement en phase de

reconnaissance d'un réseau de neurone multicouche lors d'une tâche

d'auto-association.

59

Figure 3.23: Réseaux de neurones

interconnectés.

59

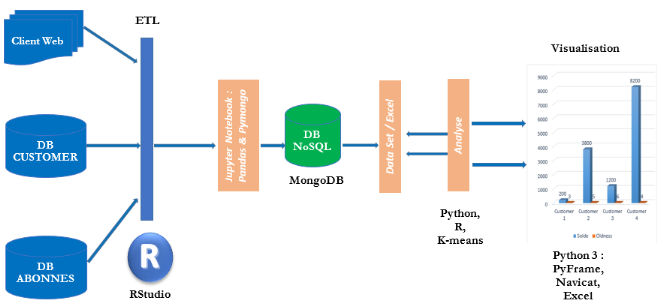

Figure 4.24: Architecture Big Data

intégrant les technologies utilisées.

66

Figure 4.25:Logo de la

BCDC.[www.bcdc.cd]

69

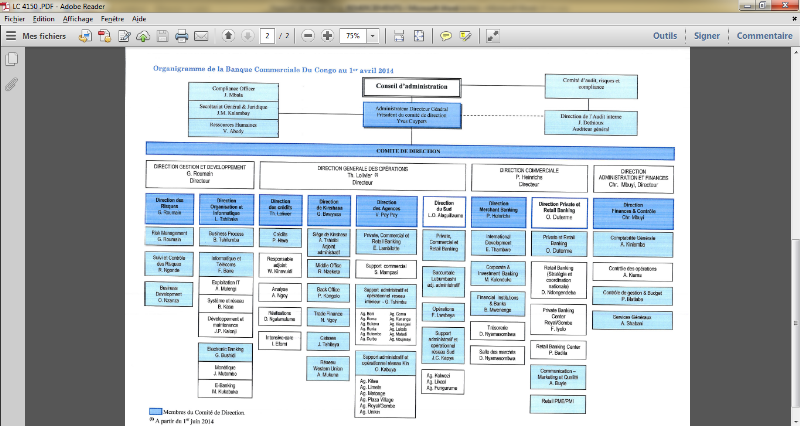

Figure 4.26: Organigramme de la Banque

Commerciale Du Congo.[Département Informatique et DSI]

69

Figure 4.27: Logo du langage de programmation

python.

73

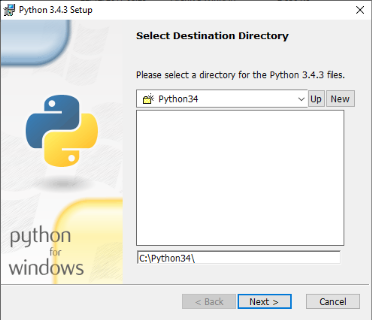

Figure 4.28: Installation Python.[Nous

même]

74

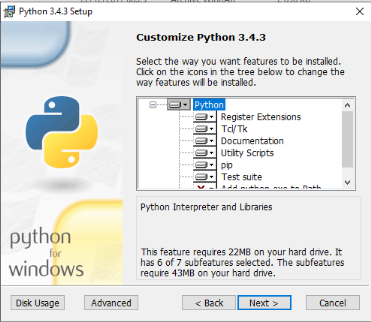

Figure 29: Configuration Python.

74

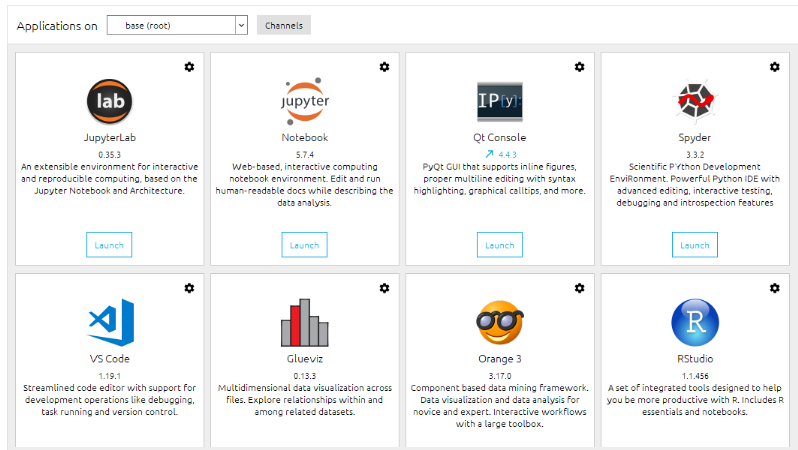

Figure 4.30: Quelques IDE dédiés

au langage de programmation Python.

76

Figure 4.31: Logo de l'environnement de

développement intégré Jupyter-IDE.

76

Figure 4.32: Logo de l'EDI RStudio.

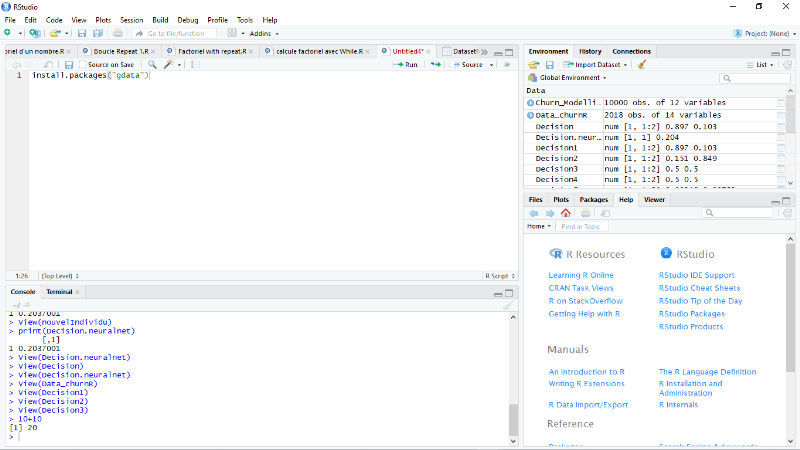

77

Figure 4.33: Espace de travail pour

l'environnement de développement intégré Rstudio version

3.4.

78

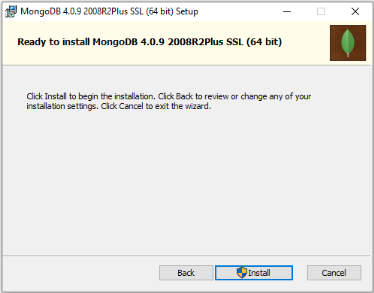

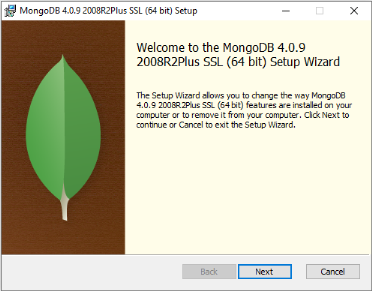

Figure 4.34: Préparation de

l'installation du serveur MongoDB.

79

Figure 4.35: Lancement de l'installation du

serveur MongoDB.

79

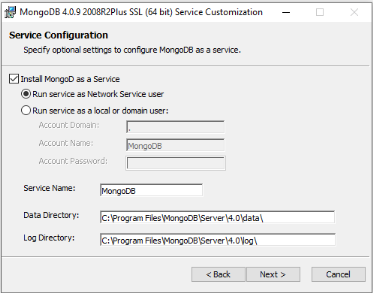

Figure 4.36: Configuration du Serveur

MongoDB.

79

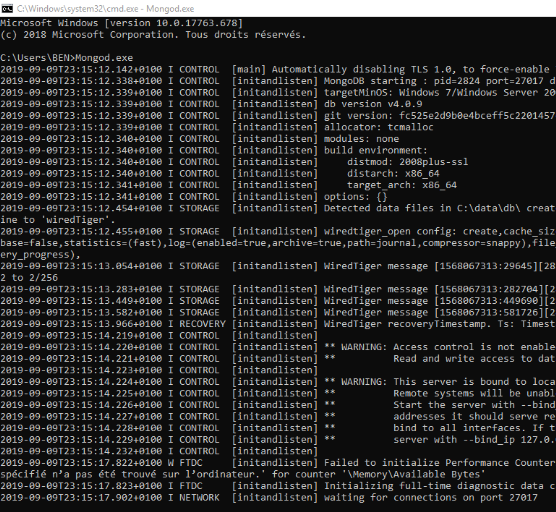

Figure 4.37: Démarrage du Serveur MongoDB

avec la commande mongod.exe [Serveur MongoDB]

80

Figure 4.38: Création de la base de

données.

80

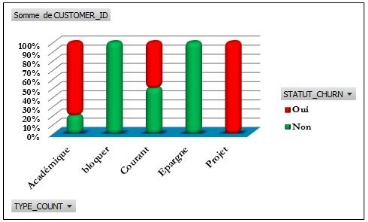

Figure 4.39: Statut churn selon les types de

compte.

82

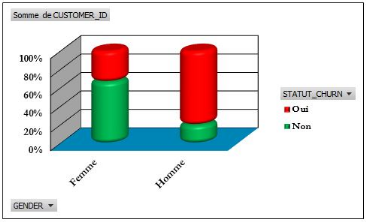

Figure 4.40: Statut churn selon le

sexe.

82

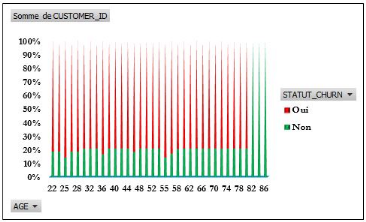

Figure 4.41:Statut churn selon l'âge des

clients.

83

Figure 4.42: Statut churn selon

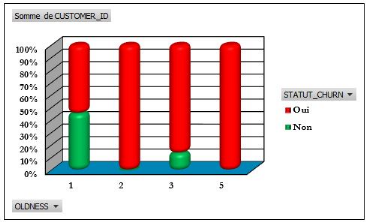

l'ancienneté des clients dans l'institution.

83

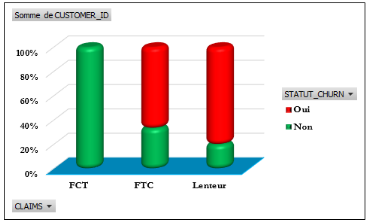

Figure 4.43: Statut churn selon les

réclamations des clients.

84

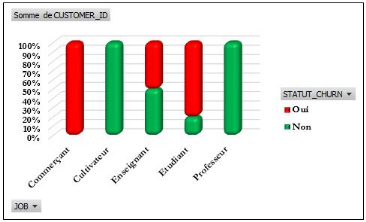

Figure 4.44: Statut churn selon la profession

des clients.

84

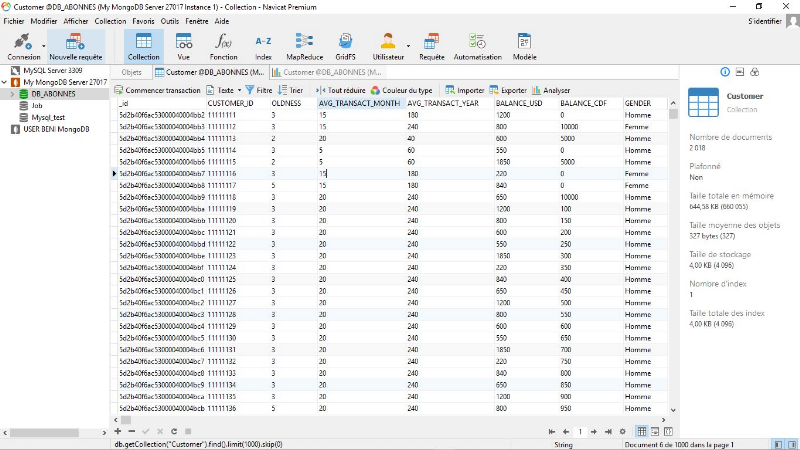

Figure 4.45: Extrait de données

d'apprentissage depuis MongoDB. Vue n°1 [Client Navicat

Premium-MongoDB].

83

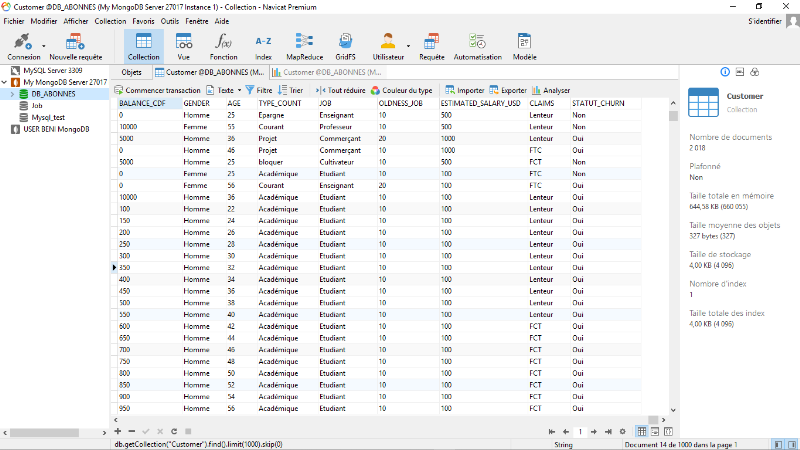

Figure 4.46: Extrait de données

d'apprentissage depuis MongoDB. Vue n°2 [Client Navicat

Premium-MongoDB].

84

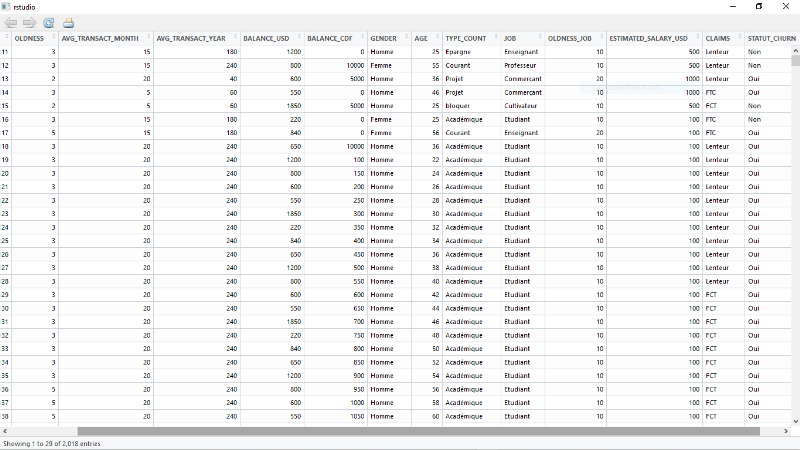

Figure 4.47: Visualisation des données

d'apprentissage.[RStudio]

85

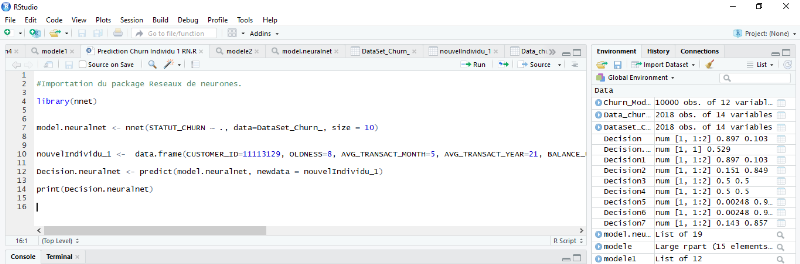

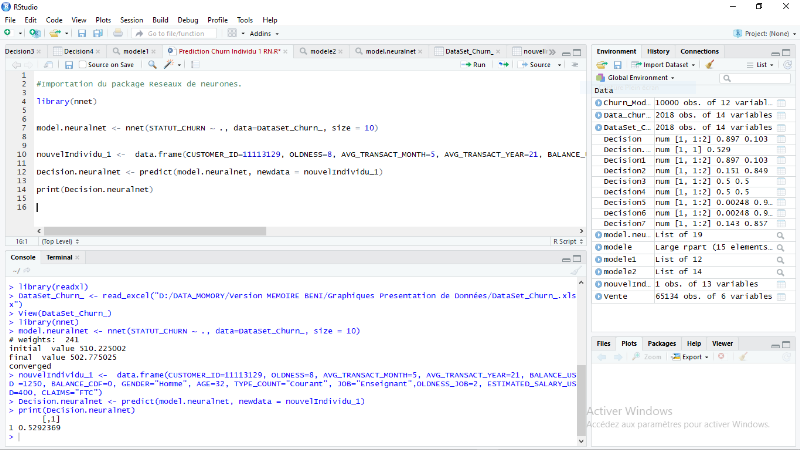

Figure 4.48: Phase d'apprentissage pour le

classement d'un nouveau client (individu). [RStudio]

85

Figure 4.49: Nouvel individu à

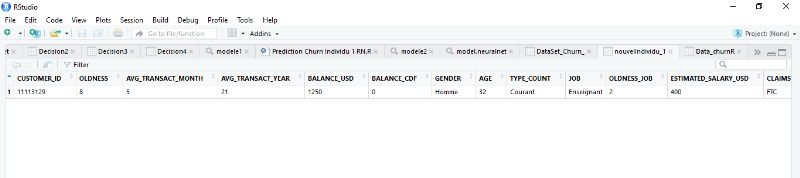

prédire cas 1. [RStudio]

86

Figure 4.50: Classement du nouvel individu

premier cas (1). [RStudio]

87

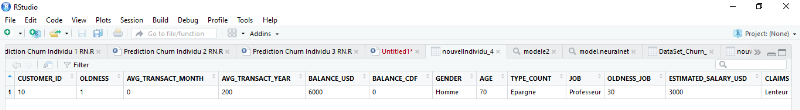

Figure 4.51: Nouvel individu à

prédire deuxième cas (2). [RStudio].

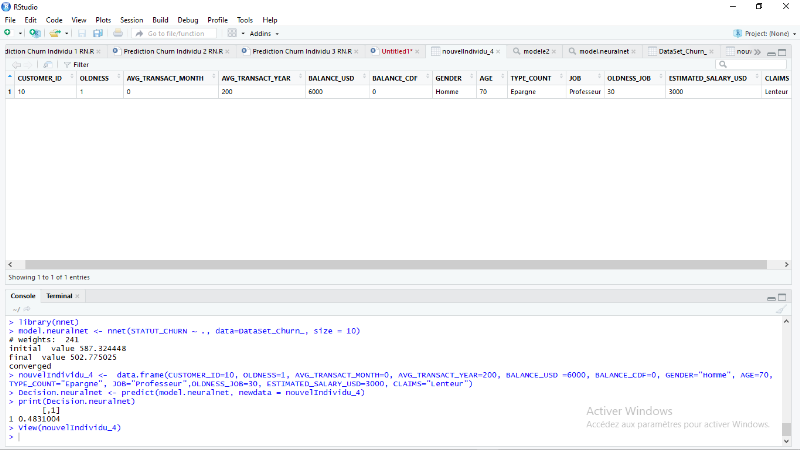

88

Figure 4.52: Classement du deuxième

nouvel individu deuxième cas 2. [RStudio]

89

LISTE DES TABLEAUX

Tableau 1.1: Les sociétés

utilisant la technologie de NoSQL.[ Enjeux et usages du Big Data technologies,

méthodes et mise en oeuvre]

3

Tableau 2.2: Comparaison de système de

Base des données NoSQL.

30

Tableau 3.3: Méthodes de Fouille de

données.

42

Tableau 4.4: Dictionnaire des variables

descriptives utilisées.

81

INTRODUCTION GENERALE

1. CONTEXTE

Au cours de dix dernières années, grâce

à l'internet et des autres objets connectés, les informations

sont devenues non seulement disponibles mais aussi très subtiles et

facilement manipulables. Cette explosion des données est une aubaine

pour les entreprises mais en même temps une responsabilité, parce

qu'elles nécessitent une gestion adéquate et minutieuse afin

d'orienter leurs certaines décisions.

En effet, ces informations qui proviennent de sources

hétérogènes imposent aux entreprises surtout du secteur

bancaire à utiliser des techniques de pointe afin de les gérer et

stocker. Désormais, il a été remarqué que les

entreprises enregistrent plusieurs données des clients surtout lors des

ouvertures des comptes et au cours de la période où ils sont

comme membres, clients.

Ces données peuvent être recueillies de diverses

manières notamment à travers les réseaux sociaux, les

plateformes téléphoniques, les courriers électroniques. Ce

genre d'informations constituent une masse de données souvent non

structurées et posent un problème de gestion (analyse,

traitement, stockage, etc.) avec des outils classiques.

A ces jours, il existe des outils qui permettent de traiter et

de stocker ces gigantesques volumes d'informations grâce à une

technologie appelée le Big Data. L'une de ses plus grandes promesses est

de permettre le développement des entreprises par l'analyse et la

transformation de ces informations, c'est-à-dire l'évaluation du

volume de ces données provenant de diverses sources avec une certaine

rapidité.

Au-delà de leur inopérabilité (formes et

quantités) aux technologies traditionnelles, le Big Data permet

l'exploration de très grands ensembles de données pour obtenir

des informations utilisables.

Le Big Data fait référence à des

technologies qui permettent aux entreprises d'analyser rapidement un grand

volume de données et d'obtenir une vue synoptique. En combinant

l'intégration de stockage, analyse prédictive et applications, le

Big Data permet d'économiser du temps et facilite une

interprétation de qualité des données. Aussi, la

croissance exponentielle des données, la prise en compte des

données faiblement structurées et les avancées

technologiques sont tous des arguments qui poussent les entreprises

principalement les géants du web à faire une migration de leur

système d'information des systèmes de gestion de base de

données traditionnelle (SGBD) aux nouveaux systèmes de gestion de

base de données du type NoSQL, c'est-à-dire aux moteurs de base

de données utilisant non seulement le standard SQL.

Ces nouveaux systèmes de gestion de base de

données dit NoSQL offrent une meilleure disponibilité des

données et des capacités de stockage gigantesques en

libérant les contraintes des propriétés ACID

(Atomicité, Cohérence, Isolation et Durabilité). Ce

mouvement de SGBD de type NoSQL a trouvé une place importante dans les

infrastructures de NTIC (Nouvelle technologie de l'information et de la

communication) et est devenu largement utilisé.

De ce fait, les entreprises en général et les

banques en particulier retardent encore les pas pour s'approprier et d'utiliser

cette technologie pouvant leurs permettre d'analyser, traiter et stocker

facilement les données.

Dans le cadre de ce travail, nous nous sommes appesantie sur

le cas de la Banque Commerciale Du Congo (BCDC) qui accumule une foison des

données avec la croissance sans précédente de ses clients.

Cette banque qui cherche le jour le jour à convaincre des clients

potentiels, les convertir et les fidéliser, utilise jusqu'à ce

jour, malgré les migrations technologiques,des systèmes de

stockage tels que SQL Serveur, Oracle DataBase, Informix et Accès et

Excel comme outils d'analyse. Il se pose donc un problème d'analyse des

comportements des clients (analyse de churn) au sein de cette institution

bancaire en vue d'anticiper au départ brusque des clients. Alors que

l'orientation de certaines stratégies marketing axées sur la

promotion des nouveaux produits et offres se réfère le plus

souvent aux données fidèlement analysées et

stockées dans les bases des données du type NoSQL

orientées document.

L'utilisation de cette technologie NoSQL permettrait à

la BCDC non seulement de mieux analyser les comportements ou des transactions

(dépôts, retraits, transferts, virements bancaires, emprunts etc.)

de ses clients mais aussi et surtout prédire des nouvelles connaissances

ou tendances grâce aux données existantes sur les clients pour

permettre au décideur de prendre une décision afin de maximiser

ses recettes.

2. PROBLEMATIQUE

Partant de cette observation, nous résumons notre

problématique autour des questions suivantes :

· Est-il important de connaître les offres ou

produits qu'aiment les clients au sein de la BCDC ?

· Est-il important de prédire les nouvelles

connaissances sur les clients ?

· La prédiction des nouvelles connaissances

aidera-t-elle la BCDC à fidéliser ses clients aussi longtemps

quepossible ?

· Quelle est la place et la valeur ajoutée

d'une technologie NoSQL orientée document au sein de la

BCDC ?

3. HYPOTHESE

Nous formulons notre hypothèse de la manière

suivante : la mise en place d'un système prédictif

basé sur l'administration d'un Big Data sous le SGBD MongoDB et

l'extraction des connaissances par l'algorithme de data mining, réseaux

de neurones, au sein de la Banque Commerciale Du Congoafin d'avoir une vision

exhaustive de l'ensemble des comportements de ses clients et prendre des

décisions optimales synchrones y afférentesserait la meilleure

solution.

4. CHOIX ET INTERET DU SUJET

4.1.

Choix du sujet

Le sujet que nous avons choisi est intitulé :

« Administration d'un Big Data sous MonogoDB et extraction de

connaissance par réseaux de neurones : Application de

l'analyse de churn dans une institution bancaire » cas de la

BCDC.

4.2.

Intérêt du sujet

Ce travail subdivise son intérêt en trois niveaux

à savoir :

· Au niveau de l'entreprise : ce travail permettra

à l'entreprise de pouvoir gérer et extraire les différents

comportements de ses clients. Cela permettra aux autorités d'analyser le

comportement des clients, c'est-à-dire leurs préférences,

afin de répondre à leurs besoins ou de proposer des offres plus

agréables pour fidéliser leurs clients ;

· Au niveau personnelle :ce travail me permet de

concilier les différentes théories que nous avions apprises

depuis le début de nos études universitaires jusqu'à nos

jours à la pratique ;

· Au niveau scientifique : ce travail est un document

permettant de comprendre les différentes étapes de la conception

d'une base de données NoSQL orientée-document et la mise en

oeuvre d'un système décisionnel utilisant des outils de data

mining.

5. METHODES ET TECHNIQUES UTILISEES

5.1.

Méthodes

Quant à notre travail, nous avons eu à utiliser

des méthodes scientifiques analytiques qui nous ont permis de faire une

analyse profonde par rapport aux données colletées.

5.2.

Techniques

Pour l'élaboration du présent travail, nous

avons fait recours aux techniques ci-après :

ü Documentaire : par laquelle nous nous

sommes servis pour la récolte des diverses informations à partir

de notre cours, livre, syllabus, mémoire, etc.

ü Navigation par internet : par laquelle

nous avons plus utilisé pour consulter quelques sites internet pour la

récolte des informations ayant trait à notre travail.

ü Interview : cette technique nous a

également permis d'entretenir librement avec certains agents de notre

entité.

6. SUBDIVISION DU TRAVAIL

Hormis l'introduction et la conclusion générale,

notre travail comprend 4 chapitres à savoir :

· Le chapitre premier intitulé « Big

Data » contient des généralités sur la notion de

Big Data ;

· Le second chapitre intitulé « SGBD

orienté document et MongoDB » dans lequel nous avons

décrit les différents SGBD orientés documents tout en nous

concentrant sur le SGBD MongoDB,

· Le troisième chapitre, « Fouille de

données et Réseaux de Neurones », dans lequel nous

parlons en détail des différents algorithmes d'analyse que nous

utiliserons dans la mise en oeuvre ;

· Le dernier chapitre, qui concerne

l'« Implémentation et interprétation des

résultats ».

CHAPITRE I: BIG DATA[1],

[6], [12], [16], [19]

I.1. INTRODUCTION

Au cours des dix dernières années, le monde a

connu une augmentation exponentielle des informations disponibles via Internet

et le nombre d'objets connectés augmente constamment. Les entreprises

ont également accumulé des informations utilisées ou non

sur leurs clients.

Les taux de croissance de volume attendus des données

traitées dépassent les limites des technologies traditionnelles.

Parfois, on parle de pétaoctets (ou billard d'octets) ou même de

zettaoctet (trilliard d'octets) et à la longue, on parle de yottaoctet

(1012 octets). Il est rapidement devenu indispensable de mettre

à niveau les baies de stockage traditionnelles pour leur permettre

d'absorber le nombre croissant et la diversité des sources de ces

données. Ces données collectées sur le Web (réseaux

sociaux, plate-forme téléphonique, courrier électronique,

commerce électronique, open data (données en accès libre),

géolocalisation des personnes ouvrent des possibilités de

personnalisation de produits. Les entreprises voient dans ce

phénomène l'occasion de cibler très

précisément les attentes du client.

Les données sont donc le carburant de l'économie

numérique. Tous les secteurs de l'économie, du commerce à

l'automobile en passant par le secteur de l'énergie, tous les domaines

de la vie quotidienne (santé, éducation, etc.) sont

concernés. Le Big Data combine à la fois le traitement de ces

grandes masses de données, leur collecte, leur stockage, leur

visualisation et leur analyse. Comment relier toutes ces données ?

Comment les faire parler ?

Comment faire face à l'explosion du volume de

données, un nouveau domaine technologique est apparu : le Big Data.

Inventé par les géants du Web, outil très important et en

pleine expansion, tant pour la prise de décision que pour l'optimisation

de la compétitivité (au sein des entreprises), les entreprises

ont su dépasser tous les problèmes de multi-structuration et

d'hétérogénéité des sources de ces

données. Ainsi, le Big Data peut être défini sous de

nombreuses formes, en fonction du domaine appliqué, et peut être

considéré comme un outil permettant d'explorer de très

grands ensembles de données pour obtenir des informations

exploitables.

La démarche du Big Data et sa capacité à

traiter rapidement des données non structurées et

structurées provenant d'un grand nombre de sources ouvrent des

perspectives dans un grand nombre de secteurs de la vie tels que: le commerce

et la gestion des relations clients, la défense et le renseignement

(cybersécurité, biométrie), etc. et dans un grand nombre

d'activités humaines telles que: la détection de fraude, la

maintenance prédictive, etc., leur mise en valeur au service des

consommateurs, de nos concitoyens.

I.2. APERÇU HISTORIQUE

Le Big Data a une histoire récente et en partie

cachée, en tant qu'outil des technologies de l'information et en tant

qu'espace virtuel d'importance croissante dans le cyberespace.

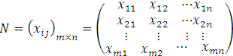

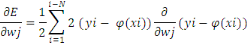

SH. Lazare et F. Barthélemy (www.axiodis.com), dans

leur document intitulé « Introduction aux Big Data »,

présentent l'historique suivant, représenté graphiquement

de la manière suivante :

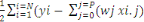

Figure 1.1:Graphique historique

du Big Data [developpez.com-big data-evolution]

Selon le document « Big-Data et Data-Marketing », le

terme « Big Data » est apparu pour la première fois

en 2000 lors d'un congrès d'économétrie, puis a repris en

2008 et 2010 sous la couverture de revues Nature et Sciences, et s'est

établi dans les entreprises suite à un rapport de MC Kinsey en

2011.

Le répertoire de référence pour les

utilisateurs intitulé « GUIDE DU BIG DATA 2013-2014 » indique

que le Big Data est apparu il y a seulement trois ans dans le domaine de la

prise de décision et se positionne comme l'innovation numéro un

de la première décennie et à la frontière entre

technologie et management.

Selon V. Tréguier (2014) et selon la « très

courte histoire du Big Data » publiée par Gil Press en 2013 pour la

période 1944-2012, sa naissance est liée à

l'évolution des systèmes de stockage, de fouille et d'analyse de

l'information numérisée, qui ont permis une sorte de big bang

d'informations stockées, puis une croissance inflationniste dans le

monde des données numérisées. Mais ses prémisses se

situent au confluent de la cybernétique et des courants de pensée

nés pendant la Seconde Guerre mondiale, selon lesquels l'homme et le

monde peuvent être représentés comme des

« ensembles d'informations, dont la seule différence avec la

machine est leur niveau de complexité. La vie deviendrait alors une

séquence de 0 et de 1, « programmable et

prévisible » », ajoute V. Tréguier.

Les risques d'abus par des gouvernements ou des entreprises

ont été décrits pour la première fois par Orwell

à la fin de la dernière guerre mondiale, et souvent par la

science-fiction. Avec l'apparition de grandes banques de données dans

les années 1970 (et tout au long de la guerre froide), de nombreux

auteurs s'inquiètent des risques d'atteinte à la vie

privée, notamment le professeur A. Miller, qui cite l'exemple de la

croissance des données stockées relatives à la

santé physique et mentale des individus.

I.3. PRESENTATION DE

L'ASPECTS BIG DATA2(*)

Au-delà des aspects purement quantitatifs, ces

données sont présentées de telle manière qu'elles

ne sont guère supportées par les SGBD traditionnels :

v Elles ne sont pas nécessairement organisées en

tables et leurs structures peuvent varier ;

v Elles sont produites en

temps rée

l

;

v Elles arrivent mondialement en flots continus ;

v Elles sont

méta taguée

s

mais de façon

disparate (localisation, heure, jour, etc.) ;

v Elles proviennent de sources très disparates

(téléphone mobile, capteurs, téléviseurs

connectés, tablettes, PC fixes, PC portables, objets, machines), de

façon désordonnée et non prédictible.

Depuis quelque temps, le mot Big Data est apparu et est

largement utilisé par les journalistes, les analystes, les consultants

et certains éditeurs ou fabricants occidentaux qu'orientaux

intéressés par le monde de la prise de décision. Mais il

est clair qu'aucune définition n'a été imposée et

que les mots des uns et des autres mélangent avec bonheur beaucoup de

choses, le volume global de données à traiter, le volume de la

base de données (web log, texte, photo, vidéo, etc.), types de

données (structuré, non structuré,

multi-structuré), ambitions analytiques (aller au-delà de la BI),

etc.

Il est difficile de dire si le mot Big Data est adapté

et durera (continuera à l'être), mais il est certain que le

domaine de la prise de décision connaît un développement

important lié à l'émergence simultanée de

« nouvelles demandes » et de « nouvelles solutions

technologiques » aboutissant au traitement de plus en plus de

données, à la fois en termes de volumes et de

variétés. La quantité de données

générées quotidiennement dans les systèmes

d'information augmente de manière exponentielle et, par

conséquent, la volumétrie explose aussi dans le monde de la prise

de décision.

Le traitement du Big Data n'entraîne pas une

révolution dans le monde de la prise de décision mais

élargit le champ de travail des experts de ce domaine, conduit à

modifier les infrastructures en place pour répondre aux nouvelles

exigences de volume, de variété et de vitesse données,

pour changer la façon dont les données sont

préparées pour une analyse avancée, et comme souvent

lorsque le marché aborde un nouveau sujet, les solutions occupent une

place centrale, même si elles ne sont pas une panacée

(remèdes, solutions, moyens) universelles.

Le Big Data permet sans aucun doute de mieux connaître

les clients3(*), par exemple

en traitant automatiquement ce qu'ils disent, pour mieux les servir via des

solutions de commerce électronique et de Cloud Computing, qui sont

à la fois de plus en plus sophistiquées et de plus en plus facile

à mettre en place.

Mais au finish, le Big Data n'est qu'une extension de ce qui a

été fait pendant des années et présente les

mêmes avantages, inconvénients ou risques: information,

propagande, désinformation et mystification.

I.4. OBJECTIFS

Le Big Data est une nouvelle technologie qui poursuit

plusieurs objectifs, parmi lesquels:

v L'objectif de ces solutions d'intégration et de

traitement de données est de gérer un très grand volume de

données structurées et non structurées sur une

variété de terminaux (PC, smartphones, tablettes, objets

communicants, etc.), produits ou non en temps réel depuis n'importe

quelle zone géographique du monde ;

v Un autre objectif réside dans la capacité de

gérer en temps réel un volume de données de plus en plus

important et en constante évolution.

v Le Big Data vise à améliorer les services

existants, c'est-à-dire que leur apparence ne signifie pas la fin des

entrepôts de données, mais vise à les compléter en

fonction de besoins spécifiques de l'entreprise en proposant des

alternatives pour adapter le fonctionnement des bases de données

relationnelles à des besoins spécifiques ;

v Cette solution est conçue pour offrir

également un accès en temps réel aux bases de

données géantes.

I.5. CARACTERISTIQUES

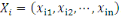

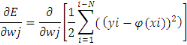

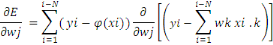

À l'origine, le Big Data était

caractérisé par la problématique du 3V4(*), à savoir Volume,

Vitesse, Variété. Alors que le concept et la technologie se

répandaient rapidement dans de nombreux secteurs industriels et

économiques et occupaient une place prépondérante, les

chercheurs dans ce domaine ont encore poussé plus loin les

caractéristiques du Big Data en valorisant les données pour

obtenir un 4ème V puis rechercher leur véracité

pour constituer son 5ème V.

Vous êtes confronté à un problème

de gestion de données correspondant à ces trois critères,

à savoir Volume, Vitesse et Variété ou plus simplement,

vous ne savez pas comment gérer ces données avec les

architectures traditionnelles, vous avez alors un problème de type Big

Data.

Il faut en effet penser à collecter les données,

les stocker puis les analyser de manière à ne plus pouvoir

être traitées par une approche traditionnelle permettant de

satisfaire les 4ème et 5ème V qui sont la

Valorisation et la Véracité des données.

Ces 5 V du Big Data peuvent se définir ou s'expliquer

de la manière suivante :

· Volume (Volume) :

représente la quantité de données

générées, stockées et utilisées dans le SI.

L'augmentation du volume dans le SI s'explique par l'augmentation de la

quantité de données générées et

stockées, mais aussi et surtout par la nécessité

d'exploiter des données qui, jusqu'à présent, ne

l'étaient pas. L'unité principal pour mesurer le volume de

données étant l'octet.

Pour rappel, 1 mégaoctet = 106 octets ; 1

gigaoctet = 109 octets ; 1 téraoctet =

1012 octets ; 1 pétaocte = 1015

octets ; 1 exaoctet = 1018 octets ; 1 zettaoctet =

1021 octets ; 1 yottaoctet = 1024 octets.

En effet, aujourd'hui, les données sont d'ordre de zetta

ou même yottaoctets.

· Varieté (Variety) :

représente la démultiplication des types de données

gérés par un SI, nous parlons ici de type de données au

sens fonctionnel du terme et pas seulement au sens technique. En fait, les

données traitées sont des tweets, des vidéos, des photos,

des textes, des audios, etc. La démultiplication implique

également la complexification5(*) des liens et des types de lien entre ces

données.

· Vélocité

(Velocity) : représente la fréquence à laquelle

les données sont générées, capturées et

partagées. Les données arrivent par flux et doivent être

analysées en temps réel pour répondre aux besoins des

processus chrono-sensibles, donc urgents.

· Valeur (Value) : représente la

capacité de disséminer rapidement des informations au sein de

l'organisation pour leur permettre d'être reflétées dans

les processus métier.

· Véracité

(Veracity) : représente la résistance à laquelle

se heurte l'organisation pour explorer, exploiter les données

disponibles au sein des processus métier.

Ainsi, aux trois V de base, à savoir Volume,

Variété, Vélocité, les acteurs du marché ont

également ajouté d'autres V, qui sont la Valeur des

données pour ce qu'ils sont susceptibles de contenir sous forme de

signaux ou en référence au fait qu'ils sont commercialisables, et

Véracité d'insister sur la qualité nécessaire des

données.

Figure 1.2:Les 5V du Big

Data.[Évolution du Big Data]

I.6. DEFINITION DU BIG

DATA

Eu égard aux concepts définis ci-haut, on peut

redéfinir le Big Data comme suit :

I.6.1. Première

définition de Big Data

Le Big Data désigne des ensembles des

données de nature variée, et se générant à

très grande vitesse, devenus si volumineux qu'ils vont au-delà de

l'intuition et des compétences analytiques humaines, mais

également de celles des outils informatiques de gestion de base de

données (ou de gestion l'information) traditionnels.

I.6.2. Deuxième

définition de Big Data

Le Big Data désigne des ensembles des

données caractérisées par les 3 (ou 5) V.

I.7. TYPES6(*) DES

DONNEES DU BIG DATA

Comme nous l'avons vu, le Big Data réside dans la

capacité de gérer en temps réel un volume de

données de plus en plus important et en constante évolution. Afin

d'approfondir les solutions répondant à ce besoin, il convient de

distinguer les différents cas d'utilisation que l'on refusera en

fonction du type de données manipulées et de l'utilisation que

l'on souhaite en faire. Le Big Data comprend deux types principaux de

données : les données structurées et les données

non structurées.

Figure 1.3:Les données du

Big Data.[Big Data et ses données]

I.7.1. Données structurées

Elles sont définies par le fait qu'elles sont

conçues pour être traitées automatiquement et efficacement

par un logiciel, mais pas nécessairement par un humain. Les

données structurées nous amènent dans un virage qui

s'appelle Big Data Analytics (ou Big Analytics).

Le Big Data Analytic désigne un ensemble des

technologies de pointes mise en place pour fonctionner de manière

efficace sur les grandes masses de données

hétérogènes. Dans cette approche, l'analyse des

données structurées évolue de par la variété

et la vélocité des données manipulées. On ne peut

donc plus se contenter d'analyser des données et de produire des

rapports, la grande variété des données fait que les

systèmes en place doivent être capables d'aider à l'analyse

des données.

L'analyse consiste à déterminer automatiquement,

au sein d'une variété de données en évolution

rapide, les corrélations entre les données afin de contribuer

à leur exploitation.

I.7.2. Données non structurées

Au contraire, elles sont définies comme des

données disponibles mais non directement exploitables. En fait, ce sont

les données qui peuvent être extraites de tous les types de

documents électroniques (courrier électronique, document Word,

vidéo, image, SMS, courrier électronique, page Web, réseau

social). Les données non structurées nous amènent dans un

autre virage celui, du Text Mining.

Le Text Mining (fouille de textes) permet à un ensemble

de documents d'analyser leur contenu par le biais d'une recherche

sémantique basée sur l'analyse du langage naturel (le

français par exemple) et la gestion d'ontologies

spécialisées (pour un secteur d'activité, un

métier). Cette fouille peut permettre de déterminer le contenu

d'un document, mais aussi aller jusqu'à analyser le ressenti par des

tournures de phrases pour savoir par exemple si un client se plaint ou fait une

simple demande d'informations.

À l'issue de cette fouille, on produit la liste des

« concepts et relations » 2 abordés dans un document afin de

pouvoir alimenter une base de connaissances qui permet :

? Soit d'effectuer des recherches au sein de ce fond

documentaire ;

? Soit d'extraire des données qui serviront à

alimenter d'autres systèmes.

La différence entre une analyse sémantique et

une indexation classique de document est que l'indexation se contente de

référencer les mots présents dans un document sans

s'intéresser au sens, à l'usage fait de celui-ci.

I.8. TECHNIQUES D'ANALYSE ET DE VISUALISATION DU BIG DATA

Pour donner un sens à cette masse de données, il

existe des modèles mathématiques qui répondent aux

principes des méthodes prédictives. Vous voulez obtenir des

résultats plus pertinents et dégager des nouvelles tendances,

certains de ces modèles nécessitent des ajustements et des

réglages. Ce détail important fait partie intégrante de

l'analyse des données et plus encore lorsqu'elles sont volumineuses.

Il est concevable que Big Data soit une solution d'aide aux

entreprises qui leur permette non seulement de réduire leurs risques,

mais également de faciliter la prise de décision, et l'aide de

l'analyse prédictive d'avoir une « expérience client »

plus personnalisée et contextualisée (marketing

personnalisé).

Les techniques de « Data Mining » sont

adaptées à cette masse de données dans laquelle il faut

explorer, faire parler et interpréter ces volumes d'informations.

L'apprentissage automatique a d'énormes progrès. La combinaison

de ces algorithmes avec les capacités de stockage disponibles, sans

parler de la puissance de calcul des machines et des outils devenus disponibles

aujourd'hui, nous offre la possibilité de rechercher et de faire parler

les données.

I.8.1. Visualisation

Pour une bonne prise de décision, la

présentation des résultats doit être lisible. La prise de

décision est difficile avec les données présentées

avec toutes leurs complexités. Le Big Data présente d'autres

représentations des données plus lisibles que des graphiques

classiques, histogrammes, courbes, camemberts, tels que nous les connaissons.

La visualisation peut jouer un rôle crucial en rendant

les composants analytiques individuels compréhensibles et en les

regroupant dans une image globale intelligible. De plus, la visualisation peut

être utilisée de différentes manières pour aider

à contrôler le volume et la complexité des données

et ainsi simplifier leur interprétation. Pour comprendre comment, vous

pouvez commencer avec un seul ensemble de données client et ajouter des

vues client, y compris celles de Big Data.

I.9. DIFFERENCES AVEC L'INFORMATIQUE TRADITIONNELLE

OUDECISIONNELLE

Les principales différences entre les données

traditionnelles et les données massives ne concernent donc presque pas

le volume, même s'il a explosé, mais le type de données et

la façon dont elles sont stockées.

v Du point de vue modèle, les données

traditionnelles stockées ou géré avec un modèle

déjà préalablement défini d'avance dans de bases de

données ou entrepôts. À contrario, les données du

Big Data sont stockées sans construction d'un modèle

préalable de rangement.

v Du point de vue type des

données, Les données traditionnelles ont un type

bien définies à l'avance suivant un certain modèle

préalable autrement dit que les données traditionnelles sont des

données de type structurées. En revanche quand on parle du Big

Data, il s'agit donc des données de types divers dont au moins une

partie est constituées de données non structurées ou multi

structurées.

v Du point de vue langage, souvent,

c'est le langage SQL qui est utilisé pour formuler des requêtes

avec des données traditionnelles, cela est supposé d'avoir

défini par avance les types d'informations (ou des données) qui

doivent être stockées et établi un modèle permettant

de relier ses informations entre elles. Avec le Big Data, on parle des

données NoSQL car les normes du langage SQL ne permettent plus de les

traiter.

v Du point de vue stockage et

technologique, les données traditionnelles sont

stockées au sein des bases de données relationnelles ou

entrepôts de données internes au sein des entreprises. Le stockage

des données du type Big Data ou données massives se fait

généralement dans le Cloud au sein d'un DataCenter.

I.10. BIG DATA ET SES TECHNOLOGIES

Si aujourd'hui leBig Data est possible, c'est grâce aux

évolutions technologiques (logicielle ou hardware) qui permettent de

répondre au 5Vs et aux usages nouveaux que l'on souhaite faire des

données. Nous pouvons les subdiviser en 3, à savoir:

· Les solutions de stockage( cloud computing

(LaaS7(*))) ;

· Les solutions logicielles ;

· Les solutions matérielles et/ou architecturales.

I.10.1. Solutions de stockage

Pour les solutions de stockage dans le domaine du Big Data,

nous pouvons citer entre autre : Les Bases NoSQL, que nous utilisons pour notre

travail, et les Outils MapReduce et Hadoop.

Figure 1.4: les solutions sur le

cloud computing8(*).

I.10.1.1. Bases des Données NoSQL

Le terme NoSQL9(*) (de l'anglais Not only SQL) est apparu en 1989. C'est

à cette année-là que Carlo Stozzi le prononça pour

la première fois en public ; c'était lors de la

présentation de son système de gestion de base des données

relationnelles open source. Il l'a appelé ainsi à cause de

l'absence de l'interface SQL pour communiquer.

Plus tard en 2009, le mot réapparait lorsqu'Eric Evans

l'utilisa pour spécifier le nombre grandissant des bases de

données distribuées open source.

NoSQL est une catégorie de systèmes de gestion

de base de données (SGBD) qui ne repose plus sur l'architecture de base

de données relationnelle classique. L'unité logique n'est plus la

table et les données ne sont généralement pas

manipulées avec le langage de requête SQL.

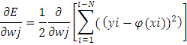

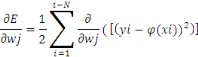

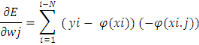

1) Théorème du CAP (d'Eric

Brewer)10(*)

À l'heure actuelle, il est important de savoir que le

mouvement des bases de données NoSQL contient plusieurs approches qui

ont leur propre architecture et traitent des cas d'utilisation bien

définis. Il est donc nécessaire de choisir l'outil qui

répond le mieux au problème posé, à la fois en

termes de modélisation mais également de diffusion des

données.

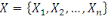

Le théorème énonce donc de la

manière suivante :

Il est impossible pour un système distribué

de fournir les trois propriétés suivantes à la fois :

v Cohérence (Consistency) : Tous les

noeuds du système voient les mêmes données au même

moment quelques soient les modifications ;

v Disponibilité (Availability) : Les

requêtes d'écriture et de lecture sont toujours satisfaites, donc

il y a disponibilité pour la lecture et l'écriture ;

v Tolérance au partitionnement(Partition

tolerance) : La seule raison qui pousse un système à

l'arrêt est la coupure totale du réseau. Autrement dit si une

partie du réseau n'est pas opérationnelle, cela n'empêche

pas le système de répondre. Le système tolère

même une partie du réseau.

Afin de créer une architecture distribuée on

doit donc choisir deux de ces propriétés, laissant ainsi trois

conceptions possibles :

· CP : Les données sont consistantes entre tous

les noeuds et le système possède une tolérance aux pannes,

mais il peut aussi subir des problèmes de latence ou plus

généralement, de disponibilité ;

· AP : Le système répond de façon

performante en plus d'être tolérant aux pannes. Cependant rien ne

garantit la consistance des données entre les noeuds ;

· CA : Les données sont consistantes entre tous

les noeuds (tant que les noeuds sont onlines). Toutes les

lectures/écritures des noeuds concernent les mêmes données.

Mais si un problème de réseau apparait, certains noeuds seront

désynchronisés au niveau des données (et perdront donc la

consistance).

2)

Principes ACID et BASE

Hormis le théorème CAP ci-haut

énoncé, nous pouvons aussi parler de deux principes qui sont

alors liés à la répartition des données et qui sont

à la base des architectures actuelles des systèmes de gestion de

bases de données, notamment les systèmes du type NoSQL.

ACID et BASE représentent deux principes de conception

aux extrémités opposées du spectre

cohérence-disponibilité. Les propriétés ACID se

concentrent sur la cohérence et sont l'approche traditionnelle des bases

de données. Le principe BASE était créé à la

fin des années 90 pour saisir les concepts émergents de la haute

disponibilité et rendre explicite à la fois le choix et le

spectre. Les systèmes étendus modernes et à grande

échelle, y compris le Cloud, utilisent une combinaison des deux

approches.

Bien que les deux acronymes soient plus mnémoniques que

précis, l'acronyme BASE (étant le second apparu) est un peu plus

délicat : BasicallyAvailable, Soft state, Eventuallyconsistent

(Simplement disponible, état souple, finalement consistant). Soft state

et Eventualconsistency sont des techniques qui fonctionnent bien en

présence de partitions réseau et donc améliorent la

disponibilité.

La relation entre CAP et ACID est plus complexe et souvent

incomprise, en partie parce que les C et A d'ACID représentent des

concepts différents des mêmes lettres dans CAP et en partie parce

que choisir la disponibilité affecte seulement certaines des garanties

ACID. Les quatre propriétés ACID sont :

· Atomicité : Tout système

bénéficie d'opérations atomiques.

· Cohérence : Dans ACID, le C signifie qu'une

transaction préserve toutes les règles des bases de

données, telles que les clés uniques

· Isolation : L'isolation est au coeur du

théorème CAP : si un système nécessite l'isolation

ACID, il peut opérer sur au plus une partie durant une partition

réseau.

· Durabilité : La propriété

durabilité assure que lorsqu'une transaction a été

confirmée, elle demeure enregistrée même à la suite

d'une panne d'électricité, d'une panne de l'ordinateur ou d'un

autre problème.

Il est à noter que le principe BASE abandonne donc la

consistance au profit de ces nouvelles propriétés :

· Fondamentalement disponible

(BasicallyAvailable) : Le système garantie bien la

disponibilité dans le même sens que celle du

théorème de CAP ;

· Etat souple (Soft-State) : Indique que

l'état du système peut changer à mesure que le temps

passe, et c'est sans action utilisateur. C'est dû à la

propriété suivante ;

· Eventuellement Cohérent (Eventually)

consistent : Spécifie que le système sera consistant à

mesure que le temps passe, à condition qu'il ne reçoive pas une

action utilisateur entre temps.

ACID est nécessaire si :

· Beaucoup d'utilisateurs ou processus qui travaillent

sur une même donnée au même moment ;

· L'ordre des transactions est très important ;

· L'affichage de données dépassées

n'est pas une option ;

· Il y a un impact significatif lorsqu'une transaction

n'aboutit pas (dans des systèmes financiers en temps réel par

exemple).

BASE est possible si :

· Les utilisateurs ou processus ont surtout tendances

à faire des mises à jour ou travailler sur leurs propres

données ;

· L'ordre des transactions n'est pas un problème

;

· L'utilisateur sera sur le même écran

pendant un moment et regardera de toute façon des données

dépassées ;

· Aucun impact grave lors de l'abandon d'une transaction.

Il est ainsi à remarquer que s'agissant des

systèmes AC, il s'agit des bases des données relationnelles

implémentant les propriétés de Cohérence et de

Disponibilité. Ce qui signifie que les bases des données NoSQL

sont généralement des systèmes CP et AP.

C

A

P

Les systèmes CP sont

du groupe NoSQL

Les systèmes AC renferment

tous les systèmes qui

obéissent au principe ACID

Les systèmes AP sont du groupe NoSQL

Figure 1.5:Guide visuelle au

théorème du CAP.

3)

Critères de Migration vers le principe CAP NoSQL

C'est une évidence de dire qu'il convient de choisir la

bonne technologie en fonction du besoin. Il existe cependant certains

critères déterminants pour basculer au NoSQL notamment :

· Taille : Nous sommes dans un monde où il y a des

données ayant une masse considérable (qu'on appelle

infobésité). Il sied d'avoir alors un système pouvant

supporter un nombre important des opérations, d'utilisateurs, des

données, etc. de manière optimale.

· Performance en écriture : Des données qui

augmentent chaque année.

· Performance en lecture clé-valeur : Certaines

solutions NoSQL ne possèdent pas cet avantage mais comme il s'agit d'un

point clé, la plupart d'entre elles en sont dotées.

· Type de données flexibles : Les solutions NoSQL

supportent de nouveaux types de données et c'est une innovation majeure.

· ACID : Bien que ce ne soit pas le but premier du NoSQL,

il existe des solutions permettant de conserver certains (voire tous) aspects

des propriétés ACID. Se référer au

théorème CAP plus haut et aux propriétés BASE.

· Simplicité de développement :

L'accès aux données est simple.

· ParallelComputing : Les solutions NoSQL

améliorent les calculs parallèles.

I.11. TYPES DE BASE DE DONNEES NoSQL

Les bases de données NoSQL ou Bases sans schéma

fait référence à une diversité d'approches

classées en quatre catégories, qui implémentent des

systèmes de stockage considérés comme plus performants que

le traditionnel SQL pour l'analyse de données massives. Il s'agit de :

I.11.1. Bases de données

orientées-document

11(*)Les

bases de données orientées-document sont une extension des bases

orientées clé-valeur, à la place de stocker une valeur,

nous stockons un document. Un document peut contenir plusieurs valeurs et

d'autres documents, qui peuvent à leur tour en contenir d'autres et

ainsi de suite. Un document peut donc posséder plusieurs niveaux de

profondeur. Tous les documents de niveau 0 sont identifiés par une

clé et sont regroupés dans une collection.

Elles s'adaptent aux données non planes (type profil

utilisateur).

Document

|

Champ1

|

Valeur

|

|

Champ2

|

valeur

|

Document

|

Champ1

|

Valeur

|

|

Champ2

|

valeur

|

|

Champ3

|

Valeur

|

Document

Document

|

Champ1

|

Valeur

|

|

Champ2

|

Valeur

|

|

Champ3

|

Valeur

|

|

Champ4

|

Valeur

|

|

Champ5

|

Champ5.1

|

Valeur

|

|

Champ5.2

|

valeur

|

|

Clé

|

|

CLE2016

|

|

CLE2017

|

|

CLE2018

|

|

CLE2019

|

|

CLE...

|

Figure 1.6:Illustration d'une

base de données orientées document. [MS Office Word

2016].

Quelques SGBD orientées-document :

ï MongoDB : Développé en

C++. Les API officielles pour beaucoup de langages.

Protocole personnalisé BSON. Réplication

master/slave. Licence AGPL

(Commercial et libre) ;

ï CouchDB : Développé en

Erlang. Protocol http. Réplication master/master. Licence Apache.

I.11.2. Bases de données

orientées-colonne

Elles s'adaptent mieux au stockage des listes (messages,

postes, commentaires, ...).

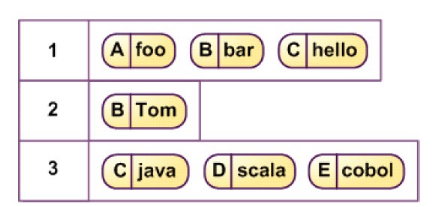

Figure 1.7:Illustration d'une

donnée orientées-colonne.

Quelques SGBD orientées-colonnes :

· HBase : Utilise un API Java. Adopte un

design CA. Présence de quelques SPOF.

· Cassandra : Beaucoup d'API

disponibles. Adopte un design AP avec consistance éventuelle. Aucun SPOF

car réplication master/master. Moins performant que HBase sur les

insertions de données.

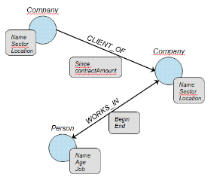

I.11.3. Bases de données

orientées-graphe

12(*)Elles gèrent les relations multiples entre

objets (comme des relations dans un réseau social). Les bases de

données orientées-graphe sont celles qui stockent les

enregistrements dans les noeuds et les relations entre les enregistrements par

les arêtes. Elles sont modélisées à l'aide de la

théorie des graphes.

C'est ainsi, une base de données

orientées-graphe stocke les informations d'une manière

très optimisée sous forme de graphe. Les liens entre

différentes informations sont aussi faits de manière

optimisée.

Ce type de base de données est très performant

surtout dans des domaines où les données sont très

nombreuses.

Figure 1.8: Illustration d'une

base de données orientées-graphe. [KAMINGU Gradi L,

Mémoire 2014].

Quelques SGBD orientées-graphe :

· Neo4J : Développé en

Java. Supporte beaucoup de langages. Réplication master/slave.

Propriétés ACID possibles. Langage de requêtes

personnalisé «Cypher».

· Titan : Haute disponibilité

avec réplication master/master. Prise en compte d'ACID avec consistance

éventuelle. Intégration native avec le frameworkTinkerPop.

I.11.4. Bases de données

orientées-clé-valeur

Les bases de données orientées-clé-valeur

permettent de stocker une valeur, cette valeur peut être de tout type

(entier, chaine de caractères, flux binaire, etc.). En revanche les

requêtes ne portent que sur la clé associée à cette

valeur. Ce système de base de données est conçu pour

être très fortement répliqué de manière

à augmenter la disponibilité et les performances. La

réplication de données est plus ou moins partielle pour trouver

un bon compromis entre nombre de serveurs, disponibilité et espace

disque.

Elles permettent d'accéder rapidement aux informations

pour la gestion des caches.

Clé

251657216

Clé2018

Valeur 2019

Valeur2018

Valeur 2017

Clé2019

Clé2017

251655168

Clé...

Figure 1.9:Illustration d'une

base de données orientées-clé-valeur [Outil de

modélisation Win'Design].

Quelques SGBD orientées-clé-valeur :

· DynamoDB : Solution d'Amazon à

l'origine de ce type de base. Design de type AP selon le théorème

de CAP mais peut aussi fournir une consistance éventuelle.

· Voldemort : Implémentation

open-source de Dynamo. Il y a possibilité d'en faire une base

embarquée.

Voici quelques sociétés qui utilisent les bases

des données NoSQL et leur type de technologie :

Tableau 1.1: Les

sociétés utilisant la technologie de NoSQL.[ Enjeux et usages du

Big Data technologies, méthodes et mise en oeuvre]

|

Société

|

Technologie

Développée

|

Type de Technologie

|

|

|

Système de base de données propriétaire

reposant sur GFS (Google File System).

Technologie non open source, mais qui a inspiré HBase qui

est open source.

|

|

Plate-forme de développement pour traitements

distribués.

|

|

|

Plate-forme Java destinée aux applications

distribuées et à la gestion intensive des données. Issue

à l'origine de Google Big Table, MapReduce et Google File System.

|

|

|

Plate-forme de développement dédiée aux

applications de traitement continu des flux de données.

|

|

|

Base de donnée de type NoSQL et distribuée.

|

|

Logiciel d'analyse de données utilisant Hadoop.

|

|

|

Plate-forme de traitement de données massives.

|

|

Base de données distribuées de type graphe.

|

|

|

Système distribué de gestion de messages

|

|

Base de données temps réel distribuée et

semi structurée.

|

|

Base de données distribuée destinée aux

très grosses volumétries.

|

4)

Outils MapReduce et Hadoop

a) MapReduce

MapReduce est un modèle de développement

informatique, popularisé (et non inventé) par Google, dans lequel

sont effectués des calculs parallèles, et souvent

distribués, de très grandes volumes de données

(généralement supérieures à un

téraoctet).

Il s'agit donc d'une technique de programmation

distribuée largement utilisée dans l'environnement NoSQL et qui

vise à produire des requêtes distribuées. C'est

également un modèle de programmation permettant de gérer

de grandes quantités de données qui ne sont pas

nécessairement structurées.

b) Hadoop

Créé par Doug Cutting en 2009 et employé

par Yahoo, Hadoop est la plateforme de développement d'applications

utilisant le modèle MapReduce.

Hadoop est un framework13(*) Java

libre pour les applications

distribuées et la gestion intensive de données. Il permet aux

applications de travailler avec des milliers de noeuds et de pétaoctets

de données. Hadoop a été inspiré par la publication

de Google MapReduce, GoogleFS et BigTable

Il s'agit également d'un framework open source

conçu pour traiter des volumes massifs de données. En d'autres

termes, une technologie open source permettant d'effectuer des requêtes

dans des puits de données distribués, dont les informations sont

localisées sur des serveurs distants.

Le framework Hadoop de base se compose des modules suivants :

· Hadoop Common ;

· Hadoop Distributed File System (HDFS) : le

système de fichiers ;

· Hadoop YARN ;

· Hadoop

MapReduce ;

Le terme Hadoop fait référence non seulement aux

modules de base ci-dessus, mais également à son

écosystème et à tous les logiciels qui y sont

attachés, tels

Apache Pig,

Apache Hive,

Apache HBase, Apache Phoenix,

Apache Spark,

Apache ZooKeeper,

Cloudera Impala,

Apache Flume, Apache Sqoop,

Apache oozie, Apache Storm.

I.12. SOLUTIONS LOGICIELLES

I.12.1. Moteurs Sémantiques (Text Mining)

Généralement associés à un moteur

de recherche, ils permettent une analyse sémantique des documents afin

de comprendre le contenu et permettent ainsi de retrouver, dans une base de

données de documents, le ou les documents traitant d'un sujet, parlant

d'une personne. Parmi les solutions les plus connues : Fise, Zemanta, iKnow

(InterSystems), Noopsis, Luxid (Temis), LingWay.

I.12.2. Solutions d'Analytiques

Ce sont des solutions qui permettent de gérer la

variété des données exploitées par une

visualisation nouvelle de celles-ci avec une première analyse qui les

contextualise, compartimente, corrèle. Pour cela, ces nouvelles

solutions cherchent à aller au-delà d'une analyse statistique des

données pour aller vers une analyse prédictive et la prise en

compte de la temporalité des données.

Parmi les solutions les plus connues : QlickView, PowerPivot,

Tableau. Ainsi que, pour la manipulation des données : Aster, Datameer,

SPSS, SAS ou Kxen pour le DataMining.

Il y a aussi moyen d'écrire ces propres programmes

(scripts) pour exploiter les données d'un Big Data, nous pouvons citer

ces langages par excellence comme : Python, Langage R, Java.... Mais on peut

tout de même adaptée un autre langage dans certain cas.

I.12.3. Solutions matérielles et/ou architecturales

Une des innovations permettant de stocker et de partager de

grandes quantités de données. Le Cloud est un modèle qui

permet d'accéder à des ressources informatiques partagées

telles que des réseaux, des serveurs, de grandes capacités de

stockage, des applications et des services15(*). Le Cloud permet également un accès

réseau, des services à la demande et en libre-service sur des

ressources informatiques partagées et configurables.

Les services les plus connus sont ceux de Google BigQuery, Big

Data sur

Amazon Web

Services

et Microsoft

Windows Azure

.

Le Cloud Computing signifie donc que les applications en ligne

sont utilisées comme si elles étaient situées dans

l'éther, dans un espace sans réalité physique.

Figure 1.10: Illustration du

Cloud Computing.[Du Big Data au Business]

Sont des machines de haute performance utilisées pour

le traitement des données massives, telles que

IDRIS

,

CINES

,

CEA

ou

HPC-LR qu'on trouve en France dans les Centres Nationaux de Calculs

Universitaire (CNCU).

I.12.3.3. Stockage des Données en Mémoire :

Cette technique permet d'accélérer les temps de

traitement des requêtes.

I.12.3.4. Serveurs des Traitements Distribués :

Cette technique de traitement distribué permet

d'effectuer plusieurs traitements simultanés sur plusieurs noeuds. C'est

ce qu'on appelle un traitement massivement parallèle. Le framework

Hadoop est probablement le plus connu d'entre eux. Il combine le système

de fichiers distribué HDFS, la base de données NoSQL et

l'algorithme MapReduce.

I.13. CHOIX DU BIG DATA [1]

La mise oeuvre (ou soit la migration vers) un système

d'informations du type Big Data se fait pour des raisons :

· Stratégiques : qui permettent d'obtenir des

informations plus riches et approfondies sur les clients et les partenaires

voire même le marché et au bout du compte de

bénéficier d'un avantage concurrentiel. En bref, c'est de

créer un avantage concurrentiel ;

· Organisationnelles : qui permettent de travailler avec

des ensembles de données dont la taille et la diversité

dépassent les capacités classiques. Elles permettent

également le traitement en temps réel d'un flux continu de

données afin de prendre plus rapidement des décisions urgentes.

Les processus d'analyse se dirigent, là où sont les

données pour plus de rapidité et d'efficacité. Elles

permettre ainsi aux personnels dirigeants de prendre de meilleures

décisions, plus rapidement et en temps réel. En bref, c'est

piloter en temps réel pour prendre plus rapidement des décisions

urgentes qui implique les collaborateurs.

I.13.1. Big Data et recrutement

Le Big Data permet de traiter un grand nombre d'applications

et de profils beaucoup plus rapidement, voire simultanément, par rapport

à un recruteur. En fait, pour les questionnaires, le programme commence

l'analyse lorsque la personne a fini de répondre aux questions. De plus,

l'algorithme peut fonctionner en continu et à tout moment.

Néanmoins, si les algorithmes sont efficaces pour

établir un profil et estimer une correspondance entre un individu et un

poste, les recruteurs auront toujours une place prépondérante

à occuper dans les années à venir. En effet, certains

aspects resteront irremplaçables pour les machines, aussi complexes

soient-elles. En effet, l'intelligence artificielle soulève le doute

quant au remplacement de la fonction par de simples algorithmes, et rejoindrait

ainsi les emplois victimes du processus d'automatisation des tâches.

I.13.2. Métiers du Big Data

Les métiers du Big Data sont :

Ø Data Scientist: Il est chargé

de modéliser des problématiques commerciales complexes, d'ouvrir

des perspectives commerciales, et d'identifier les opportunités. Il a :

· Connaissance des logiciels & langages Big Data ;

· Connaissance en modélisations ;

· Connaissances métiers.

Ø Architecte Big Data:

· Connaissance infrastructures et logiciels Big Data ;

· Connaissances en modélisations.

Ø Data Analyst :

· Connaissance des logiciels & langages Big Data ;

· Connaissance en modélisations.

Ø Chief-Data-Officer (Directeur des

données) :

· Responsable des données et de leur gouvernance

(collecte, traitement, sauvegarde, accès) ;

· Responsable de l'analyse des données et aide

à la décision.

CONCLUSION PARTIELLE

La rapidité technologique a mis les données

à la disposition des entreprises à partir de sources multiples,

souvent structurées ou non. Pour faire face à ce type de

données, une technologie Big Data permet l'exploration de grands volumes

de données provenant des sources les plus variées.

Cette technologie Big Data utilise plusieurs autres techniques

pour le traitement de ces données non structurées ou

structurées, leur gestion et leur stockage avec des outils de traitement

et un SGBD (Système de gestion de base de données) très

spécifiques à ces types de données. Dans ce chapitre il a

été question de parler de ladite technologie dans ses multiples

aspects.

CHAPITRE II :

SYSTÈME DE GESTION DE BASE DE DONNEES ORIENTE DOCUMENT ET

MONGODB[7], [9]

II.1. SGBD ORIENTE

DOCUMENT

II.1.1. Introduction

Les systèmes de gestion de bases de données

constituent une grande problématique de nos jours. Ce sont des

systèmes qui enregistrent et classent les données pour permettre

une recherche et un stockage rapides et faciles des informations. Dans un

programme, les bases de données sont utilisées pour de stocker

à long terme ce que les variables enregistrent à court terme.

Pendant des années, ces systèmes de gestion

relationnelle ont constitué la base du stockage de documents. Cela a

entraîné d'importants problèmes de gestion, notamment le

volume, la vitesse et la variabilité des composants de la base de

données. En effet, on ne pouvait pas stocker beaucoup d'enregistrements

et les traitements étaient très lourds, car les informations

disposées sur plusieurs tables nécessitaient l'utilisation de

plusieurs jointures pour être extraites.

II.1.2.Définition

Une base de données orientée

documents est un type de base de données NoSQL conçu pour

stocker et interroger des données sous forme de documents. Elle est donc

destinée aux applications qui gèrent des documents.

Cette catégorie de produits fait le compromis

d'abandonner certaines fonctionnalités classiques des

SGBD relationnels au profit de la

simplicité, la performance et une montée en charge (

scalabilité)

élevée. Ce type de base de données peut être une

superposition d'une base de données relationnelle ou non.

L'avantage des bases de données orientées

documents réside dans l'unité de l'information et l'adaptation

à la distribution. En effet, d'une part, tout étant inclus dans

la structure, cela évite de faire des jointures pour reconstruire

l'information car elle n'est plus dispersée dans plusieurs tables.

Aucune transaction n'est nécessaire car l'écriture est suffisante

pour créer des données sur un document afin de modifier un objet.

Une seule lecture suffit pour reconstruire un document. Par contre, les

documents étant autonomes, ils peuvent être déplacés

facilement, ils sont indépendants les uns des autres.

II.1.3. Types de modèle

de SGBD NoSQL[7]

Bien que plusieurs caractéristiques

générales aient été soulignées

précédemment, il convient de noter qu'il existe plusieurs

familles de systèmes de base de données NoSQL, étant

donné qu'elles sont apparues progressivement, à des fins

différentes et conçus par différents auteurs. Chacune de

ces familles peut parfois s'écarter des définitions

générales.

II.1.4. Comparaison des outils

de gestion des BD NoSQL

Dans cette partie, nous allons lister les

caractéristiques des principales bases de données NoSQL. CouchDB

présente de nombreuses similitudes avec MongoDB, à la

différence que CouchDB est moins adapté à des

données très variables [Oussous et al., 2015].

CouchDB assurera la disponibilité et la

tolérance à la partition là où MongoDB assurera la

disponibilité et la cohérence. Le choix de l'importance de ces

caractéristiques est à effectuer selon les besoins

del'application. De prime à bord, dans les conditions de création

du prototype dans ce travail, ni la disponibilité ni la cohérence

semble avoir plus d'importances l'une que l'autre. Par contre MongoDB

semble

supporter des requêtes plus complexes et a l'avantage de supporter

nativement le partitionnement [Lourenço et al., 2015].

Tableau 2.2: Comparaison de

système de Base des données NoSQL.

|

CouchDB

|

MongoDB

|

Neo4j

|

Big Table

|

|

Basic Concepts

|

Document-Oriented

|

Document-Oriented

|

Network-Oriented

|

Column-Oriented

|

|

Indexing

|

R-Tree Only2D

|

2D 2Dsphere

|

R-Tree 2Dand partially 3D

|

B-Tree Only2D

|

|

Vector Data Types

|

Fully

|

Fully

|

Fully Basic Types and Limited MultiGeometry Types

|

Fully Basic Types

|

|

Topologycal functions

|

Only Within() Contains()

|

Only Wiyhin() Contains(Point)

|

Almost fully

|

Not supported

|

|

Analysis and metric functions

|

Only Distance()

|

Only Distance(Point)

|

FullyMultiGeometry

|

Only Distance()

|

|

Set functions

|

Not support

|

Only Intersection(Point)

|

Fully

|

Not supported

|

MongoDB semble donc être plus approprié pour la

gestion de nos données. L'utilisation de CouchDB n'est pas pour autant

inintéressante, au contraire, elle offre bon nombre d'avantages

simplement par ses objectifs différents (disponibilité au lieu de

cohérence).

II. 2. MongoDB

II.2.1.Présentation

MongoDB est l'un des systèmes de gestion de

données NoSQL les plus populaires. Développé par la

société new-yorkaise MongoDB Inc., il est disponible depuis 2009.

À l'heure actuelle, la dernière version disponible est la

4.6.8.

MongoDB vient du mot anglais humongous qui signifie «

énorme ». Il est un SGBD faisant partie de la mouvance NoSQL qui

n'est plus fondée sur l'architecture classique des bases relationnelles

où l'unité logique n'y est plus la table, et les données

ne sont en général pas manipulées avec le SQL.

MongoDB est un système de gestion de documents

orienté document, répartissables sur un nombre quelconque

d'ordinateurs de scalabilité (extensibilité ou

évolubilité) ou scalability en anglais, avec des performances

raisonnables et ne nécessitant aucun schéma de données

prédéfini. Il est écrit en C ++ et distribué sous

licence AGPL. Son objectif est de fournir des fonctionnalités

avancées.

Avant de fonder 10gen (renommée depuis en MongoDB

Inc.), Kevin Ryan et Dwight Herriman avaient déjà

créé Double Click, une entreprise bien connue de publicité

en ligne. Frustrés par l'impossibilité de monter en charge comme

ils le souhaitaient, ils décidèrent de développer une

plate-forme applicative distribuée conçue pour le cloud,

composée d'un moteur applicatif et d'une base de données, qu'ils

développèrent d'abord en JavaScript. Cette idée de

plate-forme applicative (un App Engine tel que celui de Google)

n'intéressait pas grand monde, mais la base de données

éveillait la curiosité, si bien qu'après un an, ils

décidèrent de libérer son code. Ce fut à ce moment

qu'un net intérêt commença à se manifester. Cet

engouement se traduisit par une activité importante de

développement par la communauté et un investissement grandissant

de la part de 10gen, notamment par le recrutement d'ingénieurs

spécialisés en SGBD.MongoDB est identifié par le logo

ci-dessous :

Figure 2.11:Présentation

logo du SGBD MongoDB.

II.2.2. Schéma

La conception du schéma doit prendre en compte les

particularités de l'application elle-même. Il faut regarder le

nombre de lectures et l'importance de chacune. Les requêtes et la

fréquence des mises à jour doivent également être

étudiées bien avant la conception du modèle.

II.2.2.1. Document

Le modèle de données MongoDB est

entièrement basé sur des documents. Le document est

représenté par un fichier BSON. Les caractéristiques de

ces fichiers permettent d'introduire des documents intégrés, ce

qui permet d'éviter les jointures et les transactions lourdes. Les

documents peuvent donc être comparés à plusieurs lignes

d'une table d'une base de données relationnelle.

MongoDB garantit la conformité ACID (atomicité,

cohérence, isolation et durabilité) au niveau du document. En

effet, toutes les données incluses dans un document peuvent être

collectées en une seule opération. Ainsi, toutes les

données peuvent être stockées dans un seul document pour

appliquer les caractéristiques ACID à l'ensemble de la base de

données [Abraham, 2016].

II.2.2.2. Collection

Une collection est l'ensemble des documents de la

même famille. Il n'y a pas de structure imposée pour les documents

d'une même collection, ils peuvent tous varier entre eux.

Il existe des collections typiques appelées «

collections limitées », créées à l'avance avec

une limite de taille. Quand l'ajout de documents provoque le dépassement

de la taille limite, ce sont les plus vieux documents qui vont être

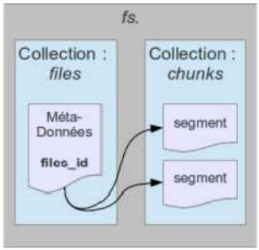

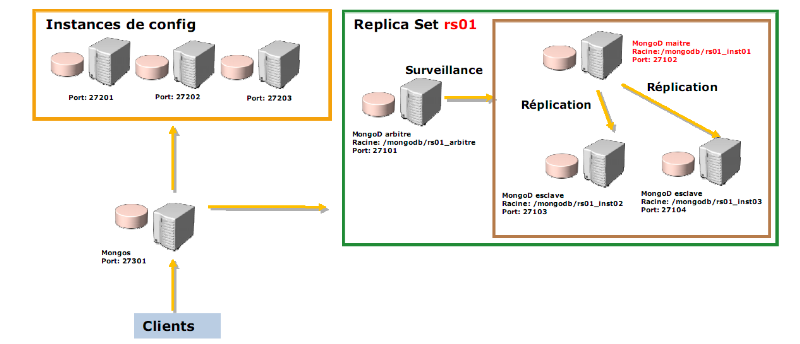

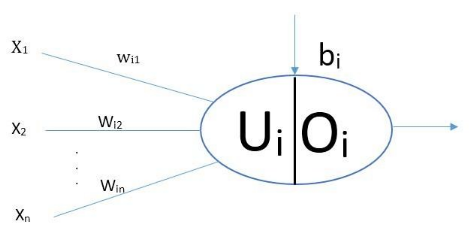

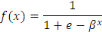

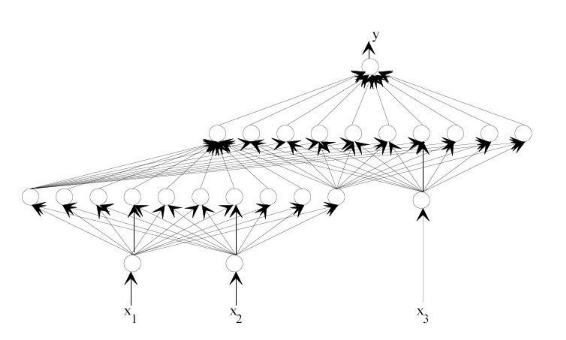

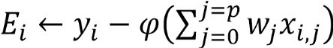

supprimés [Chodorow, 2013].