2009-2010

Département Informatique

MEMOIRE DE MAGISTER

Option : Informatique et Automatique

THEME :

FOUILLE DE DONNEES BIOLOGIQUES : ETUDE COMPARATIVE

ET

EXPERIMENTATION.

Présenté par : Abdelhak

MANSOUL

Soutenu devant les membres du jury :

Mr B. BELDJILALI Professeur à l'Université

d'Oran

Président

Mr K. BOUAMRANE Maître de Conférences à

l'Université d'Oran

Examinateur

Mr A. GHOMARI Maître de conférences à

l'Université d'Oran

Examinateur

Mr M. MALKI Maître de conférences à l'UDL

de Sidi Belabess

Examinateur

Mr B. ATMANI Maître de conférences à

l'Université d'Oran

Rapporteur

Résumé

Le traitement des données biologiques est

indispensable en recherches médicales et sciences de la vie. En effet,

les données biologiques sont de différents types, et souvent

complexes, ce qui a induit une recherche soutenue de nouveaux

procédés d'exploitation parce que ceux existant ne suffisent plus

ou ne sont plus adaptés. Une nouvelle approche : l'Extraction de

Connaissances à partir des Données biologiques est de plus en

plus envisagée. De là, notre étude qui porte sur la

fouille de données biologiques sur un terrain expérimental : une

épidémie.

Le présent travail de recherche se situe dans

le cadre de l'ECD Biologiques, à travers une étude comparatives

des outils existants et la proposition d'une nouvelle approche pour

l'extraction des règles d'association à partir de données

biologiques, leur gestion et l'alimentation d'un système d'aide à

la décision.

D'où, la problématique

abordée par notre étude qui est la fouille de données

biologiques assistée par une modélisation booléenne des

résultats obtenus.

Nous proposons un processus d'extraction de motifs

assez novateur pour générer des règles d'association

profitable et exploitable à deux niveaux :

· Profitable au spécialiste du domaine,

en particulier à travers les règles d'association qui aident

à mieux interpréter les données.

· Le résultat de la fouille de

données est optimisé par une modélisation booléenne

des règles d'association extraites. Cette amélioration se fait

par la machine BRI (Boolean Rules Induction ). En premier lieu nous

présenterons un état de l'art, s'ensuit une étude

comparative des différents outils et méthodes existants afin d'en

tirer bénéfice, et on continuera par exposer notre

démarche et les résultats obtenus.

Mots clés: Automate cellulaire, Fouille de

données biologiques, Induction de règles, Règle

d'association, modélisation booléenne.

Abstract

The biological data processing is an

indispensable tool in medical researches and life sciences. Indeed, the

biological data are various types, and often complex, what led a search of new

exploitation processes because those existing are not any more enough or are

not any more adapted. A new approach : the Extraction of Knowledge from the

biological data is more and more envisaged. From there, our study which

concerns the Biological Data Mining on an experimental ground: an

epidemic.

The present research work is situated within the

framework of Knowledge Discovery from Biological Data, through study

comparative clauses of the existing tools and the proposition of a new approach

for the extraction of the association rules from biological data, there

management and the supply of a system of decision-making

support.

Where from, the problem approached by our study

which is the Data Mining of biological data assisted by a boolean modeling for

the obtained results.

We propose a rather innovative process of extraction

of patterns for generating a profitable and

exploitable association rules at two

levels:

· Profitable, to the specialist of the domain,

in particular through the rules of association which help to interpret better

the data.

· The result of the data mining process is

optimized by a boolean modelling of the extracted association rules. This

improvement is made by the machine BRI (Boolean Rules Rules

Induction).

First of all we shall present a state of the art,

follows a comparative study of the various existing tools and the methods to

benefit from it, and we shall continue to expose our approach and the obtained

results.

Key words: Cellular automaton, Biological data

mining, Rules Induction, Association Rules, Boolean

modelisation

Remerciements

Je remercie les membres du jury qui m'ont fait

l'honneur d'avoir accepté d'évaluer ce travail.

Je remercie vivement Monsieur Bouziane BELDJILALI,

qui m'a bien accueilli et m'a entretenu pour me diriger ensuite vers mon

encadreur. Ainsi que, Monsieur Baghdad ATMANI mon encadreur, pour m'avoir

dirigé pendant tout le long de ce travail, par ses précieux

conseils, ses pertinents commentaires, et ses orientations. De plus m'a fait

profiter de son expérience dans la direction de travaux de

recherche.

Mes remerciements vont aussi :

À Monsieur Abdelhafid HAFFAF, le chef du

département informatique de l'université d'Oran.

À Monsieur Karim BOUAMRANE pour m'avoir

facilité les démarches administratives au département

informatique.

Et Monsieur Smain MAAZOUZI, le chef du

département informatique de l'université du 20 Août 55 de

SKIKDA pour son grand soutien.

TABLE DES MATIERES

Résumé

Liste des figures

Liste des tableaux

Glossaire

Introduction générale 1

Chapitre I. L'Extraction de Connaissances à partir

de Données Biologiques 6

I.1 Définition de l'extraction de connaissances à

partir de données

biologiques 6

I.2 Le processus de l'ECD biologiques 7

I.3 Notre contribution 13

I.4 Etat de l'art de l'ECD biologiques 14

I.5 Les méthodes de fouille de données 20

I.6 Etude comparative 27

I.7 Discussion sur l'ECD Biologiques 30

I.8 Conclusion 31

Chapitre II. Extraction de règles d'association

33

II.1 Les règles d'association 34

II.2 L'induction et l'évaluation des règles 35

II.3 Les algorithmes d'extraction des règles d'association

37

II.4 Conclusion 42

Chapitre III. Modélisation booléenne des

règles d'association 44

III.1 Le moteur d'inférence cellulaire : architecture et

principe de 44

fonctionnement

III.2 La modélisation booléenne 47

III.3 Exemple d'illustration d'induction des règles

booléennes 48

III.4 La dynamique du moteur d'inférence cellulaire 50

III.5 Conclusion 52

Chapitre IV. Conception et expérimentation du

système BIODM 54

IV.1 Etude et choix des données biologiques pour

expérimentation 54

IV.2 Architecture du système BIODM (BIOlogical Data

Mining) 55

IV.3 Le processus de l'ECD biologiques 57

IV.4 Le logiciel réalisé 63

IV.5 L'expérimentation 66

IV.6 Conclusion 70

Conclusion générale 71

Références bibliographiques 73

Annexe B 77

Liste des figures

Introduction générale.

Figure 0.1 : Complexe Tuberculosis. 2

Figure 0.2 : Morceau de séquence génomique

rapatriée de NCBI. 4

Figure 0.3 : Fichier des séquences ayant subi une

transformation. 4

Chapitre I. L'ECD Biologique.

Figure 1.1 : Exemple du format FASTA d'une séquence

protéique. 9

Figure 1.2 : Exemple du format STADEN d'une séquence

protéique. 9

Figure 1.3 : Exemple du format PIR d'une séquence

protéique. 10

Figure 1.4 : Exemple de fichier à l'état brut de la

séquence génomique de la

souche MT CDC1551 au format texte brut. 10

Figure 1.5 : Morceau de la séquence génomique

nettoyée du Mt CDC1551. 11

Figure 1.6 : Morceau de la séquence génomique mise

en forme du

Mt CDC1551. 11

Figure 1.7 : Morceau de la séquence génomique

structurée du Mt CDC1551. 11

Figure 1.8 : Processus d'ECD Biologiques. 12

Chapitre III. Modélisation booléenne des

règles d'association.

Figure 3.1 : Le système BRI (Boolean Rule Induction).

44

Figure 3.2 : Les partitions S, S1 et S2. 45

Figure 3.3 : Illustration du principe d'induction des

règles booléennes

inductives par BRI. 48

Chapitre IV. Conception et expérimentation du

système BIODM.

Figure 4.1 : Architecture du système BIODM. 55

Figure 4.2 : Morceaux de la séquence génomique du

Mt CDC1551. 58

Figure 4.3 : Morceaux de séquence protéique du Mt

CDC1551. 58

Figure 4.4 : Architecture fonctionnelle du système BIODM.

64

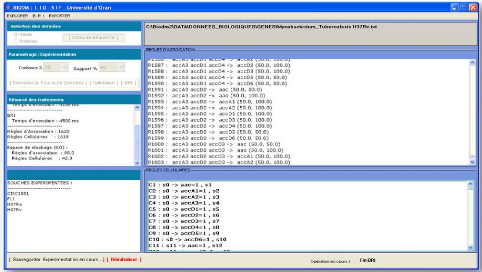

Figure 4.5 : Interface du système BIODM. 66

Figure 4.6 : Echantillon de gènes servant à la

fouille de données. 67

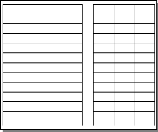

Liste des tableaux

Introduction générale.

Tableau 0.1: Tableau des différentes souches du

Mycobacterium Tuberculosis 77

Tableau 0.2: Tableaux informatif sur les

caractéristiques des souches du

Mycobacterium Tuberculosis complètement annotées.

78

Tableau 1.3 : Les souches du Mycobacterium Tuberculosis en cours

d'annotation. 78

Chapitre I. L'ECD Biologique.

Tableau 1.1: Description du fichier FASTA de l'exemple de la

figure 1.1. 9

Tableau 1.2: Description du fichier PIR de l'exemple de la figure

1.3. 10

Tableau 1.3: Les souches du Mycobacterium Tuberculosis en cours

d'annotation. 77

Tableau 1.4: Les méthodes de FDD utilisées en ECD

biologiques. 28

Tableau 1.5: Les tâches et méthodes utilisées

en ECD. 29

Tableau 1.6: Tableau comparatif des tâches de l'ECD. 29

Chapitre III. Modélisation booléenne des

règles d'association

Tableau 3.1 : Représentation cellulaire de la Base des

connaissances de la

figure 3.2. 46

Tableau 3.2 : Les matrices d'incidences

d'entrée RE et de sortie Rs pour la

figure 3.2. 46

Chapitre IV. Conception et expérimentation du

système BIODM.

Tableau 4.1 : Base de test servant à

l'expérimentation. 66

Tableau 4.2 : Exemple de règles

générées par Apriori pour un support de 60% 68

et une confiance de 80%.

Tableau 4.3 : Exemple de règles cellulaires

générées par BRI. 68

Tableau 4.4 : Nombre de

règles et temps d'exécution d'Apriori sur l'échantillon

de la figure 4.6. 69

Tableau 4.5 : Evolution de l'espace de stockage. 69

Annexe A

Glossaire

A

Acide désoxyribonucléique

(ADN)

Support biochimique de l'information génétique

chez tous les êtres vivants (à l'exception de quelques virus qui

utilisent l'ARN). Principal composant des chromosomes, l'ADN se présente

le plus souvent sous forme de deux longs filaments (ou chaînes)

torsadés l'un dans l'autre pour former une structure en double

hélice. Chacune de ces chaînes est un polymère formé

de l'assemblage de quatre nucléotides différents,

désignés par l'initiale de la base azotée qui entre dans

leur composition : A (Adénine), C (Cytosine), G (Guanine) et T

(Thymine).

Acide ribonucléique (ARN)

Dans les cellules, on distingue plusieurs types d'ARN suivant

leur fonction. Les trois types principaux sont : les ARN messagers, les ARN de

transfert et les ARN ribosomaux. L'ARN est un acide nucléique

constitué d'une seule chaîne de nucléotides, de structure

analogue à celle de l'ADN. Il existe cependant des différences

chimiques entre ces deux acides nucléiques qui donnent à l'ARN

certaines propriétés particulières. L'ARN est produit par

transcription de l'ADN.

ACP

L'analyse en composantes principales (ACP) est une

méthode mathématique d'analyse des données qui consiste

à rechercher les directions de l'espace qui représentent le mieux

les corrélations entre n variables aléatoires

Acyclique (graphe)

Un graphe acyclique est un graphe ne contenant aucun cycle.

Agrégation (données)

Le mot agrégation désigne l'action

d'agréger, de regrouper des éléments.

Alignement Global / Local

L'alignement de séquences (ou alignement

séquentiel) est une manière de disposer les composantes

nucléotides ou acides aminés) des ADN, des ARN, ou des

séquences primaires de protéines pour identifier les zones de

concordance qui traduisent des similarités ou dissemblances de nature

historique. Il existe l'alignement global, c'est-à-dire entre les deux

séquences sur toute leur longueur (FASTA) et local, entre une

séquence et une partie de l'autre séquence (BLAST).

Annotation

L'annotation d'un génome consiste à traiter

l'information brute contenue dans la séquence dans le but :

1. de prédire, le contenu en gènes, la position

des gènes à l'intérieur d'un génome ainsi que leur

organisation, des séquences promotrices, etc. Dans ce cas, on parle

d'annotation structurale.

2. de prédire la fonction potentielle de ces

gènes. Dans ce cas on parle d'annotation fonctionnelle.

Antigènes

Un antigène est une macromolécule naturelle ou

synthétique, reconnue par des anticorps ou des cellules du

système immunitaire et capable d'engendrer une réponse

immunitaire.

Arbre de décision

Modèle issu des techniques d'intelligence artificielle.

Son principe est de chercher à diviser une population en 2 (arbres

binaires) ou plus (arbres n-aires) de sorte que ces sous-populations soient

aussi différentes entre elles que possibles, et homogènes du

point de vue de la répartition de la variable cible.

Apprentissage (échantillon

d')

Partie des données servant à l'évaluation

des différents paramètres d'un modèle (en anglais,

"training").

Athérosclérose

Le vieillissement normal des artères et artérioles

se nomme artériosclérose.

Auto-immunes (maladies)

Les maladies auto-immunes sont dues à une

hyperactivité du système immunitaire à l'encontre de

substances ou de tissus qui sont normalement présents dans

l'organisme.

Automate cellulaire

Un automate cellulaire consiste en une grille

régulière de « cellules » contenant chacune un «

état » choisi parmi un ensemble fini et qui peut évoluer au

cours du temps. L'état d'une cellule au temps t+1 est fonction de

l'état au temps t d'un nombre fini de cellules appelé son «

voisinage ». À chaque nouvelle unité de temps, les

mêmes règles sont appliquées simultanément à

toutes les cellules de la grille, produisant une nouvelle «

génération » de cellules dépendant entièrement

de la génération précédente.

Annexe A

B

Bio-informatique

La Bio-informatique est constituée par l'ensemble des

concepts et des techniques nécessaires à l'interprétation

de l'information génétique (séquences) et structurale.

C'est le décryptage de la « bio-information ». La

bio-informatique est donc une branche théorique de la biologie.

Biologie moléculaire

La biologie moléculaire est une discipline scientifique au

croisement de la génétique, de la biochimie et de la physique,

dont l'objet est la compréhension des mécanismes de

fonctionnement de la cellule au niveau moléculaire.

BLAST

BLAST (acronyme de basic local alignment search tool) est une

méthode de recherche heuristique utilisée en bio-informatique

permettant de trouver les régions similaires entre deux ou plusieurs

séquences de nucléotides ou d'acides aminés.

C

Candidat (gène)

L'approche gène candidat consiste à supposer

l'implication d'un gène dans un quelconque effet à priori, et

l'étude vise à confirmer cette implication a posteriori.

Cas-témoins (étude)

Etude rétrospective entre deux groupes, l'un

présentant une maladie (cas) et l'autre, indemne (témoins).

Chromosome

Unité physique de matériel

génétique correspondant à une molécule continue

d'ADN. Les cellules bactériennes n'en comportent qu'un. Ils sont

doués du pouvoir d'autoreproduction.

Classification ascendante hiérarchique

(CAH)

Méthode de création de typologies qui

agrège, à chaque étape, les individus ou les groupes

d'individus les plus proches. Les emboîtements successifs se poursuivent

ainsi jusqu'à agréger toute la population. On choisit ensuite la

partition (ensemble de classes ainsi constituées) qui propose le

meilleur rapport homogénéité interne des groupes /

hétérogénéité des groupes entre eux.

Classification automatique

On appelle classification automatique la catégorisation

algorithmique d'objets. Celle-ci consiste à attribuer une classe ou

catégorie à chaque objet (ou individu) à classer, en se

basant sur des données statistiques.

Coeliaque (maladie)

La maladie coeliaque est une maladie auto-immune,

caractérisée par une atteinte de tout ou partie des

villosités recouvrant l'intestin grêle.

Co-régulé

(gène)

Gènes liés l'un à l'autre.

Code génétique

Système de correspondance permettant de traduire une

séquence d'acide nucléique en protéine.

Cohorte

Ensemble d'individus étudiés sur une

période de temps donnée. Une cohorte permet de suivre de

manière longitudinale les comportements de la population observée

ainsi que sa réaction à un ou plusieurs événements

donnés.

Continue (variable)

Se dit d'une variable qui peut prendre une "infinité"

de valeurs (par opposition à discrète) par exemple, un

réel. Un âge, une somme d'argent, un coefficient de bonus/malus

sont souvent considérés comme continus. Synonyme :

quantitatif.

Corrélation

Mesure de la liaison entre deux variables. On parle de

corrélation entre une cause et son effet, ou entre deux variables qui

apportent la même information.

CROHN (maladie)

La maladie de Crohn est une maladie inflammatoire chronique

intestinale (MICI) de l'ensemble du tube digestif.

Annexe A

D

Data Mining (outils de)

Aussi connu sous le nom de KDD (Knowledge Discovery Data), les

outils de data mining permettent d'extraire de la connaissance des

données en découvrant des modèles, des règles dans

le volume d'information.

Data mining

Le terme anglais «datamining» évoque le

travail de «mineur de fond» pour extraire les données

pertinentes noyées dans de gros volumes de données. Ensemble de

techniques héritées de la statistique "classique", de la

statistique bayésienne et de l'intelligence artificielle, qui permet

l'étude de grands volumes de données. Ces techniques sont

soutenues en général par une méthode de travail qui pose

les étapes de l'étude DataMining.

Déduction / induction

En logique, la déduction procède de la

conception que les moyens ne sont pas plus importants que la fin (conclusion),

par opposition à l'induction logique qui consiste à former des

représentations générales à partir de faits

particuliers.

Dichotomique (Variable)

Variable qui peut opérer une division de

l'échantillon en deux parties.

Discrète / Continue

(variable)

Se dit d'une variable qui ne prend qu'un nombre limité

et connu d'avance de modalités (valeurs distinctes), par opposition

à continue. Une situation familiale, un sexe, ou à une

catégorie socio-professionnelle sont des variables discrètes.

Synonyme : qualitative.

Distance

En mathématiques, une distance est une application qui

formalise l'idée intuitive de distance, c'est-à-dire la longueur

qui sépare deux points.

Données biologiques ( cohorte

)

Ce sont les des dosages systématiques

réalisés (la biochimie, NFS numération de formule sanguine

et analyse d'urine).

Données cliniques ( cohorte )

Les données cliniques, se divisent en examens cliniques

systématiques (taille, poids, pression artérielle, ....), et en

examens cliniques spécifiques (échographie,.....).

Données

génétiques

Les données relatives au génome (ADN, ..).

E

Élaguer

Consiste à supprimer d'un problème des valeurs de

variables ne pouvant pas prendre part à une solution.

Épi-génétique

(maladie)

Le terme épigénétique définit les

modifications transmissibles et réversibles de l'expression des

gènes ne s'accompagnant pas de changements des séquences

nucléotidiques.

Epidémiologie

Etude des différents facteurs qui interviennent dans

l'apparition et l'évolution des maladies.

Eucaryotes / procaryotes

L'ensemble des organismes vivants peut être

classé en trois grands groupes : les eucaryotes (L'Homme, ainsi que les

animaux, les plantes et les champignons), les eubactéries, les

archaebactéries. Les cellules des eucaryotes possèdent un noyau.

Les eubactéries et les archaebactéries ne possèdent pas de

vrai noyau.

F

FASTA

C'est une méthode de recherche heuristique

utilisée en bio-informatique permettant de trouver les régions

similaires entre deux ou plusieurs séquences de nucléotides ou

d'acides aminés. Ce programme permet de retrouver rapidement dans des

bases de données, les séquences ayant des zones de similitude

avec une séquence donnée (introduite par l'utilisateur).

Annexe A

Fonctionnelle (génomique)

Étude de la fonction des gènes par analyse de leur

séquence et de leurs produits d'expression : les ARNm (transcriptome) et

les protéines (protéome).

G

Gène

Fragment d'ADN portant les informations nécessaires

à la fabrication d'une ou plusieurs protéine(s). Un gène

comprend la séquence en nucléotide qui peut varier de quelques

centaines, à plus d'un million de nucléotides.

Génétique (algorithme)

Un algorithme génétique est un algorithme lent,

représentant les modèles comme des gènes et des

opérateurs génétiques et les faisant évoluer soit

par mutation (un gène au hasard est remplacé), soit par

cross-over (la place de deux sous-arbres est échangée).

Génome

Ensemble de l'information génétique d'un organisme

(matériel génétique présent dans chacune des

cellules d'un individu, patrimoine héréditaire d'un individu).

Une copie du génome est présente dans chacune de ses cellules. Le

génome est transmis de génération en

génération.

Génomique

Étude des génomes. Son objectif est de

séquencer l'ADN d'un organisme et de localiser sur celui-ci tous les

gènes qu'il porte, puis de caractériser leurs fonctions.

Génotype

Ensemble des caractères génétiques d'un

individu. Son expression conduit au phénotype.

H

HMM

Un modèle de Markov caché (MMC) -- en anglais

Hidden Markov Models (HMM) (ou plus correctement, mais moins employé

automate de Markov à états cachés) est un modèle

statistique dans lequel le système modélisé est

supposé être un processus Markovien de paramètres inconnus.

Les modèles de Markov cachés sont massivement utilisés

notamment en reconnaissance de formes, en intelligence artificielle ou encore

en traitement automatique du langage naturel.

I

Induction

Méthode consistant à tirer une conclusion d'une

série de faits. Cette conclusion ne sera jamais sûre à 100

%. L'induction en revanche génère du sens en passant des faits

à la loi, du particulier au général.

M

Marqueur génétique

En cartographie génétique, séquence d'ADN

particulière utilisée pour "baliser" les chromosomes.

Modèle

Mécanique plus ou moins "boîte noire" qui,

à partir de données connues (input), calcule une réponse

(target) et la probabilité de réalisation de cette réponse

associée (score).

Moteur d'inférence

Partie d'un système expert qui effectue la

sélection et l'application des règles en vue de la

résolution d'un problème donné.

Motifs fréquents

Un caractère ou trait qui se répète

fréquemment.

Motifs séquentiels

Les motifs séquentiels permettent de traiter de gros

volumes de données et d'en extraire des règles incluant la

dimension temporelle

Mutation

Modification affectant l'ADN d'un gène. Cette

altération du matériel génétique d'une cellule ou

d'un virus entraîne une modification durable de certains

caractères du fait de la transmission héréditaire de ce

matériel de génération en génération.

Annexe A

N

Nucléotide

Motif structural de base des acides nucléiques,

formé de l'assemblage de plusieurs molécules : un sucre, un acide

phosphorique et une base azotée (dans le cas de l'ARN, cette base peut

être l'Adénine - A, la Cytosine - C, la Guanine - G ou l'Uracile -

U ; idem dans le cas de l'ADN, excepté que l'Uracile est remplacé

par la Thymine - T).

O

OR (Odds Ratio)

Un Odds ratio (OR), se définit comme le rapport des

chances qu'un évènement arrivant, par exemple une maladie,

à un groupe de personnes A, arrive également à un autre

groupe B.

Orphelines (pathologies)

Les maladies rares ou maladies orphelines sont des maladies qui

affectent moins de 0,05 % de la population (1 personne sur 2 000).

P

Pathogènes

/pathogénicité

Les agents infectieux sont un type d'agent pathogène,

responsables des maladies infectieuses.

PE / PPE

Familles de protéines.

Perceptron

Catégorie de réseaux de neurones robustes. Ils

diffèrent des autres réseaux (les RBF) par la fonction

d'activation des neurones, c'est à dire leur manière de

transformer les signaux d'entrée en signal de réponse.

Plasmide

Petite molécule circulaire d'ADN extrachromosomique

présente chez les bactéries, capable de se répliquer de

façon autonome, dans la cellule d'origine et dans une

cellule-hôte.

Polymorphismes

génétiques

Les polymorphismes génétiques s'expriment chez les

individus sous la forme de différents phénotypes.

Protéine

L'un des quatre matériaux de base de tout organisme, avec

les glucides, les lipides et les acides nucléiques. Les protéines

sont formées d'un enchaînement spécifique d'acides

aminés (de quelques dizaines à plusieurs centaines). Les

protéines remplissent différentes fonctions dans la cellule,

notamment des fonctions de structure et des fonctions enzymatiques.

Protéome / protéomique

Le protéome est l'ensemble des protéines produites

à partir du génome d'un organisme. La protéomique est

l'étude du protéome, dans le but de déterminer

l'activité, la fonction et les interactions des protéines.

Puce à ADN

Technologie employée dans l'étude du transcriptome

et basée sur la capacité des molécules d'ADN et d'ARN

à s'hybrider entre elles. De courtes séquences d'ADN connues sont

fixées sur des supports d'une surface de l'ordre du centimètre

carré : les puces.

Q

Qualitative / Quantitative

(variable)

Une variable qualitative est une variable pour laquelle la

valeur mesurée sur chaque individu (parfois qualifiée de

catégorie ou de modalité) ne représente pas une

quantité. Une variable est dite quantitative lorsque la valeur

mesurée sur chaque individu représente une quantité.

R

Raisonnement à partir de cas / Case Based

Reasoning

Un système CBR dispose d'une base de cas. Chaque cas

possède une description et une solution. Pour utiliser ces informations,

un moteur est aussi présent. Celui-ci va retrouver les cas similaires au

problème posé. Après analyse, le moteur fournit une

solution adaptée qui doit être validée. Enfin le moteur

ajoute le problème et sa solution dans la base de cas.

Annexe A

Règles séquentielles

C'est une règle d'association incluant le facteur

temporel.

Renforcement (apprentissage)

L'apprentissage par renforcement fait référence

à une classe de problèmes d'apprentissage automatique, dont le

but est d'apprendre, à partir d'expériences, ce qu'il convient de

faire en différentes situations, de façon à optimiser une

récompense numérique au cours du temps.

RR (Risque relatif),

Le risque relatif (RR) est une mesure statistique souvent

utilisée en épidémiologie, mesurant le risque de survenue

d'un événement entre deux groupes.

S

Segmentation (ou Typologie)

Découpage d'une population en fonction d'un ou

plusieurs critères (géographiques, sociodémographiques,

comportementaux...). Les groupes ainsi constitués aussi homogènes

et différents entre eux que possibles, peuvent être choisis comme

autant de cibles à atteindre à l'aide d'un marketing mix

spécifique.

Séquençage

(génome)

Analyse du génome, consistant à

déterminer la succession de toutes les bases qui composent l'ADN d'un

organisme. Ce séquençage n'est réalisé ou en cours

de réalisation que pour un nombre limité d'espèces :

quelques bactéries, une levure, un insecte (la drosophile) et l'homme.

Le séquençage ne permet pas la détermination de la

fonction des protéines codées par l'ADN.

Séquenceurs automatiques

Un séquenceur de gènes (ou « séquenceur

») est un appareil capable d'automatiser l'opération de

séquençage de l'ADN.

Séquences répétées

directes

Séquences identiques ou quasi identiques, présentes

en plusieurs copies dans la même molécule d'ADN.

Séquences répétées en

tandem

Séquences répétées directes

adjacentes.

Souche (bactérie)

Une population d'une espèce pouvant engendrée

une population fille c'est-à-dire les ancêtres d'une population,

par exemple des souches de bactéries pathogènes,

Supervisé / non supervisé

(méthode)

L'apprentissage supervisé est une technique

d'apprentissage automatique où l'on cherche à produire

automatiquement des règles à partir d'une base de données

d'apprentissage contenant des exemples de cas déjà

traités. L'apprentissage non-supervisé est une méthode

d'apprentissage automatique. Cette méthode se distingue de

l'apprentissage supervisé par le fait qu'il n'y a pas de sortie a

priori.

Streptococcus

Les Streptococcus ou streptocoques sont des bactéries.

On retrouve des streptocoques un petit peu partout dans la nature. Certains

vivent sur la peau et les muqueuses de l'homme : leur présence est

normale.

Syndrome métabolique

Le syndrome métabolique (ou syndrome X)

désigné par les acronymes SMet (pour syndrome métabolique)

ou MetS (pour Metabolic syndrome chez les anglophones) désigne

l'association d'une série de problèmes de santé ayant en

commun un mauvais métabolisme corporel.

T

Transfert horizontal / vertical

Le Transfert horizontal de gènes (ou HGT pour

Horizontal Gene Tranfer en anglais), est un processus dans lequel un organisme

intègre du matériel génétique provenant d'un autre

organisme sans en être le descendant. Par opposition, le transfert

vertical se produit lorsque l'organisme reçoit du matériel

génétique à partir de son ancêtre.

Introduction générale - 1 -

Introduction générale

Au cours des dernières années, la

bioinformatique [Gibas et Jambeck, 2002] a connu un grand développement

lié à l'aboutissement de nombreux travaux de

séquençage, lesquels ayant conduit à l'arrivée

d'énormes quantités de données biologiques qu'il faut

exploiter pour tirer un maximum de connaissances possibles [Chervitz et al.,

1999], [Tzanis et al., 2005]. Si dans un premier temps, les génomes

séquencés étaient ceux des procaryotes (unicellulaires :

Bactérie, ....), nous arrivons maintenant au stade où des

génomes d'eucaryotes (pluricellulaires : animaux, humains, ...) sont

disponibles. De ce fait, les quantités de données brutes

disponibles sont déjà trop importantes pour pouvoir être

analysées manuellement [Chervitz et al., 1999].

L'outil informatique et par la même les

méthodes informatiques se sont imposées d'elles mêmes en

biologie moléculaire: C'est la naissance de la bioinformatique. Son

développement a été rendu possible par les énormes

progrès réalisés en informatique (capacités de

calcul, stockage, nouveaux algorithmes,...), qui ont permis la constitution de

banques de données pour le stockage de l'intégralité des

données biologiques produites par les

expérimentations.

Dans un autre volet complémentaire, nous avons

l'épidémiologie, qui est basée sur l'utilisation des

méthodes de surveillance et d'analyse des données recueillies

concernant les diagnostics relatifs à des infections. Ces

méthodes classiques ne sont plus satisfaisantes comme elles

l'étaient autrefois, surtout quand il s'agit d'analyser et

détecter précocement une épidémie causée par

une maladie émergente.

Du fait de l'inefficacité de ces

méthodes, de la variété des données biologiques, et

de la nature même des épidémies [Labbe, 2007], une nouvelle

approche, exploitant des données biologiques relatives aux

épidémies, est utilisée afin de mieux comprendre les

maladies qui ont un profil épidémiologique : c'est la fouille de

données biologiques relatives aux épidémies [Remvikos,

2004], [Maumus et al., 2005], [Etienne, 2004].

Cette fouille de données permet d'extraire des

connaissances qui aideront à mieux connaître ou interpréter

les phénomènes biologiques liés à une

épidémie particulière et ainsi permettre la mise en oeuvre

de mesures de prévention et de lutte, par des traitements

appropriés, des vaccinations, des antibiotiques, etc.

Un autre aspect, la disponibilité de vastes

banques de données de santé publique relatives aux

épidémies issues des récents séquençages de

nouveaux agents pathogènes,

Introduction générale - 2 -

a incité à les valoriser pour mieux

connaitre les épidémies et aider les spécialistes à

trouver des réponses thérapeutiques efficaces.

En effet, parmi ces épidémies, il existe

une qui a montré un fort intérêt notamment par les

récents séquençages de nouvelles souches : c'est la

tuberculose.

A l'origine l'infection est provoquée par la

pénétration dans l'organisme d'une bactérie appelée

Mycobacterium Tuberculosis, et lorsque cette infection se multiplie dans un

lieu et une période donnée cela abouti à une

l'épidémie. Dans la pratique, il existe un Complexe Tuberculosis

dont le Mycobacterium Tuberculosis est l'agent typique responsable de la

tuberculose humaine (voir Figure 0.1).

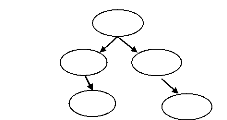

Complexe Tuberculosis

M.

Tuberculosis

M.

Africanum

M.

Bovis

M. Bovis BCG

M.

Canetti

M.

Microti

Figure 0.1: Complexe Tuberculosis.

L'agent pathogène : La bactérie

Les bactéries (Bacteria) sont des organismes

vivants unicellulaires. Elles mesurent quelques micromètres de long et

peuvent présenter différentes formes : des formes

sphériques (coques), allongées ou en bâtonnets (bacilles),

et des formes plus ou moins spiralées [Wikipedia].

Caractéristiques génétiques d'une

bactérie

La plupart des bactéries possèdent un

unique chromosome circulaire, d'autres possèdent un chromosome

linéaire. Il existe toutefois de rares bactéries possédant

deux chromosomes. La taille du génome s'exprime en millier de

nucléotides et peut être très variable selon les

espèces de bactéries.

L'analyse chimique de l'appareil nucléaire

indique qu'il est composé à 80 % d'ADN (le chromosome), à

10 % d'ARN et à 10 % de protéines [Carbonelle et al.,

2003].

· L'ADN (le chromosome) : Chez les bactéries

tout l'ADN est codant.

· L'ADN Extrachromosomique (les plasmides) : A

côté du chromosome, il peut exister des éléments

génétiques (ADN) de petites tailles (0,5 à 5 % du

chromosome bactérien), extra-chromosomiques, se sont les plasmides. Les

plus connus sont les plasmides de résistance aux antibiotiques, ils

portent des gènes

Introduction générale - 3 -

qui confèrent aux bactéries la

résistance à divers antibiotiques [Carbonelle et al.,

2003].

Dans le domaine des bactéries et en

particulier celui du Mycobacterium Tuberculosis, les séquences

complètes de génomes s'accumulent depuis 1995 (voir Tableau

0.1, Tableau 0.2, Tableau 0.3). Ces données ont

permis d'envisager l'étude du génome du Mycobacterium

Tuberculosis par des techniques informatiques, pour identifier et

connaître au mieux la source de l'infection afin d'aider les

spécialistes à trouver des solutions thérapeutiques et

stopper la diffusion de la bactérie et par conséquent stopper

l'épidémie par certains vaccins, ou antibiotiques.

Plusieurs approches informatiques notamment par la

fouille de données ont été alors développées

en exploitant des données biologiques en générale et de la

tuberculose en particulier, notamment par :

· l'utilisation d'algorithmes de recherche de

mots puis de couples de mots représentés énormément

dans les séquences ADN des souches et espèces

phylogénétiquement proches, ces séquences de lettres

particulières, permettent de repérer et d'identifier des

séquences anormales.

· la fouille de données génomiques

sans à priori pour faire émerger des sous-séquences d'ADN

qui peuvent donner des éléments d'informations sur les grandes

séquences d'ADN ;

· la recherche de gènes

co-régulés, etc.

En 1998, la première séquence

complète du génome de Mt H37RV a été

réalisée et a permis de dégager des

caractéristiques propres aux mycobactéries dont les plus

importantes [Carbonelle et al., 2003]:

· 51 % des gènes sont

dupliqués;

· 10 % du génome code pour 2 familles de

gènes qui codent eux mêmes pour 2 protéines nommées

PE et PPE;

· forte présence de séquences

répétées d'ADN, dont 65 copies de séquences

appelées MIRUs (Mycobacterial Interspaced Repetitive Unit), et de

répétitions directes appelées RDs. Ces séquences

répétées sont riches en particularités sur le

génome. Toutes ces caractéristiques de ce génome sont

autant chacune une source qu'on exploite en fouille de données

[Fleiishman et al., 2002], [Ferdinand et al., 2004], [Yokoyama et al.,

2007].

Introduction générale - 4 -

Problématique.

La représentation des séquences

biologiques. Dans un passé récent, la fouille de données

dans un contexte biologique utilisait la séquence dans sa structure

primaire à base de nucléotides (ex : AAGTCGTTGCTGGC) où

celle-ci est considérée comme une chaine de milliers de

caractères, en ce moment le gène, la protéine, et autres

éléments caractérisant n'étaient pas suffisamment

cernés (annotation incomplète) pour être exploités

efficacement et donc le prétraitement des données se basait

essentiellement sur des techniques de traitement de texte plus ou moins

aménagées selon le contexte.

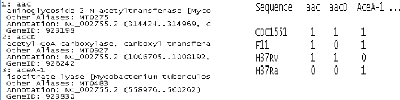

Alors, nous avons envisagé un système

de fouille de données un peu plus élaboré du fait de

l'existence d'entités sémantiques dans le fichier de la

séquence en question (le

gène, la protéine, sa localisation, )

(voir Figure 0.2). Nous utilisons donc des

traitements

spécifiques pour obtenir une structure bien appropriée à

la fouille de données (voir Figure 0.3) ou les entités

sémantiques (gènes, protéines, ...) deviennent des

descripteurs, et on attribuera la valeur «0» en l'absence et

«1» en la présence de ce descripteur dans la

séquence.

Figure 0.2. Morceau de séquence

génomique Figure 0.3. Fichier des séquences

rapatriée de NCBI. ayant subi une

transformation.

Dans le cadre de cette étude, nous avons

développé des recherches sur les systèmes d'extraction de

règles d'association à partir des données (gènes,

...) [Chen et al., 2003], [Bahar et Chen, 2004], [Benabdeslem et al., 2007] et

nous avons réalisé un système baptisé BIODM :

BIOlogical Data Mining. En premier lieu, nous avons étudié

l'extraction de règles d'association en utilisant des algorithmes

appropriés. En deuxième lieu nous avons travaillé sur le

raffinement, des résultats, par un processus d'induction cellulaire BRI

(Boolean Rule Induction). Ce raffinement est assuré par une

modélisation booléenne.

Deux motivations concurrentes nous ont amenés

à adopter le principe des automates

Introduction générale - 5 -

cellulaires pour les systèmes à base de

règles d'association. En effet, nous avons non seulement souhaité

avoir une base de règles optimale (modélisation

booléenne), mais nous avons également exploité les

performances du moteur d'inférence cellulaire CIE de la machine

cellulaire CASI, déjà opérationnel [Benamina et Atmani,

2008].

Ce mémoire s'articule autour de quatre chapitres

:

Le chapitre I introduit l'extraction de la

connaissance à partir de données biologiques. Nous commencerons

par expliquer comment est né le besoin en fouille de données

biologiques et particulièrement en épidémiologie, ensuite

nous passerons en revue les différents types de données

biologiques auxquels nous seront amené à travailler pour donner

par la suite une vue d'ensemble du processus d'ECD biologiques que nous

envisageons de suivre. Une fois, toutes ces notions clarifiées nous

aborderons un état de l'art du domaine de l'ECD biologiques que nous

concluons par une étude comparative des méthodes et techniques

utilisées et une explication de notre contribution par cette

étude.

Le chapitre II aborde le principe de l'extraction des

règles d'association, une méthode descriptive de fouille de

données qui a reçu beaucoup d'intérêt en recherche.

Nous présentons le principe ainsi que les différents algorithmes

les plus en vue dans la littérature.

Le chapitre III est consacré à la

présentation du processus d'ECD biologiques que nous avons adopté

en particulier la modélisation booléenne des règles

d'association, résultat du module BRI, selon le principe de la machine

cellulaire CASI [Benamina et Atmani, 2008].

Le chapitre IV présente les données

expérimentales et l'architecture générale du

système que nous avons réalisé : BIODM. Ensuite, nous

présentons les résultats obtenus sur la base des

échantillons test que nous avons utilisés.

Finalement, nous concluons en synthétisant les

différentes étapes de notre contribution et nous proposons les

perspectives envisagées pour poursuivre cette recherche.

Chapitre I : L'extraction de connaissances à

partir de données biologiques - 6 -

Chapitre I.

L'extraction de connaissances à partir de

données biologiques

L'avènement des biotechnologies nouvelles a

permis, au cours des dernières années, d'améliorer les

connaissances sur le génome des agents pathogènes

épidémiologiques, de développer des moyens de lutte

efficace par le développement de plusieurs médicaments

appropriés. Par contre l'exploitation des données

génomiques n'a pas suivi le rythme des découvertes et

l'extraction de connaissances à partir de données (ECD)

biologiques, particulièrement à caractère

épidémiologique, s'est imposée d'elle-même afin de

répondre aux questions que se pose l'épidémiologiste comme

par exemple la recherche des facteurs de risque des maladies.

Ainsi et depuis le premier séquençage

d'une bactérie, des dizaines de génomes ont été

révélés. Les dispositifs expérimentaux tels que les

séquenceurs automatiques ont permis de constituer des banques de

données de séquences de génomes complets. Il fallait donc

analyser ces données, identifier les gènes, les protéines

produites et leurs fonctions pour comprendre les mécanismes cellulaires.

Les retombées de ces travaux sont énormes et concernent aussi

bien la biologie, l'épidémiologie et l'industrie pharmaceutique,

pour une meilleure compréhension des maladies et la découverte de

nouvelles réponses thérapeutiques.

I.1 Définition de l'extraction de connaissances

à partir de données biologiques

Le terme ECD (en anglais Knowledge Discovery in

Databases) est communément confondu avec la fouille de données ou

« Data Mining ». Ceci s'explique par le fait que la fouille de

données est l'étape principale du processus de l'ECD.

L'ECD a été définie comme suit

[Fayyad et al., 1996] : « l'ECD vise à transformer des

données (volumineuses, multiformes, stockées sous

différents formats sur des supports pouvant être

distribués) en connaissances. Ces connaissances peuvent s'exprimer sous

forme d'un concept général qui enrichit le champ

sémantique de l'usager par rapport à une question qui le

préoccupe. Elles peuvent prendre la forme d'un rapport ou d'un

graphique. Elles peuvent s'exprimer comme un modèle mathématique

ou logique pour la prise de décision. Les modèles explicites

quelle que soit leur forme, peuvent alimenter un système à base

de connaissances ou un système expert ».

Chapitre I : L'extraction de connaissances à

partir de données biologiques - 7 -

Cette définition apporte un concept nouveau,

celui de modèle et sous entend un autre celui de motif qui ne seraient

pas synonymes. En réalité il existe une différence entre

les deux :

Un modèle est une connaissance qui concerne la

totalité des données. Si le Data Miner possède un

modèle, il peut l'appliquer à chaque nouveau cas qui se

présente.

Un motif est une connaissance qui concerne une partie

des données. On ne peut l'appliquer à chaque nouveau cas. En

d'autres termes, c'est un modèle local, selon lequel se comporte une

partie des données et non pas la totalité.

I.2 Le processus de l'ECD biologiques

Avec le récent développement des

études à l'échelle génomique et protéomique,

les données biologiques se sont considérablement

multipliées et diversifiées. Ces données se

présentent alors sous la forme de séquences ou d'informations qui

proviennent de soumissions directes effectuées par les auteurs, par

l'intermédiaire d'Internet ou d'autres moyens électroniques

appropriés.

Nous trouvons alors des :

· des séquences et des données

d'expression de gènes (ADN, ARN, Protéines) ;

· des informations d'annotations (fonctions, ...)

de gènes et de protéines, etc.

Ces données biologiques sont stockées

dans des banques de données généralistes ou

spécialisées. On trouve alors des banques de données

:

· d'ADN : GenBank, DDBJ, EMBL, ...;

· d'ARN : RNAdatabases, QTL, ... ;

· de protéines : PIR ,Swiss-Prot, TrEMBL,

PDB, SCOP, ... ;

· de gènes : NCBI, dbEST, UniGene, Gis, ...

;

· ..etc.

L'ECD biologiques est un peu particulière

parce qu'en fait les données biologiques sont souvent dans un format

textuel (voir Figure 0.2) et ne se prêtent pas directement

à une exploitation par des systèmes classiques. Pour cela nous

présenterons ce processus dans son contexte biologique. Bien que le

processus général de l'ECD est particulièrement standard,

il présente néanmoins des traitements spécifiques d'une

étape à une autre et ce par rapport à la nature des

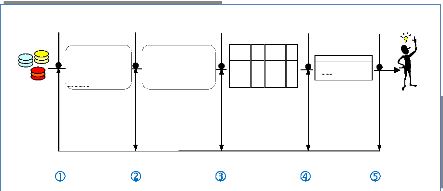

données traitées. Nous allons présenter une

démarche qui comprend les cinq étapes suivantes : la

sélection des données, le prétraitement, la

transformation, la fouille de données, l'évaluation et

l'interprétation des connaissances, en montrant d'une étape

à une autre, les particularités du processus d'ECD.

Chapitre I : L'extraction de connaissances à

partir de données biologiques - 8 -

(1) La sélection des

données

L'accès aux données se fait, dans notre

cas, à travers Internet via des interfaces spécialisées

pour le téléchargement d'échantillons expérimentaux

sélectionnés selon des critères fixés par

l'utilisateur. On utilise alors le système d'accès et de

récupération de données, ENTREZ de NCBI1.

Celui-ci permet d'interroger une collection de séquences disponibles

sous le format texte brut. Il permet aussi la recherche et l'extraction de

données relatives aux séquences nucléotidiques ou

protéiques, aux références bibliographiques

associées, et aux collections de séquences génomiques et

structurales, à l'aide d'une simple interrogation du serveur de NCBI

(National Center for Biotechnology Information).

Ensuite, ces données sont

récupérées sous la forme d'un ensemble de fichiers textes

bruts. À l'intérieur de ces fichiers, chaque séquence est

contenue dans une structure appelée « entrée »,

celle-ci comprend des informations liées à la séquence

considérée : structure, rôle biologique, organisme

d'origine...etc. Les données intéressantes sont stockées

au niveau de « champs » bien définis.

A l'intérieur de ces fichiers, la

donnée biologique peut être représentée sous

différents formats. Nous présentons les formats les plus

utilisés :

· FASTA (le format le plus simple)

· PIR (spécifique à la Bdd

PIR)

· STADEN

· Texte Brut.

Format FASTA

FASTA est sans doute le plus répandu et l'un

des plus pratiques. La séquence est décrite sous forme de lignes

de 80 caractères maximum, et précédée d'une ligne

de titre (nom, définition, ...) qui doit commencer par le

caractère ">". Plusieurs séquences peuvent être mises

dans un même fichier (voir Figure 1.1).

>entête de la séquence 1 Séquence

1

>entête de la séquence 2 Séquence

2

1

http://www.ncbi.nlm.nih.gov

Chapitre I : L'extraction de connaissances à partir de

données biologiques - 9 -

|

>gi|22777494|dbj|BAC13766.1| glutamate dehydrogenase

[Oceanobacillus iheyensis]

MVADKAADSSNVNQENMDVLNTTQTIIKSALDKLGYPEEVFELLKEPMRILTVRIPVRMDDGNV

LGGSHGRESATAKGVTIVLNEAAKKKGIDIKGARVVIQGFGNAGSFLAKFLHDAGAKVVAISDA

YGALYDPEGLDIDYLLDRRDSFGTVTKLFNNTISNDALFELDCDII

>EM|U03177|FL03177 FELINE LEUKEMIA VIRUS CLONE

FELV-69TTU3-16. AGATACAAGGAAGTTAGAGGCTAAAACAGGATATCTGTGGTTAAGCACCTG

GCCAGCAGTCTCCAGGCTCCCCA

|

Figure 1.1 : Exemple du format FASTA d'une

séquence protéique.

|

CODE

|

SIGNIFICATION

|

|

">"

|

Début de séquence.

|

|

gi|22777494

|

GenInfo Identifier

|

|

dbj|BAC13766.1|

|

Un enregistrement de séquence peut être

enregistré dans

plusieurs banques de données donc il y aura

un

identifiant dans la banque de données dans cet exemple c'est DNA

Database of Japan sous le n° dbj|BAC13766.1

|

|

BAC13766.1|

|

". 1" la séquence a été

révisée une fois

|

|

"glutamate dehydrogenase"

|

nom de la protéine

|

|

[Oceanobacillus iheyensis]

|

nom de l'organisme à partir duquel elle a

été déterminée.

|

Tableau 1.1 : Description du fichier FASTA de

l'exemple de la Figure 1.1.

Format STADEN

STADEN est le plus ancien et le plus simple. C'est une

suite de lettres par ligne terminée par un retour à la ligne (80

caractères maximum par ligne). Ce format n'autorise qu'une

séquence par fichier (voir Figure 1.2).

|

lovelace$ more zfmtsec

SESLRIIFAGTPDFAARHLDALLSSGHNVVGVFTQPDRPAGRGKKLMPSPVKVLAEEKGL

PVFQPVSLRPQENQQLVAELQADVMVVVAYGLILPKAVLEMPRLGCINVHGSLLPRWRGA

APIQRSLWAGDAETGVTIMQMDVGLDTGDMLYKLSCPITAEDTSGTLYDKLAELGPQGLI

TTLKQLADGTAKPEVQDETLVTYAEKLSKEEARIDWSLSAAQLERCIRAFNPWPMSWLEI

EGQPVKVWKASVIDTATNAAPGTILEANKQGIQVATGDGILNLLSLQPAGKKAMSAQDLL

NSRREWFVPGNRLV

|

Figure 1.2 : Exemple du format STADEN d'une

séquence protéique.

Format PIR

La première ligne commence par ">" suivi du

code de la séquence et du nom de la protéine. La deuxième

ligne contient une description textuelle de la séquence suivent

plusieurs lignes descriptives de la séquence elle-mêm,e et se

termine par une marque de fin de séquence "*" (voir Figure

1.3).

Chapitre I : L'extraction de connaissances

à partir de données biologiques -

10 -

|

>P1;1h7wa1

structureX:1h7wa1: 2 :A: 183 :A:undefined:undefined:

1.90:99.90

APVLSKDVADIESILALNPRTQSHAALHSTLAKKLDKKHWKRNPDKNCFHCEKLENNFD

DIKHTTLGERGALREACLKCADAPCQKSCPTHLDIKSFITSISNKNYYGAAKMIFSDNPLG

LTCGMVCPTSDLCVGGCNLYATEEGSINIGGLQQFASEVFKAMNIPQIRNPCLPSQEKMP*

|

Figure 1.3 : Exemple du format PIR d'une

séquence protéique.

|

CODE

|

SIGNIFICATION

|

|

|

|

">P1"

|

Début de la ligne

|

|

|

|

1h7wa1

|

Code de la protéine

|

|

|

|

structureX:1h7wa1: 2 :A: 183

:A:undefined:undefined: 1.90:99.90

|

description textuelle

séquence

|

de

|

la

|

|

"*".

|

Fin de la séquence

|

|

|

Tableau 1.2 : Description du fichier PIR de

l'exemple de la Figure 1.3.

Format Texte Brut

L'information biologique est décrite dans un

fichier au format texte brut ou chaque ligne a un sens bien précis,

comme par exemple, un code, un nom, etc. (voir Figure 1.4)

1: aac

aminoglycoside 2-N-acetyltransferase [Mycobacterium

tuberculosis CDC1551]

Other Aliases: MT0275

Annotation: NC_002755.2 (314424..314969,

complement)

GeneID: 923198

4270: tRNA-Pro-3

tRNA [Mycobacterium tuberculosis CDC1551] Annotation:

NC_002755.1 (4118796..4118872) GeneID: 922697

This record was discontinued.

Figure 1.4 : Exemple de fichier à

l'état brut de de la séquence génomique de

la souche MT

CDC1551 au format texte brut.

(2) Le prétraitement des

données

Le prétraitement consiste à nettoyer et

mettre en forme les données dans un formalisme approprié pour une

exploitation efficiente, i.e. l'élimination des données sans

importances particulières dans le processus d'ECD, et qui sont

susceptibles de réduire l'exactitude des modèles à

extraire. Ceci commence par un nettoyage des fichiers

Chapitre I : L'extraction de connaissances

à partir de données biologiques -

11 -

par enlèvement des lignes inutiles, des termes

ou morceaux de texte, tels que n° ligne, caractères spéciaux

inutiles. La Figure 1.5 montre un morceau de séquence de

gène nettoyé, et la Figure 1.6, montre le

résultat final de cette étape.

1: aac

aminoglycoside 2-N-acetyltransferase [Mycobaterium

Tuberculosis CDC1551] GeneID: 923198

2: accD

acetyl-CoA carboxylase, carboxyl transferase, beta

subunit [Mycobaterium Tuberculosis CDC1551]

GeneID: 926242

Figure 1.5 : Morceau de la séquence

génomique nettoyée, de la souche Mt CDC1551.

aac |aminoglycoside 2-N-acetyltransferase | Mycobaterium

Tuberculosis CDC1551 | 923198

accD | acetyl-CoA carboxylase, carboxyl transferase,

beta subunit | Mycobaterium Tuberculosis CDC1551 | 926242

Figure 1.6 : Morceau de la séquence

génomique mise en forme, de la souche Mt CDC1551.

(3) La transformation des

données

Cette étape consiste à transformer les

données et les convertir en données appropriées (voir

Figure 1.6), pour exploitation. Ce sera une transformation vers un

formalisme base de données (attribut, valeur), à partir des

descripteurs possibles qui peuvent être dégagées à

cette étape. Ces descripteurs ou attributs vont aider à «

binariser » les entités dégagées et serviront ainsi

à alimenter une base de données.

aac |aminoglycoside 2-N-acetyltransferase | Mycobaterium

Tuberculosis CDC1551

| 923198

accD | acetyl-CoA carboxylase, carboxyl transferase, beta

subunit | Mycobaterium Tuberculosis CDC1551 | 926242

aceA-1 | isocitrate lyase |

Mycobaterium Tuberculosis CDC1551 | 923830

Figure 1.7 : Morceau de la séquence

génomique structurée, de la souche Mt CDC1551.

|

Séquence génomique

structurée

|

|

code_gene

|

nom_gene

|

id_gene

|

|

aac

|

aminoglycoside 2-N-

acetyltransferase

|

923198

|

|

accD

|

acetyl-CoA carboxylase, carboxyl transferase, beta

subunit

|

926242

|

|

aceA-1

|

isocitrate lyase

|

923830

|

Chapitre I : L'extraction de connaissances à

partir de données biologiques - 12 -

(4) La fouille de données

C'est le coeur du processus d'ECD biologiques.

L'extraction de connaissances est faite à partir de cette étape.

Elle consiste à dégager un ensemble de connaissances brutes

à partir des données prétraitées. Un exemple est la

recherche d'associations.

(5) Evaluation et interprétation des

connaissances

Dans la plupart du temps, les connaissances extraites

au terme de la précédente étape ne sont pas toutes

profitables. En effet, il est difficile d'avoir directement des connaissances

valides et utilisables par l'utilisateur humain, le Data Miner. Il existe, pour

la plupart des techniques de fouille de données, des méthodes

d'évaluation des modèles ou motifs extraits. Ces méthodes

peuvent aussi aider à corriger les modèles, et à les

ajuster aux données.

Selon le degré d'exactitude des connaissances

retournées par ces méthodes, l'expert du domaine décide

d'arrêter le processus d'ECD ou au contraire le reprendre à partir

d'une étape antérieure (le processus est itératif)

jusqu'à ce que les connaissances obtenues soient nouvelles,

interprétables, valides et utiles au Data Miner. Ce dernier peut les

utiliser directement ou les incorporer dans un système de gestion de

connaissances.

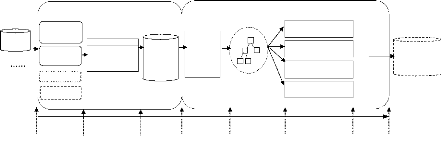

La Figure 1.8, ci-dessous montre l'aspect

itératif du processus, i.e. la possibilité de retourner à

n'importe quelle étape afin d'obtenir des connaissances de

qualité.

Banques de Données Biologiques (NCBI,

...)

Selection Prétraitement Transformation

Données biologiques cibles (séquence

génomique, séquence protéique,..)

1: aac

aminoglycoside 2-N-acetyltransferase [Mycobacterium tuberculosis

CDC1551]

Other Aliases: MT0275

Annotation: NC_002755.2 (314424..314969, complement) GeneID:

923198

Données Nettoyées et mises en

forme

accD | acetyl-CoA carboxylase, carboxyl transferase, beta

subunit | Mycobaterium Tuberculosis CDC1551 | 926242

aac |aminoglycoside 2-N-acetyltransferase | Mycobaterium

Tuberculosis CDC1551 | 923198

CDC1551 aac aminoglyco side 2-N-acetyltransf erase

Données Structurées

souche

Code gene

Nom gene

9231

98

Id gene

Fouille de données

aac -> ackA (75.0, 100.0) ackA -> aac (75.0,

100.0)

Motifs

Evaluation, interpretation

Connaissances

Figure 1.8 : Processus d'ECD

Biologiques.

Chapitre I : L'extraction de connaissances

à partir de données biologiques -

13 -

I.3 Notre contribution

Dans notre étude, nous nous proposons

d'étudier les aspects physiologiques liés à la

génomique de cette bactérie modèle (Mycobacterium

Tuberculosis), à savoir : les gènes, protéines, et autres

données génomiques, ceci afin de mieux connaitre notre terrain

expérimental.

Ensuite, nous étudions les outils de l'ECD pour

les utiliser sur les données précitées, et dégager

une approche expérimentale par des moyens informatiques afin de donner

à l'expert du domaine des connaissances qui permettent d'avoir quelques

éléments de réponses possibles aidant à comprendre

certains processus biologiques et se fixer de nouvelles hypothèses et

continuer ainsi le processus de compréhension et de recherche

médicale.

En premier

Nous avons établi un état de l'art de

l'ECD, où nous présentons les techniques de l'ECD avec certains

détails d'une technique à une autre et qui ne sont pas forcement

en rapport direct avec notre étude. Ceci est justifié par le fait

que ce travail est notre première contribution dans ce domaine, nous

avons alors pensé qu'il est utile de faire le tour du domaine afin de

situer la technique de recherche d'associations parmi les différents

outils de l'ECD. Ensuite, une étude comparative des différentes

méthodes existantes a été faite pour nous positionner par

rapport à celles-ci et nous fixer sur la plus appropriée pour

notre étude.

Deuxièmement

Nous avons abordé l'étude de l'agent

pathogène afin de cerner la nature et le type de données

biologiques qui nous intéressent et ainsi pouvoir localiser d'où

puiser nos données expérimentales pour la fouille de

données, i.e. les sources de données biologiques relatives au

Mycobacterium Tuberculosis.

Troisièmement

Nous avons établi notre propre démarche

expérimentale par un processus d'ECD pour générer des

connaissances à partir de données biologiques. Ces connaissances

vont êtres profitables et exploitables à deux niveaux

:

· profitables au premier niveau au

spécialiste du domaine pour la compréhension des aspects

biologiques liés à la pathologie ;

· exploitables au deuxième niveau par la

machine cellulaire pour l'inférence et la

Chapitre I : L'extraction de connaissances

à partir de données biologiques -

14 -

déduction.

Le processus informatique établi procède

en deux étapes : une fouille de données est faite dans un premier

temps et donnera des règles d'association, ensuite ces règles

sont transformées dans un deuxième temps pour produire des

règles booléennes inductives qui vont alimenter la base de

connaissances de la machine cellulaire CAST, [Atmani et Beldjilali, 2007],

[Abdelouhab et Atmani., 2008], [Benamina et Atmani, 2008]. Cette machine a

été développée pour l'acquisition automatique

incrémentale de connaissances par induction et la prédiction par

déduction [Atmani et Beldjilali, 2007].

Ainsi, notre contribution a adopté la

démarche suivante :

(1) Etude et sélection des données

biologiques relatives au mycobactérium tuberculosis ;

(2) Extraction des motifs fréquents et

recherche des règles d'association ;

(3) Production des règles booléennes

inductives pour la machine cellulaire CAST.

I.4 Etat de l'art de l'ECD biologiques

Vu la variété des données

biologiques et par la même des banques de données biologiques,

différents travaux de fouilles de données biologiques ont

été faits. Nous présentons quelques uns mais la liste

n'est pas exhaustive, et nous mentionnons quand même que ce qui a

été fait à nos jours l'a été à base

de séquences biologiques ou de cohortes et suivent deux orientations

principales : certains travaux touchent directement

l'épidémiologie alors que d'autres la touchent indirectement

(génomique et protéomique), mais sont d'un grand apport pour la

compréhension des maladies et par la même des

phénomènes épidémiologiques. Nous présentons

les travaux réalisés dans un tableau récapitulatif (voir

Tableau 1.4) qui donne une vue générale sur les

principales méthodes de fouille de données utilisées en

biologie et dans le domaine des maladies. Ce tableau donne une tendance

à priori sur les méthodes de fouille utilisées mais notons

quand même que c'est un tableau qui résume des articles que nous

avons pu lire et se rapportant à notre sujet sans pour autant

prétendre à l'exhaustivité, vu les travaux qui se font

continuellement.

La classification de protéines

Le prétraitement des séquences biologiques

permet de préparer les données et de les

I.4.1 La fouille de séquences biologiques

Chapitre I : L'extraction de connaissances

à partir de données biologiques -

15 -

exploiter par la suite afin d'identifier des

gènes, comparer des séquences, rechercher des motifs, ou

détecter des signaux (segment ADN) qui indiquent à la cellule la

protéine qui doit être exportée ou

sécrétée. Pour la classification des protéines on

commence souvent par cette phase de prétraitement comme indiquée

pour construire des attributs plus significatifs que la chaîne de

caractères originale. Différentes approches ont été

étudiées allant de l'extraction des descripteurs (variables qui

décrivent au mieux) discriminants, à l'extraction des n-grammes

[Mhamdi et al., 2006], à d'autres en utilisant les modèles de

Markov cachées [Hergalant et al., 2005].

La prédiction de

gène

Les modèles de Markov cachés

interviennent dans de nombreux algorithmes d'analyse de séquence, que ce

soit pour la détection de gènes, l'inférence et la

détection de motifs, ou encore la recherche de mots exceptionnels.

L'utilisation des modèles de Markov cachées d'ordre 2 (HMM2) est

d'une grande utilité dans la segmentation de grandes séquences

ADN en grandes classes déduites à partir de courtes

séquences riches en sémantiques biologiques. Cette segmentation

est utilisée pour prédire des ensembles de gènes

co-régulés donc susceptibles d'avoir des fonctions liées

[Hergalant et al., 2002].

La segmentation de séquences

biologiques

Les très grandes séquences d'ADN qui

constituent les génomes ne sont pas avantageuses directement pour la

fouille de données, donc il est nécessaire de dégager des

sous séquences d'ADN significatives pour une exploitation en

génomique fonctionnelle. Les modèles de Markov cachés ont

étés utilisés pour permettre la segmentation de grandes

séquences d'ADN en différentes classes pour l'étude d'une

bactérie du sol du genre Streptomyces, important producteur

d'antibiotiques. En effet, l'ADN est stratifiée en différents

niveaux de structures, de la plus globale qui reflète une organisation

propre à une espèce considérée, aux portions

locales qui décrivent des constituants fonctionnels particuliers, en

passant par des régions intermédiaires qui délimitent des

domaines où réside une certaine homogénéité

(par exemple pour les protéines).

Recherche de similitudes et étude

d'alignement

La recherche de similarité de séquences

ou de structures est un autre sujet abordé avec les méthodes de

comparaison des séquences ADN et de protéines. Cette comparaison

peut être en local c'est-à-dire entre séquences (Alignement

Local) ou globale (Alignement Global) avec une base de données. Elle a

pour but le repérage des

Chapitre I : L'extraction de connaissances

à partir de données biologiques -

16 -

endroits où se trouvent des régions

identiques ou très proches entre deux séquences et déduire

celles qui sont significatives et qui correspondent à un sens

biologique. En général les algorithmes fonctionnent sur des

segments de séquences sur lesquels on regarde s'il existe ou pas une

similitude significative et la comparaison de séquences s'appuie sur une

de ces trois notions : la recherche de segments identiques, de segments

similaires, ou d'alignements. Leur but est de filtrer les données de la

banque en étapes successives, car peu de séquences vont avoir des

similitudes avec la séquence comparée. Ces programmes calculent

ensuite un score pour mettre en évidence les meilleures similitudes

locales qu'ils ont observées. Plusieurs programmes ont

étés créés dont les plus connus et les plus

utilisés par les biologistes sont les logiciels FASTA et BLAST [Chervitz

et al., 1999].

La recherche de motifs

fréquents

La recherche de séquences

répétées (motifs fréquents), en tandem ou

répétées en dispersion sur l'ensemble du génome,

utilise les Modèles de Markov cachées d'ordre 2. Une étude

a été faite en utilisant cette méthode pour classer un

résidu ou un groupe de résidus nucléotidiques [Hergalant

et al., 2002].

La recherche

d'hétérogénéité

L'analyse de séquences génomiques

à l'aide des modèles de Markov cachés a montré une

grande capacité à détecter des zones

hétérogènes dans les génomes, ces zones qui peuvent

renseigner sur l'implication d'un pathogène donné dans une

maladie [Hergalant et al., 2002].

La recherche de séquences

exogènes

Un autre aspect, de l'étude des gènes,

est le transfert horizontal (échange de matériel

génétique entre bactéries). Des études ont

été faites sur le genre Streptococcus parce qu'il revêt une

importance particulière en renfermant les bactéries

pathogènes. L'utilisation des modèles de Markov cachés

[Hergalant et al., 2002], a permis d'identifier certaines séquences

exogènes au sein de ces génomes qui sont susceptibles de contenir

des gènes de virulence, caractéristiques d'un pathogène,

ou des gènes d'adaptation écologique particulière, ces

résultats montrent que des bactéries seraient en mesure de

transmettre des gènes de virulence à d'autres bactéries

encore inoffensives. Ce genre de découverte améliore la

compréhension du phénomène de résistance à

un antibiotique.

Chapitre I : L'extraction de connaissances

à partir de données biologiques -

17 - I.4.2 fouille du génome

De nombreuses maladies, rares ou fréquentes,

dont souffrent les humains ont une origine génétique tels que le

diabète, les maladies cardiovasculaires ou la mucoviscidose [Maumus et

al., 2005]. Ces maladies ont un caractère plus ou moins

héréditaire dans le sens où des anomalies chromosomiques

sont à l'origine ou favorisent l'apparition de ces maladies. Cela

signifie qu'un ou plusieurs gènes anormaux sont là où est

la maladie. L'étude du génome ou la génomique structurelle

(recherche de mutation, de délétion, ...) peut montrer des

anomalies tout comme la génomique fonctionnelle (compréhension du

fonctionnement des gènes et des autres composantes du génome).

Cette étude se situe à plusieurs niveaux depuis l'échelle

nucléique jusqu'à celui de la génomique comparative avec

pour objectif la localisation, de structures, de régions fonctionnelles,

la caractérisation d'une fonction biologique ou la prédiction

d'autres gènes, c'est ce qui explique le décryptage du

génome par plusieurs travaux de fouille dont les suivants :

Identification de gènes codants et non

codants

Si l'existence de facteurs génétiques de

susceptibilité est fortement soupçonnée dans de nombreuses

maladies, leurs identifications sont souvent difficiles ce qui ouvre la voie

à une étude de recherche des facteurs génétiques de

susceptibilité aux maladies à l'échelle de tout le

génome. Sur le volet de l'annotation des génomes,

c'est-à-dire l'identification des gènes codants (exon), et non

codants (intron), la localisation du début des gènes ainsi que la

détection de petits gènes restent difficiles, et dans le but de

répondre à ces problèmes, on utilise des modèles de

Markov cachés couplés à une estimation par maximisation de

la vraisemblance (comptage des mots de m nucléotides) [Prum et al.,

2001].

La classification et l'identification de

gènes candidats

L'analyse de séquences sur puces à ADN

permet d'obtenir des morceaux de séquences appelées EST

(Expressed Sequence Tags) courtes, de 300-500 nucléotides en

général, ces éléments permettent d'identifier les

variations génétiques associées (zone de

susceptibilité) comme par exemple le gène NOD-2 impliqué

dans la maladie de CROHN.

L'approche gène candidat recherche et met en

relation des gènes nouveaux, découverts par le

séquençage, avec les pathologies orphelines (dont on ne

connaît pas encore le gène responsable) ou des pathologies

complexes, (obésité, arthrose, ...). Deux

Chapitre I : L'extraction de connaissances

à partir de données biologiques -

18 -

classifications ont été

utilisées, l'une pour classer les patients dont la maladie se ressemble

quant à l'expression des gènes, et l'autre qui cherche les

gènes ou les ensembles de gènes dont l'expression est

différente chez des patients de mauvais et de bon pronostic [Maumus et

al., 2005].

I.4.3 Fouille de cohortes

Les cohortes fournissent aussi un tas de

données médicales et en particulier biologiques, qui permettent

de travailler directement sur des cas réels (sujets exposés, non

exposés) et permettent de montrer le rôle et la contribution des

facteurs génétiques et environnementaux dans une maladie. Les

données recueillies sont de 3 types : cliniques, biologiques, et

génétiques.

Les données cliniques. Se divisent en examens

cliniques systématiques (taille, poids,

pression artérielle, ....), et en examens

cliniques spécifiques (échographie, ).

Les données biologiques. Sont les dosages

systématiques réalisés, la biochimie, NFS «

numération de formule sanguine » et analyse d'urine.

Les données génétiques. Se

rapportent à chaque sujet.

On dit que le sujet est génotypé, si

l'on procède par le recueillement de toutes ces données

génétiques. Ce génotypage permettra d'avoir des SNPs

(Single Nucleotide Polymorphisms ou polymorphismes génétiques)

correspondant à tous les processus métaboliques impliqués

dans la maladie. Une fois ces données recueillis, les premières

expérimentations d'extraction de règles sont utilisées

pour permettre la détection d'interactions de type

gène-gène et gène-environnement. Les méthodes de

classification sont aussi très utilisées pour comprendre les

maladies, une étude comparative des différents algorithmes a

été faite pour la pertinence de ces méthodes [Chervitz et

al., 1999], et a montré que les réseaux de neurone, et les SVM

donnent à peu près les mêmes résultats

comparativement aux K-ppv et les arbres de décision. Ces méthodes

de classification sont aussi utilisées pour étudier la

variété des segments ADN et leurs relations avec des maladies ou

symptômes particuliers [Etienne, 2004].

L'extraction de motifs fréquents et

recherche d'association

La technique d'extraction de motifs fréquents

pour l'extraction de règles d'association et de profils

génétiques pour une maladie a bien montré de bons

résultats. Une étude dans ce sens a été faite sur

la cohorte STANISLAS [Maumus et al., 2005], pour la compréhension de

l'athérosclérose et étudier les mécanismes

physiopathologies du syndrome métabolique et déterminer les

facteurs influents. Cette technique a permis

Chapitre I : L'extraction de connaissances

à partir de données biologiques -

19 -

aussi de mettre en évidence la relation entre

un gène en l'occurrence le HLA-DQ impliqué dans les maladies

auto-immunes tel que la maladie coeliaque sur une cohorte de 470 individus

(témoins) de 3 pays européens [Maumus et al., 2005]. Aussi,

l'apprentissage des règles à partir de données d'une

étude épidémiologique « cas-témoins » a

montré une grande utilité pour la compréhension de

certaines maladies telle que le cancer du nasopharynx de 1289 observations.

L'objectif était de connaître les différents facteurs

impliqués dans cette maladie [Benabdeslem et al., 2007].