|

Novembre 2016

Département d'informatique

THESE

Pour l'obtention du

Doctorat

Spécialité :

Informatique

Option : Modèles de

données avancées et réseaux

émergents

Intitulée

Amélioration de la performance de TCP

dans

les réseaux mobiles ad hoc

Présentée par

DOUGA Yassine

Composition du Jury :

KHELFI Med Fayçal Pr., Université d'Oran1

Président

GUEZOURI Mustapha Pr., Université d'Oran1 Examinateur

FERAOUN Md Kamel Pr., Université de Sidi Bel Abbes

Examinateur

BOURENANE Malika MCA, Université d'Oran1 Directeur de

thèse

HADJADJ-AOUL Yassine MCA, Université de Rennes 1 Co

Directeur de thèse

HAFFAF Abdelhafid Pr., Université d'Oran1 Invité

ii

Dédicace

Je dédie ce travail à tous les membres de

ma très chère famille, mes amis et mes collègues, en

particulier :

Mon cher père et ma chère

mère.

Ma très chère femme ainsi que toute sa

famille.

Ma soeur Ahlem.

Mes grands-parents (DADI, MANI et baba

chikh).

Mes cousins (Afaf, Chaouki,

Mohamed).

A tous les membres de la famille El Kerbadji et

surtout Redha.

A tous mes amis (Rachid, Zaki, Hafid, Walid, Ali,

Adel ...)

Et à ma tante Hafidha et ma grand-mère

que je viens de perdre.

DOUGA Yassine.

Remerciements

Je voudrais tout d'abord remercier grandement mon

directeur de thèse, Dr BOURENANE Malika, maitre de

conférences au département d'informatique de l'université

d'Oran1 Ahmed Ben Bella, de m'avoir permis d'effectuer cette thèse dans

de bonnes conditions et de m'avoir témoigné tant de

bienveillance. Je lui adresse mes plus vifs remerciements pour son aide

scientifique, sa contribution, son implication aussi bien dans mes travaux

publiés que dans la rédaction de mon mémoire et pour ses

remarques constructives tout au long de ces années de thèse. Ce

travail n'aurait pas abouti dans les délais sans son soutien, son suivi

pédagogique, son assiduité et sa généreuse

contribution.

Je voudrais remercier aussi mon co-directeur de

thèse, Dr HADJADJ-AOUL Yassine de l'université

de Rennes 1 pour son aide efficace et technique, ses conseils scientifiques et

sa qualité humaine. Toute ma profonde gratitude et ma reconnaissance

vont à mon directeur et à mon co-directeur de

thèse.

Je remercie également Mr MELLOUK

Abdelhamid, Professeur et Mr SOUIHI Sami de

l'université de Paris-est, pour leurs remarques constructives.

Mes remerciements vont à Mr HAFFAF

Hafid, directeur de notre laboratoire LRIIR (université Oran1)

et invité dans mon jury de soutenance, Mr KECHAR Bouabdellah

responsable de l'équipe « Réseaux et

multimédia » au sein du laboratoire LRIIR, Mr KHELFI

Mohamed Fayçal, président de mon jury de soutenance et

Mr BOUAMRANE Karim, chef de département d'informatique

de l'université d'Oran1 pour leurs aides académiques et les

facilités qu'ils ont mis à ma disposition afin que je puisse

arriver à ce stade.

Je remercie également Monsieur GUEZOURI

Mustapha, Professeur à l'université Oran 1 Ahmed Ben

Bella et Monsieur FERAOUN Mohamed Kamel, Professeur à

l'université de Sidi Bel Abbes qui m'ont fait l'honneur de faire parti

de mon jury de soutenance et pour le temps qu'ils ont bien voulu consacrer

à l'évaluation de ce travail.

A tous, mon infinie gratitude....

iv

RÉSUMÉ

De nos jours, le nombre d'utilisateurs mobiles utilisant le

protocole de transport (TCP) sur des réseaux sans fil pour

accéder à des services sur Internet tels que les services de

streaming vidéo via HTTP est en croissance très rapide. A

l'origine le protocole TCP a été conçu pour les

réseaux filaires. Cependant, il souffre de quelques défauts sur

les réseaux sans fil, tels que la dégradation de débit en

raison de pertes aléatoires et de la connectivité intermittente.

Dans cette thèse, un ensemble de techniques sont proposées pour

améliorer les performances du protocole TCP sur les communications sans

fil de bout en bout. L'approche proposée est une solution inter-couches

qui intègre des informations à partir de la couche physique (la

puissance de la force du signal et la valeur de bruit) avec le mécanisme

de contrôle de perte de paquets TCP. La réalisation d'une telle

approche laisse poser des sous problématiques très importantes,

par exemple : sur une connexion multi-sauts, quelle puissance de force du

signal et de bruit nous devons choisir ? Quel seuil faut-il considérer

et comment peut-on estimer la meilleure valeur du RTT ? Les résultats

des simulations effectuées ont prouvé que l'approche

proposée donne de meilleures performances que les autres approches en

matière de débit accompli dans un environnement sans fil.

Dans la suite de notre travail, nous avons choisi d'appliquer

notre première contribution sur les services de vidéo streaming

adaptatif HTTP (HAS) afin d'améliorer la qualité

d'expérience QoE des utilisateurs. Le streaming adaptatif HTTP (HAS) est

une technique de streaming vidéo largement utilisé sur Internet

que ça soit pour la vidéo à la demande (VoD) ou pour les

services de streaming en direct. Elle utilise le protocole TCP en tant que

protocole de transport. Dans ce genre de service, le protocole TCP divise la

vidéo d'origine à l'intérieur du serveur en plusieurs

segments de même durée. Ces segments sont transcodés en

plusieurs niveaux de qualité. Dans cette thèse, nous avons

proposé une approche de vidéo streaming adaptatif qui ajoute le

feedback des utilisateurs ainsi que les paramètres du terminal

(résolution, écran, batterie) au processus d'adaptation de la

qualité vidéo à travers les paramètres du protocole

TCP. Afin d'estimer la satisfaction des utilisateurs, nous avons utilisé

le MOS (Mean Opinion Score) de l'utilisateur. L'approche a été

testée dans des scénarios d'émulations et les

résultats ont montré que l'approche proposée peut

améliorer l'expérience des utilisateurs (satisfaction) sur ce

type de service par rapport aux services de vidéo streaming adaptatif

qui existent.

Mots clés : TCP, Congestion, Force de

signal, Bruit, MANET, Transport, RTT, QoE, QoS, Vidéo streaming,

Terminal d'utilisateur, Multimédia, Apprentissage par renforcement.

v

ABSTRACT

We are currently witnessing a rapidly increasing number of

mobile users utilising the Transmission Control Protocol (TCP) over wireless

networks for accessing Internet services such as video streaming services over

HTTP. TCP has been designed for wireline networks and its shortcomings; such as

throughput degradation due to random losses and intermittent connectivity, have

been the subject of a large volume of research investigations over the last few

years. In this thesis, a set of techniques are proposed to enhance the

performance of the end-to-end wireless communications using TCP as a transport

layer protocol. The proposed set of technique is a Cross-Layer solution that

integrates some information from the link layer as the value of signal strength

and noise with the TCP packet loss control mechanism of TCP connections. In the

design of such a smart transport layer such as on a multi-hop connexion,

important issues are raised such as deciding which value of signal strength and

noise to choose, which threshold we need to set and how to estimate the best

RTT value. Through an extensive series of simulations on the performance of the

proposed techniques while focusing on the variables that affect the experience

of the end-user, the end-to-end throughput that a TCP flow can accomplish was

considered.

As a next step in working on TCP performances over wireless

network, we have chosen to apply our first contribution with the HTTP adaptive

streaming (HAS) to increase the users experience QoE. The HTTP adaptive

streaming (HAS) is a streaming video technique widely used over the Internet

for Video on Demand (VoD) and Live streaming services. It employs Transmission

Control Protocol (TCP) as transport protocol and it splits the original video

inside the server into segments of same duration, called "chunks", that are

transcoded into multiple quality levels. In this thesis, we proposed to

integrate the user feedback and his terminal parameters (i.e. resolution,

screen, battery) on the adaptation process by using the TCP parameters tuning.

To estimate the user satisfaction we used the mean opinion score (MOS) of the

users which is a score out of five points that the user gives to express his

satisfaction towards the proposed set of techniques. Compared to other adaptive

video streaming solutions, the emulation results show the extent to which our

proposed solution can increase the user experience (satisfaction) on this kind

of service.

Keywords: TCP, Congestion, Signal strength,

Noise, MANET, RTT, QoE, QoS, Video streaming, Terminal device, Multimedia,

Reinforcement learning.

vi

TABLE DES MATIERES

DEDICACES ii

REMERCIEMENTS ...iii

RESUME iv

ABSTRACT . .v

TABLE DES MATIERES vi

LISTE DES FIGURES vii

LISTE DES TABLES .viii

LISTE DES ACRONYMES ...ix

PUBLICATIONS ET CONFERENCES ...X

INTRODUCTION GENERALE 1

1. CONTEXTE ET PROBLEMATIQUE DE LA THESE

1

2. CONTRIBUTION ET STRUCTURE DE LA THESE

..3

CHAPITRE I : CONCEPTS DE BASE

|

1. GENERALITES SUR LES RESEAUX SANS FIL

|

...6

|

|

1.1. Introduction

|

6

|

|

1.2. Définition

|

.6

|

|

1.3. Les différentes technologies des réseaux

sans fil

|

7

|

|

1.4. Différents normes de réseaux sans fil

|

8

|

|

1.5. Spécificités des réseaux sans fil

|

.10

|

|

1.5.1. Spécificité physique

|

..10

|

|

1.5.2. Erreur du canal

|

10

|

|

1.5.3. Contention du Médium et collision

|

..11

|

vi

1.5.4. Mobilité 12

1.5.5. Spécificité du routage 13

1.5.6. Congestion 13

1.5.7. Considérations énergétiques 14

1.6. Les réseaux sans fils ad hoc mobiles 14

1.7. Caractéristiques des réseaux ad hoc 15

2. PROTOCOLE DE TRANSPORT 17

2.1. Introduction ..17

2.2. Le protocole TCP 18

2.2.1. Caractéristiques et fonctionnement

général .18

3.FONCTIONS DE CONTROLE DE CONGESTION

3.1. La phase slow-start (démarrage lent) 22

3.2. Congestion avoidance (évitement de congestion)

23

3.3. L'algorithme Additive Increase and Multiplicative

Decrease (AIMD) 23

3.4. La reprise sur erreur . 23

3.4.1. Fast retransmit (retransmission rapide) 24

3.4.2. Fast-recovey (recouvrement rapide) . 24

3.4.3. Selective Acknowledgment (SACK) 24

4.VARIANTES DE TCP 25

4.1. TCP Tahoe 25

4.2. TCP Reno 25

4.3. TCP New Reno 26

4.4. TCP Vegas 26

4.5. TCP Westwood+ 26

4.6. TCP SACK 27

5.TCP ET LES RESEAUX SANS FIL 27

5.1. Problèmes de TCP dans les réseaux ad hoc

mobiles ...28

6.LE PROTOCOLE HTTP 30

7.LES SERVICES DE VIDEO STREAMING ..

32

7.1. Introduction 32

vi

7.2. Le streaming vidéo 32

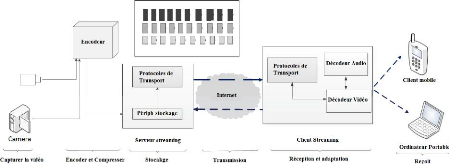

7.3. Le système de streaming multimédia 33

8.LES DIFFERENTES TECHNOLOGIES DE STREAMING

34

8.1. Le streaming en direct et le streaming stocké

34

8.1.1. Streaming adaptatif 35

8.1.2. Le streaming non adaptatif 35

9. Conclusion ..36

CHAPITRE II : ETAT DE L'ART

1.INTRODUCTION . 37

2. LA QUALITE DE SERVICE 37

2.1. Définition 38

3. LA QUALITE D'EXPERIENCE 39

3.1. Définition 39

3.2. Les approches de la QoE 40

3.2.1. Les approches objectives 40

3.2.2.Modèles de planification réseau 41

3.2.2. Approche subjective 41

4.L'APPROCHE CROSS-LAYER .

42

4.1. La conception cross-layer 43

4.2. Approches du cross-layer dans les réseaux sans fil

43

4.3. Les types d'architecture cross-layer 44

4.3.1. Architecture cross-layer à base de

communication directe 44

4.3.2. Architecture Cross-layer à base de communication

indirecte ... 44

4.3.3. Architecture Cross-layer à base de nouvelles

abstractions 44

4.4. Avantages et inconvénients du Cross-layer

[108,109] . 45

5.APPRENTISSAGE DANS LE STREAMING ADAPTATIF

45

5.1. Introduction 45

5.2. Apprentissage par renforcement 46

5.3. Processus de Décision de Markov 46

5.4. Résolution d'un PDM dans l'incertain 47

5.4.1. La stratégie ?-greedy .48

5.4.2. La stratégie de Boltzmann 49

6. PERFORMANCES DU PROTOCOLE TCP DANS LES RESEAUX

SANS FIL AD

HOC 49

6.1. Introduction 49

6.2. Différentes causes de perte de paquets dans les

réseaux sans fil . 50

6.2.1. Problème lié à la puissance du

signal . 50

6.2.2. Problème lié aux interférences

... 50

6.2.3. Autres causes de perte de paquets 51

6.3. TCP et le problème de perte de paquets dans les

réseaux sans fil (impact et performance) 52

6.3.1. La congestion et la perte de paquet dans les

réseaux sans fil 52

6.4. TCP et la qualité de service dans les

réseaux sans fil 53

6.5. Etude comparative des travaux existants . 54

6.5.1. Les solutions inter-couches (Cross-Layer) 54

6.5.2. Les solutions basées sur la couche Transport

60

6.6. Conclusion 62

7. IMPACT DU PROTOCOLE TCP SUR LES SERVICES VIDEO

STREAMING

ADAPTATIFS 63

7.1. TCP et les services de vidéo streaming adaptatif

63

7.2. Protocoles de transport dédiés au streaming

63

7.3. Impact des paramètres de TCP sur la qualité

de service des services de vidéo streaming

adaptatifs 65

7.4. L'enjeu de la qualité d'expérience sur les

services de vidéo streaming adaptatif 65

7.5. Technique d'adaptation du réseau 66

7.5.1. Contrôle de débit basé source 66

7.5.2. Contrôle de débit basé

récepteur 71

7.5.3. Contrôle de débit hybride . 76

vi

8.CONCLUSION ET CRITIQUES 78

vi

CHAPITRE III : APPROCHES POUR L'AMELIORATION DE TCP DANS

UN ENVIRONNEMENT SANS FIL

1.INTRODUCTION . 80

2. CONTRIBUTIONS .. 81

2.1. Première contribution : Proposition d'un

mécanisme inter-couches de différentiation de perte

pour TCP dans les réseaux sans fils ad hoc 81

2.1.1. Positionnement du problème 81

2.1.2. Description de la solution ... 82

2.1.3. Formulation de la solution proposée 83

2.1.4. Récupération de la valeur du RSSI minimal

et du bruit maximal du chemin 84

2.1.5. Organigramme et Algorithme 86

2.1.6. Evaluation par simulations . 87

2.1.7. Conclusion 94

2.2. Deuxième contribution : TCP et

l'amélioration des services de vidéo streaming adaptatifs...

94

2.2.1. Introduction 94

2.2.2. Positionnement du problème 95

2.2.3. Description de la solution 98

2.2.4. Emulation 106

2.2.5. Conclusion 113

Conclusion générale et

perspectives 114

Références Bibliographiques.

VII

Liste de figures

|

Figure1 : Catégories de réseaux

sans fil

|

07

|

|

Figure 2 : Principales normes de réseaux

sans fil

|

08

|

|

Figure3 : Interférence de noeud dans une

topologie en chaine

|

12

|

|

Figure 4 : Réseau ad hoc

|

15

|

|

Figure 5 : Extension de couverture par un

réseau adhoc

|

17

|

|

Figure 6 : Mécanisme de l'acquittement

|

...19

|

|

Figure7 : Etablissement d'une connexion

|

...20

|

|

Figure8: Diagramme d'états

simplifié de TCP

|

21

|

|

Figure 9: Démarrage lent de TCP

|

22

|

|

Figure 10: Variation du débit de TCP avec

la longueur du chemin

|

29

|

|

Figure 11 : Média streaming

...32

|

|

|

Figure12 : Système général

de streaming multimédia

34

|

|

|

Figure 13 : Flux direct adaptatif

|

35

|

|

Figure 14 : QdS/QoE domaines d'application

inspirés de [126]

|

39

|

|

Figure 15 : QdS/QoE couches dans le

modèle OSI

|

...40

|

|

Figure 16 : Quelques types d'interférence

|

51

|

|

Figure 17 : Comparaison des valeurs du

débit filaire et sans fils avec déplacement

|

.53

|

|

Figure 18 : Comparaison des valeurs du

débit filaire et sans fils sous l'effet des

interférences

54

|

|

Figure 19 : Classification des solutions pour

l'amélioration de TCP dans les réseaux

|

sans fil

|

..55

|

|

Figure20 : TCP-Split

|

59

|

|

Figure 21 : Inter-couches (Cross-Layer)

réseau et physique

|

.59

|

|

Figure 22: Architecture 3GPP-DASH

|

74

|

|

Figure 23 : Structure d'un segment TCP

|

82

|

|

Figure 24 : Organigramme de l'architecture

proposée

|

86

|

|

Figure 25 : Topologie de la simulation

|

..89

|

VII

Figure 26 : Résultats de premier

scénario 90

Figure 27 : Résultat du

deuxième scénario ...91

Figure 28 : Résultat du

troisième scénario 92

Figure 29 : Résultats du

quatrième scénario .93

Figure 30 : Vidéo streaming adaptatif

à travers HTTP .96

Figure 31 : Services de vidéo

streaming adaptatif les plus connus ...97

Figure 32 : Accès aux services de

vidéo streaming adaptatif à travers différents types de

technologies avec différents type de terminaux 98

Figure 33 : Datagramme d'un service de

streaming adaptatif 109

Figure 34 : Scénario de

l'émulation 109

Figure 35 : Consommation du forfait Internet

110

Figure 36 : Consommation de la batterie

111

Figure 37 : Consommation de CPU 111

Figure 38 : Le MOS global des utilisateurs

112

Figure 39 : Evolution de la bande passante

disponible dans le temps 112

Figure 40 : Valeur du MOS (MOS*2) par rapport

au temps 113

Figure 41 : Valeur du MOS (MOS*2) par rapport

au temps 1

Figure 42 : Valeur du MOS (MOS*2) par rapport

au temps 2

Figure 43 : Valeur du MOS (MOS*2) par rapport

au temps 4

VIII

LISTE DES TABLES

|

Table 1 : Comparaison générale des

approches

|

62

|

|

Table 2 Comparaison des différentes

approches de vidéo streaming

|

78

|

|

Table 3 : Valeur de FR (facteur de

résolution)

|

99

|

|

Table 4 : Valeur de FS (facteurs d'écran)

|

99

|

|

Table 5 : Valeur de BC (facteur de batterie)

|

99

|

|

Table6 : Les valeurs facteur utilisateur avec

les qualités vidéo

|

..100

|

|

Table 7 : Les qualités vidéo avec

les débits minimaux

|

101

|

|

Table 8 : Pourcentage de récompense par

rapport au MOS

|

104

|

|

Table 9 : Paramètres des terminaux

utilisés dans l'émulation

|

.107

|

|

Table 10 : Paramètres de

l'émulation

|

109

|

LISTE DES ACRONYMES

Wpan : Wireless Personal Area Network

Wlan : Wireless Local Area Network

Wman : Wireless Metropolitan Area Network

Wran : Les réseaux régionaux

Wwan : Wireless Wide Area Network BLR :

Boucle locale radio

WIMAX : Worldwide Interoperability for Microwave

Access

GSM : Global System for Mobile Communication

GPRS : General Packet Radio Service

DVB-S : Digital Video Broadcasting-Satellite

WIFI : Wireless Fidelity UWB :

Ultra-Wide Band

OFDM : Orthogonal Frequency Division

Multiplex

MAC : Media Access Control AP :

Access point

IP : Internet protocol

TCP : Transport control protocol

UDP: User Datagram Protocol

ix

DCCP : Datagram Congestion Control Protocol

SCTP : Stream Control Transmission Protocol

RTO : Retransmit Time Out

RTT : Round trip time

RTTVAR : Variation du RTT

Syn : Paquet de synchronisation

ACK : accusé de réception

CWND : congestion window

HTTP : Hypertext Transfer Protocol

AIMD : Additive Increase and Multiplicative

Decrease

DUPACK : ACK dupliqué

SACK : Selective Acknowledgment

MPEG : Moving Picture Experts Group

QoS : Qualité de service

QoE : Qualitéd'experience

IPTD : IP Packet Transfer Delay

IPDV: IP packet delay variation

IPLR : IP Loss Ratio

IPER : IP Packet Error Rate

IPPT : IP Packet Throughput

MOS : Mean opinion score

OSI : Open SystemsInterconnection RCSF :

Réseaux de Capteurs Sans Fils PDM : processus

de décision de Markov RSSI : Puissance du signal

reçu

DCF : Distrubuted Coordination Function

MANET : Mobile AD-HOC network ICMP : Internet

Control Message Protocol

RRN : Notification de la restauration de la

route

RFN : Notification d'erreur de route BER

: Erreurs de bits

ECN : Explicit Congestion Notification

NDER :

Notification-de-Déconnection-Explicite-de-Route

NP : Noeud-Pivotant RL :

Requête localisée

NRER :

Notification-Réussie-Explicite-de-Route

PRR : Phase de la reconstruction de Route

LACK : Acquittement local

COPAS : COntention-based PAth Selection

DSR : Un protocole de routage

OOO : Livraison Out-Of-Order

ix

TPSN : TCP Packet-Sequence-Number

ADSN : ACK de duplication de numéro de

séquence

RTP : Le protocole de transmission temps

réel

RTSP : Real Time Streaming Protocol NAT

: Network address translation

RTCP : Real-time Transport Control Protocol

MIMD : l'augmentation multiplicative et la

diminution multiplicative

MTP : Multimedia transport protocol

VTP : Protocole de transport vidéo

LDA : L'algorithme de discrimination de perte

AR : le taux d'estimation atteint

SAMM : Source-Adaptive Multilayered Multicast

Algorithms

TFRC : Contrôle de débit avec TCP

Friendly

RLM : Receiver-driven Layered Multicast

LVMR : Layered Video Multicast Retransmission

3G-DASH : Dynamic Adaptive Streaming over

HTTP

PVR : Réseau d'enregistrement

vidéo personnel

CDN : Content delivery network

AEC : Approche de l'environnement

contrôlé

RNN : Réseau de neurone aléatoire

GOP : Un groupe d'images successives

SSM : La puissance du signal minimale de la

route

NMX : La puissance du bruit maximal de la

route

PNMX : La puissance du bruit maximal de la

route prédite

PSSM : La puissance du signal minimale de la

route prédite

NS3 : Network simulator

AODV : Ad hoc On Demand Distance Vector

(protocole de routage)

ix

CSMA/CA : Carrier Sense Multiple Access with

Collision Avoidance

UF : le facteur d'utilisateur

TR : la résolution du terminal

FR : le facteur de résolution

FB : Le facteur de la batterie

BC : La batterie disponible

FS : Le facteur de la taille d'écran

SS : La taille de l'écran

MDP : un processus de décision

markovien

BW : La bande passante

CAS : L'approche YOUTUBE classique

UAS : L'approche proposée

x

Publications et conférences

1) Yassine DOUGA, Malika BOURENANE, Yassine HADJADJ-AOUL,

Abdelhamid MELLOUK: « TCP based-user-parameters control for adaptive video

streaming». Dans le journal international MULTIMEDIA TOOLS AND

APPLICATIONS Springer journal, ISSN: 1380-7501, DOI

10.1007/s11042-015-2857-1,(aout 2015).

2) Yassine DOUGA, Malika BOURENANE: « Simulation of an

Adaptive video streaming based-user control using TCP parameters ». Dans

la Revue Méditerranéenne des Télécommunications,

Vol. 5, No 2 (2015).

3) Yassine DOUGA, Malika BOURENANE: « New adaptation

method of TCP for mobile ad hoc networks ». Dans le proceeding de IEEE

WCCAIS 2014, Computer Applications and Information Systems World Congress,

Tunisie, (janvier 2014).

4) Yassine DOUGA, Malika BOURENANE: « Improve

Performance of TCP over Mobile AdHoc Network using a cross-layer

solution». Dans le journal IJSER, International Journal of Scientific

& Engineering Research, Volume 5, Issue 7, ISSN 2229-5518, ,

(July-2014).

5) Yassine DOUGA, Malika BOURENANE, Abdelhamid MELLOUK:

« Adaptive Video Streaming Using TCP Factors Control with User Parameters

». Dans le proceeding de

Elsevier FNC'14,

|

The 9th International Conference on Future Networks and

|

|

Communication, Volume 34, 2014, Pages 526-531, Niagara Falls,

Canada, (aout 2014).

6) Yassine DOUGA, Malika BOURENANE: « A cross layer

solution to improve TCP performances in Ad Hoc wireless networks». Dans le

proceeding de IEEE SaCoNeT 2013, International Conference of Smart

Communications in Network Technologies France, Paris, (juin 2013).

INTRODUCTION GENERALE

1

Introduction générale

Introduction générale

1. Contexte et problématique de la

thèse

De nos jours, certains protocoles supportant l'Internet sont

les mêmes qu'à l'origine, ils n'ont presque pas changé

[78]. Suivant une structure en couches abstraites, fournissant chacune une

fonctionnalité bien définie [79], la pile protocolaire TCP/IP a

réussi à bien s'adapter aux évolutions des technologies

sous-jacentes. Cependant ces nouvelles technologies ont graduellement

étendu le contexte dans lequel ces protocoles doivent fonctionner.

La réduction en taille et le prix des

équipements informatiques a largement facilité l'apparition de

l'informatique mobile et l'accès simultané à plusieurs

réseaux Figure 41. Ces équipements informatiques tels que

smartphones, tablettes, ordinateurs portables ...etc, sont transportés

au rythme des déplacements de leur utilisateur. Plus récemment,

ces terminaux se sont aussi vus pourvoir de plus d'interfaces réseau

supplémentaires Figure 42. Ainsi, ils peuvent s'adapter aux mouvements

de leur porteur, établir une ou plusieurs connexions à de

multiples réseaux afin d'être « toujours connectés au

mieux » [80].

2015 2016 2017 2018 2019 2020

Billions of devices

30

25

20

15

10

5

0

M2M Smart Phone Non-smartphones TVs PCs Tablets Other

Figure 41 Différents types de terminaux qui

accèdent de nos jours à Internet

2

Introduction générale

Fixed/Wired Mobile Data

Exabyte per month

140

120

100

40

80

60

20

0

2014 2015 2016 2017 2018 2019

Fixed/Wifi From Wifi Only Devices Fixed/Wifi From Wifi

Mobile Devices

19%

21%

42%

Figure 42 Classification du flux de données sur Internet

par technologie d'accès

L'environnement sans fil fondé sur l'utilisation des

liaisons radios est caractérisé par deux modes de communication,

à savoir le mode avec infrastructure où la communication entre

deux points ou noeuds quelconques du réseau passe nécessairement

par une station de base. Ainsi que les réseaux mobiles sans

infrastructure (appelés réseaux ad hoc) où chaque point ou

noeud du réseau peut communiquer directement avec ses voisins, sans

station de base intermédiaire.

Les réseaux ad hoc sont une catégorie de

réseaux sans fil caractérisés entre autres par une

topologie dynamique [16], une bande passante limitée, des contraintes de

consommation d'énergie. Le lien sans fil à la

caractéristique essentielle de varier en fonction du temps et de

l'espace. Il est aussi caractérisé par une mémoire

à courte échelle due au multi trajets pouvant causer une rafale

d'erreurs qui occasionne l'impossibilité de transmettre correctement les

paquets sur le lien. Le changement de l'état du lien sans fil de "bon"

à "mauvais" et vice-versa peut intervenir de façon asynchrone

pendant des laps de temps très courts. En plus de la variation du canal

à petite échelle, il y a une variation à grande

échelle qui implique le conditionnement de l'état moyen du canal

par la position de l'utilisateur et le niveau des interférences

possibles.

Ainsi, la récente prévalence des réseaux

d'accès sans-fil en général et des réseaux ad hoc

en particulier présente de nouveaux problèmes à des

protocoles dont les hypothèses de conception sont basées sur

l'usage d'un média fiable. Par exemple le protocole de transport TCP

classique, souffre d'une mauvaise interprétation des pertes de paquets

dues aux conditions du medium radio et non à des congestions sur le

réseau. Il ne peut cependant

3

Introduction générale

pas distinguer la cause de ces pertes en raison de la

séparation en couches. Cette erreur entraine des baisses de performances

lorsque des réseaux sans fil sont traversés [83].

Le passage des systèmes reposant sur les réseaux

filaires vers les environnements sans fil et la différence notoire qui

existe entre ces deux environnements ont conduit à l'émergence

des systèmes multi-niveaux ou Cross-Layer. Ces systèmes visent

à répondre aux besoins de l'amélioration des performances

qui s'imposent au bénéfice des systèmes sans fil dont par

exemple les réseaux ad hoc. Le concept de « Cross-Layer »

introduit une technique d'adaptation des protocoles au contexte sans fil

à travers le partage d'information entre les couches. Cette technique

permet d'obtenir des gains de performance divers comme démontré

dans plusieurs études [19] [20][21] [23] [24] [25] [26] [27], ce qui

justifie pleinement l'importance des modèles réseaux «

Cross-Layer ».

La technique « Cross-Layer » s'applique à

tous les protocoles de divers niveaux du modèle en couches, tant qu'il

existe des interactions pour lesquelles les performances globales du

système peuvent être améliorées. Un exemple simple

relatif au multimédia illustre l'importance de cette conception

novatrice. La gestion de ressources, l'adaptation et les stratégies de

protection disponibles dans les couches inférieures de la pile du

modèle OSI (PHY, MAC, Réseau, Transport) sont optimisées

sans considérer explicitement les caractéristiques

spécifiques des applications multimédias par exemple, les

algorithmes de flux et de compression ne considèrent pas les

mécanismes fournis par les couches inférieures pour la protection

d'erreur, l'ordonnancement, la gestion de ressource, ainsi de suite.

De nos jours, la plupart des applications sur internet

utilisent le protocole http. Le protocole http est un protocole de couche

application, il utilise le protocole TCP comme protocole de transport de

données. Parmi les applications les plus utilisés et

répondu sur internet on trouve les applications de vidéo

streaming adaptative basé http figure 43.

Les applications multimédia interactives fournissent

des environnements de communication très complets pouvant être

utilisés dans le cadre du travail collaboratif synchrone ou encore dans

un contexte ludique et familial. Cela va de la communication audio et/ou

vidéo jusqu'aux applications partagées...etc. Ces applications,

par leur aspect interactif, requièrent un service de qualité du

système de communication sous-jacent afin de fonctionner correctement.

Au niveau réseau, ce service, varie selon les applications et s'exprime

par exemple en termes de garanties sur le délai de bout en bout, le

débit de transmission ou encore le taux de perte d'information.

Jusque-là, les applications multimédia ont

été largement déployées et supportées sur

les infrastructures filaires telles que la fibre optique comme lien en coeur de

réseau, ou encore la technologie xDSL (Digital Subscriber Line) pour la

distribution finale. De nos jours, le large déploiement et les avantages

que les réseaux sans fil présentent a fait que la plupart des

utilisateurs des applications multimédia accèdent à ce

genre d'application via réseau sans fil. En déployant les

applications multimédia interactives sur de tels réseaux,

4

Introduction générale

de nombreux problèmes apparaissent, tel que la

dégradation de la qualité de la vidéo reçu, les

interruptions de la vidéo, la réception d'une qualité de

vidéo qui n'est pas adéquate avec les exigences des utilisateurs

ou avec les conditions du réseau.

Figure 43 Portion de téléchargement des

données de vidéo streaming sur Internet par

services

2. Contribution et structure de la thèse

Dans cette thèse, nous proposons une nouvelle

architecture inter-couche du protocole TCP. Cette architecture a pour but

d'améliorer les performances du protocole TCP dans les réseaux

sans fil en général et dans les réseaux ad hoc en

particulier. L'idée de cette approche est de faire une interaction entre

les deux couches du modèle OSI. Ces deux couches sont, la couche

physique et la couche transport. Cette interaction va nous permettre

d'améliorer le mécanisme de perte de paquet et de contrôle

de congestion du protocole TCP en se basant sur deux grandeurs de la couche

physique qui sont la puissance de signal et le bruit. A l'aide de ces deux

valeurs, la nouvelle architecture de TCP saura faire la distinction entre les

pertes de paquets dû à la congestion et ceux qui sont dû

à l'environnement sans fil. D'après les résultats obtenus

ceci va garantir un bon fonctionnement du protocole TCP dans les réseaux

sans fil sans perdre en performance. Cette architecture a été

testée sous NS3.

Suite aux travaux sur notre nouvelle architecture et afin de

mieux la perfectionner, nous avons opté pour une nouvelle adaptation qui

vise à améliorer la qualité de service (QdS) du

réseau sans fil et la qualité d'expérience QoE des

utilisateurs pour des applications de vidéo streaming en utilisant les

paramètres de la nouvelle architecture du protocole TCP qu'on a

développé auparavant. Cette amélioration vise à

adapter les

5

Introduction générale

paramètres du réseau qui dépendent

directement du protocole TCP comme la bande passante, la gigue, le

délai, le taux de pertes, avec les différentes

caractéristiques du terminal de l'utilisateur et de son feedback. Les

tests ont été fait avec des émulations, les

résultats sont représentés sous forme de MOS (Mean Opinion

Score) ou le ressenti global des utilisateurs.

Le reste de la thèse est structuré comme suite

Le premier chapitre, fourni des définitions et des

notions de base sur tout ce qui est en relation avec les réseaux sans

fil, le protocole de transport TCP et les services de vidéo streaming

adaptatifs, afin de servir de point de repère pour les lecteurs dans ce

qui suit dans les chapitres suivants.

Le deuxième chapitre, l'état de l'art,

décrit, compare et critique les travaux existants des deux approches. Le

but de ce chapitre est de pointer sur les limites des travaux

précédents et leurs inconvénients.

Dans le troisième chapitre, nous décrivons avec

détails les deux solutions proposées, les formules et les

méthodes utilisées, en plus des algorithmes explicatifs. Ensuite,

nous introduirons l'environnement et les conditions de test (simulation et

émulation) des deux approches, les résultats obtenus et les

critiques qui se rapportent aux résultats.

Enfin nous terminons par une conclusion qui situe nos travaux

et qui fixe nos perspectives.

CHAPITRE I : CONCEPTS DE BASE

6

Chapitre I: Concepts de base

CHAPITRE I CONCEPTS DE BASE

1.

Généralités sur les réseaux

sans fil

2.

Protocole de transport

3.

Fonctions de contrôle de congestion

4.

Variantes de TCP

5.

TCP et les réseaux sans fil

6.

Le protocole http

7.

Les services de vidéo streaming

8.

Les différentes technologies de streaming

9.

Conclusion

1. Généralités sur les

réseaux sans fil

1.1. Introduction

.25 . 27 .. 30 Les

réseaux sans fil sont en plein développement. Conduit par

l'émergence des appareils de communication tels que les

téléphones cellulaires, les ordinateurs portables et par la

flexibilité de leur interface, ce qui permet à un utilisateur de

changer de place tout en restant connecté. Ainsi l'utilisateur transite

d'un environnement restreint vers un environnement ubiquitaire où les

traitements se font à travers plusieurs infrastructures.

1.2. Definition

Les réseaux sans fil sont des réseaux

informatiques ou numériques dont les noeuds sont connectés par

radio. La mobilité et la flexibilité comptent parmi les

principaux avantages des réseaux sans fil. En effet, un utilisateur peut

se connecter à un réseau existant et se déplacer librement

tant qu'il reste sous la couverture radio du réseau. La

flexibilité se traduit par la rapidité de déploiement. Il

existe différents types de réseaux

7

Chapitre I: Concepts de base

sans fil, tels que les réseaux de

téléphonie mobile, les réseaux ad hoc et les

réseaux de capteurs.

1.3. Les différentes technologies des réseaux

sans fil

Aujourd'hui, divers équipements sont accessibles aux

entreprises et au grand public permettant des connexions entre appareils sans

fil. Plusieurs communautés collaborent afin de standardiser les

technologies de ces réseaux, tantôt concurrentes, tantôt

complémentaires. La figure 1 montre une classification des

différentes technologies selon leur portée.

Figure 1 : Catégories de réseaux

sans fil [84]

Où

? WPAN : Les réseaux sans fil personnels (Wireless

Personal Area Network),

sont des réseaux sans fil à très faible

portée (de l'ordre d'une dizaine de mètres). Ils concernent

l'entourage immédiat d'une personne. La principale technologie pour

mettre en oeuvre de tels réseaux est le Bluetooth (proposée par

Ericsson en 1994) pour une portée maximale d'une trentaine de

mètres, elle fournit un taux de transmission radio théorique de 1

Mbit/s.

? WLAN : Les réseaux locaux sans fil (Wireless Local Area

Network)

concernent un environnement plus étendu que les

réseaux personnels comme une maison, une entreprise ou un campus. Ils

sont principalement basés sur la technologie IEEE 802.11 ou sur les

technologies HiperLan 1 et Hiperlan 2 qui offre des taux de transmission radio

théoriques pouvant atteindre 54 Mbit/s. Ces technologies ont une

portée plus importante : 300 mètres en extérieur et 100

mètres à l'intérieur des bâtiments pour IEEE 802.11b

et d'une centaine de mètres pour Hiperlan 2.

? WMAN : Les réseaux métropolitains sans fil

(Wireless Metropolitan Area

Network) sont connus sous le nom de boucle locale radio (BLR).

Ils sont basés sur la

Chapitre I: Concepts de base

norme IEEE 802.16 et visent à couvrir une région

étendue comme une ville (plusieurs kilomètres). La norme la plus

connue est le WiMAX, permettant d'obtenir un taux de transmission radio

théorique de l'ordre de 74Mbit/s sur un rayon de dizaines de

kilomètres.

? WRAN : Les réseaux régionaux sont

étudiés par l'IEEE 802.22. Le rayon de

la cellule peut atteindre 50 kilomètres pour les gammes

de fréquences en dessous de 1 GHz. La distance potentielle du terminal

étant importante, le débit montant est assez limité. En

revanche, sur la bande descendante, 4 Mbit/s sont disponibles. L'application de

base est la télévision interactive ou les jeux vidéo

interactifs.

? WWAN : Les réseaux sans fil étendus (Wireless

Wide Area Network) tirent

profit de l'infrastructure réseau cellulaire pour

fournir à l'utilisateur une connectivité réseau même

en déplacement. Les WWANs regroupent notamment les différents

réseaux téléphoniques de première et

deuxième génération mais également les

réseaux satellitaires. Parmi les technologies des réseaux

cellulaires téléphoniques : GSM (Global System for Mobile

Communication) et GPRS (General Packet Radio Service). Les réseaux

satellites s'appuient sur des normes comme DVB-S (Digital Video

Broadcasting-Satellite).

1.4. Différents normes de réseaux sans

fil

Les principales normes sont IEEE 802.15, pour les petits

réseaux personnels d'une dizaine de mètres de portée, IEEE

802.11, ou Wi-Fi, pour les réseaux WLAN, IEEE 802.16, pour les

réseaux WMAN atteignant plus de dix kilomètres, IEEE 802.22 pour

les WRAN (Wireless Regional Area Network), et IEEE 802.20, pour les

réseaux WWAN qui correspondent aux solutions cellulaires permettant de

recouvrir un pays.

Figure 2 : Principales normes de réseaux

sans fil

8

9

Chapitre I: Concepts de base

Dans le groupe IEEE 802.15, trois sous-groupes normalisent des

gammes de produits en parallèle :

- IEEE 802.15.1, le plus connu, prend en charge la norme

Bluetooth, aujourd'hui largement commercialisée. La version 3.0 utilise

l'interface radio décrite dans IEEE 802.15.3, ce qui procure à

Bluetooth une nouvelle jeunesse, avec un débit de 480 Mbit/s.

- IEEE 802.15.3 définit la norme UWB (Ultra-Wide Band),

qui met en oeuvre une technologie très spéciale,

caractérisée par une puissance d'émission

extrêmement faible, sous le bruit ambiant, mais sur pratiquement

l'ensemble du spectre radio (entre 3,1 et 10,6 GHz). Le débit est de 480

Mbit/s sur une portée de 3 m et décroît à environ

120 Mbit/s à une dizaine de mètres.

- IEEE 802.15.4 s'occupe de la norme ZigBee, qui a pour

objectif de promouvoir une puce offrant un débit relativement faible

mais à un coût très bas. ZigBee est avant tout

normalisé pour le passage des commandes plutôt que des

données.

- 802.11 est une norme établie par l'IEEE. Elle

décrit les couches physiques et MAC d'interfaces Réseau radio et

infra-rouge. Les débits possibles varient entre 1 et 54 Mbit/s suivant

les techniques et les éventuelles extensions de la norme

employées. Les portées prévues sont variantes entre

quelques dizaines et quelques centaines de mètres en fonction de la

vitesse choisie et de l'environnement. Cette norme cible deux contextes

d'utilisation, le mode infrastructure et le mode appelé ad hoc. La norme

originelle de 802.11 date de 1997 et décrit les couches physiques et MAC

pour un débit allant jusqu'à 2 Mbit/s en radio, dans la bande

dès 900 MHz. Des extensions ont été publiées depuis

qui viennent lui ajouter des améliorations et des modes de

fonctionnement plus performants. Les principales extensions sont les suivants

:

- 802.11b ajoute la description d'une couche physique

améliorée proposant des débits de 5.5 et 11 Mbit/s en plus

de ceux déjà supportés.

- 802.11a ajoute des modes encore plus rapides (jusqu'à

54 Mbit/s) en travaillant dans la bande dès 5 GHz, mais en utilisant des

techniques OFDM d'accès au canal.

- 802.11g utilise des techniques OFDM similaires à la

802.11a, mais en restant dans la bande ISM à 2.4 GHz. Les débits

possibles atteignent également les 54 Mbit/s tout en gardant la

compatibilité avec les équipements 802.11b.

- 802.11n augmente la vitesse des réseaux sans fil

local (WLAN), elle améliore la fiabilité et elle étend la

zone de couverture sans fil.

- 802.11e cherche à améliorer 802.11 de

façon à pouvoir donner des garanties de qualité de

service.

10

Chapitre I: Concepts de base

1.5. Spécificités des réseaux sans

fil

L'intégration des technologies sans fil avec les

protocoles classiques des réseaux fixes ne va pas sans poser des

difficultés notamment au niveau de la couche Transport.

Les réseaux sans fil arborent des

spécificités qui les caractérisent par rapport aux

réseaux filaires. Ils sont basés sur une liaison utilisant des

ondes radioélectriques (radio et infrarouges) au lieu des câbles

habituels. Par nature, les communications par ce type de liaison

entraînent un certain nombre de problèmes n'ayant pas

d'équivalent dans le monde filaire.

La propagation du signal radio est un élément

clé de la qualité d'une transmission mais le nombre de

fréquences et de canaux disponibles pour la communication est

limité. Ainsi, lorsque deux noeuds émettent simultanément

sur des bandes de fréquence ou des canaux proches, des

interférences (bruit) seront ressenties sur les communications. De plus,

la distance et l'environnement en général, affectent la

qualité d'une transmission radio en perturbant le signal. Celui-ci

s'atténue en fonction de la distance mais aussi en fonction des

contraintes de l'environnement sans fil.

Les spécificités des réseaux sans fil

représentent des sources d'imperfection qui contribuent à

déformer le signal jusqu'à le rendre inutilisable. Les sections

suivantes s'intéressent aux spécificités des

réseaux sans fil ayant des répercussions sur le protocole de

transport TCP.

1.5.1. Spécificité physique

Le principal problème qui se manifeste au niveau

physique concerne la dégradation du signal due à certaines

causes. En effet, sur un support sans fil, les perturbations issues des

interférences, de l'environnement et du mouvement des noeuds viennent

dégrader le signal original.

Aussi, les caractéristiques du support de communication

tel que débit, délai ou taux de perte dépendent fortement

de l'environnement radio et sont sujettes aux interférences et aux

bruits. Le taux d'erreur de niveau physique peut aller au-delà de trois

fois celui d'un support filaire [94].

1.5.2. Erreur du canal

Les erreurs de bit par rafales peuvent corrompre les paquets

en transmission, conduisant ainsi à la perte des paquets de

données TCP ou des accusés de réception (ACKs). Si

l'émetteur TCP ne peut pas recevoir l'accusé de réception

dans le délai de retransmission (RTO), il réduit

immédiatement sa fenêtre de congestion, régresse sa

retransmission de façon exponentielle, et retransmet le paquet perdu.

Les erreurs de canal

11

Chapitre I: Concepts de base

intermittentes peuvent donc provoquer la réduction de

la taille de la fenêtre de congestion de l'émetteur, ce qui

entraîne un faible débit.

1.5.3. Contention du Médium et collision

Les protocoles d'accès au canal (de niveau 2 dans le

modèle OSI et l'équivalent de la couche liaison dans le

modèle TCP/IP) décrivent l'ensemble des méthodes

permettant de coordonner les accès au support partagé entre

plusieurs stations. Plus spécifiquement, la couche MAC décrit les

règles permettant à une station de transmettre et

d'écouter. Ces règles sont écrites de façon

à remplir un ensemble de services tels que l'équité (dans

l'accès au canal ou dans les ressources utilisées), la

fiabilité, le passage à l'échelle, la qualité de

service et ce en maximisant les débits. Ces protocoles sont critiques

dans un environnement où les stations ne peuvent pas recevoir en

même temps qu'elles émettent et dans lequel le support est

partagé et en diffusion par nature.

Les mécanismes de contrôle d'accès au

support basés sur la contention, tels que le protocole MAC IEEE 802.11

[114], ont été largement étudiés et

incorporés dans de nombreux bancs d'essai pour réseaux sans fil

multi-sauts ad hoc, où les noeuds voisins se disputent le canal sans fil

partagé avant de transmettre. Ces protocoles se sont

avérés affecter significativement les performances de TCP [115,

116, 117]. Lorsque TCP fonctionne sur MAC 802.11, comme il a été

souligné dans [118], le problème de l'instabilité devient

très dramatique. Il est montré que les collisions et le

problème de la station exposée sont deux raisons majeures qui

peuvent empêcher un noeud d'atteindre un autre lorsque les deux noeuds

sont à portée de transmission.

Si un noeud ne peut pas atteindre son noeud adjacent

après plusieurs tentatives, il déclenche alors une

défaillance de la route, ce qui, à son tour provoquera le

démarrage de la découverte de route par le noeud source. Aucun

paquet de données n'est envoyé avant qu'une nouvelle route ne

soit trouvée. Pendant ce processus, TCP invoque les algorithmes de

contrôle de congestion s'il observe un délai d'expiration. Ainsi,

de sérieuses oscillations dans le débit TCP seront donc

observées. En outre, le mécanisme du backoff BEB (Binary

Exponential Backoff) utilisé dans la couche MAC exacerbe cette situation

[116]. En effet, un paquet de données volumineux qui occupe le canal

partagé, diminue la chance d'accès au médium pour un noeud

intermédiaire. Ce dernier marque une attente d'une période de

temps aléatoire et essaye à nouveau. Après plusieurs

essais négatifs, un échec de route est signalé.

TCP peut également rencontrer de sérieux

problèmes d'iniquité [115, 116, 118] pour les raisons

indiquées ci-dessous:

- La topologie peut provoquer une iniquité en raison de

l'inégalité des chances d'accès au canal pour les

différents noeuds. En effet, comme indiquée dans la figure 3

où le cercle en bleu dénote une portée de transmission

valide d'un noeud et le cercle en rouge

12

Chapitre I: Concepts de base

une portée d'interférence d'un noeud, les noeuds

dans cette topologie en chaine de 7 noeuds subissent différents

degré de compétitions. Soient deux flux TCP, dont TCP flow 1 est

envoyé du noeud 0 vers le noeud 1 et TCP flow 2 du noeud 6 vers le noeud

2. La transmission du flux 1 subit l'interférence de 3 noeuds (les

noeuds 1, 2 et 3) alors que la transmission du noeud 3 vers le noeud 2 subit

l'interférence de 5 noeuds (les noeuds 0, 1, 2, 4 et 5). Ainsi, le flux

1 obtient un débit beaucoup plus élevé que le flux 2 en

raison de l'inégalité des chances d'accès au canal.

- Le mécanisme du backoff peut conduire à une

situation d'iniquité car il favorise toujours le dernier noeud qui a

émis avec succès.

- La longueur des flux TCP influence l'iniquité. En

effet, Des flux plus grands conduisent à un temps aller-retour (RTT)

plus long et une probabilité de rejet des paquets plus grande entrainant

ainsi une baisse et une fluctuation du débit TCP de bout en bout.

L'iniquité est amplifiée à travers cette réaction

en chaine. Ainsi, un haut débit sera plus élevé alors

qu'un débit faible subira encore une baisse.

Figure 3 : Interférence de noeud dans une

topologie en chaine

1.5.4. Mobilité

La mobilité peut provoquer la rupture de lien et

l'échec de l'itinéraire entre deux noeuds voisins, ce qui peut

entrainer alternativement des pertes de paquets. Comme TCP ne distingue pas

entre les pertes de paquets causées par les défaillances de

routes et celles en raison d'une congestion, il déclenche les

mécanismes de contrôle de congestion qui réagissent

négativement. En effet, si la découverte d'un nouvel

itinéraire prend plus de temps qu'un RTO, l'émetteur TCP invoque

un contrôle de congestion et le débit déjà

13

Chapitre I: Concepts de base

réduit en raison des pertes va encore diminuer. Il

pourrait être encore pire lorsque la source et la destination d'une

connexion TCP se situent dans différentes partitions du réseau.

Dans un tel cas, plusieurs expirations RTO consécutives conduisent

à une inactivité durant une ou deux minutes, même si

l'expéditeur et le récepteur se reconnectent finalement.

Les auteurs Fu et al. ont effectué des simulations en

tenant compte de la mobilité, de l'erreur du canal, et de la contention

du média partagé [116]. Ils ont indiqué que les

déconnexions et reconnexions réseau induites par la

mobilité ont un impact plus significatif sur la performance de TCP

comparées aux erreurs du canal et aux contentions du média

partagé. Lorsque la mobilité augmente, par rapport à un

TCP de référence, TCP New Reno souffre d'une chute relative de

débit allant de presque 0% dans un cas statique à 90% dans un cas

fortement mobile (lorsque la vitesse de déplacement est de 20m/s). En

revanche, une congestion et une légère erreur de canal (soit 1%)

ont un effet moins visible sur TCP (avec moins de 10% de baisse de performance

par rapport au TCP de référence).

1.5.5. Spécificité du routage

Le routage est un élément essentiel pour la

communication entre les noeuds éloignés. Cependant, la

mobilité et la dynamicité de la topologie rendent sa

réalisation complexe. En effet, cette mobilité va augmenter les

problèmes de propagation du signal dans la mesure où un noeud

mobile va voir évoluer les conditions de propagation du milieu qui

l'entoure en fonction de sa position. Le signal s'atténue donc avec

l'éloignement et les noeuds ne peuvent communiquer qu'avec leurs voisins

proches.

Les routes sont de courte durée en raison des ruptures

fréquentes de liens. Pour réduire les retards dus à la

découverte d'une nouvelle route, certains protocoles de routage tels que

l'algorithme de routage temporellement ordonné (Temporally-Ordered

Routing Algorithm : TORA) [119, 120] maintiennent plusieurs itinéraires

entre une paire émetteur-récepteur et utilisent un routage

multi-chemin pour transmettre les paquets. Dans un tel cas, les paquets

provenant de chemins différents peuvent ne pas arriver dans l'ordre au

niveau du récepteur. Ignorant le routage multi-chemin, le

récepteur TCP interprétera cette situation comme une congestion.

Le récepteur va donc générer des ACKs dupliqués qui

amènent l'expéditeur à invoquer des algorithmes de

contrôle de congestion tels que la retransmission rapide ou fast

retransmission (dès la réception de 3 ACK dupliqués).

1.5.6. Congestion

Il est connu que TCP est un protocole de la couche transport

agressif. Ses tentatives d'utiliser pleinement la bande passante entrainent les

réseaux ad hoc facilement vers la congestion. En outre, en raison de

nombreux facteurs tels que le changement de route et le délai variable

imprévisible de MAC, la relation entre la taille de la fenêtre de

congestion et

14

Chapitre I: Concepts de base

le débit de données tolérable pour une

route n'est plus maintenue dans les réseaux ad hoc. La taille de la

fenêtre de congestion calculée pour l'ancienne route peut

être trop grande pour la route nouvellement trouvé,

entraînant ainsi une congestion du réseau si l'émetteur

transmet toujours à taux plein, autorisé par l'ancienne taille de

la fenêtre de congestion.

La congestion et la surcharge peuvent donner lieu à un

débordement du buffer et à une augmentation de contention de

lien, ce qui dégrade les performances de TCP.

1.5.7. Considérations

énergétiques

Malgré l'essor dans l'équipement à

connexion sans fil de plus en plus miniaturisé, la capacité finie

de la batterie est toujours l'une des plus grandes limitations de ces

appareils. Dans les réseaux sans fil, la consommation de

l'énergie est observée au niveau communication, dans l'envoi et

le contrôle des données et au niveau traitement qui concerne les

aspects de traitement de protocole.

Comme la puissance des noeuds mobiles est limitée, tout

système efficace doit être conçu pour être

économe en énergie. Dans certains scénarios où la

recharge de la batterie n'est pas autorisée, l'efficacité

énergétique est critique pour prolonger la durée de vie du

réseau. La recherche sur TCP dans les réseaux ad hoc a besoin de

trouver un équilibre entre la consommation d'énergie et une

session à haut débit. Pour contourner cette limitation

énergétique, des mesures d'optimisation doivent être prises

au niveau matériel et logiciel.

Dans la suite, nous allons mettre l'accent sur quelques

éléments essentiels caractérisant les réseaux

locaux sans fil en particulier les réseaux ad hoc mobiles.

Dans ces réseaux, les communications entre

équipements terminaux peuvent s'effectuer par le biais de stations de

base ou directement. Dans le premier mode, appelé mode infrastructure,

le réseau s'organise autour d'une topologie en étoile où

le point central appelé point d'accès (AP : Access Point)

coordonne l'utilisation du support. Le point d'accès joue souvent le

rôle de passerelle vers un réseau filaire, voire vers Internet.

Dans le second mode d'utilisation appelé ad hoc, les noeuds ne

s'appuient plus sur un noeud central pour communiquer. Toutes communications

entre ces noeuds se fait directement sans intermédiaire.

L'intérêt de ce mode réside dans la possibilité de

communiquer en l'absence d'infrastructure.

1.6. Les réseaux sans fils ad hoc mobiles

Une autre grande catégorie de réseaux sans fil

est constituée par les réseaux ad hoc, dans lesquels

l'infrastructure n'est composée que des stations elles-mêmes. Ces

dernières acceptent de jouer le rôle de routeur pour permettre le

passage de l'information d'un

15

Chapitre I: Concepts de base

terminal vers un autre, sans que ces terminaux soient

reliés directement. Les réseaux ad hoc peuvent être

déployé dans tout environnement difficile où le

déploiement d'une infrastructure réseau filaire est très

contraignant, soit parce qu'il est difficile à mettre en place, soit

parce que l'existence du réseau ne dure pas assez longtemps pour

justifier une installation par câblage. De tels réseaux,

dépourvus de toute infrastructure, trouvent de nombreux champs

d'applications : lors d'une compagne militaire, d'une situation de catastrophe

(tremblement de terre, désastre naturel, etc), d'une urgence, d'une

salle de conférence, ou encore dans le cadre des réseaux de

senseurs/capteurs (sensor networks). La figure 4 illustre la notion de

réseau ad-hoc:

Figure 4 : Réseau ad hoc

1.7. Caractéristiques des réseaux ad hoc

Les réseaux ad hoc sont caractérisés par

des propriétés particulières. Chaque

propriété est considérée dans la littérature

comme étant une problématique en soi. Nous présentons dans

ce qui suit ces propriétés :

? L'absence de l'infrastructure : les

réseaux ad hoc se distinguent des autres

réseaux mobiles par l'absence de l'infrastructure fixe et

par leurs contrôles décentralisés.

? Les topologies dynamiques : les noeuds sont

libres de se déplacer

aléatoirement, alors la topologie du réseau

précisément le multi-saut peut changer d'une façon brusque

et rapide, et peut être constituée de liaisons unidirectionnelles

et bidirectionnelles en même temps.

? La bande passante limitée et des liens à

débits variables : les liens sans fil

posséderont toujours une capacité inférieure

à leurs homologues câblés. L'utilisation des

16

Chapitre I: Concepts de base

méthodes de partage du canal radio (accès

multiple) influence directement la bande passante réservée

à un terminal ad hoc.

? Utilisation limitée de l'énergie

: l'alimentation des noeuds se reposent sur des

batteries ou d'autres sources d'énergie

limitées. Cette alimentation limitée demande de prendre en

considération l'optimisation de la conservation de l'énergie.

? Sécurité physique limitée

: les réseaux sans fil mobiles sont

généralement

plus vulnérables à des attaques que les

réseaux câblés fixes. En effet, la sécurité

est nécessaire à la démocratisation des réseaux

MANET.

? Qualité des liaisons variables :

à cause du bruit et des interférences entre les

noeuds, la qualité des liaisons peut varier.

La solution développée pour les réseaux

ad-hoc prend pour fondement l'environnement IP. Les mobiles qui jouent le

rôle de passerelles (le plus souvent l'ensemble des mobiles)

implémentent un routeur dans leurs circuits, de telle sorte que les

problèmes posés reviennent essentiellement à des

problèmes de routage dans Internet, la mobilité étant

gérée par le protocole IP Mobile. MANET (Mobile Ad-hoc

NETwork) [95] est un groupe de travail de l'IETF (Internet Engineering

Task Force) [96] qui se préoccupe de la spécification et de

la normalisation des protocoles de routage pour les réseaux ad-hoc au

niveau IP. Ce groupe s'est appuyé sur les protocoles classiques

d'Internet et les a perfectionné pour qu'ils puissent fonctionner avec

des routeurs mobiles.

Les réseaux ad-hoc posent de nombreux problèmes

du fait de la mobilité des noeuds. Ceci résulte en une topologie

changeante dans le temps d'une manière imprévisible. D'autre

part, la portée des transmissions radio étant limitée les

noeuds formant le réseau ad hoc doivent se relayer par un protocole de

routage dédié pour retransmettre les messages d'une source vers

une destination.

Les protocoles de routage doivent prendre en compte les

caractéristiques de ces réseaux mobiles, multi-sauts et sans fil.

Les difficultés de conception sont principalement liées (i) aux

caractéristiques spécifiques des liens sans fil et (ii) aux

changements fréquents de topologie dus à la mobilité.

Les protocoles de routage des réseaux ad hoc s'appuient

sur trois modèles de fonctionnement : les protocoles proactifs, les

protocoles réactifs et les protocoles hybrides. On peut les

différencier par la méthode utilisée pour découvrir

le chemin entre le noeud source et le noeud destination.

Les protocoles proactifs établissent et mettent

à jour les routes pour tous les noeuds du réseau en se basant sur

l'échange périodique d'information de routage. Dans le cas des

protocoles réactifs les routes sont établies uniquement à

la demande. En effet, une procédure de découverte de route est

déclenchée lorsqu'un noeud souhaite envoyer des paquets vers un

destinataire dont la route est inconnue. Les protocoles hybrides quant

à

17

Chapitre I: Concepts de base

eux, combinent les techniques des protocoles proactifs et

réactifs. Ils utilisent un protocole proactif, pour apprendre le proche

voisinage. Au-delà de cette zone prédéfinie, le protocole

hybride fait appel aux techniques des protocoles réactifs pour la

recherche des routes.

Les réseaux ad-hoc sont utiles dans de nombreux cas de

figure. Ils permettent de mettre en place des réseaux dans un laps de

temps restreint, en cas, par exemple, de tremblement de terre ou pour un

meeting avec un très grand nombre de participants. Une autre

possibilité est d'étendre l'accès à une cellule

d'un réseau sans fil comme Wi-Fi. Comme illustré à la

figure 5, un terminal situé hors d'une cellule peut se connecter

à une machine d'un autre utilisateur se trouvant dans la zone de

couverture de la cellule. Ce dernier sert de routeur intermédiaire pour

accéder à l'antenne de la cellule.

Figure 5 : Extension de couverture par un

réseau ad hoc

3. Protocole de transport

2.1. Introduction

La fonctionnalité principale de la couche transport est

le transfert de l'émetteur vers le récepteur, des données

de bout-en bout de manière fiable et économique. Elle permet

d'isoler les niveaux supérieurs des variations technologiques et des

imperfections des couches inférieures. Pour cela, elle emploie des

protocoles de transport qui utilise les services de la couche réseau

(IP) pour assurer l'acheminement des données. Les protocoles largement

déployés dans les réseaux IP sont : TCP (Transmission

Control Protocol), UDP (User Datagram Protocol), les protocoles DCCP (Datagram

Congestion Control Protocol) et SCTP (Stream Control Transmission Protocol).

Etant donné que notre intérêt porte sur

l'amélioration de TCP dans les réseaux ad hoc, nous nous

focalisons sur sa description en donnant ces caractéristiques dans les

réseaux filaires pour lesquels il a été conçu et

nous étudions son comportement dans les réseaux sans fil.

18

Chapitre I: Concepts de base

2.2. Le protocole TCP

Le protocole de contrôle de transmission TCP a

été défini pour fournir un service de transfert de

données fiable entre deux applications sur des stations distantes

raccordées par un réseau à commutation de paquets

utilisant le protocole IP (Internet Protocol). La fiabilité du transfert

est obtenue par différents mécanismes tels que

l'établissement de connexion, la gestion de timers de retransmissions ou

encore le contrôle de la fenêtre de retransmissions. La

spécification initiale, définie dans le Request For Comments RFC

793 de 1981 [97] a fait l'objet de nombreux travaux qui ont conduit à

des améliorations de la spécification initiale.

Dans la pratique, la plupart des déploiements du

protocole TCPont été soigneusement conçus dans le contexte

des réseaux câblés. Dans un environnement ad hoc

l'implémentation de TCP peut conduire à des performances

médiocres dues aux propriétés intrinsèques des

réseaux sans fil. Des études récentes de métrologie

rapportent que TCP est non seulement utilisé pour le transport de

données, mais est également utilisé pour le transport des

flux «streaming» [98].

2.2.1. Caractéristiques et fonctionnement

général

TCP est un protocole de transport de bout-en-bout,

fonctionnant en mode orienté connexion dont l'objectif est de

transmettre de manière fiable des données applicatives entre deux

utilisateurs. Le terme orienté connexion signifie que deux machines

souhaitant communiquer via TCP doivent commencer par établir une

connexion avant de pouvoir dialoguer. Une fois la connexion établie, les

deux extrémités de la connexion peuvent communiquer de

manière bidirectionnelle (full-duplex).

Outre le mode orienté connexion et la fiabilité,

les principales fonctionnalités de TCP sont :

Ordre : TCP assure, par utilisation des

numéros de séquence de paquets et des tampons de

réception, que les paquets arrivent dans le même ordre que celui

de leur émission.

Contrôle de congestion : des

mécanismes de contrôle de congestion (slow-start, Congestion

Avoidance, Fast Retransmit, Fast Recovery [21]) permettent d'éviter

l'engorgement du réseau lorsque ce dernier est saturé et

d'augmenter le débit de transmission lorsque le réseau est

faiblement chargé. En fait, le contrôle de congestion assure une

corrélation entre le débit d'émission et le débit

disponible sur le réseau tout en garantissant une certaine

équité pour le partage de ce débit entre plusieurs flux

TCP.

Contrôle de flux : TCP utilise un

mécanisme de fenêtre d'émission glissante dynamique pour

contrôler le débit de transmission de l'émetteur. Le

débit d'une connexion est donc directement lié à la taille

de sa fenêtre, cette dernière représentant la

quantité d'information pouvant être émise. Ce

mécanisme est également utilisé pour le

19

Chapitre I: Concepts de base

contrôle de congestion. N'ayant pas ou peu

d'informations sur la teneur du réseau emprunté, notamment en

termes de type de liens, de débit disponible ou de congestion

éventuelle, TCP ne peut compter que sur les événements

qu'il interprète comme des notifications de congestion pour

établir le débit de la connexion et assurer aux utilisateurs le

meilleur débit instantané possible.

Transfert de flux d'octets de données

: TCP découpe les flux d'octets de données de

l'application en segments dont la taille est en fonction de la fenêtre

glissante. Les segments seront ensuite réassemblés par le

récepteur afin de reformer un flux d'octets qu'il fournira à

l'application destinataire.

Contrôle d'erreur sur bit : TCP

intègre un mécanisme de checksum sur 16 bits pour couvrir les

erreurs sur bit de l'entête et des données.

2.2.1.1. Mécanisme de l'acquittement

Les acquittements sont utilisés pour fiabiliser la

communication. En effet, chaque segment émis dans un flux TCP sera

acquitté par le récepteur. Dans certaines conditions, les

acquittements ne parviennent pas à l'émetteur. Dans ces cas et

après un délai d'attente fixé, chaque segment émis

mais non acquittés et donc considérés comme perdu est

alors réémis. Le délai d'attente ou RTO (Retransmit Time

Out) est enclenché à l'établissement de la connexion et

remis à zéro chaque fois que la transmission d'un segment est

correctement validée. Il est calibré en fonction du délai

d'aller-retour entre l'émetteur et le récepteur noté RTT

(Round Trip Time). Le RTT est lui-même mesuré grâce aux

temps de réception des acquittements. La figure 6 représente le

mécanisme d'acquittement.

Sachant que la perte d'un segment est

généralement due à une congestion sur le réseau,

les acquittements servent également à réguler le

débit d'émission des sources TCP.

Figure 6 : Mécanisme de l'acquittement

Le délai d'aller-retour (RTT) est mesuré

grâce aux temps d'émission des segments et de réception de

leur acquittement. Le TCP utilise le RTT pour calculer le RTO en

Chapitre I: Concepts de base

utilisant l'algorithme de V. Jacobson [98]. Cet algorithme

fournit une valeur lissée du RTT en effectuant une moyenne

pondérée de la valeur actuelle du RTT lissé et de la

dernière mesure du RTT instantané. Il permet également de

calculer un indice de variation du RTT (RTTVAR). Chaque évaluation du

RTT et de sa variation donne lieu à la mise à jour du RTO

[99].

2.2.1.2. La connexion

Entre l'établissement et la fermeture de la connexion,

le mode opératoire de TCP est séparé en deux états

principaux permettant d'assurer le contrôle de flux et de congestion :

- Le début de connexion.

- L'état stable (le TCP fonctionne correctement).

L'établissement d'une connexion TCP s'effectue en trois

phases (figure 7) :

- L'établissement de la connexion

- Le transfert de données

- La fin de la connexion

20

Figure 7 : Etablissement d'une connexion

Où :

- SYN est un paquet de demande de

synchronisation ou établissement de

connexion

- ACK (acknowledment) signale que le paquet est

bien reçu

- SYN-ACK (synchronize,

acknowledge) paquet envoyé par le récepteur.

21

Chapitre I: Concepts de base

La Figure 8 est une représentation simplifiée du

diagramme d'états de TCP insistant sur les changements d'états

qui ont lieu entre l'ouverture et la fermeture d'une connexion.

Figure 8 : Diagramme d'états

simplifié de TCP

3. Fonctions de contrôle de congestion

Le contrôle de congestion est un mécanisme qui

permet de régir le débit d'un ou de plusieurs flux. Ce

mécanisme vise généralement à répondre aux

trois exigences suivantes :

? Maximiser l'utilisation de la bande passante.

? Limiter le nombre de paquets perdus, c'est-à-dire ne pas

dépasser les capacités

des ressources du réseau.

? Partager équitablement la bande passante entre les

différents flux parcourant le

ou les liens les plus lents.

Ce contrôle est implémenté à l'aide

d'une variable (cwnd) nommée « congestion window » ou

fenêtre de congestion. Concrètement, le nombre maximum de segments

de données que l'émetteur peut envoyer avant d'en recevoir le

premier acquittement est le minimum entre cette variable (cwnd) et la taille de

la fenêtre annoncée par le récepteur à chaque

acquittement de paquet. Le contenu de cette variable est piloté par les

algorithmes de départ lent (slow start) et d'évitement de

congestion (congestion avoidance). La limite de croissance de la variable cwnd

est la taille de la fenêtre annoncée par le récepteur. Une

fois la capacité de débit maximale atteinte, si un paquet est

perdu, l'algorithme d'évitement

22

Chapitre I: Concepts de base

de congestion diminue linéairement la valeur de cwnd

(contrairement au slow start qui l'augmente exponentiellement).

Dans ce paragraphe nous allons décrire le

mécanisme sur lequel repose le contrôle de congestion des

différentes versions de TCP.

3.1. La phase slow-start (démarrage lent)

La phase de démarrage lent, ou slow-start est

utilisée quand le TCP ignore quelle est la bande passante disponible au

démarrage de la session, ou lorsque les conditions du réseau

semblent avoir grandement changé forçant à

redécouvrir la nouvelle bande passante disponible.TCP utilise ce

mécanisme pour sonder le réseau : il commence par émettre

une petite quantité de données puis augmente rapidement sa

capacité d'émission jusqu'à la détection d'un

événement de congestion ou au dépassement d'une variable

appelée slow-startthreshold (ssthresh), qui détermine si la

connexion doit continuer en slow-start ou passer à l'état

stable.

Durant le slow-start, l'émetteur commencera par

émettre le contenu de la fenêtre de congestion cwnd, dont la

taille est communément fixée à 3 segments par la RFC 3390

[29] et attend l'acquittement. Une fois l'acquittement reçu,

l'émetteur peut alors doubler le nombre de segments et attendre les

acquittements. Ce comportement se traduit par une croissance exponentielle de

la fenêtre de congestion qui double pour chaque délai

aller-retour, ou RTT jusqu'à trouver la limite de congestion du

réseau. Une fois cette limite atteinte, des segments commencent à

se perdre et l'émission reprend avec une fenêtre de congestion

à 1. TCP quitte alors la phase de slow-start pour passer en mode

d'évitement de congestion et divise par deux la fenêtre de

congestion. La figure suivante (figure 9) illustre la phase du slow-start:

Figure 9 : Démarrage lent de TCP

Le slow-start permet ainsi d'éviter une surcharge du

réseau qui serait préjudiciable non seulement à la

performance individuelle de la connexion mais également à la

23

Chapitre I: Concepts de base

performance collective du réseau. Cependant, il n'en

reste pas moins trop conservateur dans le cas des transmissions de connexions

courtes et inadapté aux réseaux à long RTT de par sa

dépendance directe à ce paramètre. Par exemple, la

transmission d'une connexion de 10 segments, représentative des objets

HTTP, nécessitera au minimum 3 RTTs et donc plus d'1.5 secondes dans un

environnement satellitaire.

3.2. Congestion avoidance (évitement de

congestion)

La phase d'évitement de congestion est utilisée

quand le flux connaît approximativement quel est le débit

disponible. Celui-ci est estimé à la valeur du débit