|

Année Académique 2011 - 2012

Page | 0

REPUBLIQUE DEMOCRATIQUE DU CONGO

MINISTERE DE L'ENSEIGNEMENT SUPERIEUR ET

UNIVERSITAIRE

Ecole Supérieure des Métiers d'Informatique et

de Commerce

« ESMICOM »

N°MINESU/CABMIN/123/2005

BP.15.835

KINSHASA/LINGWALA

Orientation : RESEAU ET TECHNIQUE DE

MAINTENANCE

STRATEGIE DE STORAGE NAS ET DE TECHNIQUE DE

MAINTENANCE D'UN PARC INFORMATIQUE

ETUDE SUR LA MISE EN OEUVRE COMPLETE D'UNE

DIMBA NKUNKU Reddy

Travail de fin de cycle

Présenté et défendu en vue de l'obtention du

grade de gradué en Informatique

Option : Réseaux et technique de

maintenance Directeur : LUKELE KALUNGA

Ingénieur en informatique appliquée

Page | 1

INTRODUCTION GENERALE

1. Présentation du sujet

Si les premiers ordinateurs sont apparus après la

seconde guerre mondiale, leur conception héritait de diverses

expériences comme l'ENIAC, le Z3 ou le Colossus du service de

cryptanalyse britannique, ainsi que de théories comme la "machine de

Turing", ou de techniques bien plus anciennes comme les premières

machines à calculer mécaniques (XVIIe siècle) et les

premières machines à tisser automatisées par la lecture de

cartes et de rubans perforés (XVIIIe siècle).

Les premiers instruments de calcul utilisent des techniques

naturelles. Par exemple l'utilisation de petits cailloux où chaque

caillou représente un objet ou un ensemble d'objets. Le mot calcul

dérive d'ailleurs de calculus, mot latin pour caillou. Ou alors

l'utilisation des doigts de la main pour calculer en base 5.

Plus formelles, les tables de calcul. Le plus ancien appareil

à calculer est une table de marbre trouvée sur dans l'île

de Saramine. La table est striée de manière verticale et

horizontale. On place des cailloux ou des pièces et de leur position

dépend leur valeur.

C'est un des ancêtres des bouliers, qui ont

survécu jusqu'à maintenant (ou presque !). Expliquer le principe

des bouliers. Le boulier est toujours très utilisé en Asie et au

Japon. En novembre 1946, une compétition a eu lieu entre un

employé du service des communications du Japon muni d'un boulier et un

G.I. muni d'une calculatrice moderne de l'époque (avec les 4 signes

mathématiques). Dans un concours de vitesse, c'est le boulier qui a

gagné.

Jusqu'au XVIIe siècle, rien d'intéressant dans

les machines à calculer. Neper (mathématicien Écossais)

invente un jeu de réglettes (les « bâtons de Neper »)

qui permet de faire des multiplications.

En 1642, la Pascaline. Blaise Pascal (19 ans) réalise

la première machine à calculer qui permet de faire des additions

et des soustractions (avec un engrenage on peut faire une retenue). Mais aucun

succès, même amélioré (ajout des multiplications)

par Leibniz 50 ans plus tard.

Jusqu'au XIXe, des machines à calculer sont

inventées par plusieurs scientifiques (De Poleni, Caze, Lépine,

Hileron De Boistissandeau), mais restent sur les principes des machines du

XVIIe siècle.

Page | 2

2. Intérêt et choix du sujet

L'étude sur la mise en oeuvre complète d'une

stratégie de storage NAS et de technique de maintenance d'un parc

informatique, est un sujet d'actualité ayant un grande apport dans la

société vue la performance du parc informatique, voilà

pourquoi nous avons opté pour ce sujet.

3. Problématique

La problématique majeure pour le développement

de ce sujet se présente de la manière suivante :

Le problème de mise à jour, la

sécurité du réseau et des informations transitant sur le

réseau n'est efficace que s'il est très

régulièrement (quotidiennement) mis à jour.

? Pourquoi la maintenance d'un parc informatique est-il

indispensable?

? Qu'entendez-vous par une stratégie de Storage NAS ? ?

Quels sont les critères pour réaliser la

télémaintenance?

Tels sont les questions que nous essayerons de

répondre.

4. Hypothèse

Le parc informatique d'une organisation est un assemblage,

parfois l'ensemble des disciplines scientifiques et technique applicables au

traitement de l'information effectué notamment par des moyens

automatique. Hétéroclite de matériels et de logiciels

accumulés tout au long des années. Un serveur offre une grande

capacité de stockage et possède plus de mémoire vive est

un processeur plus rapide que ceux d'un PC hôte type fournit des

applications et des données aux ordinateurs hôtes et assure des

services réseau, dont le système qui garde une trace des noms de

domaine.

Tout travail scientifique nécessite une méthode

de travail, en choisissant ce sujet nous avons utilisé :

5. Méthode et technique

Page | 3

? Méthode documentaire puisque nous nous sommes

appuyées sur des documentations qui, nous à servie et enrichie

notre travail.

? La cybernétique qui nous a servis à avoir des

données ressente en rapport avec notre travail.

6. Délimitation d'un travail

Un travail scientifique est délimité dans le temps

et dans l'espace.

Dans le temps la période de recherche est comprise de

l'intervalle du 20 Février au 25 Août 2012.

Dans l'espace nous, nous somme concentrer sur « Etude

sur la mise en oeuvre complète d'une stratégie de Storage NAS et

de technique de maintenance d'un parc informatique ».

7. Planification

Le détail des chapitre qui constitué ce travail

:

? Chapitre I : La structure d'un PC ;

? Chapitre II : La théorie sur le parc informatique ; ?

Chapitre III : Les techniques de sauvegarde.

Page | 4

CHAPITRE I. LA STRUCTURE D'UN PC

I.1. Définition

L'informatique est l'ensemble des disciplines scientifiques et

technique applicables au traitement de l'information effectué notamment

par des moyens automatiques.

Le mot informatique vient de la contraction des deux mots :

Information et Automatique.

Nous appelons information tout ensemble de données. On

distingue généralement des différents types d'informations

: Textes, nombres, sons, images, etc.

I.2.ORDINATEUR1

Un ordinateur est une machine de traitement de l'information

d'une manière automatique. Il est capable d'acquérir de

l'information, de la stocker, de la transformer en effectuant des traitements

quelconques, puis de la restituer sous une autre forme.

Un PC est constitué d'un certain nombre des composants

assemblés dans un boitier auquel sont reliés des accessoires

appelés périphériques.

I.2.1.Standards de micro-ordinateurs

Le micro-ordinateur (ordinateur d'entreprise muni d'une

unité centrale à laquelle sont connectes plusieurs écrans

terminaux qui peuvent en être très éloignés) a

été rapidement remplacé par les micro-ordinateurs

dès qu'ils ont acquis de grandes capacités mémorielles et

la possibilité d'être connectés en réseau.

Micro-ordinateur est un ordinateur personnel, à un seul

écran en général. Il peut être portable (de

dimensions de plus en plus réduites et de plus en plus performant) ou

non.

(1) Pierre Alain-goupille, Technologie des

ordinateurs et des réseaux, éd. Masson, P.38

Page | 5

Il ne reste actuellement que deux grands standards de

Micro-

ordinateurs :

Les PC compatibles appelés ainsi pour leur

compatibilité avec le standards IBM. Très nombreuses marques

(IBM, Compaq, Dell, etc.) et nombreux « clones » (copies

fabriquées le plus souvent dans le sud-est asiatique) donc sont des

ordinateur qui n'a pas de marque encouragés par IBM pour établir

la suprématie de son standards

Les ordinateurs Apple avec notamment la gamme des Macintosh,

réputés pour la puissance de leur interface graphique. Ils sont

capables de reconnaître et de lire des fichiers enregistrés au

format PC, la réciproque n'étant pas vraie, pour des raisons

visiblement commerciales.

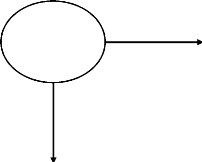

I.2.2. Fonctionnement d'un ordinateur

Unité Centrale

Unité de

commande

Unité

Arithmétique et Logique

Mémoire

Centrale

Mémoires périphérique

(disques,

disquettes, bandes

Organe d'entrées

Organes de sortie

Clavier

Accès aux réseaux

Modem, etc.

Ecran

Imprimante

Organe de conservation des données et programmes

Figure I.1 Schéma de base d'un ordinateur

Le données, introduites par un organe d'entrée

(clavier, disques, souris, commandes vocales, manettes etc.) sont

traitées dans l'unité centrale par un programme qui fournit des

résultats à un organe de sortie (écran, imprimante,

disques, synthétiseur de voix, commandes d'un robot etc.).

Page | 6

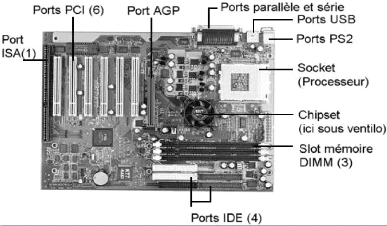

I.3. La carte mère

La carte mère est le circuit imprimé principal

de l'ordinateur, sur lequel sont connectés tous le composants de

l'ordinateur : le microprocesseur, la mémoire centrale, les interfaces,

les ports...

Figure I.2: Carte mère

C'est aussi l'élément constitutif de

l'ordinateur. Les différents composants de la carte mère sont

:

> Le chipset, circuit qui contrôle la majorité

des ressources (interface du bus du processeur, mémoire cache et

mémoire vive, slots d'extension, ...) ;

> L'horloge et la pile du CMOS ;

> Le BIOS ;

> Le bus système et le bus d'extension.

I.3.1. Caractéristique

Une carte mère se caractérise par :

> Son facteur d'encombrement

> Son chipset

> Son type de support de processeur

Page | 7

I.3.2. Facteur d'encombrement

On entend généralement par facteur

d'encombrement, la géométrie et les dimensions de la carte

mère. Afin de fournir des cartes mères pouvant s'adapter dans les

différents boitiers de marques différentes, des standards ont

été mis au point.

I.3.3. Chipset

Le chipset est un circuit électronique chargé de

coordonner les échanges de données entre les divers composants de

l'ordinateur (processeur et mémoire, ...).

? Le chipset pour AMD

AMD + VIA, VIA, SIS, NVDIA ? Le chipset pour INTEL

I810, i810E, i810 E2, i815G.

I.3.4. L'horloge et la pile du CMOS

L'horloge temps réel (notée RTC, Real Time

Clock) est un circuit chargé de synchronisation des signaux du

système. Elle est constituée d'un cristal qui, qui en vibrant

donne des impulsions (appelés top d'horloge) afin de cadencer le

système.

Lorsque votre ordinateur est hors tension, l'alimentation

cesse de fournir du courant électrique à la carte mère.

Or, lorsque vous le rebranchez, votre système d'exploitation est

toujours à l'heur bien que l'unité centrale n'était plus

alimentée pendant un certain temps.

En réalité, même lorsque votre ordinateur

est débranché ou qu'une panne d'électricité

intervient, un circuit électronique appelé CMOS (Complementary

Metal Oxyde Semi-conducteur parfois appelé BIOS CMOS) conserve certains

informations sur le système, y corrige l'heur et la date

système.

Page | 8

I.4. Périphériques

On appelle périphérique, l'ensemble des

unités connectées à l'unité centrale de

l'ordinateur. 2

Les périphériques ont pour rôle

l'échange d'informations entre l'ordinateur et le monde

extérieur.

I.4.1. Périphérique de sortie

Un périphérique de sortie ne peut que recevoir

les informations depuis l'ordinateur, pas lui en transmettre (à

l'exception d'information sur son état de fonctionnement).

I.4.2. Périphérique d'entré

Un périphérique d'entré ne peut

qu'envoyer les informations vers l'ordinateur, pas en recevoir.

I.4.3. Périphérique

d'entrée-sortie

Un périphérique d'entrée-sortie peut

échanger les informations avec l'ordinateur dans les deux sens.

Ex : Disquette, Disque dur, Graveur CD-Rom ou DVD etc.

Ces périphériques fonctionnent correctement

qu'à l'aide d'un programme spécifique appelé pilote.

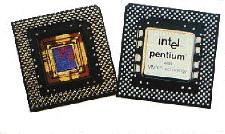

I.5. Le processeur

Le processeur est un circuit électronique qui effectue

les options arithmétiques et logiques. L'appellation microprocesseur

tient du fait que les composants du processeur ne sont plus distincts mais

incorporés dans un même circuit intégré.

Les microprocesseurs utilisent des petits transistors pour

faire des opérations de base, il y en a plusieurs millions sur un seul

processeur.

(2) Patric MARCEL : Architecture des

ordinateurs 1er Année. 24 janvier 2001. P.46 -

59

Suivant le type de processeur le nombre de registre peut varie

entre une dizaine et plusieurs centaines. Les registres les plus importants

sont :

Page | 9

Figure I.3: Processeur Intel

Les éléments principaux d'un microprocesseur sont

:

? Une horloge qui rythme le processeur : à chaque TOP

horloge le processeur effectue une instruction, ainsi plus horloge a une

fréquence élevée, plus le processeur effectue

d'instruction par seconde ;

? Une unité de gestion des bus qui gère les flux

d'informations entrant et sortant ;

? Une unité d'instruction qui lit les données

arrivant, les décode, puis les envoie à l'unité

d'exécution ;

? Une unité d'exécution qui accomplit les taches

données par l'unité d'instruction.

I.5.1. Fréquence du processeur

Exprimée en gigahertz (GHZ) à présent, la

fréquence du processeur désigne le nombre d'opérations

effectuées en une seconde par processeur. Une horloge lui définit

sa cadence.

I.5.2. Le registre

Lorsque le processeur traite des données

(exécute des instructions), il les stocke temporairement dans de petit

mémoires de 8, 16 ou 32Ko (qui sont très rapides) qu'o appelle

registres.

Page | 10

> Le registre d'état : il permet de stocker les

indicateurs

> Le registre accumulateur : il contient l'instruction en

cours de traitement > Le compteur ordinal : il contient l'adresse de la

prochaine instruction à traiter

> Le registre tampon : il permet de stocker temporairement

une donnée provenant de la mémoire.

I.5.3. Sorte de processeur Les processeurs utilise sont

:

> Processeur Intel ; > Processeur AMD > Processeur

Cyrix > Processeur AthlonsT-Bird et XP

I.5.4. Le support

La mise en place d'un processeur doit se faire avec de grandes

précautions. Veillez à bien superposer le détrompeur du

processeur (un coin tronqué ou un point de couleur) sur celui du

support. Sur les marches antérieures au pentium, le support LIF (Low

Insertion Force) était couramment utilisé. Ce dernier n'est en

fait qu'une base perforée où le processeur devait être

inséré de force.

Figure I.4: Support processeur

Le support ZIF (Zero Insertion Force) est constitué

d'un socle plastique généralement de couleur bleue ou blanche et

d'un levier. Lorsque ce dernier est levé, le processeur n'est plus

maintenu et peut être extrait sans effort, d'où son nom.

Page | 11

Il faut éviter à tout prix de plier les broches

qui pouvaient casser. On pouvait alors soit utiliser un extracteur ou faire

levier doucement avec un tournevis.

I.6. LES MEMOIRES

La mémoire est un composant de base de l'ordinateur,

son rôle est de stocker les données avant et pendant leur

traitement par le processeur.

I.6.1.La mémoire vive

La mémoire vive appelée également

mémoire centrale ou RAM (Random Acces Memory) permet de stocker

temporairement les données et programmes en cours de traitement. Les

données contenues dans la mémoire vive sont perdues lorsque le

courant électrique est coupé.

Figure I.5: Random Acces Memory

La mémoire vive se présente sous la forme de

barrettes qu'on insère dans un connecteur de la carte mère. On

peut augmenter la taille mémoire en rajoutant des barrettes de RAM.

Figure I.6: Connecteur insertion de la RAM

I.6.2. La mémoire morte

La mémoire morte (en anglais Rom = Read Only Memory)

est une mémoire en lecture seule, appelée aussi mémoire

non volatile, c'est-à-dire une mémoire qui ne s'efface pas

à l'extinction de l'ordinateur. Elle stocke le programme de base pour

démarrer et utiliser un ordinateur (le BIOS: Basic Input Output

System).

Page | 12

I.6.3. La mémoire cache

La mémoire cache est une petite mémoire à

accès rapide qui sert de tampon entre la mémoire vive et le

processeur. Elle stocke les informations les plus souvent utilisées,

permettant ainsi de réduire les états d'attente du

microprocesseur. Lorsque le microprocesseur veut traiter des données, il

accède d'abord à la cache interne, s'il ne trouve pas les

données, il accède à la cache externe, puis à la

RAM.

I.6.4. Cache interne

C'est une mémoire ultra rapide intégrée

au microprocesseur. Elle stocke les données les plus

utilisées.

I.6.5. Cache externe

Si le micro-processeur ne trouve pas les données dans

la cache interne, il les cherche dans la cache externe. La cache externe est

moins rapide que la cache interne mais plus rapide que la RAM

I.6.6. La mémoire CMOS

On l'utilise pour stocker les paramètres

d'initialisation du BIOS. Son contenu est conservé en permanence car

alimentée par une pile ou accumulateur.

I.7. LES SLOTS D'EXTENSION3

Les slots d'extension permettant de recevoir des cartes

d'extensions ou additionnelles (carte graphique, réseau, TV, etc.)

I.7.1. Type des slots

Le nombre et le type de slots pour cartes additionnelles sont

aussi très importants.

? Les slots ISA (Industry Standard Architecture): sont

dépassées ;

? Les slots PCI (Peripheral Component Interconnect) sont les

standard actuels et quatre sont assez utiles;

? Le port AGP (Accelerated Graphics Port) le port AGP est

indispensable pour les cartes, plus rapides ;

? Les ports USB (Universal Serial Bus).

(3)

http://www.wikipedia.com

Page | 13

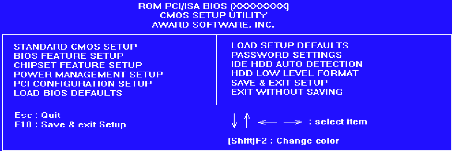

I.8. LE BIOS

Le BIOS (Basic Input/Output System traduisez) est un

composant essentiel de l'ordinateur, permettant le contrôle des

éléments matériels.

C'est une composant essentiel de l'ordinateur ; il s'agit

d'un petit logiciel dont une partie est dans une mémoire morte (ROM) que

pouvez donc pas modifier, et une autre partie est dans [[PROM (ROM que l'on

peut modifier par impulsions électriques, d'où le terme flasher

lorsqu'on la modifiez).

Il est possible de configurer le BIOS grâce à

une interface nommée BIOS setup, traduisez configuration du BIOS

accessible au démarrage de l'ordinateur par simple pression d'une

touche.

I.9. LES PERIPHERIQUES INTERNES

Sur un PC on peut connecter des périphériques

internes. Les périphériques internes sont connectés

à l'intérieur du PC, c'est-à-dire sur les ports AGP, PCI

ou ISA de la carte mère il s'agit principalement :

? Carte vidéo (indispensable) : qui permet de fournir

l'image au

moniteur ;

? Carte son qui permet d'avoir le son sur le PC ;

? Modem interne ;

? Carte réseau : qui permet d'interconnecter plusieurs

ordinateurs :

? Carte TV, Capture d'image, Radio...

I.9.1. Carte graphique

La carte graphique ou écran est l'élément

de l'ordinateur chargé de convertir les données numériques

à afficher en données graphiques exploitables par un

périphérique d'affichage.

Page | 14

Figure I.7: Carte graphique (écran)

Une carte graphique se caractérise par :

> Bus utilisé (ISA, PCI, AGP) ;

> Le circuit intégré qui gère

l'affichage

> Mémoire

> Convertisseur digital-analogique

> Taux de rafraichissement maximum :

> Possibilités 3D ;

> Bios vidéo ;

> Connecteur de sortie.

Quelques une de ces caractéristiques sont identiques

à celle d'un système à microprocesseur : processeur,

mémoire et Bios. En effet, le sous-système vidéo est un

système à microprocesseur tout à fait conforme dont le

seul but est de traiter des informations digital provenant du PC pour les

transférer vers le convertisseur.

I.9.2. Le disque dur (Périphérique

d'entre-sortie)4

Un disque dur est une mémoire de masse

magnétique, servant à conserver les données de

manière permanente, contrairement à la mémoire vive, qui

s'efface à chaque redémarrage de l'ordinateur, c'est la raison

pour laquelle on parle parfois de mémoire de masse pour désigner

les disques durs.

Le disque dur est relié à la carte-mère

par l'intermédiaire d'un contrôleur de disque dur faisant

l'interface entre le processeur (Carte mère) et le disque dur.

(4) Jean-François Pillou, Tout sur le

hardware PC, éd. Dunod, P. 88, 2005

Page | 15

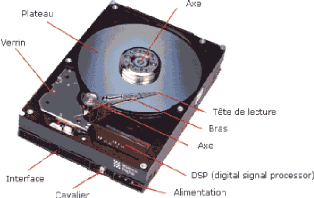

Figure I.8: Disque dur IDE

Types

On distingue généralement les interfaces suivantes

:

> IDE (Intelligent Drive Electronic);

> SCSI (Small Computer System Interface) ;

> Serial ATA (Serial Advanced Technology Attachment).

Caractéristique

Les disques dur sont caractérisés par :

> Capacité : volume de stockage de données ;

> Taux de transfert (ou débit) : quantité de

données pouvant être lues ou écrites

> Vitesse de rotation

> Temps de latence (délai rotationnel) ;

> Temps d'accès moyen : temps moyen que met la

tête pour se positionner sur la bonne piste et accéder à la

donnée ;

> Densité radiale : nombre de pistes par pouce ;

> Densité linéaire : nombre de bits par pouce

sur une piste donnée ;

> Densité surfacique : rapport de la densité

linéaire sur la densité radiale; > Mémoire cache (ou

mémoire tampon) : quantité de mémoire

embarquée sur le disque dur. La mémoire cache

permet de conserver

les données auxquelles le disque accède le plus

souvent afin

d'améliorer les performances globales ;

Page | 16

I.10. BLOC OU BOITIER D'ALIMENTATION

L'alimentation permet de fournir du courant électrique

à l'ensemble des composants de l'ordinateur. Aux Etats-Unis les blocs

d'alimentation délivrent un courant à 110V et à 60 Hz,

tandis qu'en Europe la norme est 220V à une fréquence de 50 Hz,

c'est la raison pour laquelle les blocs d'alimentation possèdent la

plupart du temps un commutateur permettant de choisir le type de tension

à délivrer.

Figure I.9: Bloc d'alimentation

I.10.1. Sortes

Actuellement, il existe deux types de boîtiers qui

correspondent à deux types de formats de cartes mères :

? AT : C'est l'ancien format des cartes

mères et est en voie de disparition. C'était le format

dédié aux Pentium et processeurs de cette

génération.

? ATX : C'est le format actuel, Il est bien

plus pratique que l'ancien. On peut bricoler pour le transformer en AT mais

cela reste assez compliqué pour pas grand-chose. Les connecteurs

séries, parallèles, USB s'intègrent directement dans le

boîtier. Le processeur est situé sous l'alimentation.

L'alimentation qui d'ailleurs n'est pas la même que celle du AT.

Page | 17

I.10.2. Facteur de forme

La forme désigne le format de l'emplacement prévu

pour la carte mère, les types de connecteurs et leur agencement. Il

conditionne ainsi le type de carte mère que le boîtier peut

accueillir.

I.11. Logiciels

Logiciel est l'ensemble de programme destinés à

faire fonctionner l'ordinateur.

Pour pouvoir être utilisable, un micro-ordinateur doit

disposer de logiciels et d'un système d'exploitation capable de

gérer les différentes ressources matérielles et

logicielles disponibles.

? MS-DOS (Microsoft Disk Operating System): pour PC;

? Microsoft Windows 3.x, Windows 95, 98, NT, 2000, XP: pour PC,

mais plus

convivial que MS-DOS ;

? Mac Os : pour Macintosh ;

? UNIX, LINUX : pour PC ;

Les premiers systèmes d'exploitation sur PC

étaient peu conviviaux et fonctionnaient en mode texte, à la

différence du Mac Os qui avait adopté dès 83 une interface

graphique. Les interfaces graphiques se sont généralisées

sur PC à partir de 1990 (Windows 2, 3, 3.1, 95, 98, etc.).

Microsoft détient un quasi-monopole des systèmes

d'exploitation sur PC. Mais il existe aussi un système d'exploitation

concurrent, appelé Linux, développé à l'origine par

un étudiant finlandais, Linus Thorvald.

DOS (Disk Operating System)

Système d'exploitation développé par

Microsoft, d'où le nom MS-DOS. Le système MS-DOS est un

système de type clavier, c'est-à-dire que l'utilisateur se sert

du clavier comme intermédiaire entre lui et l'ordinateur.

Mais le MS-DOS ne permet pas le travail du microprocesseur en

multitâche, c'est-à-dire lancé plusieurs programmes

simultanément.

WINDOWS

En système Windows type 3.0, 3.1, 3.11, n'est pas un

système d'exploitation. Il a besoin du système MS-DOS pour

fonctionner. C'est un programme qui est un intermédiaire de type

souri.

Page | 18

WINDOWS 9X :

En septembre 1995, sort le système d'exploitation

Windows 95. A la différence de Windows 3.x, il n'a pas besoin de MS-DOS

pour travailler, malgré qu'il garde une couche MS-DOS en

arrière-plan (peu visible pour l'utilisateur). Il peut travailler en

multitâche. L'avantage de Windows 95 est multiple. Il a

révolutionné le système d'exploitation par son interface

visuel et ses particularités techniques. C'est un système

d'exploitation utilisant la souris.

En septembre 1998, Microsoft sort une version améliorer

de Windows 95, nommée Windows 98 qui corrige certains défaut de

la première version mais garde cependant la même interface

visuelle.

WINDOWS NT

C'est un système d'exploitation de type serveur client.

La gamme NT en version 4 actuellement est prévue pour faire fonctionner

un réseau en se servant d'un serveur et de poste client. Il est

prévu pour permettre une sécurité ajouter pour les

données.

NOVELL

Ne pas vraiment un système d'exploitation mais un

logiciel uniquement prévu pour un serveur dans un réseau. Les

postes clients ont cependant besoin d'une couche pour accéder à

celui-ci.

UNIX

C'est également un système d'exploitation,

multiposte et multitâche. UNIX est développé par la

société USL (Unix Système La boratories).

OS2

C'est un système d'exploitation multitâche

développé par la société IBM. On le rencontre sur

les micro-ordinateurs PS/2 d'IBM ou les compatibles PC à partir des 386.

Ce système intègre une interface graphique et permet ainsi de

remplacer l'association MS-DOS/WINDOWS. Windows 95 lui ressemble

étrangement.

Page | 19

CHAPITRE

II. LA THEORIE SUR LE PARC INFORMATIQUE

II.1. DEFINITION

Un parc informatique est un ensemble des matériels et

logiciels informatique (Ordinateur, imprimante, fax, serveur...) relié

en réseau. En somme, quelqu'un qui gère un parc informatique est

un administrateur réseau.

Les solutions informatiques sont actuellement indispensables

aux activités de d'importe quelle structure, quelle se présente

sous forme de sociétés ou d'un groupement nature

différent, il faut savoir que cette nécessite d'emploi est

essentiellement due à leur caractère multi taches et de ce fait,

elles avèrent être des outils de travail primordiaux.

Ainsi l'intérêt de l'utilisation des ordinateurs

et autre solution informatiques est plus qu'évident puisque leurs

fonctions principales garantissent un excellent fonctionnement d'une

organisation, si l'on ne cite que la communication ou la gestion. Lorsque

plusieurs dispositifs informatiques sont mis à la disposition des

employés d'une société, leur ensemble est qualifié

de parc informatique.

Par définition, un parc informatique est, comme il a

été souligné précédemment, un ensemble de

solutions informatiques que dispose une organisation et comprend tous les

équipements intégrant ce domaine il est important de souligner

que la notion de parc informatique et aujourd'hui indissociable au domaine du

réseau, autrement dit, les solutions informatique sont

interdépendantes et interconnectées. Il est évident que le

réseau dont on fait allusion ici fait référence aux deux

types réseaux informatique existants, à savoir le réseau

local qui est strictement privé et le réseau externe : Internet,

dans la majorité des cas. Comme il a été

précisé plus haut, un parc informatique est composé de

tous les éléments de nature informatique et non exclusivement,

les ordinateurs en tant que machine.

II.2. TYPES DE MATERIELS5

Par conséquent, on distingue deux catégories de

dispositifs composant un parc informatique, à savoir les

matériels et les programmes.

(5) SOLANGE CHERNAOUTI -

Hélie : Sécurité et informatique de

réseaux 2ème Ed. P. 268 - 281

Page | 20

Les matériels dont il est question ici sont bien

évidement les solutions qui peuvent être considérés

comme étant des machine, dénommées hardware dans le jargon

informatique, à savoir les ordinateurs et tous ses composants internes

mais également les matériels accessoires, les canner, imprimante,

webcams, les périphériques tels que les disques durs et graveurs

externes ainsi que les clés USB, les commutateurs réseaux

communément connus sous la qualification de switch, les

différents câbles, les modems nécessaires à la

connexion internet, les vidéoprojecteurs et les onduleurs. Il est

également nécessaire déprécier que les consommables

informatiques sont compris dans cette catégorie, si l'on ne cite que les

cartouches d'encre ou les papiers.

Pour ce qui est des programmes ou software, ce sont toutes les

applications informatiques qui peuvent être considérées

comme étant des logiciels et qui sont nécessaires au

fonctionnement des machines (ordinateurs) ainsi que du réseau. En

réalité, il n'existe que deux types des logiciels : les

programmes applicatifs et ceux qualifiés de système.

Dans le contexte de la gestion d'un parc informatique, ils

peuvent être subdivisés en trois catégories, à

savoir :

? Les softs destinés aux activités professionnelles

si l'on ne cite que les outils bureautiques ;

? Les programmes dédiés à

l'opérationnalité des machines tels que les systèmes

d'exploitation ou les anti-virus ;

? Les logiciels conçus pour le réseau mais

également pour la gestion du parc.

Actuellement, les programmes informatiques sont indissociables

avec la licence qui régit leur utilisation mais également avec

l'opération de mise à jour. En réalité, cette

affirmation n'est valable que pour les logiciels propriétaires puisque

les logiciels libres ne nécessitent pas une gestion de droit

d'utilisation. Il faut savoir que plus les éléments qui forment

un parc informatique sont importants, plus sa gestion se révèle

être complexe. C'est la raison pour laquelle les grand

sociétés, mais pas obligatoirement, ont opté pour la mise

en place de services informatiques. Mise à part la gestion des sites

internet, qui est également la fonction principale de cette

entité, les missions relatives à la gestion d'un parc

informatique sont succinctement les suivant :

Page | 21

? Gérer les pannes matérielles ainsi que les

dysfonctionnements ;

? Mettre en place et administrer les serveurs ainsi que les

réseaux ;

? Définir et fournir des machines aux configurations

spécifique nécessaires aux activités professionnelles

particulières ;

? Réaliser l'inventaire du parc informatique et

établir une base de données concernant la gestion des

matériels et programmes.

Définir et mettre en place le système

d'information adéquat aux besoins de la société,

gérer les fournisseurs de services informatiques, mettre en place un

système de sécurité correspondant aux besoins, fournir des

solutions des sauvegardes mais également d'archivage de données

et conseiller les utilisateurs, évidemment du point de vue informatique

actuellement.

Plusieurs solution informatiques conçues pour optimiser

la gestion d'un parc informatique sont disponibles dont certaines sont libres.

Parmi les logiciels qui répondant à ce critère et qui sont

très prises par le service informatique figure le soft

dénommé GLPI (gestionnaire libre de parc informatique),

distribué sous la licence GLP, la raison de la notoriété

de ce programme libre repose essentiellement sur ses performances et ses

fonctionnalités.

II.3. PARC HETEROGENE OU HOMOGENE II.3.1. Parc

hétérogène

Hétérogénéité du

matériel, de l'environnement de logiciel, évolution de

l'environnement logiciel au court du temps.

L'hétérogénéité des parcs

informatique (machine, connectivité, réseau, système

d'exploitation) commune à la plupart des entreprises d'aujourd'hui rend

difficile l'accès aux applications Windows critiques et impliquent des

mises à jour couteuses, l'utilisation de logiciels d'émulation

problématiques et la rée critique intégral des

applications.

Page | 22

II.3.2. Parc homogène

Un parc homogène facilite la maintenance des machines

et réduit les couts. L'homogénéité concerne non

seulement les ordinateurs (modèles identique ou proches) mais aussi les

périphériques comme les imprimantes (consommables identique), les

scanners (familiarité des utilisateurs) et même les claviers et

souris. Au niveau logiciel et configuration, l'homogénéité

améliore la productivité permettant à un utilisateur de

passer d'un poste à un autre sans être dépaysé.

L'homogénéité peut également

être atteinte par le biais d'une installation centralisée, ou les

utilisateurs utilisent des clients légers pour accéder aux

ressources situées sur un ou plusieurs serveurs centraux.

II.4. GESTION DU PARC INFORMATIQUE II.4.1. Objectifs et

fonctions

Comme on ne gère et on ne sécurise bien que ce

que l'on connaît bien, il est primordial d'effectuer un recensement le

plus exhaustif possible des actifs informatiques de l'entreprise pour en

évaluer le niveau de sécurité et vérifier qu'il est

correct vis-à-vis des exigences.

Les fonctions d'un système de gestion du parc

informatique contribuent à la sécurité via les fonctions

suivantes :

> Gestion technique de parc ;

> Gestion du catalogue, codification des équipements,

terminologie

commune, repérage physique des matériels à

fins d'inventaire ;

> Inventaire initial et périodique de tous les

composants du système d'information ;

> Standardisation maximale des configurations

(économie d'échelle, cohérence des fonctions

assurées) ;

> Schéma de circulation des flux de données ;

> Volumétrie des flux (pour un bon dimensionnement

afin de répondre au critère de disponibilité) ;

> Harmonisation des différents fournisseurs ;

> Gestion commerciale (administration des contrats, tarifs,

commandes, acquittement des factures, gestion des délais de livraison et

de garantie, suivi de comptes fournisseurs, suivi budgétaire, gestion

des licences, etc.) ;

Page | 23

? Gestion des immobilisations (traduction des états

comptables réglementaire) ;

? Gestion physique du parc (définition des

responsabilités pour l'entrée, le suivi de l'état, la

localisation des équipements, pour le maintien des inventaires et des

statiques, la détermination de la valeur d'assurance, etc.) ;

? Gestion des incidents (réception automatique des

incidents, description, suivi des pannes par fournisseur, etc.) ;

? Contrôle de gestion (mesure des coûts actuels et

prévisionnels refacturation aux utilisateurs, préparation de

budgets, contrôle budgétaire des achats par centre

d'activité, suivi des coûts de maintenance, d'exploitation, suivi

d'un indicateur donnant le nombre

d'interventions par unité d'équipement selon

les

marques/modèle/types, corrélation entre le niveau

d'obsolescence et l'immobilisation comptable, etc.) ;

? Processus d'identification, de valorisation, et

d'affectation des coûts réels pour contrôler les

dépenses.

L'inventaire des ressources, y compris des profils des

utilisateurs est fondamental pour identifier les valeurs à

protéger et les critères de sécurité associes afin

d'identifier les mesures sécurité pour les satisfaire.

II.4.2. Recommandations

La mise en oeuvre d'un service de gestion de parc s'inscrit

dans une logique de qualité et doit s'interfacer et dialoguer

harmonieusement avec les autres services de gestion de réseaux (modules

de gestion des performances, des incidents, de la comptabilité).

Une bonne gestion de parc informatique n'a de sens que si l'on

sait également gérer correctement l'utilisation des ressources

informatiques et les fournisseurs (éditeurs de logiciels,

opération, etc.) dont l'entreprise dépend.

La mise en place d'une politique cohérente de

remplacement des machines pour faire évoluer le parc informatique, ainsi

qu'une bonne connaissance du réseau donne lieu à une meilleure

anticipation des besoins et justification des demandes budgétaires qui

en découlent.

Page | 24

La dénomination des ressources est très

importante. L'administrateur doit choisir les noms des serveurs, des stations,

des ressources périphériques, des répertoires pour les

logiciels, des utilisateurs. Une politique de dénomination claire,

cohérente et connue des administrateurs réseau est primordiale si

l'on souhaite maintenir une cohérence des noms dans le parc

informatique.

Une observation suivie de la qualité de service permet

de mesurer l'efficacité du réseau. Cela connaitre le trafic,

à repérer très tôt les incidents potentiels,

à surveiller la croissance et les tendances des utilisateurs. Ainsi, la

prévision de l'évolution des besoins et du réseau est

facilitée.

La gestion du trafic (facteur de performance du réseau)

peut entraîner un redimensionnement du réseau en fonction des

tendances lourdes détectées par les observations du trafic avec

comme corollaire, la mise en oeuvre de nouveaux services et

équipements.

Il est important de définir un seuil de fonctionnement

minimal pour évaluer la qualité de service et dimensionner le

réseau.

II.4.3. Gestion comptable et facturation

Un système de compatibilité participe au

contrôle, à la réduction et l'analyse des couts de

communication, dans l'optique maitriser les couts et risques financiers

liés à l'usage des réseaux. IL peut supporter par exemple

des fonctions:

? D'enregistrement des appels sortants par poste ou par

compte, possibilité de raturer en internet ;

? De génération d'états d'utilisation

(états d'activité par, compte, date indicatif, états

récapitulatifs, par poste, service, centre de couts, appel, etc.)

états d'exceptions, numéros le plus couteuses, etc.) ;

? De suivi des décisions d'exploitation (routage,

durées, priorité d'appel, etc.) ;

? D'identification des bus, etc.

Page | 25

Toute les facilites dont a besoin la gestion de réseau

pour réaliser une comptabilité appropriée de l'usage des

ressources contribuent à la gestion d'identités, des profils des

utilisateurs de leurs droits d'accès, de la surveillance leurs

activités cela participera par exemple à la détection

d'utilisations frauduleuse ou abusives du réseau, à l'usage des

technologies de l'information les fonctions de comptabilité et de

facturation sont basées sur l'enregistrement des données et sur

la surveillance. Ceci facilite donc l'implantation de mesures d'autre de non

répudiation, de traçabilité, d'imputation et de

contrôles nécessaires à la réalisation de la

sécurité.

II.4.4 Gestion opérationnelle d'un

réseau

La gestion opérationnelle d'un réseau recouvre

l'ensemble des activités d'exploitation journalière et de

maintenance qui conservent le réseau en état de marche au niveau

de qualité de service et de sécurité satisfaisant pour le

client utilisateur.

La gestion opérationnelle ne peut se faire que si on

analyse le fonctionnement de réseau et si on détermine dans

quelle mesure des objectifs de qualité de service et

sécurité sont atteints. Pour cela, il est nécessaire de

disposer d'états du réseau ces informations observées

constituent en quelque sorte, des « prises de température »

systématiques, véritables indicateurs de performance qui

permettent d'identifier au plus vite des anomalies, des intrusions ou une

dégradation des performances préjudiciable à la

sécurité. Cela autorise autant que faire se peut un diagnostic

afin d'établir des mesures adaptées pour optimiser

l'infrastructure et les services.

II.4.5. Gestion des configurations

Rendre un réseau opérationnel, c'est tout

d'abord le configurer. C'est à ce niveau de paramètre du

réseau que l'on fixe les critères d'accès aux ressources

(permission), les seuils d'alarmes, les éléments à auditer

et de trace qui contribuent à la réalisation de la

sécurité.

En effet, c'est lors de la configuration que l'on positionne

les sondes permettant d'effectuer un audit actif des événements

du réseau. Ainsi, de façon dynamique, le système est

capable d'identifier la survenue d'atteintes sécuritaires et de

déclencher des actions ad hoc (génération d'alarmes,

déconnexions automatiques par exemple). Du point de vue

sécuritaire, cette phase est primordiale dans la mesure où elle

permet

Page | 26

d'appliquer la politique de sécurité sur

l'ensemble des éléments du réseau et d'établir les

procédures de contrôle d'accès.

La configuration du réseau permet sa

génération : c'est un chargement effectif de la configuration

dans les éléments du réseau. Le réseau

possède alors la connaissance de son architecture, de son mode de

fonctionnement, de l'implantation de chaque entité, de leur localisation

et des protocoles de communication.

Les phases de configuration et de génération

constituent l'initialisation du réseau après lesquelles il

devient opérationnel et capable de répondre à une demande

de service. Un réseau peut voir son architecture évoluer au cours

de son utilisation (ajout, suppression, modifications logicielle ou

matérielle), nécessitant une

reconfiguration-génération. Cette phase doit pouvoir se faire

dynamiquement sans entrainer un arrêt du réseau afin d'assurer la

continuité des services.

La gestion des configurations s'accompagne d'un contrôle

des modifications, matérialisé par un processus d'autorisation,

de mise au point, de teste et de documentation des modifications

apportées (gestion sécurisés des configurations).

Le risque associé à cette fonction peut

être lié à des modifications non testées,

prohibées ou non documentées qui peuvent mettre à mal le

réseau et sa sécurité (mauvais paramétrage du

routage, des contrôles d'accès, conduisant par exemple à

des effondrements du réseau, à l'indisponibilité de

certaines ressources, à des dénis de service, à une

facturation erronée, etc.).

<

II.4.6. Surveillance et optimisation

La fonction de surveillance, véritable outil de

maîtrise de la sécurité, permet réaliser la

traçabilité des actions et événements.

La surveillance consiste à observer en permanence le

fonctionnement et le comportement du réseau, via notamment des «

sondes réseau » qui permettent des observations du trafic, des

remontées, des comptes rendus d'anomalies, par la signalisation

d'incidents par les usagers, etc.

Page | 27

IL s'agit de:

> S'assurer que la qualité de service est

satisfaisante, que les exigences de sécurité sont

respectées ;

> Déceler des variations qui pourraient affecter la

qualité de service et la sécurité ;

> Déterminer s'il n'existe pas de problèmes

sur le réseau qui ralentissent les services (goulot

d'étranglement, dysfonctionnement, panne partielle, mauvaise

configuration, etc.) ;

> Détecter les tentatives d'accès frauduleux,

de détournement de l'usage de ressources, etc. (notion de monitoring

actif, de système de détection des intrusions) ;

> Vérifier à l'aide de mesures que le

réseau ou les serveurs ne sont pas saturés, ou en tout cas qu'ils

travaillent avec un degré de charge supportable. Cela traduit un souci

de recherche de configuration optimale et de dimensionnement correct.

L'administrateur système/réseau doit non

seulement s'assurer que le réseau est opérationnel, mais aussi

vérifier périodiquement qu'il fonctionne de façon

optimale.

II.4.7. Gestion des performances

L'évaluation des performances des réseaux a pour

objet principal de mesurer les performances de systèmes et des

réseaux en vue de leur optimisation. De plus, elle permet

d'évaluer et de paramétrer les outils nécessaires pour

satisfaire les exigences de qualité de service et de

sécurité.

Les évaluations de performances s'effectuent lors des

différentes phases de la vie du réseau :

> A sa conception (dimensionnement du réseau) ;

> Lors de modifications d'équipements (prise en

compte des expériences passées) ;

> Durant le suivi du réseau (surveillance des

paramètres de temps de réponse, analyse du trafic,

évaluation du débit efficace et maximum, réalisation de

test, tests d'intrusion, test du niveau de robustesse des mots de passe,

identification du seuil d'effondrement des systèmes conduisant à

des dénis de service, etc.).

Page | 28

Les performances d'un réseau peuvent être

appréhendées de trois façons complémentaires :

? Par des mesures sur le réseau (monitoring,

surveillance, sondes, remontées d'alarmes, etc.), elles constituent le

seul moyen d'obtenir les indicateurs de performance qui tiennent compte de

toutes les caractéristiques réelles du réseau ;

? Par des simulations informatiques qui passent par la

réalisation et l'exécution de programmes modélisant les

mécanismes de comportement du système observé en fonction

des valeurs des variables étudiées ;

? Par des méthodes analytiques (étude

théorique, le plus souvent basée sur des mathématiques)

qui reposent sur la théorie des files d'attente et sur la

résolution d'équations modélisant les aspects du

fonctionnement du réseau que l'on désire analyser.

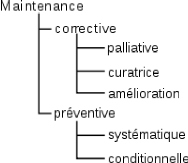

II.4.8. Maintenance et exploitation

La maintenance est l'ensemble des actions entreprises pour

conserver ou remettre un équipement dans un état tel qu'i puisse

remplir correctement ses fonctions. La maintenance des systèmes

distribués est donc une composante de la réalisation de la

sécurité de ces derniers.

Les ressources matérielles et logicielles qui composent

le réseau font l'objet de tests tout au long de leur vie.

Appliqués lors de leur conception, les tests permettent de

déterminer le degré de fiabilité et de confiance que l'on

peut avoir envers elles. Lors de leur usage, ils contribuent avec des mesures

de performances à réaliser la maintenance préventive du

réseau. Si les tests sont mis en oeuvre sans interruption partielle ou

totale du service réseau, les tests sont qualifiés de tests on

line et, dans le cas contraire, de tests off line.

La maintenance préventive vérifie le bon

fonctionnement d'un équipement par des tests et le remplacement

périodique de certains organes fragiles, sans même faire d'essai

ou de mesure.

La maintenance corrective s'effectue après la

localisation de l'origine d'une anomalie afin d'y remédier, par

réparation ou par remplacement de l'entité défectueuse.

Page | 29

Toutes les actions et procédures de maintenance sont

déterminées par la politique de maintenance et de gestion des

anomalies définie par la politique de gestion de réseaux et de la

sécurité de l'entreprise.

Rendre imperceptibles les pannes aux utilisateurs ou, en tout

cas, minimiser la durée de l'interruption de service est l'objectif

à atteindre de la fonction de gestion des incidents contribuant ainsi la

continuité des services, à la disponibilité et à

l'intégrité des ressources.

La détection des pannes (localisation et signalisation)

est indispensable pour que les mécanismes de réparation et de

reconfiguration puissent se réaliser et laisser un système dans

un état opérationnel fiable et sûr. L'origine d'une

défaillance se détecte par logiciel soit par des

mécanismes de senseurs ou de « chiens de garde » internes soit

par la surveillance d'une unité par une autre. Cela est

réalisé par les fonctions suivantes:

? Surveillance et alarme ;

? Prise en compte des événements non

sollicités ;

? Localisation des pannes par des tests ;

? Détermination et identification des pannes par analyse

ou via des

systèmes experts ;

? Correction (action curatives).

Des tests périodiques et systématiques

automatiques autorisent la signalisation de défaillances des

équipements. La plupart des équipements informatiques

intègrent des mécanismes de contrôle et de surveillance

divers (détection d'erreur, de parité en mémoire ou sur

bus, de contrôle d'état des coupleurs, etc.). Toutes ces

détections donnent lieu à des transferts d'informations, à

des fins de gestion (notion d'informations de gestion), au(x) point(s) de

contrôle du réseau dont dépendent les équipements.

Les points de contrôle, pouvant agir à distance sur des

systèmes en déclenchant des procédures de tests par

exemple, autorisent des actions de télémaintenance et de

télésurveillance en temps réel ou différé.

Du point de vue des logiciels de communication, les procédures de

transmission (niveau 2 du modèle OSI) sont conçues pour

détecter des problèmes de lignes, de modems et de coupleurs,

tandis que les protocoles de niveaux OSI 3 et 4 permettent de détecter

de anomalies liées au routage et à la qualité de service

du transport.

Page | 30

La surveillance permet de prévenir certaines pannes par

détection anticipée des défaillances (identification de

mode de fonctionnement dégradé pouvant conduire à des

défaillances totales des équipements).

La gestion des incidents est une fonction qui permet de

consigner, d'étudier, de comprendre et de corriger les incidents de

fonctionnement du réseau. Elle intègre une procédure qui

oriente les utilisateurs en pannes vers un centre d'assistance

approprié. La notification d'un incident entraîne

généralement les actions suivantes :

> Consignation de l'incident (historique des incidents) ;

> Identification de la personne responsable de sa correction

;

> Analyse visant à déterminer son origine ;

> Mise en oeuvre des mesures correctives et préventives

nécessaires.

A cela, il faut rajouter pour les incidents critiques, la mise

en place d'une procédure de définition des

responsabilités.

La direction peut imposer, par exemple, au responsable d'un

réseau local d'indemniser en interne les départements de

l'entreprise pour chaque heure d'interruption. Il s'agit en quelque sorte

d'offrir une garanti de service, en partant du principe que si le service n'est

pas fourni, les départements de l'entreprise ne peuvent travailler

correctement, ce qui justifie une indemnisation comptable interne.

On dénomme exploitation, toutes les actions qui

contribuent à maintenir opérationnel d'un réseau de

télécommunication. Cela consiste également à

prélever des informations et à les transmettre à une

entité, en vue de réaliser la facturation de l'utilisateur des

ressources.

Fonction d'exploitation est l'administration quotidienne du

réseau. Elle effectue les contrôles de vérification de

bonne fonction du réseau. Comme toute fonction vitale à la vie du

réseau, cette dernière est à sécuriser

(sécurité de l'exploitation) en fonction des risques effectifs

qu'elle pourrait encourir. Préventive ou Corrective, la faction

d'exploitation intègre les tâches suivantes :

> Mise en route ;

> Suivi ;

> Intervention en cas d'alerte ou problème ;

Page | 31

? Prévention des risques liés aux virus ou autres

formes d'attaques ; ? Application des mesures correctives ;

? Activation du plan ou des équipements de secours,

etc.

Le fonctionnement de l'exploitation sera qualifié de

bon, dans la mesure où il est en position de service vis-à-vis

des utilisateurs, et de partenaire vis-à-vis des développeurs.

Pour ce qui concerne ces derniers, cela sera vraiment nécessaire lors de

la phase d'industrialisation des applications. Celle-ci a pour objectif de

s'assurer que leur intégration et leur mode opératoire sont

corrects, administrables, exploitables avant leur diffusion et mise en

production. De nouveaux applicatifs ne doivent pas perturber l'environnement

d'exécution dans lequel ils s'insèrent, ni la

sécurité en place.

De plus, l'essai et la réception d'applications doivent

être prévus en collaboration avec l'équipe de

développement d'applications et les utilisateurs, afin de garantir

l'emploi des applications de tests adéquates (plan de tests, tests de

charge critique) dans des conditions de fonctionnement normal.

L'automatisation de l'exploitation contribue

généralement à la réduction des coûts

d'exploitation, du nombre d'interventions humaines et à

l'amélioration de la qualité et de la rapidité de service.

Pour ce faire, il faut préalablement « normaliser » le

processus opératoire des exploitant et mettre

en place les systèmes permettent de le réaliser.

II.4.9. Supervision et contrôle

Les activités reliées à la collecte,

à la mémorisation, et au traitement des données relatives

aux usagers et aux équipements, autorisent celles de la supervision et

du contrôle de l'utilisation des ressources du réseau.

Les principales composantes de la supervision sont la

surveillance du réseau et du trafic, la mise en oeuvre des

procédures de sauvegarde et la coordination des services. Cela consiste

en:

? Réception en temps réel des informations

relatives à la qualité de service ;

? Transfert de ces informations vers l'application de gestion

concernée, ou vers un système de gestion de bases de

données ;

Page | 32

? Traitement (détection des anomalies,

génération d'alarmes, mise en oeuvre du plan de secours, etc.)

;

? Présentation des données selon certaines

caractéristiques (ergonomie, valeurs significatives, forme, couleur,

son), pour une meilleure aide à la décision (vue synoptique de

l'état du réseau, etc.) ;

? Aide à la tété-action (plans de secours

prédéterminés) ;

? Mémorisation des actions et événements

(journal de bord) dont l'analyse a posteriori permet d'améliorer les

procédures, les configurations, les plans de secours.

II.5. DOCUMENTATION

La direction informatique ou la direction

générale doit exiger, en la contrôlant si

nécessaire, une documentation complète, précise et

à jour de tout ce qui concerne la vie du réseau et sa

sécurité. La documentation des activités liées au

réseau est une tâche difficile souvent sous-estimée mais

toutefois nécessaire à la gestion du réseau et de la

sécurité. En effet aux données strictes de l'inventaire,

on intégrera des informations relatives aux configurations logicielles

et matérielles, afin d'apprendre des évènements

passés, de mémoriser le savoir-faire de l'équipe

réseau, mais aussi les évènements à des fins de

traçabilité, d'audit et d'optimisation.

Une erreur qui est survenue doit être connue, si elle se

répète, elle devient une faute !

La non-documentation crée ou maintient une

dépendance très forte entre l'entreprise et son (ou ses)

administrateur(e) réseau ; ce qui réduit considérablement

sa capacité de contrôle, de gestion et de sécurité

du réseau.

<

La sécurité passe par la confiance n'exclut pas le

contrôle !

Toutefois, il est bon d'effectuer un compromis

approprié entre « tout documenter » jusqu'au moindre

détail, auquel cas l'administrateur réseau ne fait plus que de la

documentation, et « ne rien documenter ». Si la direction

générale a le sentiment de ne pas maîtriser les questions

technique et n'est pas en mesure d'assurer elle-même le contrôle de

la documentation, il est de son ressort de la faire valider par des auditeurs

externes. Il sera alors demandé une estimation du degré de

détail exigé dans rapport à ce qui en est attendu.

Page | 33

CHAPITRE III. TECHNIQUE DE SAUVEGARDE

III.1. Les techniques de sauvegarde6

Le meilleur moyen de ne pas perdre ses données est

d'avoir toujours au moins une copie en lieu sûr, appelée

sauvegarde. Il est primordial d'effectuer régulièrement des

sauvegardes. La fréquence des sauvegardes dépend de la

quantité de données que vous acceptez de perdre en cas de

destruction de vos données.

En plus des données, vous pouvez sauvegarder votre

système et vos logiciels, mais en général, ils sont

fournis avec des moyens de réinstallation qui rendent cette sauvegarde

moins importante que celle des données.

Pour effectuer une sauvegarde, vous pouvez utiliser soit un

outil spécialisé soit faire de la simple copie de fichiers.

Il est recommandé, une fois la sauvegarde

effectuée, d'entreposer les supports loin de l'ordinateur qui contient

les données. Cette précaution évite que la destruction des

données d'origine ne puisse s'accompagner de la destruction de leur

copie de sauvegarde (ce qui pourrait arriver en cas d'incendie ou

d'inondation).

Le support externe utilisé pour stocker la sauvegarde

peut être un CD, un DVD enregistrables, un disque dur externe, une bande

magnétique (DAT, DLT)... en fonction de l'équipement que vous

possédez (interface USB, graveur, lecteur de bande) et de la

quantité de données que vous avez à sauvegarder.

En informatique, la sauvegarde (backup en anglais)

est l'opération qui consiste à dupliquer et à mettre en

sécurité les données contenues dans un système

informatique.

(6) Pierre-Alain Goupille, Technologie des

ordinateurs et des réseaux, éd. Masson, 2003

Page | 34

Ce terme est proche de deux notions :

> L'enregistrement des données, qui

est l'opération d'écriture des données sur un item

d'enregistrement durable, tel qu'un disque dur, une clé USB, des bandes

magnétiques, etc.

> L'archivage, qui consiste à

enregistrer des données sur un support à des fins légales

ou historiques.

La sauvegarde passe forcément par un enregistrement des

données, mais pas nécessairement dans un but d'archivage.

III.1.1 Finalité

Les copies de sûreté sont utiles principalement

à deux choses :

> La première et la plus

évidente est de permettre de restaurer un système informatique

dans un état de fonctionnement à la suite d'un incident (perte

d'un support de stockage tel que disque dur, bande magnétique, etc., ou

de tout ou partie des données qu'il contient).

> La seconde, incluse dans la

première mais certainement la plus courante, est de faciliter la

restauration d'une partie d'un système informatique (un fichier, un

groupe de fichiers, un système d'exploitation, une donnée dans un

fichier, etc.) à la suite d'une suppression accidentelle ou d'une

modification non désirée.

La technique la plus fréquente est la recopie des

données sur un support indépendant du système initial

(ordinateur local, serveur, etc.). L'opération inverse qui consiste

à réutiliser des données sauvegardées s'appelle une

restauration. On parle de « stockage » pour les données

sauvegardées en attente d'une éventuelle restauration.

III.1.2. Critères de choix

Le choix d'une technique de sauvegarde se fera en prenant en

compte :

> La capacité de stockage du support

(le volume d'information) ;

> La vitesse de sauvegarde ;

> La fiabilité du support (notamment

après une longue période de

stockage) ;

> La simplicité de classement ;

> La facilité à restaurer les

données ;

> Et bien sûr le coût de

l'ensemble.

Page | 35

Intervient également la possibilité de

sélectionner les données à sauvegarder. Enfin pour les

grands systèmes de sauvegarde, il faut tenir compte de critères

physiques : volume physique des supports de stockage, poids, sensibilité

à la température, à l'humidité, à la

poussière, à la lumière.

III.2. Stratégies de sauvegarde

On distingue la sauvegarde d'un poste individuel et la

sauvegarde sur serveur. L'une et l'autre s'adressent à la même

nature d'information (la donnée informatique) et ont le même

objectif (protéger l'information et permettre de la retrouver si elle

était perdue), mais les méthodes de sauvegarde sont

différentes pour plusieurs raisons :

? Les données sur poste client sont

réputées moins importantes que les données

gérées sur des systèmes centraux ;

? Les utilisateurs sont moins

sensibilisés au risque de perte de données que les professionnels

de l'informatique ;

? Ils ont également moins de formation

sur les techniques de sauvegarde ;

? Les moyens techniques sont moins

développés sur poste individuel que sur serveur, même si

des progrès importants ont été réalisés ces

dernières années (chute du rapport coût/volume des supports

de sauvegarde, simplification des interfaces de sauvegarde, sauvegarde sans

intervention de l'utilisateur, etc.)

De fait la sauvegarde des données des postes

individuels reste marginale dans la stratégie d'utilisation des

ordinateurs. Cependant les entreprises, en généralisant l'usage

des micro-ordinateurs et du partage des ressources en réseau, ont

ressenti un besoin de sécurité qui a favorisé le

développement d'outils de sauvegarde sur micro-ordinateurs, lesquels

gagnent petit à petit le monde de la micro-informatique personnelle.

III.2.1. Sauvegarde sur serveur

La sauvegarde s'inscrit dans une démarche plus globale

qui consiste à assurer la continuité d'activité d'un

système informatique ou, en cas de défaillance, son

redémarrage le plus vite possible. Cette démarche est souvent

formalisée dans un document qui peut porter des noms divers, par exemple

le Plan de reprise d'activité (PRA) ou le plan de secours, et qui fait

appel soit à des automatismes (ex. donner l'alerte en cas de coupure de

courant ou de perte d'accès à une unité de stockage) soit

à des gestes manuels (ex. remplacer des bandes magnétiques

défectueuses). La tendance est à l'automatisation,

réputée plus sûre dans les situations d'urgence que les

opérations manuelles.

Page | 36

En termes de support, les serveurs ont depuis toujours requis

des supports à grande capacité de stockage. La bande

magnétique a longtemps été le principal vecteur, du fait

de sa grande capacité, de son coût faible (par rapport aux autres

supports), de sa capacité de réutilisation et de sa relative

stabilité au temps et à l'usure. Puis sont venus les

cartouches numériques (bandes magnétiques intégrées

dans un boîtier plastique type DAT, DLT, SDLT, LTO), les disques durs et

plus récemment les médias optiques, réinscriptibles ou

non, tels que les CD-R, DVD-R ou formats similaires.

III.2.2. Sauvegarde sur système client

Au cours des années 1975-95, la plupart des

utilisateurs d'ordinateurs personnels (PC) associaient principalement le terme

"backup" au fait de faire des copies sur disquettes. Avec le

développement de micro-ordinateurs mieux équipés, les

utilisateurs personnels ont adopté des supports plus performants :

disques optiques (CD-ROM ou DVD), clés USB. De même, les

ordinateurs intègrent des fonctions de sauvegarde de plus en plus

évoluées, par exemple :

? Des outils intégrés au

système d'exploitation tels que les "points de restauration" que l'on

peut exécuter avant d'installer un nouveau logiciel et qui remettront le

système en l'état d'avant l'installation si l'utilisateur le

demande ;

? Des logiciels capables de faire une image

parfaite du système à un moment donné (image

appelée un "ghost", en référence au logiciel du même

nom, mot qui signifie "fantôme" en anglais) ; cette image sera

stockée sur l'ordinateur lui-même ou sur un support externe.

III.2.3. Sauvegarde sur Internet

Avec la banalisation des connexions Internet à large

bande et à haut débit, de plus en plus d'utilisateurs recourent

à ce type de service de sauvegarde. On peut différencier deux

méthodes:

III.2.4. Sauvegarde en ligne

Aujourd'hui, les copies de sûreté dites « en

ligne »1 deviennent populaires. Elles consistent à se

connecter à un site Internet, appelé « hébergeur

», et à y transférer ses données. Les avantages sont

multiples :

? minimiser le risque de perte puisque le

site est géré par un professionnel qui fait lui-même des

sauvegardes ;

? accéder à ses données

à partir de n'importe quel ordinateur connecté à Internet

;

? souvent le coût de cette prestation

est modique, parfois même gratuit pour les petites sauvegardes.

Page | 37

Sur le marché de la sauvegarde de données, les

entreprises et administrations expriment des attentes spécifiques

vis-à-vis des acteurs du marché, si bien qu'elles se tournent en

priorité vers des intégrateurs, des éditeurs de solutions

de sauvegarde, des fournisseurs d'infrastructure matérielle et des

fournisseurs de services d'externalisation de sauvegarde, voire vers des

prestataires couvrant un spectre complet d'expertises dans le domaine de la

sauvegarde ainsi que de services à distance2.

L'inconvénient majeur du recours à ces solutions

est de laisser ses données à disposition d'un tiers qui peut

à loisir les consulter, les modifier, les dupliquer, les publier ou en

faire commerce, voire les rendre indisponibles (cas des faillites, rachats de

sites par des concurrents, ou différend commercial avec

l'hébergeur). Évidemment, des dispositions contractuelles

viennent réguler ces risques mais elles ne peuvent empêcher

l'hébergeur d'agir techniquement de façon malveillante. Une des

parades à la consultation abusive consiste à chiffrer / crypter

les données.

Un autre inconvénient vient des limites imposées

sur le stockage ou la récupération des données : pour

maîtriser l'usage de ses disques et de sa bande passante, un

hébergeur peut limiter contractuellement son client à un volume

de stockage ou de données consultées au-delà duquel il

bloque l'accès aux données.

Les critères importants à retenir dans

l'utilisation de ce processus de sauvegarde en ligne sont les suivants :

1. Les données doivent être

cryptées/chiffrées avant de remonter via Internet chez

l'hébergeur. Cela empêche le prestataire d'exploiter les

données du client par définition ;

2. L'hébergeur se doit d'avoir deux copies de vos

données, pour se prémunir aussi d'une panne de son

côté (si possible sur des réseaux informatiques distincts,

sur des réseaux électriques indépendants, voire sur deux

infrastructures géographiques distantes). Ne pas oublier que, si le

client a une panne en même temps que le prestataire, la solution devient

caduque pour le client dans ce cas de figure ;

3. L'hébergeur doit avoir vis-à-vis des

professionnels une assurance « Responsabilité d'exploitation »

adéquate avec le service proposé, afin que le client dans un cas

ultime « puisse être couvert » ;

4. Le tarif des solutions n'est pas le plus important. Il

faut d'abord et surtout compter sur la mise à disposition des

données et la couverture du prestataire.

Page | 38

III.2.5. Sauvegarde en pair à pair

L'évolution des méthodes d'échange de

fichier rend possible depuis un certain temps la sauvegarde en mode « pair

à pair ». Cette technique s'appuie sur un service collaboratif

où chacun protège ses données sur les espaces de stockage

des autres.

Les avantages sont multiples :

> Le risque de perte est minimisé et

on dispose d'une protection à

distance répondant aux problèmes de vol, incendie,

inondation ;

> Les espaces de stockage ne sont pas

limités en taille ;

> Le service est entièrement gratuit

;

> La sauvegarde est entièrement

automatisée et périodique.

L'inconvénient majeur de cette technique est qu'elle

s'adresse uniquement aux particuliers. Elle ne répond pas aux besoins

des entreprises. Il faut veiller à ce que les données soient

entièrement chiffrées afin de les rendre illisibles sur les

espaces de stockage des autres. Cette technique doit s'inscrire au sein de

groupes de confiance.

III.3. Méthodes (Types) de sauvegarde les plus

courantes

La méthode la plus simple est la sauvegarde

complète ou totale (appelée aussi "full backup") ; elle consiste

à copier toutes les données à sauvegarder que celles-ci

soient récentes, anciennes, modifiées ou non.

Cette méthode est aussi la plus fiable mais elle est

longue et très coûteuse en termes d'espace disque, ce qui

empêche de l'utiliser en pratique pour toutes les sauvegardes à

effectuer. Afin de gagner en rapidité et en temps de sauvegarde, il

existe des méthodes qui procèdent à la sauvegarde des

seules données modifiées et/ou ajoutées entre deux

sauvegardes totales.

On en recense deux :

> La sauvegarde différentielle ;

> La sauvegarde incrémentielle.

La restauration d'un disque avec l'une de ces méthodes

s'avère plus longue et plus fastidieuse puisqu'en plus de la

restauration de la sauvegarde différentielle ou des sauvegardes

incrémentielles, on doit également restaurer la dernière

sauvegarde complète. Les fichiers supprimés entre-temps seront

restaurés ou non (en fonction des fonctionnalités du logiciel de

sauvegarde utilisé).

Page | 39

Afin de comprendre la différence entre les deux

méthodes, nous prendrons l'exemple d'un plan de sauvegarde selon le

cycle suivant :

? Une sauvegarde complète au jour J

(dimanche soir par exemple)

? Une sauvegarde des fichiers modifiés ou

nouveaux du jour J+1 au jour J+6 (du lundi soir au samedi soir inclus)

? Une sauvegarde complète au jour J+7

(dimanche soir suivant).

<

Mécanisme

Pour pouvoir différencier ces différentes

méthodes de sauvegarde/archivage (complète,

incrémentielle, différentielle), le mécanisme mis en place

est l'utilisation d'un marqueur d'archivage. Chaque fichier possède ce

marqueur d'archivage, qui est positionné à "vrai" lorsque l'on

crée ou modifie un fichier.

On peut comprendre cette position comme "Je viens d'être

modifié ou créé : je suis prêt à être

archivé donc je positionne mon marqueur à vrai". Ce marqueur est

appelé aussi attribut d'archivage (ou bit d'archivage). Sous Windows,

cet attribut est modifiable et peut être visualisé par la commande

ATTRIB (attribut A pour archive). Le système de sauvegarde peut aussi

constituer une base de données contenant les définitions des

fichiers et utiliser un marquage interne.

III.3.1. Sauvegarde complète

Lors d'une sauvegarde complète, on va remettre à

"0" l'attribut du fichier pour mémoriser le fait que le fichier a

été enregistré. Lorsque l'on travaille avec la date, on

mémorise la date de la dernière sauvegarde de façon

à pouvoir différencier les fichiers qui ont été

sauvegardés des autres (date de dernière modification).

III.3.2. Sauvegarde différentielle

La sauvegarde différentielle effectue une copie des

fichiers créés ou modifiés depuis la dernière

sauvegarde complète, quelles que soient les sauvegardes

intermédiaires. En d'autres termes, la sauvegarde complète du

jour J sert de référence pour identifier les fichiers

créés, modifiés ou ajoutés et ainsi ne sauvegarder

que ces derniers du jour J+1 au jour J+6.

La restauration faite à partir de ce type de sauvegarde

nécessite la recopie sur disque de la dernière sauvegarde

complète et de la sauvegarde différentielle la plus

récente.

Page | 40

Avec notre exemple, si la restauration se porte sur un disque

complet qui a été sauvegardé le jour J+2, on doit alors

recopier sur disque la sauvegarde complète du jour J et la sauvegarde

différentielle du jour J+2 afin d'avoir la dernière version des

données.

Cependant lorsqu'il s'agit de la restauration d'un fichier ou

d'un répertoire qui a été sauvegardé le jour J+2

seule la dernière sauvegarde, ici la différentielle, est

utile.

III.3.3. Sauvegarde incrémentale ou

incrémentielle

Cette méthode consiste à sauvegarder les

fichiers créés ou modifiés depuis la dernière

sauvegarde quelque soit son type (complet, différentiel ou

incrémentiel).

Exemple : une sauvegarde complète est

réalisée le jour J. Le jour

J+1, la sauvegarde incrémentielle est

réalisée par référence au jour J. Le jour

J+2, la sauvegarde incrémentielle est

réalisée par référence au jour J+1. Et ainsi de

suite.

Si la restauration se porte sur un disque complet qui a

été sauvegardé le jour J+4, on doit alors recopier sur

disque la sauvegarde du jour J et les sauvegardes incrémentielles des

jours J+1, J+2, J+3 et J+4 afin d'obtenir la dernière version de la

totalité des données.

Cependant lorsqu'il s'agit de la restauration d'un fichier ou

d'un répertoire qui a été sauvegardé le jour J+3,

seule la dernière sauvegarde, ici l'incrémentielle, est utile.

La sauvegarde incrémentale peut également porter

sur les seuls octets modifiés des fichiers à sauvegarder. On

parle alors de sauvegarde incrémentale octet. Cette méthode est

celle qui permet d'optimiser le plus l'utilisation de la bande passante. Elle

rend possible la sauvegarde de fichiers de plusieurs Giga-octets, puisque seul

un pourcentage minime du volume est transféré à chaque

fois sur la plateforme de sauvegarde.

III.3.4. Sauvegarde archivage et

rétention

La rétention permet de faire la différence entre

sauvegarde et

archivage.

La rétention est le temps pendant lequel la

donnée sauvegardée est conservée intacte. Un travail de

rétention courte est assimilé à un travail de sauvegarde

classique : la donnée est protégée contre sa

disparition/son altération. Un travail de rétention longue (une

ou plusieurs années) est

Page | 41

Assimilé à un travail d'archivage et aura pour

but de retrouver la donnée à une date précise, sur demande

express.

Exemple : une rétention de 4 semaines implique que

l'instance des données sauvegardées à une date

précise sera toujours disponible jusqu'à 28 jours après

leur sauvegarde. Après ces 28 jours, d'un point de vue logique, les

données n'existent plus dans le système de sauvegarde et sont