|

L'intelligence artificielle : outil de la

gestion

des connaissances

Thèse professionnelle

Comment automatiser la classification d'une

base

documentaire grâce au Machine Learning ?

|

Jamal EL MAHDALI

MASTERE SPECIALISÉ

MANAGEMENT DES SYSTEMES D'INFORMATION

DÉCEMBRE 2018

|

|

1

Remerciements

La réalisation de ce mémoire a été

possible grâce au concours de plusieurs personnes à qui je

voudrais témoigner toute ma reconnaissance.

Je remercie bien sûr mon tuteur école, Alain RIVET,

pour ses conseils dans l'approche de cette étude.

Le sujet de l'étude a été proposé par

TCS et je tiens à remercier Hervé LEBEL, Manager, et Charles

SIMILIA, Directeur de projets pour leur participation.

Mes remerciements vont aussi à tous les professionnels qui

ont accepté de partager leur expérience.

Enfin, je suis reconnaissant envers ma famille et mes proches qui

m'ont encouragé et soutenu dans cette entreprise. Et je tiens à

remercier particulièrement mon épouse pour son soutien et sa

patience sans lesquels ce travail n'aurait pu aboutir.

2

Résumé

Cette étude a pour objectif de proposer une

série de recommandations dans le cadre d'un projet pilote, pour

automatiser la classification d'une masse importante de documents textuels. Les

méthodes utilisées dans ce mémoire sont classiques,

à savoir une revue de littérature complétée par une

série d'entretiens avec des professionnels.

A l'époque de l'économie de la connaissance,

l'enjeu de la gestion des connaissances et en particulier de la gestion

d'information est crucial pour les entreprises. L'accès aux documents,

support de la connaissance explicite, est de plus en plus difficile pour les

utilisateurs, eu égard à l'infobésité galopante et

à la structure hiérarchique des bases documentaires

étouffées par les strates accumulées au fil des

années.

Certaines entreprises profitent des opportunités

offertes par la transformation digitale pour basculer leurs bases

documentaires, importante partie de leur patrimoine informationnel, vers des

solutions cloud de type ECM afin de mieux les gérer. Ces nouveaux outils

issus du web 2.0 apportent une multitude de fonctionnalités qui

permettent d'accroître la productivité des utilisateurs, en

facilitant le transfert des connaissances. L'accès aux informations sur

ces outils est facilité par une organisation de la connaissance

basée sur l'étiquetage des documents, via la méthode des

métadonnées. Ces nouveautés apportent leur lot de

changements d'usage qu'il faut gérer avec une stratégie de

conduite du changement.

Une autre problématique, plus technique, empêche

la faisabilité du projet. D'une part, l'étiquetage de documents

est difficilement automatisable, car la complexité de la tâche

requiert un système de règles dont le coût ne serait pas

justifié. D'autre part, la quantité astronomique de documents

à étiqueter n'est pas réalisable manuellement, ce qui

mène le projet à une impasse.

Une discipline, très médiatisée ces

derniers temps, propose des solutions à ce type de problème,

c'est le Machine Learning. Ce domaine a connu des progrès spectaculaires

ces vingt dernières années, grâce aux progrès des

capacités de calcul et à l'explosion des données

disponibles. Ces méthodes sont totalement différentes des

solutions classiques, car elles se basent sur une démarche empirique qui

consiste à construire une solution qui imite le processus cognitif

humain simplement à partir d'exemples.

La littérature est relativement fournie à ce

sujet, surtout sur les aspects techniques. Nous avons pu y relever un certain

nombre de spécificités propres au traitement de données

textuelles, ainsi que d'autres comme l'implication des métiers au point

de le faire participer aux tâches de construction de la solution.

Le retour d'expérience des professionnels valide en

grande partie les informations issues de la littérature, et

complète celle-ci par certaines informations concernant les aspects

organisationnels à appliquer dans le cadre de cette démarche.

Nous n'avons pas relevé de contradictions dans cette

étude entre la littérature et le monde professionnel, ce qui a

facilité la rédaction des recommandations. Ces dernières

font un focus sur les méthodes et techniques à privilégier

dans le cadre de la modélisation d'une solution de classification

automatique de documents.

3

Table des matières

Remerciements 1

Résumé 2

Table des matières 3

Table des figures 5

Liste des tableaux 5

1 INTRODUCTION GENERALE 6

1.1 Contexte de l'étude 7

1.1.1 Etat des lieux 7

1.1.2 Les bases documentaires IT 7

1.2 Problématique 8

1.2.1 Questions de recherche 8

1.3 Méthodologique 9

1.3.1 Revues de littératures 9

1.3.2 Entretiens 9

2 GESTION DES CONNAISSANCES ET CLASSIFICATION 11

2.1 La gestion des connaissances 11

2.1.1 Définition du KM 11

2.1.2 La connaissance 12

2.1.3 Création et transfert de la connaissance 13

2.2 Gestion documentaire 14

2.2.1 Outils et méthodes 14

2.2.2 Classification de documents 16

2.2.3 Accès à l'information 16

2.2.4 Métadonnée 17

2.3 Etiquetage manuel 17

2.4 Conclusion 18

3 L'INTELLIGENCE ARTIFICIELLE ET LA CLASSIFICATION DE DOCUMENTS

19

3.1 L'intelligence artificielle 19

3.1.1 Différentes définitions 19

3.1.2 Historique de l'intelligence artificielle 19

3.1.3 L'intelligence artificielle est déjà

là ! 20

3.1.4 Enjeux pour les entreprises 21

3.2 Les domaines de l'intelligence artificielle 22

3.2.1 Les approches 23

4

3.2.2 Les sous-domaines de l'intelligence artificielle 23

3.3 La classification de document 25

3.4 Le traitement automatique du langage naturel 25

3.5 Le Machine Learning 26

3.5.1 Les modes d'apprentissage et les types de problèmes

à résoudre 27

3.5.2 Les étapes du Machine Learning supervisé

27

3.5.3 Les données 29

3.5.4 Les algorithmes utilisés en Machine Learning 30

3.5.5 Algorithmes adaptés à la classification de

document textuel 32

3.5.6 La mesure des performances du modèle 33

3.5.7 Leviers d'ajustement 35

3.6 Spécificités de la classification de texte

37

3.6.1 Etapes du pré-traitement des données

textuelles 37

3.7 Outils 40

3.8 Conclusion 41

4 ENTRETIENS 42

4.1 Aspect projet 42

4.1.1 Quelle méthode de projet choisir ? 42

4.1.2 Phase de cadrage 42

4.1.3 Quels sont les rôles et compétences

nécessaires ? 43

4.1.4 Comment définir la qualité du livrable ?

43

4.1.5 Comment estimer l'opportunité ? 43

4.1.6 Quels sont les principaux risques ? 44

4.1.7 Faut-il prévoir une MCO particulière ? 44

4.2 Aspect technique 45

4.2.1 Comment préparer les données ? 45

4.2.2 Choix de l'algorithme 45

4.2.3 Validation et régularisation du classifieur 46

4.2.4 Outillage 46

4.3 Conclusion 47

5 RECOMMANDATIONS SYNTHÉTISÉES 48

6 CONCLUSION 50

BIBLIOGRAPHIE 52

ANNEXE 58

5

Table des figures

FIGURE 1- INTERDISCIPLINARITE DE LA GESTION DES CONNAISSANCES

(DALKIR, 2013) 12

FIGURE 2 - PYRAMIDE DIKW (ERMINE, ET AL., 2012) 12

FIGURE 3 - MODELE SECI (NONAKA, ET AL., 2000) 13

FIGURE 4 - CYCLE CONNAISSANCE-INFORMATION (BLUMENTRITT &

JOHNSTON, 1999) 14

FIGURE 5 - INTEGRATION DE LA GESTION DOCUMENTAIRE DANS L'ECM

(KATUU, 2012) 15

FIGURE 6 - CYCLE DE VIE DU DOCUMENT (CABANAC & AL, 2006)

16

FIGURE 7 - ADOPTION DE L'IA PAR LES ENTREPRISES (MIT, 2017) 21

FIGURE 8 - CHAMPS DE L'IA (VILLANUEVA & SALENGA, 2018) 23

FIGURE 9 - L'IA : UNE INTERCONNEXION D'APPLICATIONS, DE DOMAINES

ET DE METHODES (SEE, 2016) 24

FIGURE 10 - LA CLASSIFICATION, A LA CROISEE DES CHEMINS DE L'IA

25

FIGURE 11 - LES DEUX PHASES DE L'APPRENTISSAGE AUTOMATIQUE

(CHAOUCHE, 2018) 26

FIGURE 12 - ETAPES DE MODELISATION D'UN CLASSIFIEUR 28

FIGURE 13 - IMPORTANCE DES DONNEES PAR RAPPORT AUX ALGORITHMES

(BANKO ET BRILL - 2001) 29

FIGURE 14 - EXEMPLE DE MATRICE DE CONFUSION ACCOMPAGNEE DE LA

F-MESURE (F1) (AWS, S.D.) 35

FIGURE 15 - CONSEQUENCES DU SOUS-APPRENTISSAGE ET DU

SUR-APPRENTISSAGE SUR LE TAUX D'ERREUR (AL-BEHADILI, ET AL.,

2018) 35

FIGURE 16 - PROCESSUS DE MODELISATION D'UN CLASSIFIEUR (OSISANWO,

2017) 36

FIGURE 17 - PRE-TRAITEMENT DES DONNEES TEXTUELLES 37

FIGURE 18 - ETAPES DU PRE-TRAITEMENT DES DONNEES TEXTUELLES

(OSISANWO, 2017) 38

FIGURE 19 - COMPARAISON DES MLAAS DE AWS, MS, GOOGLE ET IBM

(ALTEXSOFT, 2018) 40

FIGURE 20 - AZURE ML TEXT CLASSIFICATION WORKFLOW (ABDEL-HADY,

2015) 40

Liste des tableaux

TABLEAU 1 - REPRESENTATION DES DONNEES SOUS FORME D'UNE MATRICE

(BIERNAT & LUTZ, 2015) 30

TABLEAU 2 - EXEMPLES D'ALGORITHMES (BIERNAT & LUTZ, 2015)

31

TABLEAU 3 - MATRICE DE CONFUSION 34

TABLEAU 4 - MATRICE DOCUMENT-TERMES 39

6

1 INTRODUCTION GENERALE

La maxime "Scientia potentia est"1 est plus

pertinente que jamais dans le monde d'aujourd'hui. Ce qu'une entreprise sait

est souvent plus important que ce qu'elle produit. La bonne gestion des

connaissances au sein des organisations est une question stratégique,

plus encore pour le domaine de l'informatique, car marqué par une

rotation des employés et des technologies. Dans ce secteur, le

patrimoine informationnel doit être maintenu pour garantir sa

qualité et en faciliter sa circulation. Malheureusement encore trop

d'entreprises stockent leurs documents sur des serveurs bureautique, se coupant

ainsi de l'apport des technologies du web 2.0, connues pour faciliter

l'échange informationnel et la collaboration.

Une grande entreprise consciente de l'enjeux a

décidé d'actionner ce levier. La DSI2 de cette

organisation a pris la décision de basculer ses bases documentaires vers

la solution cloud SharePoint Online. Pour bénéficier des

fonctionnalités de recherche de SharePoint, les documents doivent tous

être taggués (étiquetés) avec leur(s)

catégorie(s) en utilisant les métadonnées. Pour valider la

faisabilité de ce projet, une opération pilote sur les bases

documentaires du département EUS3 de la DSI doit être

effectuée. Cette opération ne peut pas être

effectuée manuellement, car le corpus compte plusieurs dizaines de

milliers de documents, il faut donc automatiser cette tâche.

Avec l'arrivée de l'intelligence artificielle,

l'automatisation n'est plus confinée aux seules tâches courantes,

les progrès rapides dans ce domaine annoncent le remplacement d'un plus

grand nombre d'activités par des machines. Ainsi elle ouvre

d'innombrables perspectives aux entreprises en termes de productivité.

Des spécialistes de renom proposent d'explorer ces opportunités

pour améliorer la performance de la gestion des connaissances. Parmi ces

solutions, le Machine Learning est la discipline qui se distingue le plus. Elle

s'est considérablement développée au cours des quinze

dernières années en raison de la croissance de la puissance de

calcul disponible ainsi que des progrès réalisés dans la

conception d'algorithmes.

Il nous parait nécessaire d'explorer cette

méthode pour savoir si elle peut solutionner notre problème, et

si oui, comment ?

Nous commencerons par une revue de littérature qui va

porter dans un premier temps, sur l'enjeu pour les entreprises de gérer

efficacement leur capital informationnel, ensuite nous étudierons le

rôle que joue la classification dans la gestion d'information. Dans un

deuxième temps, nous essayerons de comprendre ce qu'est l'intelligence

artificielle avant de passer au coeur de la partie théorique,

c-à-d rechercher les méthodes du Machine Learning applicables au

domaine de la gestion documentaire, et plus particulièrement à la

classification de documents.

Nous compléterons la revue de littérature par

une série d'entretiens auprès de professionnels du secteur pour

collecter des retours d'expériences, qui ne sont pas légion dans

ce domaine.

Enfin, l'analyse des résultats de cette recherche

permettra de proposer des recommandations.

1 Le savoir est pouvoir

2 Direction des systèmes d'information

3 End User Services : support aux utilisateurs

7

1.1 Contexte de l'étude

Dans le cadre d'un projet de transformation digitale,

l'entreprise TCS4 recherche une solution pour préparer la

migration des bases documentaires d'une grande entreprise française vers

le cloud. Le premier objectif est l'identification et la classification des

bases de connaissances, le deuxième est l'implémentation d'un

outil pour aider l'utilisateur à mieux classer les nouveaux documents.

Afin d'atteindre cet objectif, TCS souhaite intégrer une solution de

classification automatique basée sur l'intelligence artificielle. Cette

étude a pour objectif d'éclairer le sujet à travers une

série de recommandations.

1.1.1 Etat des lieux

La DSI du groupe a décidé de transférer

une partie de son patrimoine informationnel, composé de nombreuses bases

documentaires actuellement stockées sur ses serveurs, vers le cloud,

plus précisément vers la solution ECM5 de Microsoft :

SharePoint Online. Le but est de promouvoir un usage des informations contenues

dans les documents qui soit plus intuitif et collaboratif. La

problématique principale consiste à préparer cette

migration, en effet, les bases documentaires ne sont pas

systématiquement structurées de façon hiérarchique,

c-à-d que les documents sont éparpillés sur

différents dossiers partagés. Il faut trouver une solution pour

classifier ces documents avant de les transférer sur le cloud. Une autre

problématique concerne l'implémentation d'une solution

d'assistance « en ligne » complétement automatisée, qui

aidera les utilisateurs à mieux classer leurs nouveaux documents sur le

cloud, ce deuxième point ne sera pas abordé dans cette

étude.

La contrainte principale est le temps nécessaire pour

classer manuellement les éléments de ces bases documentaires, car

d'une part, le nombre de fichiers à classer est important et d'autre

part, la tâche de classification manuelle prend du temps eu égard

au processus cognitif nécessaire pour classer un document dans la bonne

catégorie. Or, l'entreprise n'a ni le temps ni le budget suffisant pour

préparer les bases documentaires manuellement.

1.1.2 Les bases documentaires IT

La gestion des connaissances dans le domaine de l'informatique

est importante, les bases documentaires le sont aussi parce qu'elles sont le

support principal du transfert de l'information et donc des connaissances. Une

bonne gestion des connaissances répond aux contraintes inhérentes

de la vie d'un service informatique, notamment :

4 TATA Consultancy Services

5 Entreprise Content Management

·

8

L'obsolescence technologique : Le domaine informatique est

très dépendant de la technologie. Contrairement à d'autres

métiers, il faut régulièrement mettre à jour les

outils, mais aussi les compétences des collaborateurs. En effet,

l'obsolescence des compétences est un phénomène qui

survient régulièrement à la suite d'une évolution

technologique (Geyer, 2017).

· Le turn-over : Le taux de turn-over dans le secteur

informatique est le plus élevé du marché, avec près

de 20% (Lo, 2014) , il n'est pas nouveau et est propre au secteur, les

entreprises doivent éviter de perdre une partie de leurs connaissances

avec le départ de collaborateurs (Chafiqi & El Moustafid, 2006).

· L'externalisation : 90% des entreprises en France ont

eu recours à l'externalisation de leur informatique, ce type

d'activité est marqué par un niveau d'externalisation

élevé (ABSYS, 2016), il faut gérer au mieux la transition

entre les fournisseurs, notamment le transfert des connaissances (Grim-Yefsah,

et al., 2010).

De façon générale, les acteurs du domaine

de l'informatique sont soucieux du niveau de qualité de leur base de

connaissances (Jäntti & Cater-Steel, 2017).

1.2 Problématique

Quelles sont les bonnes pratiques qui permettent de

réussir l'implémentation d'une solution basée sur

l'intelligence artificielle pour automatiser la classification d'une base

documentaire ?

1.2.1 Questions de recherche

Dans un premier temps, nous essayerons de comprendre

l'importance de la classification des données dans le cadre de la

gestion des connaissances et plus particulièrement de la gestion

documentaire, ainsi que du rôle des métadonnées.

Question de recherche 1 : Quelle est

l'importance de la classification et du rôle des

métadonnées dans le domaine de la gestion des connaissances et en

particulier pour la gestion documentaire ?

Une seconde question permettra de comprendre ce qu'est

l'intelligence artificielle et les sous-domaines la composant afin de cibler

les méthodes applicables à notre étude.

Question de recherche 2 : Quelles

méthodes basées sur l'intelligence artificielle permettent

d'automatiser la tâche de classification manuelle des documents textuels

d'une base documentaire ?

Enfin, la dernière question devra mettre en exergue

les bonnes pratiques pour réussir l'implémentation d'une solution

basée sur l'intelligence artificielle, notamment dans le contexte de

notre étude, en utilisant les retours d'expériences d'experts

dans le domaine.

Question de recherche 3 : Quelles sont les

bonnes pratiques à appliquer pour réussir l'automatisation de la

classification de documents ?

9

1.3 Méthodologie

Une série de recommandations sera formulée dans le

chapitre 5 à partir de l'analyse de la revue de littérature et

des entretiens.

1.3.1.1 Revue de littérature

Nous abordons notre étude par une revue de

littérature qui va porter sur les grands thèmes de cette

problématique. Dans le chapitre 2, nous verrons l'importance que

requière la gestion des connaissances pour les entreprises, ensuite nous

ferons un focus sur le rôle de la gestion documentaire, puis nous

finirons sur les méthodes de structuration de bases documentaires et

leur importance. Dans le chapitre 3, nous verrons les enjeux de l'intelligence

artificielle pour les organisations, puis nous rechercherons les

méthodes du Machine Learning qui conviennent le mieux à notre

problématique.

1.3.2 Entretiens

Pour compléter la revue de littérature, des

données ont été collectées auprès

d'entreprises qui utilisent ou délivrent des services dans le domaine du

Machine Learning, à travers cinq entretiens semi-directifs.

L'entretien est une technique d'investigation qui nous permet

de recueillir des informations auprès de professionnels. Il existe trois

types d'entretiens, directif, non-directif et semi-directif, c'est ce dernier

qui a été choisi. La réalisation de l'entretien

semi-directif implique la prise en compte d'un certain nombre

d'éléments parmi lesquels figurent les buts de l'étude, le

cadre conceptuel, les questions de recherche (Imbert, 2010).

La méthode de l'entretien semi-directif a

été retenue car d'une part le sujet est assez cadré, et

d'autre part cela donne une plus grande liberté à

l'interrogé de développer sur des sujets non relevés dans

la revue de littérature.

Un guide d'entretien a été rédigé

grâce à la revue de littérature, il comporte vingt-quatre

questions et est divisé en deux parties, la première est

centrée sur les sujets d'ordre organisationnel tel que la gestion de

projet, la deuxième porte sur les aspects techniques de l'étude.

Les questions sont disponibles en annexe. Chaque entretien a duré

environ une heure.

Les entretiens ont été retranscrits,

analysés, codés et synthétisés. La synthèse

est présentée dans le chapitre 4 à travers dix sujets

répartis dans deux thèmes ; les questions relevant de la gestion

de projet, et celles consacrées aux méthodes techniques.

Présentation des fonctions des experts interrogés

ainsi que leur entreprise :

10

1.3.2.1 MS Azure CS

Consultant expert en data science, il travaille pour

l'éditeur Microsoft sur l'offre de service Microsoft Azure cognitive

services, qui est une plate-forme cloud du géant américain

dédiée à l'intégration et au développement

de solutions basées sur l'intelligence artificielle. (Microsoft,

2018)

1.3.2.2 Upfluence

Docteur en Machine Learning, il travaille pour une start-up

nommée Upfluence dont le coeur de métier est le marketing

d'influence sur Internet, cette entreprise utilise beaucoup les technologies de

l'intelligence artificielle, elle compte parmi ses clients de grandes

entreprises françaises. (Upfluence, 2018)

1.3.2.3 Antidot

Responsable R&D de l'entreprise Antidot, qui est un

éditeur spécialiste dans les solutions de recherche

d'accès à l'information, cette entreprise développe

notamment des solutions basées sur le Machine Learning. (Antidot,

2018)

1.3.2.4 Bull-Atos

Directeur innovation de l'agence Bull Atos de Grenoble, cette

entreprise est un géant des prestations de services numériques,

elle intervient dans le domaine du Machine Learning en déléguant

des spécialistes techniques auprès de clients grands comptes.

(Bull-Atos, 2018)

1.3.2.5 Sinequa

Consultants Machine Learning chez Sinequa, qui est un

éditeur de solutions basées sur les technologies de

l'intelligence artificielle, cette entreprise est spécialisée

dans l'intégration de moteurs de recherches d'entreprises et

développe des solutions basées sur le Machine Learning. (Sinequa,

2018)

Ces cinq entreprises ont en commun le fait de

développer des solutions basées sur le Machine Learning pour de

grandes organisations, ce qui correspond à notre contexte.

11

2 GESTION DES CONNAISSANCES ET CLASSIFICATION

A notre époque, les entreprises sont

confrontées à un environnement en perpétuelle

évolution, la capacité d'adaptation est devenue essentielle,

parmi les leviers de performance organisationnelle, la gestion des

connaissances joue un rôle important. La gestion documentaire est un

vecteur de transferts des connaissances. Elle connait une mutation au travers

des outils de dernière génération qui offrent des

fonctionnalités permettant d'améliorer la circulation des

connaissances, notamment en simplifiant l'accès aux documents.

2.1 La gestion des connaissances

D'après Jean-Louis Ermine, nous sommes entrés

depuis 20 ans dans l'économie de la connaissance, la prise en compte de

cette réalité pour les organisations n'est plus un choix mais une

nécessité (Ermine, 2018). Depuis la version 2015 de la norme ISO

9001, un chapitre concernant la connaissance a fait son apparition. Afin

d'être en règle, les organismes certifiés sont tenus de

mettre en place une gestion de la connaissance qu'ils considèrent comme

nécessaire à la mise en oeuvre de leurs processus. Le savoir et

la connaissance deviennent des ressources importantes pour l'organisation

(AFNOR, 2015).

Les entreprises sont donc confrontées à la

recherche de démarches spécifiques de gestion des connaissances,

que l'on désigne le plus souvent sous le nom de KM ou « knowledge

management » (Dudezert, 2013). Parmi les facteurs qui poussent les

organisations à adopter une démarche KM on retrouve (Dalkir,

2013) :

· La globalisation de l'économie qui exacerbe la

nécessité de trouver de nouveau levier pour se distinguer de la

concurrence

· L'impact des progrès technologiques de

l'informatique qui ont complexifié l'environnement de travail

· La mobilité des employés qui appauvrit

le capital connaissance

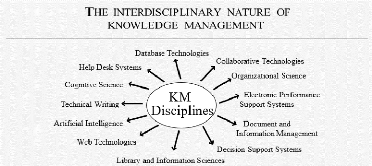

2.1.1 Définition du KM

Il n'y a pas de définition généralement

acceptée de la gestion des connaissances, mais la plupart des praticiens

et des professionnels s'accordent à dire que la gestion des

connaissances est le processus de création, de partage, d'utilisation

des connaissances et des informations d'une organisation (Girard & Girard,

2015). Le KM n'est pas une nouvelle démarche managériale, elle

est pratiquée dans une grande diversité de contextes sous

différentes appellations. Son champ d'application est large et

interconnecté avec de nombreuses disciplines comme le montre la figure 1

(Dalkir, 2013) :

12

Figure 1- interdisciplinarité de la gestion des

connaissances (Dalkir, 2013)

L'objectif principal de la gestion des connaissances est de

faciliter la circulation des informations entre l'organisation et les individus

en améliorant le travail de chacun et la connaissance métier.

Ceci dans le but de renforcer ou sauvegarder les compétences de

l'organisation. L'une des caractéristiques les plus importantes du KM

réside dans le fait qu'elle traite à la fois de la connaissance

et de l'information.

2.1.2 La connaissance

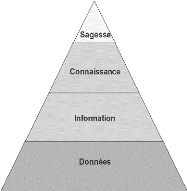

Figure 2 - Pyramide DIKW (Ermine, et al., 2012)

La description des constituants de la connaissance est un bon

moyen de définir la connaissance, la pyramide DIKW6 est la

façon la plus connue d'illustrer ses constituants. Cette

représentation suggère que les éléments

supérieurs dépendent de leur base, ainsi la connaissance est

construite à partir de l'information et celle-ci à partir de

données. (Ermine, et al., 2012)

Les données sont des faits bruts qui ont

été accumulés par des personnes ou des machines, elles

sont donc une collection de « faits » et de nombres bruts. Robert

Reix explique le lien entre les données et l'information : « passer

du monde des symboles à celui du sens, des significations, donc des

données à l'information, n'est pas automatique, mais se

réalise par l'intermédiaire de processus spécifiques

d'interprétation, de cognition » (Reix, 2016), l'information est

donc produite lorsque les données sont assez structurées et

organisées pour produire du sens. Enfin, la connaissance se construit

à partir de l'information. Pour un individu, le processus de

création de connaissances consiste à analyser, comprendre et

assimiler l'information pour en produire

6 Data, Information, knowledge and wisdom

13

une représentation personnelle. Du point de vue de

l'organisation, la connaissance est la faculté à donner aux

informations reliées un sens en son sein. Autrement dit, les

connaissances organisationnelles sont « un ensemble de connaissances

individuelles, spécifiques ou partagées » (Bouhedi,

2017).

2.1.3 Création et transfert de la connaissance

|

Selon la théorie de la création de la

connaissance dans les organisations (Nonaka et al., 1995), les connaissances

surgissent d'une interaction entre deux types de connaissances : les

connaissances explicites et les connaissances tacites.

La connaissance explicite fait référence au

« savoir » verbalisable, transmissible oralement ou par

l'écriture. La connaissance tacite se réfère plutôt

au « savoir-faire », c'est une connaissance pratique qui

résulte de l'expérience et se traduit par le geste.

|

|

|

Figure 3 - Modèle SECI (Nonaka, et al., 2000)

|

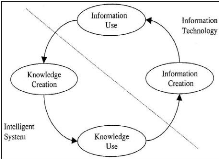

Ces connaissances circulent dans l'organisation selon un

processus de transfert. Le modèle SECI7

représenté ci-dessus est sans doute l'un des plus populaires. Il

décrit le processus de création et de transfert des connaissances

en quatre étapes :

1. La socialisation : processus de transfert du savoir tacite

entre individu

2. L'externalisation : formalisation sous forme de concept de

connaissances explicites

3. La combinaison : reformulation d'une donnée

explicite

4. L'internalisation : transfert des connaissances explicites

vers des connaissances tacites, ce processus correspond à

l'apprentissage et à la transformation du savoir vers le savoir-faire,

où les connaissances explicites transmises sont assimilées par

les individus qui acquièrent de nouvelles connaissances (Bouhedi,

2017).

7 SECI : Socialisation, Externalisation, Combination,

Internalisation

Cette dernière étape s'appuie sur les

connaissances explicites qui sont formalisées, codifiées,

transformées et partagées sous forme de documents ou de base de

données (Wallez, 2010). Autrement dit, la connaissance redevient de

l'information, ce qui permettra la sauvegarde et le transfert de celle-ci

à travers le cycle connaissance-information (fig. 4).

L'interaction entre le transfert de connaissances et le

stockage de connaissances est donc cruciale pour le KM (Jasimuddin, 2005). Pour

assurer cette mission, les organisations doivent disposer d'un

Figure 4 - Cycle connaissance-Information (Blumentritt &

Johnston, 1999)

14

mécanisme de partage des connaissances qui s'appuie sur

des documents électroniques sous forme de bases de connaissances

(Janicot & Mignon, 2008). Cette méthode de gestion est

communément appelée gestion documentaire ou GED qui est une

branche de la gestion des connaissances (Dalkir, 2013).

2.2 Gestion documentaire

Une organisation se doit de conserver certains contenus,

indispensables au maintien des activités de l'organisation, le chapitre

7.1.6 de la norme ISO 9001 (2015) en fait référence.

Le document est certainement le support de la connaissance le

plus connu. Selon la définition de l'ISO, un document est un ensemble

constitué d'un support d'informations et des données

enregistrées sur celui-ci sous une forme généralement

permanente et lisible par l'homme ou par une machine. Le document est donc la

conséquence de l'interaction d'une information, d'une connaissance et

d'un support. Ce support est souvent un document électronique sous forme

de fichier bureautique.

Ces documents peuvent former des bases de connaissances

(Janicot & Mignon, 2008), cependant, il est important de préciser

que parmi les documents, certains servent directement ou indirectement de

support de capitalisation de connaissances, mais d'autres ne le sont pas

(MAHÉ, et al., 2012).

La gestion de ces documents, est un enjeu de plus en plus

important pour les entreprises (Dupoirier, 2009), ainsi les systèmes de

gestion documentaire peuvent améliorer significativement la gouvernance

de l'information (Hubain, 2016) et par conséquent la performance du

KM.

2.2.1 Outils et méthodes

La gestion documentaire ou GED est le contrôle

automatisé des documents électroniques tout au long de leur cycle

de vie au sein d'une organisation, de la création à l'archivage

final (Nastase & al., 2009).

Figure 5 - Intégration de la gestion documentaire

dans l'ECM (Katuu, 2012)

Elle est à la fois une méthode et un outil qui

permet de gérer une base documentaire composée principalement de

fichiers bureautiques (Crozat, 2016). Sa fonction première est le

stockage des documents électroniques pour en assurer la qualité,

c-à-d la disponibilité, l'intégrité et la

confidentialité, conformément aux critères de

sécurité du système d'information DICP8 (Faris,

2013).

Depuis l'arrivée dans les organisations des outils du

web 2.0, on voit l'intégration de la gestion documentaire dans une

solution plus large qui englobe tous type de support d'information, on peut en

voir une représentation sur la figure 5. Cette méthode,

appelée ECM9, a pour but de centraliser l'information pour

faciliter la circulation des connaissances en favorisant le partage des

connaissances et la collaboration (Alalwan & Heinz, 2012).

Parmi les usages nouveaux, on peut citer la coédition,

la gestion du « versionning » et l'utilisation des

métadonnées pour classer les documents.

Mais ce genre d'applications n'est à la portée

que de grandes organisations. Microsoft a ainsi réalisé des

partenariats pour intégrer sa solution ECM SharePoint au sein des

grandes organisations. Cependant, la valeur ajoutée de ces solutions

n'est pas assez exploitée (Alalwan & Heinz, 2012), il est

nécessaire de revoir l'usage de ces applications, notamment la

façon d'organiser et d'exploiter ce type d'informations.

15

8 DICP : Disponibilité,

Intégrité, Confidentialité, Preuve

9 Enterprise Content Management

16

2.2.2 Classification de documents

Pour rappel, l'un des objectifs de la gestion des

connaissances est de faciliter la circulation des connaissances, à

travers notamment l'information contenue dans les bases documentaires.

|

La diffusion et l'exploitation sont au coeur du cycle de vie

du document comme le montre la figure 6 (Cabanac & al, 2006),

l'accessibilité des documents est une question importante, c'est

pourquoi la structure de la base documentaire doit être pensée de

façon à faciliter l'accès aux informations

recherchées, notamment en structurant la base documentaire de sorte que

le stockage et la recherche de documents soit le plus intuitif possible pour

les utilisateurs. L'organisation des documents a un impact important sur la

circulation des informations, alors, quelle structure choisir ?

|

|

|

Figure 6 - Cycle de vie du document (Cabanac & al,

2006)

|

D'après Michèle Hudon, il ne peut exister de

structure idéale et absolue pour organiser les connaissances, cependant

le processus d'organisation suppose presque toujours une opération de

classification.

La classification est la méthode classique de

structuration, elle est définie comme l'opération qui organise

des entités en classes, de sorte que les entités semblables ou

parentes soient regroupées et séparées des entités

non semblables ou étrangères. Par analogie, la classification

documentaire est donc l'opération qui consiste à regrouper en

classes les documents semblables ou liés, en les séparant des

documents avec lesquels ils n'entretiennent aucun lien ou n'ont aucune

caractéristique commune. Le plus souvent, la classification est

fondée sur la thématique du contenu du document (Hudon & El

Hadi, 2010).

La représentation des documents est propre à

chaque organisation, et dépend principalement du domaine métier

et de l'organisation interne.

2.2.3 Accès à l'information

Il existe, dans les organisations, deux types d'accès

à l'information : la navigation à travers une structure

hiérarchique et la recherche de documents (Voit, et al., 2011) :

· La navigation est la méthode classique. Elle

consiste à franchir une hiérarchie de dossiers

(représentants des catégories ou des classes) en naviguant

jusqu'au document contenant l'information. Comme toute structure

hiérarchique, elle est rigide, il n'est, par exemple, pas évident

de déplacer une sous-catégorie d'une catégorie à

une autre. De plus, un document ne correspond pas obligatoirement à une

seule catégorie (Francis & Quesnel, 2007).

· La recherche permet de retrouver et d'accéder

directement au document recherché. Les outils habituellement

utilisés s'appuient sur le mécanisme d'indexation. Le

système indexe en amont les informations contenues dans les documents,

l'utilisateur doit alors renseigner des éléments

caractérisant le document pour le retrouver, ce qui n'est pas

évident dans le cas d'indexation plein texte tel que proposé par

les systèmes d'exploitation.

L'augmentation de la quantité de documents rend la

classification d'une base documentaire plus complexe, il est alors

nécessaire de trouver une solution pour accéder plus facilement

à l'information. Les outils modernes comme l'ECM10 propose

une indexation intelligente des informations, ils tirent parti des

métadonnées pour améliorer la pertinence des recherches de

document.

2.2.4 Métadonnée

Les métadonnées, littéralement «

les données des données », sont les propriétés

d'un document, décrit sous trois aspects : technique, administratif et

descriptif. Les métadonnées permettent d'identifier chaque

document et de le relier à l'ensemble de la base (Westeel, 2010).

L'approche fondée sur les métadonnées

pour structurer une base documentaire n'utilise pas de dossiers pour organiser

le contenu. Les documents sont étiquetés avec

des valeurs descriptives telles que « classe de document », «

date de création », « utilisateur », « client

», « projet », « fournisseur », «

mots-clés », « description ». La structure des

métadonnées est entièrement personnalisable (

GED.fr, s.d.). Enfin, cette méthode

permet d'associer un document à plusieurs catégories.

La recherche basée sur l'indexation des

métadonnées facilite l'accès et l'échange

d'informations (Morel-Pair, 2005), et par conséquent améliore le

transfert de connaissances.

2.3 Etiquetage manuel

Nous venons de voir l'avantage d'utiliser la classification

par l'étiquetage des éléments composant une base

documentaire pour en faciliter l'exploitation, voyons maintenant comment

s'effectue une tâche d'étiquetage.

L'opération consiste à analyser le contenu pour

trouver des éléments distinctifs qui serviront à prendre

la décision de classer le document dans telle ou telle catégorie.

Ce processus, lorsqu'il est effectué par un humain peut être long

et donc couteux, surtout si la quantité de documents est importante. La

solution est alors de chercher à automatiser la tâche.

L'automatisation de ce genre de tâches est

réalisée habituellement en développant un logiciel. Cette

tâche de classification nécessite un certain niveau d'analyse qui

ne peut être traité par un programme informatique classique. En

effet, la complexité cognitive du traitement de l'information par

l'être humain n'est reproductible que par l'approche symbolique des

systèmes de règles aussi appelés

17

10 Entreprise Content Management

18

systèmes experts. Cependant, le temps et le coût

élevé de modélisation d'un tel système sont

inadaptés à notre situation.

Une autre approche dite numérique propose d'imiter ce

type de tâche, elle se base sur la notion d'apprentissage. K.C. Laudon

propose, pour améliorer la performance de la gestion des connaissances,

d'explorer les opportunités offertes par l'intelligence artificielle. Le

domaine du Machine Learning permet d'imiter l'intelligence humaine (Laudon,

2013).

2.4 Conclusion

Nous avons exploré le domaine de la gestion

documentaire qui est un enjeu important pour les organisations, en ce sens

qu'elle améliore la circulation de l'information métier. D'autre

part, les outils de gestion ECM propose une meilleure organisation de

l'information basée sur les métadonnées. Cette

méthode de recherche d'informations accélère grandement

l'accès aux informations contenues dans les bases documentaires.

Nous avons ainsi répondu à la première

question de recherches, dont l'objectif était de comprendre le sens du

projet de migration ainsi que la nécessité d'automatiser la

classification des documents à migrer. Nous allons maintenant nous

plonger dans le domaine de l'intelligence artificielle et notamment le Machine

Learning.

19

3 L'INTELLIGENCE ARTIFICIELLE ET LA CLASSIFICATION DE

DOCUMENTS

3.1 L'intelligence artificielle

L'intelligence artificielle est une technologie qui arrive

aujourd'hui à maturité (Panetta, 2018). Elle trouve des

débouchés croissants dans les entreprises qui la

considèrent comme un levier de compétitivité. Mais elle ne

touche pas que le monde des entreprises, elle est déjà

présente dans nos vies de tous les jours.

Alors, qu'est-ce que l'intelligence artificielle ?

3.1.1 Différentes définitions

Il est difficile de donner une définition unique de

l'intelligence artificielle car elle peut être abordée de

différentes manières, elle touche ainsi différentes

disciplines, tels que la philosophie, les mathématiques,

l'économie, les neurosciences, la psychologie ainsi que l'informatique

qui nous intéressera tout particulièrement dans cette

étude.

Il y a donc plusieurs définitions de l'intelligence

artificielle, mais en voici deux qui caractérisent bien les deux champs

couverts par l'intelligence artificielle dans notre sujet, la première

est issue du Mercator : « Discipline qui travaille sur les méthodes

et les programmes informatiques permettant de résoudre des tâches

complexes que les êtres humains accomplissent aujourd'hui en utilisant

des processus mentaux de haut niveau (comme l'apprentissage et le

raisonnement)» (Lendrevie & Lévy, 2014). La seconde est celle

de Cédric Vilani, député et célèbre

mathématicien qui a été chargé par le gouvernement

d'une mission sur l'intelligence artificielle : « L'intelligence

artificielle, c'est l'art de la programmation qui permet à un

algorithme, un ordinateur de réaliser des tâches subtiles en

tenant compte de nombreux paramètres » (Ceaux, 2018).

Pour résumer, l'intelligence artificielle est la mise

en oeuvre de solutions techniques pour automatiser des tâches complexes

nécessitant jusqu'alors l'intervention de l'homme.

Beaucoup pourraient croire que l'intelligence artificielle

est une innovation récente tellement le sujet est rabâché

à longueur d'articles depuis quelques années, elle n'est pourtant

pas un concept nouveau. La notion a été introduite il y a environ

70 ans.

3.1.2 Historique de l'intelligence artificielle

L'histoire de l'intelligence artificielle est parsemée

de succès, de déceptions et de prédictions non

réalisées. Dès 1950, Alan Turing tente d'établir un

critère permettant de juger de l'intelligence d'une

20

machine à travers le test dit « de Turing »,

il prédisait qu'en l'an 2000 personne ne pourrait distinguer les

réponses données par un homme ou un ordinateur (De Ganay &

Dominique, 2017). La naissance à proprement dit de l'intelligence

artificielle date de l'été 1956 sur le campus de Dartmouth

College aux USA durant lequel une dizaine de chercheurs définissent ce

nouveau domaine de recherche, et parmi eux John Mc Carthy et Marvin Lee Minsky

qui co-fondent en 1959 le groupe d'intelligence artificielle du MIT (MIT AI

Lab) grand artisan du développement de cette discipline (Russell &

Norvig, 2010).

Jusqu'au milieu des années 70, c'est l'euphorie, la

recherche n'a pas de mal à trouver du financement et les espoirs sont

grandissants. Certains experts prédisent même que « des

machines seront capables, d'ici 20 ans, de faire le travail que toute personne

peut faire ». Malheureusement les résultats ne seront pas au

rendez-vous, principalement à cause d'un manque de maturité des

algorithmes et aux faibles capacités du « hardware » de

l'époque. Les principaux financeurs se désengagent des

différents projets et la discipline connaitra un hiver qui durera

jusqu'aux années 90.

En parallèle, un nouveau type de solution apparait,

c'est le « système expert » qui est basé sur un

ensemble de règles configurées par des experts humains. Il

connaitra un succès certain avec par exemple, dans le domaine

médical MYCIN qui contenait 450 règles, ce système

réussissait à diagnostiquer à un niveau proche des experts

humains. Ces systèmes seront progressivement adoptés par

l'industrie dans les années 80 (Russell & Norvig, 2010).

A partir de 1987, l'intelligence artificielle adopte les

méthodes scientifiques, ce qui va accélérer les

progrès en la matière. La victoire du superordinateur d'IBM

« Deep Blue » sur le champion des échecs Garry Kasparov en

1997 marque un premier tournant en matière de progrès de

l'intelligence artificielle (Russell & Norvig, 2010). Les années

suivantes seront marquées par l'explosion de données disponibles,

qui, conjuguées aux progrès énormes en matière de

puissance de calcul vont booster cette discipline tout au long des

années 2000. La démonstration de la solution actuelle d'IBM

« Watson » qui gagne aux jeux de Jeopardy en 2011, et l'an dernier

celle de Google « AlphaGO Zero » au jeu de go en sont de belles

illustrations.

3.1.3 L'intelligence artificielle est déjà

là !

L'intelligence artificielle est longtemps restée

cloitrée dans un rôle d'expert, en effet les systèmes

experts ne se sont pas popularisés à cause du coût

prohibitif et du champ d'application limité à un certain niveau

de complexité. Depuis une quinzaine d'années, les progrès

du Machine Learning, la puissance de calcul et les données de plus en

plus disponibles ont permis de « démocratiser » l'usage de

l'intelligence artificielle. Aujourd'hui, ces solutions sont déjà

à l'oeuvre dans de nombreux domaines, en voici quelques exemples :

· Le géant Google a utilisé sa solution

phare « DeepMind » pour améliorer l'efficience

énergétique de ses datacenters. L'algorithme a été

entrainé avec plusieurs années de données de consommations

électriques et de données météorologiques. La

consommation électrique a diminué de 40% (MANAGERIS, 2018).

· Airbus a décidé d'implémenter de

l'intelligence artificielle dans la gestion des interruptions de productions de

son nouvel appareil l'A350. La solution a été

implémentée en intégrant toutes les données

historiques. Lorsqu'un problème survient, le système analyse les

données

21

contextuelles et donne à l'équipe une

recommandation. Cela a permis de réduire d'un tiers le temps

nécessaire à la gestion des interruptions de production (MIT,

2017).

· La société JobiJoba a

développé un outil basé sur l'intelligence artificielle

appelé "CV Catcher", celui-ci a déjà été

implémenté sur les sites de recrutement de 40 grandes entreprises

comme SFR, la SNCF et EDF. L'algorithme permet au candidat de connaitre,

immédiatement après avoir uploadé son CV, les postes

à pourvoir qui correspondent à son profil.

· Tout un chacun profite déjà de

l'implémentation de solution d'intelligence artificielle comme, le

filtre anti-spam de nos boites email, la traduction automatique en ligne, et

plus récemment avec l'apparition d'assistants virtuels sur nos

smartphones comme Siri, Google Assistant ou Cortana qui simplifie au quotidien

nos usages personnels.

Bien entendu, ces quelques exemples sont loin d'être

exhaustifs, notons néanmoins que le champ d'application des solutions

d'intelligence artificielle est vaste, car elles visent à

améliorer d'une manière générale la

productivité. C'est pourquoi de plus en plus d'entreprises

s'intéressent de près à ces solutions (MIT, 2017).

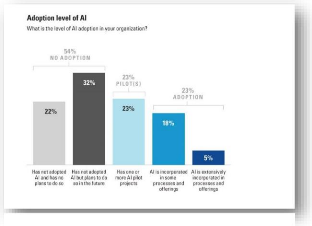

Figure 7 - Adoption de l'IA par les entreprises (MIT,

2017)

3.1.4 Enjeux pour les entreprises

Cette technologie n'en est qu'à ses débuts et

nous sommes encore loin de la phase d'intégration à grande

échelle dans les entreprises.

Une étude menée l'an dernier par le MIT

auprès de 3000 entreprises montre qu'il y a un grand écart entre

les ambitions et la mise en pratique en matière de

stratégie d'intelligence

artificielle (MIT, 2017)

ainsi 85% des dirigeants interrogés estiment que l'intelligence

artificielle leur permettra d'obtenir ou de conserver un avantage

concurrentiel, alors que 40% ont mis en place une stratégie

d'intelligence artificielle et seule une entreprise sur vingt a

intégré l'intelligence artificielle dans ses offres ou ses

processus (figure 7).

Avant de mettre en oeuvre une gouvernance de l'intelligence

artificielle, les entreprises attendent de tirer les leçons des

premières expériences (CIGREF, 2017). Et celles-ci montrent qu'il

y a des conditions à respecter pour réussir l'intégration

de solution d'intelligence artificielle, en voici quelques exemples :

·

22

Définir le besoin : La solution

à implémenter doit répondre à un besoin clairement

identifié, il convient de bien comprendre la problématique

business et de s'assurer que l'intelligence artificielle est capable de la

résoudre (Caseau, 2018).

· Disposer de données :

S'assurer de disposer de données en quantité et en

qualité. Il a été prouvé que la performance de ces

solutions est proportionnelle à la quantité de données

à disposition (Banko & Brill, 2001).

· Adopter une démarche empirique :

Les solutions « clés en main » n'existe pas en IA,

chaque solution doit s'imprégner du contexte métier du

problème à résoudre. Car aucun modèle et algorithme

ne fonctionne bien pour tous les problèmes, on parle du

théorème « No free lunch » (Wolpert & Macready,

1997).

· Acquérir les compétences

: L'implémentation d'une solution d'intelligence artificielle

demande l'intervention de profils spécifiques tel que les data

scientistes, qui doivent bien entendu être accompagnés par le

business afin de cadrer le besoin (MANAGERIS, 2018).

· Prévoir une MCO : Il est

nécessaire dès le début du projet de prévoir la MCO

(maintenance en condition opérationnelle) en effet, les mutations que

peuvent subir les données dans le temps entraineront à coût

sûre une dégradation du niveau de qualité de la machine,

sans compter les mises à jour nécessaires (MANAGERIS, 2018).

Les enjeux de l'intelligence artificielle notamment

opérationnels sont considérables, mais avant d'entamer la phase

de « transition intelligente » les entreprises doivent apprivoiser

cette révolution technologique (CIGREF, 2017).

3.2 Les domaines de l'intelligence artificielle

Il faut distinguer 2 formes d'intelligence artificielle,

« l'intelligence artificielle forte » (Artificial General

Intelligence) et « l'intelligence artificielle faible » (en anglais

Artificial Narrow Intelligence) (Gonenc, et al., 2016) :

· L'intelligence artificielle « forte » se

rapproche du raisonnement humain. Ce type d'intelligence artificielle est

capable d'appliquer l'intelligence à tout problème contrairement

à l'intelligence artificielle faible. A ce jour il n'existe aucune AGI

opérationnelle, ce domaine se cantonne (pour l'instant) à la

recherche. Le grand public a tendance à penser que c'est ce type

d'intelligence artificielle qui est appliqué alors qu'il relève

de la science-fiction tout comme une troisième forme nommée ASI

(Artificial Super Intelligence) et qui prévoit le sur-classement de

l'homme par la machine dans 30 ans.

· L'intelligence artificielle « faible »

beaucoup plus « terre à terre » vise à imiter

l'intelligence pour répondre à un problème

spécifique, la machine ne fait que donner une impression d'intelligence.

Toutes les applications actuelles sont basées sur des solutions

d'intelligence artificielle faible !

23

3.2.1 Les approches

Depuis les débuts de l'intelligence artificielle dans

les années 1950, deux approches ont été employées

:

Dans la première approche dite symbolique, on

programme des règles et résout un problème à

travers une série d'étapes (les pionniers de l'intelligence

artificielle, pour la plupart logiciens, appréciaient beaucoup cette

méthode). Elle a culminé dans les années 1980 avec le

développement des systèmes experts, programmes dont le but

était d'intégrer une base de connaissances et un moteur de

décision venant de spécialistes de domaines pointus. Cette

approche souffre d'un manque de souplesse, par exemple il faut repartir de

zéro lorsque l'on développe un nouveau modèle.

Dans la deuxième approche dite numérique, on se

concentre sur les données. Les solutions vont rechercher des

corrélations au sein d'ensemble de données de différentes

formes. Cette approche connait depuis une vingtaine d'années une

évolution croissante grâce à l'augmentation de la puissance

de calcul avec notamment l'utilisation des GPU et l'explosion de la

quantité de données disponibles. La plupart des systèmes

actuels utilise le Machine Learning 11, une méthode

fondée sur une représentation mathématique, stochastique

et informatique.

3.2.2 Les sous-domaines de l'intelligence artificielle

Dans certains articles on peut trouver une

représentation classique de l'intelligence artificielle (figure 8) mais

il est difficile de parler d'un domaine avec ses sous branches, l'intelligence

artificielle est plus un concept qui rassemble d'elle-même une multitude

de disciplines scientifiques, d'applications et de méthodes. Toutes plus

ou moins interconnectées. Il est donc difficile de présenter une

liste exhaustive des domaines, cependant voici une présentation des

principaux « sous-domaines » (INRIA, 2016) (Russell & Norvig,

2010) :

Figure 8 - Champs de l'IA (Villanueva & Salenga,

2018)

11 Apprentissage automatique

· Représentation des connaissances :

Cette branche traite de la formalisation des connaissances, le but est

d'implémenter dans les systèmes les représentations

symboliques du savoir humain. C'est là un des secteurs les plus

importants de la recherche en intelligence artificielle.

· Traitement du langage naturel : Cette

discipline vise à étudier la compréhension et

l'utilisation du langage naturel des humains par les machines, on parle de

langage naturel par opposition au langage codé de l'informatique.

· Vision artificielle : Le but de cette

discipline est de permettre aux ordinateurs de comprendre les images et la

vidéo.

· Robotique : Ce sous-domaine vise

à fabriquer des machines physiques, ce qu'on appelle habituellement un

robot. Les robots industriels sont utilisés depuis longtemps, mais ici

on vise à créer des robots avec une certaine autonomie et

capables de percevoir et d'interagir avec leur environnement.

· Machine Learning : Le Machine

Learning vise à automatiser l'analyse de grands ensembles de

données en utilisant des méthodes stochastiques,

mathématiques et d'optimisation. Le but est de trouver des

corrélations dans les données de façon autonome ou non.

Les applications sont diverses.

· Moteurs de règle et système

experts : un système expert est un programme configuré

par un spécialiste qui effectue des tâches précises afin de

simuler le comportement humain.

Ces sous-domaines ne fonctionnent pas en silos, il y a des

interactions fortes entre eux (Russell & Norvig, 2010) (Cambrai, 2017). Par

exemple on peut en NLP utiliser le Machine Learning (Machine

Figure 9 - L'IA : une interconnexion d'applications, de

domaines et de méthodes (See, 2016)

24

25

Learning), les langages développés dans la

représentation des connaissances peuvent servir de base à des

systèmes experts. La figure 9 illustre bien les liens complexes qu'il y

a entre les applications (à gauche), les sous-domaines et les

méthodes d'intelligence artificielle.

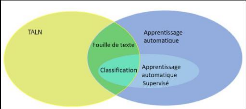

Notre étude porte sur la recherche d'une solution qui

permet de classer des données au format texte, c'est

précisément le but d'une tâche qui est au croisement de

deux sous-domaines du TALN12 (en anglais NLP13) et du

Machine Learning : La classification de documents (document classification en

anglais).

3.3 La classification de documents

Figure 10 - La classification, à la croisée

des chemins de l'IA

Parmi la multitude d'applications de l'intelligence

artificielle, la classification de documents consiste à regrouper les

documents en catégories en fonction de leur contenu. La classification

des documents joue un rôle essentiel dans diverses

applications d'intelligence artificielle

traitant de

l'organisation, de la classification et de la recherche de quantités

importantes de données textuelles. La classification de documents est

une discipline étudiée de longue date dans les disciplines de la

recherche d'information (Power, et al., 2010) (Patra & Singh, 2013). C'est

aussi une des tâches de la fouille de texte qui utilise les techniques et

méthodes du TALN et le Machine Learning (figure 10).

3.4 Le traitement automatique du langage naturel

Le TALN (NLP en anglais) ou TAL est le domaine de

l'intelligence artificielle qui s'intéresse à l'analyse et

à la compréhension des langues naturelles. Bien que cette

discipline ait plus de soixante ans, ce n'est qu'à partir des

années 90 qu'elle se développe, grâce aux progrès de

l'informatique qui a permis le traitement du texte au format numérique.

Les techniques utilisées aujourd'hui sont issues de l'informatique, de

la linguistique et du Machine Learning (Tellier, 2010).

Il existe deux approches distinctes, l'approche linguistique

et l'approche syntaxique (aussi appelée stochastique), cette

dernière s'appuie sur les méthodes numériques,

principalement statistiques et probabilistes, elle ne cherche pas à

comprendre le texte mais à étudier les corrélations

présentes dans celui-ci. Depuis que les chercheurs se sont

tournés vers ces nouvelles méthodes de l'intelligence

12 Traitement automatique de la langue naturelle

13 Natural language Processing

26

artificielle, le TALN a connu une avancée remarquable,

parmi les applications que le grand public utilise, il y a la correction

orthographique des logiciels de traitement de textes, la reconnaissance de

caractère, et plus récemment la traduction automatique et la

reconnaissance vocale.

Nous ferons un focus sur ces méthodes

appliquées à la classification textuelle qui sont principalement

issues du Machine Learning.

3.5 Le Machine Learning

Comme toutes les branches de l'intelligence artificielle, les

domaines du Machine Learning et du TALN partagent l'objectif de douer les

machines de certaines capacités humaines (Tellier, 2010), comme nous

l'avons vu plus haut le TALN utilise les méthodes du Machine Learning en

particulier dans les tâches de fouille de textes et de recherche

d'informations. Le Machine Learning est un domaine vaste et complexe, nous nous

limiterons aux aspects qui s'appliquent à notre sujet.

Le Machine Learning est la voie qui donne aujourd'hui les

meilleurs résultats dans les applications d'intelligence artificielle.

Cette discipline étudie, développe des techniques et

méthodes qui permettent à un algorithme d'apprendre à

partir d'exemples. C'est une démarche empirique qui tient plus de

l'observation que de la logique mathématique.

Parmi les nombreuses définitions du Machine Learning

celle-ci résume assez bien le but du Machine Learning : « une

machine14 est censée apprendre, si à partir d'une

expérience E en respectant les classes de la tâche T et en

mesurant la performance P sa performance à exécuter la

tâche T mesuré par P s'améliore avec l'expérience E

» (Mitchell & al., 1997), en d'autres termes il s'agit

d'améliorer la performance d'un algorithme à réaliser la

tâche en utilisant un ensemble d'exercices d'apprentissage.

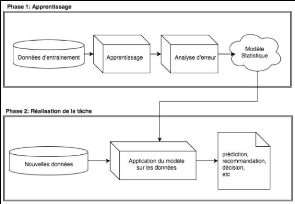

Figure 11 - Les deux phases de l'apprentissage automatique

(Chaouche, 2018)

Rappelons que la plupart des applications de Machine Learning

ont pour objectif d'automatiser, tout ou partie, des tâches complexes

accessibles seulement à l'être humain. Le ML15

répond ainsi aux problématiques non résolues par les

systèmes basés sur l'approche symbolique traditionnelle de

l'intelligence artificielle. Ceux-ci ne peuvent être

modélisés et configurés que par des spécialistes,

cette approche devient problématique lorsque la complexité

augmente et limite le

champ d'application de

l'intelligence artificielle. Au

contraire, le ML qui se

base principalement sur une approche

analogiste va limiter

14 « Machine » est pris au sens informatique,

autrement dit c'est un programme

15 Machine Learning

l'intervention d'experts, ce système utilise des

exemples déjà vus pour prendre des décisions. Dans une

première phase, il va rechercher des corrélations à partir

d'un jeu de données en entrée pour créer une règle,

puis le but est de généraliser cette règle apprise

à de nouvelles données dans une deuxième phase (figure

11).

3.5.1 Les modes d'apprentissage et les types de

problèmes à résoudre

Il existe plusieurs techniques de Machine Learning (Russell

& Norvig, 2010) :

· L'apprentissage supervisé : Un

expert labelise une partie des données qui va servir à

l'apprentissage. L'algorithme va alors apprendre la tâche de

classification en se basant sur les données labelisées.

· L'apprentissage non supervisé

: L'algorithme doit découvrir de lui-même les

ressemblances et différences dans les données fournies pour

apprendre la tâche.

· L'apprentissage semi-supervisé :

Les algorithmes fonctionnent comme pour l'apprentissage

supervisé mais acceptent en plus des données non

labelisées pendant la phase d'apprentissage.

· L'apprentissage par renforcement :

L'algorithme doit apprendre les actions à partir d'expériences,

de façon à gagner une récompense et à éviter

un gage.

Il existe deux types de problèmes bien distincts pour

lesquels le ML propose une solution, la classification et la

régression.

· Classification : Un problème

d'apprentissage supervisé où la réponse à apprendre

est celle d'un nombre infini de valeurs possibles. C'est un type de tâche

qui va chercher à catégoriser des éléments à

partir d'autres. Quand il n'y a que deux valeurs possibles, on dit que c'est un

problème de classification binaire, s'il y en a plus on parle de

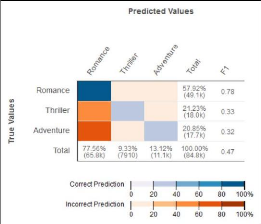

classification multi-classes.

· Régression : Un

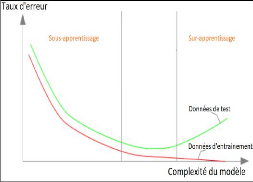

problème d'apprentissage supervisé où la réponse

à apprendre est une valeur continue. L'algorithme va chercher à

prédire un chiffre.

La tâche à traiter dans notre contexte

relève de la classification supervisée, nous ne nous

intéresserons pas aux autres cas dans la suite de ce chapitre. Le

modèle de classification supervisée à construire est

communément appelé « classifieur » (Boucheron, et al.,

2005).

27

3.5.2 Les étapes du Machine Learning

supervisé

28

La résolution d'un problème par l'apprentissage

machine peut se résumer en trois étapes, voir quatre si on estime

que la compréhension de la problématique posée entre dans

le processus d'apprentissage (Chaouche, 2018) :

· La tâche spécifique :

comprendre le problème à résoudre

· Les données : préparer les

données

· L'algorithme d'apprentissage : choisir

et paramétrer un algorithme

· La mesure des performances du modèle :

évaluer le modèle pour ajuster au mieux ses paramètres.

Avant de démarrer un projet de Machine Learning il est

nécessaire de comprendre la problématique afin de

sélectionner les bonnes données, le bon algorithme et les bons

paramétrages.

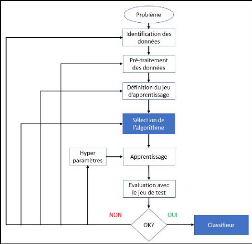

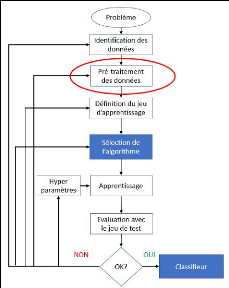

Figure 12 - Etapes de modélisation d'un

classifieur

Comme toute démarche empirique, le processus

d'apprentissage est itératif, il est peu probable d'arriver au meilleur

résultat possible du premier coup. Il sera donc nécessaire de

revenir sur certaines étapes pour améliorer le résultat.

L'évaluation permet de cibler les paramètres à optimiser

tant au niveau de l'algorithme que du pré-traitement des données

(figure 12).

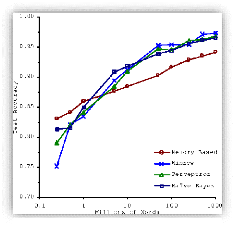

Figure 13 - Importance des données par rapport aux

algorithmes (Banko et Brill - 2001)

3.5.3 Les données

Le traitement des données est une étape

cruciale dans le processus de construction du modèle.

3.5.3.1 Quantité suffisante

Sans les données, il ne peut y avoir d'apprentissage,

c'est donc la première étape dans ce genre de projet :

vérifier que l'on dispose d'assez de données pour que le projet

soit viable.

29

D'ailleurs, il est prouvé que la performance de

l'apprentissage machine s'améliore avec la quantité de

données en entrée. Comme on peut le constater dans la figure

13,

l'augmentation des performances résultant de

l'utilisation de plus de données dépasse toute différence

de choix d'algorithmes. Un algorithme médiocre avec cent millions de

mots d'apprentissage dépasse le meilleur algorithme connu avec un

million de mots indépendamment de la technique choisie (Banko &

Brill, 2001).

Peter Norvig avance même que les données sont

plus importantes que les algorithmes notamment dans le cas de résolution

de problèmes complexes (Halevy, et al., 2009).

3.5.3.2 Donnée représentative

Les résultats seront bons si, et seulement si, les

données sont représentatives du corpus à traiter en

production. La sélection des données pour l'entrainement aura

donc un impact important sur la performance du modèle construit

(Géron, 2017).

3.5.3.3 Structure exploitable

Toutes sortes de données peuvent être

exploitées, bases de données, images, documents textuels,

à condition de les préparer, car les algorithmes ne traitent les

données que sous forme matricielle. En effet, elles sont rarement

stockées dans un fichier csv prêt à l'emploi, on parle

alors de nettoyage et de pré-traitement des données.

Ce traitement ne sera pas le même en fonction de la

structuration des données :

· Données structurées : ce sont des

données qui peuvent être organisées sous forme de tableaux.

Ces données peuvent être affichées par un tableur et

contiennent des lignes et des colonnes de variables, variables dont l'ensemble

des valeurs possibles peuvent être déterminées. C'est le

cas d'une base de données ou d'un fichier csv.

· Données non structurées : ce sont

principalement des documents textuels, audios ou graphiques.

30

Seules les données structurées peuvent

être directement représentées dans un tableau. Quant aux

données non-structurées, elles doivent subir un

pré-traitement pour les convertir en chiffres. Nous verrons que les

données textuelles doivent subir un traitement spécifique pour

être exploitées par les algorithmes de Machine Learning.

3.5.3.4 Représentation des données

Tout objet est décrit par un ensemble de variables.

L'objectif du Machine Learning est de rechercher des régularités

dans ces données grâce à l'observation d'un grand nombre

d'objets. On représente ces objets caractérisés par leur

variable de façon matricielle, chaque ligne est un objet (un document

dans notre contexte) et chaque colonne, une variable (attribut, ou feature en

anglais), qui peut être représenté comme ceci :

|

Variables

|

|

|

|

|

v 1

|

|

|

|

|

|

|

|

|

v n

|

|

|

...

|

|

|

Objets

|

o 1

|

o

|

o

|

x1,1

|

|

|

x1,n

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

...

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

xm,1

|

|

|

|

|

o m

|

|

|

xm,n

|

|

|

|

|

|

|

Tableau 1 - Représentation des données sous

forme d'une matrice (Biernat & Lutz, 2015)

Ce n'est en fait qu'un tableau composé de n variable(s)

et m objet(s) ! On obtient donc un ensemble de données de M vecteurs

à N dimensions. Dans le cas de la classification supervisée,

chaque vecteur sera labelisé, c'est-à-dire qu'on associera

à chaque vecteur, du jeu de données d'entrainement, une

catégorie.

3.5.3.5 Répartition des données

Le jeu de données doit être découpé

en deux parties, la première servira à l'entrainement et la

seconde est réservée aux tests pour la mise en production

(Géron, 2017). Le jeu d'entrainement est lui-même scindé en

deux, un pour l'entrainement et l'autre pour l'évaluation du

modèle (Ibekwe-Sanjuan, 2007). Pour résumer, les données

qui permettent de construire et valider un modèle de classification sont

réparties de la manière suivante :

· Le jeu d'entrainement : 80%

o Dont 80% pour le jeu d'apprentissage

o Dont 20% pour le jeu de validation (20%)

· Le jeu de test : 20%

Ce découpage n'est nécessaire que lorsque le

problème est complexe, en effet, dans les cas les plus simples, on

pourra n'utiliser que le jeu d'entrainement, c'est-à-dire 80% pour

l'apprentissage et 20% pour la validation.

3.5.4 Les algorithmes utilisés en Machine

Learning

Les algorithmes sont les outils essentiels du Machine

Learning, ils sont basés sur des règles statistiques et

probabilistes. Un algorithme va analyser des données et extraire des

régularités qui les

31

caractérisent. C'est ce qui permettra l'apprentissage.

Dans le cas de la classification, le but est de séparer, identifier ou

discriminer des données par rapport à d'autres.

3.5.4.1 Spécialisation des algorithmes

Les algorithmes sont souvent dédiés à un

type d'apprentissage, en voici quelques exemples :

Algorithme

|

Mode d'apprentissage

|

Type de problème à traiter

|

Régression linéaire

|

Supervisé

|

Régression

|

Régression polynomiale

|

Supervisé

|

Régression

|

Naive Bayes

|

Supervisé

|

Classification

|

Régression logistique

|

Supervisé

|

Classification

|

Arbres de décision

|

Supervisé

|

Régression ou classification

|

Random forest

|

Supervisé

|

Régression ou classification

|

Gradient boosting

|

Supervisé

|

Régression ou classification

|

Support Vector Machine

|

Supervisé

|

Régression ou classification

|

Clustering

|

Non supervisé

|

-

|

|

Tableau 2 - Exemples d'algorithmes (Biernat & Lutz,

2015)

3.5.4.2 Que fait l'algorithme dans le cas de la

classification supervisée ?

Le programme recherche une fonction qui prendra, en

entrée, un vecteur (ligne du tableau) et fournira, en sortie, le nom

d'une classe (catégorie). Ce cheminement n'est pas automatique, il

nécessite un ajustement. Le but étant de sélectionner une

fonction qui décrit au mieux les données du jeu d'apprentissage,

on parle alors de minimisation du risque empirique. Les valeurs de la fonction

seront interprétées de façon différente selon la

famille de l'algorithme, il en est de même pour le seuil qui fixe

l'appartenance à telle ou telle classe (Ibekwe-Sanjuan, 2007).

3.5.4.3 Comment choisir l'algorithme ?

Un théorème mathématique prouve qu'il

n'existe pas de meilleure méthode que toutes les autres sur tous les

problèmes de Machine Learning possibles, c'est le « NO FREE LUNCH

» (Wolpert & Macready, 1997). En d'autres termes, si un algorithme de

Machine Learning fonctionne bien sur un type de tâche

particulière, il sera moins performant en moyenne sur d'autres types de

tâches. Il faut donc rechercher et tester l'algorithme qui sera le plus

adapté pour la tâche à accomplir.

Voici trois critères de choix qui permettent de faire une

première sélection :

· Type de tâche

Le tableau 2 nous montre que les algorithmes sont

spécialisés, seuls certains pourront répondre à

notre contexte.

· Type de données

Certains algorithmes seront plus performants que d'autres en

fonction des données, par exemple les documents textuels contiennent

beaucoup de dimensions, par conséquent il faut un algorithme assez

puissant pour traiter ce type de données.

· 32

Adaptabilité

Cette notion d'adaptabilité concerne le fait de

pouvoir mettre à jour le modèle construit, en effet certains

algorithmes peuvent être facilement mis à jour alors que d'autres

pas du tout. Ce critère est fonction de l'utilisation, par exemple un

modèle de classification de données en masse aura moins besoin

d'être mis à jour qu'un modèle de traitement de

données en continu.

Le choix de l'algorithme sera donc fait en fonction du

problème à résoudre.

3.5.5 Algorithmes adaptés à la

classification de documents textuels

Certains programmes sont plus performants que d'autres, parmi

ceux qu'on retrouve dans la littérature, le SVM et le Bayésien

Naïf sont souvent en tête pour les tâches de classification de

document textuel (Osisanwo, 2017) (Kotsiantis, et al., 2007) (Mertsalov,

2009).

3.5.5.1 Les SVM

Le SVM16 est un classifieur linéaire,

c-à-d que les données doivent être linéairement

séparables. Les données sont représentées dans un

espace vectoriel. La fonction va rechercher le meilleur séparateur pour

partager les données en deux classes via une ligne, ou un hyperplan, qui

sera placée de façon à maximiser les marges la

séparant des points, représentant les variables, les plus

proches. Si les données ne sont pas linéairement

séparables, on utilise alors la technique du « noyau » qui

consiste à considérer le problème dans un espace de

dimension supérieure, ainsi on augmente grandement les chances de

trouver une séparation.

C'est algorithme de classification binaire, mais il existe

des méthodes pour l'adapter à la classification multi-classes,

notamment la technique « one-vs-all ».

Le SVM est largement accepté dans l'industrie ainsi

que dans le monde académique. Par exemple, Health Discovery Corporation

utilise le SVM dans un outil d'analyse d'images médicales actuellement

sous licence de Pfizer. Dow Chemical utilise le SVM dans ses recherches pour la

détection des valeurs aberrantes et Reuters l'utilise pour la

classification de textes (Mertsalov, 2009).

Ils sont particulièrement bien adaptés aux

problèmes de classification binaire dans des espaces vectoriels de

grande dimension. Les documents textuels étant par définition

composé d'un grand nombre de dimensions, le SVM est donc

particulièrement performant sur ce type de données (Amancio,

2014). Le SVM surclasse les autres algorithmes sur les aspects de

surdimensionnement, de redondance des fonctionnalités, de robustesse et

donc de précision de la classification (Luo & Li, 2014). De plus, il

performe bien avec peu d'exemples.

Malheureusement, il n'est pas incrémental (Tellier,

2010), il ne peut s'adapter au changement de nature inhérents aux

document textuels. Mais d'autres le sont, notamment le Bayésien

naïf.

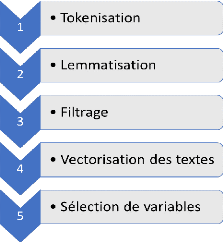

3.5.5.2 Le Bayésien naïf