|

Institut Africain d'Informatique

Myrabilys Technologies Sarl

Etablissement Inter - Etats d'Enseignement

Supérieur

BP 2263 Libreville (Gabon)

Tél. (241) 07 70 55 00

/ 07 70 56 00

Site web:

www.iai-siege.com

E-mail:

contact@iaisiege.com

Carrefour Ancienne Sobraga

BP 13.984 Libreville

(Gabon)

Tél. (241) 01 73 00 24

Site web:

www.myrabilys.com

MÉMOIRE DE FIN DE CYCLE

En vue de l'obtention du diplôme

D'INGENIEUR EN INFORMATIQUE

THÈME

ÉTUDE, CONCEPTION ET

IMPLÉMENTATION D'UN CLUSTER LOW-

COST HAUTE DISPONIBILITÉ DE

RASPBERRY PI 3

Réalisé par :

TCHUENCHÉ Rodrigue

Élève en fin

de cycle ingénieur

Superviseur

Maître de stage

Dr. NOUSSI Roger

Enseignant Permanent à

IAI

M. NJIOMO Luc Prosper

Ingénieur Informaticien

& MBA

C.E.O de

Myrabilys

Année Académique 2015 - 2016

ÉTUDE, CONCEPTION ET IMPLÉMENTATION

D'UN CLUSTER LOW-COST HAUTE

DISPONIBILITÉ DE RASPBERRY PI 3

Tchuenché Rodrigue

Septembre 2016

Table des matières

Liste des Acronymes vii

DÉDICACE xi

ÉPIGRAPHE xii

REMERCIEMENTS xiii

AVANT-PROPOS xiv

RÉSUMÉ xv

ABSTRACT xvi

INTRODUCTION GÉNÉRALE 1

I PARTIE 1 : Présentation

générale de l'étude 2

INTRODUCTION 3

1 CHAPITRE 1 : Présentation de la

structure d'accueil, du contexte et du su-

jet d'étude 4

1.1 Structure d'accueil 4

1.1.1 Historique 4

1.1.2 Missions et Activités 4

1.1.3 Organigramme 5

1.2 Contexte et Problématique 7

1.3 Sujet d'étude 7

ii

2 CHAPITRE 2 : Concepts

généraux liés au sujet 9

iii

iii

2.1 Quelques Définitions 9

2.2 Etude de quelques concepts liés au sujet

d'étude 10

2.2.1 Raspberry Pi 10

2.2.1.1 Modèle A 11

2.2.1.2 Modèle A+ 11

2.2.1.3 Modèle B 12

2.2.1.4 Modele B+ 12

2.2.1.5 Modèle 2B 13

2.2.1.6 Modèle 3B 14

2.2.1.7 Modèle Zéro 14

2.2.2 Cluster 16

2.2.2.1 Catégories de clusters 16

2.2.2.2 Architecture des Clusters 19

2.2.3 Les Dockers 21

2.2.3.1 C'est quoi un Docker? 22

2.2.3.2 Difference entre Docker et Machine Virtuelle (VM) 22

2.2.3.3 Environnement et notions de base Docker 22

2.2.4 ERP Odoo 23

2.2.4.1 Historique 23

2.2.4.2 Principaux Modules Applicatifs du logiciel Odoo 24

2.2.4.3 Architecture Logiciel d'Odoo 25

CONCLUSION 25

II PARTIE 2 : Conception, Implémentation et

étude de la solution

à proposer 26

INTRODUCTION 27

3 CHAPITRE 3 : Analyse et conception 28

3.1 Solution logicielle de Cluster 28

iv

|

3.1.1

3.1.2

|

Microsoft Cluster / Cluster pour système Windows

3.1.1.1 Microsoft Cluster Server (MSCS)

3.1.1.2 Evidian Safekit

Cluster GNU/Linux

|

28

29

29

30

|

|

|

3.1.2.1 Linux Virtuel Server (LVS)

|

30

|

|

|

3.1.2.2 Beowulf

|

30

|

|

|

3.1.2.3 Linux HA-Project

|

31

|

|

|

3.1.2.4 Multicomputer Operating System for Unix (MOSIX)

|

31

|

|

|

3.1.2.5 Apache Mesos

|

31

|

|

|

3.1.2.6 Cluster Docker Swarm

|

31

|

|

3.2

|

Analyse Des Solutions

|

32

|

|

3.3

|

Concepts de répartition de charge réseau (Load

Balancing)

|

32

|

|

3.3.1

|

Présentation

|

32

|

|

3.3.2

|

Logiciels de distribution de charge réseau et haute

Disponibilité du cluster 33

|

|

|

3.3.2.1 HAProxy

|

33

|

|

|

3.3.2.2 Heartbeat

|

34

|

|

3.4

|

Conception du cluster

|

35

|

|

|

3.4.1 Nombre de Noeuds du Cluster

|

35

|

|

|

3.4.2 Adressage IP du Cluster

|

36

|

|

|

3.4.3 Constituant de chaque noeud

|

36

|

|

|

3.4.4 Architecture de notre cluster

|

37

|

|

CONCLUSION

|

37

|

|

4

|

CHAPITRE 4 : Mise en oeuvre du

cluster

|

39

|

|

4.1

|

Matériel utilisés pour monter notre Cluster

|

39

|

|

4.2

|

Mise en OEuvre du cluster

|

42

|

|

|

4.2.1 Installation du système d'exploitation sur les 10

noeuds du cluster . . . .

|

42

|

|

|

4.2.1.1 Configuration adresse IP des noeuds Raspberry Pi

|

42

|

|

|

|

iv

|

v

v

4.2.1.2 Configuration nom d'hôte des noeuds Raspberry Pi

43

4.2.2 Installation du moteur Docker sur chaque noeud 43

4.2.3 Création d'un container Docker, le cas du container

Odoo 43

4.2.3.1 Création d'un Docker Image à partir d'un

Dockerfile 44

4.2.3.2 Création des Docker Containers 44

4.2.4 Mise en oeuvre du Cluster Docker Swarm 44

4.2.5 Mise en OEuvre du Cluster de Répartition de charges

et Haute Disponi-

bilité 45

4.2.5.1 Mise en oeuvre de la répartition de charge 45

4.2.5.2 Mise en oeuvre Haute Disponibilité du cluster

46

CONCLUSION 47

5 CHAPITRE 5 :Évaluation du cluster et conduite du

projet 48

5.1 Protocole d'évaluation 48

5.2 Évaluation du cluster 49

5.2.1 Évaluation de l'énergie 49

5.2.2 Évaluation coût du cluster 50

5.2.3 Évaluation Performance Cluster 50

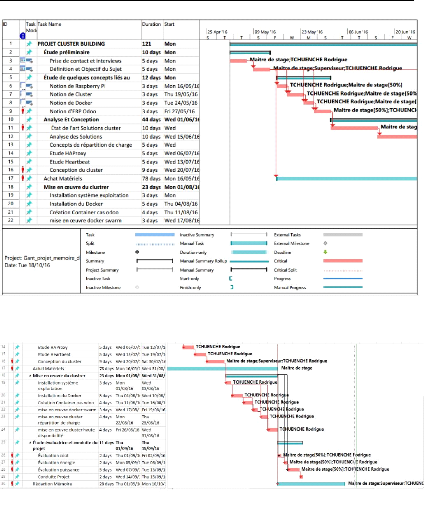

5.3 Conduite du projet 50

5.3.1 Les intervenants dans le projet 51

5.3.2 Découpage du projet 51

5.3.3 Diagramme de GANTT 52

5.4 Bilan et perspectives 53

5.4.1 Bilan 53

5.4.2 Perspectives 54

CONCLUSION GÉNÉRALE 55

Les Annexes 56

.1 Annexe 1 56

vi

vi

.2 Annexe 2 58

.3 Annexe 3 59

.4 Annexe 4 60

.5 Annexe 5 61

.6 Annexe 6 68

.7 Annexe 7 68

.8 Annexe 8 70

.9 Annexe 9 75

.10 Annexe 10 80

Référence bibliographique 83

vii

vii

Liste des Acronymes

|

Abréviations

|

Significations

|

|

VM

|

Virtual Machine

|

|

ERP

|

Enterprise Resource Planning

|

|

Sarl

|

Societé à Responsabilité Limité

|

|

IAAS

|

Infrastructure As A Service

|

|

SAAS

|

Software as a service

|

|

CRM

|

Customer Relationship Management

|

|

ARM

|

Advanced RISC Machines

|

|

HDMI

|

Interface Multimédia Haute Définition

|

|

GPIO

|

General Purpose Input/Ouput

|

|

MOSIX

|

Multicomputer Operating System for Unix

|

|

FTP

|

File Transfert Protocol

|

|

DMA

|

Direct Memory Access

|

|

API

|

Application Program Interface

|

|

PVM

|

Parallele Virtual Machine

|

|

MPI

|

Message Passing Interface

|

|

RMA

|

Remote Memory Access

|

|

RAM

|

Random Access Memory

|

|

CPU

|

Central Processing Unit

|

|

LXC

|

Linux Container

|

|

OS

|

Operating System

|

|

GPL

|

General Public License

|

|

LGPL

|

Lesser General Public License

|

|

CMS

|

Content Management System

|

|

MVC

|

Modèle Vue Contrôleur

|

|

NLB

|

Network Load Balancing

|

|

MSCS

|

Microsoft Cluster Service

|

|

CLB

|

Component Load Balancing

|

|

LVS

|

Linux Virtual Server

|

TABLE 1 - Liste des abréviations

viii

Liste des tableaux

|

1

|

Liste des abréviations

|

vii

|

|

2.1

|

Tableau récapitulatif version Odoo

|

24

|

|

4.1

|

Carte MicroSD 8 & 32 Go

|

40

|

|

5.1

|

Comparaison consommation d'énergie

|

50

|

|

5.2

|

Table dépenses

|

50

|

|

5.3

|

Comparaison coût

|

50

|

|

5.4

|

Découpage des tâches

|

52

|

|

5

|

Liste outils nécessaires pour flasher la carte microSD

|

56

|

ix

Table des figures

2.1 Schéma Architecture D'un Cluster 10

2.2 Une carte nue du Raspberry Pi modèle A 12

2.3 Une carte nue du Raspberry Pi modèle A+ 12

2.4 Une carte nue du Raspberry Pi modèle B 13

2.5 Une carte nue du Raspberry Pi modèle B+ 13

2.6 Une carte nue du Raspberry Pi 2 modèle B 14

2.7 Une carte nue du Raspberry Pi 3 modèle B 14

2.8 Une carte nue du Raspberry Pi Zéro 15

2.9 Une carte annotée du Raspberry Pi 3 Modèle B

15

2.10 Cluster haute disponibilité 17

2.11 Cluster répartition de charges 18

2.12 Cluster calcul haute performance 18

2.13 Cluster de stockage 19

2.14 Machine Virtuelle Vs Docker 23

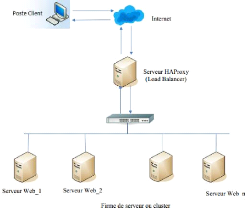

3.1 Architecture Haproxy 34

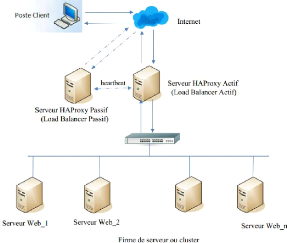

3.2 Architecture Haproxy/heartbeat 35

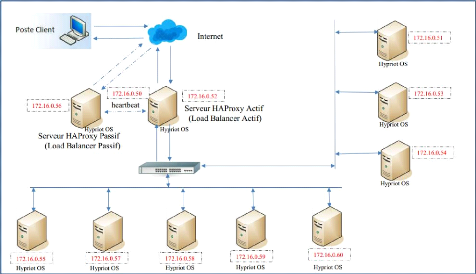

3.3 Architecture cluster à implémenter 38

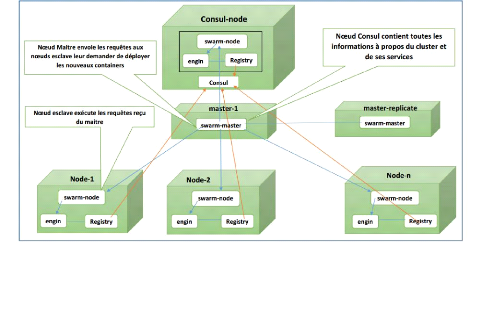

3.4 Architecture cluster Docker Swarm à

implémenter 38

4.1 Switch Gigabit Ethernet 40

x

|

4.2

|

Câble RJ45

|

40

|

|

4.3

|

Batterie d'alimentation

|

40

|

|

4.4

|

Convertisseur 12V - 5V

|

41

|

|

4.5

|

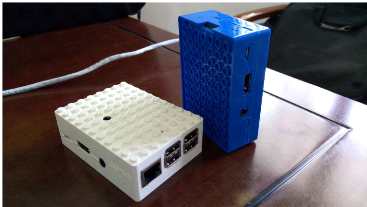

Notre Raspberry Pi 3 Assemblé

|

41

|

|

4.6

|

Notre Cluster Physique monté

|

42

|

|

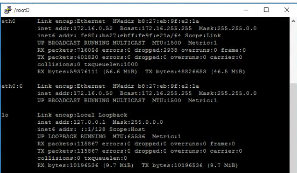

4.7

|

ifconfig partie eth0 :0 qui indique que le noeud fonction sur

l'adresse virtuelle

|

|

|

172.16.0.50

|

46

|

|

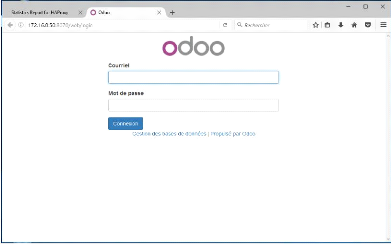

4.8

|

Interface Connexion Odoo sur le cluster à l'adresse

172.16.0.50 :8070

|

47

|

|

5.1

|

Diagramme de GANTT

|

53

|

|

5.2

|

Diagramme de GANTT next

|

53

|

|

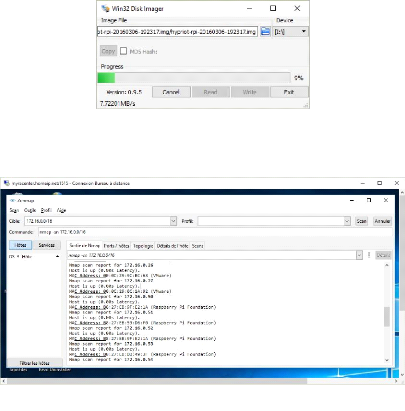

3

|

Fenêtre WinDiskImager

|

57

|

|

4

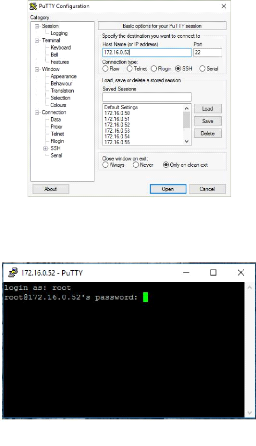

|

Fenêtre Zenmap

|

57

|

|

5

|

Fenêtre Putty.exe

|

58

|

|

6

|

Fenêtre connexion Hypriot OS

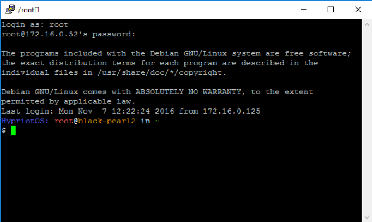

|

58

|

|

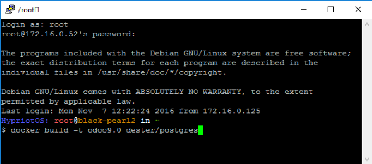

7

|

Fenêtre acceuil Hypriot OS

|

59

|

|

8

|

Fenêtre docker build

|

65

|

|

9

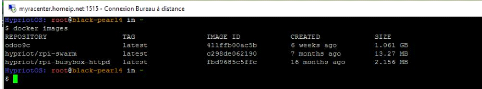

|

Fenêtre docker images

|

69

|

|

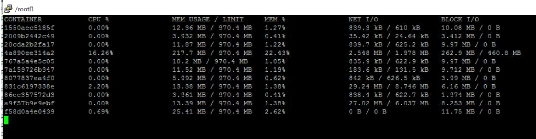

10

|

Fenêtre résultat docker stats

|

75

|

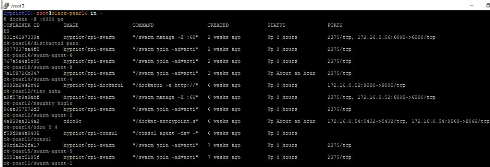

|

11

|

Fenêtre résultat docker ps sur cluster

|

76

|

|

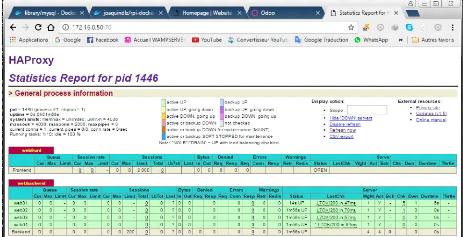

12

|

Fenêtre statistique Haproxy

|

78

|

|

13

|

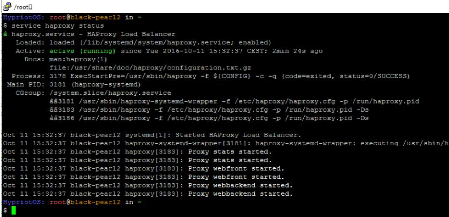

Fenêtre status Haproxy

|

80

|

|

|

x

|

xi

DÉDICACE

Je dédie ce mémoire à ma feue

grand-mère

Maman KUISSU Pauline

Paix à son âme, que la terre de nos ancêtres

lui soit légère.

xi

xii

xii

ÉPIGRAPHE

« Nous ne pouvons pas prédire où nous

conduira la Révolution

Informatique. Tout ce que nous savons avec

certitude, c'est que,

quand on y sera enfin, on n'aura pas assez de RAM

»

Dave Barry

xiii

xiii

REMERCIEMENTS

Je remercie l'État camerounais pour

m'avoir donné l'opportunité de poursuivre mes

études

d'ingénieur à IAI-GABON en les finançant.

Je voudrais par la même occasion remercier

l'État Gabonais pour

l'accueil, l'assistance et les facilités à nous accordés

pour permettre le

bon déroulement de nos études sur son

territoire.

Je tiens particulièrement à remercier ma feue

grand-mère Maman KUISSU Pauline pour

l'amour, la

patience, le courage, le soutien et les conseils qu'elle a toujours

porté à mon

endroit. Paix à son âme.

Je remercie papa KOUAM Moïse et son

épouse Maman Béatrice pour leur soutiens et

conseils.

Je remercie mes parents pour leurs amours,

soutiens et conseils.

À Mr NJIOMO Luc Prosper , mon

maître de stage, je dis un merci spécial pour

ses

précieux conseils, sa disponibilité, son soutien, son

hospitalité, sa rigueur durant ses trois

années de formation

et pour son encadrement durant ses cinq mois de stage.

À Mr NOUSSI Roger enseignant permanent

à l'IAI, mon superviseur, je dis merci pour

ses conseils et

orientations durant ce stage.

Aux corps administratif et enseignants de

l'Institut Africain d'Informatique(IAI) pour la formation et l'encadrement

reçus, je dis merci.

À mes camarades de promotion plus particulièrement

Apollinaire, Hervé, Mbonwouo, Etienne Willy, Franck

César, Sergeo, Francine, je les remercie pour leurs soutiens,

les échanges fructueux et l'ambiance qui a régné durant le

stage et ses trois années de formation.

À mon grand ami TANON Hervé, je

dis un grand merci pour son soutien et ses conseils.

J'exprime ma gratitude à mes frères,

soeurs, amis et toute la famille pour leur soutiens

inconditionnels.

À la grande famille ASSECI (Association

des étudiants Camerounais de l'IAI), je leur

témoigne mes

sincères remerciements pour leurs soutiens et conseils.

À Mme NJIOMO Marcelle, pour son accueil

aussi chaleureux à chaque visite, son

hospitalité, ses

conseils, son soutien, je lui témoigne mes sincères

remerciements.

Enfin, à tous ceux qui, de près ou de loin, ont

participé à l'élaboration de ce mémoire, je vous

dis sincèrement merci

xiv

xiv

AVANT-PROPOS

L'institut Africain d'Informatique (IAI) est un

établissement Inter-états d'enseigne-ment supérieur

créé en 1971. Il regroupe onze (11) Etats africains : le Burkina

Faso, le Benin, le Cameroun, la République Centrafricaine, le Congo

Brazzaville, la Côte d'Ivoire, le Gabon, le Niger, le

Sénégal, le Tchad et le Togo. L'IAI intègre dans son

cursus de formation plusieurs cycles parmi lesquels celui des Ingénieurs

de conception en Informatique. Arrivés en fin de cycle, les

élèves du cycle Ingénieur sont soumis à un stage

pratique d'une durée de cinq (5) mois. Ce stage a pour finalité

de placer l'étudiant en fin de cycle face aux réalités

diverses et variées du monde professionnel sous l'encadrement d'un

expert métier. Celui-ci a pour mission d'apprendre à

l'étudiant stagiaire les fondamentaux requis pour construire des

solutions informatiques adaptées aux problèmes soumis à

son attention par l'entreprise (qu'elle soit privée, publique ou mixte)

ou par une structure de recherche.

Le présent document représente l'aboutissement

de trois (3) années de formation donc cinq (5) mois de stage pratique

effectué à MYRABILYS TECHNOLOGIES Sarl qui est une entreprise

informatique basée à Libreville au Gabon et tient lieu à

cet effet de notre mémoire de fin de formation d'ingénieur en

Informatique à l'Institut Africain d'Informatique de Libreville.

xv

xv

RÉSUMÉ

Le thème de notre étude porte sur la conception,

l'implémentation et l'étude d'un cluster low cost haute

disponibilité de raspberry pi 3. Ce travail permet de proposer une

solution serveur à faible coût et à faible consommation

d'énergie tout en garantissant les performances d'un serveur normal

à MYRABILYS et à ses clients composés de petites et

moyennes structures et des grandes entreprises. Parfaitement adapté aux

zones reculées, non couvertes par le réseau électrique,

cette solution vise aussi à faciliter l'utilisation et le

déploiement des applications comme l'ERP Odoo par l'utilisation des

Docker et du cluster Docker Swarm.

Après une étude approfondie en vue d'analyser

les solutions déjà existantes et de choisir les outils (logiciels

et matériels) nécessaires à la réalisation, nous

avons procédé à une phase de conception pour créer

l'architecture la mieux adaptée à nos besoins. Par la suite, nous

l'avons implémentée et procédé à une

évaluation de la solution en vue de vérifier si les objectifs en

énergie, coût et performance ont été atteints.

Mots clés : Cluster, Haute

disponibilité, Raspberry Pi, Docker, Docker Swarm

xvi

xvi

ABSTRACT

The focus of our study is on the design, implementation and

study of a low-cost, high-availability cluster of raspberry pi 3. This work

provides a low-cost, low-power server solution while Guaranteeing the

performance of a normal server to MYRABILYS and its customers composed of small

and medium structures and large companies. Perfectly adapted to remote areas,

not covered by the electrical network, this solution also aims at facilitating

the use and deployment of applications such as Odoo ERP through the use of the

Docker and the Docker Swarm cluster.

After a thorough study to analyze the existing solutions and

to choose the tools (software and hardware) necessary for the realization, we

proceeded with a design phase to create the architecture best suited to our

needs. We then implemented it and carried out an evaluation of the solution to

verify whether the energy, cost and performance objectives were met.

Keywords : Cluster, High Availability, Raspberry

Pi, Docker, Docker Swarm

1 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 1

INTRODUCTION GÉNÉRALE

De nos jours, l'informatisation des Systèmes

d'informations des entreprises est un phénomène qui prend de

l'ampleur en Afrique. La plupart des structures veulent ou doivent se doter des

infrastructures serveurs pouvant servir à héberger leurs services

informatiques ou ceux de leurs clients. Dans la démarche d'obtention de

ces serveurs, ces structures se heurtent au problème de prix et

d'énergie.

Fort de ce constat, et confrontée elle aussi à

ces problèmes, MYRABILYS Sarl s'est proposée

d'apporter une solution à cette situation. C'est donc dans cette optique

que le thème « étude, conception, et

implémentation d'un cluster low-cost haute disponibilité de

raspberry pi 3 » nous a été confié.

Le présent mémoire sera composé de deux

parties. La première sera consacrée à la

présentation générale. Elle présentera la structure

d'accueil, décrira le contexte général de l'étude,

l'objectif et la problématique, puis les concepts généraux

liés au sujet. Dans la seconde partie, il s'agira l'analyse, conception

et de la mise en oeuvre de la solution, nous évaluerons le

système implémenté, et nous terminerons par la conduite du

projet.

2

Première partie

PRÉSENTATION GÉNÉRALE DE

L'ÉTUDE

3 IAI Gabon

INTRODUCTION

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 3

Cette partie est divisée en deux chapitres. Le chapitre

1 présente la structure d'accueil, le contexte d'étude, la

problématique et le sujet d'étude. Dans le chapitre 2, nous

posons la fondation de notre travail en définissant quelques concepts

liés à notre étude. Ce même chapitre traite du

domaine dans lequel se situe notre travail. Au terme de cette première

partie, nous aurons une compréhension claire de la théorie des

concepts utilisés dans la réalisation de notre système.

4

Chapitre1

PRÉSENTATION DE LA STRUCTURE D'ACCUEIL, DU CONTEXTE ET

DU SUJET D'ÉTUDE

1.1 Structure d'accueil

Pour mieux présenter la structure qui nous a

accueillis, nous allons commencer par présenter son historique, puis ses

missions, ses activités et enfin son organigramme. Nous explorerons

enfin le département dans lequel nous avons effectué le stage.

1.1.1 Historique

La société MYRABILYS Sarl a été

créé en 2014 par Mr NJIOMO Luc Prosper le Chief Executive Officer

Actuel. Elle est basée à Libreville (Ancienne SOBRAGA) et une

succursale sera bientôt installée à Douala au Cameroun.

1.1.2 Missions et Activités

MYRABILYS TECHNOLOGIES Sarl est une

entreprise informatique basée à Libreville au Gabon et dont le

coeur de métier couvre trois activités complémentaires

suivantes :

* Le Cloud Computing (que l'on

traduit par nuage informatique) qui consiste à fournir des services ou

des applications informatiques en ligne, accessibles partout, à tout

moment, et de n'importe quel terminal (smartphone, PC de bureau, ordinateur

portable et tablette). Le Cloud Computing permet chez MYRABILYS Technologies

Sarl, de partager une infrastructure (Infrastructure As A Service - IAAS), une

solution applicative (Software As A Service - SAAS) à toute entreprise

utilisatrice qui en fait la demande via une simple connexion internet en

libre-service. MYRABILYS Technologies Sarl se positionne donc comme un «

opérateur de services informatiques managés

» où elle propose à ses clients d'externaliser

l'hébergement, la configuration, la maintenance de leur application sur

ses serveurs de sorte que les clients qui ne possèdent pas toujours de

services informatiques internes digne de ce nom, n'aient plus à se

préoccuper des problématiques

5 IAI Gabon

techniques informatiques afin de se concentrer sur le coeur de

leur métier.

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 5

* L'intégration et outsourcing,

concernant principalement l'ERP ODOO (ancien Open

ERP). En effet, L'éditeur est un industriel du

logiciel. Il conçoit et développe des produits logiciels pour le

plus grand nombre. L'intégrateur accompagne un tiers

utilisateur dans le déploiement et personnalise le produit logiciel

conçu par l'éditeur.

* Le conseil et l'audit. Cette

activité a pour objectif d'identifier et d'évaluer les risques

(opérationnels, financiers, organisationnels) associés aux

activités informatiques d'une entreprise ou d'une administration. Ceci

permet d'identifier les endroits où agir pour améliorer le

fonctionnement et la performance d'une organisation avec une éventuelle

implication dans la mise en oeuvre de cette amélioration.

1.1.3 Organigramme

Dans le cadre de notre stage, bien que attaché au

département SOFTWARE, notre travail « conception et

implémentation d'une infrastructure serveur basé sur raspberry pi

» s'intègre au département

INFRASTRUCTURE.

Pool Conseillers et Consultants

|

Juridique, Stratégique,

Management

|

DIRECTEUR GENERAL

MYRABILYS TECHNOLOGY

|

Plans, Table Plan

Recru

|

|

|

|

INFRASTRUCTURE

|

SOFTWARE

|

MARKETING

|

AD

|

Matériel, Télécom,

Réseaux

Installation et administration du Datacenter.

Animation de la cellule de veille et

d'éveille.

Cellule de test de robustesse des solutions

proposées aux clients

Installation des environnements matériels et OS

chez les clients

Règle les dysfonctionnement technique en cas

de réclamation incident client

Installe et maintient l'infrastructure interne

de l'entreprise.

Base de données, ERP

Responsable des contenus du

Datacenter.

Cellule de développement des

applications à installer chez les clients ou dans le

Datacenter.

Prépare et effectue les démonstrations chez

les clients ou dans notre salle de formation.

Déploiement fonctionnelle de l'ERP chez

les clients

Formation fonctionnelle sur les applications et

les modules de l'ERP.

Rédaction des documentations techniques.

Comp

gest

Fac

Co

anal

Fisc

l'ad

Ges

Paie

Réd

céd

Stat

bor

Ges tière

riels

Con de r

6

Prospection, Vente, CRM

Rédaction propositions commerciales, et appels

d'offre, ainsi que conditions générales de

vente.

Définition des Produits, ser vices,

Segments, Tarifications, Couple Produit/ Marché, 5 roues de

Porter

Retour d'information des clients sur les

améliorations attendues, des nouveaux besoins,

Définition des nouvelles offres,

ajustement de tarifs

Régler les soucis commerciaux en cas de

réclamation client.

Formation fonctionnelle et technique des

clients utilisant nos solutions hébergées.

Rédaction des documentations fonctionnelles des

modules de l'ERP et des applications hébergées.

7 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 7

1.2 Contexte et Problématique

L'activité coeur de métier de MYRABILYS

Technologies Sarl c'est celle du cloud computing. Elle nécessite

d'acquérir, de posséder, de sécuriser et d'administrer au

quotidien un Datacenter (centre de traitement des données en

français). Le datacenter est un site physique sur lequel se trouvent

regroupés des équipements constituants du système

d'information de l'entreprise (ordinateurs centraux, serveurs, switch,

routeurs, baies de stockage, équipements réseaux et de

télécommunications, etc.) et dans lequel les entreprises clientes

peuvent notamment louer un espace de stockage et ainsi éviter la

présence de serveurs dans leurs locaux. Posséder un datacenter

présente les difficultés suivantes :

* le coût d'acquisition de ces

solutions serveur : En effet le coût d'achat de ces solutions de

serveurs physique (HP, SuperMicro, Dell, etc.) est en général

assez élevé (des dizaines de millions et plus).

* la consommation d'énergie :

Les solutions traditionnelles de serveurs physiques sont assez

énergivores. Dans un contexte africain où la couverture et la

fourniture d'énergie électrique bon marché sont loin

d'être un acquis, l'aspect énergie est également source de

dépenses énormes pour les entreprises. Elle constitue aussi un

frein sérieux dans la généralisation des outils des NTIC

dans tous les secteurs de la vie économique.

* Le système de refroidissement

* La sécurisation

Ainsi, garantir une maintenance technique, un accès

sécurisé permanent, un fonctionnement 24h/24 de ses

infrastructures et de celui de ses clients qui sont pour la plupart des PME,

des mairies, des établissements scolaires souvent situés dans des

zones très reculées sans couverture de réseau

électrique est un grand challenge pour MYRABILYS Technologies.

Le Raspberry Pi est un nano-ordinateur monocarte à

processeur ARM. Cet ordinateur, qui a la taille d'une carte de crédit,

permet l'exécution de plusieurs variantes du système

d'exploitation libre GNU/Linux et des logiciels compatibles. Il est fourni nu

(carte mère seule, sans boîtier, alimentation, clavier, souris ni

écran) dans l'objectif de diminuer les coûts et de permettre

l'utilisation de matériel de récupération. Le raspberry Pi

nécessite très peu d'énergie électrique pour son

fonctionnement (5v et 800 mA). Il consomme 2W.

1.3 Sujet d'étude

Notre travail consiste donc à étudier, concevoir

et implémenter une solution de clustering haute disponibilité

à moindre coût et peu énergivore basée sur les

nano-ordinateurs Raspberry Pi 3 pouvant compléter l'offre serveur de

MYRABILYS Technologies. Malheureusement, les nano-ordinateurs de nos jours

n'ont pas de puissance de calcul pouvant égaler celle des gros serveurs.

Un raspberry pi pris individuellement est faible. Il faudra alors inventer un

modèle de coopération entre ces machines dans une

stratégie du type « l'union fait la force » ou encore «

l'union des petits peut égaler un grand ».

8 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 8

Par ailleurs, étant intégrateur de l'ERP Odoo,

MYRABILYS doit soit en local dans son datacenter, soit chez le client

déployer l'ERP Odoo et par la suite procéder à des

formations à l'utilisation des nouveaux utilisateurs. Une des

difficultés est le déploiement complexe d'Odoo quand il s'agit

d'un système d'exploitation Linux.

Ainsi, après avoir monté notre solution cluster,

nous devons par la suite trouver un moyen de faciliter le déploiement et

la gestion de l'ERP Odoo et d'autres applications similaires dans notre

solution cluster ou dans un système Linux pour serveur.

Chapitre2

CONCEPTS GÉNÉRAUX LIÉS AU SUJET

9

Introduction

Ce chapitre se consacre à une étude des concepts

généraux et spécifiques en rapport avec notre sujet. Dans

la première section de ce chapitre, nous présenterons quelques

définitions des termes techniques liés au domaine

étudié. Dans la deuxième section, nous présenterons

les différents éléments (matériels et logiciels) de

notre sujet d'étude.

2.1 Quelques Définitions

Raspberry Pi : Nano-ordinateur monocarte

ayant la taille d'une carte de crédit, à processeur ARM

conçu par le créateur de jeux vidéo David Braben, dans le

cadre de sa fondation Raspberry Pi

Cluster : Se définit en informatique

comme étant une grappe d'ordinateurs inter-connectés dans le but

de mutualiser leurs ressources.(voir figure 2.1)

Cluster haute disponibilité : C'est un

cluster dont le taux de disponibilité est proche de 99%

1.

Docker : Un Docker est une technologie

permettant de créer des environnements virtuels appelés «

containers » de manière à isoler les

applications. Il permet d'automatiser le déploiement des applications en

embarquant dans un container toutes les dépendances et outils

nécessaires à l'exécution de l'application.

1. Taux proche des 99%, signifie que ce n'est qu'en cas de

trouble majeur que le système sera indisponible

10 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 10

FIGURE 2.1 - Schéma Architecture D'un Cluster

Docker Swarm : C'est un cluster sur les

Docker.

Progiciel : Logiciel applicatif

généraliste aux multiples fonctions, composé d'un ensemble

de programmes paramétrables et destinés à être

utilisés simultanément par plusieurs personnes.

ERP : ( Entreprise Ressource Planning) est un progiciel de

gestion intégré servant à planifier les ressources en

entreprise. 2

Odoo : C'est un progiciel de gestion intégré

open-source comprenant de très nombreux modules permettant de simplifier

la gestion d'entreprise dans son ensemble. 3

2.2 Etude de quelques concepts liés au sujet

d'étude

2.2.1 Raspberry Pi

Comme nous l'avons défini plus haut, un Raspberry Pi

est un nano-ordinateur de la taille d'une carte de crédit à

processeur ARM 4. Son disque dur est une carte

microSD d'au moins 8 Go et de la classe 6 au moins. Le Raspberry Pi a

été crée au départ pour encourager la programmation

en informatique. Il est vendu de nos jours à plus de 10 millions

d'exemplaires.

2. Source :

https://fr.wikipedia.org/wiki/Progiciel_de_gestion_intégré

3. Source :

https://fr.wikipedia.org/wiki/Odoo

4. Les architectures ARM sont des architectures RISC 32 bits

(ARMv1 à ARMv7) et 64 bits (ARMv8) développées par ARM Ltd

depuis 1990 et introduites à partir de 1983 par Acorn Computers.

11 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 11

Il est utilisé par des particuliers et des entreprises

à des fins diverses au quotidien (Apprentissage, bureautiques,

déploiement, etc...) . Il permet l'exécution de plusieurs

variantes système d'exploitation GNU/Linux et Windows tel que:

· RASPBIAN OS

· UBUNTU MATE

· SNAPPY UBUNTU CORE

· PINET

· RISC OS

· WINDOWS 10 IOT CORE

· HYPRIOT OS

· ALPINE LINUX

· ARCH LINUX

· etc ...

La plupart de ces systèmes sont des systèmes

dérivés des systèmes GNU/Linux comme Debian par exemple.

Le Raspberry Pi est fourni nu, c'est-à-dire carte mère seule,

sans boîtier, alimentation, clavier, souris ni écran, dans

l'objectif de diminuer les coûts et de permettre l'utilisation de

matériel de récupération. Son prix est estimé entre

5$ US (soit environ 5000 FCFA) à sa sortie en 2012 et 35$ US (soit

17.500 FCFA) de nos jours, selon les modèles. A l'heure actuelle il

existe sept (07) modèles de Raspberry Pi à savoir les

modèles A, A+, B, B+, 2B, 3B, Modèle Zéro. 5

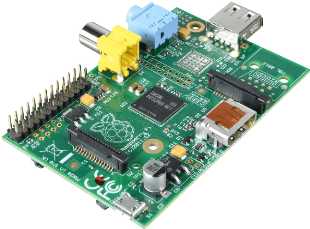

2.2.1.1 Modèle A

Premier modèle du Raspberry pi, le modèle A a

été mis sur le marché le 29 février 2012 avec un

prix d'environ 25$ US (soit environ 12.500 FCFA). Il pèse 45g avec une

taille de 85,6 mm de long, 53,98 mm de large et 17 mm d'épaisseur. Il a

un processeur ARM11 (ARMv6) à 700 MHz; une mémoire RAM de 256 Mo;

deux sorties vidéos, composite et HDMI; une sortie audio

stéréo Jack 3,5 mm (sortie son 5.1 sur la prise HDMI); une

unité de lecture - écriture de carte mémoire SD : SDHC /

MMC / SDIO; un port USB 2.0; une prise d'alimentation Micro-USB avec une

consommation de 400mA (1,5W); et des entrées/sorties directement

accessibles sur la carte mère (voir figure 2.2).

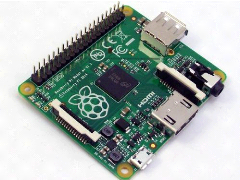

2.2.1.2 Modèle A+

Ce modèle a presque les mêmes

caractéristiques que le modèle A. Cependant, il a un prix qui est

réduit jusqu'environ 20$ US (soit environ 10.000 FCFA) avec une taille

de 65 mm de long et pèse 23g. Il a une sortie HDMI; une unité de

lecture-écriture mémoire mircoSD au lieu de SD; GPIO 40 broches

et une consommation en électricité de 200 mA (1W) (voir figure

2.3).

5. Source :

https://fr.wikipedia.org/wiki/Raspberry_Pi

12 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 12

FIGURE 2.2 - Une carte nue du Raspberry Pi modèle A

FIGURE 2.3 - Une carte nue du Raspberry Pi modèle A+

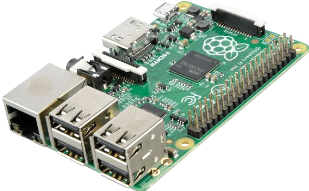

2.2.1.3 Modèle B

A la différence du modèle A, le modèle B

contient deux ports USB 2.0, un port réseau Fast Ethernet

(10/100Mbits/s) et une mémoire RAM de 512Mo. Il coûte environs 35$

US (soit environ 17.500 FCFA) avec un poids de 45g et une consommation de 700

mA (3,5W) (voir figure 2.4).

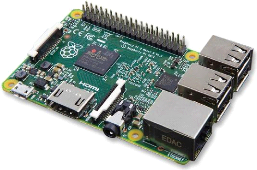

2.2.1.4 Modele B+

Ce modèle est apparu en juillet 2014 et a les

mêmes caractéristiques que le modèle initial,

c'est-à-dire le modèle B, à la différence qu'il

contient quatre ports USB 2.0 et une réduction de la consommation de

3.5W à 3W (600mA); GPIO 40 broches. Il coûte environs 35$ US

(soit

13 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 13

FIGURE 2.4 - Une carte nue du Raspberry Pi modèle B

environ 17.500 FCFA) (voir figure 2.5).

FIGURE 2.5 - Une carte nue du Raspberry Pi modèle B+

2.2.1.5 Modèle 2B

Ce modèle sort le 2 février 2015, plus puissant,

il est équipé d'un processeur Broadcom BCM2836, quatre coeurs

ARMv7 à 900MHz, accompagné de 1 Go de RAM. Il possède les

mêmes dimensions et connectiques que le modèle B.Il coûte

environs 35$ US (soit environ 17.500 FCFA). (voir figure 2.6)

14 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 14

FIGURE 2.6 - Une carte nue du Raspberry Pi 2 modèle B

2.2.1.6 Modèle 3B

Ce modèle apparait le 29 février 2016. Il

coûte environs 35$ US (soit environ 17.500 FCFA). Il dispose d'un

processeur Broadcom BCM2837 64 bit à quatre coeurs ARM Cortex-A53

à 1,2 GHz accompagné de 1 Go de RAM et d'une puce Wifi 802.11n et

Bluetooth 4.1 intégrée. Il possède les mêmes

dimensions et connectiques que les modèles 2B et B+. La vitesse

d'horloge est 33% plus rapide que le Pi 2, ce qui permet d'avoir un gain

d'environ 50-60% de performance en mode 32 bits. Il est recommandé

d'utiliser un adaptateur de 2,5 A. Tous les travaux et tutoriels du Pi 2 sont

parfaitement compatibles avec le Pi 3 (voir figure 2.7).

FIGURE 2.7 - Une carte nue du Raspberry Pi 3 modèle B

2.2.1.7 Modèle Zéro

Le 26 novembre 2015, la fondation Raspberry Pi annonce la

sortie du Raspberry Pi Zero. Il reprend les spécifications du

modèle A et B avec un processeur cadencé à 1 GHz au lieu

de 700 MHz, il est par contre plus petit, disposant d'une connectique minimale.

Son prix de 5$

15 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 15

US (soit environ 2500 FCFA) est largement revu à la

baisse par rapport aux autres Raspberry Pi (voir figure 2.8)

FIGURE 2.8 - Une carte nue du Raspberry Pi Zéro

Pour notre travail, nous avons utilisé le modèle

3B qui est actuellement le modèle le plus récent. Ce

modèle nécessite une carte microSD d'au moins 8Go et d'une classe

entre 6 et 10 d'une bonne marque pour préserver les performances en

accès disque. Une image annoté de ce modèle est la

suivante (voir figure 2.9) :

FIGURE 2.9 - Une carte annotée du Raspberry Pi 3

Modèle B

16 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 16

2.2.2 Cluster

Le terme « cluster » (mot anglais signifiant groupe,

grappe...), au sens employé ici est un ensemble de machines

connectées d'une façon ou d'une autre pour distribuer une

tâche très lourde entre ces différentes

machines6.

En fonction de l'objectif à atteindre, un cluster peut

être soit un ensemble d'ordinateurs mis en réseau dans le but de

traiter une même tâche (par exemple le cumul de puissances des

machines d'un cluster pour effectuer une tâche), soit un ensemble

d'ordinateurs mis en réseau dans le but de repartir les tâches sur

chaque noeud du cluster (par exemple un cluster de tâches systèmes

allouera à chaque machine du cluster un ensemble de processus à

traiter suivant sa charge et sa puissance de calcul).

Dans un cluster, les machines peuvent être de simples

stations de travail ou des machines multiprocesseurs et sont appelées

des noeuds. Lorsqu'il y'a besoin, la machine d'entrée sur le

réseau sera appelée noeud serveur et se chargera de diviser la ou

les tâches à travers tous les noeuds du cluster en prenant garde

à ne pas surcharger la machine réceptrice.

Les clusters sont apparus au moment de la montée en

puissance du prix des supercalculateurs alors que les microprocesseurs

devenaient de plus en plus rapides et de moins en moins chers. À partir

de la fin des années 1980, les ingénieurs ont commencé

à développer ce qu'ils appelaient alors un «

multi-ordinateur7 ». Toutefois, c'est le

projet Beowulf mis au point par Goddard Space Flight Center de la NASA en 1994

dont le principe est de construire des clusters en parallèle sous

GNU/LINUX avec du matériel commun (simples PCs), donc peu cher qui a

véritablement lancé l'intérêt sur les clusters

La mise en cluster assure une disponibilité,

c'est-à-dire lorsqu'un serveur tombe en panne alors qu'il est en train

de traiter des requêtes, d'autres serveurs du cluster doivent pouvoir les

traiter d'une manière aussi transparente que possible. Il assure aussi

l'évolutivité c'est-à-dire la capacité d'une

application à supporter un nombre important d'utilisateurs et la

possibilité d'ajouter de nouveaux serveurs sans procéder à

un arrêt du système.

Dans ce chapitre les différentes catégories de

cluster et les architectures logicielles et matérielles des clusters

seront présentées et aussi des solutions logicielles de

clustering seront présentées

2.2.2.1 Catégories de clusters

Nous catégorisons les clusters en quatre groupes :

a) Cluster haute disponibilité

Ces types de clusters ont pour objectif de prévenir les

situations où la défaillance d'un composant du cluster entraine

l'indisponibilité du service. Dans le cas où un noeud a une

défaillance quelconque, matérielle ou logicielle, les autres

prennent en charge les groupes de ressource du noeud défaillant. Ainsi

en une poignée de secondes les services de ce dernier sont pris en

charge par les autres noeuds sans pour autant que l'utilisateur ne soit

perturbé. Dans ce type de cluster le noeud chargé de

l'exécution des requêtes, le noeud

6. Source :

https://www.april.org/historique-et-fonctionnement-des-clusters-beowulf

7. relatif à un système en réseau

basé sur plusieurs ordinateurs

17 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 17

primaire, envoie périodiquement un signal qu'on appelle

heartbeat8 aux noeuds chargés de la prise en charge des

ressources du noeud défaillant, les noeuds secondaires, afin de les

notifier sa présence. Dès que les noeuds secondaires ne

reçoivent plus de heartbeat, ils déclarent le noeud primaire

comme ne faisant plus partie du cluster et un des noeuds secondaires prend son

identité complète.

En effet, le stockage des données étant

redondant, le fonctionnement du cluster, l'assurance contre la perte de

données et la disponibilité des ressources sont garantis à

99.9% pour ne pas dire 100% du temps. La figure ci-dessous représente un

cluster haute disponibilité à 2 serveurs maitres et 3 serveurs

esclaves. (voir figure 2.10)

FIGURE 2.10 - Cluster haute

disponibilité

b) Clusters de répartition de charge

Ce type de cluster dispose d'un noeud spécial que l'on

appelle noeud serveur qui a pour tâche de réceptionner les

requêtes et de les répartir sur le noeud adéquat. Ce

dernier est choisi en fonction de sa charge afin de traiter les requêtes

de façon instantanée. Il peut aussi être choisi en fonction

de sa spécialisation, c'est-à-dire que lui seul peut traiter la

demande sur l'ensemble des noeuds du cluster. Toutefois, même si les

noeuds du cluster n'utilisent pas les mêmes systèmes

d'exploitation et les mêmes entrées sorties, il existe tout de

même une relation commune entre eux, matérialisée sous la

forme d'une communication directe entre les machines ou à travers un

noeud serveur contrôlant la charge de chaque noeud. Pour pouvoir

répondre à ce besoin de communication, ce type de cluster utilise

des algorithmes spécifiques permettant de distribuer la charge. Ces

types de clusters requièrent des applications qui ont pour but de

déterminer lequel des noeuds du cluster pourra résoudre de

nouvelles requêtes en examinant la charge courante de chaque noeud du

cluster afin d'éviter la surcharge que peut subir les noeuds. Ce type de

cluster est surtout utilisé dans le domaine du réseau et plus

particulièrement sur les services comme les serveurs Web et FTP. (voir

figure 2.11)

c) Clusters de calculs haute performance

C'est un système considéré de

l'extérieur comme étant une machine multiprocesseur dont les

noeuds cumulent leurs puissances de calcul pour arriver à des

performances égales à celles qu'atteignent les supers

calculateurs. Ce cluster utilise des applications spécialisées

dans la parallélisation de calcul à travers une couche de

communication commune. A la place, un administrateur pourra utiliser le Direct

Memory Acces (DMA, similaire à celui utilisé par certains

périphériques d'un PC) à travers ses noeuds, qui

fonctionne comme une forme de mémoire partagée accessible par

l'ensemble des processeurs du système. Il

8. Battement de coeur.

18 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 18

FIGURE 2.11 - Cluster répartition de charges

pourra aussi utiliser un système de communication dit

de low-overhead comme Message Passing Interface (MPI), qui est une API

(Application Program Interface) pour dévelop-peurs d'applications de

calculs parallèles . (voir figure 2.12)

FIGURE 2.12 - Cluster calcul haute performance

d) Clusters de stockage

Ce type de système est comparable au cluster

scientifique, mais ici ce n'est pas la puissance de calcul qui est

recherchée mais plutôt la puissance de stockage. Sa mise en place

est partie d'un constat que les entreprises utilisaient de plus en plus

d'applications performantes utilisant des flux de données

conséquents et donc nécessitant une capacité de stockage

supérieure à celle d'un seul disque dur. Ce problème a pu

être contourné grâce à une vaste capacité de

stockage qu'offre ce système. Les fichiers sont découpés

en bloc de

9.

http://www-igm.univ-mlv.fr/~dr/XPOSE2006/BACHIMONT_BRUNET_PIASZCZYNKSI/index.htm

19 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 19

taille raisonnable et stockés par morceau sur plusieurs

disques, ainsi on a l'impression que l'espace de stockage ne fait qu'un et que

nos fichiers sont stockés en un seul morceau sur un "disque".

Il s'agit pour ce type de cluster d'utiliser le potentiel des

systèmes dits de "stockage combiné", c'est

à dire qu'il distribue les données par l'entremise de plusieurs

disques répartis sur les noeuds du cluster. Ainsi, tout utilisateur aura

le loisir de travailler avec des fichiers de très grandes tailles, tout

en minimisant les transferts. (voir figure 2.13)

FIGURE 2.13 - Cluster de stockage

NB : Pour notre travail, nous allons utiliser un cluster de

haute disponibilité couplé à un cluster de

répartition de charge.

2.2.2.2 Architecture des Clusters

a) Architecture Matériel

Il n'existe pas de modèle de référence

pour l'architecture matérielle des clusters, mais la plupart des

constructeurs comme IBM, SUN, Hewlet Packard, Compaq et bien d'autres

possèdent leur propre solution issue de leurs recherches.

Néanmoins pour répondre à la problématique que

posent les clusters concernant l'architecture, c'est à-dire que la

répartition des calculs entre les machines doit être la moins

couteuse possible, deux architectures sont possibles.

* Maitre - Esclave

: cette architecture est composée d'un noeud serveur

appelé noeud maitre et des noeuds esclaves. Le noeud maitre peut

être considéré comme l'organisateur du cluster. Il

maintient le système de fichiers et garde une trace de toutes

modifications de leurs propriétés, contrôle

l'exécution des opérations d'entrées/sor-ties des noeuds

clients, gère la configuration du cluster, enregistre les

métadonnées de tous les fichiers enregistrés dans le

cluster, comme par exemple l'emplacement, la taille, les permissions... Il

reçoit également des messages des autres noeuds du cluster afin

d'assurer qu'ils fonctionnent correctement, en cas de défaillance, il

choisit un nouveau noeud client pour exécuter les requêtes du

noeud défaillant. A chaque fois qu'un client externe doit lire ou

écrire des données il communique avec le noeud

20 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 20

serveur lequel répond à sa demande. Les noeuds

clients exécutent les opérations demandées par le noeud

serveur.

* Mono niveau (pair à pair) :

ce type d'architecture permet de mettre en commun un groupe d'ordinateurs pour

fournir un service même en cas défaillance d'un des composants

système. Quand une machine tombe, les autres prennent la relève

et les nouvelles tâches parviennent à la machine qui a pris la

relève. Dans cette architecture seul un noeud, le maître, peut

gérer les ressources à un instant t et les autres noeuds,

esclaves, disposent d'un système de contrôle qu'on appelle

«heartbeat» 10. Quand le maître

n'envoie pas de «heartbeat» pendant une période de temps, les

esclaves détectent cela et assument une défaillance et on

procède à une réélection du maître. Un des

esclaves devient maître, les services sont de nouveau alloués sur

ce noeud. Cette procédure s'appelle le «failover»

11. Le «failover» est donc la capacité

d'un équipement à basculer automatiquement vers un chemin

réseau redondant ou en veille.

Le choix d'une architecture est fortement lié à

l'application du cluster utilisé même si le modèle le plus

répandu est le Maitre-Esclave. Le stockage de toutes les ressources

publiables, fichiers de données, files d'impression, applications,

ressources, et services se font sur les disques partagés. Il est

nécessaire de partager les disques sur un bus, il y a deux

méthodes d'implémentation pour le partage des disques sur un bus,

la technologie SCSI et la technologie Fibre Channel sur un système SAN

(Storage Area Network).

b) Architecture Logiciel

Tout comme l'architecture matérielle, il n'existe pas

de modèle de référence pour l'architecture logicielle,

mais toutefois, il nous faut disposer de deux choses essentielles : un

système d'exploitation et une API (Application Program Interface) de

parallélisations. Ensuite, les choix s'orienteront vers les

préférences de la personne qui installe le système.

Il existe des systèmes d'exploitation

dédiés au clustering. Ces systèmes gèrent eux

mêmes les échanges réseaux et peuvent dans certains cas

découper les applications afin de les répartir sur le cluster.

Ils permettent de lancer des applications qui ne sont pas

développées à la base pour du clustering, mais pour une

utilisation optimale, l'utilisation de librairies dédiées au

clustering est recommandée.

Ainsi il existe des systèmes ou des extensions

systèmes pour tous les environnements comme Linux-Unix, BSD

12, Mac OS et Windows. Néanmoins, pour monter un cluster

performant, il est tout de même préférable d'utiliser des

systèmes d'exploitation ayant une couche TCP/IP bien

développée et sans faille.

Parmi ces systèmes d'exploitation nous pouvons d'abord

citer Beowulf11 qui est un système conçu par la NASA permettant

à partir de librairie de créer et d'utiliser des applications de

calculs répartis, Mosix qui est un système

développé par l'université de Jérusalem permettant

de découper une application pour la lancer sur un cluster et OpenMosix

est une version open-source de Mosix. Ces systèmes sont pour

l'environnement Linux-Unix. Ensuite pour l'environnement Mac OS nous pouvons

citer Xgrid qui est une surcouche à MacOS développé par la

Apple's Advanced Computation Group qui propose une API permettant à un

groupe d'ordinateurs en réseau d'effectuer des calculs répartis.

Xgrid est

10. Battement de coeur: envoi de signal entre les noeuds.

11. groupe de serveurs qui travaillent ensemble pour maintenir

une haute disponibilité des applications et des services

12. Berkeley Software Distribution (BSD, parfois

appelée Berkeley Unix) : une famille de systèmes d'exploitation

dérivée d'Unix.

21 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 21

livré par défaut depuis Tiger

13.

Enfin pour l'environnement Windows nous pouvons citer Windows

2003 cluster server R2 qui est une extension pour Windows 2003 server. Son gros

défaut est que cette solution repose sur un OS peu adapté au

clustering. En effet, la présence d'une interface graphique lourde

ralentit considérablement les performances. Puis pour BSD, nous pouvons

citer Mosix qui est le portage de Mosix sous BSD.

Pour ce qui est des API il existe de nombreuses librairies

permettant de créer des applications réparties. Certaines sont

dédiées aux communications réseaux comme MPI (Message

Passing Interface) et d'autres permettent de transformer un ensemble de

machines en une seule comme PVM (Parallele Virtual Machine). PVM possède

un environnement de contrôle permettant de rendre le lancement d'une

application de manière identique sur tous les noeuds du système.

Il est plutôt orienté vers les réseaux

hétérogènes, c'est à dire que les noeuds du cluster

peuvent être de type différent (PC Linux, PC Windows...).

MPI emploie des fonctionnalités intéressantes

(comme le RMA, Remote Memory Access, ou le système d'entrée

sortie parallèle), mais nécessite un apprentissage de MPI

identique à celui d'un nouveau langage de programmation. Même si

PVM semble mieux répondre aux contraintes d'un cluster et de son

matériel, il faut tout de même savoir que certains

inconvénients viennent s'incruster dans les rouages de PVM. En effet,

les applications l'utilisant doivent obligatoirement être

compilées avec les bibliothèques PVM. Ceci implique donc une

recompilation quasi obligatoire des logiciels déjà existants. De

plus, MPI a été développé après PVM et s'en

est inspiré. Ainsi, MPI répond mieux aux contraintes liées

à la gestion des buffers, des structures de données... En fait

cela sera à vous de choisir l'API répondant encore une fois au

mieux à vos attentes et vos besoins.

En plus du système d'exploitation et de l'API on peut

citer le BIOS (Basic Input/Output System) qui gère l'entrée et la

sortie des données et les échanges avec les

périphériques. A l'heure actuelle aucun cluster ne travaille

à ce niveau pour la gestion des calculs. Néanmoins le BIOS est

utilisé pour accélérer les échanges réseaux

entre les noeuds.

2.2.3 Les Dockers

Docker, l'une des technologies les plus importantes du moment

est un produit développé par la société du

même nom Docker inc basé au USA. Initialement

développé par un ingénieur français,

Solomon Hykes 14, le produit a été

dévoilé en mars 2013. Depuis cette date, Docker est devenu le

soft à la mode. Son potentiel révolutionne notre façon de

construire, de déployer et

13. Cinquième version majeure de Mac OS X, le

système d'exploitation d'Apple pour les ordinateurs Macintosh

14. Solomon Hykes, né à New York en 1983, est un

créateur d'entreprises franco-américain, vivant dans la Silicon

Valley, et le créateur d'un concept à l'origine d'un ensemble de

logiciels, Docker

22 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 22

de distribuer les applications. Les environnements de

développement sont souvent compliqués, difficile de garder la

cohérence entre les différents membres de l'équipe. Une

solution possible est de construire des machines virtuelles

pré-configurées disponibles pour toute l'équipe. Docker

peut sur ce point apporter des solutions en terme de rapidité et de

légèreté par rapport aux VM.

2.2.3.1 C'est quoi un Docker?

Docker permet de créer des environnements virtuels

appelés « containers » de manière

à isoler les applications. Docker n'est pas une machine virtuelle (VM)

à proprement parler, il repose sur le noyau Linux et sur une

fonctionnalité : les containers, que nous connaissons sur le nom de

LXC 15. En plus du LXC linux, un troisième composant est

requis, cgroups16 qui va avoir pour objectif de

gérer les ressources (utilisation de la RAM, CPU entre autres).

Bien que utilisant LXC et le cgroup qui sont natifs à

linux, l'équipe de Docker inc a récemment mis en oeuvre une

version Docker pour les systèmes Windows plus précisément

à partir de Windows Server 2016. Docker est donc disponible pour la plus

part des OS : Linux, Windows, Mac OS X pour les processeurs Intel et AMD x86,

x64 et les processeurs ARM (comme le cas du Raspberry Pi que nous utilisons

dans notre étude).

2.2.3.2 Difference entre Docker et Machine Virtuelle

(VM)

Docker ne se comporte pas de la même manière

qu'une machine virtuelle, Une Machine Virtuelle isole tout un système

(son OS), et dispose de ses propres ressources. Dans le cas du Docker, le noyau

va partager les ressources du système hôte et interagir avec le(s)

container(s). Le Docker partage le noyau Linux de la machine hôte et

«isole» les processus qui sont exécutés à

l'intérieur du container. On n'a donc pas besoin de la couche Operating

System complète comme dans une VM ce qui rend un Docker très

léger, très maniable et facilement voyageable dans un

environnement de cloud computing.(voir figure 2.14)

2.2.3.3 Environnement et notions de base

Docker

Trois éléments essentiels forment les bases de la

philosophie d'un Docker :

* Docker Image : c'est un template

qui va servir directement ou indirectement à produire d'autres Docker

Image ou des Docker containers.

* Docker Containers : c'est

«l'exécutable» obtenu à partir d'une Docker Image. On

peut le démarrer, l'arrêter ou le détruire.

* Docker Registry ou Docker

Hub : c'est le repository des Docker Images. On peut y

télécharger des Docker Images créé par d'autres

mais également y stocker les siennes.

15. LXC, Linux containers est un système de

virtualisation, utilisant l'isolation comme méthode de cloisonnement au

niveau du système d'exploitation.

16. cgroups (control groups) est une fonctionnalité du

noyau Linux pour limiter, compter et isoler l'utilisa-tion des ressources

(processeur, mémoire, utilisation disque, etc.).

23 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 23

FIGURE 2.14 - Machine Virtuelle Vs Docker

2.2.4 ERP Odoo

Fondé en 2005 en Belgique par Fabien

Pinckaers 17, Odoo (OpenERP) est l'ERP

open source le plus téléchargé au monde avec 2 millions

d'utilisateurs. Depuis mai 2014, la suite d'applications de gestion

d'entreprise est rebaptisée Odoo. Cette suite d'application permet aux

entreprises de disposer d'une solution intégrée pour gérer

les principales fonctions de l'entreprise. Son interface 100% Web et

adaptative, ses fonctions adaptées à l'entreprise en

réseau en font l'un des ERP les plus moderne et performant du

marché18

Odoo existe en version Communautaire sous

licence LGPLv3 et en version Enterprise sous licence

propriétaire Odoo Enterprise Edition Licence v1.0

19.

2.2.4.1 Historique

Odoo depuis son lancement en 2005 est

passé par plusieurs versions et a changé de nom plusieurs fois.

Le 20 janvier 2011, OpenERP SA annonçait le lancement de la version 6.0

du logiciel, qui comprend une version à la demande (SaaS). Son approche

modulaire permet aux utilisateurs de commencer avec une application, puis

d'ajouter d'autres modules selon leurs besoins.

En décembre 2012, la version 7.0 d'OpenERP est

lancée et peut être testée en ligne,

télé-chargée ou vue en version de démonstration.

En Mai 2014 : OpenERP change de nom et devient Odoo.

Été 2014, Odoo lance la version 8. Cette version

enrichit principalement le logiciel de nou-

17. Fabien Pinckaers, CEO Fondateur et chef visionnaire d'Odoo,

Fabien est la force tranquille derrière Odoo. Il touche à tout :

aux développements du logiciel, au marketing jusqu'aux stratégies

liées à l'expérience client.

18. Source :

http://www.audaxis.com/Odoo-OpenERP

19. Source :

https://fr.wikipedia.org/wiki/Odoo

24 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 24

velles applications qui font de Odoo un logiciel allant au

delà d'un ERP. Ces applications sont: marketing (gestion

d'événements, d'enquêtes de satisfactions, campagnes de

mails auprès de la CRM,...), CMS (construction d'un site internet -

front-end lié au back-end - grâce au déplacement rapide et

simple de 'blocs" d'éditions), e-commerce (application pour vente en

ligne). ci-dessous un tableau récapitulatif:

|

Nom du Logiciel

|

Version

|

Date Lancement

|

Changements significatifs

|

|

Tiny ERP

|

1.0

|

Février 2005

|

Première publication

|

|

2.0

|

Mars 2005

|

|

|

3.0

|

Septembre 2005

|

|

|

4.0

|

Décembre 2006

|

|

|

OpenERP

|

5.0

|

|

|

|

6.0

|

Octobre 2009

|

Première Publication sous AGPL

|

|

6.1

|

|

|

|

7.0

|

Décembre 2012

|

Fin de support prévu Octobre 2016

|

|

Odoo

|

8.0

|

Septembre 2014

|

Support pour le CMS : Construction de site internet,

e-commerce, point de vente, vente et business intelligence

|

|

9.0

|

Novembre 2015

|

Première publication des éditions Community sous

licence LGPLV3 et Enterprise sous licence propriétaire.

|

|

10.0

|

|

|

TABLE 2.1 - Tableau récapitulatif

version Odoo

2.2.4.2 Principaux Modules Applicatifs du logiciel

Odoo

Depuis sa verson v8, Odoo permet les applications logiciels

suivantes :

Principales applications logicielles front

office

* Créateur de site web et système de

gestion de son contenu, CMS

* Vente en ligne, e-commerce

* Interface de point de vente (PDV)

Principales applications logicielles

back-office

* Gestion de relation clients (CRM et SRM (en))

* Gestion des ventes

* Gestion de production

* Gestion de projets

* Gestion des stocks

* Gestion des ressources humaines

* Gestion des achats

* Gestion logistique

* Gestion de manufactures

25 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 25

* Gestion comptable

* Gestion des dépenses

* Gestion des documents

* Générateur de factures

* Gestion et outils marketing

Modules d'Odoo

L'aspect libre du logiciel a permis le développement de

nombreux modules tiers créés par sa communauté de

développeurs. Ces applications sont pour certaines officiellement

validées par l'éditeur tandis que d'autres ne sont

destinées qu'à des versions spécifiques. Le logiciel

compte près de 260 modules officiels et environ 4000 modules

communautaires.

2.2.4.3 Architecture Logiciel d'Odoo

Odoo est concu selon une architecture MVC (Modèle - Vue

- Contrôleur), des flux de travail flexibles, une interface-utilisateur

graphique dynamique, une interface de communication interne XML-RPC, et un

système personnalisable de comptes-rendus.

D'un point de vue de l'architecture technique, Odoo est

construit autour de trois composants principaux qui communiquent entre eux par

les protocoles XML-RPC et NET-RPC:

1. le serveur odoo-server qui stocke ses données dans une

base PostgreSQL.

2. le client odoo mobile (anciennement odoo-client

abandonné depuis la v7) qui s'installe sur le terminal de

l'utilisateur.

3. le serveur web odoo-web qui permet une utilisation depuis

un navigateur.

CONCLUSION

Tout au long de cette première partie, nous avons

essayé de mettre au point le cadre général de notre

travail. Nous avons tout d'abord présenté l'organisme d'accueil

qui s'avère être un élément fondamental dans

l'environnement du projet et ensuite, une étude des concepts liés

au projet a été abordée. Bien plus, nous avons

examiné attentivement le domaine spécifique et technique autour

duquel tourne notre projet. À ce stade, nous avons fourni tout le cadre

théorique sur lequel, va s'appuyer la partie destinée à la

conception et à l'implémentation de notre solution. La

deuxième partie sera donc consacrée à l'aspect pratique de

la réalisation du travail demandé.

26

Deuxième partie

CONCEPTION, IMPLÉMENTATION

ET ÉTUDE DE LA SOLUTION À

PROPOSER

27 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 27

INTRODUCTION

Après avoir circonscrit le sujet dans son contexte

ainsi que le champ d'étude du projet dans la première partie, La

deuxième partie présente l'aspect technique de la solution

proposée. À l'entame de cette partie, le chapitre 3

présente l'analyse et la conception de notre solution. Nous poursuivons

dans le chapitre 4, avec l'implémentation de notre solution et dans le

chapitre 5 avec l'étude de notre solution en vue de vérifier si

les objectifs ont été atteint. À l'issue de cette partie,

nous pourrons déjà faire tourner notre solution.

Chapitre3

ANALYSE ET CONCEPTION

28

Introduction

Notre travail d'Analyse et de Conception se fera en trois

phases. Dans la première phase nous ferons un état de l'art des

solutions logicielles de clustering existantes et ceux fonctionnant sur

Raspberry pi vu que c'est avec ces nano-ordinateurs que nous

implémenterons notre solution et nous finirons par une analyse. Dans la

seconde phase nous étudierons des différentes techniques de

clustering et la troisième phase sera consacrée à la

conception de notre architecture de cluster.

3.1 Solution logicielle de Cluster

Il existe plusieurs solutions sur le marché pour mettre

en place un cluster pour différents systèmes d'exploitation

populaires. La plupart de ces solutions sont commerciales, elles ont un

coût non négligeable dû aux prix des licences logiciels et

au prix du support technique. Ces solutions sont proposées par des

sociétés de prestations en informatique comme Microsoft, IBM,

SUN, Google, Compaq... Il existe aussi des solutions gratuites, à base

de logiciels "libres". Le choix se fera donc en fonction du support technique

voulu et du budget disponible.

3.1.1 Microsoft Cluster / Cluster pour système Windows

Microsoft propose une solution pour mettre en place un cluster

constitué de serveurs Microsoft. Pour cela deux types de clustering sont

proposés, il s'agit de clustering de service ou cluster de Haute

Disponibilité qui consiste à réaliser des clusters

d'application et de rendu de

29 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 29

service et le clustering à répartition de charge

qui garantit une répartition de charge réseau sur des flux IP

à travers un cluster constitué de 32 noeuds au maximum. A travers

ses solutions, Microsoft a implémenté des technologies de

clustering permettant d'améliorer et d'accélérer le

travail quotidien des employés des entreprises désireuses

d'améliorer leur production mais aussi permettant de réaliser du

commerce avec un plus grand nombre de clients.

3.1.1.1 Microsoft Cluster Server (MSCS)

Microsoft Cluster Server est un programme informatique qui

permet aux ordinateurs serveurs de travailler ensemble comme une grappe

d'ordinateurs, afin de fournir le basculement et la disponibilité accrue

des applications, ou une puissance de calcul parallèle en cas de grappes

de calcul haute performance (HPC) (comme dans le calcul intensif). Microsoft a

trois technologies pour le clustering :

1. Microsoft Cluster Service MSCS

Le service MSCS fournit une haute disponibilité pour les

applications critiques, telles que

les bases de données, les serveurs de messagerie, serveur

de fichier et d'impression.

2. Network Load Balancing (NLB)

NLB permet d'équilibrer le trafic IP entrant. Il joue

un rôle de répartition des connexions IP et requêtes

distantes, de répartition de la charge et bande passante sur les noeuds

et de connexion au site web. Les connexions entrantes sont reparties entre les

noeuds à travers différentes règles établies. Ces

noeuds peuvent aller jusqu'au nombre de 32 pour la charge IP en mode NLB. Ce

service augmente la disponibilité et la montée en charge des

applications serveur basées sur l'accès Internet, tels que des

serveurs WEB, des serveurs médias streaming, serveurs Windows Terminal

Server ou autres.

3. Component Load Balancing (CLB)

Équilibrage de Composants, ce type de clustering permet

d'équilibrer les Composants, le service CLB est intégré

à l'Application Center 2000(ou versions

antérieures), il permet aussi de répartir la charge sur plusieurs

noeuds du cluster, pour les applications basées sur la technologie des

objets COM et COM+, une mise à jour pour les objets WMI et la gestion du

Framework.NET est désormais

disponible. On parle de clustering d'application dit clustering de

puissance.

3.1.1.2 Evidian Safekit

Evidian Safekit est un logiciel de haute disponibilité

avec Réplication temps réel, partage de charge et reprise sur

panne pour le clustering. Il est développé par la

société Evidian 1. Le logiciel

SafeKit permet de construire un cluster actif-passif avec failover applicatif

et réplication de données temps réel et continue des

données. Le cluster actif-passif de SafeKit apporte une solution simple

à la haute disponibilité d'applications base de données

critiques sur Windows, Linux ou AIX (même Windows 7 et 8). SafeKit

implémente une réplication continue synchrone

1. Evidian IAM est le leader européen des logiciels de

gestion des identités et des accès, avec une présence en

pleine croissance en dehors du continent européen et notamment aux

Etats-Unis et au Japon

30 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 30

comme les SAN miroirs répliqués mais sans le

coût et la complexité des clusters de failover matériel.

Le cluster actif-passif est une architecture de haute

disponibilité de type miroir. L'application est exécutée

sur un serveur primaire et redémarrée automatiquement sur un

serveur secondaire si le serveur primaire est défaillant.

La réplication des données est configurée

avec les répertoires de fichiers à répliquer. Les

répertoires peuvent contenir des bases de données ou des fichiers

plats. Avec sa fonction de réplication de données temps

réel synchrone, cette architecture est particulièrement

adaptée aux applications transactionnelles avec des données

critiques à protéger contre les pannes.

2

3.1.2 Cluster GNU/Linux

Linux est l'alternative de tous ces clusters chers grâce

à sa gratuité. Grace à lui, vous êtes capables de

mettre en place un cluster répondant à toutes les attentes que

vous pouvez vous formuler. Pour cela, il suffit de posséder quelques

machines, une distribution linux et quelques logiciels permettant de

réaliser la parallélisation des noeuds du cluster. Beaucoup de

projets de clustering sont mis en oeuvre sous Linux à savoir ces

quelques exemples que nous allons citer ci-après :

3.1.2.1 Linux Virtuel Server (LVS)

Ce projet consiste à mettre en place un cluster

à répartition de charge. Son principe est de mettre en grappe des

serveurs et à orchestrer les répartitions de charges par un noeud

serveur qu'on appelle load-balanceur (répartiteur de charge). Il est

implémenté sous forme de patchs applicables au noyau Linux, et

permet alors à des applications réseaux comme les serveurs WEB de

fonctionner sur des clusters acceptant plus de connections.

3.1.2.2 Beowulf

Il s'agit de l'un des projets les plus connus du monde Linux

et le plus utilisé. Il met en place un clustering scientifique par le

biais du système d'exploitation Linux. Le principe est de mettre en

place un système où l'ensemble des noeuds cumulent leur puissance

pour fonctionner comme une seule machine. Ainsi les requêtes

envoyées par les clients externes seront traitées en fonction de

la charge et de la disponibilité de chaque noeud. Beowulf n'est rien

d'autre qu'un

2. Source :

http://www.evidian.com/fr/

31 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 31

package d'outils qui fonctionne sur le noyau linux.

3.1.2.3 Linux HA-Project

Il s'agit d'un projet de clustering qui permet de mettre en

place un système à haute disponibilité. Ce système

est constitué d'applications permettant de maintenir l'envoi de signaux

qu'on appelle heartbeat entre les différents noeuds. Dans le cas

où un noeud n'émet plus de signal, l'application donne les taches

de ce dernier à un autre noeud. Le principal inconvénient vient

du fait qu'il faut bien dimensionner son signal de heartbeat, ceci afin

d'éviter de trop longs moments d'inactivité d'un service en cas

de panne du serveur, ou bien d'éviter de polluer le réseau par

des signaux intempestifs apparaissant trop souvent. 3

3.1.2.4 Multicomputer Operating System for Unix

(MOSIX)

MOSIX est un système de gestion de clusters Linux et de

grilles organisationnelles qui fournit une Single-system image (SSI),

c'est-à-dire l'équivalent d'un système d'exploitation pour

un cluster dans son ensemble. Il s'agit d'un cluster à

répartition de charge développé pour le monde Unix et les

ordinateurs spécialisés. Le but de ce projet est de fournir un

système de clustering, à travers Linux, agissant comme une simple

machine, vu de l'extérieur, c'est à dire vu des utilisateurs et

des processus. Il existe une version "fork" de MOSIX, openMOSIX

qui est une version free open source de

MOSIX. il a été

initié après l'arrêt du développement de MOSIX en

source libre.4

3.1.2.5 Apache Mesos

Apache Mesos est un gestionnaire de cluster open-source qui a

été développé à l'Université de

Californie, Berkeley. Il fournit une isolation efficace des ressources et le

partage entre les applications distribuées, ou des frameworks.Le

logiciel permet le partage des ressources d'une manière fine et

améliore l'utilisation du cluster. Apache Mesos tourne bien sur les

systèmes Linux, Mac OS et

Windows. il existe aussi une version

pouvant tourner sur un nano-ordinateur Raspberry Pi.5

3.1.2.6 Cluster Docker Swarm

Swarm permet la gestion d'un cluster de serveurs Docker. Il

exporte les API standards de Docker mises à l'échelle du cluster

et permet de gérer l'ordonnancement des tâches et l'allocation de

ressources par container au sein du pool de ressources machines. Là

où cela devient très intéressant, c'est que Swarm permet

de gérer le cluster comme une seule et unique machine Docker. Swarm

existe en version Linux, Mac OS et

Windows. il existe aussi une version

pouvant

3. Source :

http://www.linux-ha.org/wiki/Main_Page

4. Source :

https://fr.wikipedia.org/wiki/MOSIX

5. Source :

http://mesos.apache.org/documentation/latest/index.html

32 IAI Gabon

c~Tchuenché Rodrigue Élève Ingénieur

En Informatique 32

tourner sur un nano-ordinateur Raspberry Pi à travers

certains système d'exploitation conçu à cet effet.

3.2 Analyse Des Solutions

De toutes ces panoplies de solutions citées plus haut,

nous devons combiner une solution en tenant compte des différentes

contraintes liées au cluster que nous voulons implémenter et des